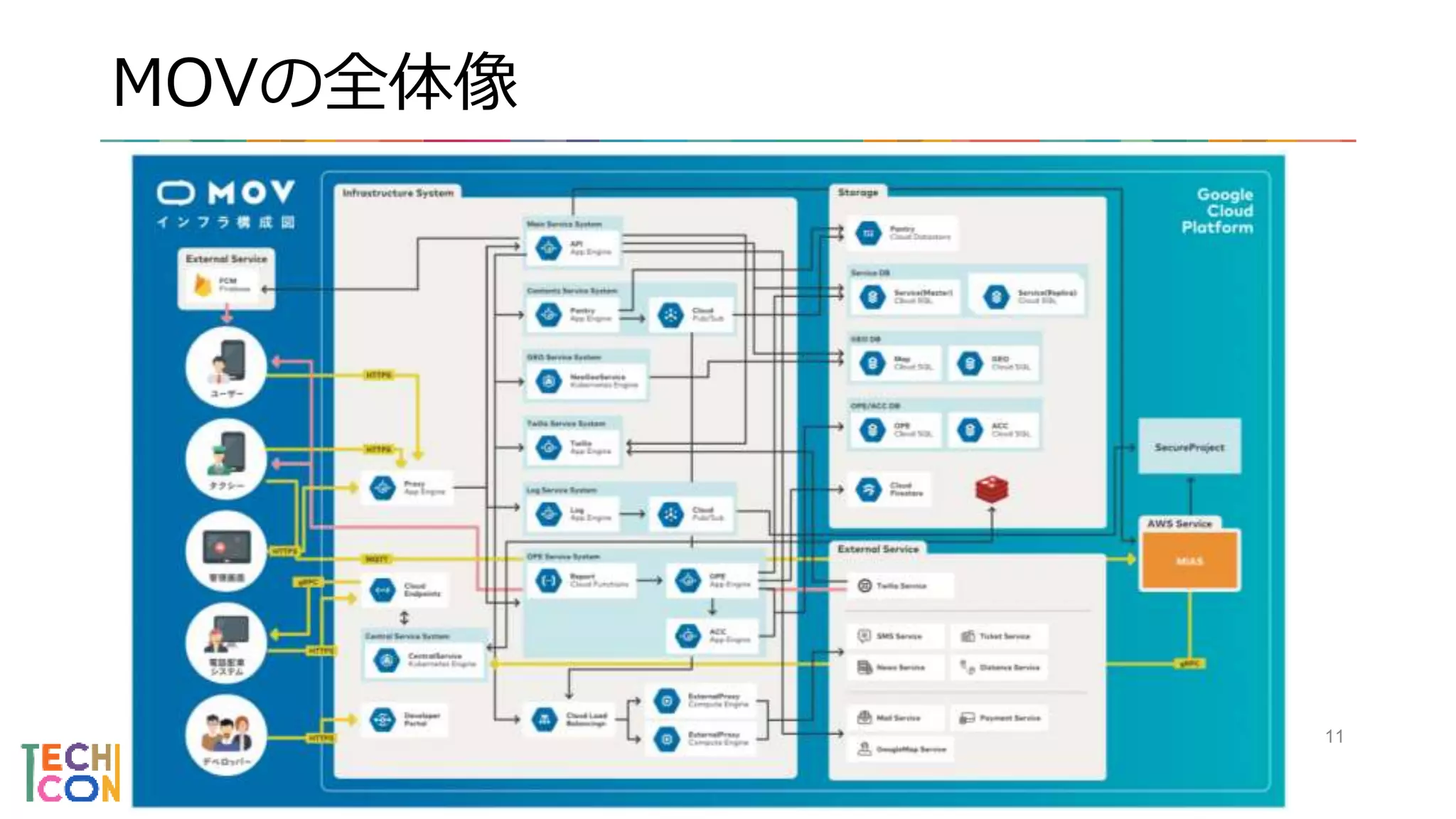

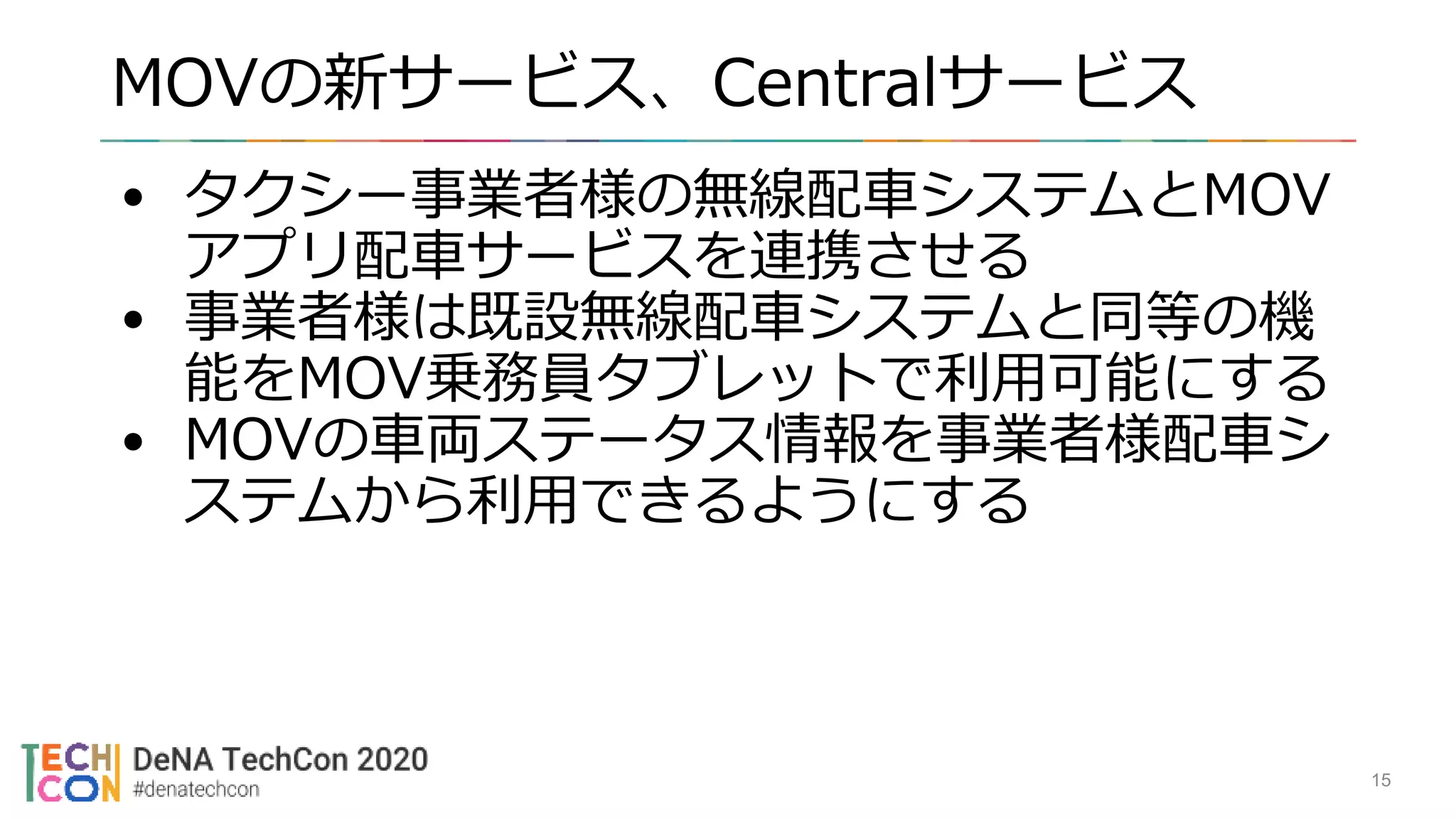

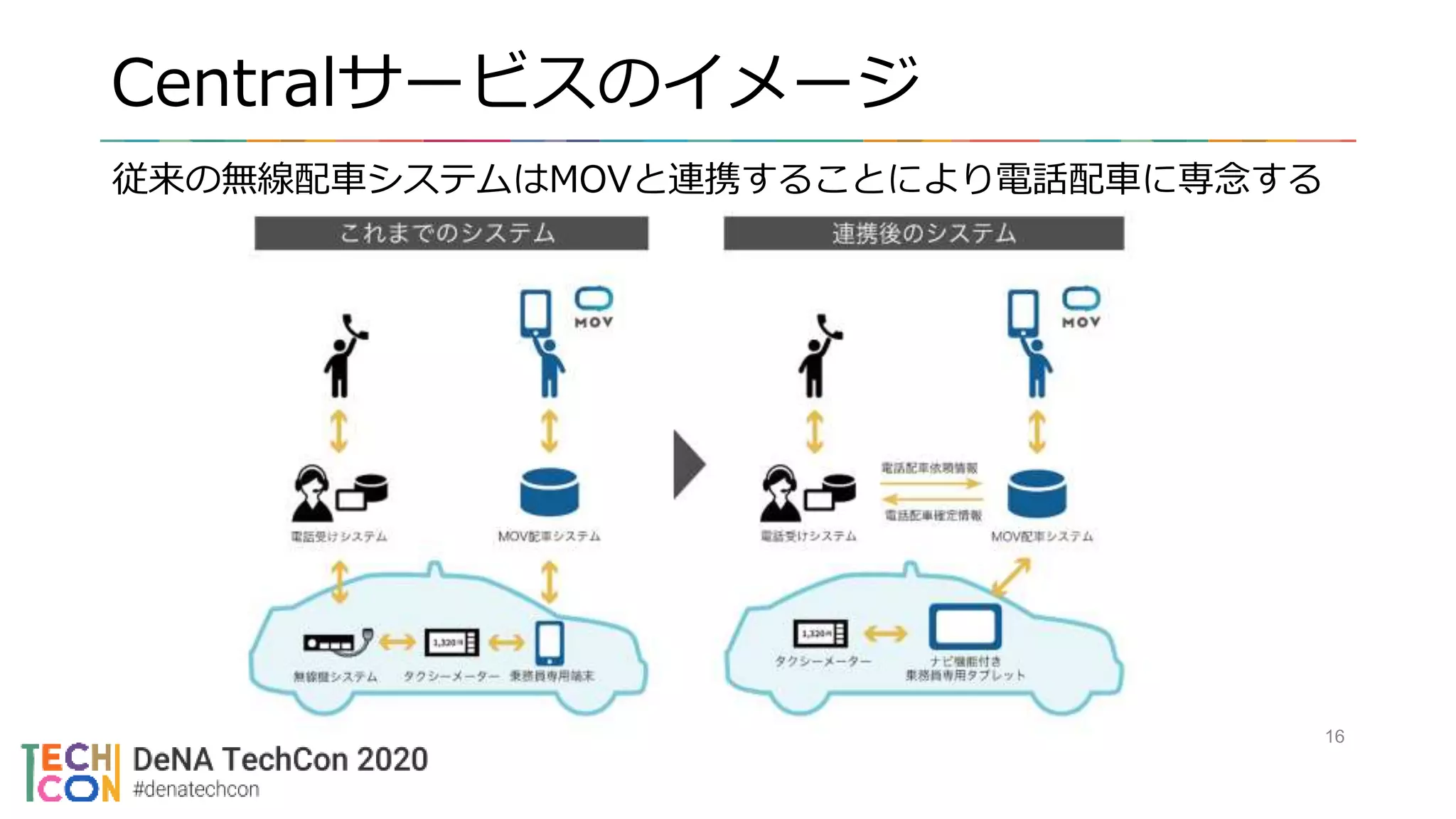

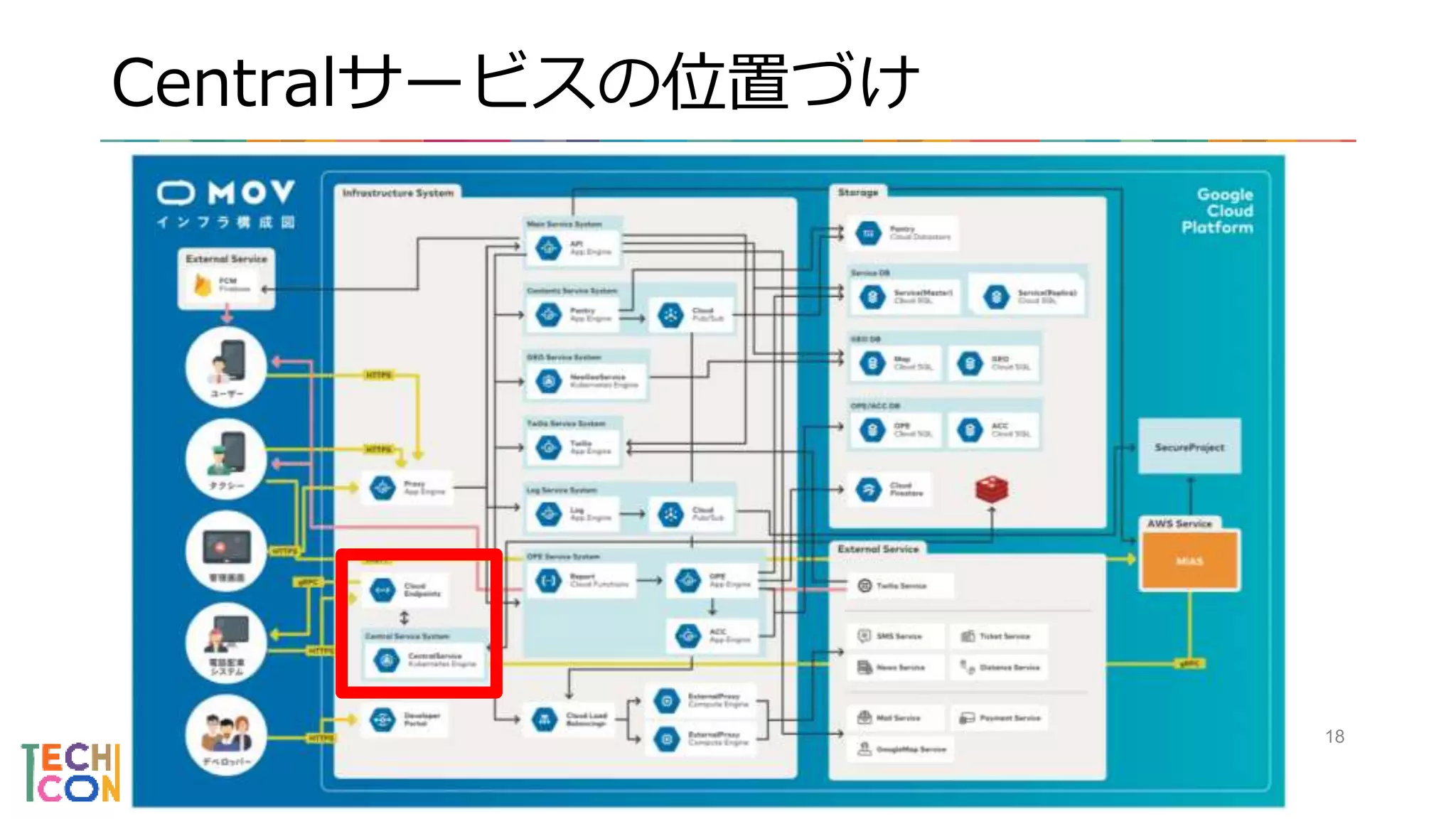

次世代タクシー配車アプリ「MOV」では、配車アプリだけでなくタクシー事業者様向けの機能開発も行っています。

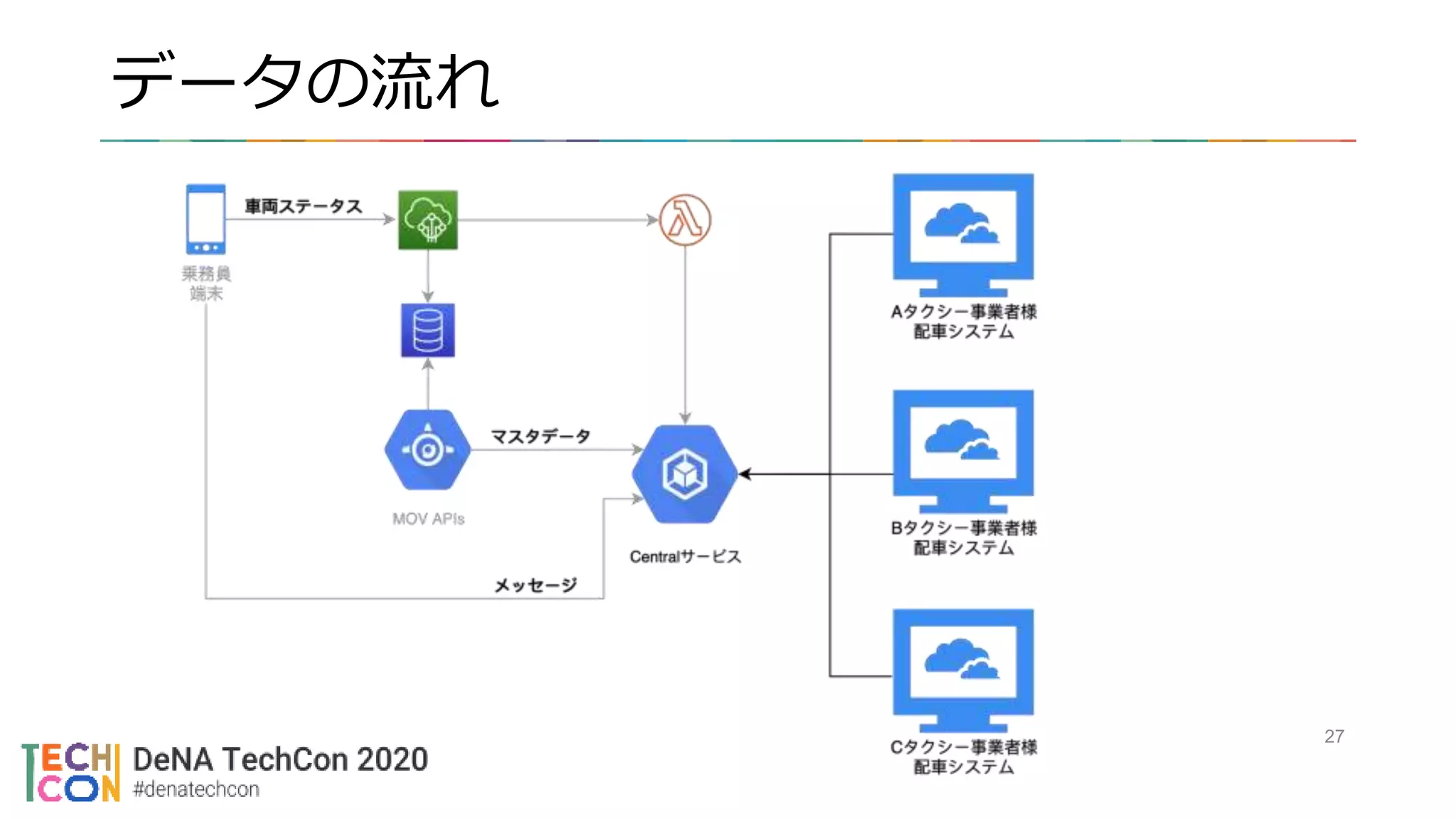

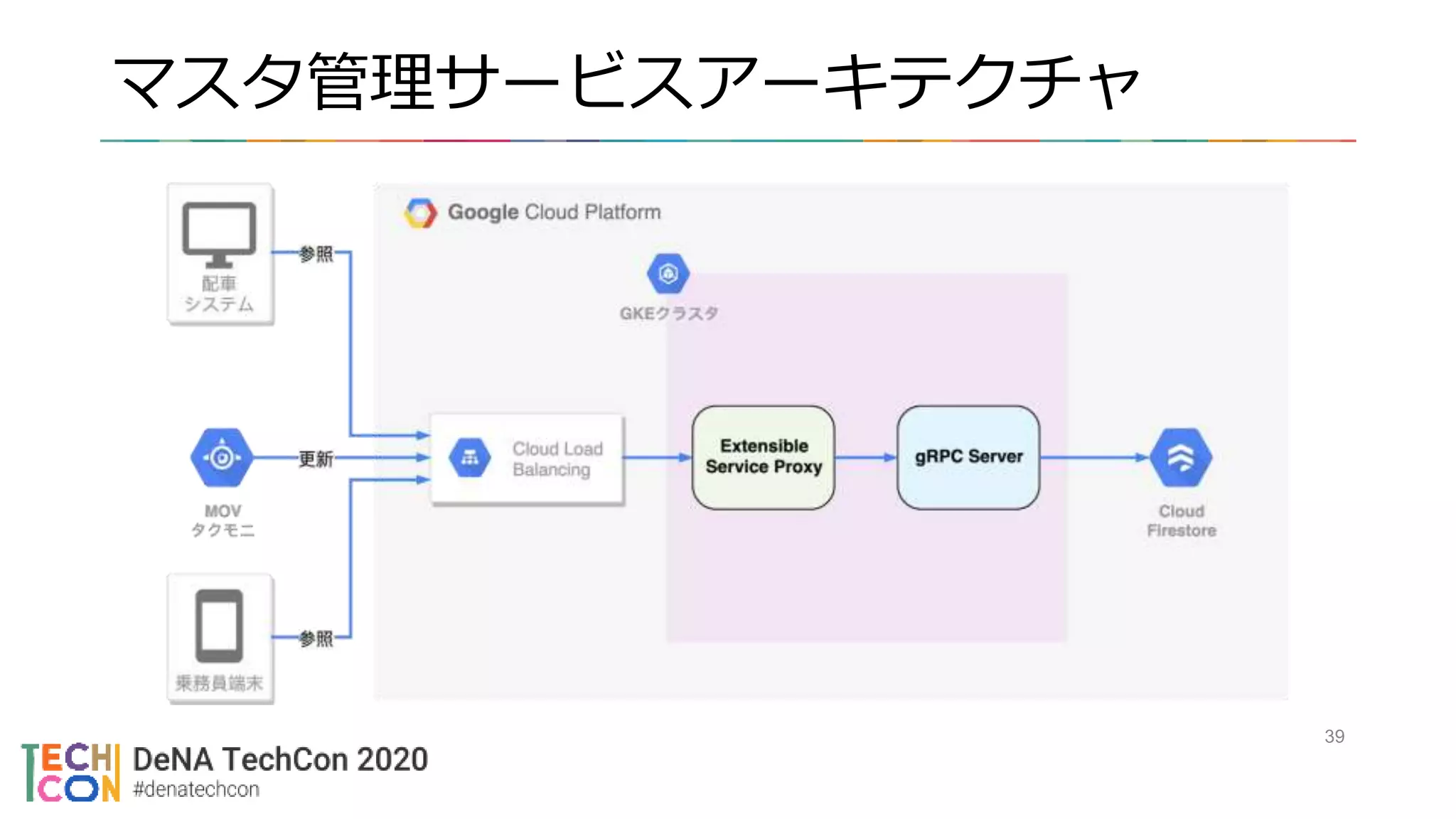

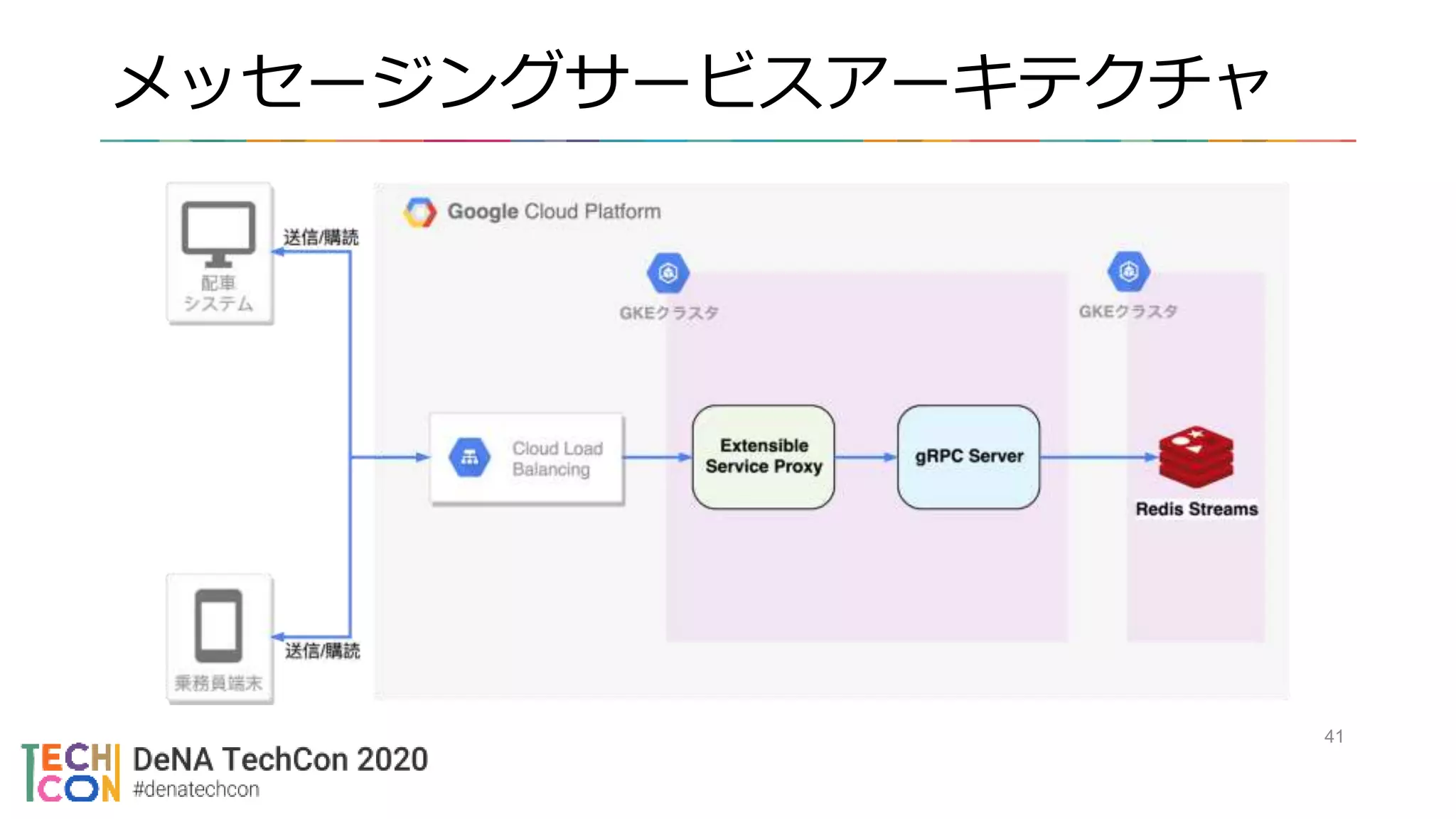

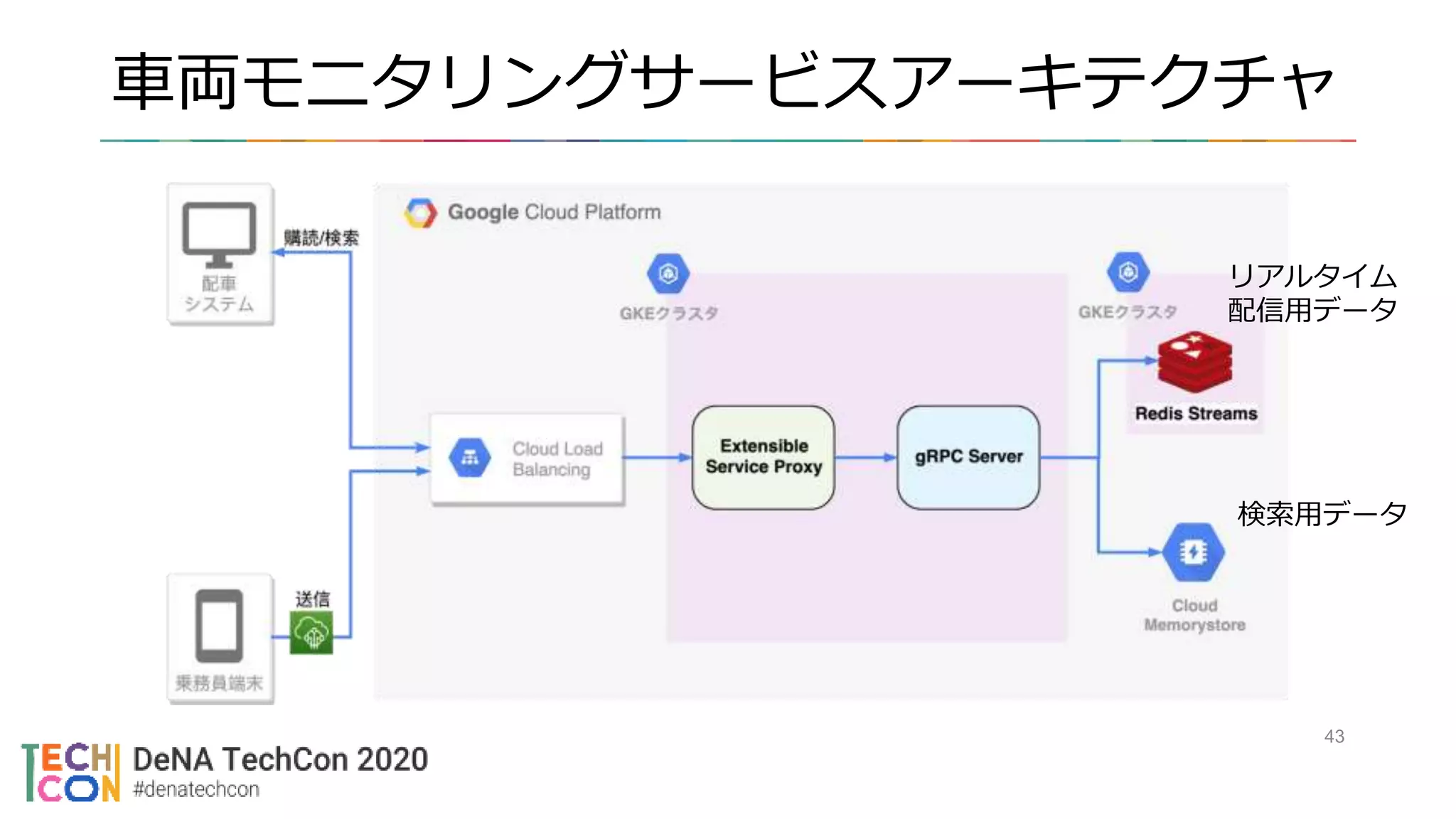

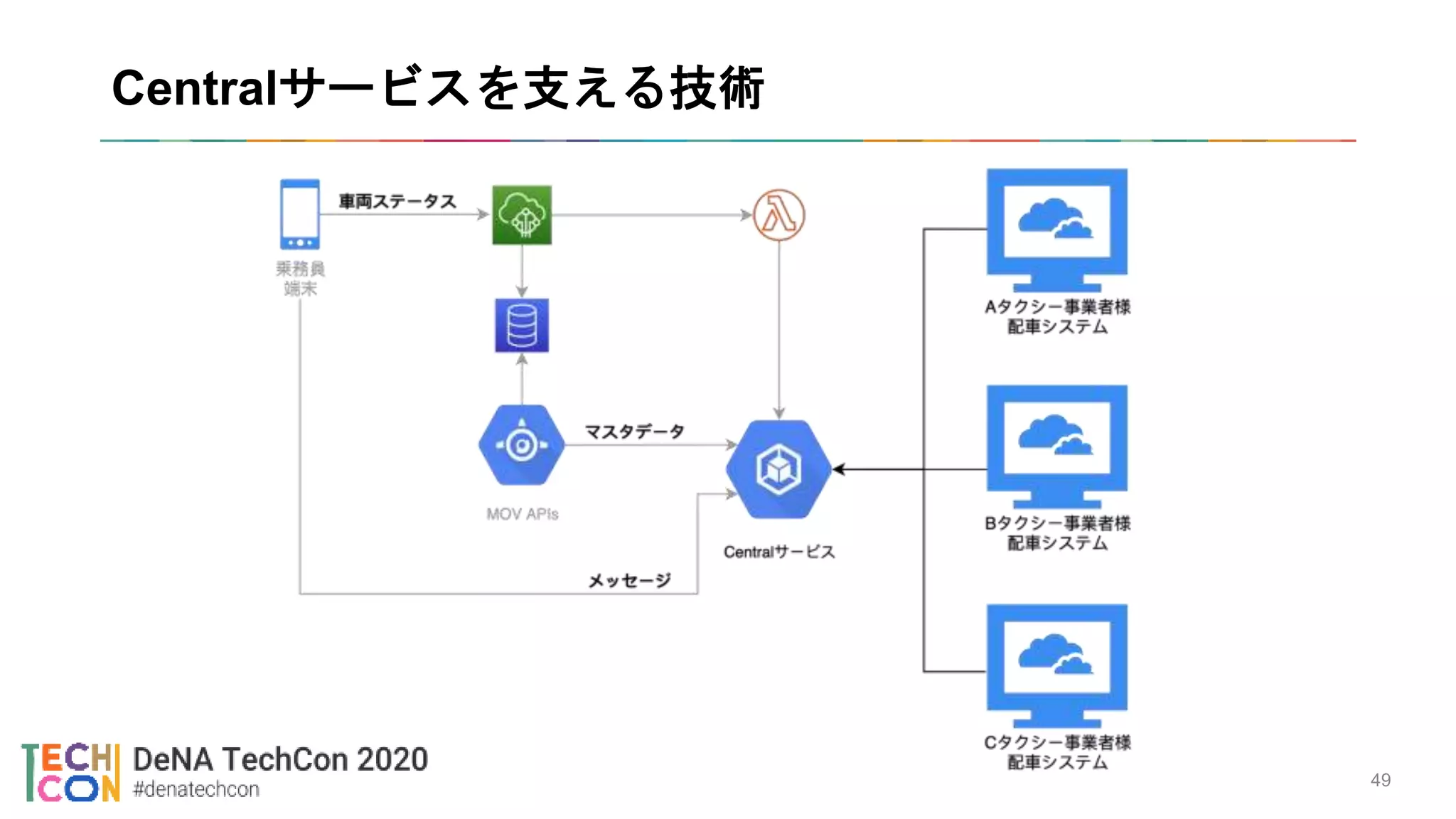

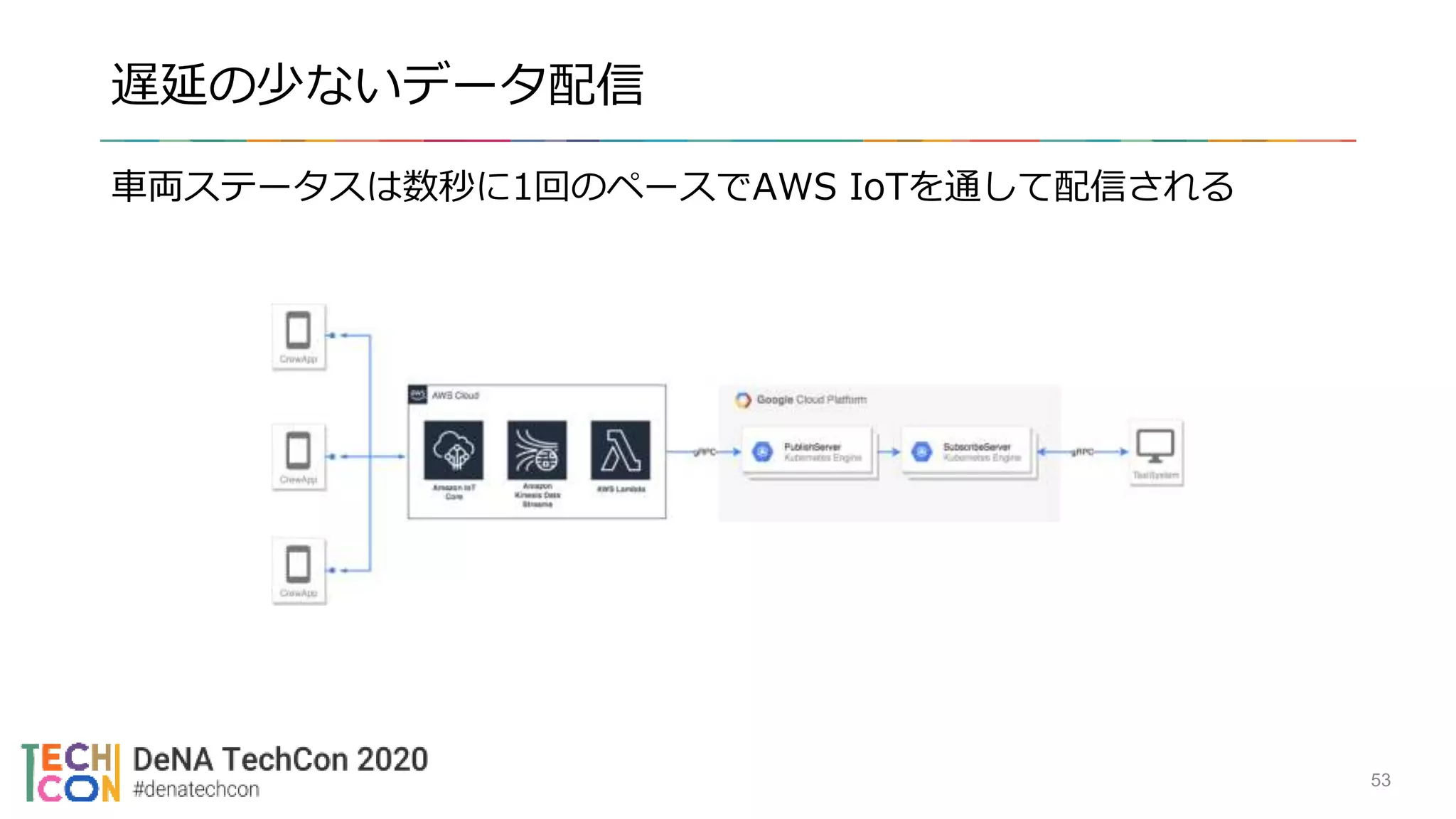

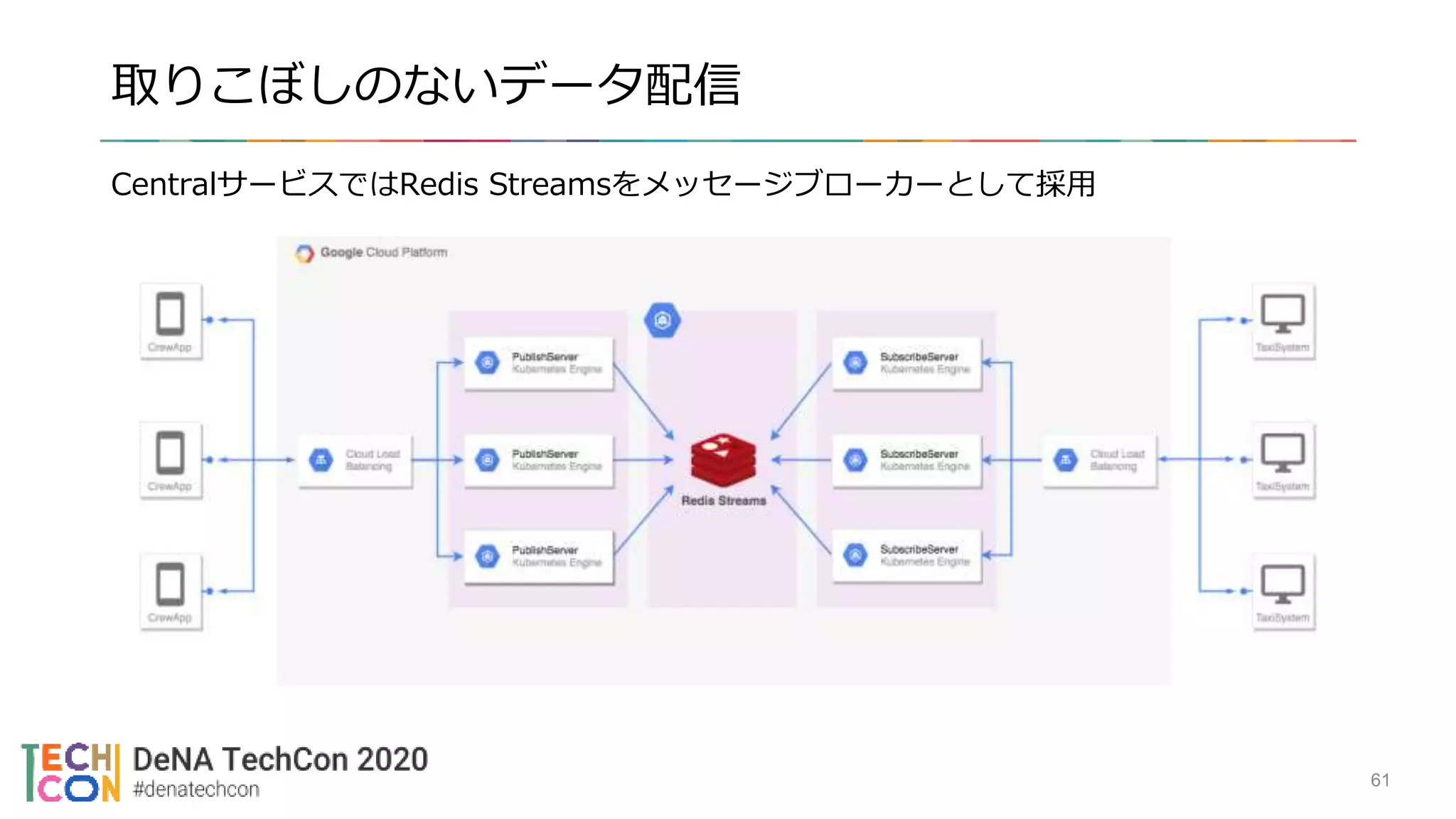

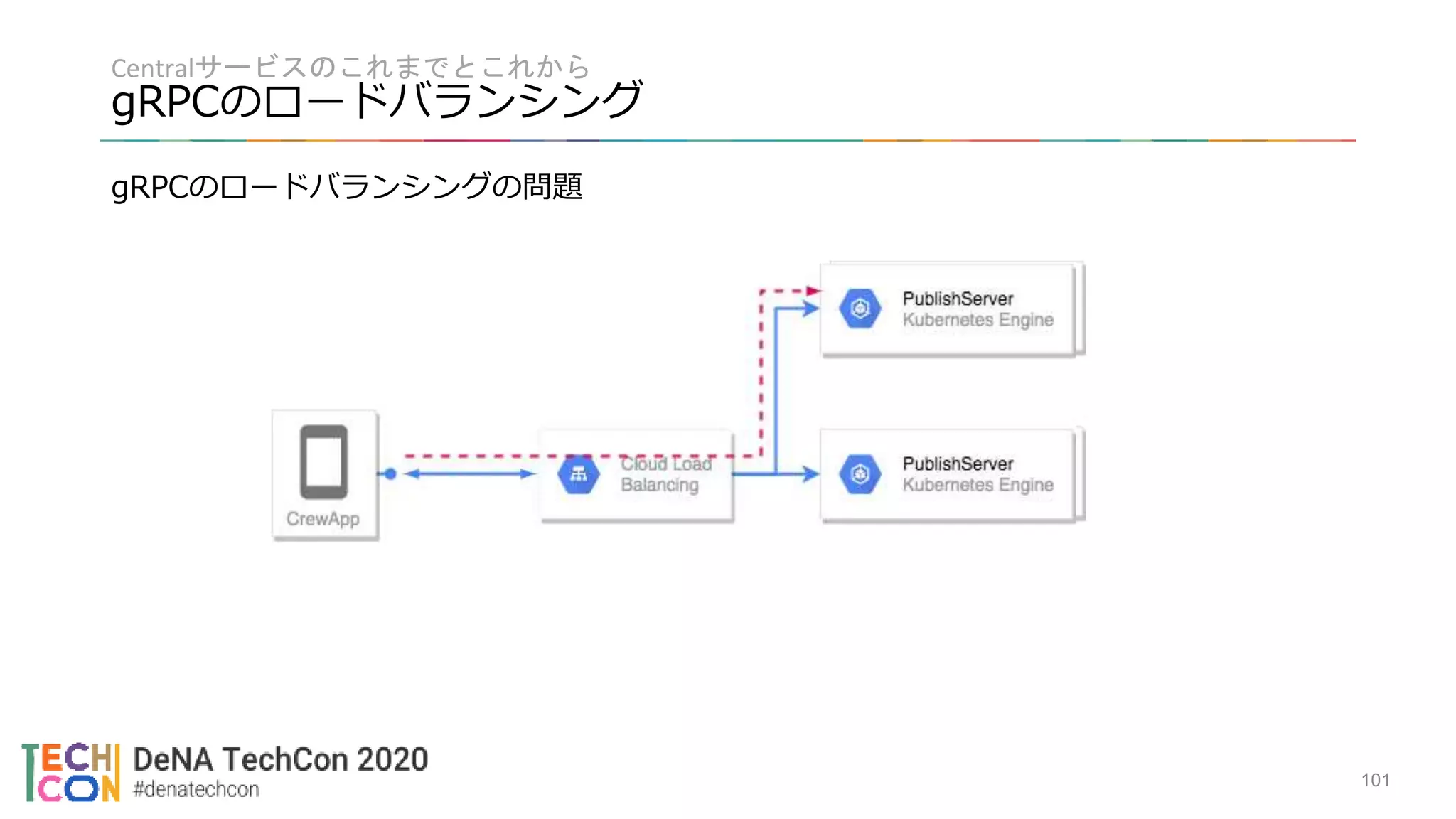

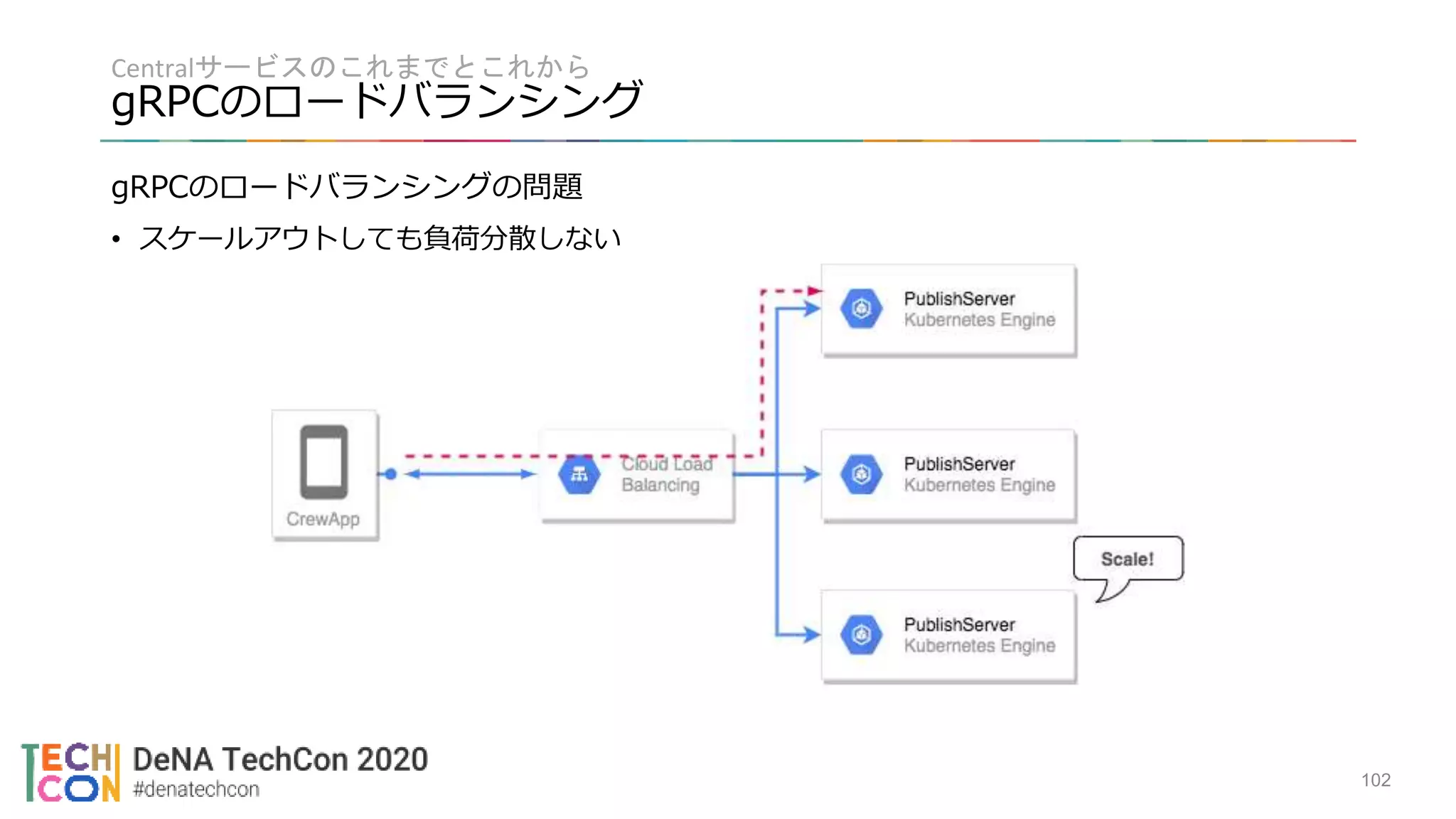

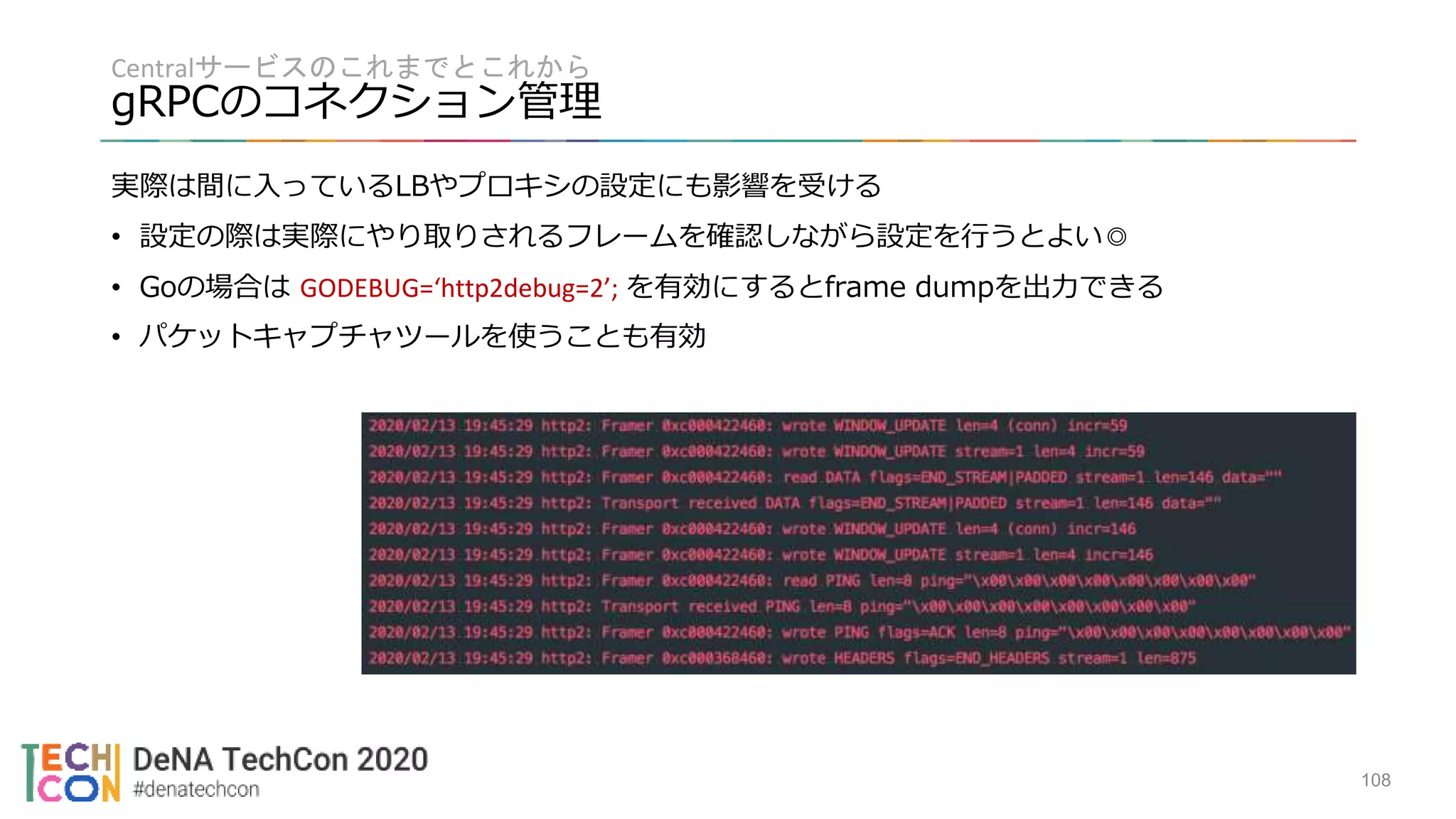

私たちのチームは、「MOV」システムで収集した車両データを利用し、従来のタクシー配車システムとタクシー車両の無線連携の仕組みをインターネット上で実現しようとしています。

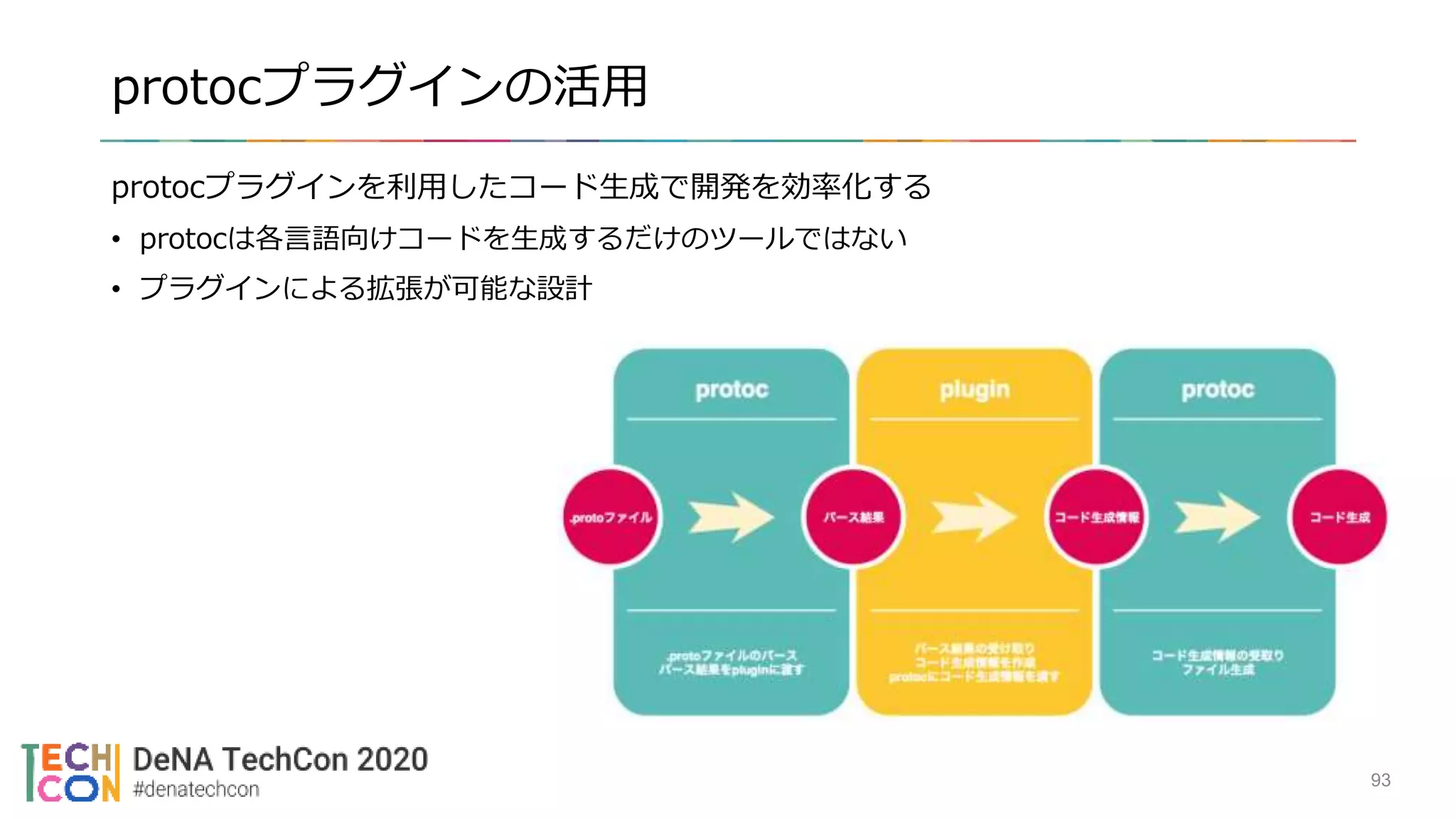

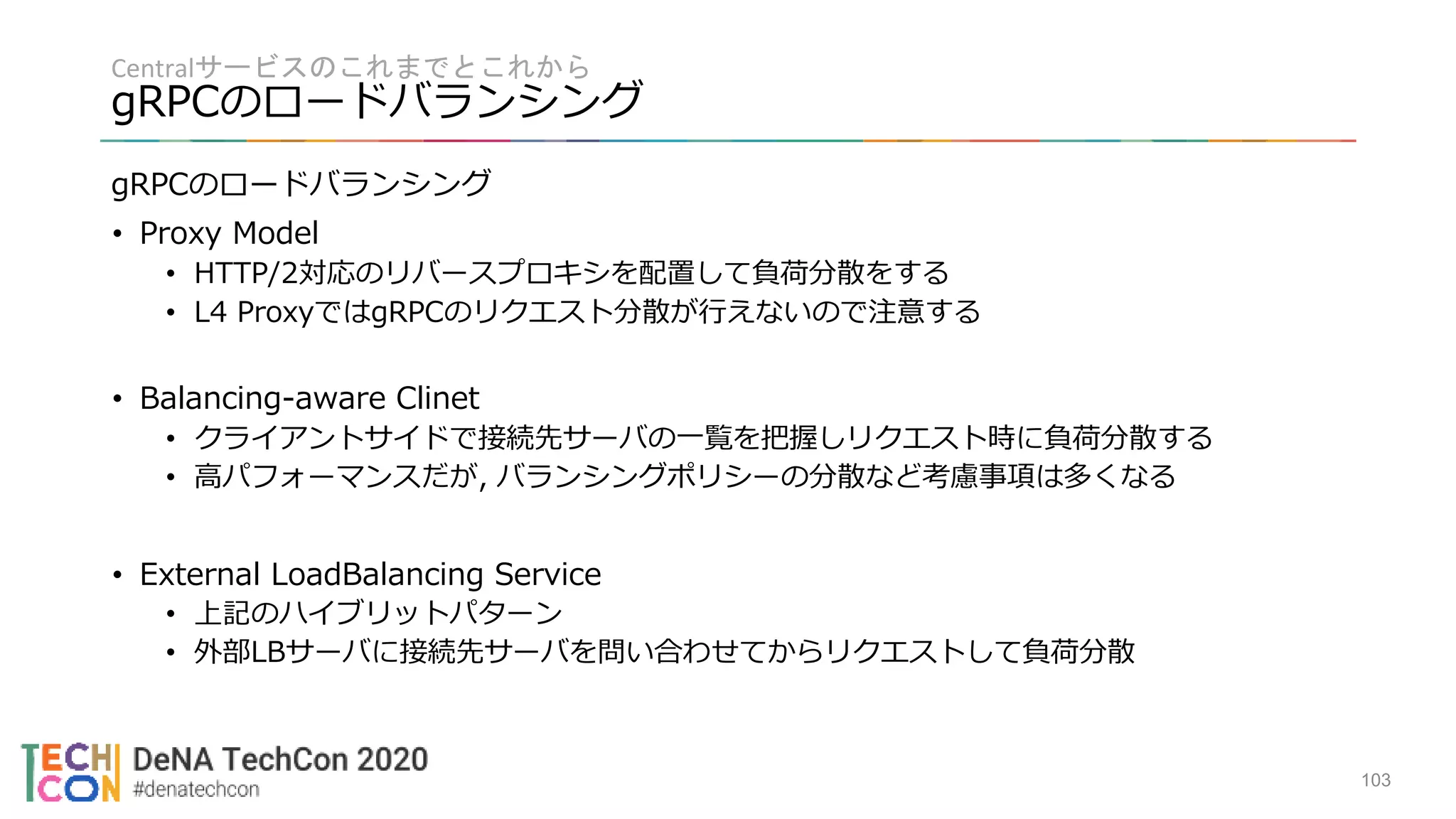

本セッションでは、GKE, gRPC, OpenAPIなどの技術を駆使して、タクシー配車システムに求められる大量の車両データのリアルタイム配信や、タクシー事業者様ごとに異なる配車システムの言語, プロトコルに向き合うためのシステム構築の工夫や運用について事例を交えてご紹介します。