More Related Content

PDF

AbemaTV Developer Conference 2016 PDF

Developers Summit 2018: ストリームとバッチを融合したBigData Analytics ~事例とデモから見えてくる、これからのデー... PDF

Decode19 cd42 fixer_public_0601 PDF

Developers Summit 2018 | IoTサービスを始める際に必要なこととは PDF

Five Steps to Culture Change を日本語で解説する 2020/11/06 PPTX

Google Colab環境でPythonスクレイピング PPTX

第一回☆GREE AI Programming ContestでTensorFlow PDF

社内エンジニアを支えるテクニカルアカウントマネージャー What's hot

PPTX

エンジニアが牽引する3Dアバター事業とAIの活用 [DeNA TechCon 2019] PPTX

PDF

機械学習をScrumで組織的に学習する (RSGT2022) PDF

Visual Studio Code のこれまでとこれから at OSC 2021 Online/Spring PDF

[Developers Summit 2018] Microsoft AIプラットフォームによるインテリジェント アプリケーションの構築 PDF

2021/03/19 パブリッククラウドを活かす運用プロセス自動化 PPTX

【Logic Apps編】ノンコーディングでデキる!お問い合わせフォーム機能拡張 PDF

【17-E-4】GitHub Enterpriseユーザ企業登壇!企業文化にイノベーションを起こすモダンなソフトウェア開発環境とは? PDF

Microsoft Power Platformで組織に力を与えよう PPTX

PDF

総売り上げ:35,400円 受託エンジニアが自社サービスのPOをやって学んだこと。 PDF

PDF

2020/12/03 SaaS を正しい方向へ加速するフィードバックループ PPTX

POWA50 - Power Apps と Power Automate の大規模な管理とサポート PDF

PDF

PPTX

データソースにLinqDataSourceを使った場合のGridViewの高速化 PDF

PDF

『ラブライブ!スクールアイドルフェスティバル ALL STARS』における開発事例 ~システムUIの管理についてご紹介~ PDF

Viewers also liked

PPTX

PDF

PPTX

ポコロンダンジョンズとリアルタイム通信 -サーバサイド編- PDF

ポコロンダンジョンズとリアルタイム通信 -クライアント編- PDF

[Azure Deep Dive] クラウド デザイン パターン ~優れたシステム構築のためのガイダンス~ PDF

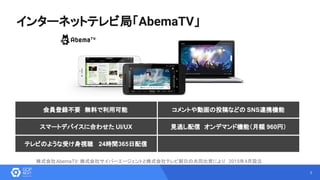

AbemaTVの動画配信を支えるサーバーサイドシステム PPTX

TechFeedのつくりかた - Angular2/Webpack/Ionic2/Cordova実践入門 PDF

Similar to Google Container Engine と Kubernetes で 無理をしないコンテナ管理

PDF

Google Container Engine (GKE) & Kubernetes のアーキテクチャ解説 PPTX

サイバーエージェントにおけるプライベートコンテナ基盤AKEを支える技術 PDF

Infra: Kubernetes and GKE, Network PDF

[GKE & Spanner 勉強会] GKE 入門 PPTX

PPTX

0から始めるコンテナの学び方(Kubernetes Novice Tokyo #14 発表資料) PDF

PDF

6 月 18 日 Next - Kubernetes のコンテナ技術ですべてをシンプルに PDF

最近良く聞く Kubernetes を体験してみた イントロ + 活用編 PDF

Wordpress案件にgkeを採用してみた(短縮版) PPTX

PDF

20191120 beyondstudy#21 kitaoka PDF

Kubernetes & Google Container Engine; DockerコンテナをGKEでクラスタリングしてみた PDF

20221105_GCPUG 女子会 Kubernets 編.pdf PDF

そろそろ知っておきたい!!コンテナ技術と�Dockerのキホン PPTX

Kubernetes etc.. & rancher 2.0 technical preview “Let’s import GKE/Bluemix/AK... PDF

インフラエンジニアのためのRancherを使ったDocker運用入門 PDF

PDF

[External] 2021.12.15 コンテナ移行の前に知っておきたいこと @ gcpug 湘南 PPTX

Google Container Engine と Kubernetes で 無理をしないコンテナ管理

- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

- 7.

- 8.

8

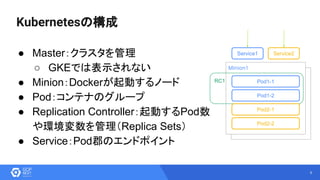

● Master:クラスタを管理

○ GKEでは表示されない

●Minion:Dockerが起動するノード

● Pod:コンテナのグループ

● Replication Controller:起動するPod数

や環境変数を管理(Replica Sets)

● Service:Pod郡のエンドポイント

Node1

Minion1

RC1 Pod1-1

Pod1-2

Pod2-1

Pod2-2

Service1 Service2

Kubernetesの構成

- 9.

9

apiVersion: v1

kind: ReplicationController

metadata:

name:abema-xxx

spec:

replicas: 4 ←起動するPodの数

selector:

name: abema-xxx

template:

metadata:

labels:

name: abema-xxx

environment: dev

spec:

containers:

- name: abema-xxx ↓環境変数

env:

- name: ENV

value: development

- name: REDIS_ADDR

value: redis-a:6379,redis-b:6379,redis-c:6379

image: asia.gcr.io/[projectid]/abema-xxx:v1.1.0

ports: ↑起動するDockerイメージとタグ

- containerPort: 30500

protocol: TCP

initialDelaySeconds: 15

timeoutSeconds: 5

apiVersion: v1

kind: Service

metadata:

name: abema-xxx

labels:

name: abema-xxx

spec:

selector:

name: abema-xxx

ports:

- port: 8484 ↓Pod郡にアクセスするためのポート

nodePort: 30200

protocol: TCP

name: http

type: NodePort

ReplicationController.yaml Service.yaml

- 10.

10

GKE at AbemaTV

●ホストOS : Debian GNU/Linux 7

● Kubernetes v1.2.0

● Docker 1.9.1

● ベースイメージ : Alpine Linux, Ubuntu

- 11.

- 12.

- 13.

- 14.

- 15.

- 16.

- 17.

- 18.

- 19.

![9

apiVersion: v1

kind: ReplicationController

metadata:

name: abema-xxx

spec:

replicas: 4 ←起動するPodの数

selector:

name: abema-xxx

template:

metadata:

labels:

name: abema-xxx

environment: dev

spec:

containers:

- name: abema-xxx ↓環境変数

env:

- name: ENV

value: development

- name: REDIS_ADDR

value: redis-a:6379,redis-b:6379,redis-c:6379

image: asia.gcr.io/[projectid]/abema-xxx:v1.1.0

ports: ↑起動するDockerイメージとタグ

- containerPort: 30500

protocol: TCP

initialDelaySeconds: 15

timeoutSeconds: 5

apiVersion: v1

kind: Service

metadata:

name: abema-xxx

labels:

name: abema-xxx

spec:

selector:

name: abema-xxx

ports:

- port: 8484 ↓Pod郡にアクセスするためのポート

nodePort: 30200

protocol: TCP

name: http

type: NodePort

ReplicationController.yaml Service.yaml](https://image.slidesharecdn.com/pdf-160907020657/85/Google-Container-Engine-Kubernetes-9-320.jpg)