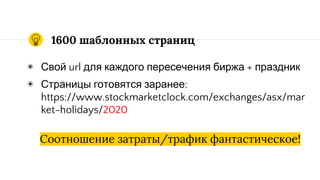

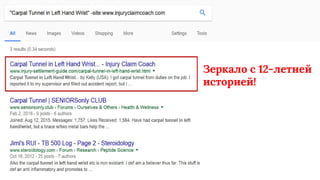

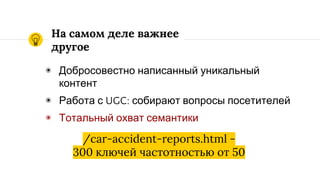

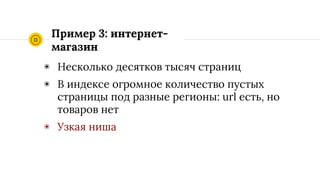

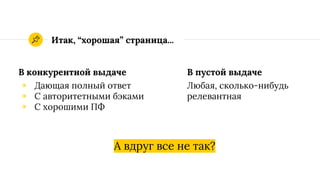

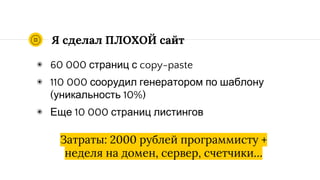

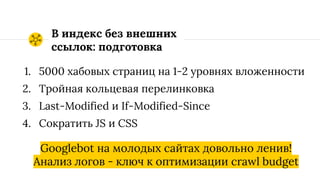

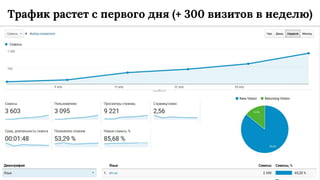

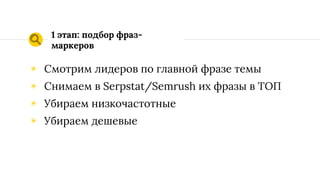

Документ анализирует стратегии успешного интернет-маркетинга, приводя примеры эффективных сайтов и их подходов к контенту и SEO. Основное внимание уделяется уникальному контенту, работе с пользовательским контентом (UGC) и поиску ниш с низкой конкуренцией. Также рассматриваются последствия обновления алгоритмов Google (Google Fred) и влияние качества страниц на трафик.