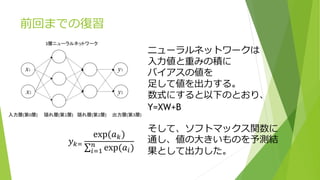

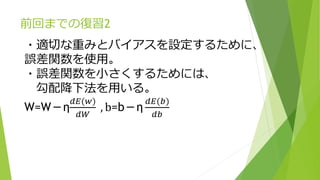

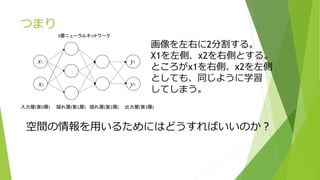

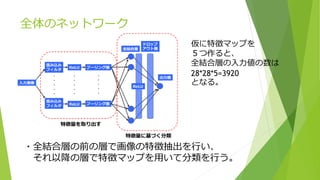

1) The document discusses convolutional neural networks, which utilize techniques like convolutional operations, padding, and pooling to extract features from image data and incorporate spatial information.

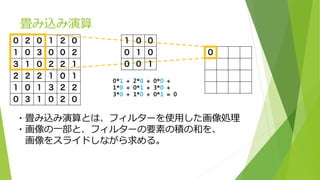

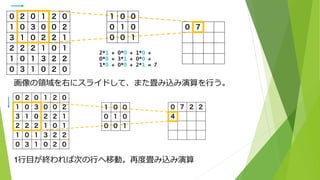

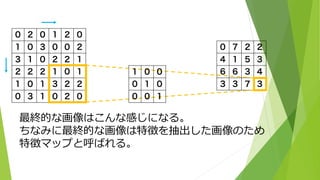

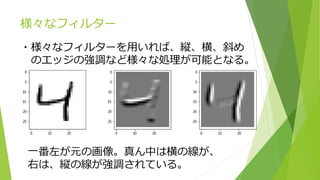

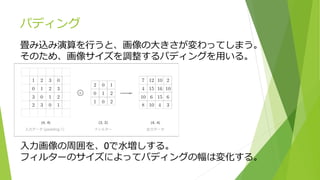

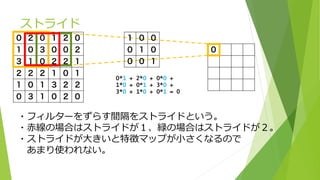

2) Convolutional operations involve applying filters to local regions of an image to produce feature maps. Padding and stride help adjust the size of these feature maps.

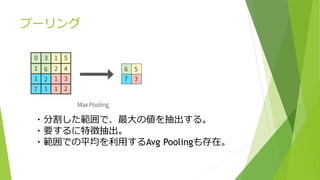

3) Pooling operates on regions of the feature maps to select the most prominent features, like the maximum value. This further abstracts the representations.