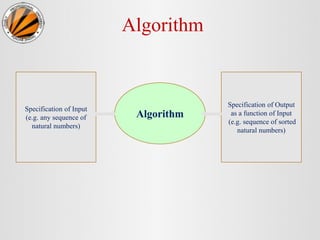

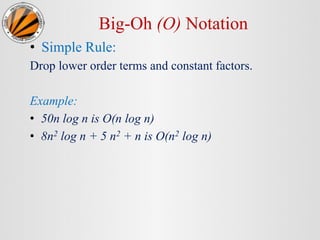

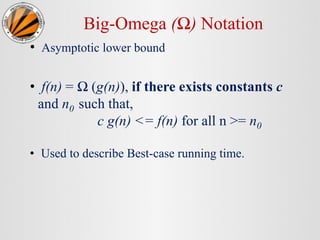

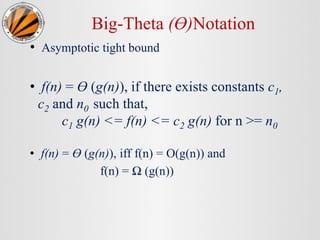

This document provides an overview of algorithms and asymptotic analysis. It defines key terms like algorithms, complexity analysis, and input/output specifications. It discusses analyzing time and space complexity, and introduces asymptotic notations like Big-O, Big-Omega, and Big-Theta to classify algorithms based on how their running time grows relative to the input size. Common algorithm classes like logarithmic, linear, quadratic, and exponential functions are presented. Examples of linear and binary search algorithms are provided to illustrate algorithm specifications and complexity analyses.

![Linear Search Algorithm

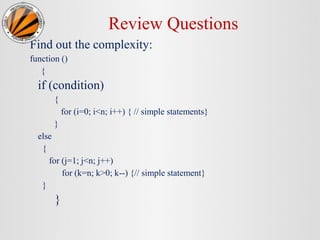

• LINEAR (DATA, N, ITEM, LOC)

1. [Insert ITEM at the end of DATA] Set Data [N]= ITEM.

2. [Initialize Counter] Set LOC=0.

3. [Search for ITEM.]

Repeat while DATA [LOC] != ITEM

Set LOC = LOC +1.

[End of loop.]

4. [Successful?] if LOC = N, then Print “ITEM not found”.

else return LOC.

5. Exit.](https://image.slidesharecdn.com/2-230820053602-6ca4d98a/85/2-Asymptotic-Notations-and-Complexity-Analysis-pptx-25-320.jpg)

![2. Binary Search

• BINARY ( DATA, LB, UB, ITEM, LOC )

1. [Initialize Segment Variables]

Set BEG = LB, END = UB and MID = INT ((BEG+END)/2).

2. Repeat Steps 3 and 4 while BEG < END and DATA [MID] != ITEM.

3. If ITEM < DATA[MID], then:

Set END = MID - 1.

Else:

Set BEG = MID + 1.

[End of if Structure.]

4. Set MID = INT ((BEG+END)/2).

[End of Step 2 Loop.]

5. If DATA [MID] = ITEM, then: Print “Item Found at ” LOC

Else:

Set LOC = NULL.

[End of if structure.]

6. Exit.](https://image.slidesharecdn.com/2-230820053602-6ca4d98a/85/2-Asymptotic-Notations-and-Complexity-Analysis-pptx-26-320.jpg)