More Related Content

PPTX

PPTX

PDF

A Machine Learning Framework for Programming by Example PDF

PDF

Coling2016 pre-translation for neural machine translation PDF

PPTX

PDF

More from sekizawayuuki

PDF

Translating phrases �in neural machine translation� PDF

Improving lexical choice in neural machine translation PDF

Improving Japanese-to-English Neural Machine Translation by Paraphrasing the ... PDF

Incorporating word reordering knowledge into attention-based neural machine t... PDF

paper introducing: Exploiting source side monolingual data in neural machine ... PPTX

目的言語の低頻度語の高頻度語への言い換えによるニューラル機械翻訳の改善 PDF

PDF

PDF

PDF

PDF

PDF

PDF

PDF

PDF

PDF

PDF

PDF

PDF

PDF

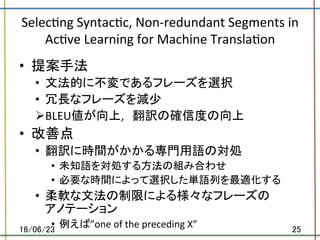

[論文紹介]Selecting syntactic, non redundant segments in active learning for machine translation

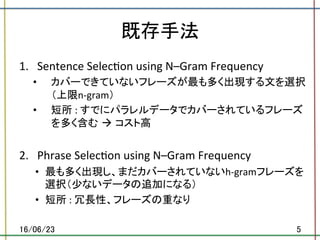

- 1.

- 2.

- 3.

- 4.

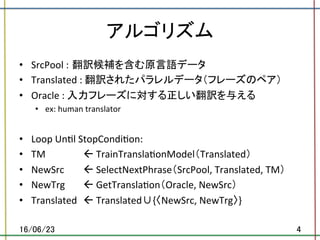

アルゴリズム

• SrcPool : 翻訳候補を含む原言語データ

• Translated : 翻訳されたパラレルデータ(フレーズのペア)

• Oracle : 入力フレーズに対する正しい翻訳を与える

• ex: human translator

• Loop Un.l StopCondi.on:

• TM ß TrainTransla.onModel(Translated)

• NewSrc ß SelectNextPhrase(SrcPool, Translated, TM)

• NewTrg ß GetTransla.on(Oracle, NewSrc)

• Translated ß Translated∪{〈NewSrc, NewTrg〉}

16/06/23 4

- 5.

- 6.

- 7.

- 8.

- 9.

- 10.

- 11.

- 12.

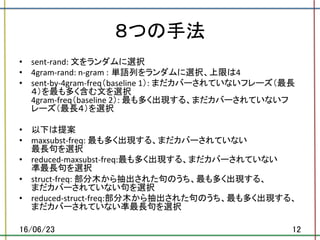

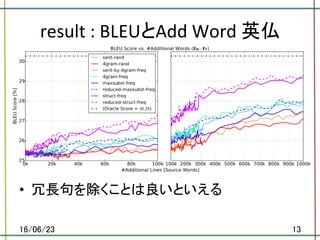

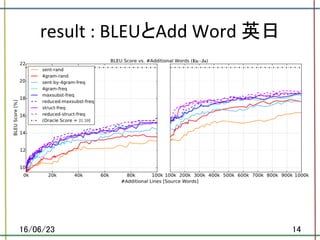

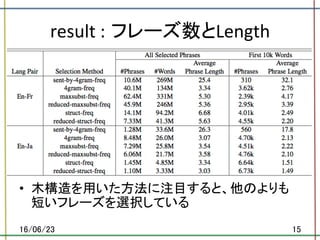

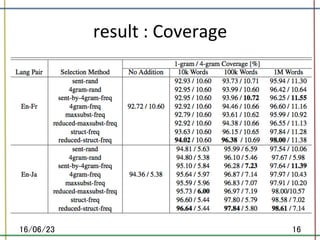

8つの手法

• sent-rand: 文をランダムに選択

• 4gram-rand: n-gram :単語列をランダムに選択、上限は4

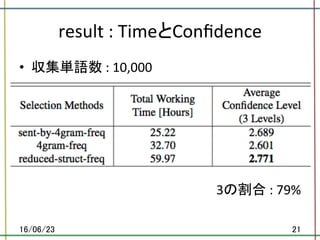

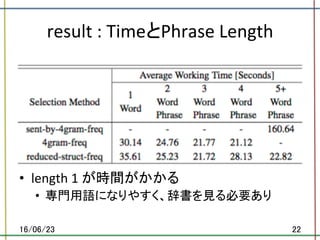

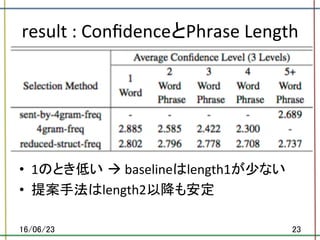

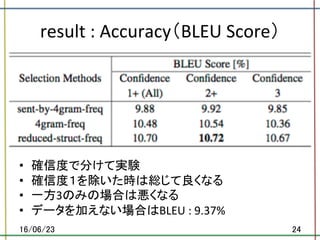

• sent-by-4gram-freq(baseline 1): まだカバーされていないフレーズ(最長

4)を最も多く含む文を選択

4gram-freq(baseline 2): 最も多く出現する、まだカバーされていないフ

レーズ(最長4)を選択

• 以下は提案

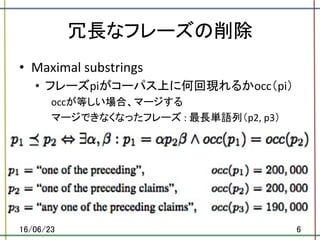

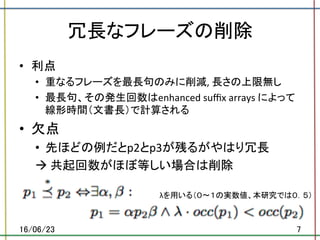

• maxsubst-freq: 最も多く出現する、まだカバーされていない

最長句を選択

• reduced-maxsubst-freq:最も多く出現する、まだカバーされていない

凖最長句を選択

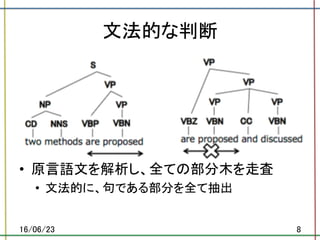

• struct-freq: 部分木から抽出された句のうち、最も多く出現する、

まだカバーされていない句を選択

• reduced-struct-freq:部分木から抽出された句のうち、最も多く出現する、

まだカバーされていない凖最長句を選択

16/06/23 12

- 13.

- 14.

- 15.

- 16.

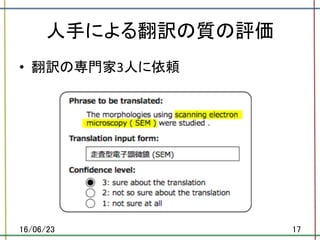

- 17.

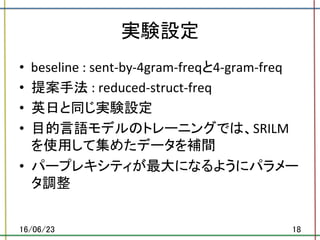

- 18.

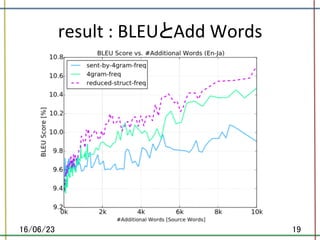

- 19.

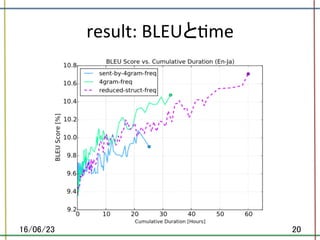

- 20.

- 21.

- 22.

- 23.

- 24.

- 25.