日本マイクロソフト株式会社

カスタマーサクセス事業本部 エンタープライズアーキテクト統括本部 クラウドアーキテクト技術本部 クラウドソリューションアーキテクト

真壁 徹

Azure は日々進化を続けており、「Azure、三日会わざれば刮目して見よ」と言ってもいいでしょう。このセッションでは、Azure のデータセンタ、仮想マシン、ネットワーク、ストレージといったコアインフラストラクチャに関する「意外に知られていない」技術や実装を、様々な実験を通じてご紹介します。学びはじめの人だけでなく、長く利用しているユーザも、その進化をお楽しみください。

【Microsoft Japan Digital Daysについて】

Microsoft Japan Digital Days は、お客様が競争力を高め、市場の変化に迅速に対応し、より多くのことを達成することを目的とした、日本マイクロソフトがお届けする最大級のデジタル イベントです。4 日間にわたる本イベントでは、一人一人の生産性や想像力を高め、クラウド時代の組織をデザインするモダンワークの最新事例や、変化の波をうまく乗り切り、企業の持続的な発展に必要なビジネスレジリエンス経営を支えるテクノロジの最新機能および、企業の競争優位性に欠かせないクラウド戦略のビジョンなどデジタル時代に必要な情報をお届けいたしました。(2021年10月11日~14日開催)

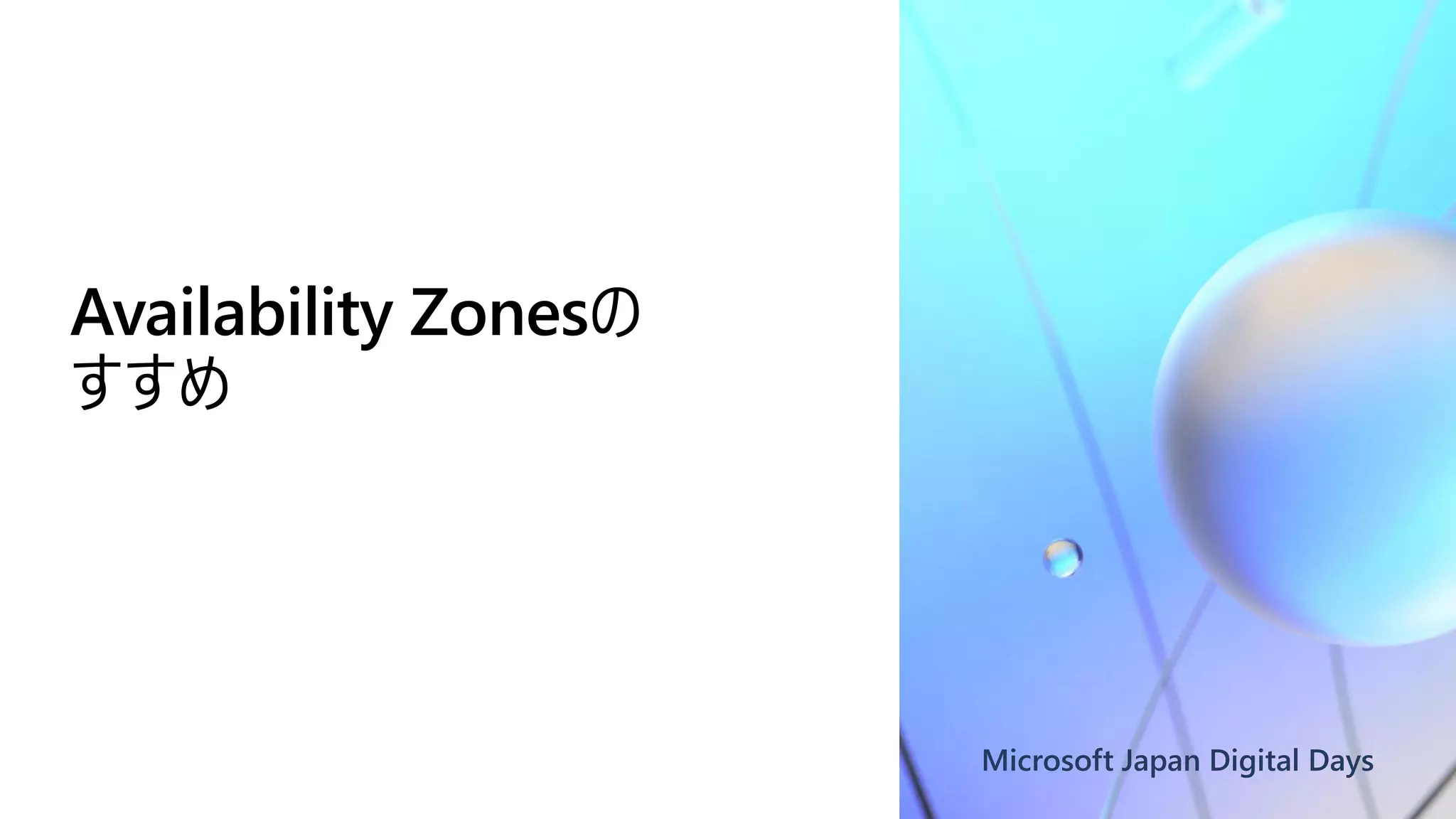

![Availability Zones(AZ) のすすめ

各Zoneは独立した電源、冷却、

ネットワーク設備を備える

障害、災害の影響を局所化

サービスのAZ化が進行中

[Link] Availability Zones をサ

ポートする Azure サービス

可用性を重視するシステムでは

利用を強く推奨

[Link] Azure のリージョンと Availability Zones](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-5-2048.jpg)

![障害、災害だけでなくメンテナンス影響の観点でも推奨

設備だけではなく、仮想マシン

のメンテナンススケジュール単位

(更新ドメイン)も分離

仮想マシンはもちろん、その上

で動いているマネージドサービス

にも好影響

マネージドサービスは更新ドメインが

不可視だが、ゾーン冗長構成を選

択することで明確に

「お客様の観点からは、ゾーン冗長性を備え

たゲートウェイをデプロイできるようになります。

つまり、すべてのゲートウェイ インスタンスが複

数の Azure Availability Zones にわたって

デプロイされ、それぞれの Availability Zone

が別々の障害ドメインおよび更新ドメインと

なります。 これにより、ゲートウェイの信頼性、

可用性、およびゾーン障害に対する回復性

が向上します。」

[Link] Azure Availability Zones でのゾーン冗長仮想

ネットワーク ゲートウェイ - Azure VPN Gateway](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-6-2048.jpg)

![AZ識別子はサブスクリプションによって異なる

意外に知られていない

概念的にはサブスクリプション

IDのハッシュ化

リソースの偏りを避けるなどの目

的

AZ識別子とリソースを厳密に

紐づけたい場合は、同じサブス

クリプション下で行う

「可用性ゾーン識別子 (上の図の番号 1、2、

3) は、各サブスクリプションの実際の物理

ゾーンに個別に論理マップされます。 つまり、

特定のサブスクリプションの可用性ゾーン 1

が、別のサブスクリプションの可用性ゾーン 1

とは異なる物理ゾーンを参照している可能性

があります。 そのため、仮想マシンの配置で

は、異なるサブスクリプション間で可用性ゾー

ン ID を使用しないようにお勧めします。」

[Link] Azure のリージョンと Availability Zones](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-7-2048.jpg)

![microsoft/Ethr

Goで書かれたネットワーク性能

測定ツール

オープンソース

(私見)ソースコードが読みやすい

この検証ではTCP Latencyテス

トを使用

[Link] microsoft/ethr](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-14-2048.jpg)

![runTCPLatencyTest

conn, err := ethrDial(TCP, test.dialAddr)

[snip]

ExitForLoop:

for {

ExitSelect:

select {

case <-test.done:

break ExitForLoop

default:

t0 := time.Now()

for i := uint32(0); i < rttCount; i++ {

s1 := time.Now()

n, err := conn.Write(buff)

[snip]

_, err = io.ReadFull(conn, buff)

[snip]

e2 := time.Since(s1)

latencyNumbers[i] = e2

}

[snip]

TCPコネクション作成

rttCount = 1000

(1000回送受信する)

事前に作成しておいたコネクションへ

のWrite(直前)から、ReadFull完了

(直後)までの時間

buff は 1byte](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-15-2048.jpg)

![adminuser@vm-nw-latency-eval-1:~$ ethr -c 10.0.0.10 -t l -p tcp

[snip]

Using destination: 10.0.0.10, ip: 10.0.0.10, port: 8888

Running latency test: 1000, 1

-----------------------------------------------------------------------------------------

Avg Min 50% 90% 95% 99% 99.9% 99.99% Max

402.582us 168.303us 291.005us 725.212us 980.417us 1.955ms 3.397ms 3.397ms 5.510ms

363.104us 165.003us 279.005us 597.510us 805.314us 1.633ms 2.303ms 2.303ms 2.567ms

463.081us 161.703us 324.505us 901.015us 1.153ms 1.939ms 3.079ms 3.079ms 3.184ms

363.558us 150.202us 273.804us 597.710us 805.913us 1.636ms 3.838ms 3.838ms 5.426ms

407.871us 169.503us 291.204us 732.111us 989.815us 1.912ms 3.060ms 3.060ms 5.928ms

367.769us 157.203us 274.004us 642.709us 854.713us 1.588ms 2.416ms 2.416ms 5.746ms

377.069us 160.802us 285.104us 634.109us 870.613us 1.919ms 2.573ms 2.573ms 3.018ms

463.531us 171.303us 305.205us 953.014us 1.247ms 2.008ms 2.478ms 2.478ms 2.494ms

387.637us 158.502us 301.704us 612.508us 839.012us 1.715ms 3.145ms 3.145ms 5.924ms

418.913us 167.602us 318.205us 741.810us 951.313us 1.696ms 2.706ms 2.706ms 3.027ms

Ethr done, duration: 10s.

(参考) Pattern 1

全パターンの結果はGitHubに公開(リンクは資料末を参照)

1行が1000回の

送受信サマリ

10秒間測定

1000回の送受信ごとにサマリする

送受信サイズは1Byte

次ページに

平均を記載

次ページに

平均を記載](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-16-2048.jpg)

![機械学習は、仮想マシン提供待ち時間の短縮にも貢献

機械学習を活かしたPre-

Provisioning

ユーザーが仮想マシン作成を指

示する前に、予測して準備して

おく

[Link] Intelligent Virtual Machine

Provisioning in Cloud Computing -

Microsoft Research

ユーザーか

らの要求

スケジュー

リング

VM

作成

ユーザーへ

の通知

ユーザーか

らの要求

準備済み

VMを割り当て

ユーザーへ

の通知

従来

Pre-

Provisioning](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-22-2048.jpg)

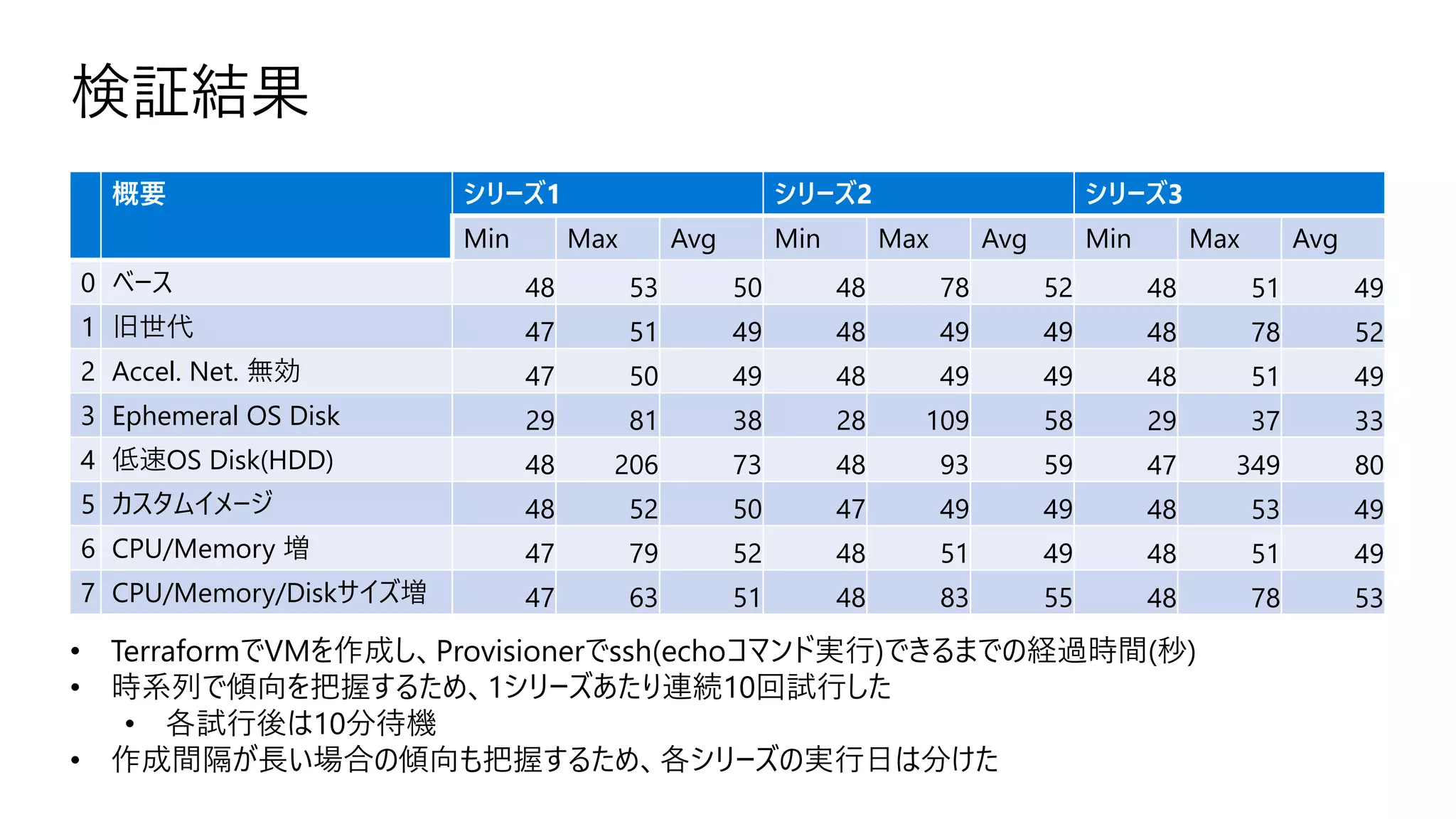

![検証結果 (シリーズ1)

0

50

100

150

200

250

1 2 3 4 5 6 7 8 9 10

azurerm_linux_virtual_machine.vm_startup_time_eval["0"] azurerm_linux_virtual_machine.vm_startup_time_eval["1"] azurerm_linux_virtual_machine.vm_startup_time_eval["2"]

azurerm_linux_virtual_machine.vm_startup_time_eval["3"] azurerm_linux_virtual_machine.vm_startup_time_eval["4"] azurerm_linux_virtual_machine.vm_startup_time_eval["5"]

azurerm_linux_virtual_machine.vm_startup_time_eval["6"] azurerm_linux_virtual_machine.vm_startup_time_eval["7"]

OS Disk: Standard(HDD)

OS Disk:

Ephemeral](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-27-2048.jpg)

![検証結果 (シリーズ2)

0

20

40

60

80

100

120

1 2 3 4 5 6 7 8 9 10

azurerm_linux_virtual_machine.vm_startup_time_eval["0"] azurerm_linux_virtual_machine.vm_startup_time_eval["1"] azurerm_linux_virtual_machine.vm_startup_time_eval["2"]

azurerm_linux_virtual_machine.vm_startup_time_eval["3"] azurerm_linux_virtual_machine.vm_startup_time_eval["4"] azurerm_linux_virtual_machine.vm_startup_time_eval["5"]

azurerm_linux_virtual_machine.vm_startup_time_eval["6"] azurerm_linux_virtual_machine.vm_startup_time_eval["7"]

学習モデルの更新など

イベントが発生した可能性あり](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-28-2048.jpg)

![検証結果 (シリーズ3)

0

50

100

150

200

250

300

350

400

1 2 3 4 5 6 7 8 9 10

azurerm_linux_virtual_machine.vm_startup_time_eval["0"] azurerm_linux_virtual_machine.vm_startup_time_eval["1"] azurerm_linux_virtual_machine.vm_startup_time_eval["2"]

azurerm_linux_virtual_machine.vm_startup_time_eval["3"] azurerm_linux_virtual_machine.vm_startup_time_eval["4"] azurerm_linux_virtual_machine.vm_startup_time_eval["5"]

azurerm_linux_virtual_machine.vm_startup_time_eval["6"] azurerm_linux_virtual_machine.vm_startup_time_eval["7"]

OS Disk: Standard(HDD)

OS Disk:

Ephemeral](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-29-2048.jpg)

![runTCPLatencyTest

func runTCPLatencyTest(test *ethrTest, g time.Duration, toStop chan int) {

ui.printMsg("Running latency test: %v, %v", test.clientParam.RttCount,

test.clientParam.BufferSize)

conn, err := ethrDial(TCP, test.dialAddr)

if err != nil {

ui.printErr("Error dialing the latency connection: %v", err)

return

}

[snip]

新規コネクション作成に失敗すると、

このメッセージが出力される

では、EthrのTCPレイテンシテストを活用し、NSGとTCによる遮断時の挙動

を確認してみましょう](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-38-2048.jpg)

![NSG:コネクション確立前

```

Terraformで下記パラメータのNSG Ruleを注入しておく

nsg_rule_injection = {

name = "ethr"

priority = 200

direction = "Outbound"

access = "Deny"

protocol = "Tcp"

source_port_range = "*"

destination_port_range = "8888"

source_address_prefix = "*"

destination_address_prefix = "*"

}

```

$ ethr -c 10.0.0.4 -t l -p tcp -d 0

[snip]

Using destination: 10.0.0.4, ip: 10.0.0.4, port: 8888

Running latency test: 1000, 1

Error dialing the latency connection: dial tcp4 :0->10.0.0.4:8888: i/o timeout

^CEthr done, received interrupt signal.

Ethrサーバー(ポート番号:8888)向け

通信を拒否する

コネクション作成が失敗する](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-39-2048.jpg)

![NSG:コネクション確立後

$ ethr -c 10.0.0.4 -t l -p tcp -d 0

[snip]

Using destination: 10.0.0.4, ip: 10.0.0.4, port: 8888

Running latency test: 1000, 1

-----------------------------------------------------------------------------------------

Avg Min 50% 90% 95% 99% 99.9% 99.99% Max

419.529us 398.305us 406.105us 463.006us 467.707us 474.106us 512.707us 512.707us 558.008us

409.854us 397.206us 406.206us 415.306us 451.806us 464.906us 511.707us 511.707us 537.907us

413.850us 396.205us 403.305us 454.906us 459.906us 467.507us 588.808us 588.808us 690.910us

419.045us 394.106us 404.405us 464.006us 465.407us 471.606us 511.307us 511.307us 534.708us

416.204us 394.305us 403.105us 462.606us 464.906us 473.207us 525.307us 525.307us 603.008us

405.982us 398.905us 403.806us 409.406us 412.906us 443.705us 491.207us 491.207us 534.307us

404.770us 396.305us 403.206us 406.505us 413.106us 455.206us 558.807us 558.807us 593.208us

403.580us 395.605us 399.505us 406.305us 441.706us 456.006us 759.710us 759.710us 808.911us

411.011us 396.105us 402.705us 454.206us 463.506us 469.906us 518.907us 518.907us 645.809us

[snip]

テスト開始、コネクション確

立後に別セッションから

NSG Ruleを注入

止まらない](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-40-2048.jpg)

![TC:コネクション確立前

$ sudo tc qdisc add dev eth0 root handle 1: prio

$ sudo tc filter add dev eth0 protocol ip parent 1: prio 2 u32 match ip dst 0.0.0.0/0 flowid 1:2

$ sudo tc qdisc add dev eth0 parent 1:1 handle 10: netem loss 100%

$ sudo tc filter add dev eth0 protocol ip parent 1: prio 1 u32 match ip dport 8888 0xffff flowid 1:1

$ ethr -c 10.0.0.4 -t l -p tcp -d 0

[snip]

Using destination: 10.0.0.4, ip: 10.0.0.4, port: 8888

Running latency test: 1000, 1

Error dialing the latency connection: dial tcp4 :0->10.0.0.4:8888: i/o timeout

^CEthr done, received interrupt signal.

Ethrサーバー(ポート番号:8888)向けの

パケットを100%破棄する

コネクション作成が失敗する](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-41-2048.jpg)

![TC:コネクション確立後

$ ethr -c 10.0.0.4 -t l -p tcp -d 0

[snip]

Using destination: 10.0.0.4, ip: 10.0.0.4, port: 8888

Running latency test: 1000, 1

-----------------------------------------------------------------------------------------

Avg Min 50% 90% 95% 99% 99.9% 99.99% Max

428.814us 401.503us 410.303us 475.103us 479.403us 524.204us 569.304us 569.304us 615.605us

428.740us 398.903us 409.703us 474.703us 476.404us 493.904us 637.105us 637.105us 934.207us

412.555us 396.803us 405.603us 420.303us 465.003us 471.403us 693.505us 693.505us 1.550ms

408.641us 397.203us 401.702us 409.302us 418.603us 463.804us 1.544ms 1.544ms 2.311ms

416.548us 399.302us 406.103us 462.503us 470.203us 476.503us 539.104us 539.104us 1.138ms

[stopping…]

Ethr done, connection terminated.

テスト開始、コネクション確

立後に別セッションからtc

qdisc、filterでパケットを

100%破棄

止まったまま、数分後にコネ

クションが終了する

TCを使えば、コネクション確立後にも疑似的な応答不可状態を注入できた

ただし、何が起こっているかが明確には分からない TCPなので再送しているはずだが…

(パケットキャプチャの海から拾い上げる? つらい)](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-42-2048.jpg)

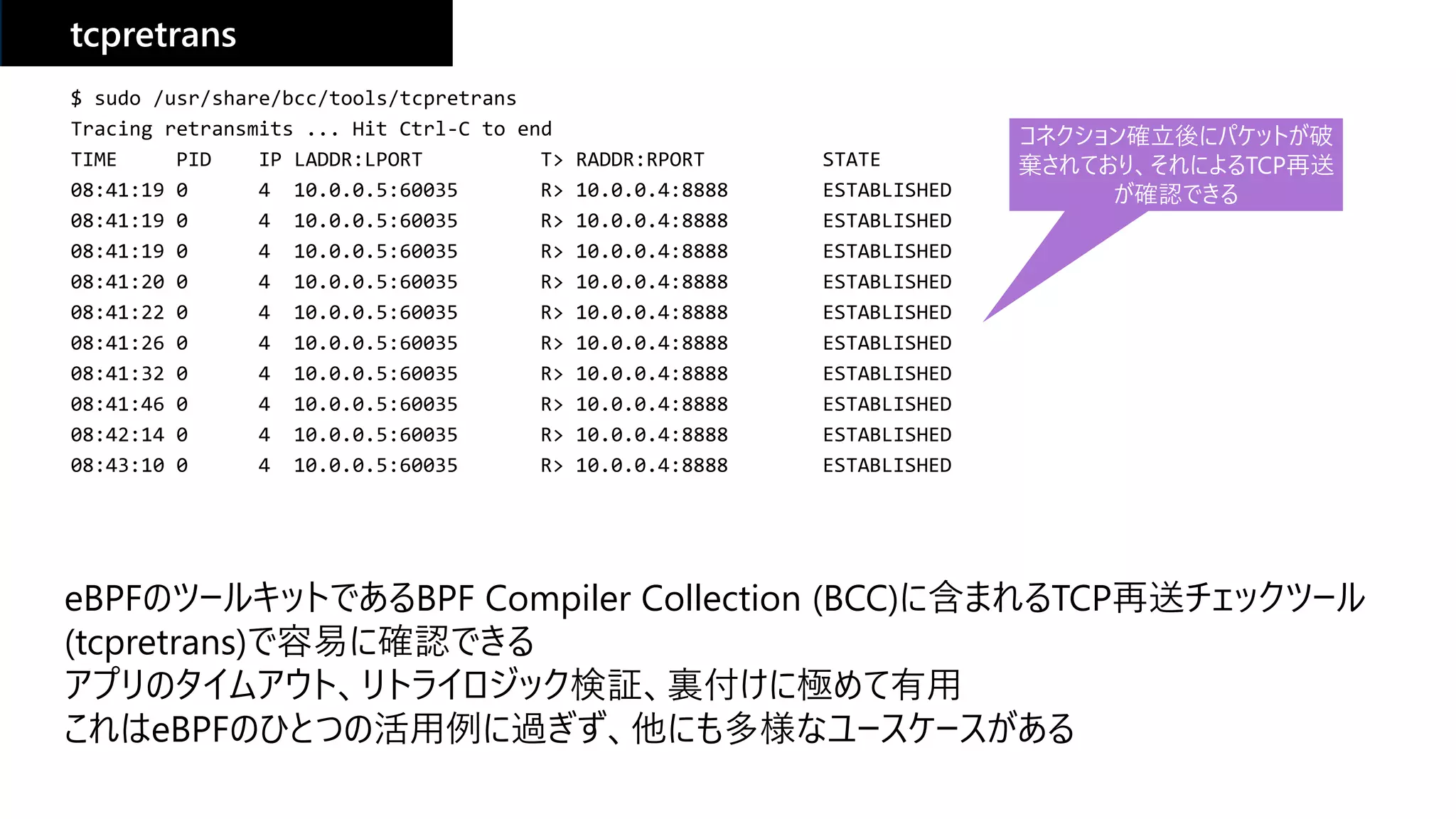

![eBPF (extended Berkeley Packet Filter)

[Link] What is eBPF? An Introduction and Deep Dive into the eBPF Technology

• パケットフィルタとして歴史あるBPF(Berkeley Packet Filter)を拡張した仕組み

• ネットワークに限らず、様々なシステムイベントをカーネル空間で効率よく取得可能

• ユースケース: 可観測性向上、パケット転送、DDoSフィルタ、etc

• eBPF Foundation: 2021/8月に設立(Microsoft, Facebook, Google, Isovalent, Netflix)](https://image.slidesharecdn.com/m08azure-211027131016/75/M08_-Azure-Microsoft-Japan-Digital-Days-43-2048.jpg)