Mohit Goyal, Sahil Modi, Rishabh Goyal, Saurabh Gupta, "Human Hands As Probes for Interactive Object Understanding" CVPR2022

https://openaccess.thecvf.com/content/CVPR2022/html/Goyal_Human_Hands_As_Probes_for_Interactive_Object_Understanding_CVPR_2022_paper.html

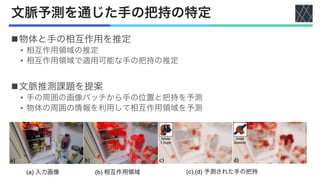

![手段

n学習済みモデルにより検出された手の把持タイプを予測

• 分類データセット : YCB-Affordance[Corona+,CVPR2020]

n手と物体の画像を連続したフレームで繋ぎ合わせ,トラックを形成

nトラックは状態依存の特徴量の学習に利用

n手と物体の相互作用はフレームごとの予測を用いて学習](https://image.slidesharecdn.com/20230406humanhandsasprobesforinteractiveobjectunderstanding-230414082740-561b631f/85/Human-Hands-As-Probes-for-Interactive-Object-Understanding-4-320.jpg)

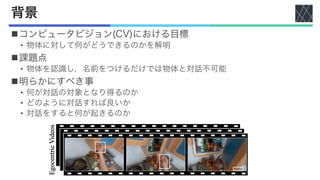

![モデルの構成と学習

nマスクされた領域はエンコーダーで処理

• エンコーダー : ResNet-50 [He+, CVPR2016]

n2つのタイプを予測する別々のヘッドに送信

• マスクセグメンテーション

• 把持タイプ

n2値クロスエントロピーロスで学習](https://image.slidesharecdn.com/20230406humanhandsasprobesforinteractiveobjectunderstanding-230414082740-561b631f/85/Human-Hands-As-Probes-for-Interactive-Object-Understanding-9-320.jpg)

![実験設定

nビデオデータセット

• EPIC-KITCHENS

• EPIC-KITCHENS-55 [Damen+, ECCV2018][Damen+, TPAMI2021]

• EPIC-KITCHENS-100 [Damen+, IJCV2021]

nイメージデータセット

• COCO [Lin+, ECCV2014]

• ImageNet-1k [Deng+, CVPR2009]

• ImageNet-21k [Deng+, CVPR2009]

nセグメンテーション

• Mask R-CNN [He+, ICCV2017]](https://image.slidesharecdn.com/20230406humanhandsasprobesforinteractiveobjectunderstanding-230414082740-561b631f/85/Human-Hands-As-Probes-for-Interactive-Object-Understanding-12-320.jpg)

![物体の状態に反応する特徴のテスト

n学習した特徴空間 𝜙% の物体状態の分類に対する性能をテスト

• ImageNetの事前学習より高性能

• 教師あり学習より高性能

• 他の自己教師学習より高性能

• SimCLR [Chen+, ICML2020]

• TCN [Sermanet+, ICRA2018]

• 低データ量や新規物体への汎化

においての性能向上

分類の性能を平均精度で比較

TSC:Temporal SimCLR

OHC:Object-Hand Consistency](https://image.slidesharecdn.com/20230406humanhandsasprobesforinteractiveobjectunderstanding-230414082740-561b631f/85/Human-Hands-As-Probes-for-Interactive-Object-Understanding-13-320.jpg)