この資料は「db tech showcase 東京 2014」と言うテクニカルイベントにて、弊社の新しいOracle DBシステムの構成について発表した際のものです。

【イベントの概要】

■イベント名

db tech showcase 東京 2014

■主催

株式会社 インサイトテクノロジー

■イベントURL

http://www.insight-tec.com/dbts-tokyo-2014.html

【セッションの概要】

■日時

2014/11/13(木) 16:00 - 16:50

■タイトル

C36:Oracle [Yahoo] 目指せExadata!! Oracle DB高速化を目指した構成

■概要

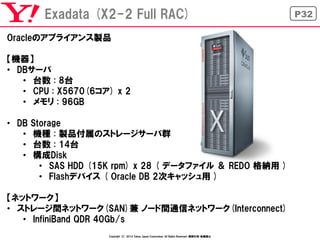

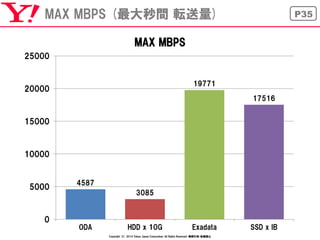

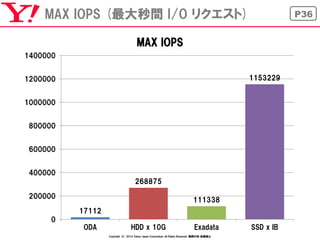

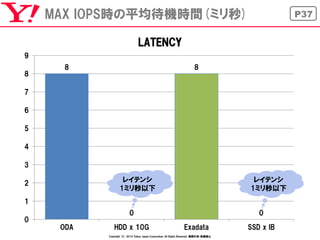

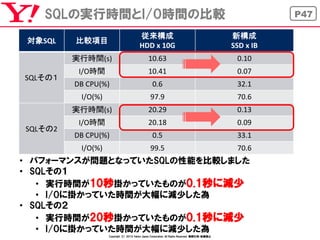

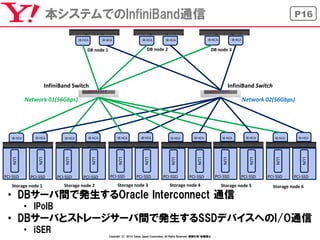

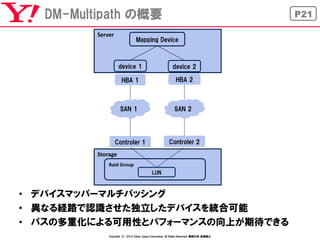

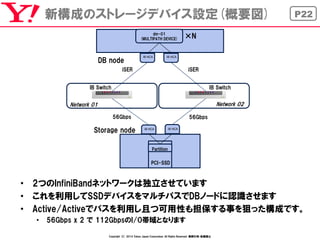

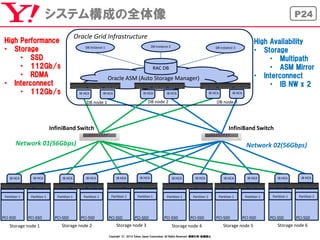

ExadataはストレージデバイスにSSD、ノード間通信、ストレージ間通信にInfiniBand、そしてストレージノード側に独自のシステム Exadata Smart Scanを搭載し最強、最高のパフォーマンスを謳っています。

しかしその導入コストは非常に高く、敬遠しているユーザーも多いのが現状です。

弊社では、このExadataに迫るパフォーマンスのDB システム構成を検討し、今年の2月に導入に至っています。

このセッションでは、弊社のOracle高速DBシステムの構成と、行ってきた検証や性能比較、そして問題点は何処に有るのかを明らかにしたいと思います。

![P29

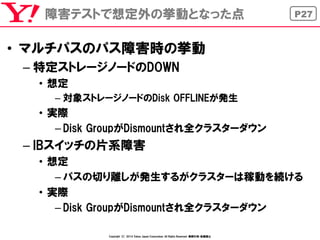

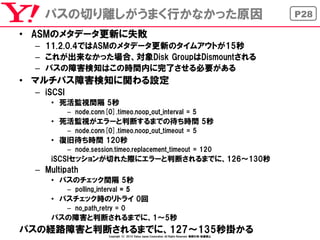

パスの切り離しがうまく行かなかった原因

•ASMのメタデータ更新に失敗

–11.2.0.4ではASMのメタデータ更新のタイムアウトが15秒

–これが出来なかった場合、対象Disk GroupはDismountされる

–パスの障害検知はこの時間内に完了させる必要がある

•マルチパス障害検知に関わる設定

–iSCSI

•死活監視間隔 5秒

–node.conn[0].timeo.noop_out_interval = 5

•死活監視がエラーと判断するまでの待ち時間 5秒

–node.conn[0].timeo.noop_out_timeout = 5

•復旧待ち時間 120秒

–node.session.timeo.replacement_timeout = 120

iSCSIセッションが切れた際にエラーと判断されるまでに、126~130秒

–Multipath

•パスのチェック間隔 5秒

–polling_interval = 5

•パスチェック時のリトライ 0回

–no_path_retry = 0

パスの障害と判断されるまでに、1~5秒

パスの経路障害と判断されるまでに、127~135秒掛かる

Copyright (C) 2014 Yahoo Japan Corporation. All Rights Reserved. 無断引用・転載禁止](https://image.slidesharecdn.com/exadataoracledb-141125203214-conversion-gate01/85/dbts-2014-tokyo-Exadata-Oracle-DB-29-320.jpg)