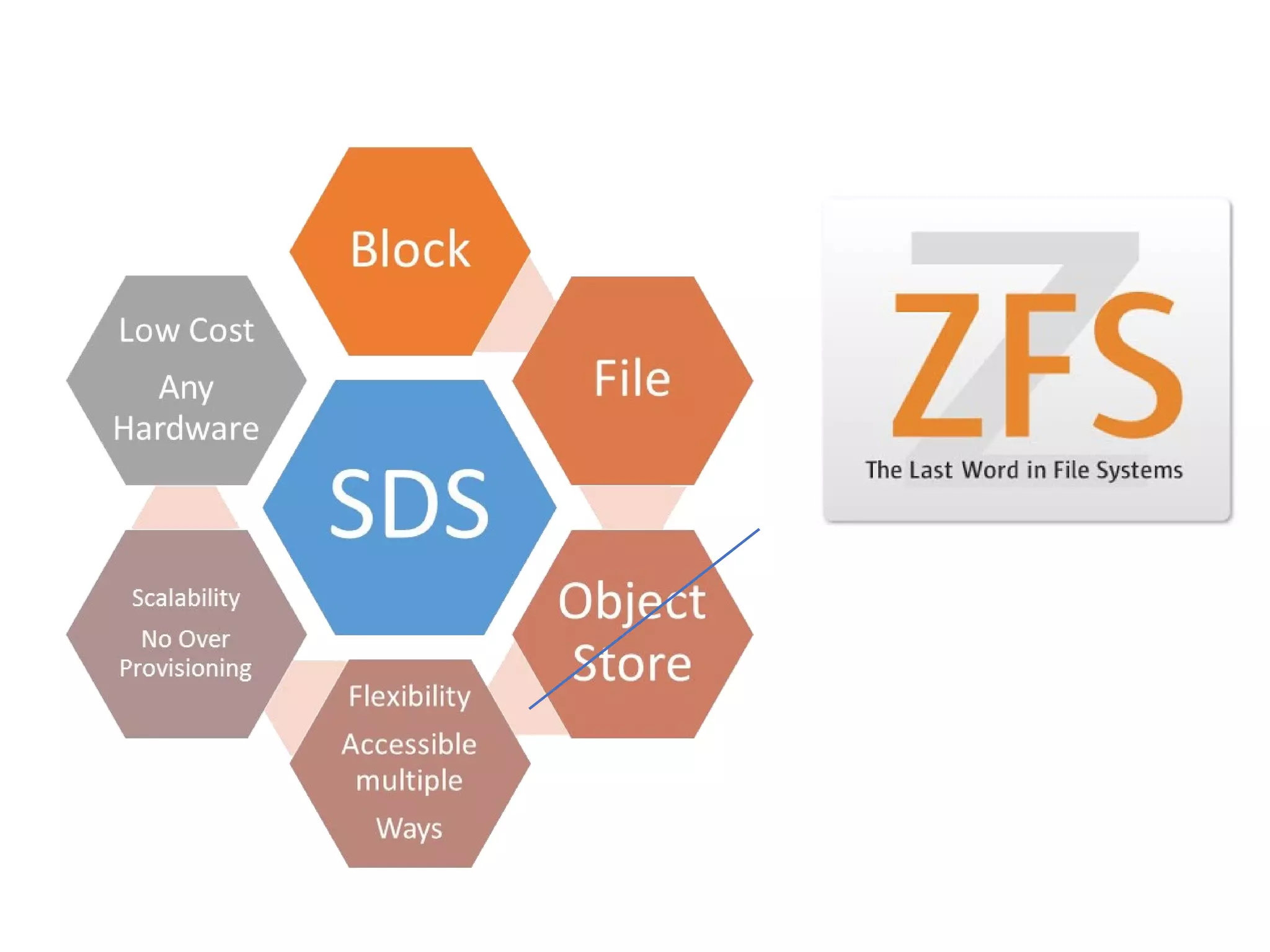

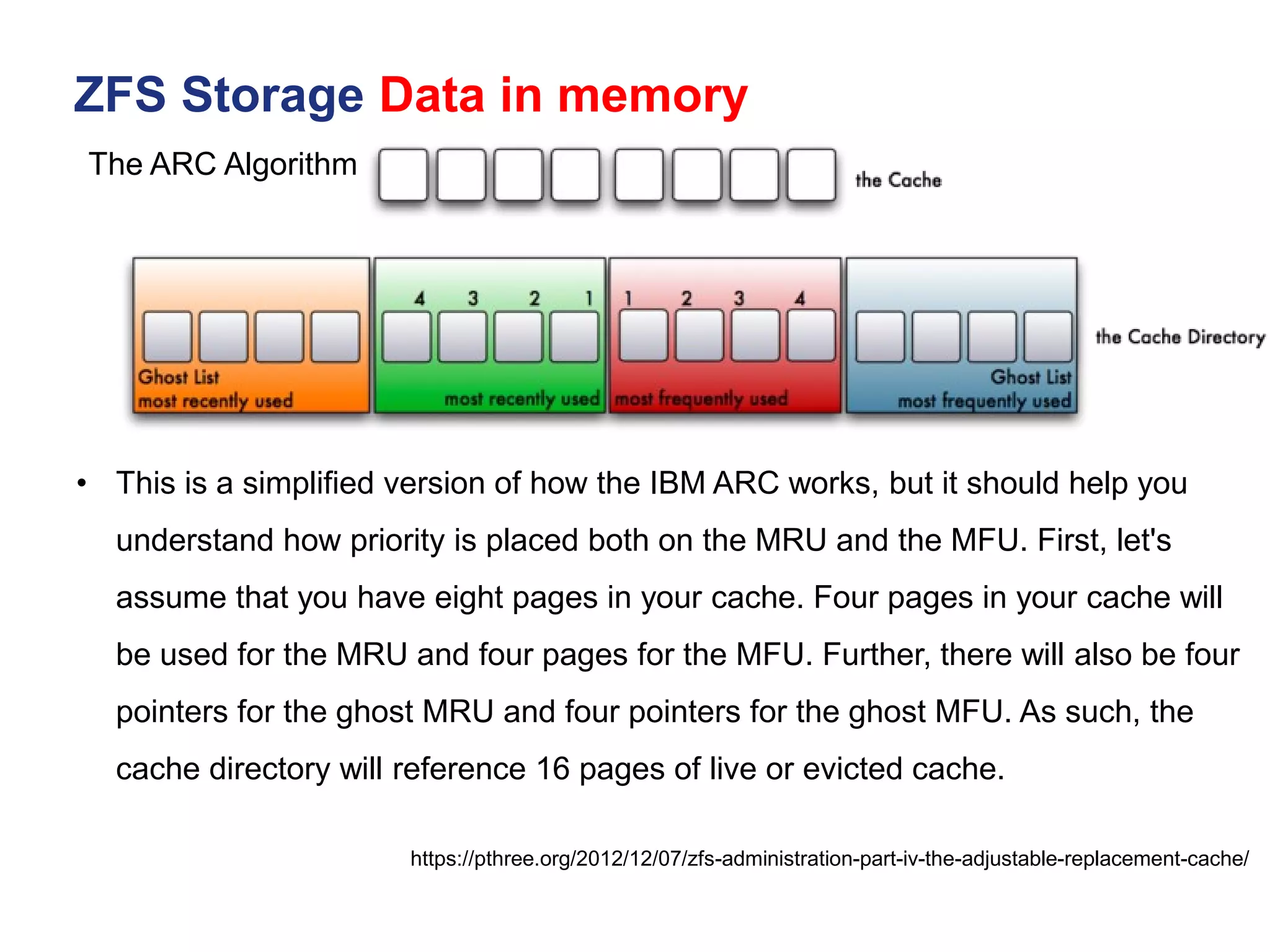

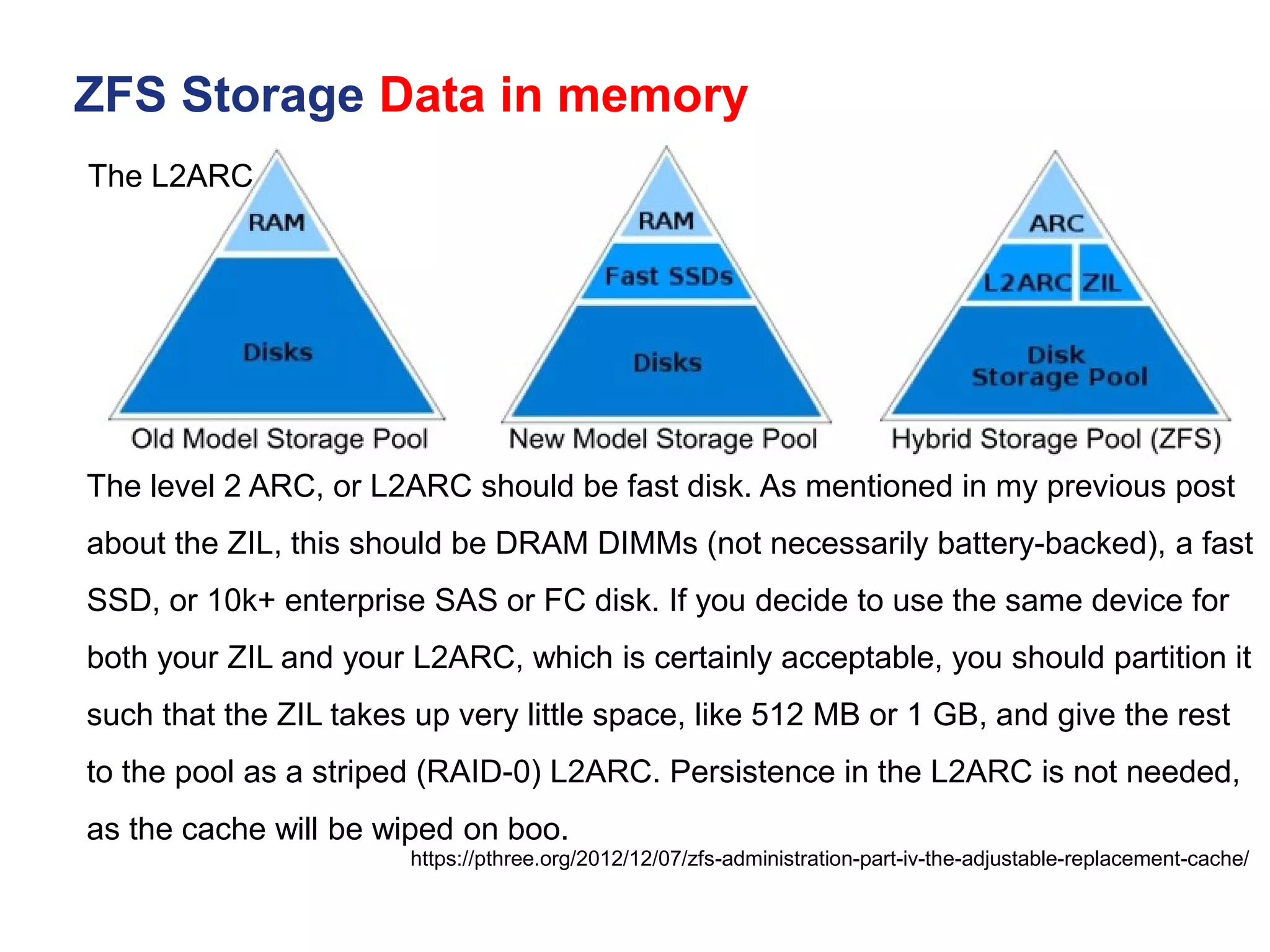

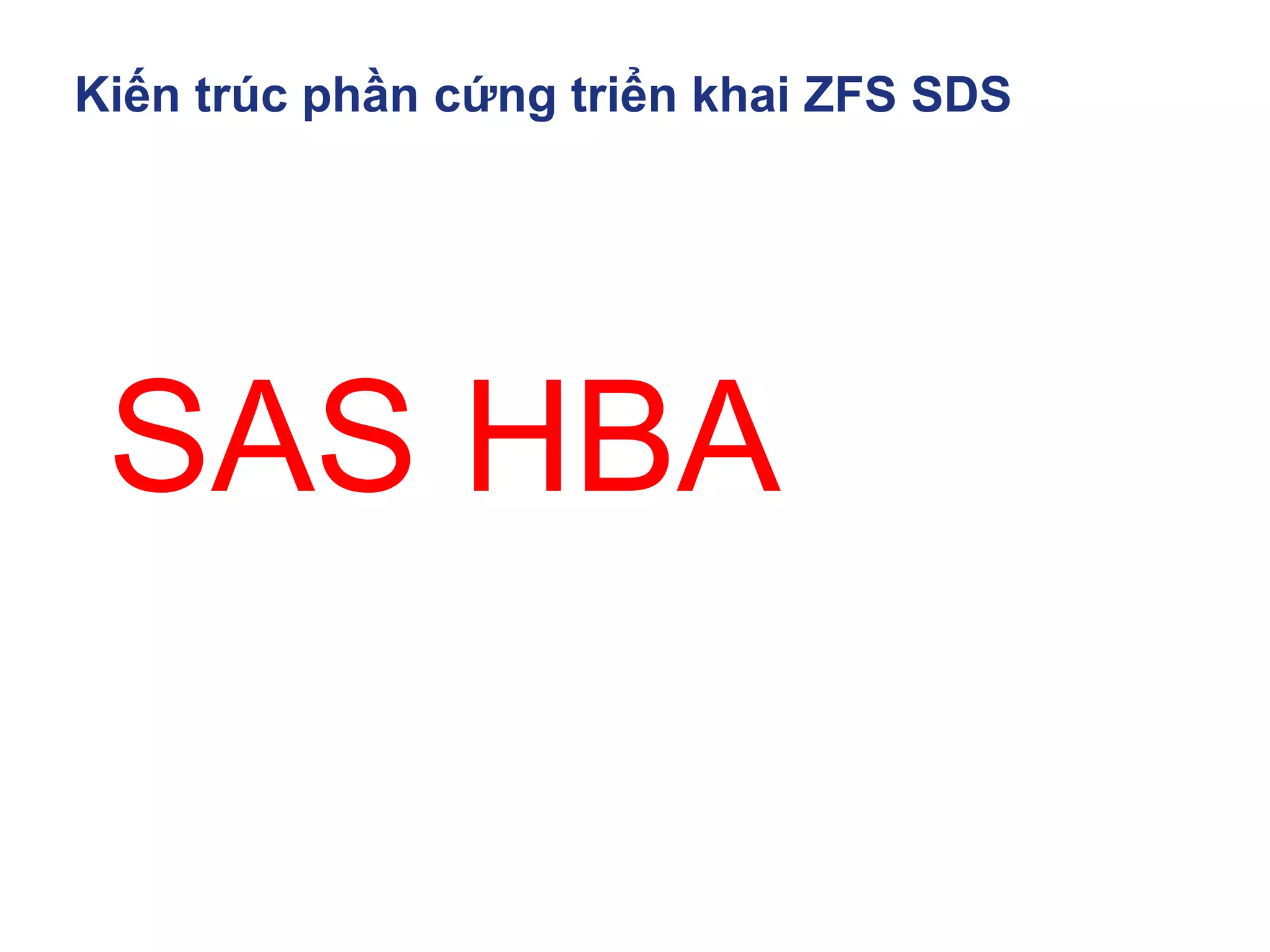

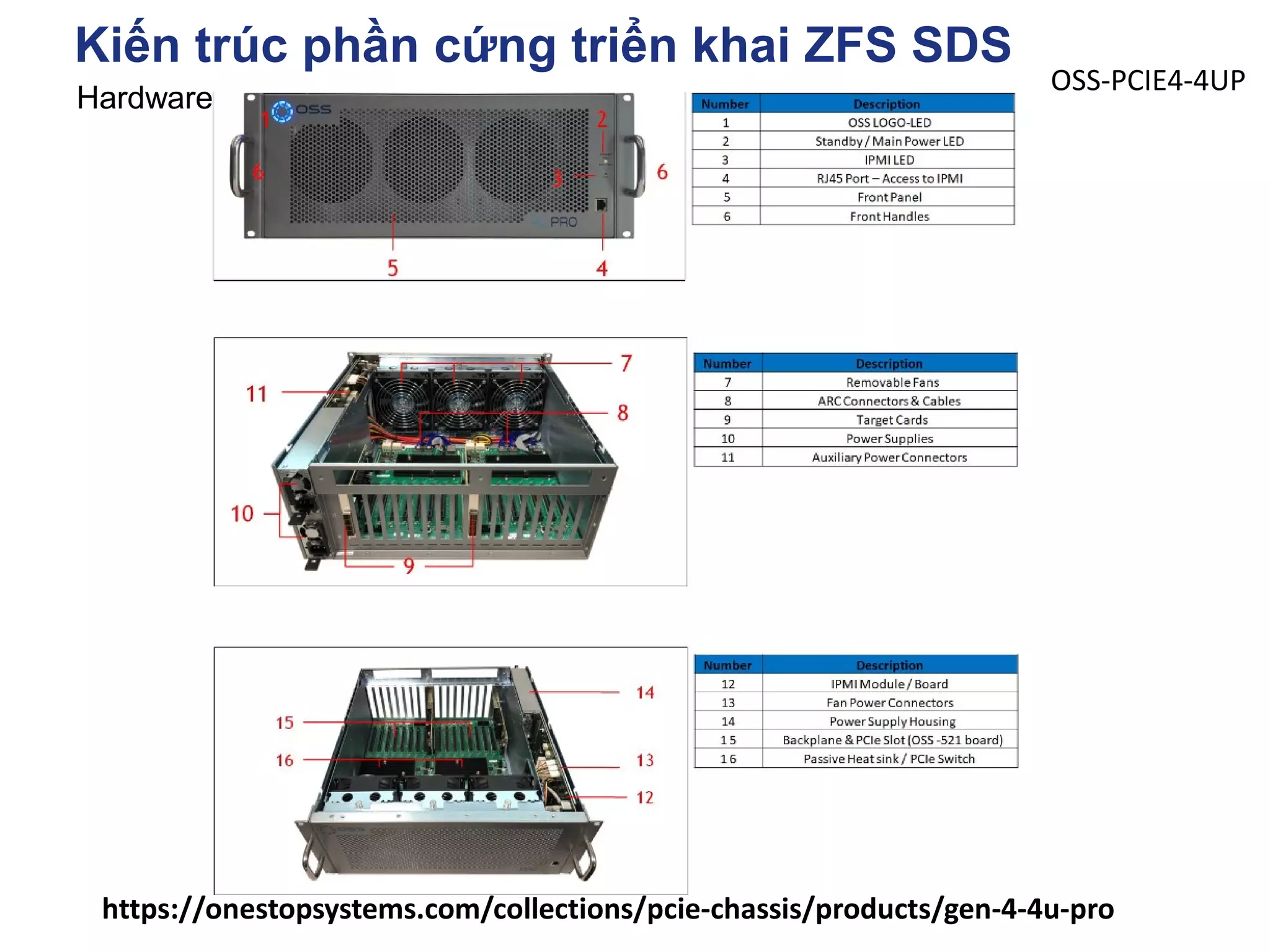

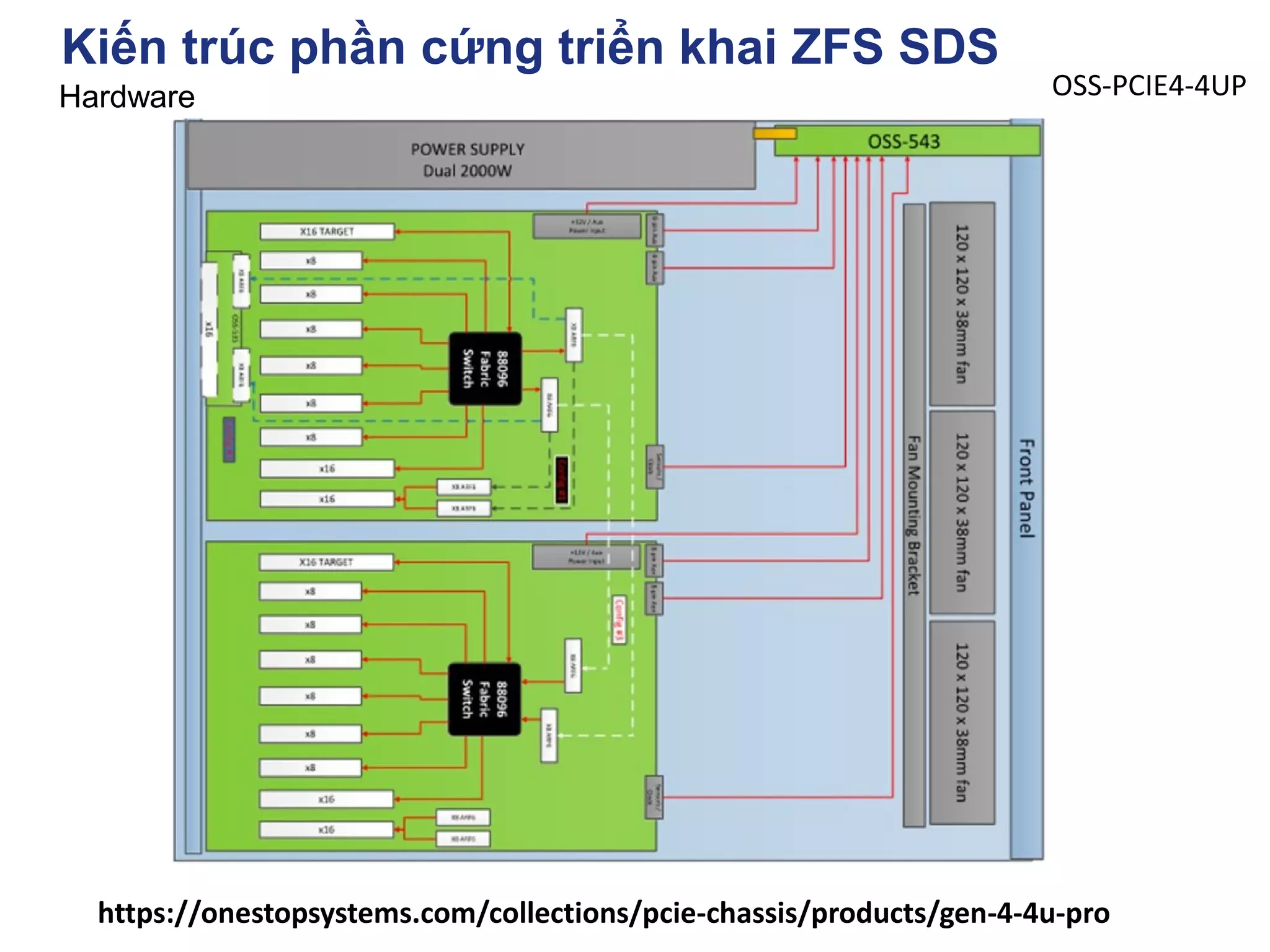

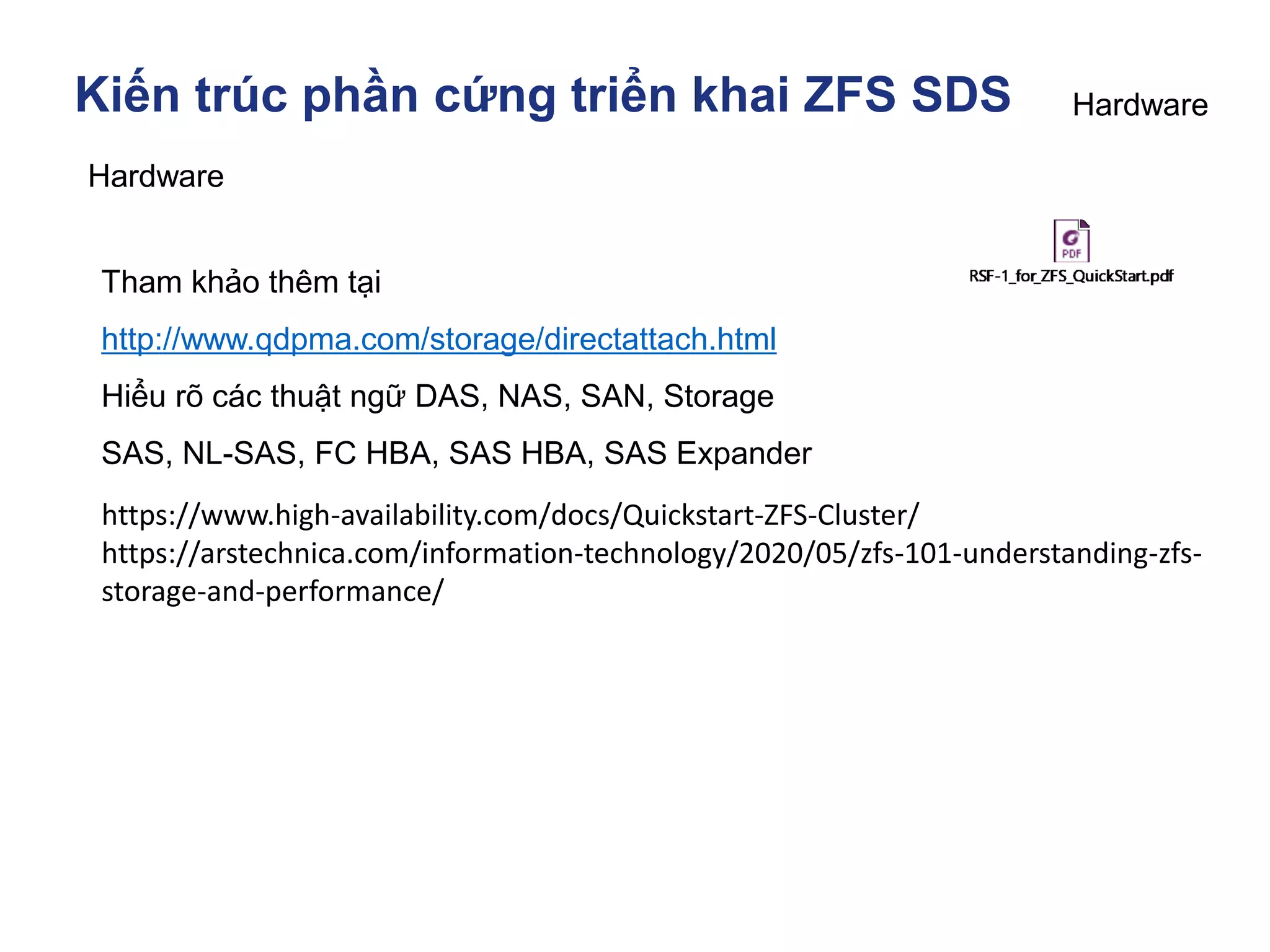

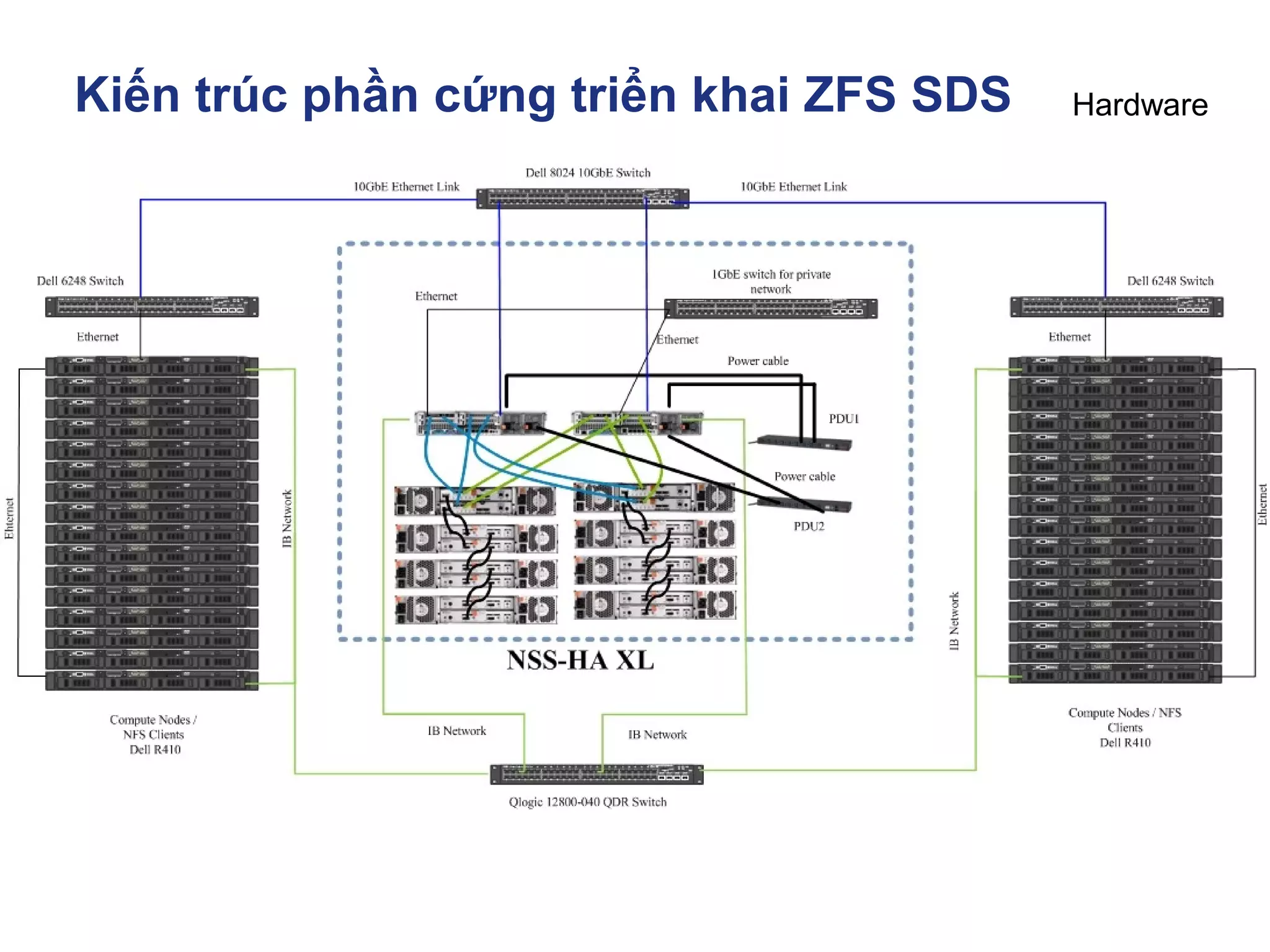

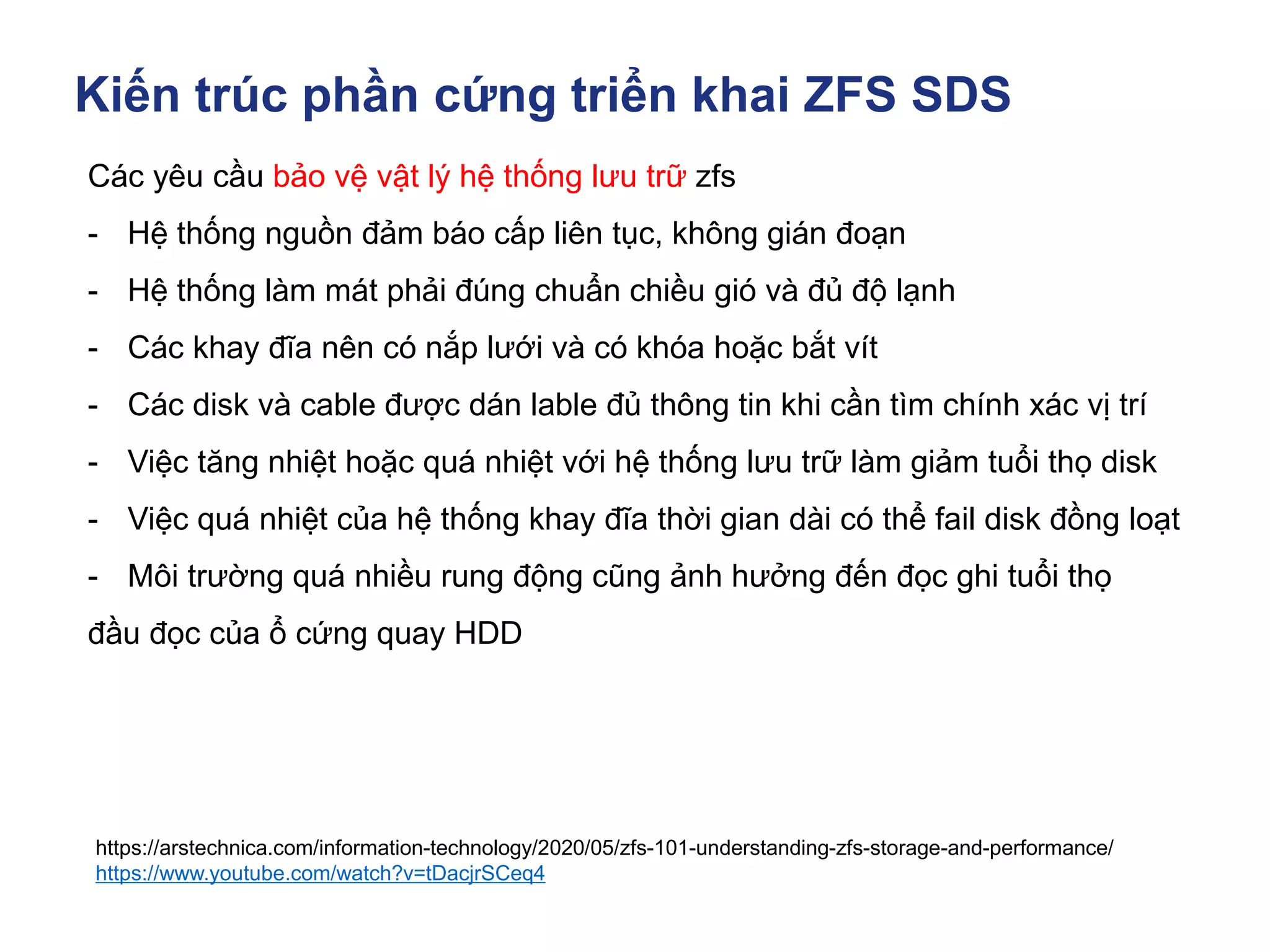

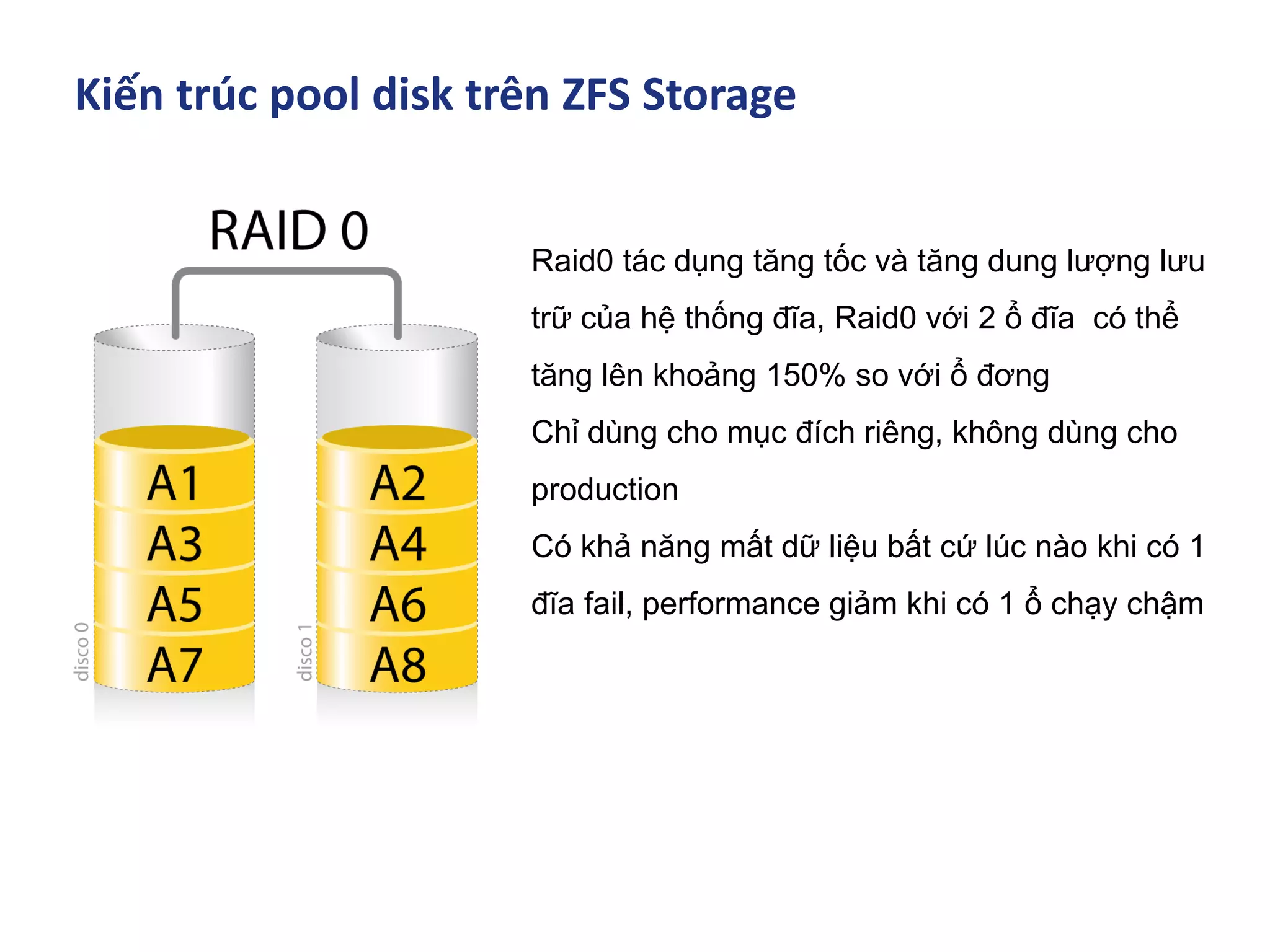

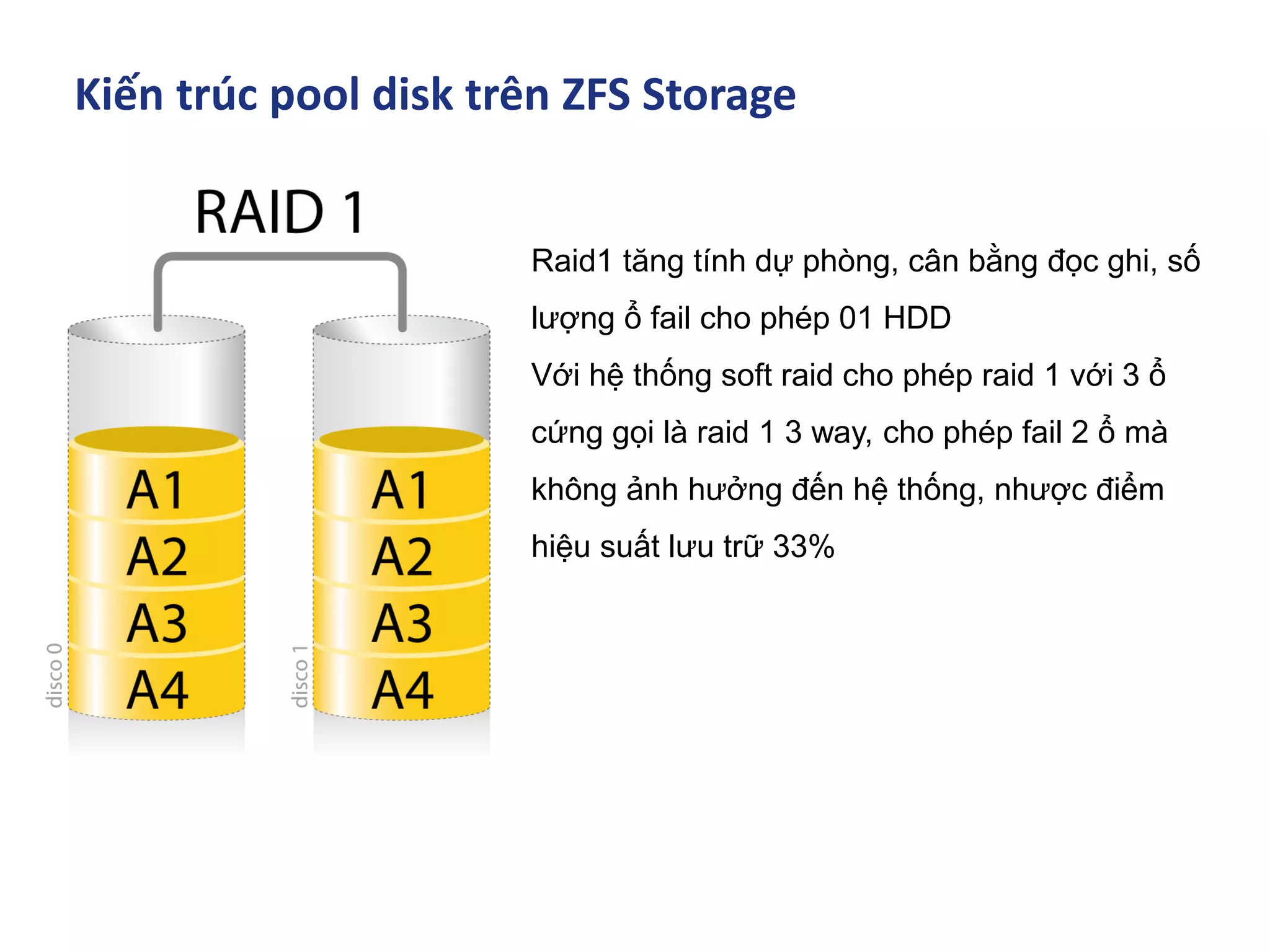

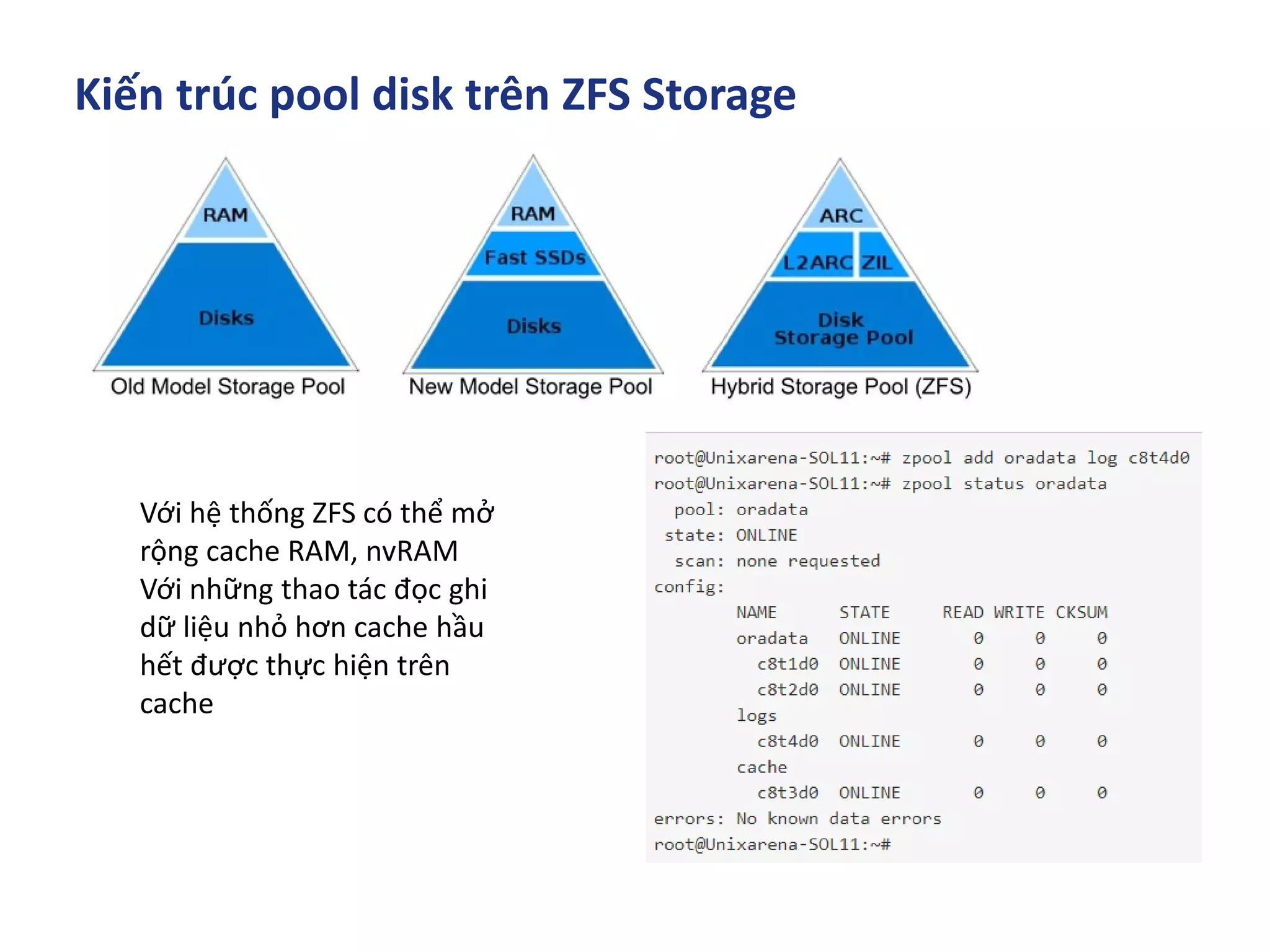

Tài liệu mô tả lịch sử phát triển của ZFS, một hệ thống tập tin và quản lý khối lượng logic do Sun Microsystems thiết kế và hiện thuộc sở hữu của Oracle. ZFS nổi bật với khả năng mở rộng, bảo vệ dữ liệu và hỗ trợ các tính năng như sao chép ảnh và kiểm tra tính toàn vẹn liên tục. Cuối cùng, tài liệu cũng đề cập đến các kiến trúc phần cứng triển khai ZFS và cơ chế bộ nhớ đệm sáng tạo của nó.

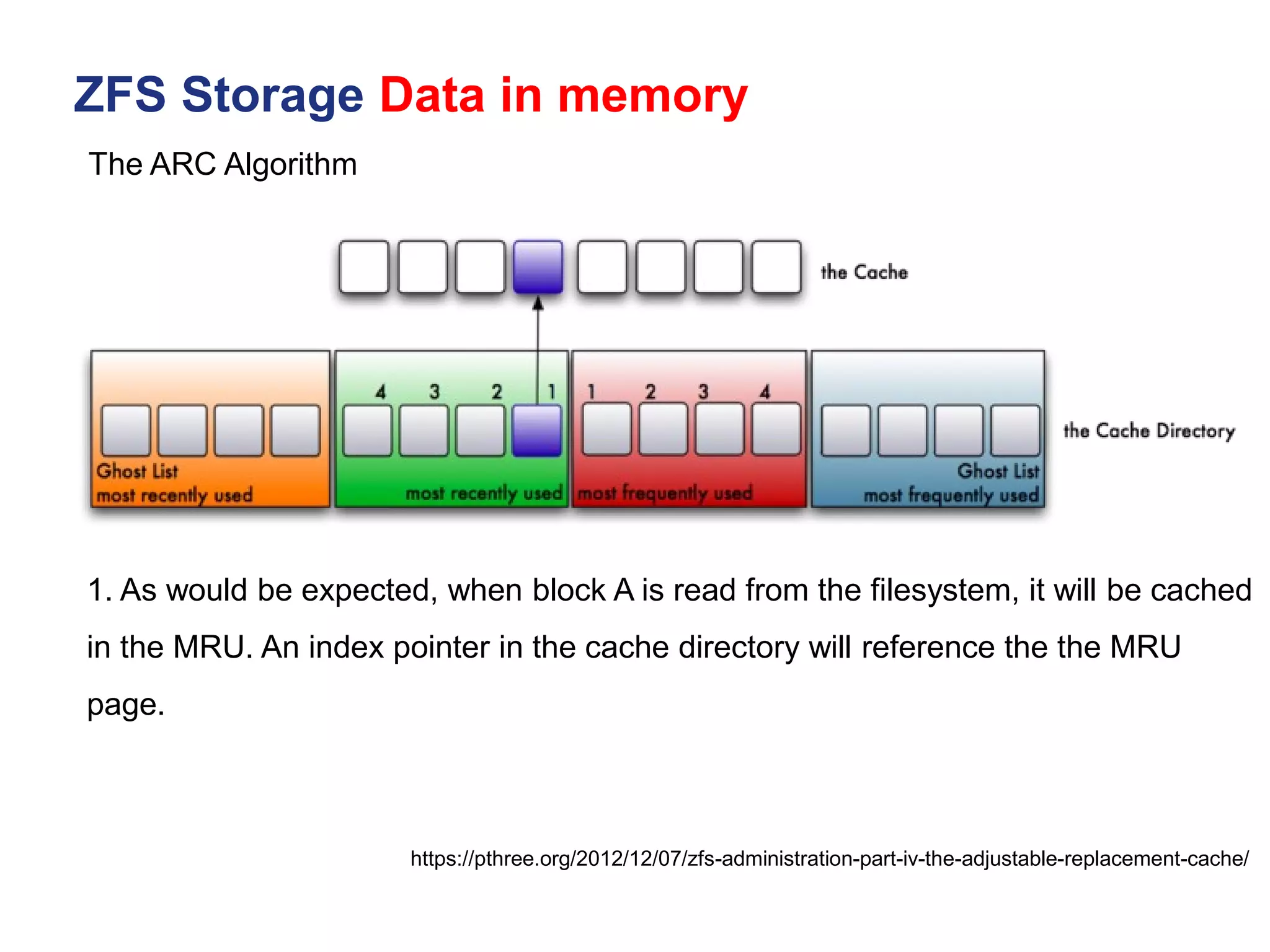

![Kiến trúc phần cứng triển khai ZFS SDS

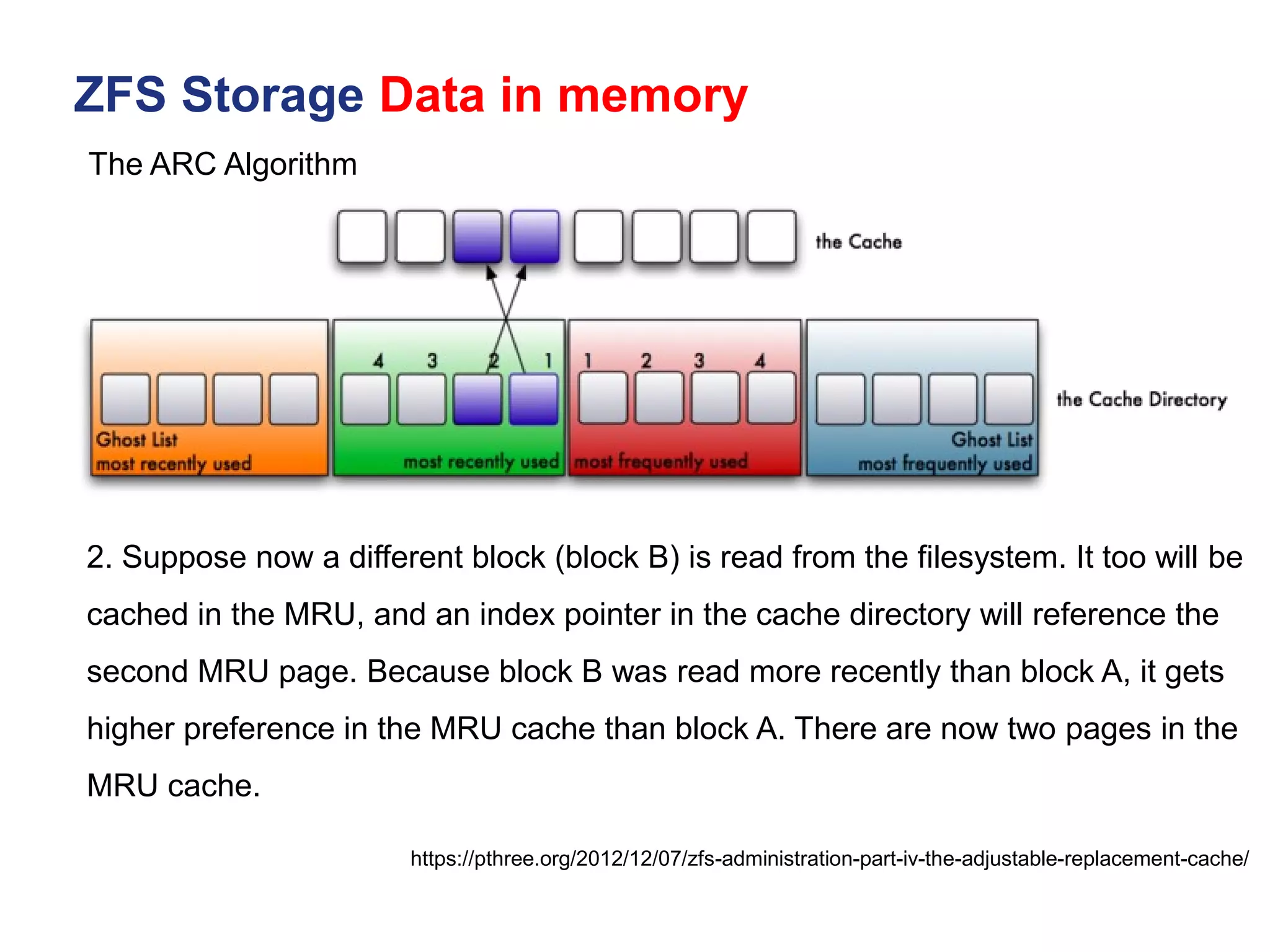

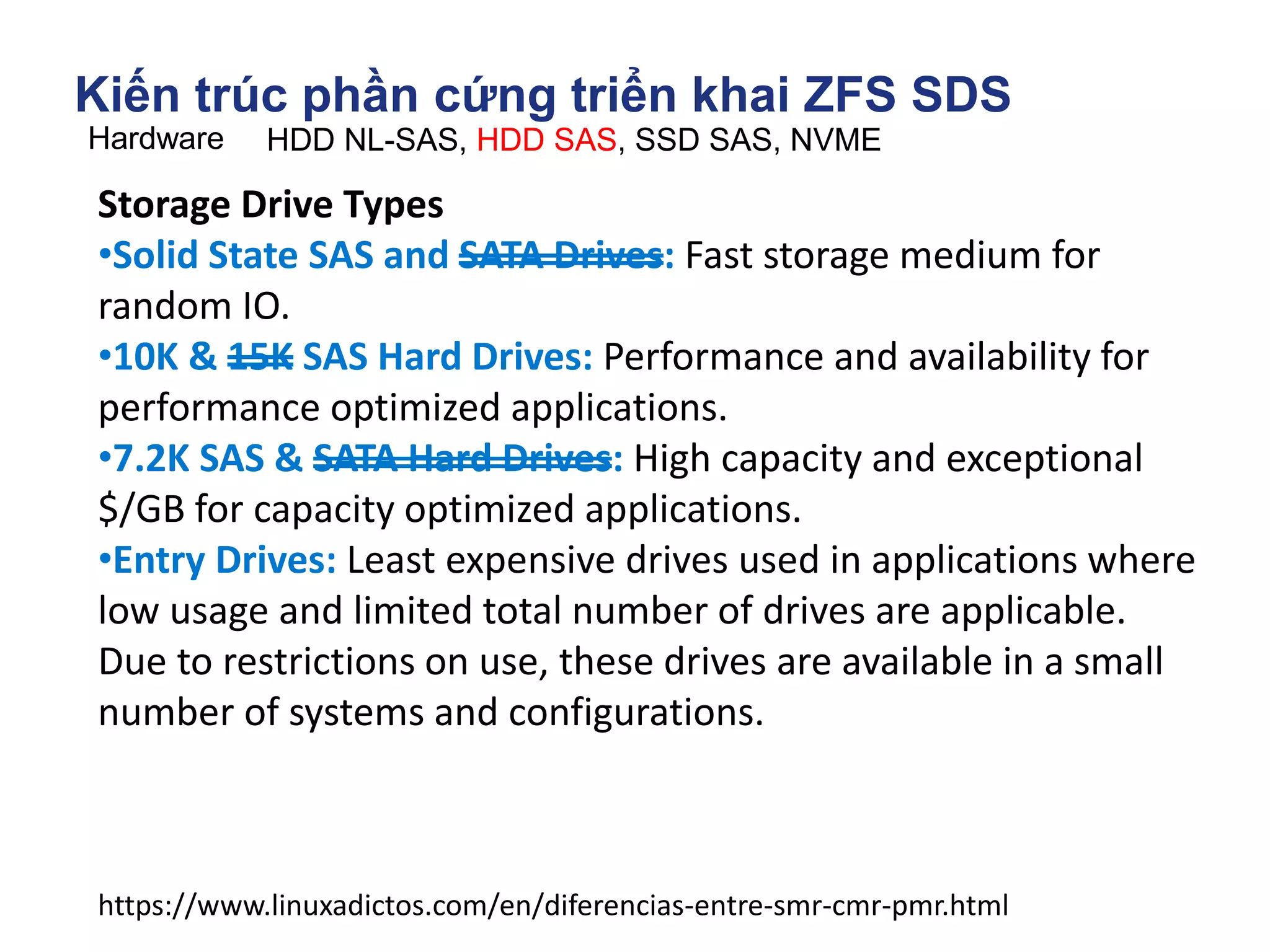

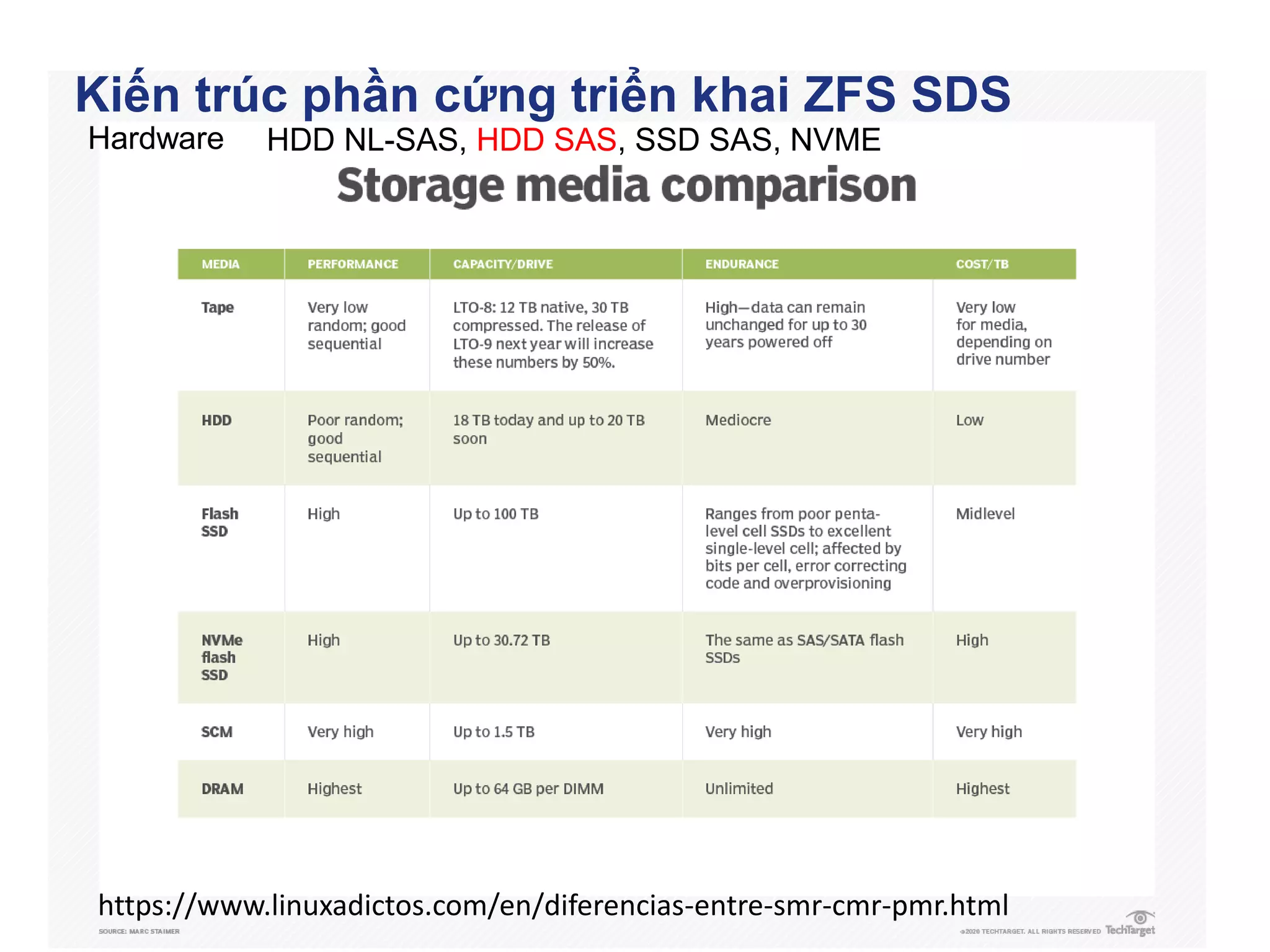

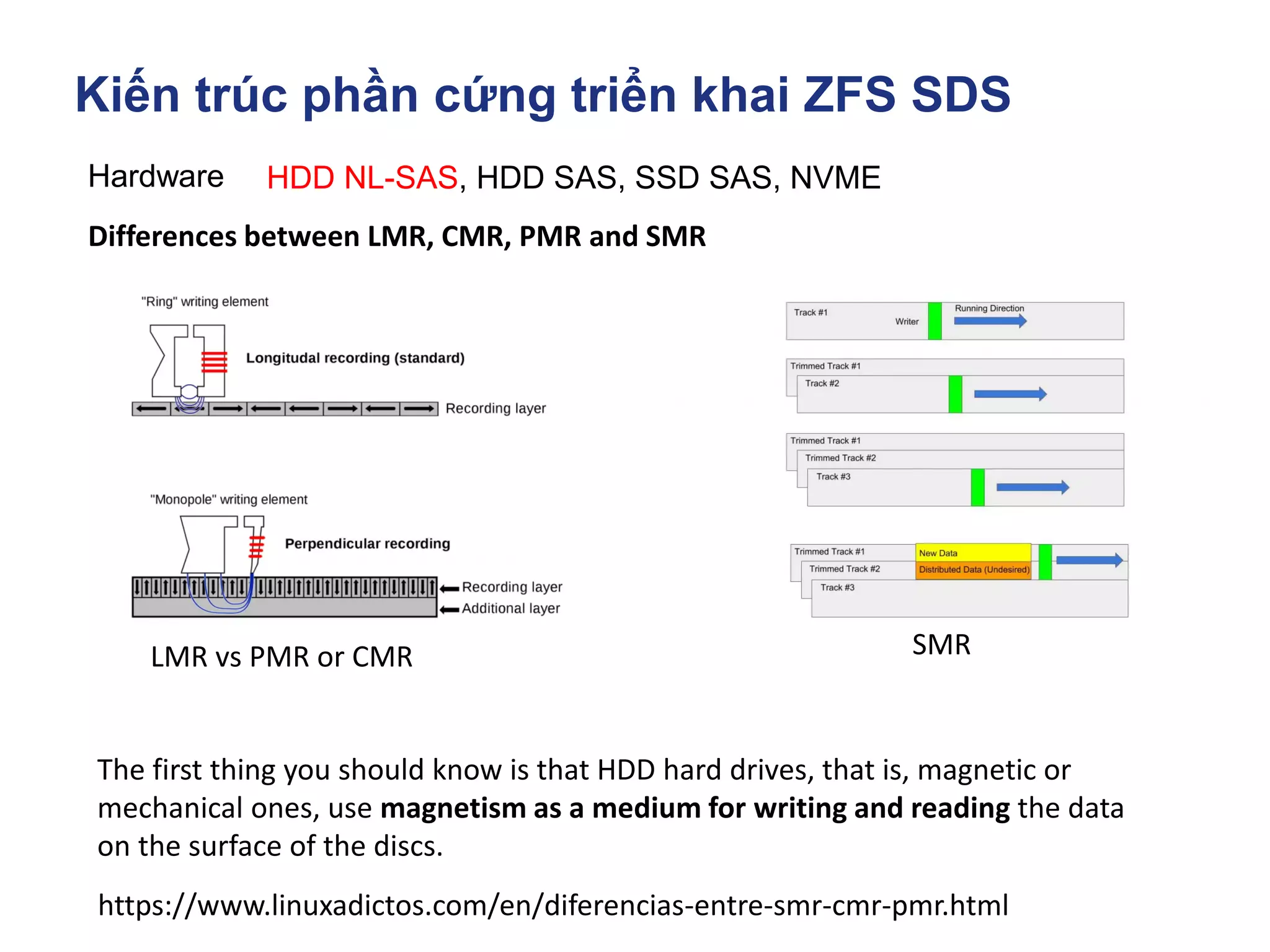

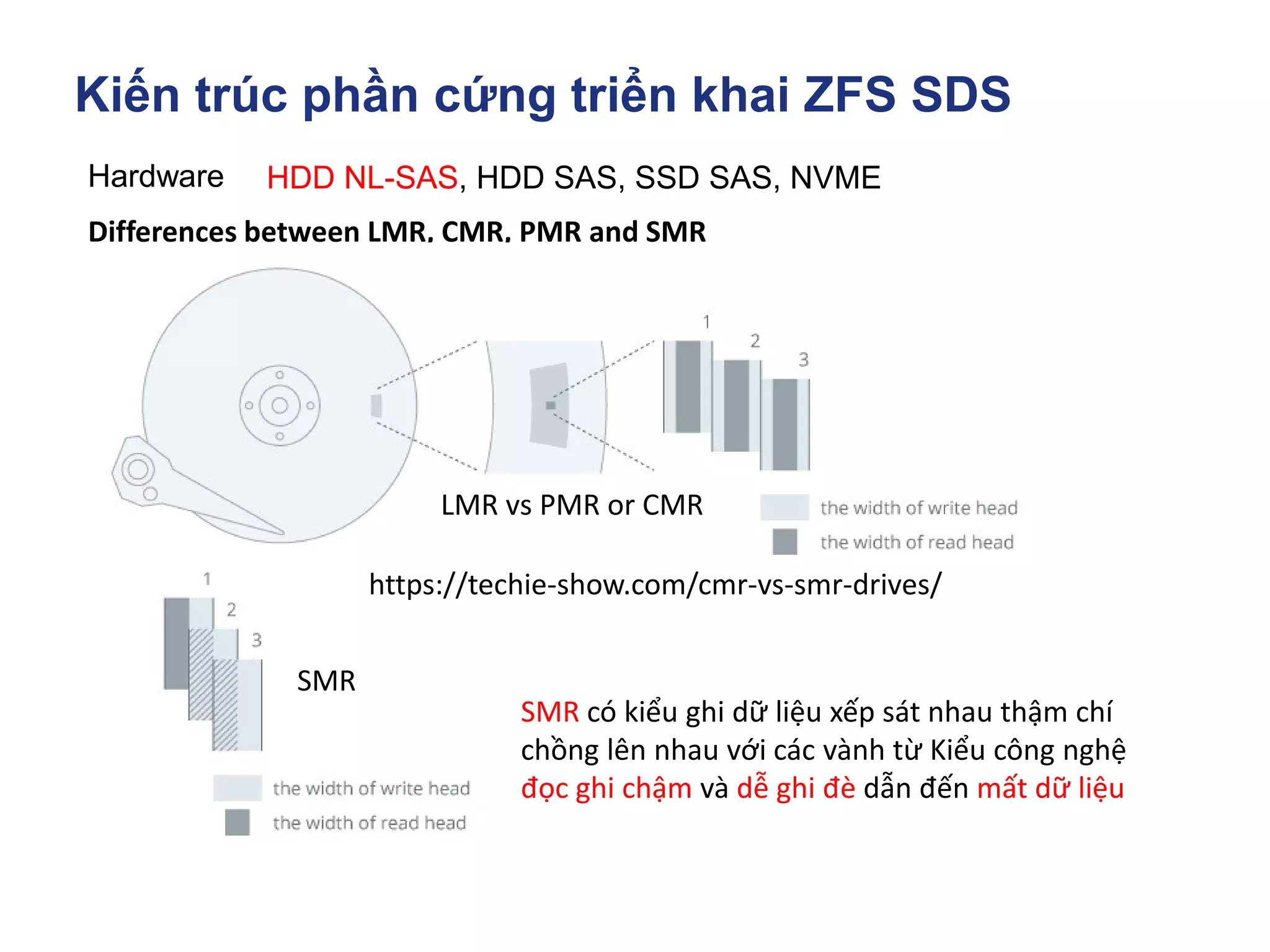

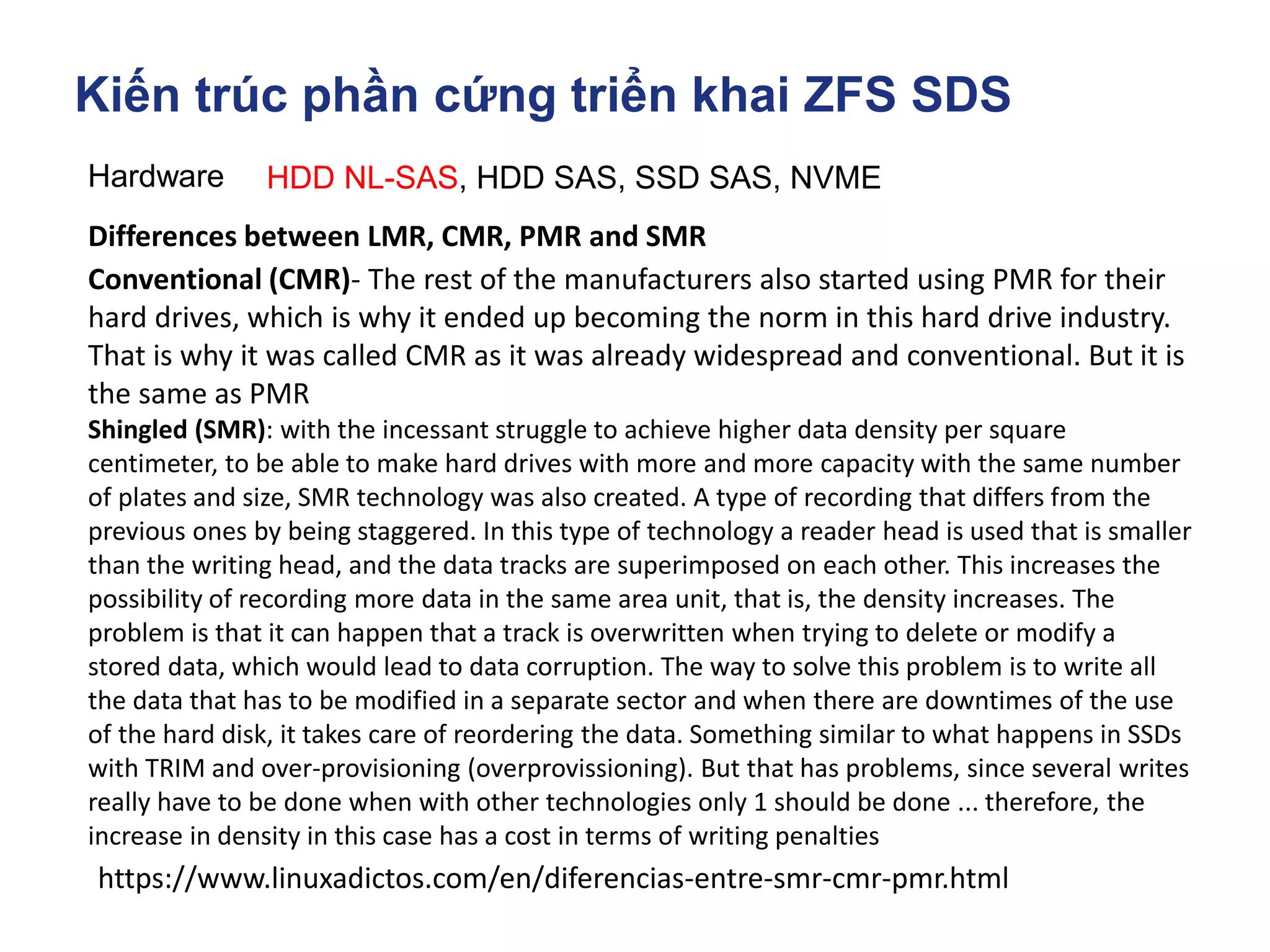

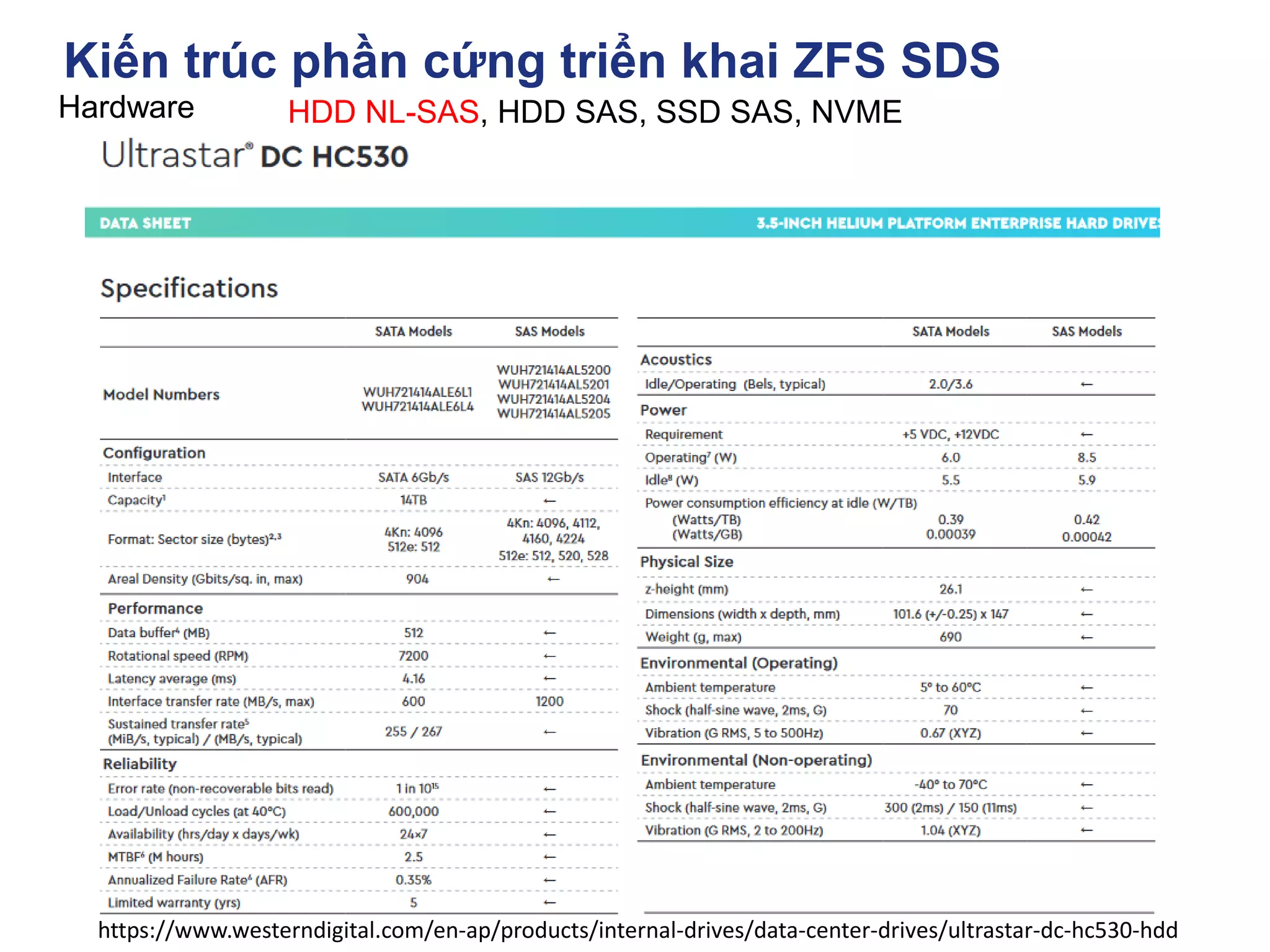

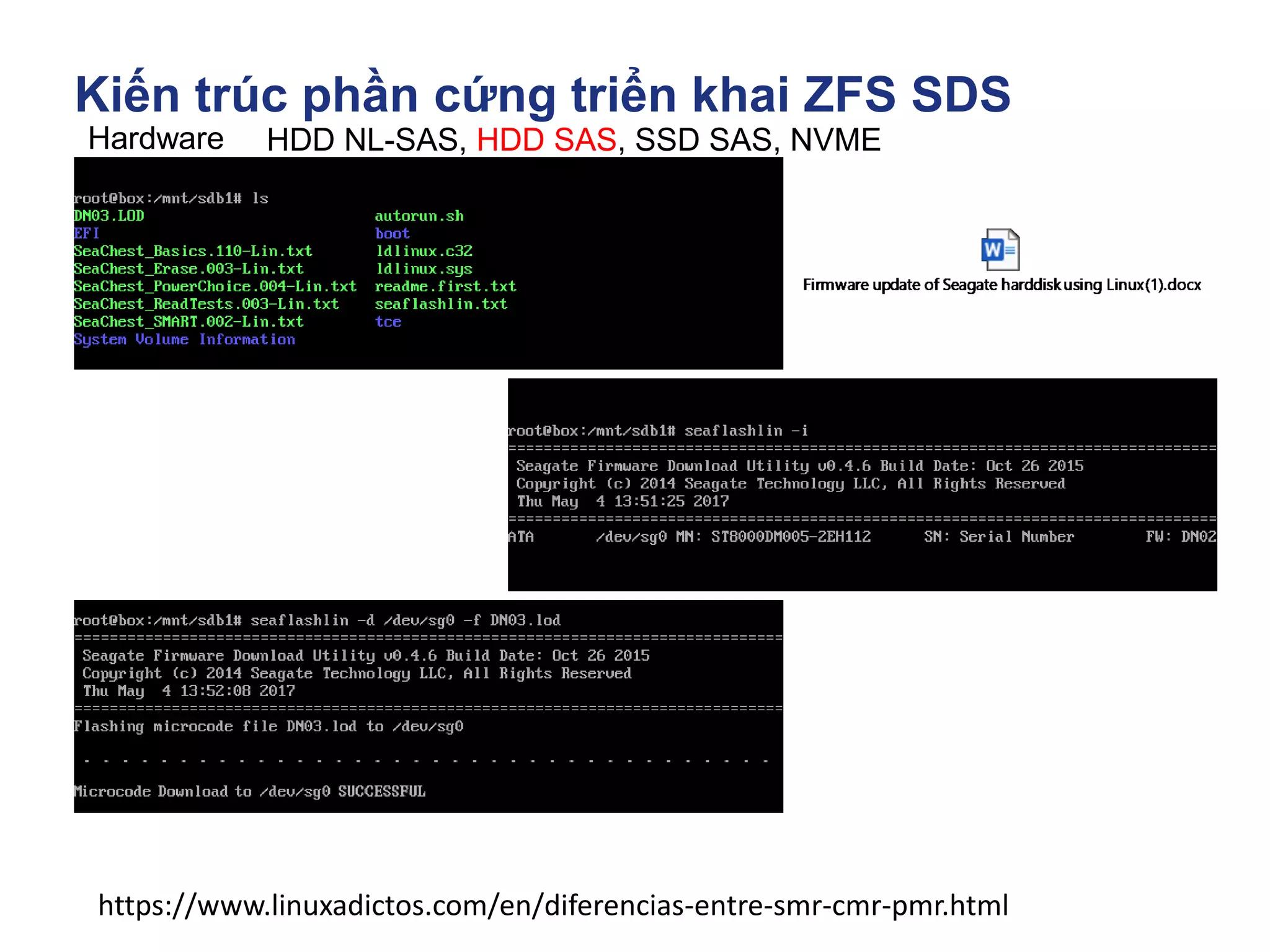

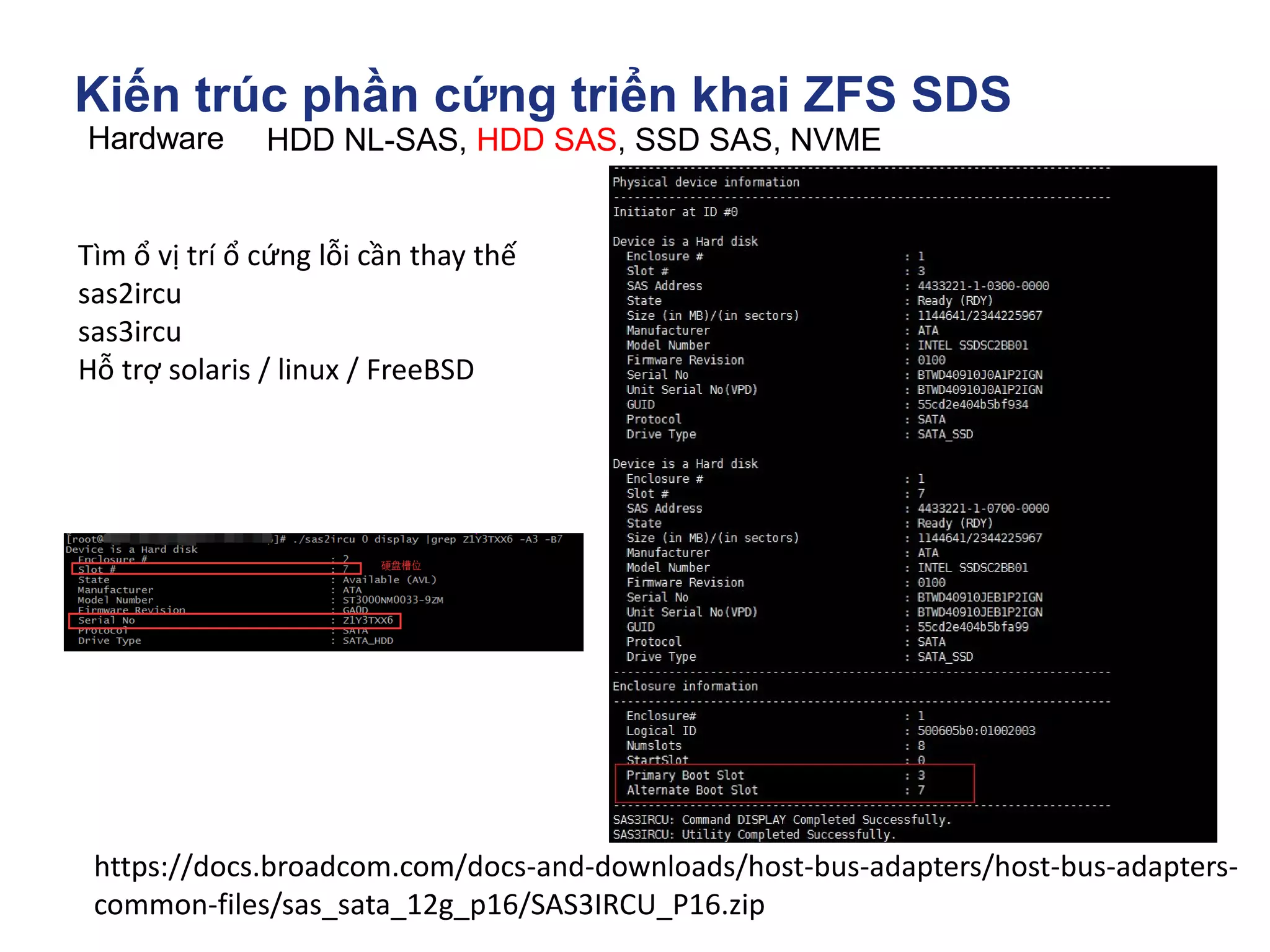

Hardware HDD NL-SAS, HDD SAS, SSD SAS, NVME

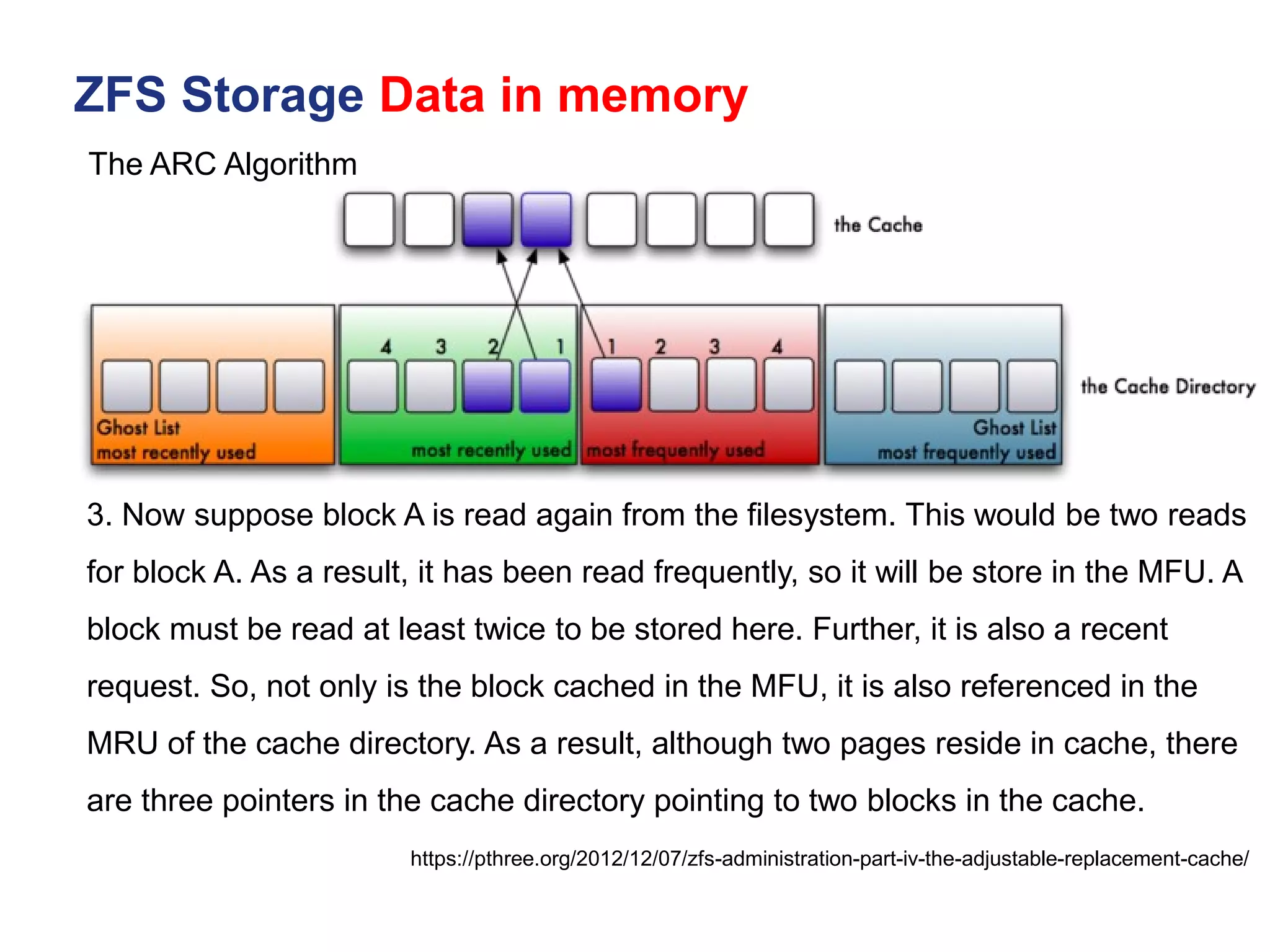

How to Flash a JBOD drive's firmware.

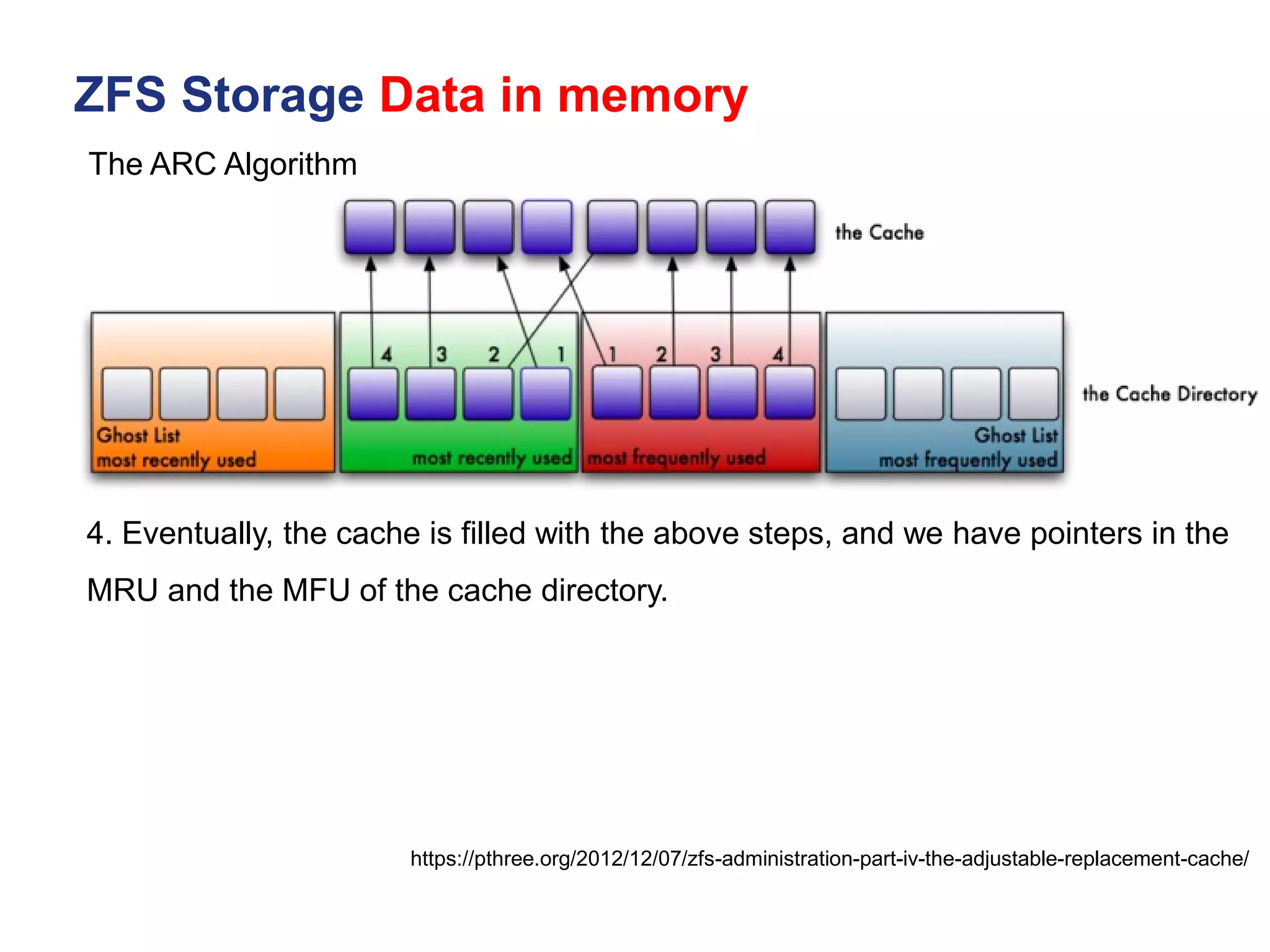

SGI Solution: sg3_utils WD DC HCxxx

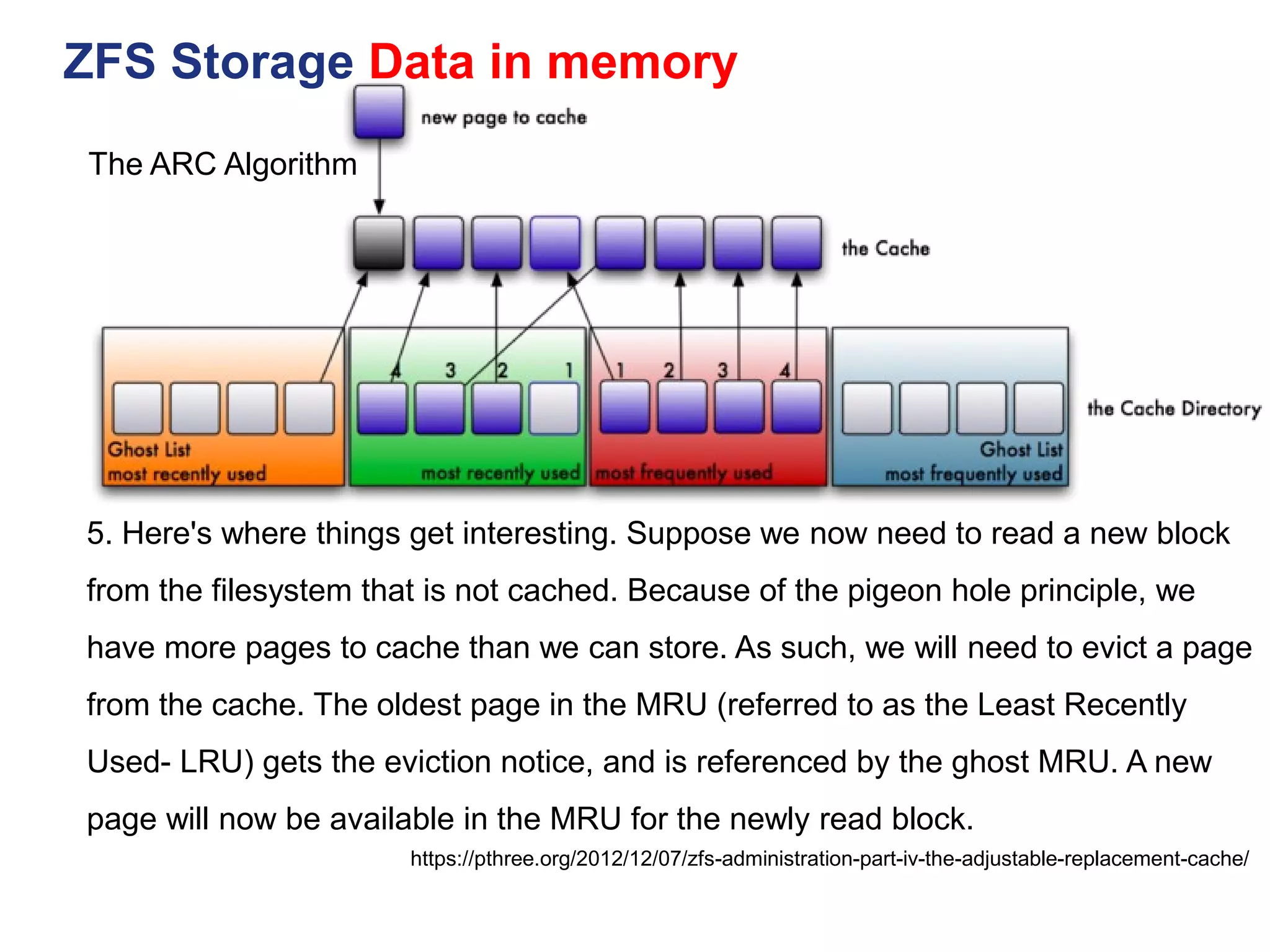

Procedure for SAS Drives

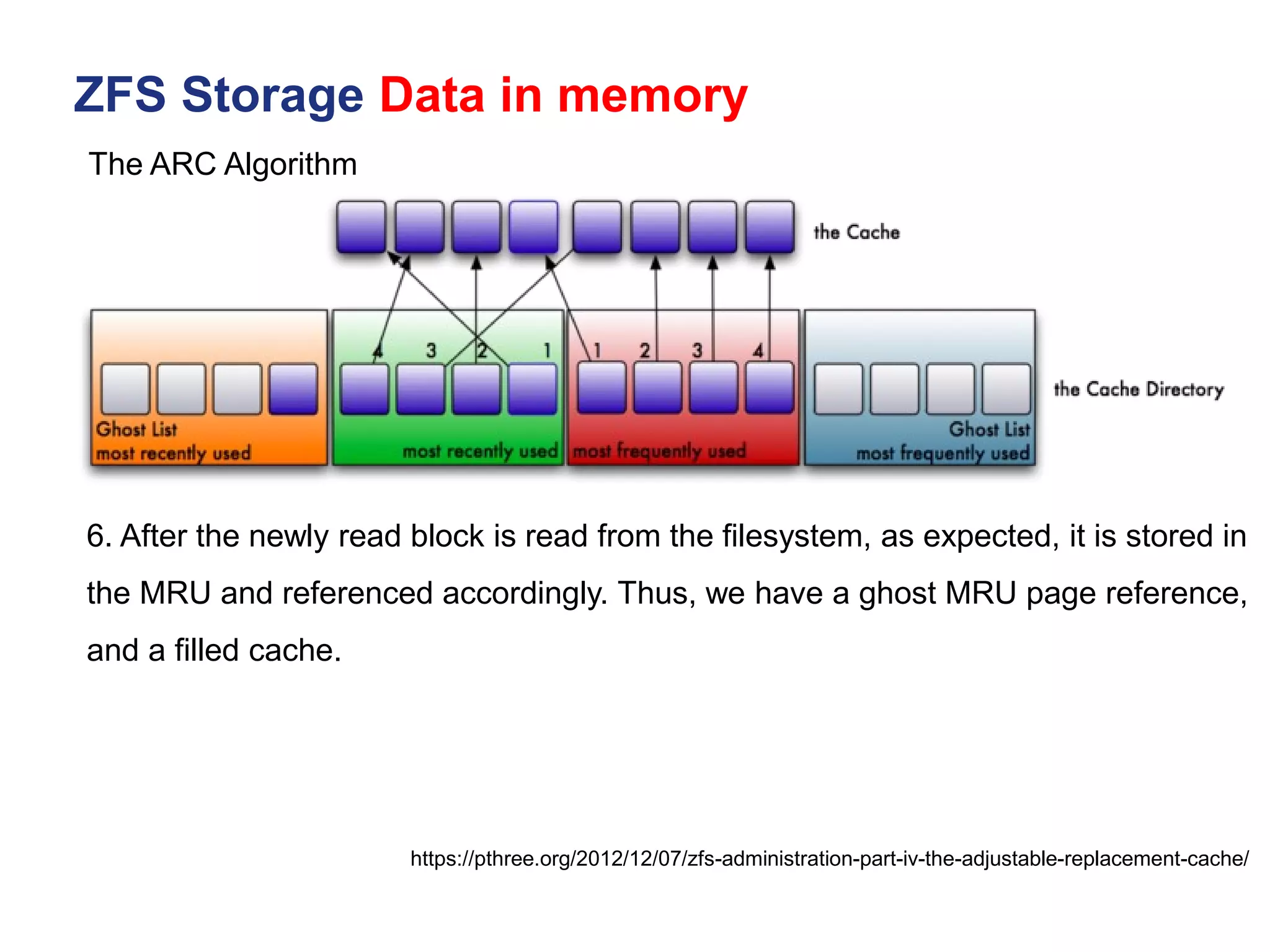

1) Identify Drive

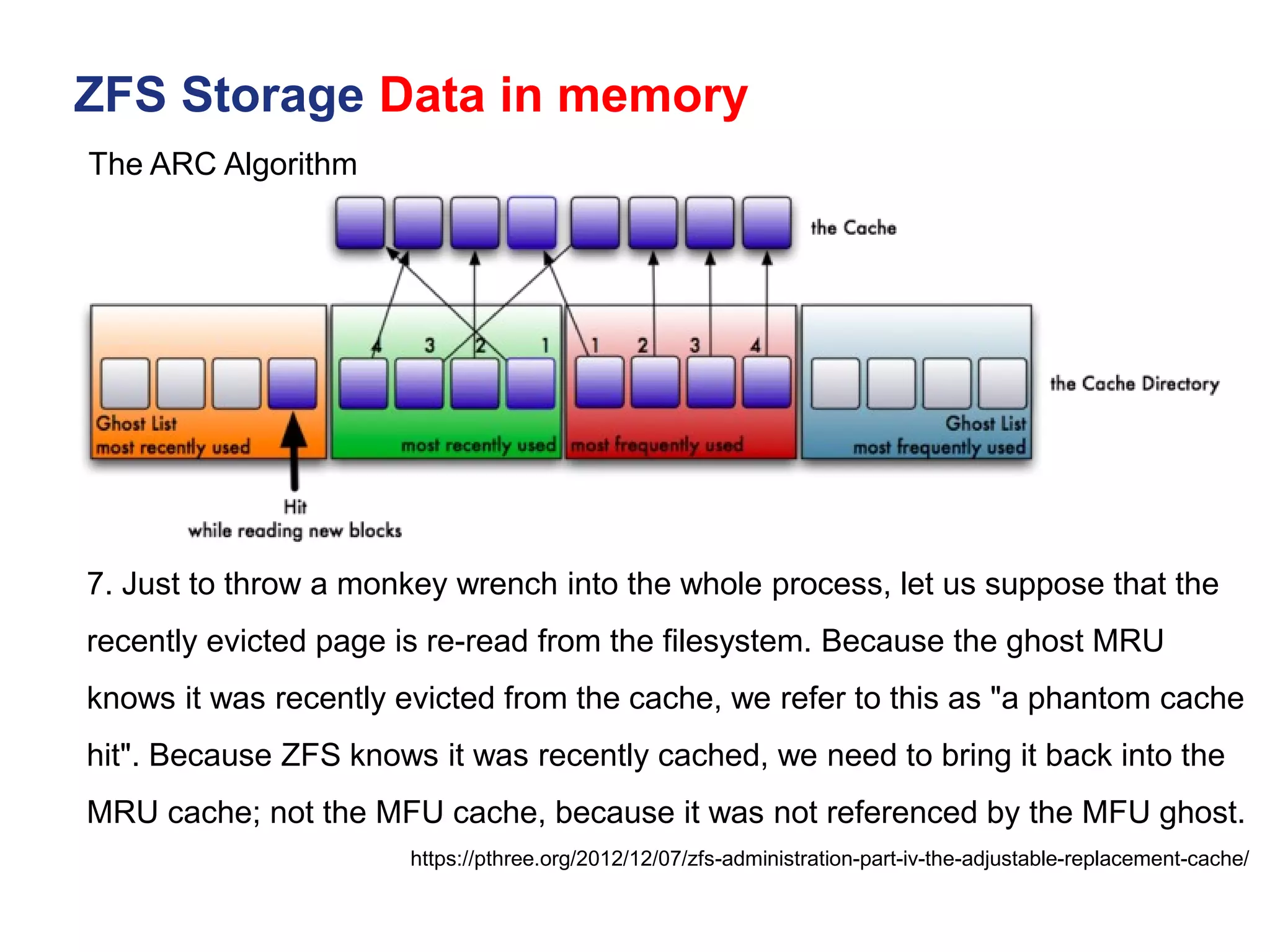

# lsscsi -g

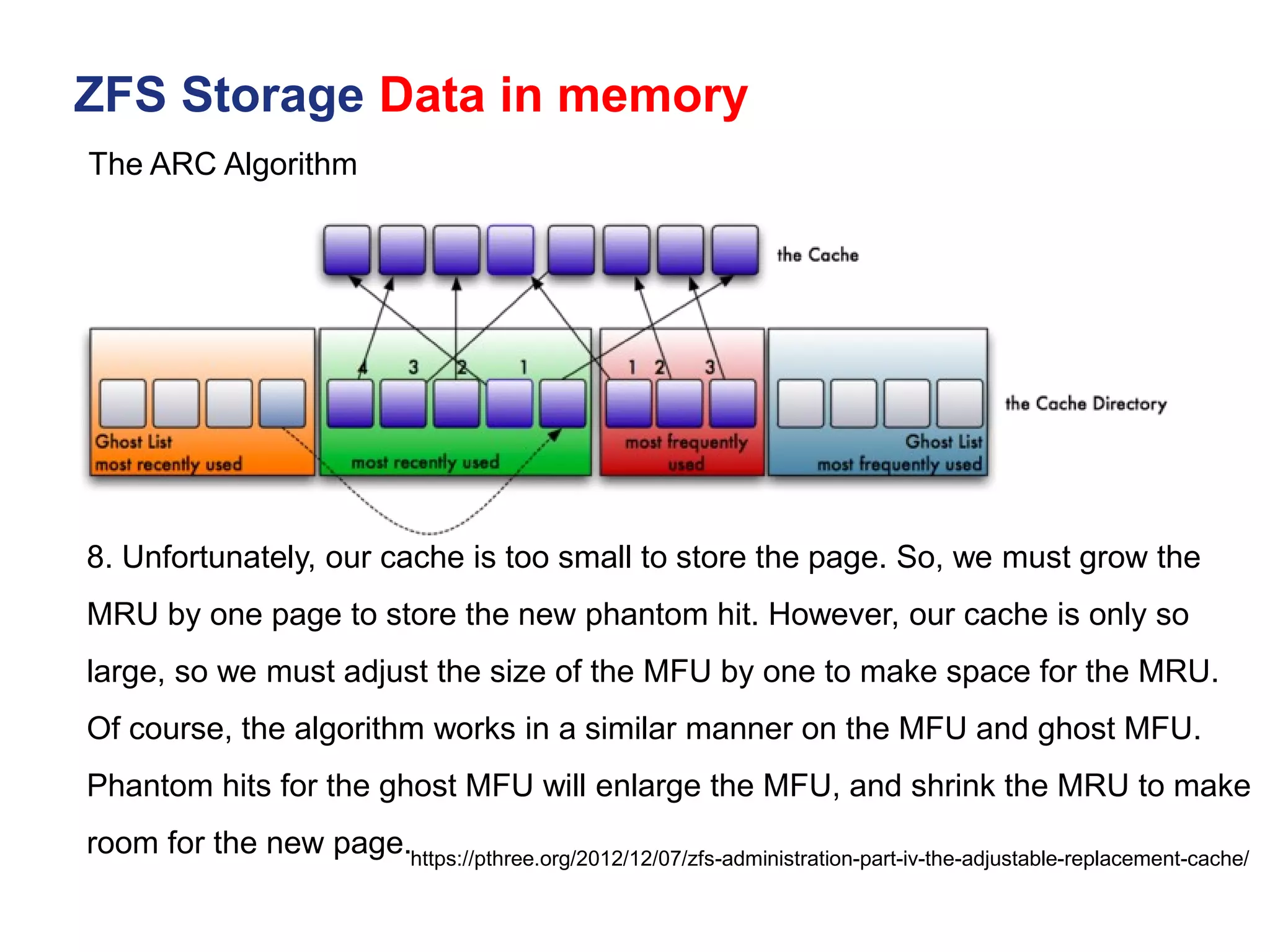

[0:2:0:0] disk LSI SMC1078 1.40 /dev/sda /dev/sg0

[1:0:1:0] cd/dvd MATSHITA DVD-RAM UJ870QJ 1.00 /dev/sr0 /dev/sg1

[12:0:37:0] disk WD WD9001BKHG-02D22 SR04 /dev/sdb /dev/sg2

In this case, we have a WD 900 Gb SAS drive we are going to upgrade to SR07 firmware.

2) Flash Drive

sg_write_buffer flags used to when downloading firmware.

--in >>FILE|-I FILE read from FILE ('-I -' read from stdin)

- m >>5 (0x05) dmc_save download microcode, save and activate

# sg_write_buffer --in=SR07.pkg -m 05 -v /dev/sg2

# sg_write_buffer -vv -m 5 --in=MPGNA3A0.bin /dev/sg3

tried to read 8388608 bytes from SR07.pkg, got 1918976 bytes

will write 1918976 bytes

Write buffer cmd: 3b 05 00 00 00 00 1d 48 00 00

3) Verify Firmware Loaded

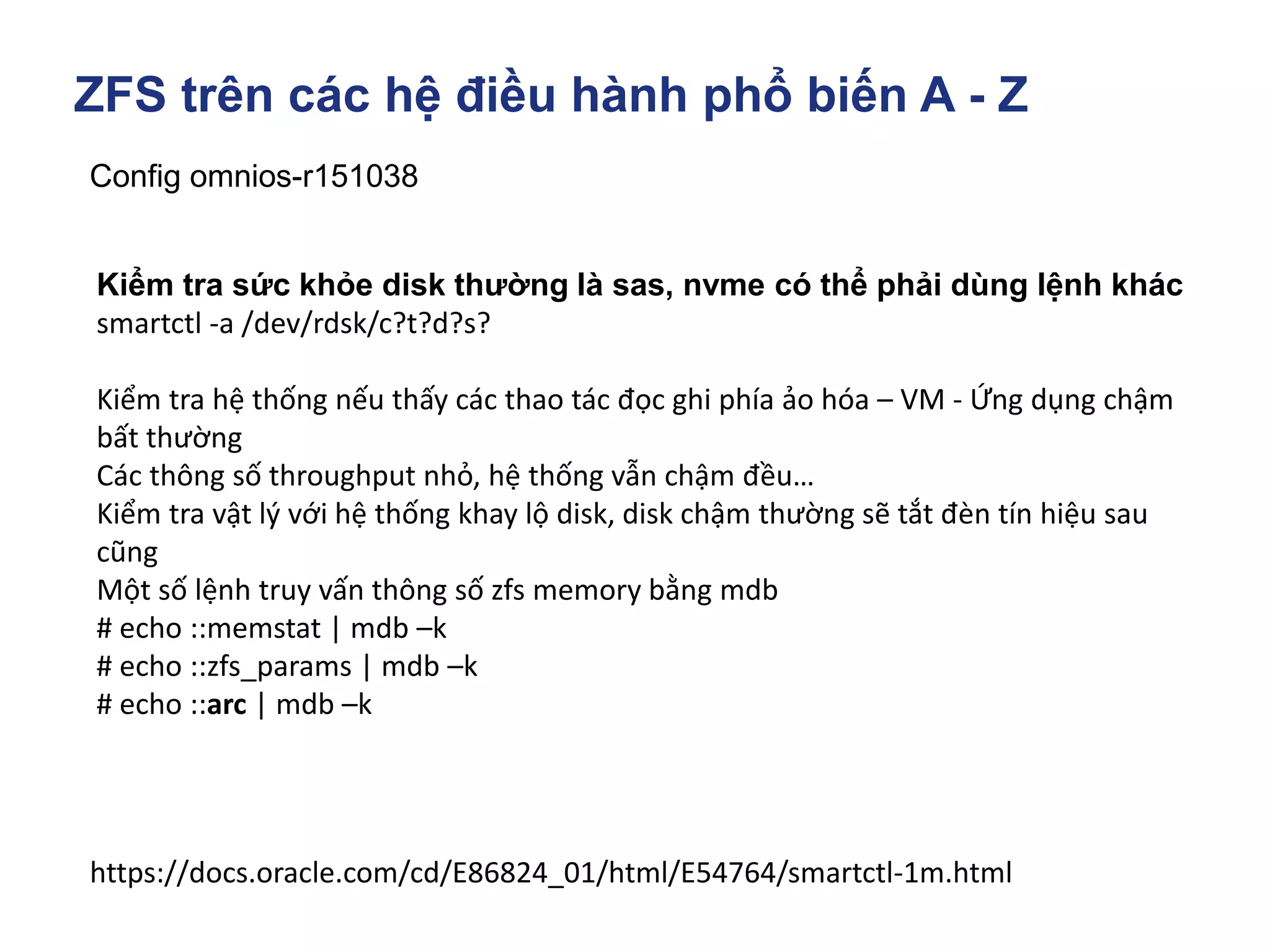

Run smartctl on drive

# smartctl -a /dev/sg2

smartctl 6.0 2012-10-10 r3643 [x86_64-linux-3.0.76-0.11-default] (SUSE RPM)

Copyright (C) 2002-12, Bruce Allen, Christian Franke, www.smartmontools.org

Vendor: WD

Product: WD9001BKHG-02D22

Revision: SR07

https://sg.danny.cz/sg/sg3_utils.html](https://image.slidesharecdn.com/3-220828144413-c996201c/75/Room-3-6-Nguy-n-Van-Th-ng-Dzung-Nguyen-ng-d-ng-openzfs-lam-l-u-tr-t-p-trung-58-2048.jpg)

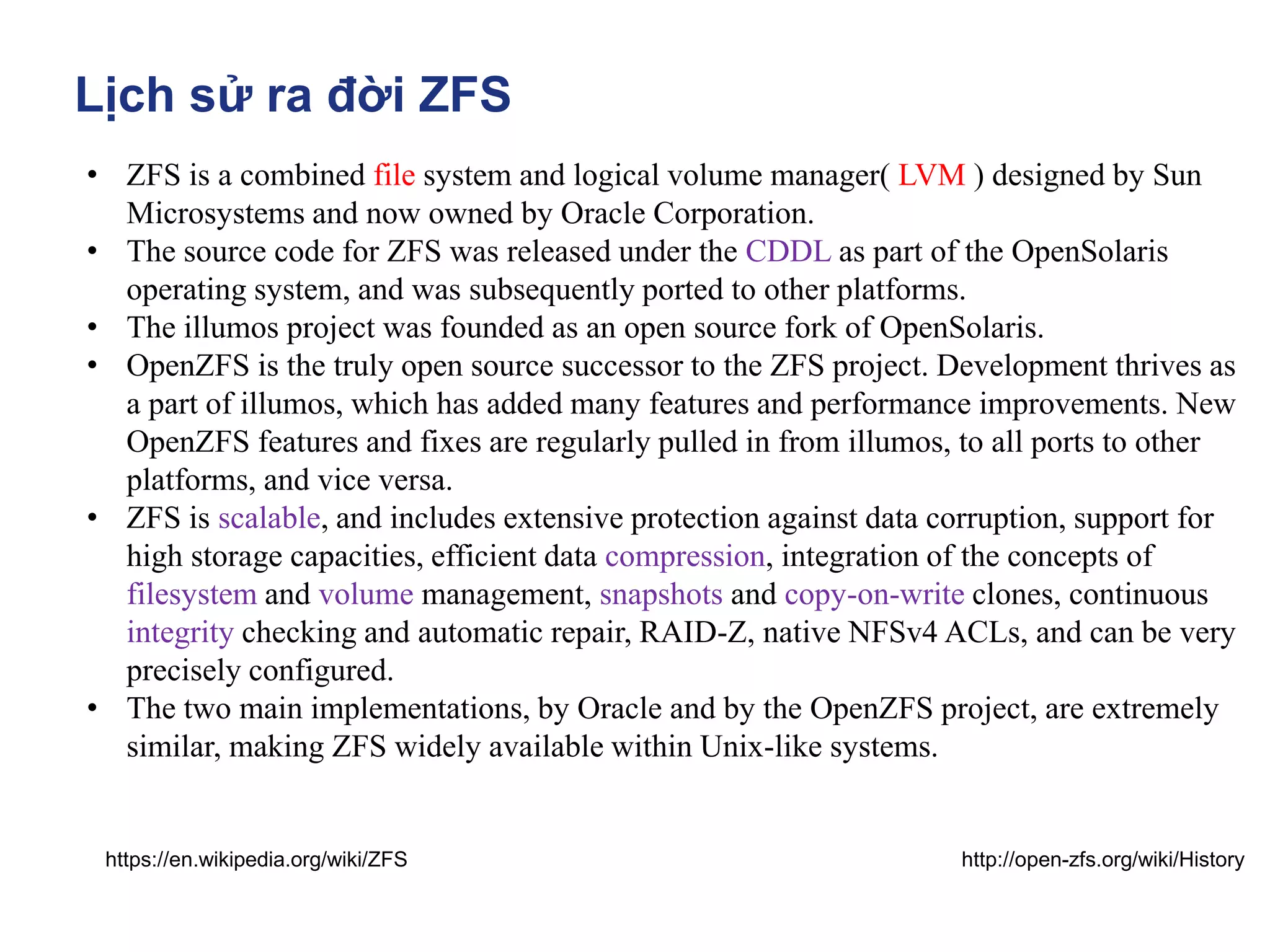

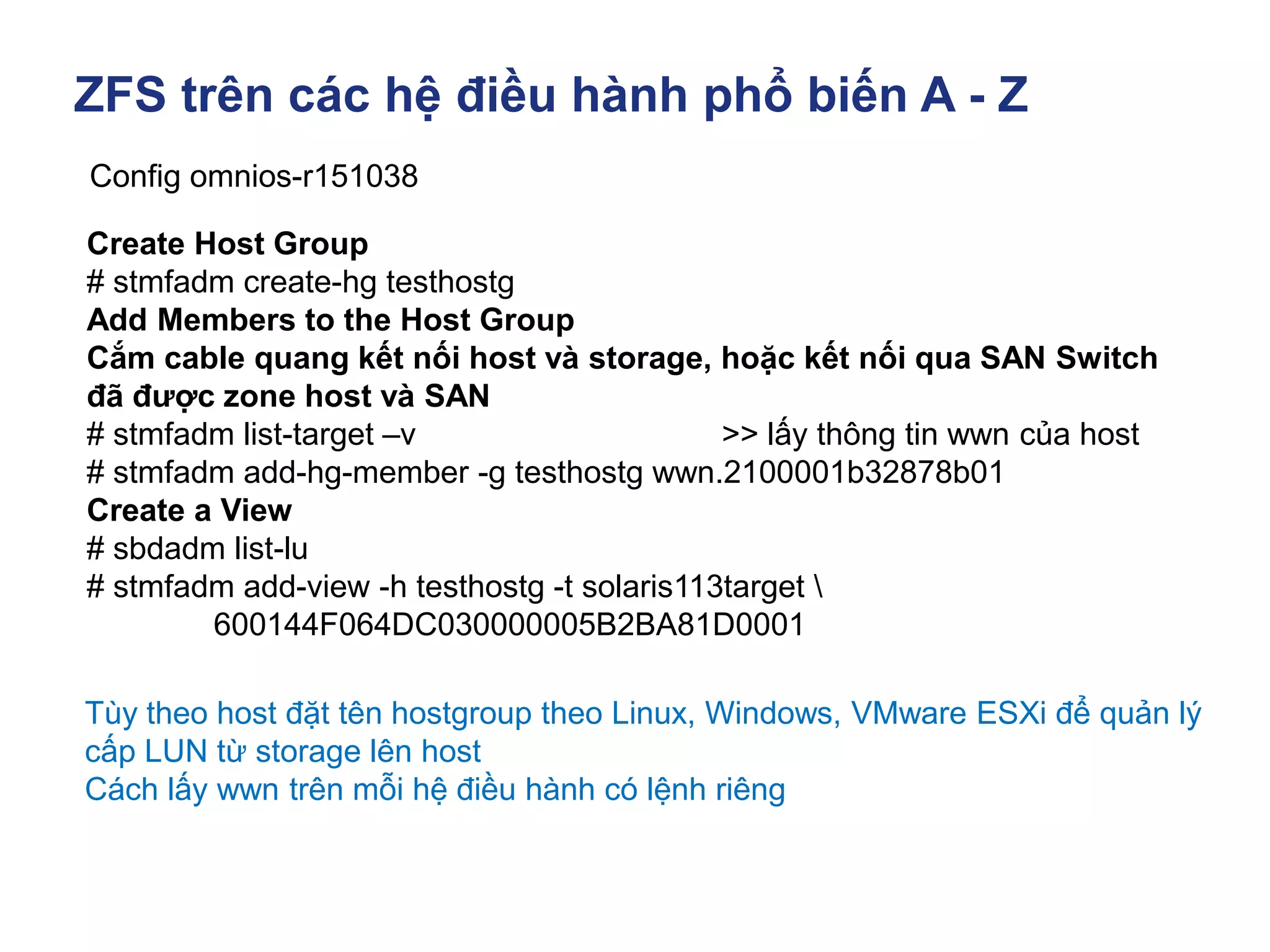

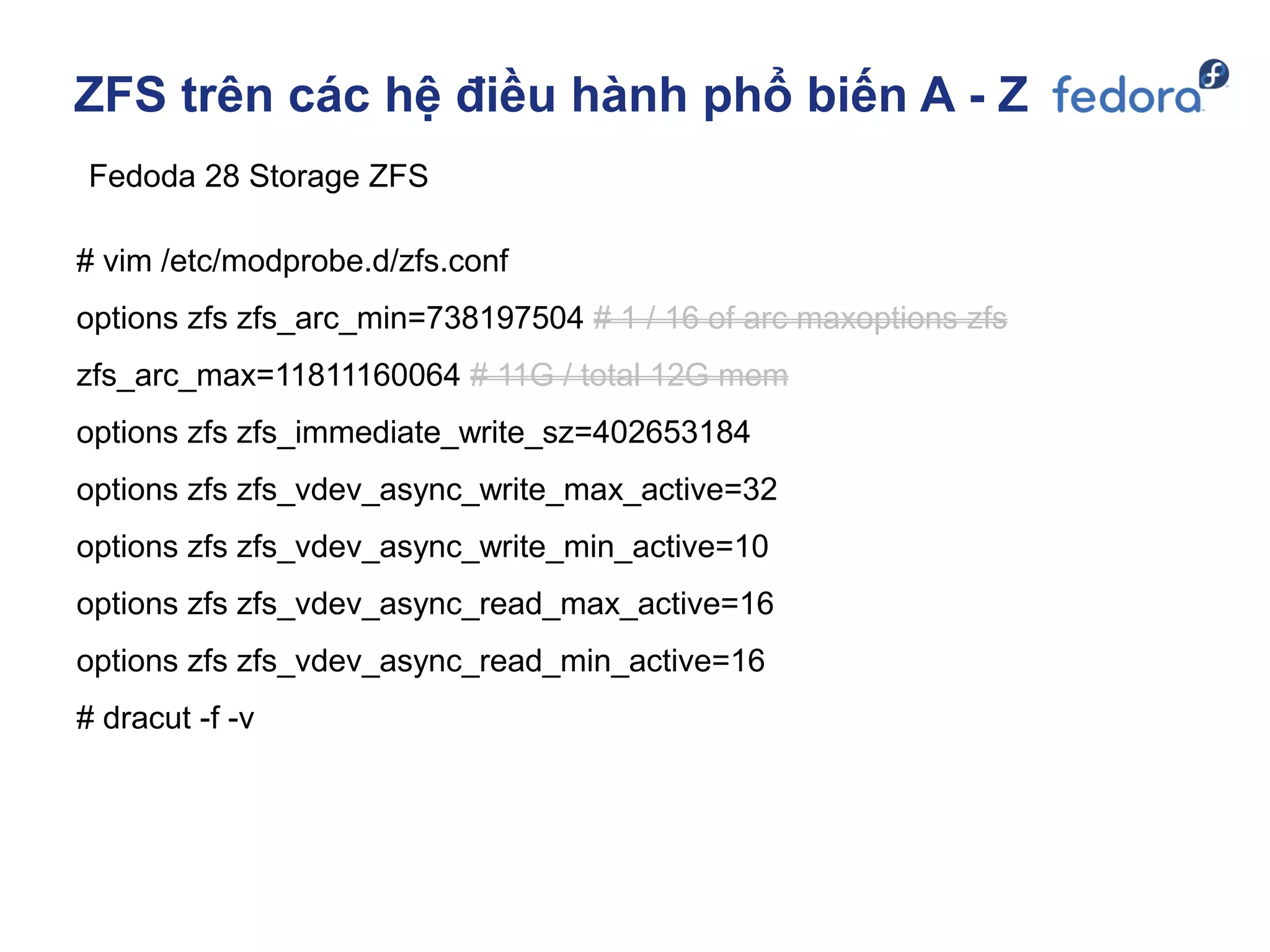

![ZFS trên các hệ điều hành phổ biến A - Z

Fedoda 28 Storage ZFS

# zpool create -o ashift=12 pool0 raidz2 /dev/sd[b-k]

# zpool export pool0

# zpool import -d /dev/disk/by-id -N pool0

# zpool status pool0

# zfs list

# zdb -C | grep ashift >> ashift = 12

# zfs set recordsize=512k pool0

# zfs set compression=on pool0

# zfs set checksum=on/off pool0

# zfs set logbias=latency/throughput pool0](https://image.slidesharecdn.com/3-220828144413-c996201c/75/Room-3-6-Nguy-n-Van-Th-ng-Dzung-Nguyen-ng-d-ng-openzfs-lam-l-u-tr-t-p-trung-120-2048.jpg)