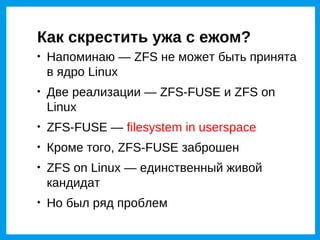

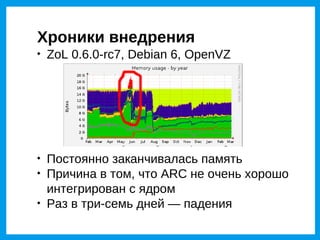

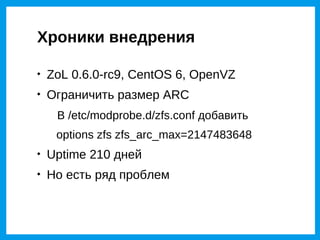

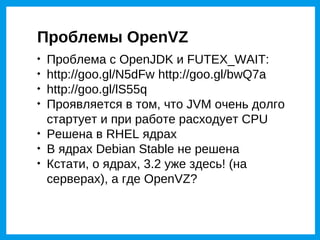

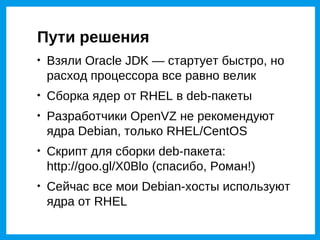

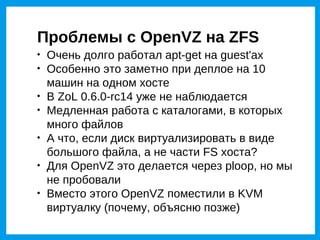

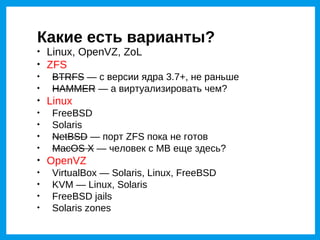

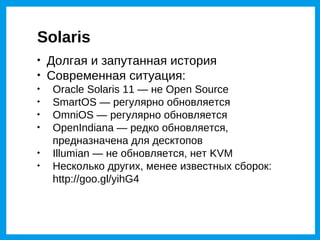

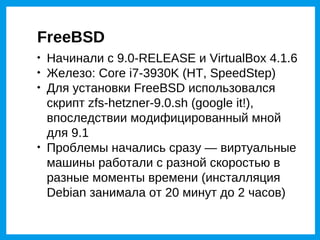

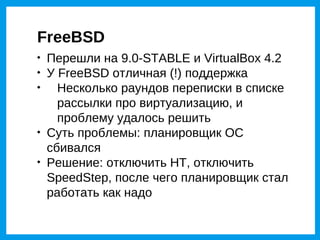

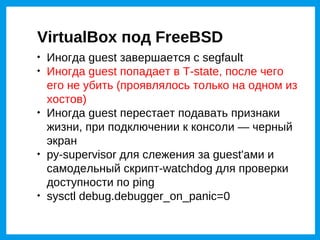

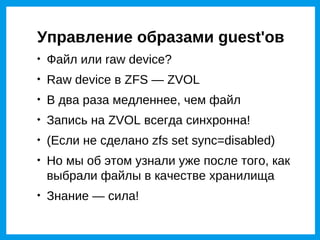

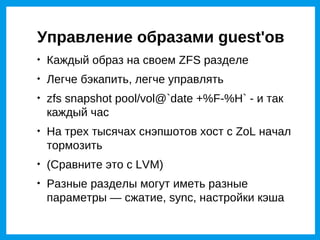

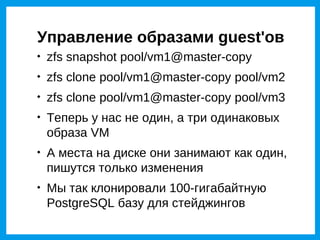

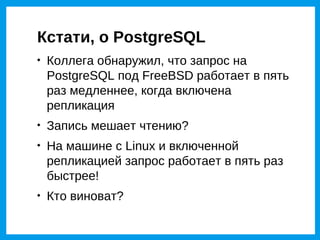

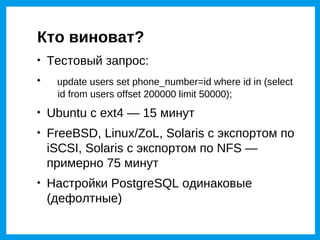

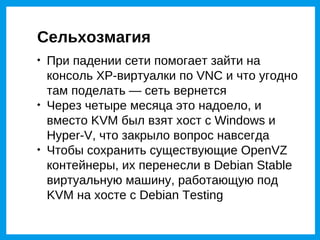

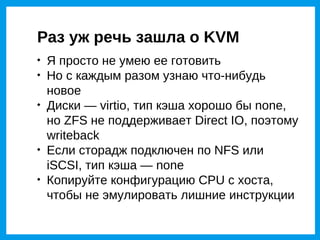

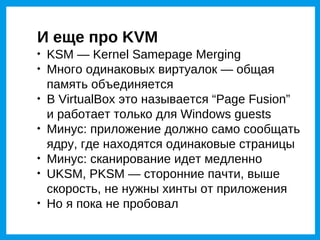

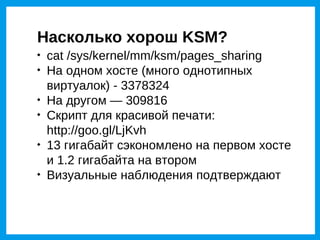

Документ обсуждает использование виртуализации, акцентируя внимание на различных системах, таких как OpenVZ и KVM, и их интеграции с файловыми системами ZFS и Btrfs. В тексте рассмотрены проблемы, возникшие при внедрении этих технологий, а также предложены пути их решения и оптимизации. Затрагиваются важные аспекты, такие как управление образами виртуальных машин, производительность PostgreSQL и отношение к различным версиям ядер Linux.