More Related Content

PDF

[INSIGHT OUT 2011] A12 ひとつのデータベース技術では生き残れない part1 カラムナーデータベース(Shinkubo) PDF

PDF

地方企業がソーシャルゲーム開発を成功させるための10のポイント PDF

18 a-6 ameba pigg backend practice 20110217 PDF

PDF

Fusion-io(ioDrive) benchmarking #sfstudy 01 LT PDF

Dbtechshowcasesapporo mysql-turing-for-cloud-0.9.3 PPTX

What's hot

PDF

PDF

PDF

使ってみた!ioMemoryで実現する噂のAtomic write! PDF

スマートフォン向けサービスにおけるサーバサイド設計入門 PDF

PHPで大規模ブラウザゲームを開発してわかったこと PDF

PDF

Microsoft power point ai fss 製品概要-4-4 [互換モード] PDF

OSC2011 Tokyo/Spring 自宅SAN友の会(前半) PDF

CROSS 2016 LT - 我々のIoTデバイスがこんなに多いはずが無い PPT

�Linux/DB Tuning (DevSumi2010, Japanese) PPTX

【アシアル塾】Linux超入門編・第一回はじめてのターミナル(黒い画面)操作 PDF

PDF

File Server on Azure IaaS PDF

第2回 ioDrive+MySQL勉強会 @外道父 ioDriveの世界へようこそ PDF

OSC2012Kansai@Kyoto 自宅SAN友の会 - インフラエンジニアなら知っておきたい ストレージのはなし PDF

Windows Azure の中でも動いている InfiniBand って何? PDF

20110517 okuyama ソーシャルメディアが育てた技術勉強会 PDF

PDF

大規模ソーシャルゲーム開発から学んだPHP&MySQL実践テクニック PDF

CLUB DB2 第137回:基礎から再入門!DB2モニタリング入門 Similar to GMOメディア RHEV-S-事例紹介

PDF

Gmo media.inc 第9回西日本ossの普及を考える会 PDF

We Should Know About in this SocialNetwork Era 2011_1112 PDF

Crooz meet fusion io3 open PDF

Apache cloudstack4.0インストール PDF

分散KVSをサービス化してみた ~Okuyama(KVS)もFusion-IO(ioDrive)もあるんだよ~ PDF

なぜソーシャルゲームはクラウドなのか? ~AWSの成功事例を紐解く~ PDF

Apache CloudStack 4.0 インストール(ver0.5) PDF

Kyoto Tycoon Guide in Japanese PDF

Solaris 11におけるシステム、ネットワーク、ストレージの仮想化機能 PDF

PPT

PDF

SaaS/クラウドコンピューティングでのオープンソース活用とセキュリティ PPTX

PDF

CommunityOpenDay2012名古屋セッション資料 PDF

Windows Azure Community Open Day 2012 PDF

PDF

20121130 solaris-11.1-day-taki PDF

PDF

Open stack reference architecture v1 2 PDF

エバンジェリストが語るパワーシステム特論 ~ 第2回:『x86Linuxのスキルを活かしてPowerを使おう GMOメディア RHEV-S-事例紹介

- 1.

- 2.

- 3.

- 4.

自己紹介

名前 : 宇津井 大(うつい だい)

Twitter : @utsuidai

Linkedin : http://www.linkedin.com/pub/dai-utsui/21/348/547

職業 : インフラエンジニア @ GMO-Media.Inc

趣味 : サーフィンとお酒と勉強会巡り。

自宅サーバー : 1台のみ!

4

- 5.

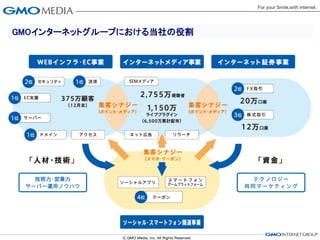

GMOインターネットグループにおける当社の役割

WEBインフラ・EC事業 インターネットメディア事業 インターネット証券事業

2位 セキュリティ 1位決済

1位 EC支援

2,755万視聴者 2位FX取引 3位 株式取引

375万顧客(12月末)

1,150万ライブプラグイン 20万口座 12万口座

1位 サーバー (6,500万累計配布)

1位 ドメイン アクセス ネット広告 リサーチ

「人財・技術」 「資金」

スマートフォン

ソーシャルアプリ

技術力・営業力 ゲームプラットフォーム テクノロジー

サーバー運用ノウハウ 共同マーケティング

4位クーポン

ソーシャル・スマートフォン関連事業

- 6.

会社概要

メディア事業 デジタルコンテンツ提供事業

• 楽しく便利な情報を提供するサイ • コンテンツプロバイダーとして、壁

トや、ブログ・SNSなどのコミュニ 紙画像や着メロなど様々なコンテ

ティサービスを運営する事業です。 ンツを制作・収集し、お客様に提供

• スポンサー企業様からの広告をお する事業です。

届けする無料サービスと、月額課 • スポンサー企業様からの広告をお

金制のサービスがあり、現在、P 届けする無料サービスと、月額課

C・携帯併せて10サイト以上の 金制のサービスがあり、現在、P

サービスを提供しています。 C・携帯併せて30サイト以上の

サービスを提供しています。

- 7.

- 8.

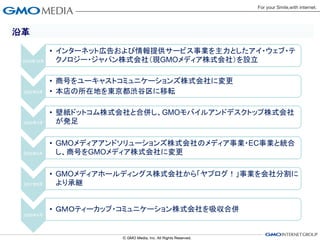

沿革

• インターネット広告および情報提供サービス事業を主力としたアイ・ウェブ・テ

2000年10月 クノロジー・ジャパン株式会社(現GMOメディア株式会社)を設立

• 商号をユーキャストコミュニケーションズ株式会社に変更

2002年5月 • 本店の所在地を東京都渋谷区に移転

• 壁紙ドットコム株式会社と合併し、GMOモバイルアンドデスクトップ株式会社

2004年3月 が発足

• GMOメディアアンドソリューションズ株式会社のメディア事業・EC事業と統合

2005年5月 し、商号をGMOメディア株式会社に変更

• GMOメディアホールディングス株式会社から「ヤプログ!」事業を会社分割に

2007年8月 より承継

• GMOティーカップ・コミュニケーション株式会社を吸収合併

2009年4月

- 9.

- 10.

- 11.

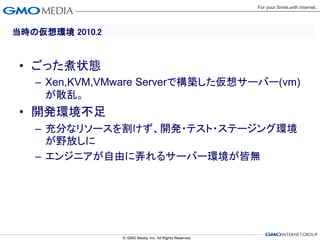

当時の仮想環境 2010.2

•ごった煮状態

– Xen,KVM,VMware Serverで構築した仮想サーバー(vm)

が散乱。

• 開発環境不足

– 充分なリソースを割けず、開発・テスト・ステージング環境

が野放しに

– エンジニアが自由に弄れるサーバー環境が皆無

- 12.

- 13.

- 14.

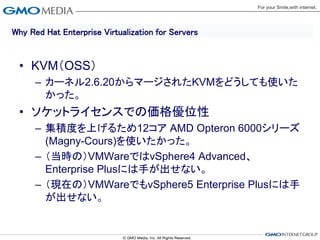

Why Red HatEnterprise Virtualization for Servers

• KVM(OSS)

– カーネル2.6.20からマージされたKVMをどうしても使いた

かった。

• ソケットライセンスでの価格優位性

– 集積度を上げるため12コア AMD Opteron 6000シリーズ

(Magny-Cours)を使いたかった。

– (当時の)VMWareではvSphere4 Advanced、

Enterprise Plusには手が出せない。

– (現在の)VMWareでもvSphere5 Enterprise Plusには手

が出せない。

- 15.

- 16.

- 17.

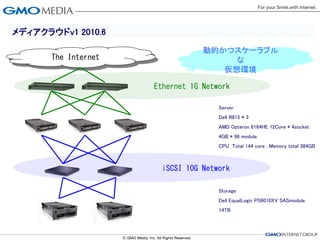

メディアクラウドv1 2010.6

動的かつスケーラブル

The Internet な

仮想環境

Ethernet 1G Network

Server

Dell R815 * 3

AMD Opteron 6164HE 12Core * 4socket

4GB * 96 module

CPU Total 144 core : Memory total 384GB

iSCSI 10G Network

Storage

Dell EqualLogic PS6010XV SASmodule

14TB

- 18.

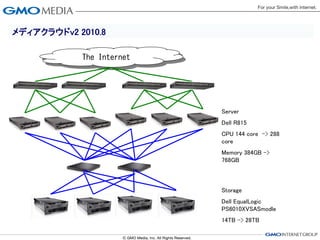

メディアクラウドv2 2010.8

The Internet

Server

Dell R815

CPU 144 core -> 288

core

Memory 384GB ->

768GB

Storage

Dell EqualLogic

PS6010XVSASmodle

14TB -> 28TB

- 19.

- 20.

要件1

• ストレージは重要

– ストレージが落ちると全体障害になりえる

– データセンター内のネットワークはfablicを求めている

– ベンダーロックインを減らす

– i/o負荷の高いDBも仮想化したい

- 21.

- 22.

- 23.

導入の効果

• ストレージの分離

– StoragePoolManagerが3つに。全体障害の回避。

• シンプル構成

– CPU Socket辺りの10Gb利用ポート数が約62%現象

• iscsiネットワーク内の話でブレードフル搭載の場合

– 現在はシャーシ辺り5台運用なので約37%。

» しかも全部10Gにしたのでポート数は増えてます

– 配線が約60%減少

• 拡張性

– スケールアウトが容易

• エンクロージャに空スロットを用意しておけば増設が非常に楽

• エンクロージャ足すのも旧来の2Uサーバーと同等程度の作業量

- 24.

- 25.

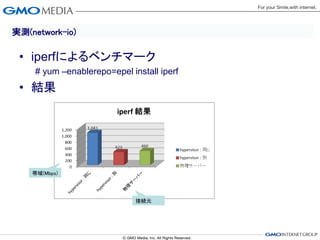

実測(disk-io)

# cat diskio-localext4.fio

• fioによるベンチマーク [global]

bs=4k

# yum –enablerepo=rpmforge install fio ioengine=libaio

iodepth=4

size=1g

# fio diskio.fio direct=1

runtime=30

directory=/data/fio

• 結果 filename=fio.test.file

[seq-read]

iscsi rhev(kvm) kvm rw=read

stonewall

BandWidth iops BandWidth iops overhead

write 298 MB/s 288 263 MB/s 257 88% [rand-read]

seq read 705 MB/s 688 511 MB/s 499 72% rw=randread

rw(mix) 153 MB/s 149 130 MB/s 127 85% stonewall

write 151 MB/s 147 113 MB/s 110 75% [seq-write]

rnd read 256 MB/s 250 128 MB/s 125 50% rw=write

rw(mix) 128 MB/s 125 59 MB/s 58 46% stonewall

[rand-write]

※format=raw rw=randwrite

stonewall

[seq-rw]

rw=rw

stonewall

[rnd-rw]

rw=randrw

stonewall

- 26.

- 27.

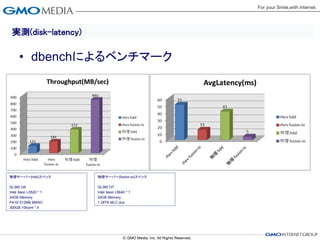

実測(disk-latency)

• dbenchによるベンチマーク

物理サーバー(hdd)スペック 物理サーバー(fusion-io)スペック

DL360 G6 DL360 G7

Intel Xeon L5520 * 1 Intel Xeon L5640 * 1

24GB Memory 24GB Memory

P410i 512MB BBWC 1.28TB MLC duo

300GB 10krpm * 4

- 28.

- 29.

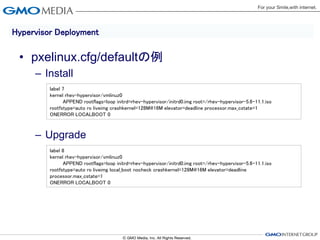

Hypervisor Deployment

•pxeboot

– 2台以上のhypervisorを利用するなら必須

– Installは手作業で実施(自動化も可能)

– Upgradeはキーボード2回たたくだけ

– 詳しくはrhel5のHypervisor 導入ガイド

» http://docs.redhat.com/docs/ja-

JP/Red_Hat_Enterprise_Linux/5/html/Hypervisor_Deploymen

t_Guide/sect-Deployment_Guide-

Preparing_Red_Hat_Enterprise_Virtualization_Hypervisor_ins

tallation_media-

Deploying_RHEV_Hypervisors_with_PXE_and_tftp.html

- 30.

Hypervisor Deployment

•pxelinux.cfg/defaultの例

– Install

label 7

kernel rhev-hypervisor/vmlinuz0

APPEND rootflags=loop initrd=rhev-hypervisor/initrd0.img root=/rhev-hypervisor-5.6-11.1.iso

rootfstype=auto ro liveimg crashkernel=128M@16M elevator=deadline processor.max_cstate=1

ONERROR LOCALBOOT 0

– Upgrade

label 8

kernel rhev-hypervisor/vmlinuz0

APPEND rootflags=loop initrd=rhev-hypervisor/initrd0.img root=/rhev-hypervisor-5.6-11.1.iso

rootfstype=auto ro liveimg local_boot nocheck crashkernel=128M@16M elevator=deadline

processor.max_cstate=1

ONERROR LOCALBOOT 0

- 31.

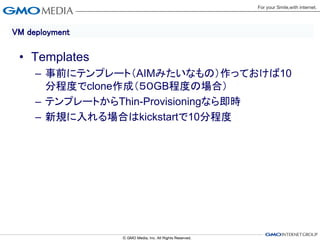

VM deployment

•Templates

– 事前にテンプレート(AIMみたいなもの)作っておけば10

分程度でclone作成(50GB程度の場合)

– テンプレートからThin-Provisioningなら即時

– 新規に入れる場合はkickstartで10分程度

- 32.

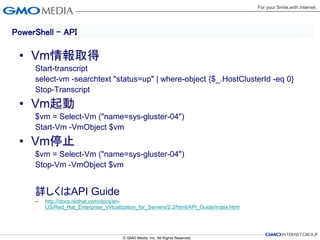

PowerShell - API

• Vm情報取得

Start-transcript

select-vm -searchtext "status=up" | where-object {$_.HostClusterId -eq 0}

Stop-Transcript

• Vm起動

$vm = Select-Vm ("name=sys-gluster-04")

Start-Vm -VmObject $vm

• Vm停止

$vm = Select-Vm ("name=sys-gluster-04")

Stop-Vm -VmObject $vm

詳しくはAPI Guide

– http://docs.redhat.com/docs/en-

US/Red_Hat_Enterprise_Virtualization_for_Servers/2.2/html/API_Guide/index.html

- 33.

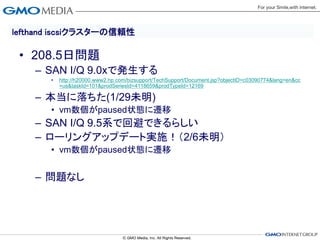

lefthand iscsiクラスターの信頼性

•208.5日問題

– SAN I/Q 9.0xで発生する

• http://h20000.www2.hp.com/bizsupport/TechSupport/Document.jsp?objectID=c03090774&lang=en&cc

=us&taskId=101&prodSeriesId=4118659&prodTypeId=12169

– 本当に落ちた(1/29未明)

• vm数個がpaused状態に遷移

– SAN I/Q 9.5系で回避できるらしい

– ローリングアップデート実施!(2/6未明)

• vm数個がpaused状態に遷移

– 問題なし

- 34.

- 35.

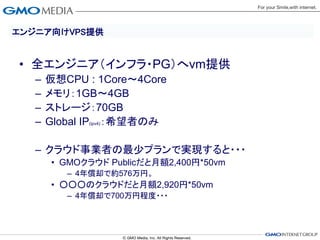

エンジニア向けVPS提供

• 全エンジニア(インフラ・PG)へvm提供

– 仮想CPU : 1Core~4Core

– メモリ:1GB~4GB

– ストレージ:70GB

– Global IP(ipv4):希望者のみ

– クラウド事業者の最少プランで実現すると・・・

• GMOクラウド Publicだと月額2,400円*50vm

– 4年償却で約576万円。

• ○○○のクラウドだと月額2,920円*50vm

– 4年償却で700万円程度・・・

- 36.

ソーシャルアプリ1

• モバゲー,Mixi向けアプリ

– Amazon Web Serviceから完全

移行

– サーバ性能というよりネットワー

ク(RTT)の改善により大幅にパ

フォーマンスアップ

– 大幅なコストダウン

• AWS月額 約20万円 ⇒ RHEV

約2万円

- 37.

- 38.

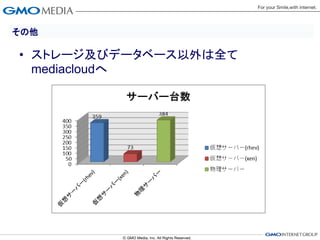

その他

• データセンター移転 2010.8

– 300台程度のDualCoreサーバ群

– rhev環境に積極的に取り込み実施。

• vmの数は物理台数の約半数で稼動可能だった。

• P2Vは不採用

– 100万円/月のコスト削減に成功!

– 節電にもかなり貢献した(はず)!

- 39.

- 40.

- 41.

- 42.

- 43.

Manual

• RedHat Docs

– http://docs.redhat.com/docs/ja-JP/index.html

- 44.

Web / Books

• Web

– 世の中のkvm一般

のナレッジは充分

参考になる。

• Books

– 世の中のkvm一般

の本・冊子は充分

参考になる。

![実測(disk-io)

# cat diskio-localext4.fio

• fioによるベンチマーク [global]

bs=4k

# yum –enablerepo=rpmforge install fio ioengine=libaio

iodepth=4

size=1g

# fio diskio.fio direct=1

runtime=30

directory=/data/fio

• 結果 filename=fio.test.file

[seq-read]

iscsi rhev(kvm) kvm rw=read

stonewall

BandWidth iops BandWidth iops overhead

write 298 MB/s 288 263 MB/s 257 88% [rand-read]

seq read 705 MB/s 688 511 MB/s 499 72% rw=randread

rw(mix) 153 MB/s 149 130 MB/s 127 85% stonewall

write 151 MB/s 147 113 MB/s 110 75% [seq-write]

rnd read 256 MB/s 250 128 MB/s 125 50% rw=write

rw(mix) 128 MB/s 125 59 MB/s 58 46% stonewall

[rand-write]

※format=raw rw=randwrite

stonewall

[seq-rw]

rw=rw

stonewall

[rnd-rw]

rw=randrw

stonewall](https://image.slidesharecdn.com/gmo-rhev-s-120323032742-phpapp01/85/GMO-RHEV-S-25-320.jpg)