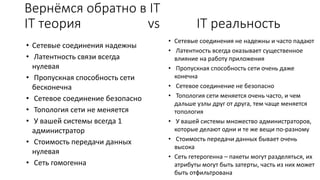

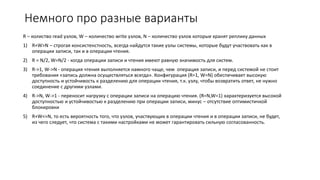

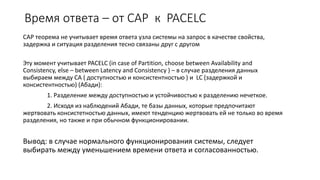

Документ обсуждает теорему CAP, согласно которой распределенные системы могут обеспечивать только два из трех свойств: согласованность, доступность и устойчивость к разделению. Особое внимание уделяется влиянию этой теоремы на веб-технологии и архитектуру приложений, а также критическим замечаниям о реалиях сети, как надежности соединений и латентности. Анализируются различные подходы к обработке запросов в условиях разделения и компромиссы между доступностью и согласованностью данных.