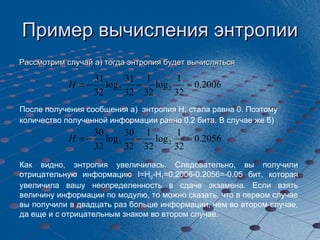

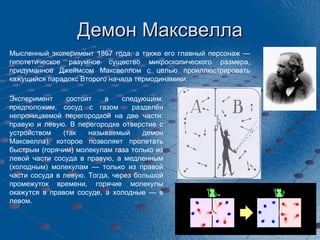

Документ охватывает концепции термодинамической и информационной энтропий, введенные Клаузиусом и Шенноном соответственно, и показывает их применение в различных областях, таких как теория вероятностей и миграционные потоки. Рассматриваются примеры вычисления энтропии и философские размышления о природе информации и неопределенности. Также упоминается мысленный эксперимент 'демон Максвелла', иллюстрирующий парадокс второго начала термодинамики.