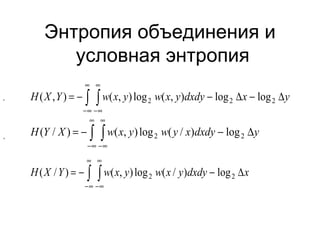

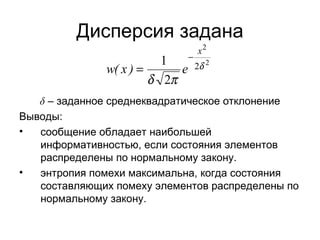

Документ посвящен информационным характеристикам непрерывных случайных систем, включая такие концепции, как энтропия, дифференциальная энтропия и взаимная информация. Обсуждаются принципы экстремума энтропии и влияние заданной или произвольной дисперсии на информативность сообщений. Выводы указывают, что максимальная информативность достигается при нормальном или равновероятном распределении состояний элементов.