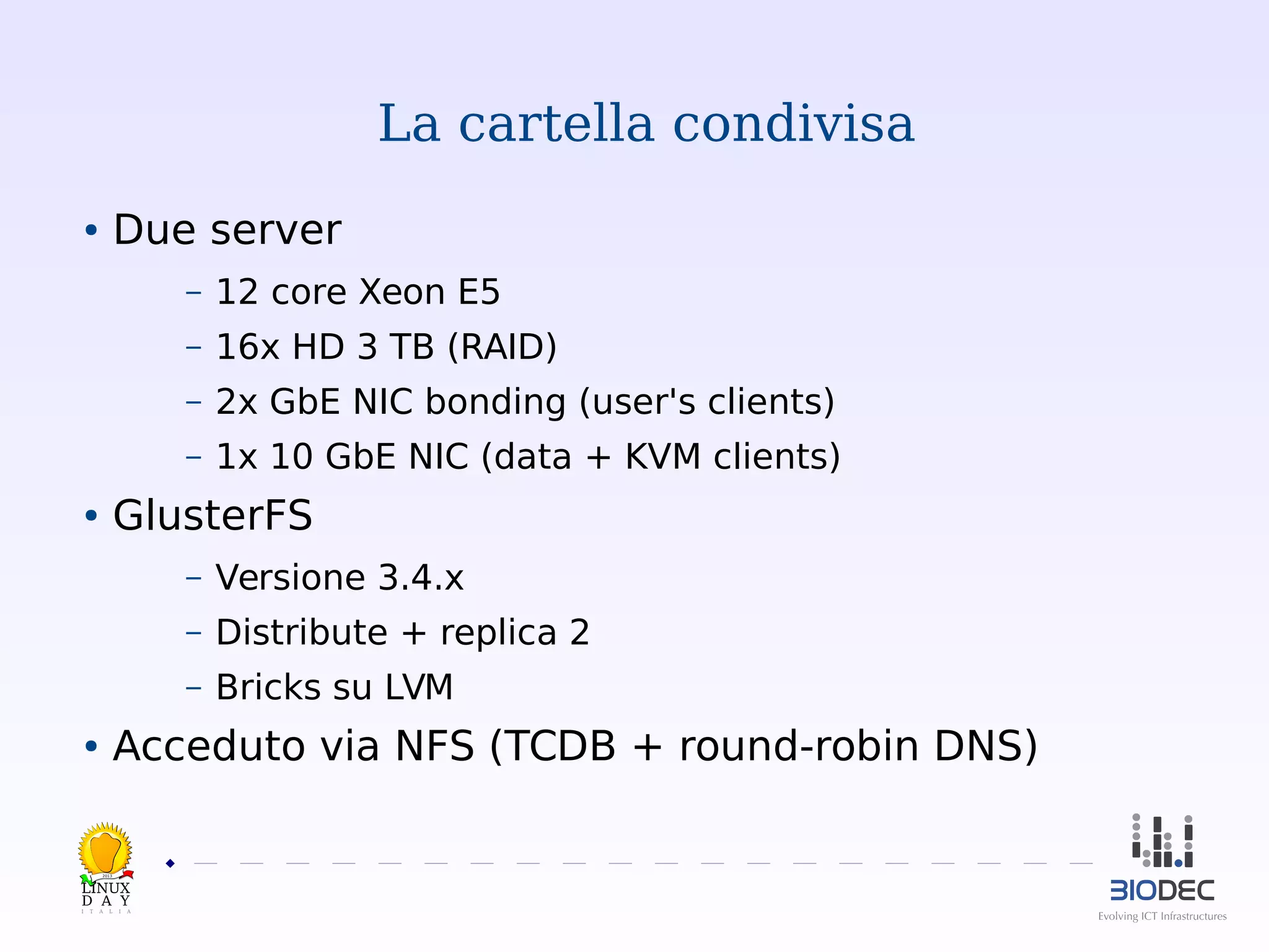

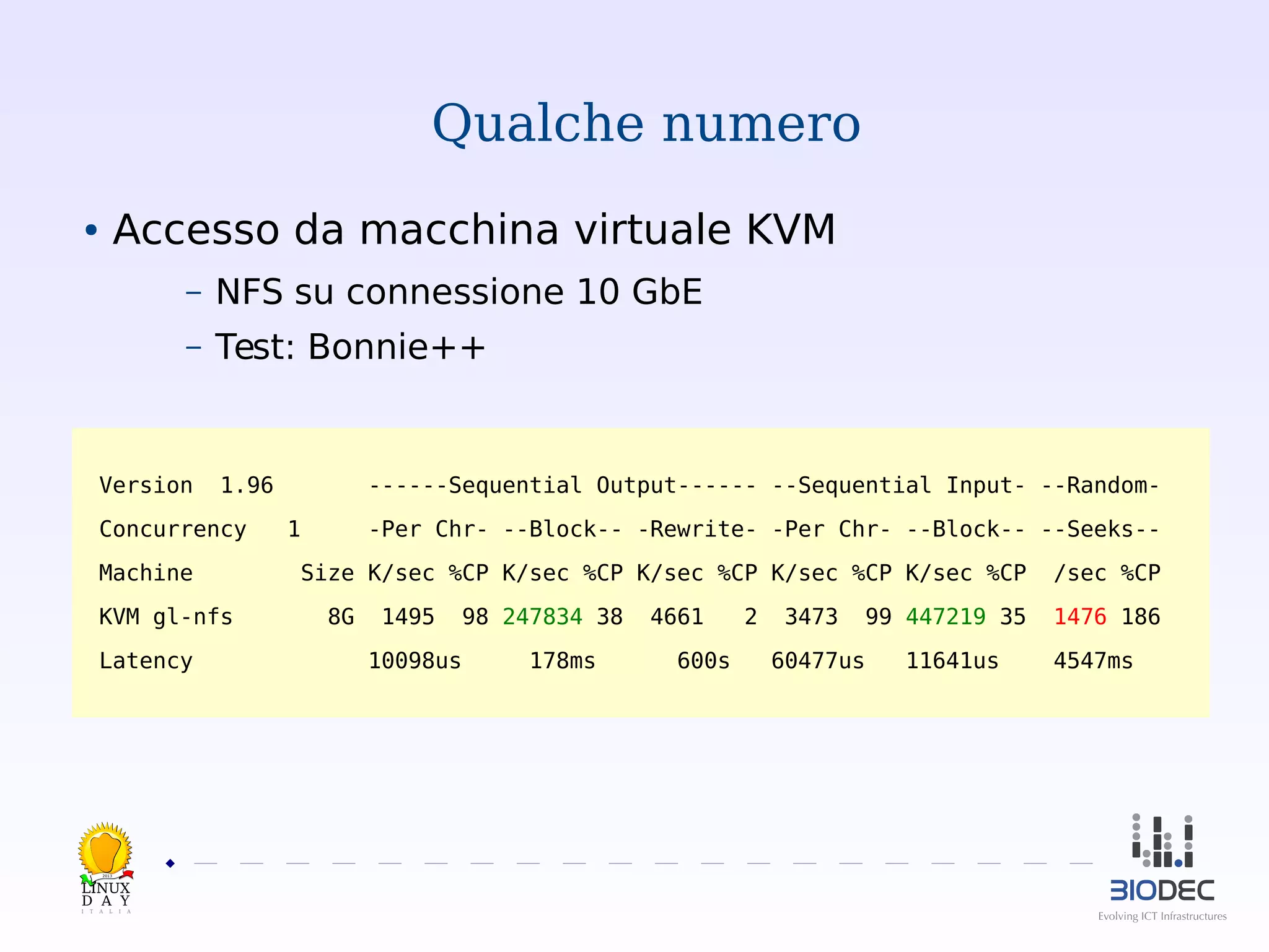

Il documento presenta GlusterFS, un file system distribuito e scalabile utilizzato da Biodec S.r.l. e altre aziende per creare soluzioni di storage personalizzate a basso costo. Attraverso un'architettura a plugin e il supporto di diversi protocolli, GlusterFS offre fault-tolerance, alta disponibilità e facilità di installazione. Viene discusso anche il confronto con altre soluzioni di storage e l'importanza di ottimizzazioni hardware e software per le prestazioni.