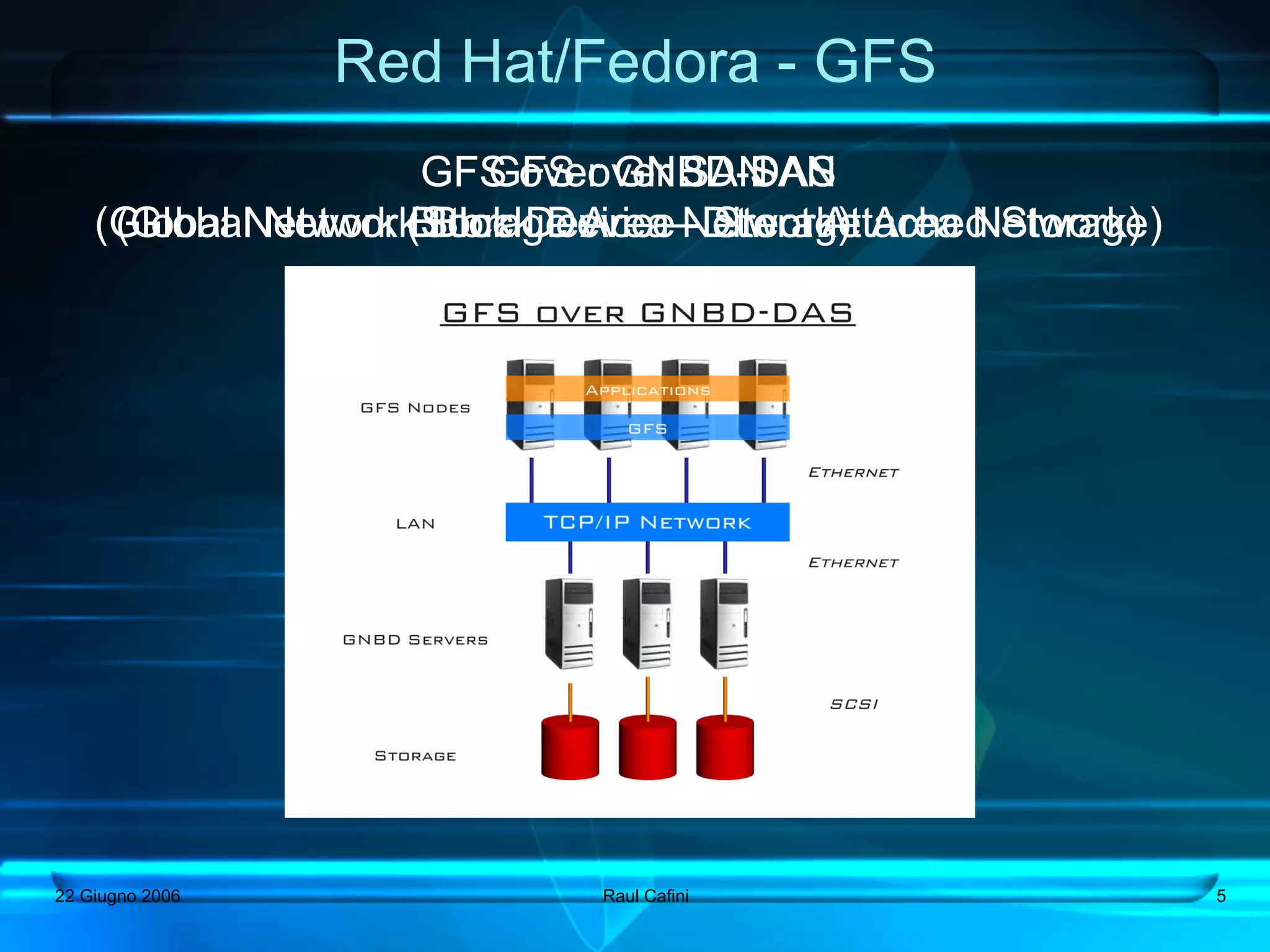

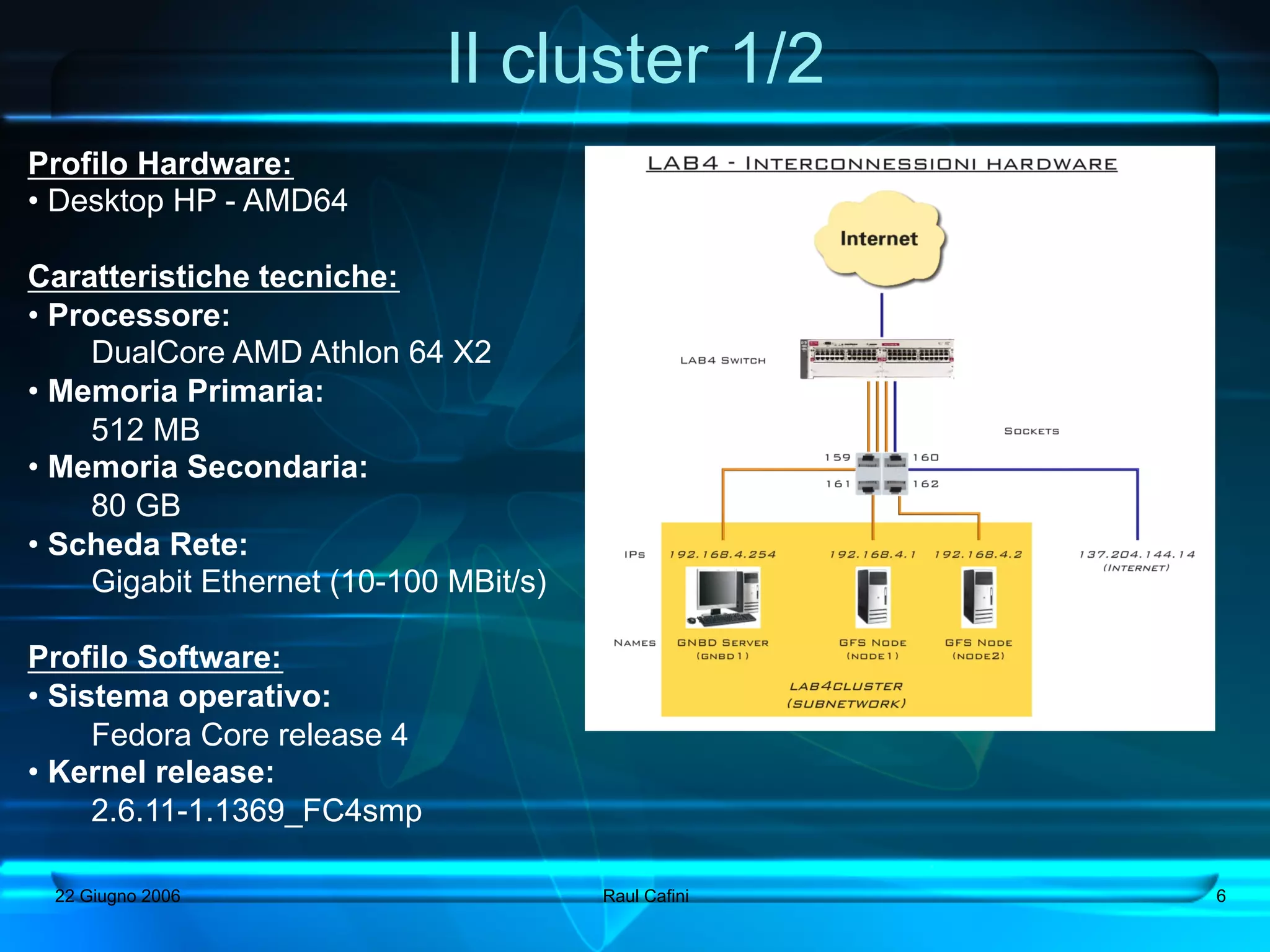

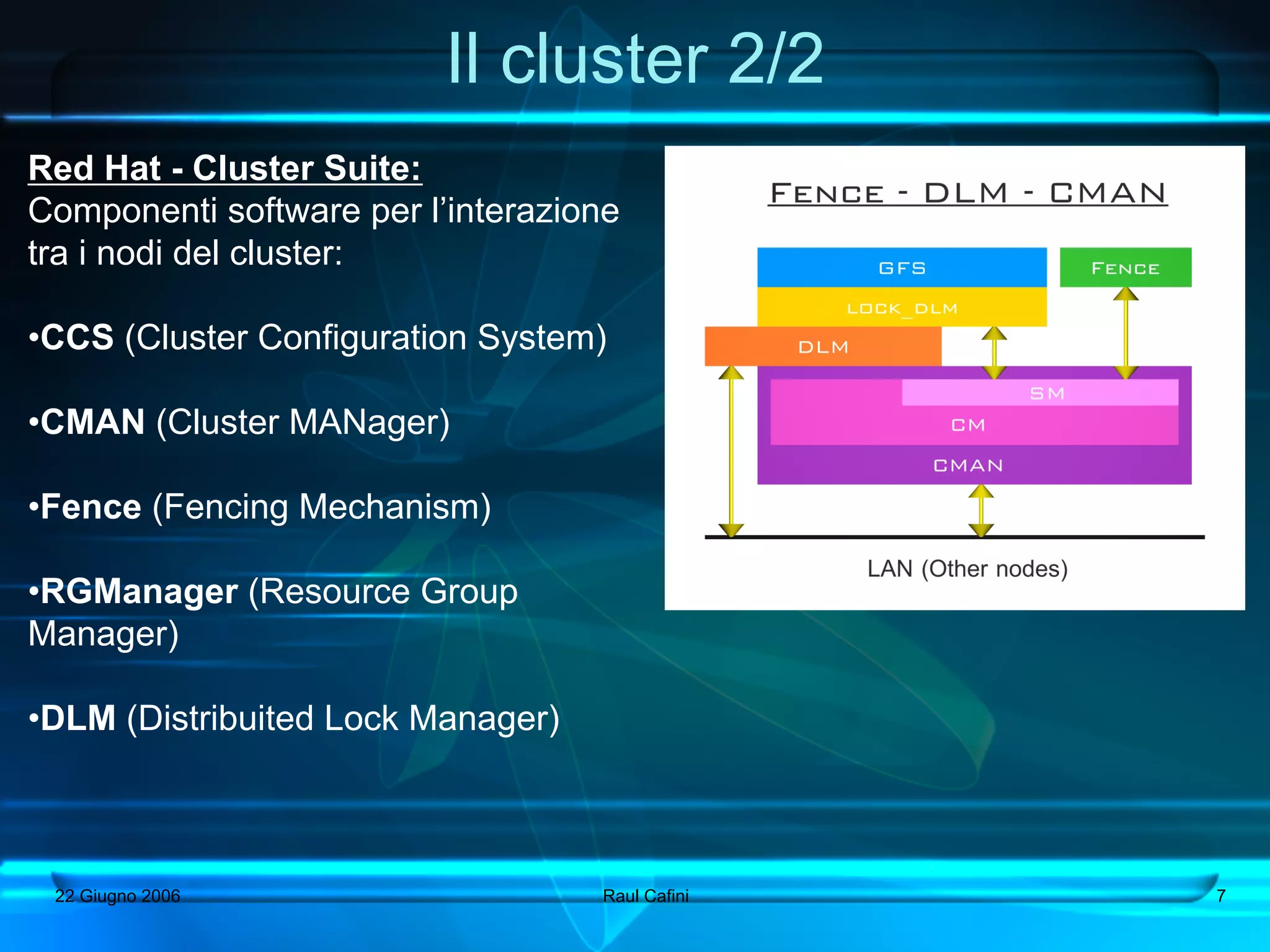

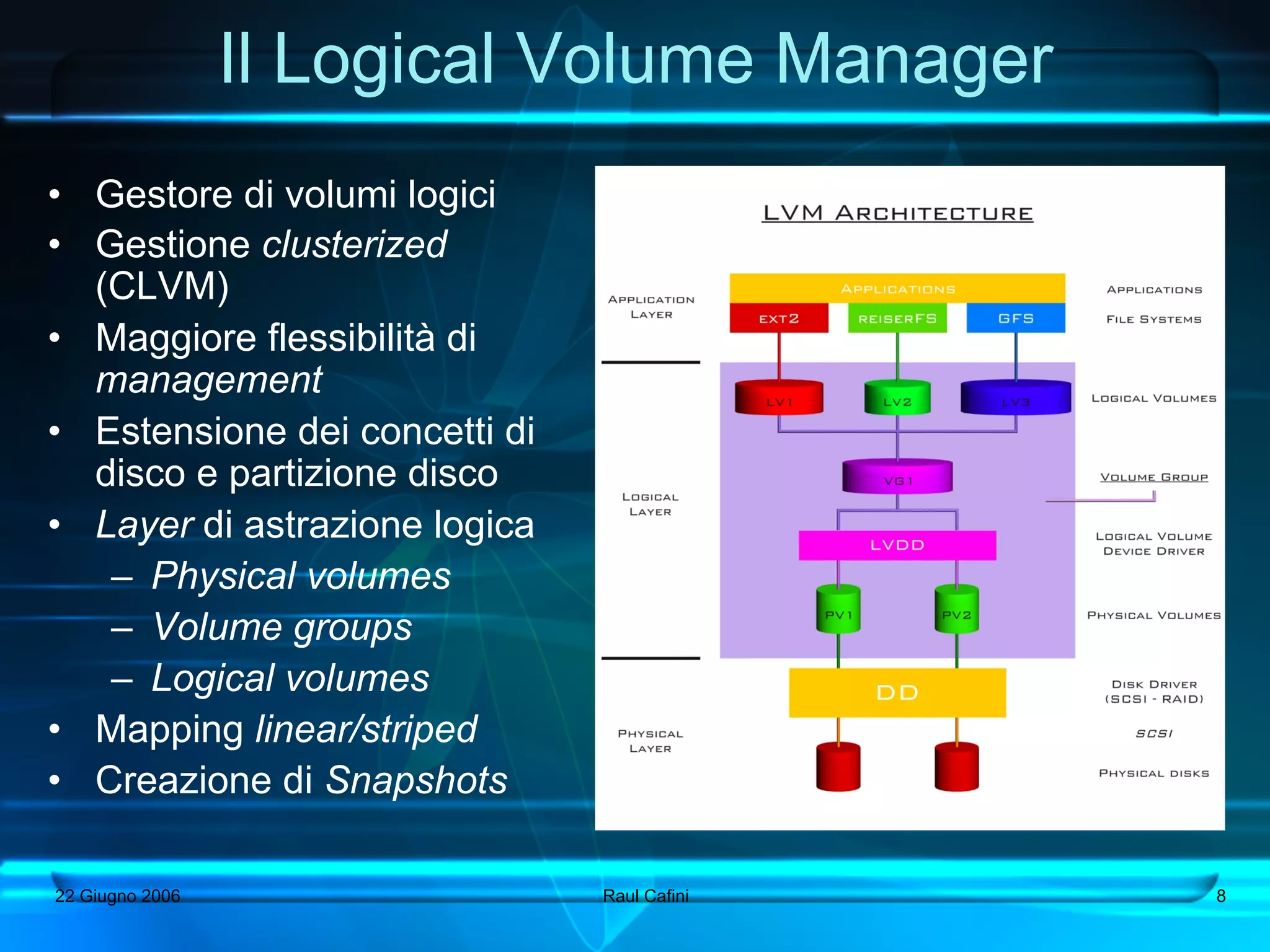

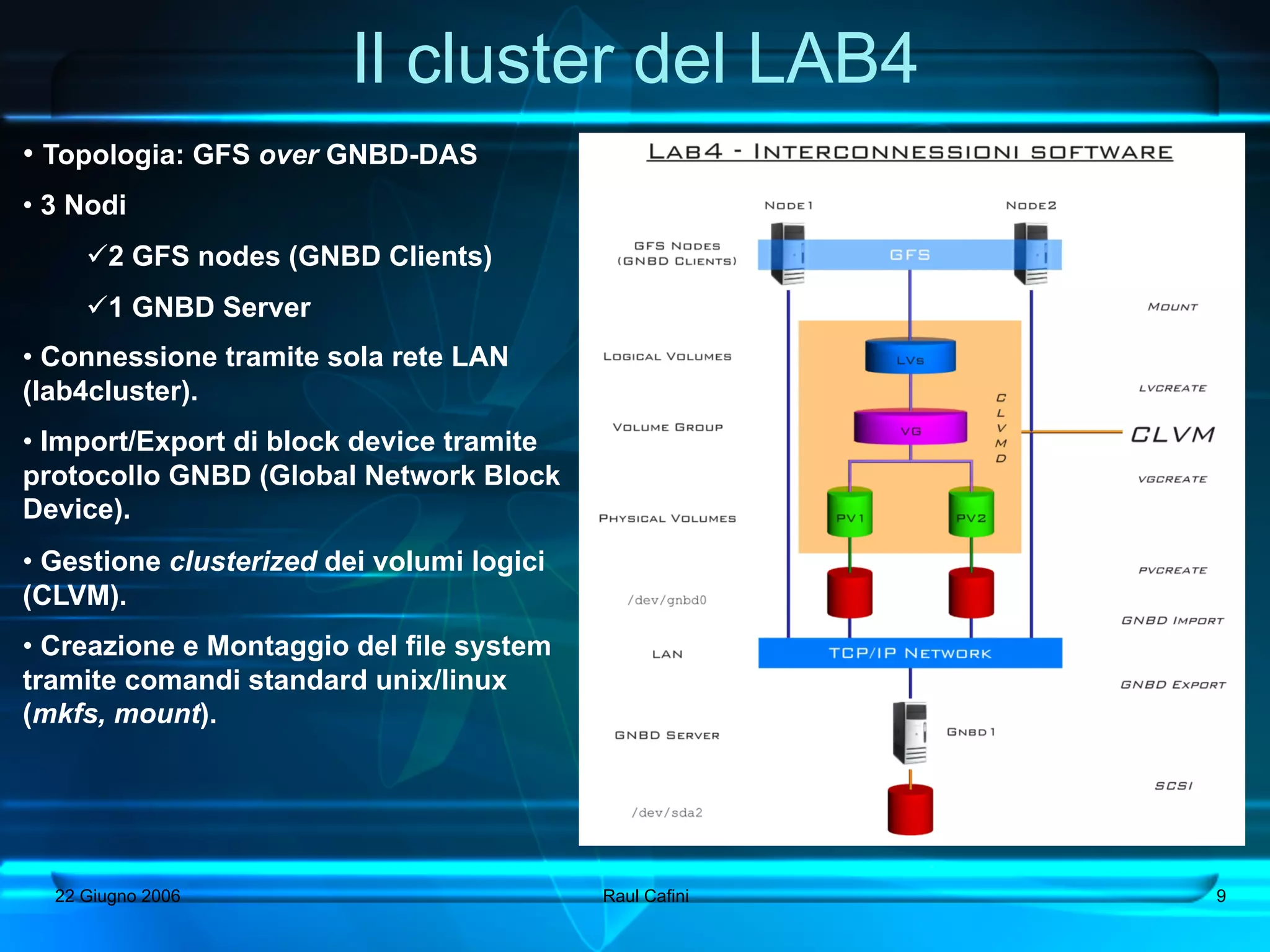

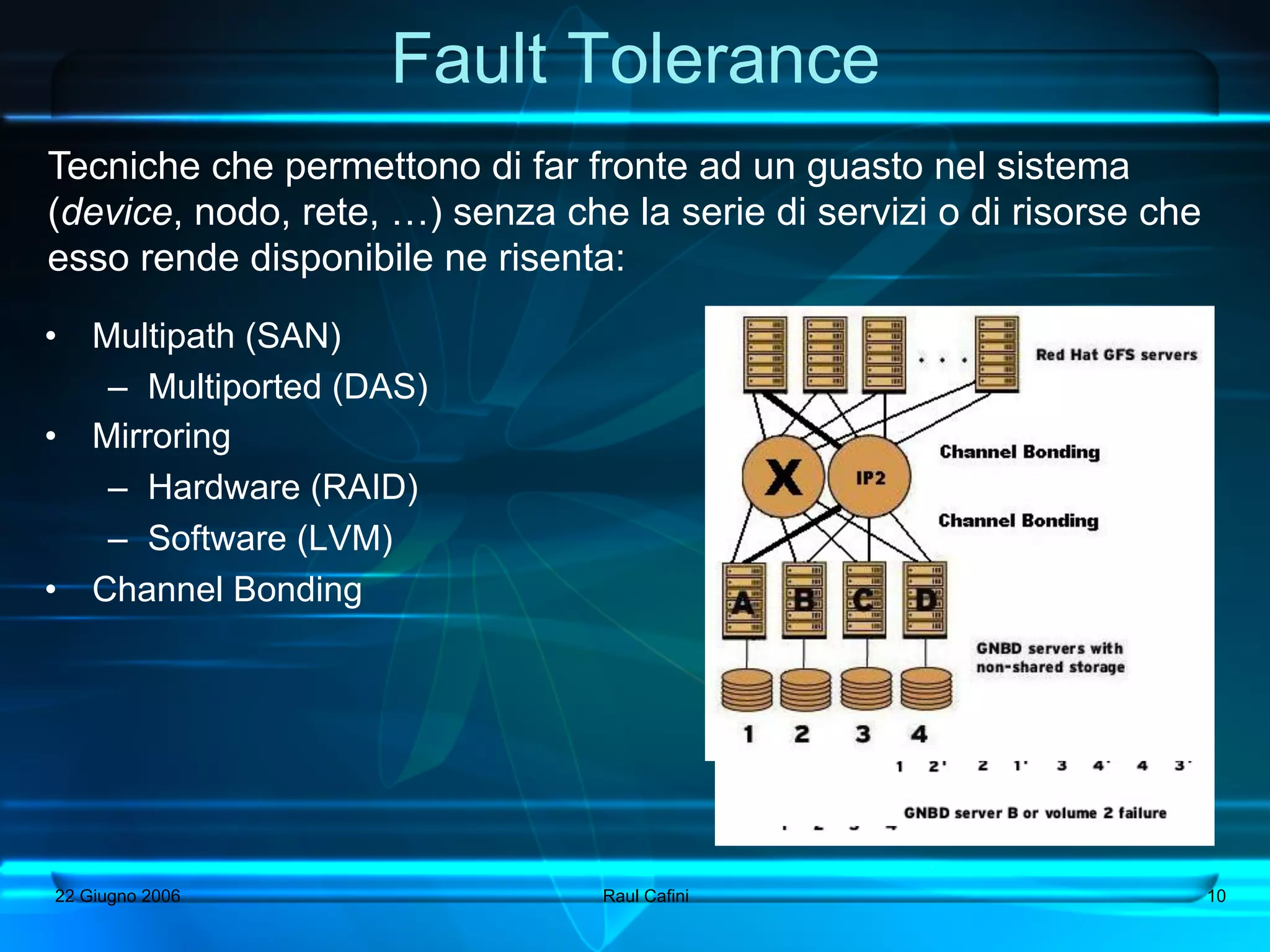

Questa tesi analizza e implementa file system distribuiti in un ambiente cluster su Linux, con un focus particolare su GFS (Global File System). L'obiettivo include l'analisi della documentazione esistente, la creazione di un cluster e la realizzazione del file system distribuito, con considerazioni sulla tolleranza ai guasti. Vengono inoltre discussi futuri sviluppi come l'aggiunta di server GNB e l'analisi delle prestazioni dei file system.