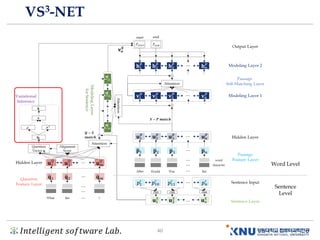

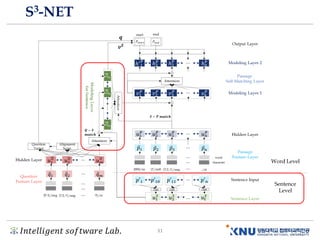

기계 독해(Machine reading comprehension)를 이용한 질의 응답(Question answering)은 주어진 문맥을 이해하고, 질문에 적합한 답을 문맥 내에서 찾는 문제이다. 기계 독해 중 SQuAD dataset은 span 단위의 답을 문맥 내에서 찾는 질의응답 태스크이다. 본 발표에서는 SQuAD 2.0에 도전하기 위하여 연구한 VS^3-NET에 대하여 설명한다. VS^3-NET은 simple recurrent unit (SRU)와 sentence- 및 self-matching network 모델을 기반으로 하고 있으며, 다양한 질문 유형에 대하여 모델링을 수행하기 위해 variational inference network를 함께 적용한다.

![𝐼𝑛𝑡𝑒𝑙𝑙𝑖𝑔𝑒𝑛𝑡 𝑠𝑜𝑓𝑡𝑤𝑎𝑟𝑒 𝐿𝑎𝑏. 22

S2-NET: Inputs

단어 표현 (word embedding)

• NNLM: 한국/nnp [0.1, 0.02, 0.7, 0.004, 0.1, …]

• GloVe: Naver [0.6, 0.245, 0.037, 0.412, 0.14, …]

음절 표현 (character embedding)

• 한, 국 [[0.05, 0.1 …], …, [0.4, 0.7, 0.2…]]

• N, a, v, e, r [[0.3, 0.2 …], …, [0.2, 0.6…]]

자질 (features)](https://image.slidesharecdn.com/vs3-netformachinereadingcomprehensionquestionanswering-181119055705/85/Vs-3-net-for-machine-reading-comprehension-question-answering-22-320.jpg)

![𝐼𝑛𝑡𝑒𝑙𝑙𝑖𝑔𝑒𝑛𝑡 𝑠𝑜𝑓𝑡𝑤𝑎𝑟𝑒 𝐿𝑎𝑏. 23

S2-NET: Features

Feature Layer

• 𝑝 = [𝑓𝑒𝑚𝑏 𝑝𝑡 ; 𝑓𝑐_𝑒𝑚𝑏 𝑝𝑡 ; 𝑓𝑒𝑥𝑎𝑐𝑡_𝑚𝑎𝑡𝑐ℎ 𝑝𝑡 ; 𝑓𝑡𝑓 𝑝𝑡 ; 𝑓𝑎𝑙𝑖𝑔𝑛(𝑝𝑡ሻ]

• 𝑞 = [𝑓𝑒𝑚𝑏 𝑞𝑡 ; 𝑓𝑐_𝑒𝑚𝑏 𝑞𝑡 ; 𝑓𝑒𝑥𝑎𝑐𝑡_𝑚𝑎𝑡𝑐ℎ 𝑞𝑡 ; 𝑓𝑡𝑓 𝑞𝑡 ; 𝑓𝑎𝑙𝑖𝑔𝑛(𝑞𝑡ሻ]

• 정확한 매치 (exact match)

𝑓𝑒𝑥𝑎𝑐𝑡_𝑚𝑎𝑡𝑐ℎ 𝑝𝑡 = 𝕝(𝑝𝑡 ∈ 𝑞ሻ

• 토큰 자질 (token feature)

𝑓𝑡𝑓 𝑝𝑡 = 𝑇𝐹(𝑝𝑡ሻ

• 정렬된 질문 표현 (aligned question embedding)

• POS and NER tags

𝑓𝑎𝑙𝑖𝑔𝑛 𝑝𝑡 = σ 𝑗 𝛼 𝑡,𝑗 𝐸(𝑞 𝑗ሻ 𝛼 𝑡,𝑗 =

exp 𝛼 𝐸 𝑝 𝑡 ⋅𝛼 𝐸 𝑞 𝑗

σ 𝑗′ exp 𝛼 𝐸 𝑝 𝑡 ⋅𝛼 𝐸 𝑞 𝑗′](https://image.slidesharecdn.com/vs3-netformachinereadingcomprehensionquestionanswering-181119055705/85/Vs-3-net-for-machine-reading-comprehension-question-answering-23-320.jpg)

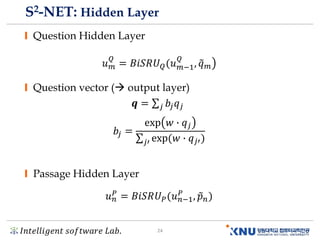

![𝐼𝑛𝑡𝑒𝑙𝑙𝑖𝑔𝑒𝑛𝑡 𝑠𝑜𝑓𝑡𝑤𝑎𝑟𝑒 𝐿𝑎𝑏. 27

S2-NET: Output (answer span)

이날 지수는 고등학교때부터 연극

을 해오다 지난해 MBC 드라마 [앵

그리맘]으로 데뷔했다고 밝혔다.

Q: 지수 데뷔작이 뭔가요?

A: 앵그리맘

output: 7,7

Pointer Networks](https://image.slidesharecdn.com/vs3-netformachinereadingcomprehensionquestionanswering-181119055705/85/Vs-3-net-for-machine-reading-comprehension-question-answering-27-320.jpg)

![𝐼𝑛𝑡𝑒𝑙𝑙𝑖𝑔𝑒𝑛𝑡 𝑠𝑜𝑓𝑡𝑤𝑎𝑟𝑒 𝐿𝑎𝑏. 34

S3-NET: Question-aware Sentence Representation

Q-S Matching Layer

𝑣𝑡

𝑆

= 𝐵𝑖𝑆𝑅𝑈(𝑣𝑡−1

𝑆

, 𝑢 𝑡

𝑆

; 𝑐𝑡

∗ሻ

𝑔𝑡 = 𝑠𝑖𝑔𝑚𝑜𝑖𝑑(𝑊𝑔

𝑆

𝑢 𝑡

𝑆

; 𝑐𝑡 ሻ

𝑢 𝑡

𝑆

; 𝑐𝑡

∗ = 𝑔𝑡⨀[𝑢 𝑡

𝑆

; 𝑐𝑡]

𝛼𝑖

𝑡

= exp 𝑢 𝑡

𝑆

𝑊𝑎

𝑆 𝑢𝑖

𝑄

/ σ 𝑗=1

𝑀

exp(𝑢 𝑡

𝑆

𝑊𝑎

𝑆 𝑢𝑗

𝑄

ሻ

𝑐𝑡 = σ𝑖=1

𝑀

𝑎𝑖

𝑡

𝑢𝑖

𝑄](https://image.slidesharecdn.com/vs3-netformachinereadingcomprehensionquestionanswering-181119055705/85/Vs-3-net-for-machine-reading-comprehension-question-answering-34-320.jpg)

![𝐼𝑛𝑡𝑒𝑙𝑙𝑖𝑔𝑒𝑛𝑡 𝑠𝑜𝑓𝑡𝑤𝑎𝑟𝑒 𝐿𝑎𝑏. 35

S3-NET: Sentence-aware Passage Representation

S-P Matching Layer

𝑣 𝑛

𝑃 = 𝐵𝑖𝑆𝑅𝑈(𝑣 𝑛−1

𝑃

, 𝑢 𝑛

𝑃; 𝑐 𝑛

∗ሻ

𝑔 𝑛 = 𝑠𝑖𝑔𝑚𝑜𝑖𝑑(𝑊𝑔

𝑃

𝑢 𝑛

𝑃

; 𝑐 𝑛 ሻ

𝑢 𝑛

𝑃

; 𝑐 𝑛

∗

= 𝑔 𝑛⨀[𝑢 𝑛

𝑃

; 𝑐 𝑛]

𝛼𝑖

𝑛

=

exp 𝑢 𝑛

𝑃 𝑊𝑎

𝑃 𝑣𝑖

𝑆

σ 𝑗=1

𝑆

exp 𝑢 𝑛

𝑃 𝑊𝑎

𝑃 𝑣 𝑗

𝑆

𝑐 𝑛 = σ𝑖=1

𝑆

𝑎𝑖

𝑛

𝑢𝑖

𝑃](https://image.slidesharecdn.com/vs3-netformachinereadingcomprehensionquestionanswering-181119055705/85/Vs-3-net-for-machine-reading-comprehension-question-answering-35-320.jpg)