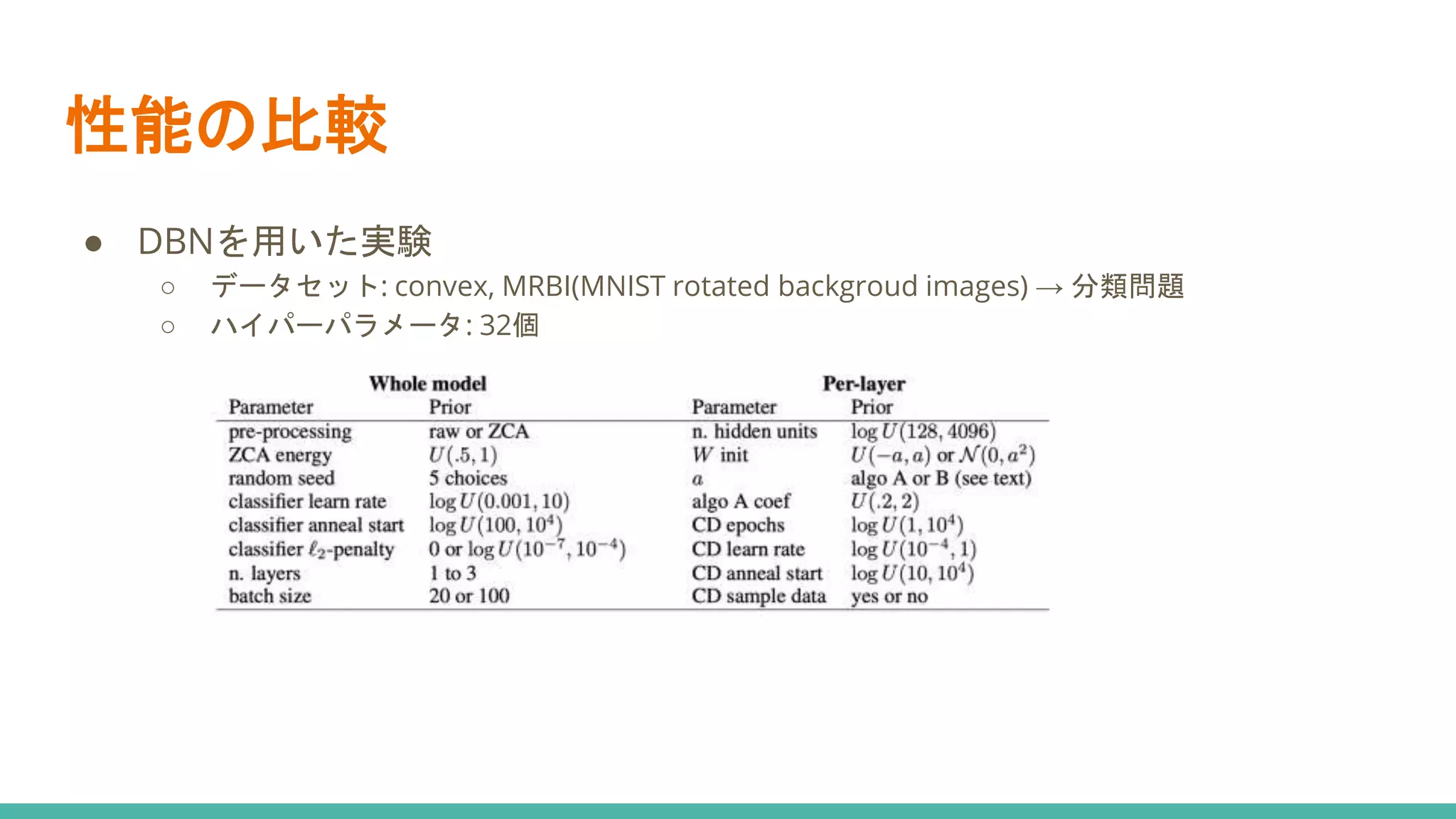

ベイズ最適化によるハイパーパラメータ探索についてざっくりと解説しました。

今回紹介する内容の元となった論文

Bergstra, James, et al. "Algorithms for hyper-parameter optimization." 25th annual conference on neural information processing systems (NIPS 2011). Vol. 24. Neural Information Processing Systems Foundation, 2011.

https://hal.inria.fr/hal-00642998/

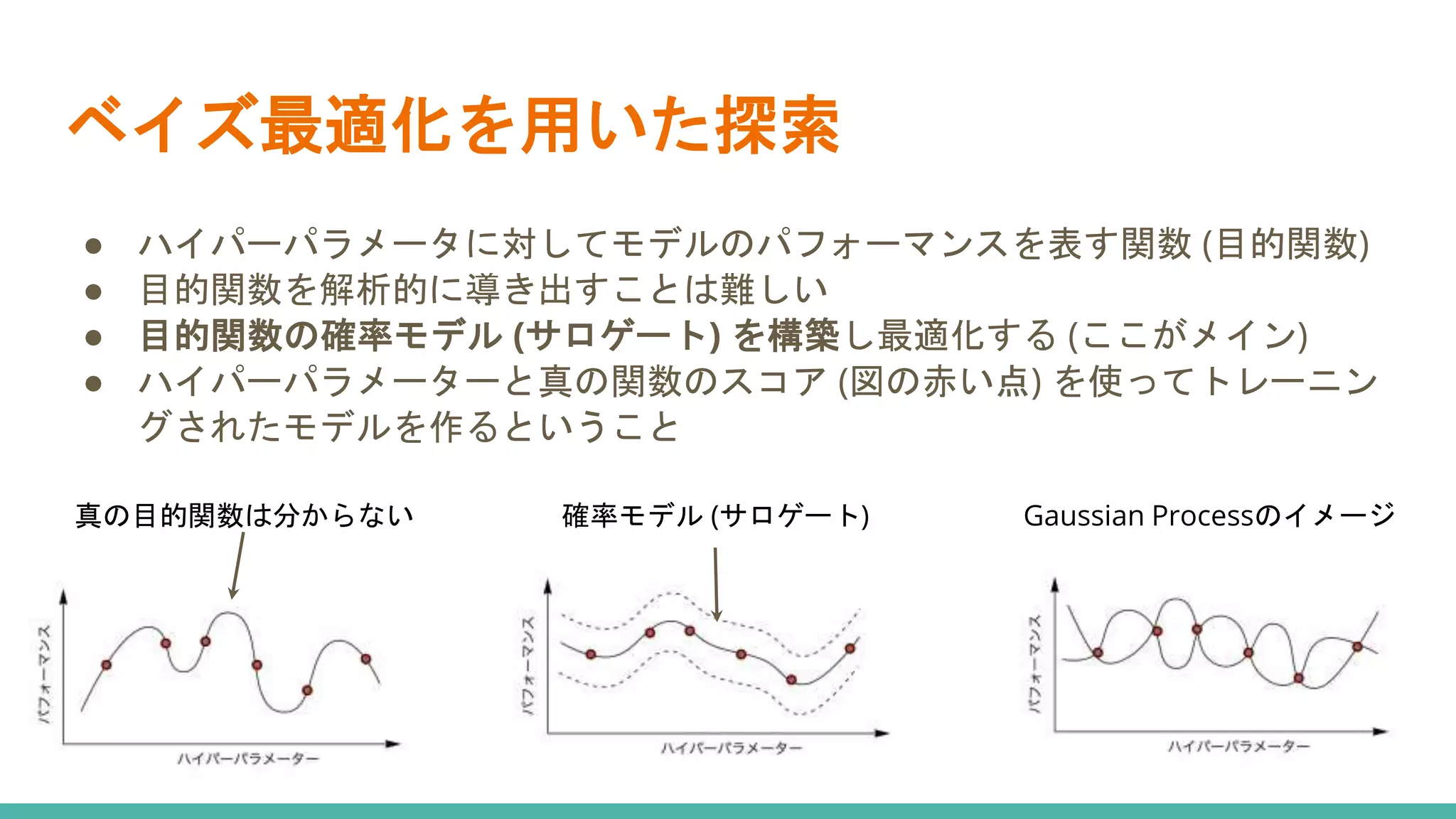

![ベイズ最適化を用いた探索

● H: 観測点とその評価値の集合

● T: イテレーション数

● x: パラメータベクトル

● M: サロゲート(パラメータの分布を推定)

● S: 獲得関数(Mの元であるxを使用した時のloss

の期待値計算)

● f(x): モデルにパラメータx 使用した際のloss

[アルゴリズム]

1. 各パラメータに対する評価値を入れる集合H を用

意

2. T回イテレーション↓

3. あるパラメータベクトルxと代理関数Mを用いて

loss を最も小さくするパラメータを選択

4. そのパラメータを評価しサンプル(x, f(x))を得る

5. Hを更新

6. 代理関数Mの更新](https://image.slidesharecdn.com/bayesianparameteroptimization-210626072505/75/slide-6-2048.jpg)