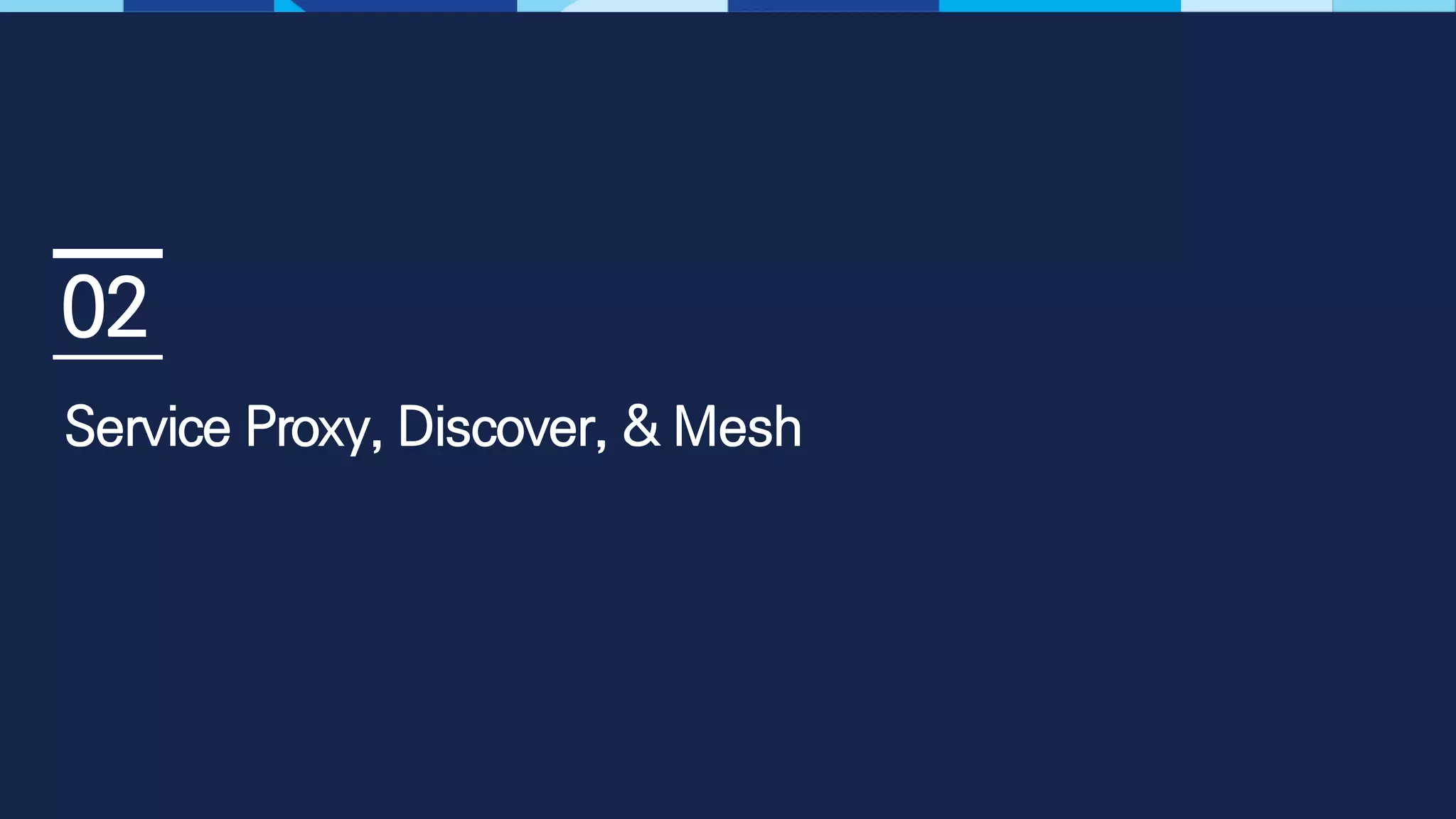

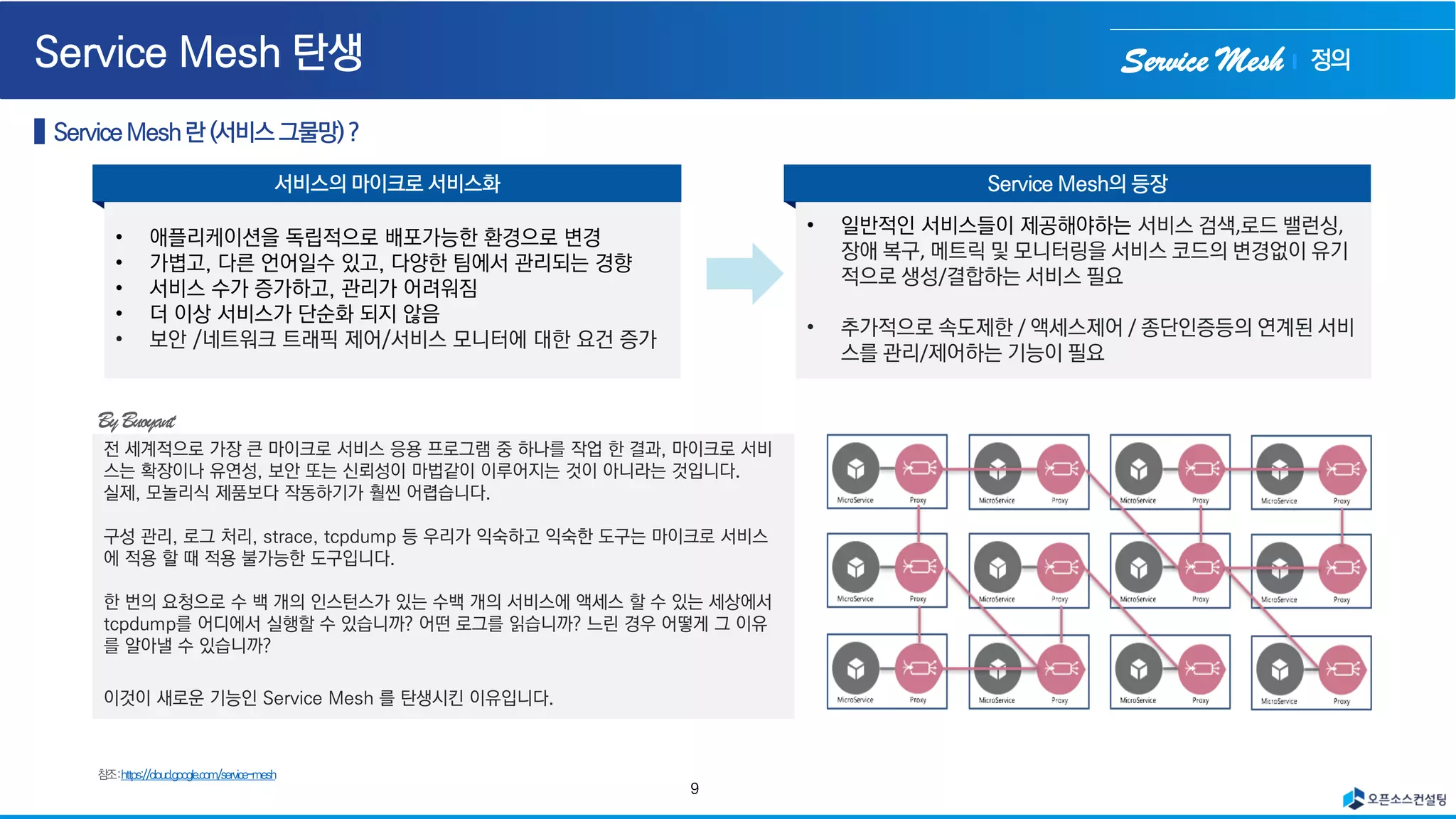

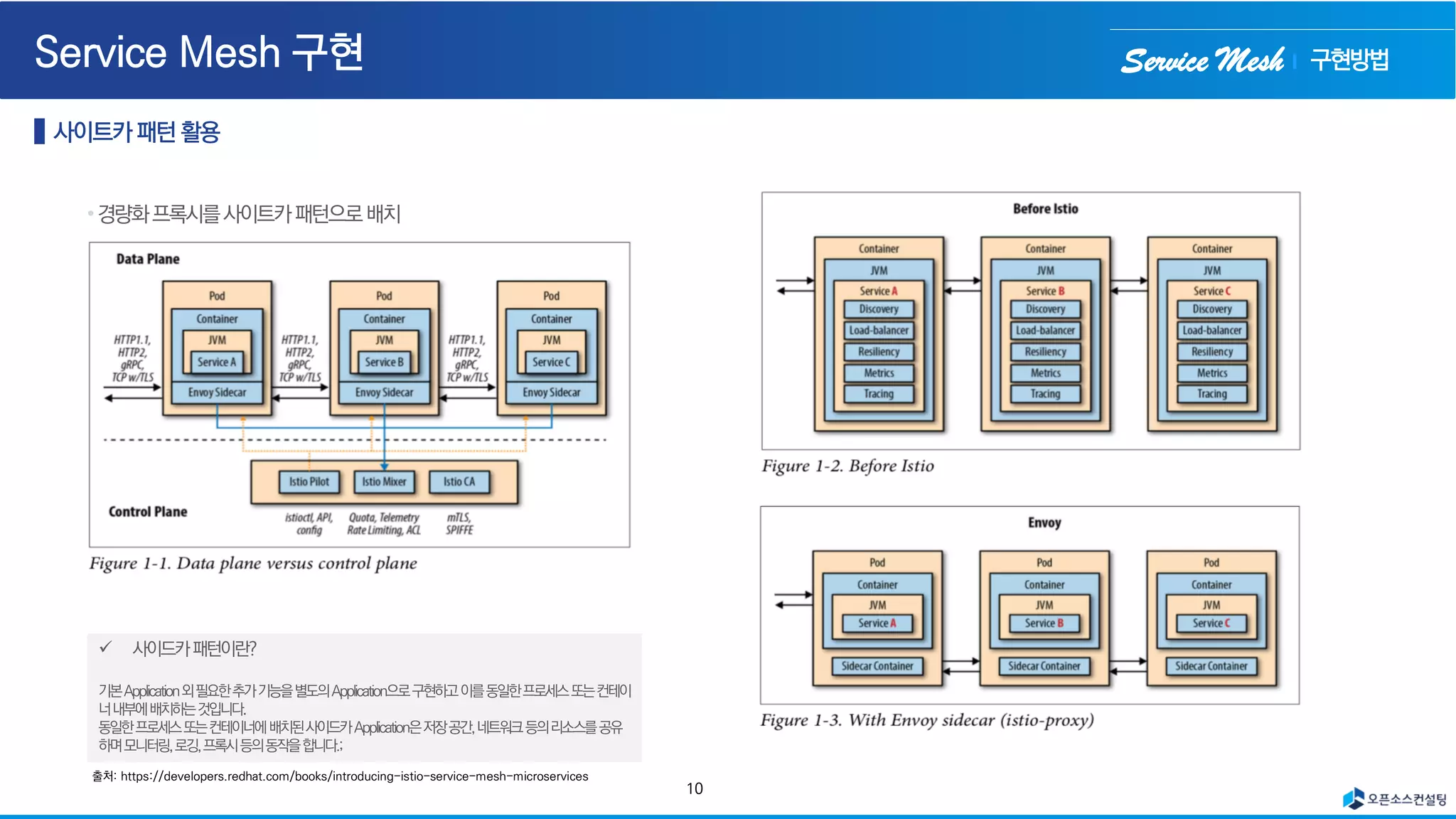

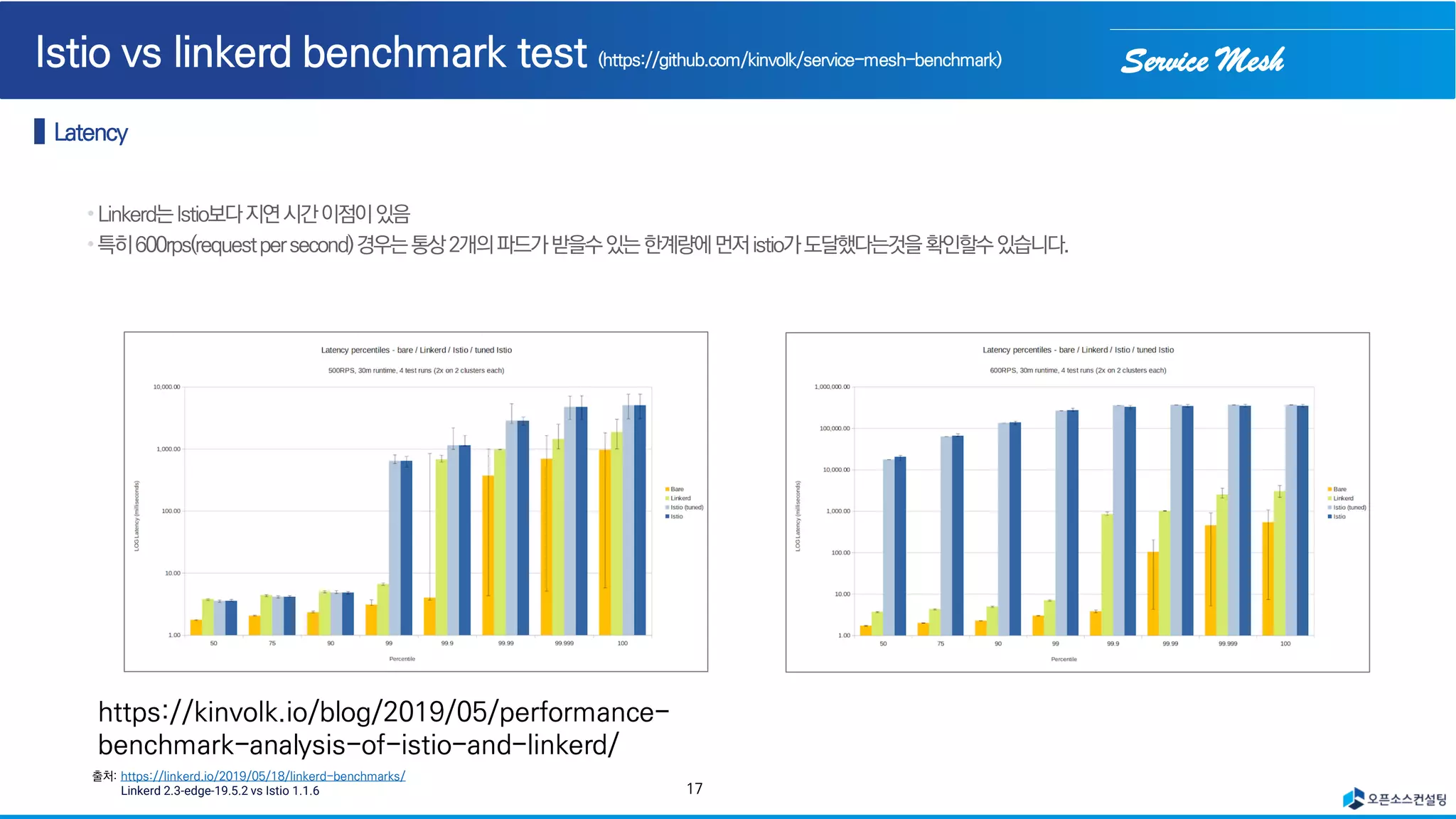

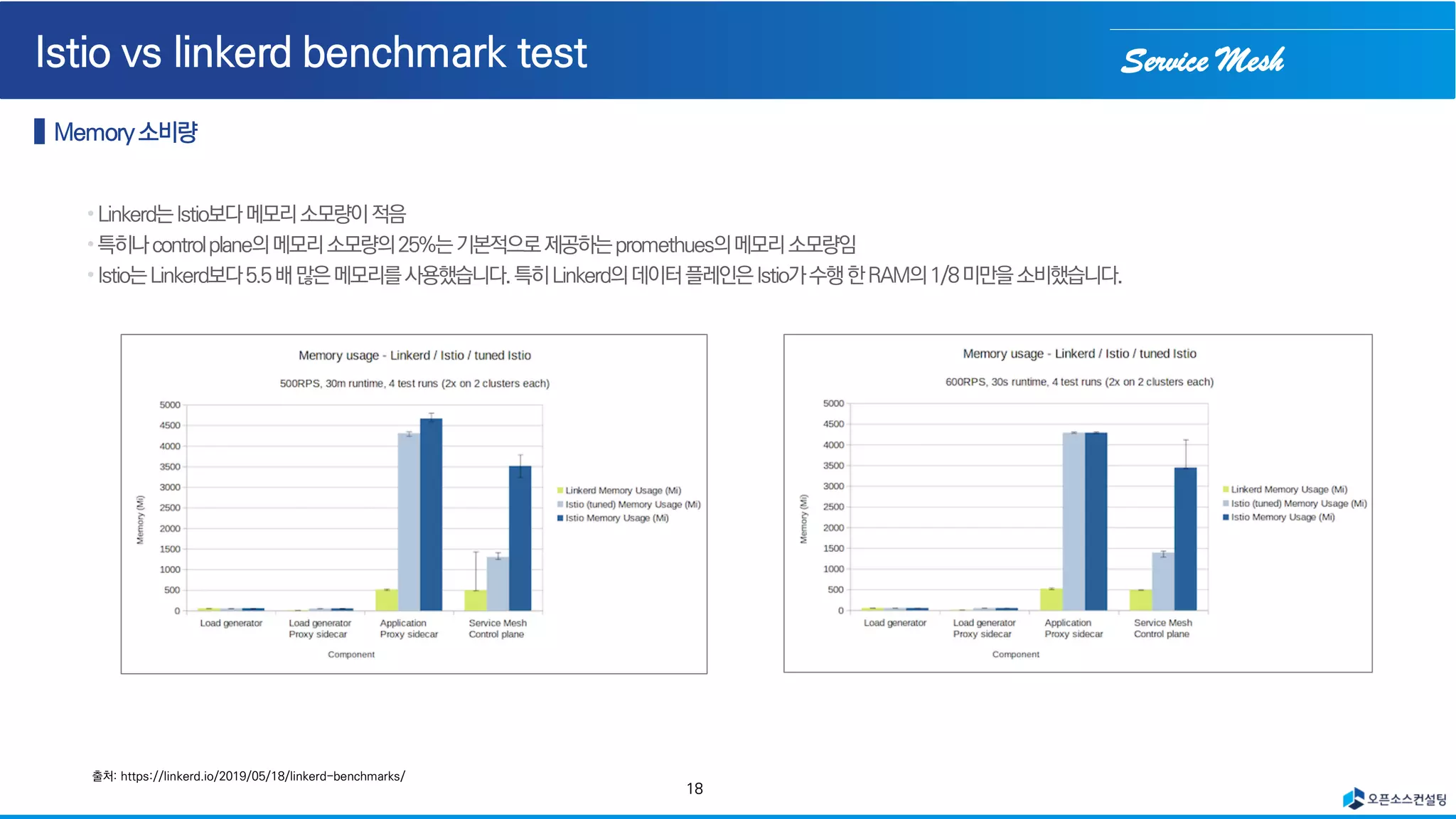

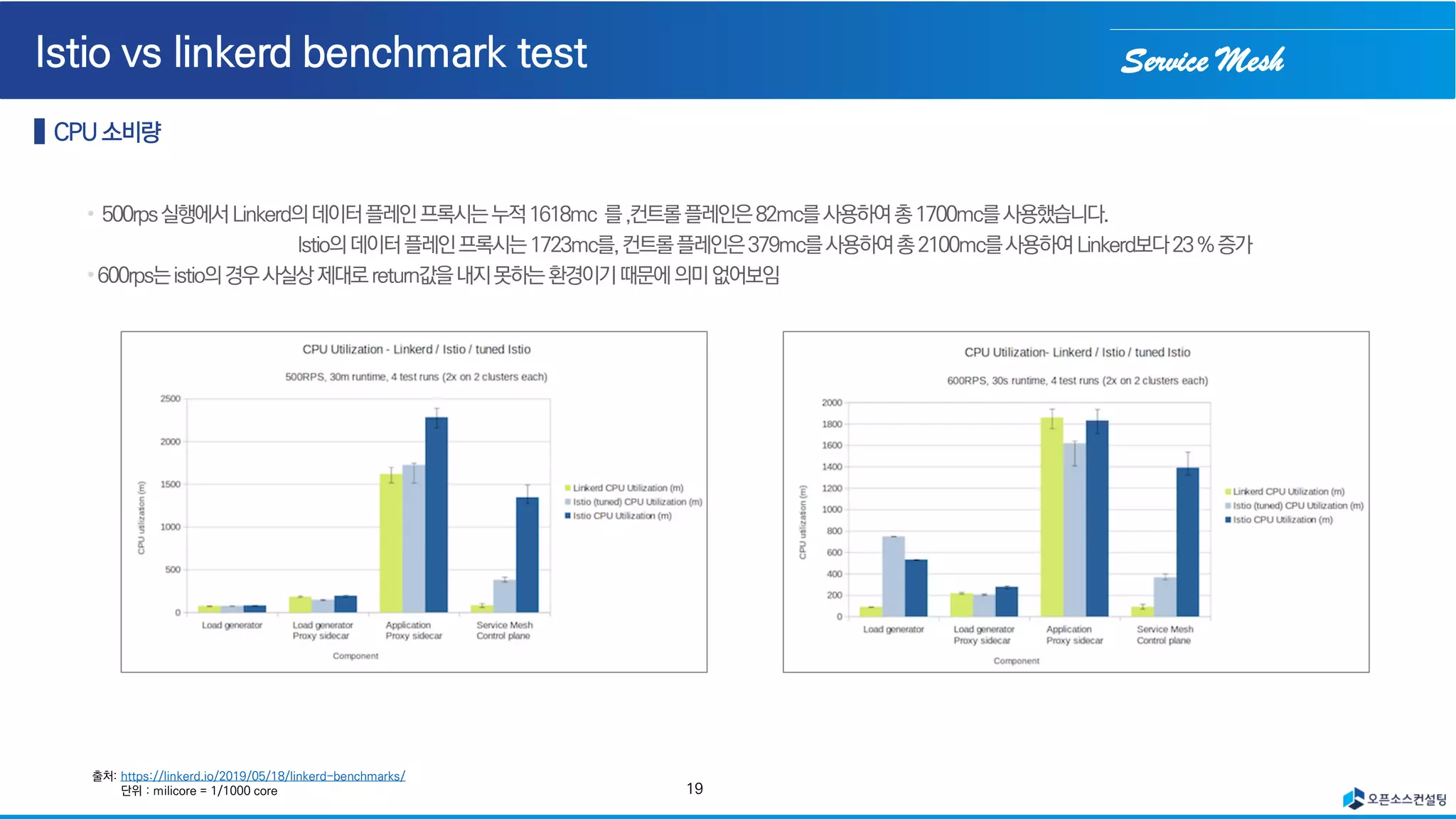

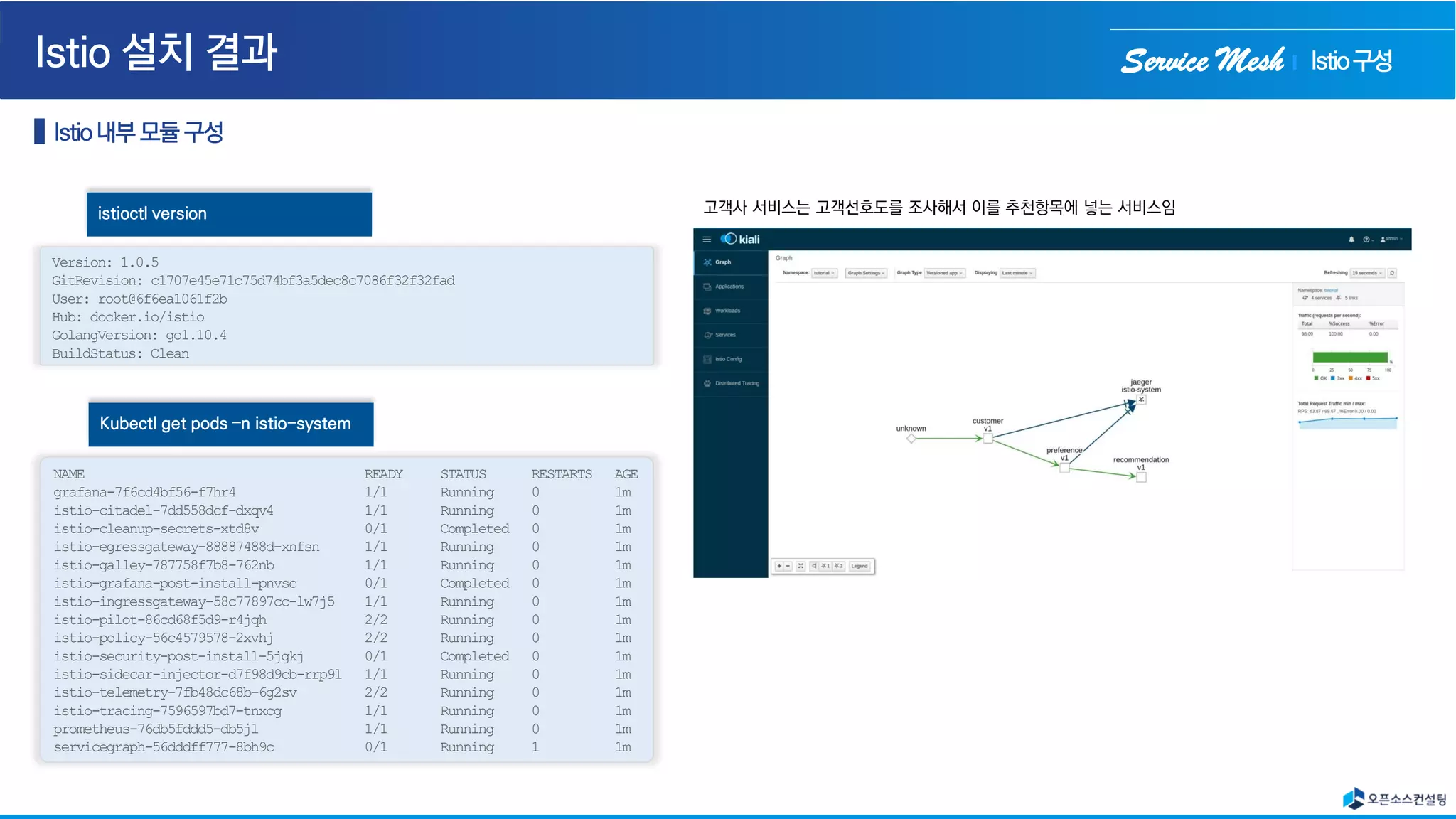

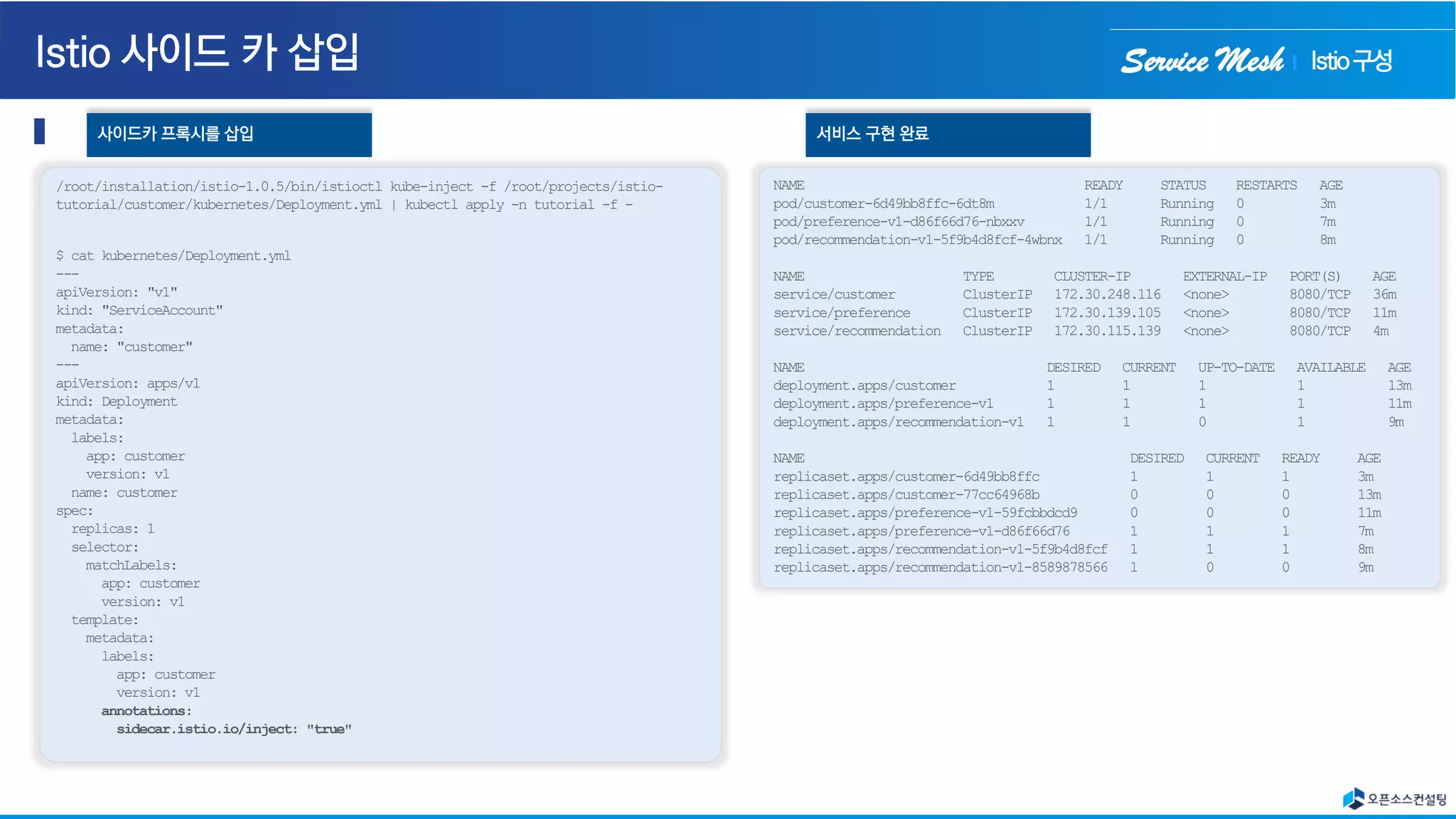

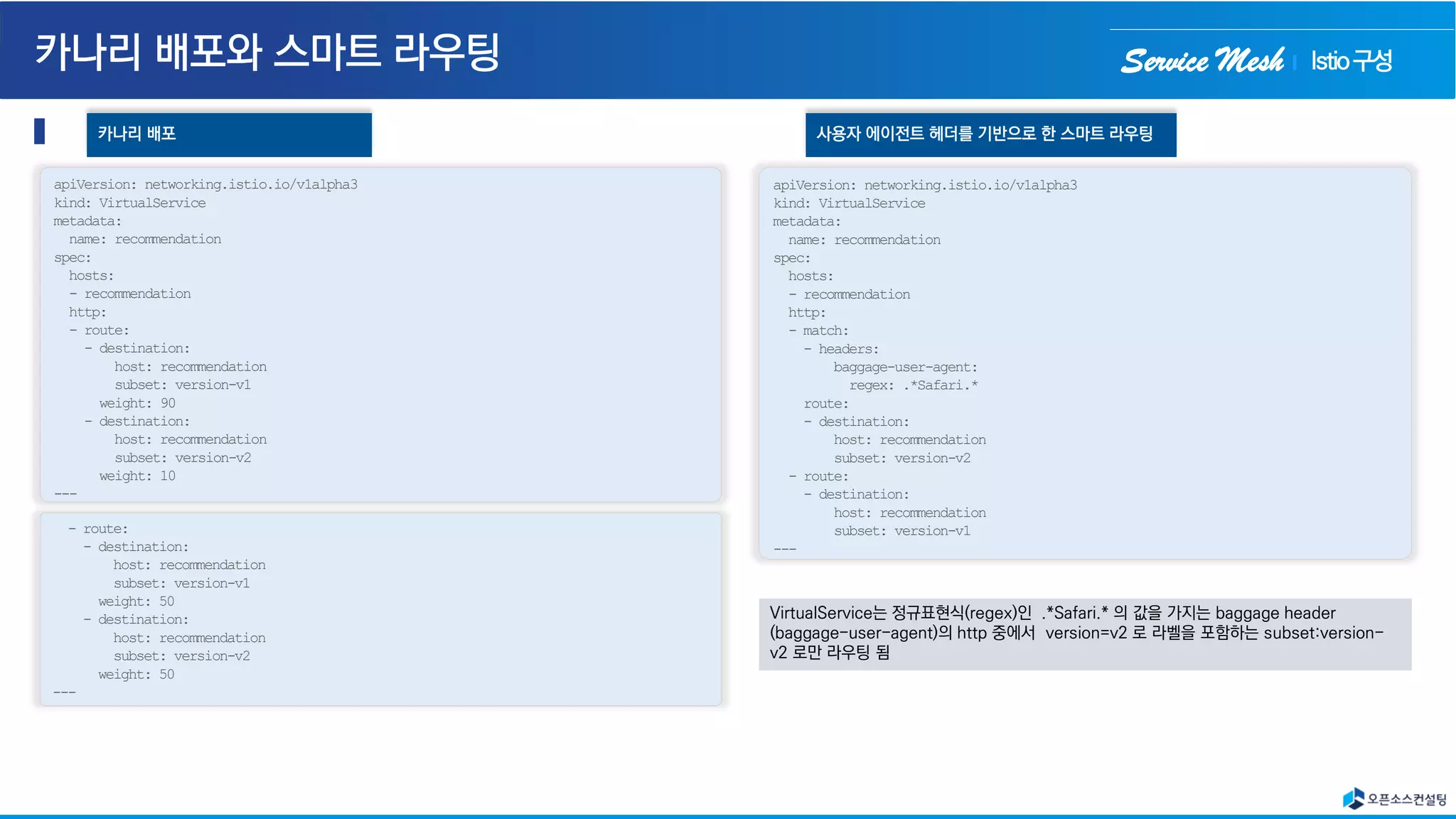

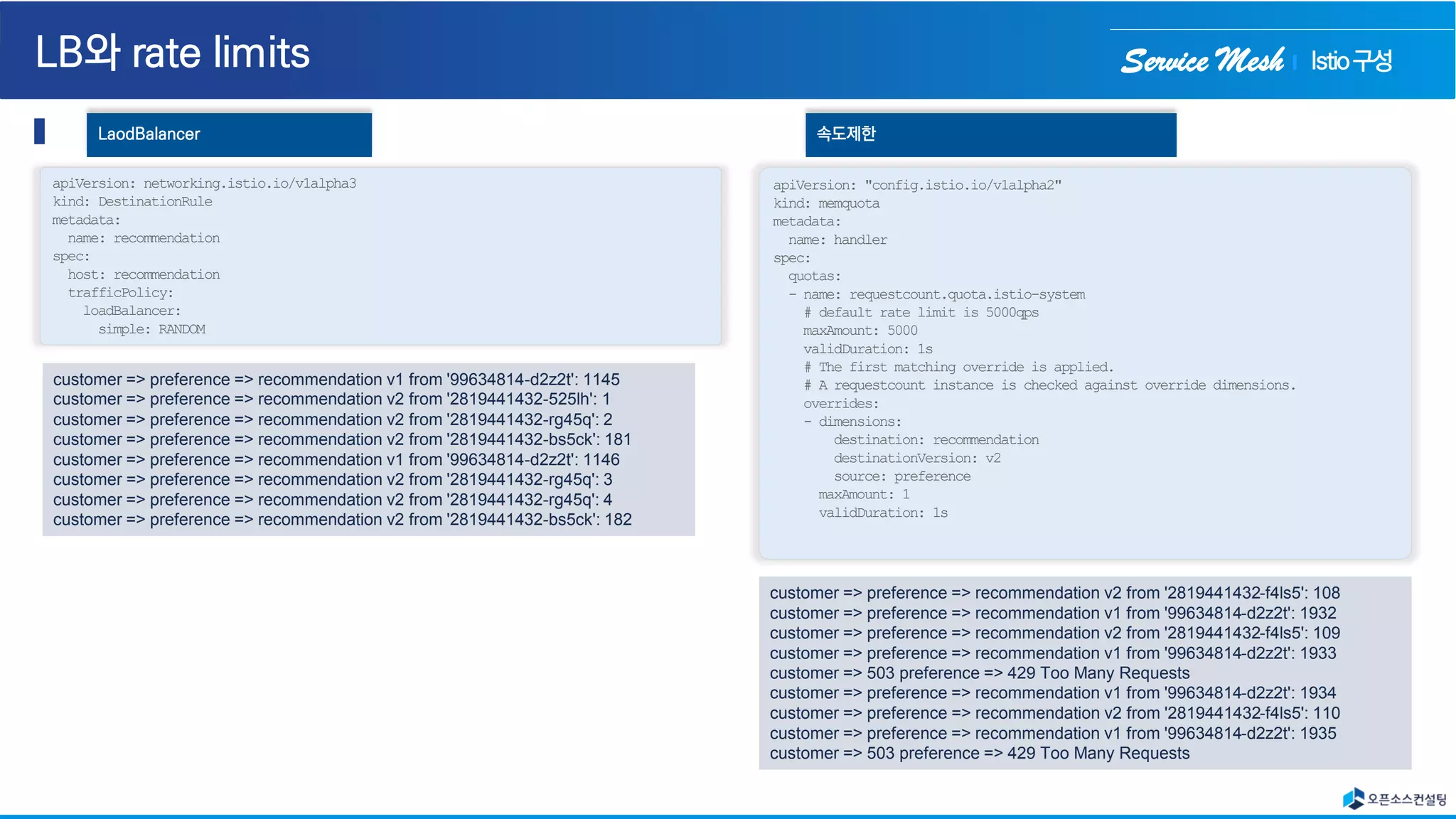

The document discusses the implementation and benefits of service meshes, with a focus on tools like Istio and Linkerd for managing microservices in cloud environments. It outlines critical features such as service discovery, traffic management, security, and observability, which enhance application performance and resilience. The content also compares various service mesh solutions and highlights the complexities of managing microservices effectively.

![Service Mesh

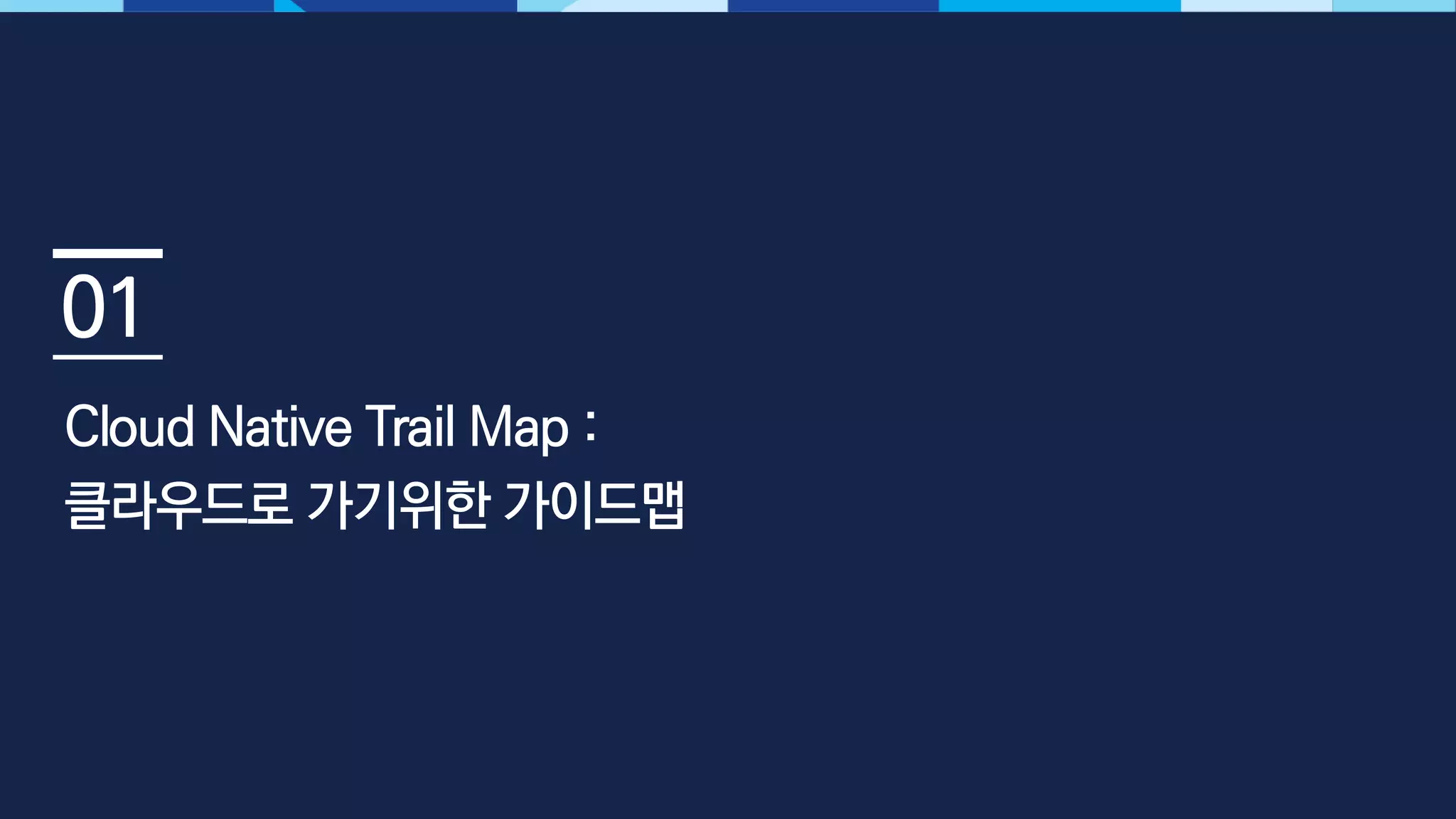

[INFO] Scanning for projects...

[INFO] ----------------< com.redhat.developer.demos:customer >-----------------

[INFO] Building customer 0.0.1-SNAPSHOT

[INFO] --------------------------------[ jar ]---------------------------------

[INFO] --- maven-jar-plugin:2.4:jar (default-jar) @ customer ---

[INFO] Building jar: /root/projects/istio-

tutorial/customer/java/springboot/target/customer.jar

[INFO]

[INFO] --- spring-boot-maven-plugin:1.5.8.RELEASE:repackage (default) @ customer ---

[INFO] ------------------------------------------------------------------------

[INFO] BUILD SUCCESS

[INFO] ------------------------------------------------------------------------

[INFO] Total time: 12.337 s

[INFO] Finished at: 2021-05-16T01:04:25Z

[INFO] ------------------------------------------------------------------------

[INFO] --- maven-jar-plugin:2.4:jar (default-jar) @ customer ---

[INFO] Building jar: /root/projects/istio-

tutorial/customer/java/springboot/target/customer.jar

[INFO]

[INFO] --- spring-boot-maven-plugin:1.5.8.RELEASE:repackage (default) @ customer ---

[INFO] ------------------------------------------------------------------------

[INFO] BUILD SUCCESS

[INFO] ------------------------------------------------------------------------

[INFO] Total time: 12.337 s

[INFO] Finished at: 2021-05-16T01:04:25Z

[INFO] ------------------------------------------------------------------------

Springboot - mvn package

FROM fabric8/java-jboss-openjdk8-jdk:1.5.2

ENV JAVA_APP_DIR=/deployments

ENV JAEGER_SERVICE_NAME=customer

JAEGER_ENDPOINT=http://jaeger-collector.istio-system.svc:14268/api/traces

JAEGER_PROPAGATION=b3

JAEGER_SAMPLER_TYPE=const

JAEGER_SAMPLER_PARAM=1

EXPOSE 8080 8778 9779

COPY target/customer.jar /deployments/

Create Docker image

Sending build context to Docker daemon 23.29 MB

Step 1/5 : FROM fabric8/java-jboss-openjdk8-jdk:1.5.2

---> 2d81027cb149

Step 2/5 : ENV JAVA_APP_DIR /deployments

---> 46fc95691e7a

Step 3/5 : ENV JAEGER_SERVICE_NAME customer JAEGER_ENDPOINT http://jaeger-

collector.istio-system.svc:14268/api/traces JAEGER_PROPAGATION b3

JAEGER_SAMPLER_TYPE const JAEGER_SAMPLER_PARAM 1

---> 518b64a43cc9

Step 4/5 : EXPOSE 8080 8778 9779

---> 0000990f2810

Step 5/5 : COPY target/customer.jar /deployments/

---> 57d20b60ca5b

Successfully built 57d20b60ca5b

Docker build

Istio구성](https://image.slidesharecdn.com/opensourceconsultingservicemesh-210531074807/75/Service-mesh-22-2048.jpg)

![Service Mesh

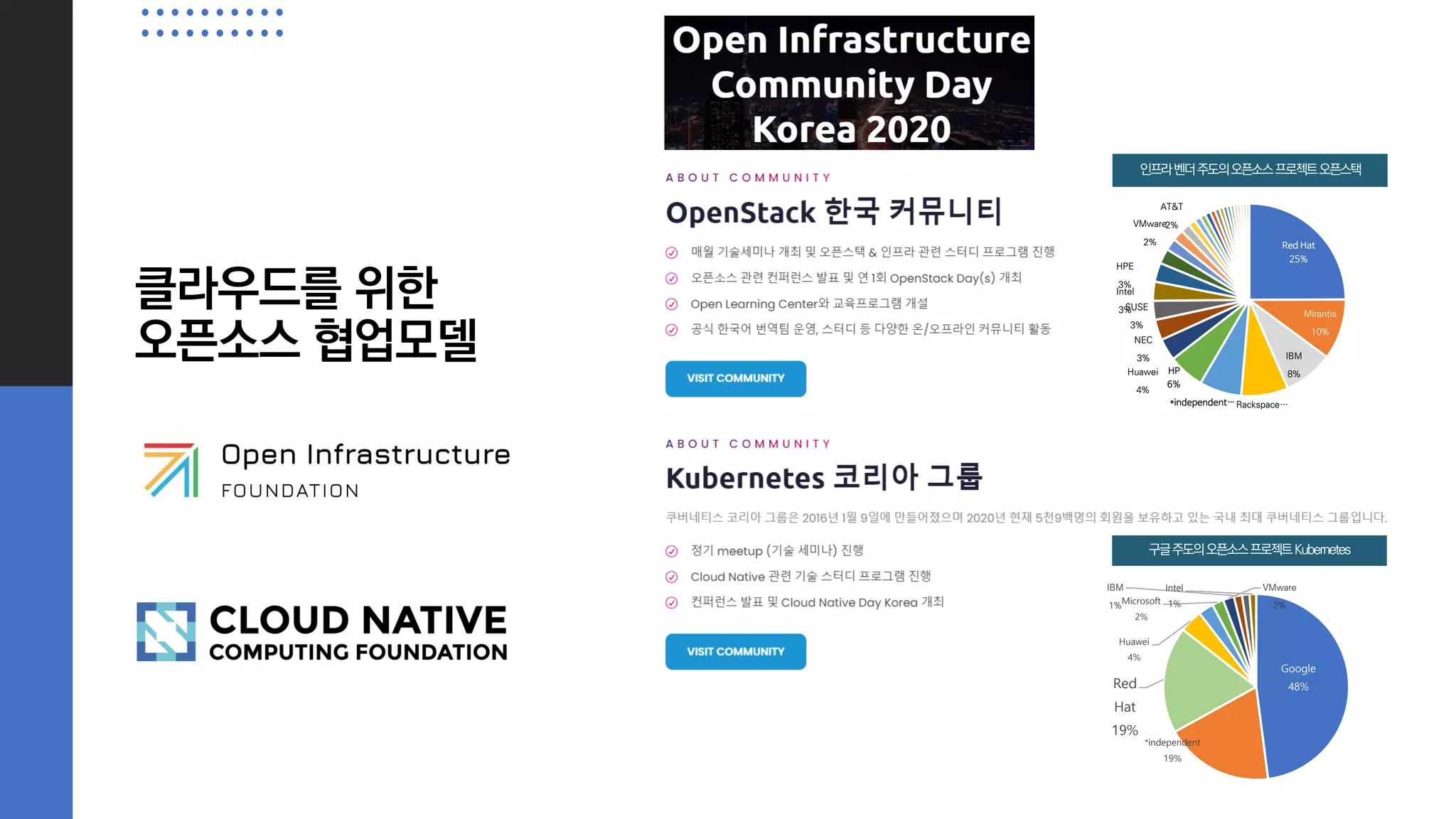

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: recommendation

spec:

host: recommendation

subsets:

- name: version-v2

labels:

version: v2

trafficPolicy:

connectionPool:

http:

http1MaxPendingRequests: 1

maxRequestsPerConnection: 1

tcp:

maxConnections: 1

outlierDetection:

baseEjectionTime: 120.000s

consecutiveErrors: 1

interval: 1.000s

maxEjectionPercent: 100

Circuit Breaker

name: recommendation

spec:

host: recommendation

subsets:

- labels:

version: v1

name: version-v1

trafficPolicy:

connectionPool:

http: {}

tcp: {}

loadBalancer:

simple: RANDOM

outlierDetection:

baseEjectionTime: 15.000s

consecutiveErrors: 1

interval: 5.000s

maxEjectionPercent: 100

- labels:

version: v2

name: version-v2

trafficPolicy:

connectionPool:

http: {}

tcp: {}

loadBalancer:

simple: RANDOM

outlierDetection:

baseEjectionTime: 15.000s

consecutiveErrors: 1

interval: 5.000s

maxEjectionPercent: 100

Pool ejection

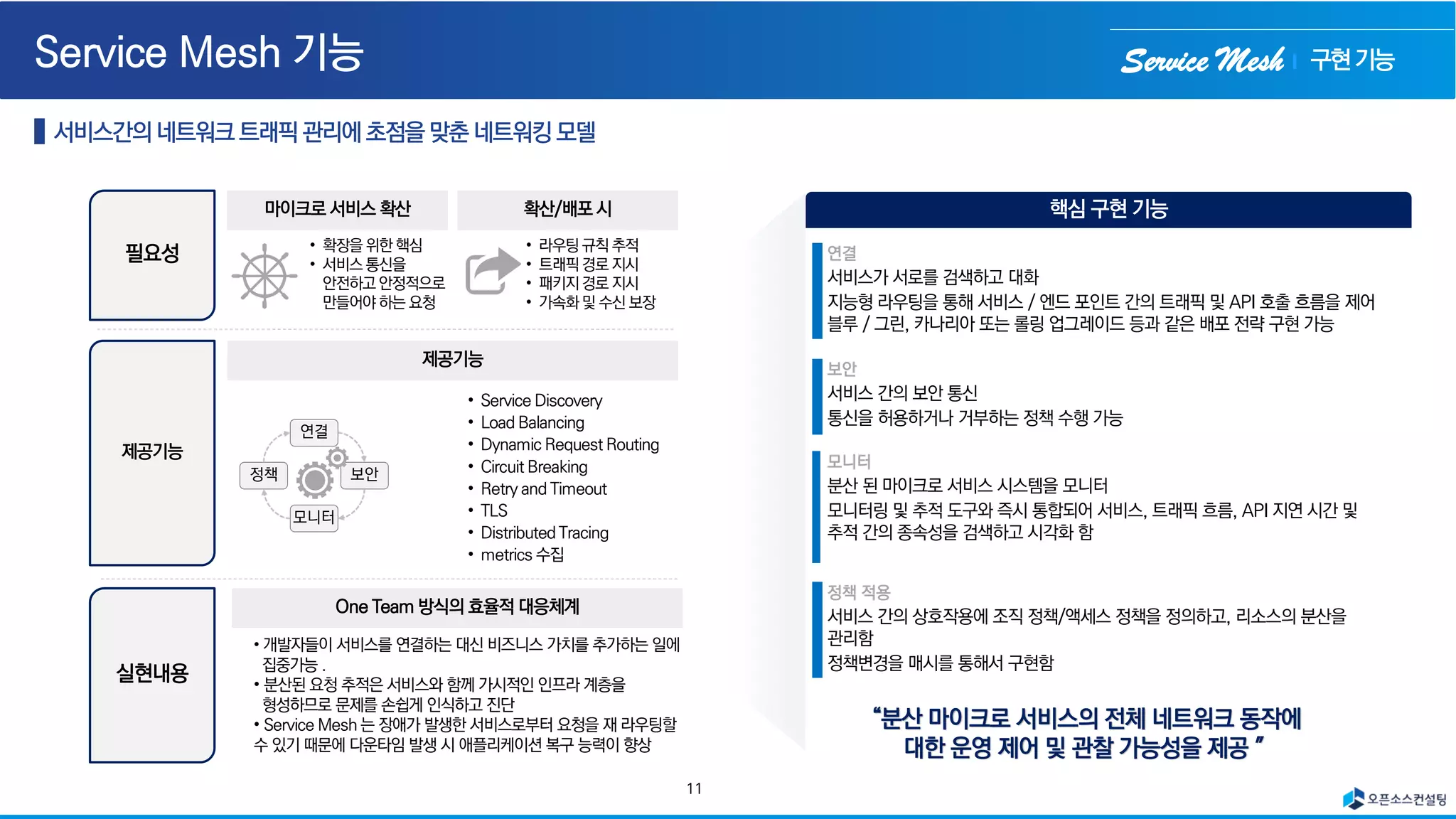

풀 제거 또는 이상 값 감지 (outlier detection)는 클라이언트 요청을 처리 할 인스턴스 /

포드 풀이있을 때마다 발생하는 탄력적 회복 전략

Connection pool에 요청사항에 따라서 1초마다 체크해서, 한번이라도 에러가 발생하면,

120초 동안 서비스에서 배제(circuit breaking) 시킴

→ [503 Service Unavailable] error 발생시킴

Istio구성](https://image.slidesharecdn.com/opensourceconsultingservicemesh-210531074807/75/Service-mesh-27-2048.jpg)

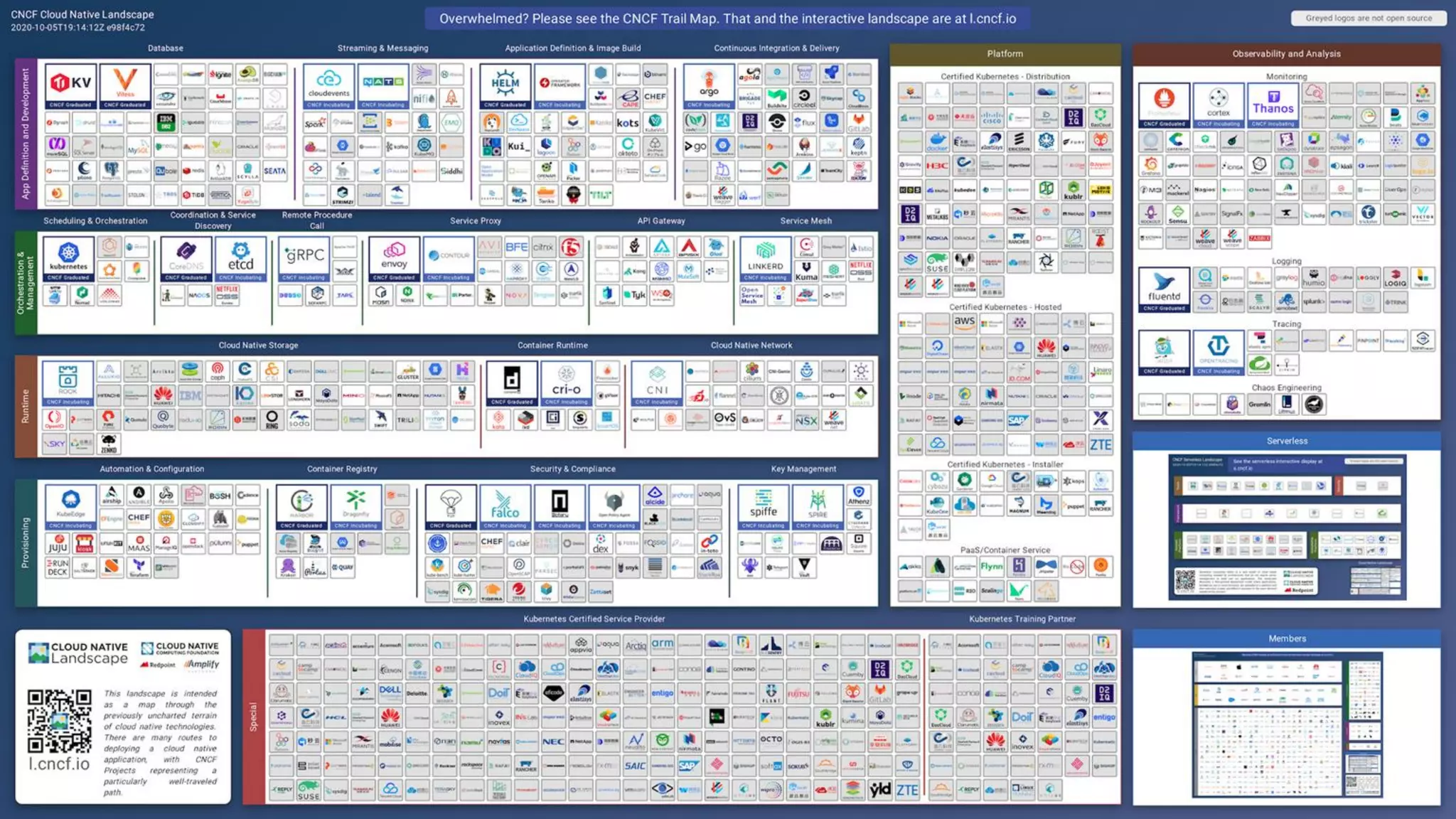

![Service Mesh

Ultimate resilience with retries, circuit breaker, and pool ejection

name: recommendation

spec:

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: recommendation

spec:

host: recommendation

subsets:

- name: version-v1

labels:

version: v1

- name: version-v2

labels:

version: v2

trafficPolicy:

connectionPool:

http:

http1MaxPendingRequests: 1

maxRequestsPerConnection: 1

tcp:

maxConnections: 1

outlierDetection:

baseEjectionTime: 120.000s

consecutiveErrors: 1

interval: 1.000s

maxEjectionPercent: 100

• 인스턴스에 대한 여러 동시 요청을 방지하는 회로 차단기

• 인스턴스를 응답의 풀을 이용하여, 실패하는 인스턴스 pool rejection

• 개방 회로 차단기 및 / 또는 풀 방출이 발생하는 경우를 대비하여 요청을 다른

인스턴스로 전달하기 위해 재 시도

mTLS

apiVersion: "authentication.istio.io/v1alpha1"

kind: "Policy"

metadata:

name: "default"

spec:

peers:

- mtls: {}

-------------------

apiVersion: "networking.istio.io/v1alpha3"

kind: "DestinationRule"

metadata:

name: "default"

spec:

host: "*.tutorial.svc.cluster.local"

trafficPolicy:

tls:

mode: ISTIO_MUTUAL

• host: 0192.168.64.70:31380 user-agent: curl/7.54.0 accept: */* x-forwarded-for:

172.17.0.1 x-forwarded-proto: http x-envoy-internal: true x-request-id: e5c0b90f-

341b-9edc-ac3e-7dd8b33f0e8b x-envoy-decorator-operation:

customer.tutorial.svc.cluster.local:8080/ x-b3-traceid: ce289e960a639d11 x-b3-

spanid: ce289e960a639d11 x-b3-sampled: 1

• 14:24:55.078222 IP (tos 0x0, ttl 64, id 32578, offset 0, flags [DF], proto TCP (6),

length 967) 172.17.0.15.33260 > customer-7dcd544ff9-652ds.8080: Flags [P.],

cksum 0x5bf5 (incorrect -> 0x595e), seq 2211080917:2211081832, ack

2232186801, win 391, options [nop,nop,TS val 5958433 ecr 5779275], length 915:

HTTP E....B@.@._........ ......j...w.....[......

Istio구성](https://image.slidesharecdn.com/opensourceconsultingservicemesh-210531074807/75/Service-mesh-28-2048.jpg)

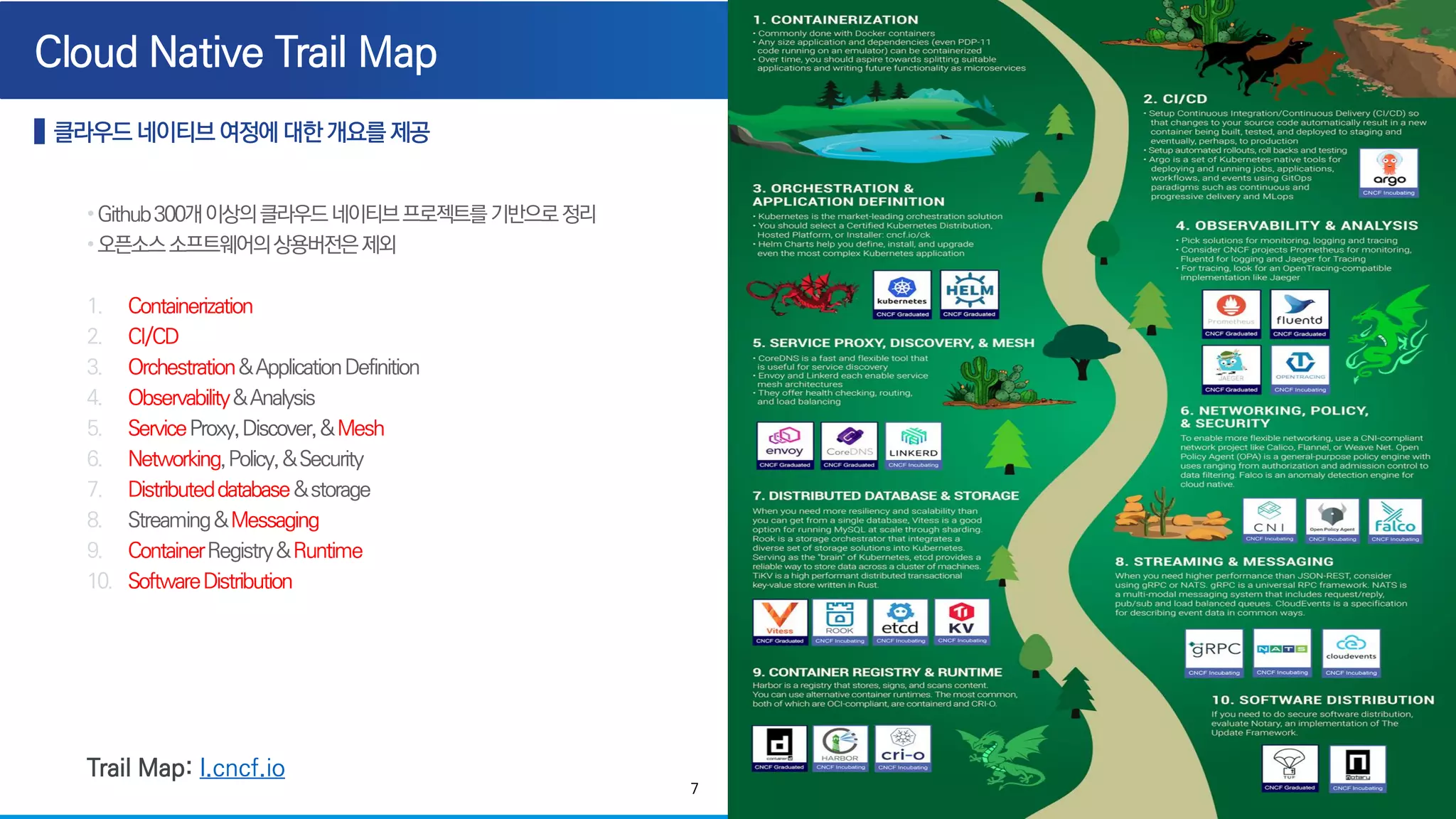

![Service Mesh

istioctl create -f istiofiles/recommendation_requestcount.yml -n istio-system

apiVersion: "config.istio.io/v1alpha2"

kind: metric

metadata:

name: recommendationrequestcount

spec:

value: "1"

dimensions:

user_agent: request.headers["user-agent"] | "unknown"

monitored_resource_type: '"UNSPECIFIED"'

---

apiVersion: "config.istio.io/v1alpha2"

kind: prometheus

metadata:

name: recommendationrequestcounthandler

spec:

metrics:

- name: recommendation_request_count

instance_name: recommendationrequestcount.metric.istio-system

kind: COUNTER

---

apiVersion: "config.istio.io/v1alpha2"

kind: rule

metadata:

name: recommendationrequestcountprom

spec:

match: destination.service == "recommendation.tutorial.svc.cluster.local"

actions:

- handler: recommendationrequestcounthandler.prometheus

instances:

- recommendationrequestcount.metric

사용자 지정 메트릭

Prometheus-1

• Recommend에대한

전체요청수에대한정보

Istio구성](https://image.slidesharecdn.com/opensourceconsultingservicemesh-210531074807/75/Service-mesh-33-2048.jpg)

![Service Mesh

spec:

routes:

- name: GET /api/annotations

condition:

method: GET

pathRegex: /api/annotations

isRetryable: true ### ADD THIS LINE ###

Retry

spec:

routes:

- condition:

method: HEAD

pathRegex: /authors/[^/]*.json

name: HEAD /authors/{id}.json

timeout: 300ms

Timeout

linkerd구성](https://image.slidesharecdn.com/opensourceconsultingservicemesh-210531074807/75/Service-mesh-42-2048.jpg)