Recommended

PDF

Cloudera Impalaをサービスに組み込むときに苦労した話

PDF

スキーマレスカラムナフォーマット「Yosegi」で実現する スキーマの柔軟性と処理性能を両立したログ収集システム / Hadoop / Spark Con...

PDF

Aerospike deep dive migration

PDF

Oracle Cloudで始める、DBエンジニアのためのHadoop超入門(db tech showcase 2016 Oracle セッション資料)

PDF

SQL on Hadoop 比較検証 【2014月11日における検証レポート】

PDF

PDF

PPTX

PDF

20190314 PGStrom Arrow_Fdw

PDF

PDF

Impalaチューニングポイントベストプラクティス

PDF

PPTX

Hadoop -ResourceManager HAの仕組み-

PDF

[db tech showcase Tokyo 2016] C32: 世界一速いPostgreSQLを目指せ!インメモリカラムナの実現 by 富士通株式会...

PPTX

PDF

PDF

PDF

ビッグデータ活用を加速する!分散SQLエンジン Spark SQL のご紹介 20161105 OSC Tokyo Fall

PDF

[db tech showcase Tokyo 2016] B31: Spark Summit 2016@SFに参加してきたので最新事例などを紹介しつつデ...

PDF

Riak / Riak-CS(Enterprise版) ベンチマークしました

PPTX

Gcpug tokyo february 2016

PDF

[db tech showcase Tokyo 2016] A35: NVMe徹底検証 by 株式会社インサイトテクノロジー 平間 大輔

PDF

PDF

Hadoop Conference Japan_2016 セッション「顧客事例から学んだ、 エンタープライズでの "マジな"Hadoop導入の勘所」

PDF

2017年5月26日 オープンソースデータベース比較セミナー「NoSQLとしても使えるMySQLとMySQL Cluster」

PDF

PPTX

[db tech showcase Tokyo 2017] B26: レデータの仮想化と自動化がもたらす開発効率アップとは?by 株式会社インサイトテクノ...

PPTX

PDF

Integration of Hive and HBase

PDF

More Related Content

PDF

Cloudera Impalaをサービスに組み込むときに苦労した話

PDF

スキーマレスカラムナフォーマット「Yosegi」で実現する スキーマの柔軟性と処理性能を両立したログ収集システム / Hadoop / Spark Con...

PDF

Aerospike deep dive migration

PDF

Oracle Cloudで始める、DBエンジニアのためのHadoop超入門(db tech showcase 2016 Oracle セッション資料)

PDF

SQL on Hadoop 比較検証 【2014月11日における検証レポート】

PDF

PDF

PPTX

What's hot

PDF

20190314 PGStrom Arrow_Fdw

PDF

PDF

Impalaチューニングポイントベストプラクティス

PDF

PPTX

Hadoop -ResourceManager HAの仕組み-

PDF

[db tech showcase Tokyo 2016] C32: 世界一速いPostgreSQLを目指せ!インメモリカラムナの実現 by 富士通株式会...

PPTX

PDF

PDF

PDF

ビッグデータ活用を加速する!分散SQLエンジン Spark SQL のご紹介 20161105 OSC Tokyo Fall

PDF

[db tech showcase Tokyo 2016] B31: Spark Summit 2016@SFに参加してきたので最新事例などを紹介しつつデ...

PDF

Riak / Riak-CS(Enterprise版) ベンチマークしました

PPTX

Gcpug tokyo february 2016

PDF

[db tech showcase Tokyo 2016] A35: NVMe徹底検証 by 株式会社インサイトテクノロジー 平間 大輔

PDF

PDF

Hadoop Conference Japan_2016 セッション「顧客事例から学んだ、 エンタープライズでの "マジな"Hadoop導入の勘所」

PDF

2017年5月26日 オープンソースデータベース比較セミナー「NoSQLとしても使えるMySQLとMySQL Cluster」

PDF

PPTX

[db tech showcase Tokyo 2017] B26: レデータの仮想化と自動化がもたらす開発効率アップとは?by 株式会社インサイトテクノ...

PPTX

Viewers also liked

PDF

Integration of Hive and HBase

PDF

PDF

PDF

Le Bizzarre Avventure Di JoJo - Purple Haze Feedback ENG

PDF

スタートアップ期におけるリーン×超高速開発手法について

PDF

Overview: Space Radiation Environment

PPT

Quimica en las redes sociales

PPTX

Teeth whitening top 10 tips.

PDF

มอค.3คณิตและสถิติในชีวิตประจำวัน ญาติกา

PDF

いまだからしっかり話しておきたい、ユーザーエクスペリエンス概論

PPTX

日経ITpro EXPO2015 ソラコム特別講演: IoTのキャズムを超える by CEO玉川

PDF

[Save themusicfoundation]

KEY

PPTX

Your style at powerpoint is dead

PDF

PDF

PPTX

R. Villano - Les photos (francais, p.7)

PDF

13 03 21 livre blanc islamophobie_rapport 2012

PDF

Sintesis informativa 21 de marzo 2017

DOCX

Similar to Hadoop conferencejapan2011

PPTX

PDF

PDF

HBaseを用いたグラフDB「Hornet」の設計と運用

PPTX

ビッグデータとioDriveの夕べ:ドリコムのデータ分析環境のお話

PPTX

PDF

Hadoopデータプラットフォーム #cwt2013

PDF

Amebaにおけるログ解析基盤Patriotの活用事例

PDF

サイバージェント 秋葉原ラボのHBase 活用事例

PDF

PDF

PDF

20141106_cwt-zenmyo-naito

PDF

Amazon Elastic MapReduceやSparkを中心とした社内の分析環境事例とTips

PPTX

Flumeを活用したAmebaにおける大規模ログ収集システム

PDF

PDF

内製パッケージによるHadoopデータ解析基盤の構築と運用

PPTX

Jenkinsとhadoopを利用した継続的データ解析環境の構築

PPTX

PPTX

ATN No.1 MapReduceだけでない!? Hadoopとその仲間たち

PPTX

Data Stream Processing and Analysis with Akka

KEY

NHN techcon-20120519-fujimoto

Hadoop conferencejapan2011 1. 2. 2

株式会社サイバーエージェント

自己紹介

名前 : 福田一郎 (フクダ イチロー)

所属 : 株式会社サイバーエージェント

アメーバ事業本部 プラットフォームディヴィジョン

コアテクノロジーグループ (新卒入社3年目)

(過去)

• Ameba Pigg運用,開発

(現在)

• ログ解析基盤 「Patriot」設計,開発,運用

【Twitter】 @toutou 【はてなID】 id:ICHIRO

3. 4. 5. 6. 7. 8. 9. 10. 11. 12. 13. 14. 15. 16. 17. 18. 19. 20. 21. 22. 22

株式会社サイバーエージェント

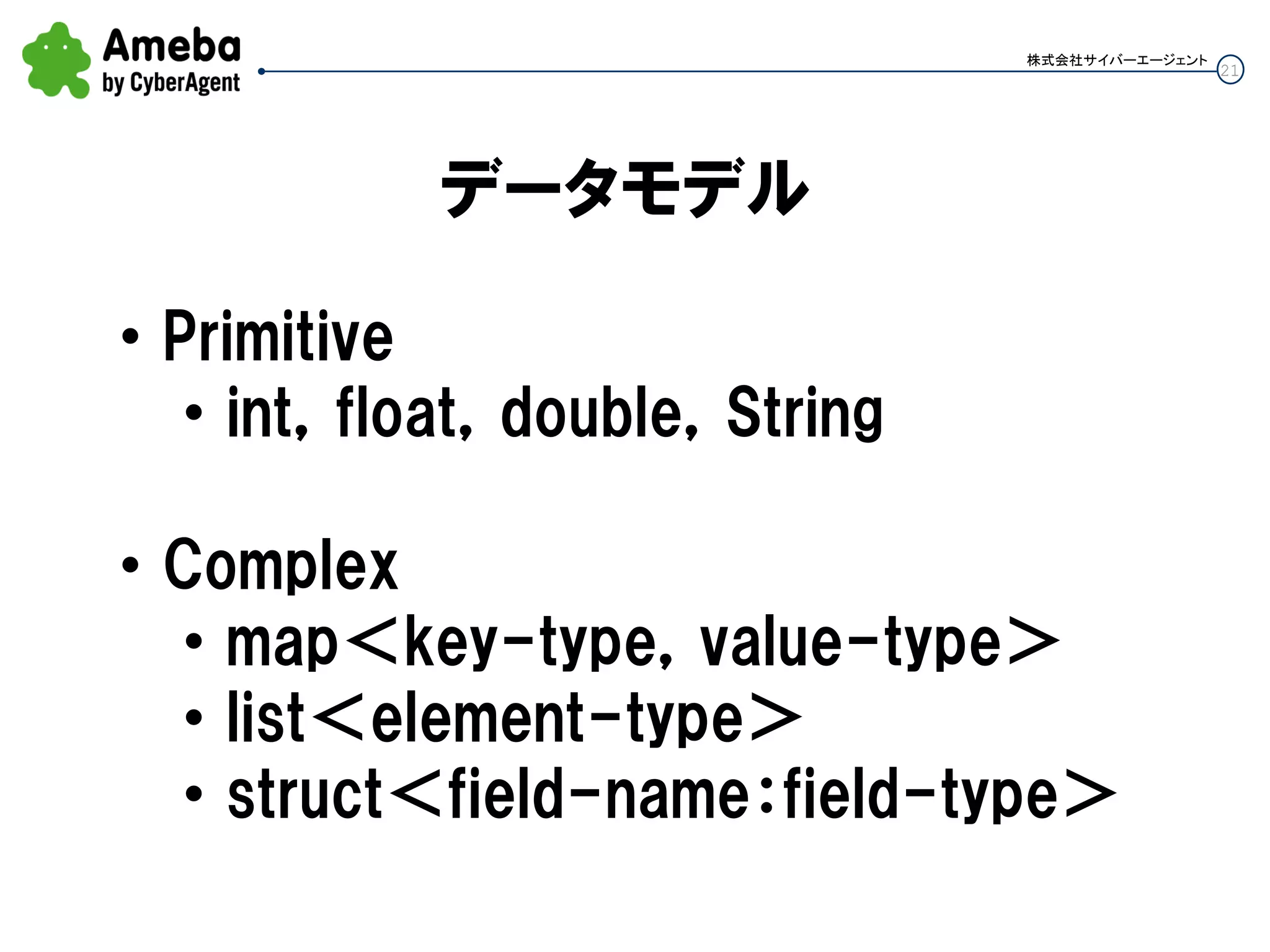

DDL

CREATE TABLE pigg_login

( time STRING, ameba_id STRING, ip STRING)

partitioned by(dt STRING)

ROW FORMAT DELIMITED FIELDS TERMINATED BY '¥t'

STORED AS SEQUENCEFILE;

カラムの区切り文字を指定

Partitionカラムを指定

ファイル形式を指定

• TextFile

• SequenceFile

• (RCFile)

23. 24. 25. 26. 27. 27

株式会社サイバーエージェント

SerDe(2)

【Apacheログ】

add jar 'hive_contrib.jar'

CREATE TABLE apachelog (host STRING, identity STRING, user STRING,

time STRING, method STRING, resource STRING,

proto STRING, status STRING, size STRING, referer STRING,

agent STRING, proctime STRING)

ROW FORMAT SERDE

'org.apache.hadoop.hive.contrib.serde2.RegexSerDe'

WITH SERDEPROPERTIES

("input.regex" = "^(.*?) (.*?) (.*?) ¥¥[(.*?)¥¥]

¥"(¥¥S+?)(?: +(.*?) +(¥¥S*?))?¥" (.*?) (.*?)

¥"(.*?)¥" ¥"(.*?)¥" (.*?)$",

"output.format.string" = "%1$s %2$s %3$s %4$s %5$s %6$s %7$s

%8$s %9$s %10$s %11$s %12$s");

28. 29. 30. 31. 32. 33. 34. 35. 36. 37. 37

株式会社サイバーエージェント

インポート処理 DSL(1)

import {

service "gyaos"

backup_dir "/data/log/gyaos"

data {

type "scp" ← その他に「mysql」,「hdfs」

servers ["172.xxx.yyy.zzz", " 172.xxx.yyy.zzz "]

user "cy_httpd"

path "/home/cy_httpd/logs/tomcat/lifelog/*.#{$dt}*"

limit 10000

}

(つづく)

38. 38

株式会社サイバーエージェント

インポート処理 DSL(2)

load {

type "hive" ← 「mysql」

table {

name "game_login"

regexp "^[^¥¥t]*¥¥t([^¥¥t]*)¥¥tlogin"

output "$1"

partition :dt => "#{$dt}", :service => "gyaos"

}

table {

name "game_user"

regexp "^([^¥¥t]*)¥¥t([^¥¥t]*)¥¥tregist_game"

output "$2¥t$1"

partition :dt => "#{$dt}", :service => "gyaos"

}}}

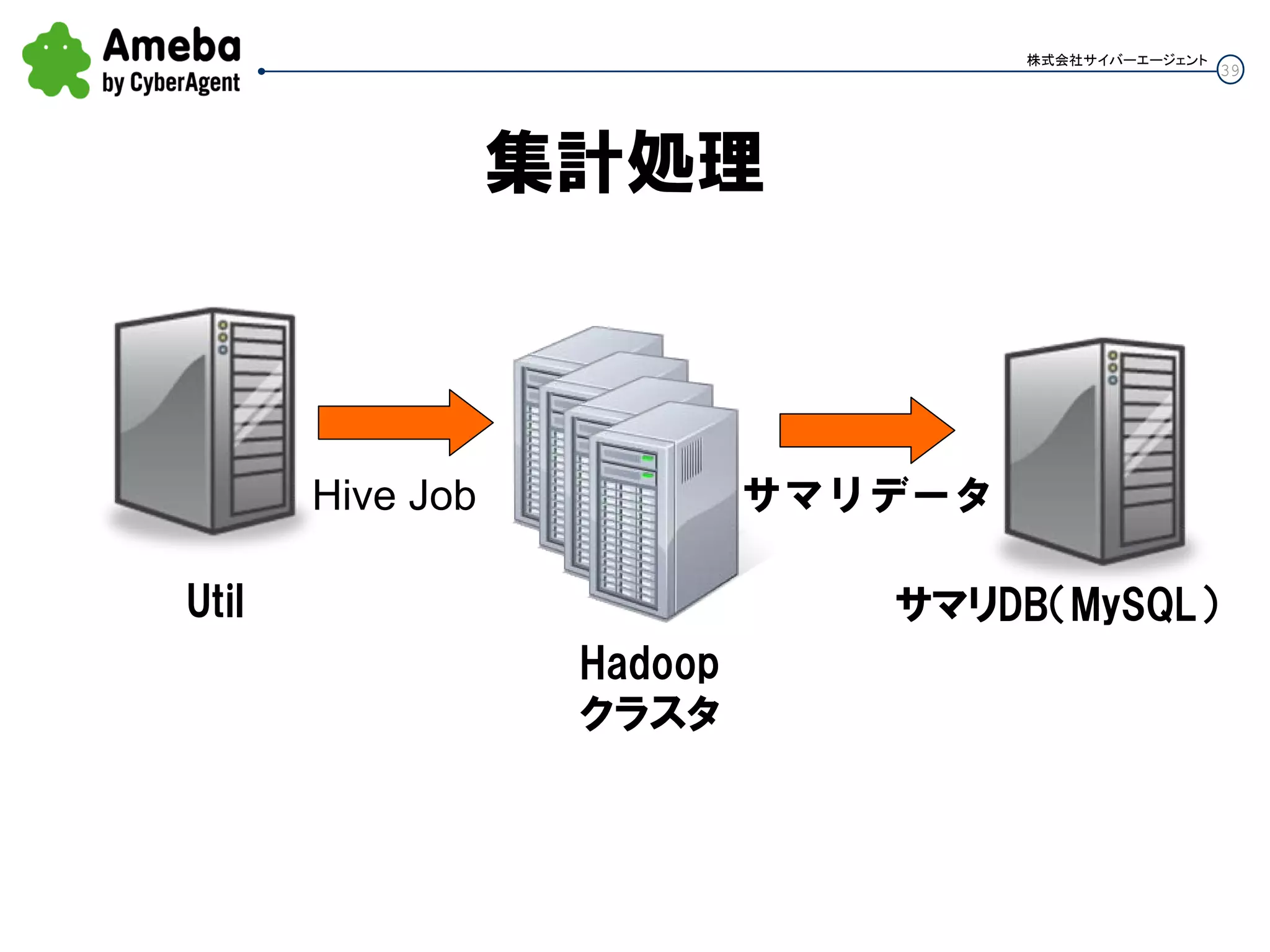

39. 40. 40

株式会社サイバーエージェント

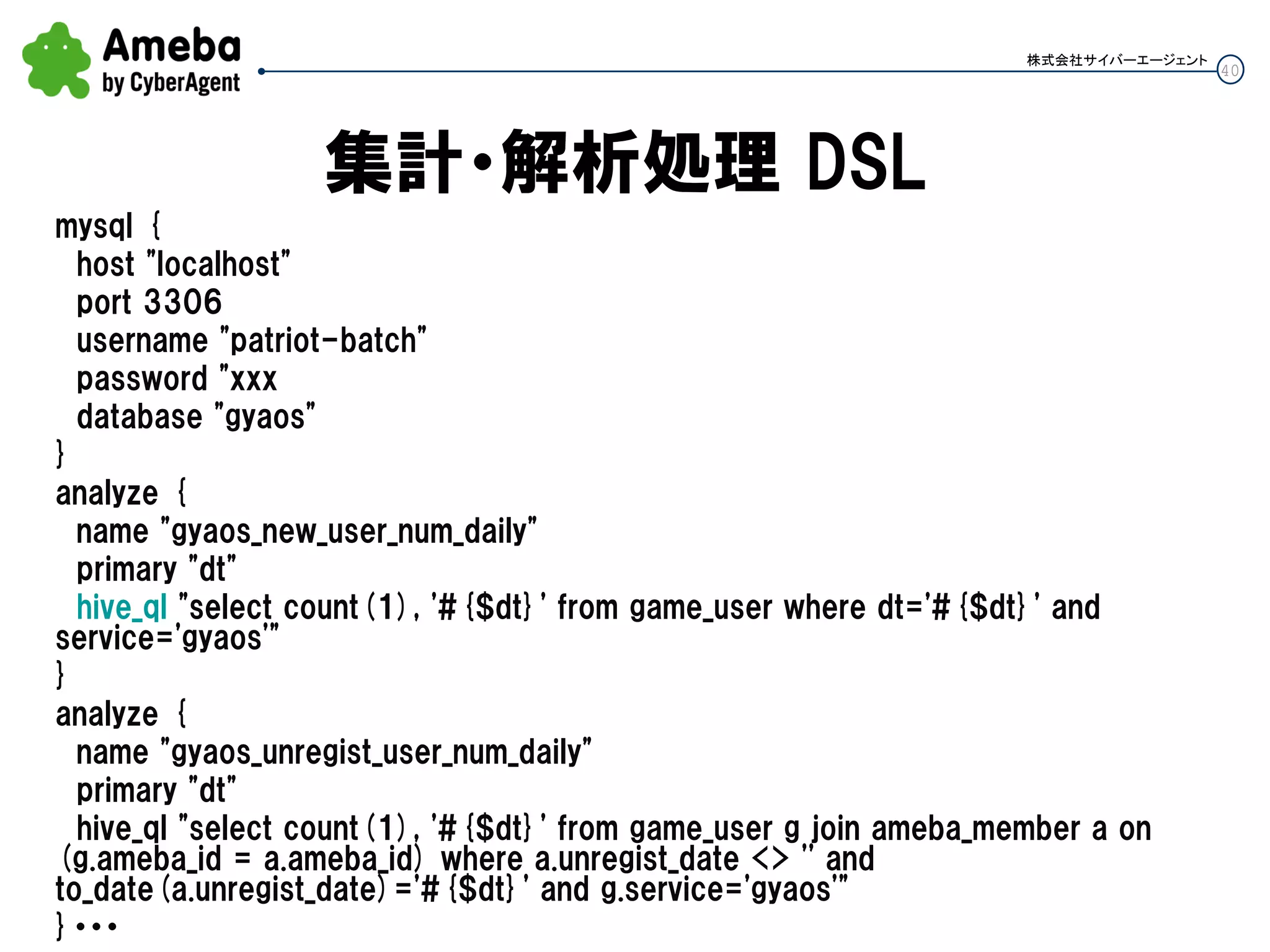

集計・解析処理 DSL

mysql {

host "localhost"

port 3306

username "patriot-batch"

password "xxx

database "gyaos"

}

analyze {

name "gyaos_new_user_num_daily"

primary "dt"

hive_ql "select count(1), '#{$dt}' from game_user where dt='#{$dt}' and

service='gyaos'"

}

analyze {

name "gyaos_unregist_user_num_daily"

primary "dt"

hive_ql "select count(1), '#{$dt}' from game_user g join ameba_member a on

(g.ameba_id = a.ameba_id) where a.unregist_date <> '' and

to_date(a.unregist_date)='#{$dt}' and g.service='gyaos'"

}・・・

41. 42. 43. 44. 45. 46. 47. 48. 49. 50. 51. 52. 53. 54.

![5

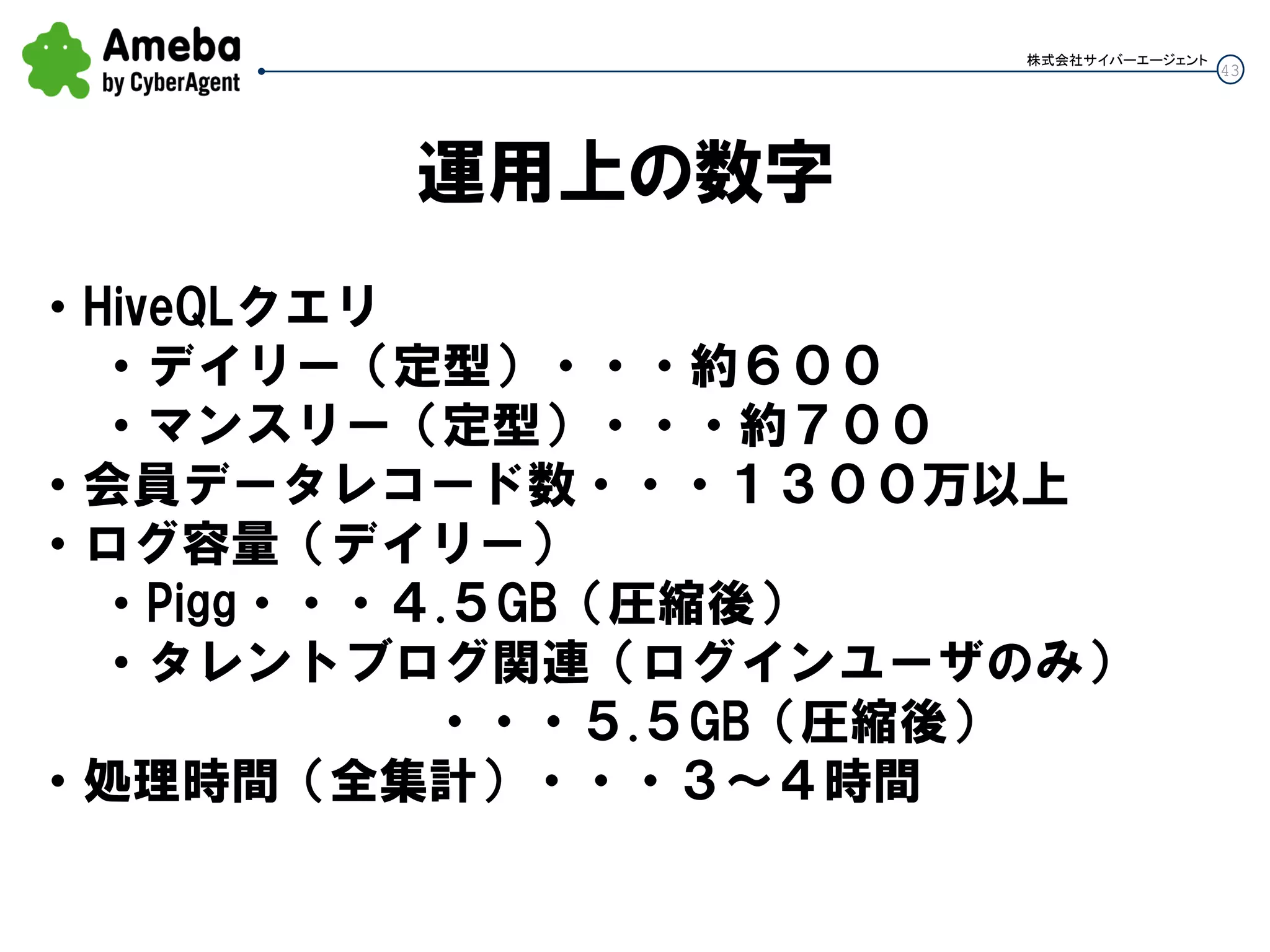

株式会社サイバーエージェント

サービス規模に関する数値

【Ameba全体】

[会員数] 1300万人 (2011/1/5時点)

[PV数] (2010年12月時点)

合計:194.9億PV (2011年1月で200億PV突破)

PC : 99.9億PV

MB : 95.0億PV

(スマートフォンUU : 367万UU)

【アメーバPigg】

[会員数] 600万人 (2011/1/14時点)

[ARPPU] ¥2,121 (2010年12月時点)](https://image.slidesharecdn.com/hadoopconferencejapan2011-110222063021-phpapp01/75/Hadoop-conferencejapan2011-5-2048.jpg)

![12

株式会社サイバーエージェント

Patriot開発までの経緯

[2009年]

11月13日 Hadoop Conference Japan 2009

ー CDH,Hiveなどを知る

11月21日~23日 開発合宿@伊豆高原

ー 統合ログ解析基盤が必要という結論に至る

11月27日 局長に相談 → 即GOサイン

[2010年]

3月末 本格検証開始

7月 第1弾リリース,11月 WebUIを中心にリニューアル](https://image.slidesharecdn.com/hadoopconferencejapan2011-110222063021-phpapp01/75/Hadoop-conferencejapan2011-12-2048.jpg)

![26

株式会社サイバーエージェント

SerDe(1)

• Serialization/Deserialization

• カラムの区切り文字などを定義

CREATE TABLE test(c1 string, c2 int)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY '¥t'

LINES TERMINATED BY '¥n';

ichiro[tab]16

suzuki[tab]51

c1

ichiro

suzuki

c2

16

51](https://image.slidesharecdn.com/hadoopconferencejapan2011-110222063021-phpapp01/75/Hadoop-conferencejapan2011-26-2048.jpg)

![27

株式会社サイバーエージェント

SerDe(2)

【Apacheログ】

add jar 'hive_contrib.jar'

CREATE TABLE apachelog (host STRING, identity STRING, user STRING,

time STRING, method STRING, resource STRING,

proto STRING, status STRING, size STRING, referer STRING,

agent STRING, proctime STRING)

ROW FORMAT SERDE

'org.apache.hadoop.hive.contrib.serde2.RegexSerDe'

WITH SERDEPROPERTIES

("input.regex" = "^(.*?) (.*?) (.*?) ¥¥[(.*?)¥¥]

¥"(¥¥S+?)(?: +(.*?) +(¥¥S*?))?¥" (.*?) (.*?)

¥"(.*?)¥" ¥"(.*?)¥" (.*?)$",

"output.format.string" = "%1$s %2$s %3$s %4$s %5$s %6$s %7$s

%8$s %9$s %10$s %11$s %12$s");](https://image.slidesharecdn.com/hadoopconferencejapan2011-110222063021-phpapp01/75/Hadoop-conferencejapan2011-27-2048.jpg)

![37

株式会社サイバーエージェント

インポート処理 DSL(1)

import {

service "gyaos"

backup_dir "/data/log/gyaos"

data {

type "scp" ← その他に「mysql」,「hdfs」

servers ["172.xxx.yyy.zzz", " 172.xxx.yyy.zzz "]

user "cy_httpd"

path "/home/cy_httpd/logs/tomcat/lifelog/*.#{$dt}*"

limit 10000

}

(つづく)](https://image.slidesharecdn.com/hadoopconferencejapan2011-110222063021-phpapp01/75/Hadoop-conferencejapan2011-37-2048.jpg)

![38

株式会社サイバーエージェント

インポート処理 DSL(2)

load {

type "hive" ← 「mysql」

table {

name "game_login"

regexp "^[^¥¥t]*¥¥t([^¥¥t]*)¥¥tlogin"

output "$1"

partition :dt => "#{$dt}", :service => "gyaos"

}

table {

name "game_user"

regexp "^([^¥¥t]*)¥¥t([^¥¥t]*)¥¥tregist_game"

output "$2¥t$1"

partition :dt => "#{$dt}", :service => "gyaos"

}}}](https://image.slidesharecdn.com/hadoopconferencejapan2011-110222063021-phpapp01/75/Hadoop-conferencejapan2011-38-2048.jpg)