박상은, 권한철, 서양주 옮김 | 한빛미디어 | 26,000원

다양한 현실 세계 예제로 스파크 2의 진면목을 경험한다.

이 책은 독자에게 대량의 데이터셋을 가지고 스파크 2를 활용해 복잡한 분석과 머신러닝 학습을 실제로 해보는 생생한 느낌을 전달한다. 단순히 모델을 구축하고 평가하는 데 그치지 않고, 데이터 정제부터 전처리, 데이터 조사, 실제 제품을 만들기까지의 전체 파이프라인을 보여준다. 이러한 과정을 다양한 분야에서 가져온 현실 예제에 맞게 교차 최소 제곱 추천 알고리즘, 의사 결정 나무, K-평균 군집화, 숨은 의미 분석, 세션화, 몬테카를로 시뮬레이션 등의 기법을 동원해 풀어본다.

![332장 스칼라와 스파크를 활용한 데이터 분석

순되게도 이 문제가 다양한 이름으로 불리기 때문에 문제 해결을 위한 기술들을 훑어보고자 해

도 관련 논문조차 다 찾아내기 어렵다. 오히려 이 데이터 정제 문제에 대한 참고 문헌들에서 중

복 제거를 수행할 데이터 과학자가 필요한 처지다! 이 장의 목적을 원만히 이루기 위해 이제부

터 ‘같은 실체를 가리키는 레코드들을 연결 짓는’ 이 문제를 레코드 링크Record Linkage라 하겠다.

이 문제의 일반적인 형태는 다음과 같다. 하나 또는 그 이상의 데이터 출처로부터 데이터를 수

집하여 취합하면 그 속의 레코드 일부가 실제로는 같은 고객, 같은 환자, 같은 위치, 같은 행사

등 동일한 실체를 가리킬 수 있다. 각 실체는 이름, 주소, 생일과 같은 여러 속성을 가지고 있어

서 동일한 실체를 가리키는 레코드들을 찾아내려면 이 속성값을 이용해야 한다. 안타깝게도 이

속성값들은 불완전하다. 형식이 다르거나 오타가 있거나 값이 누락되었을 수 있다. 그러므로

단순하게 속성의 값이 같은지만을 검사한다면 상당수의 중복 레코드를 놓치게 될 것이다. [표

2-1]을 살펴보자.

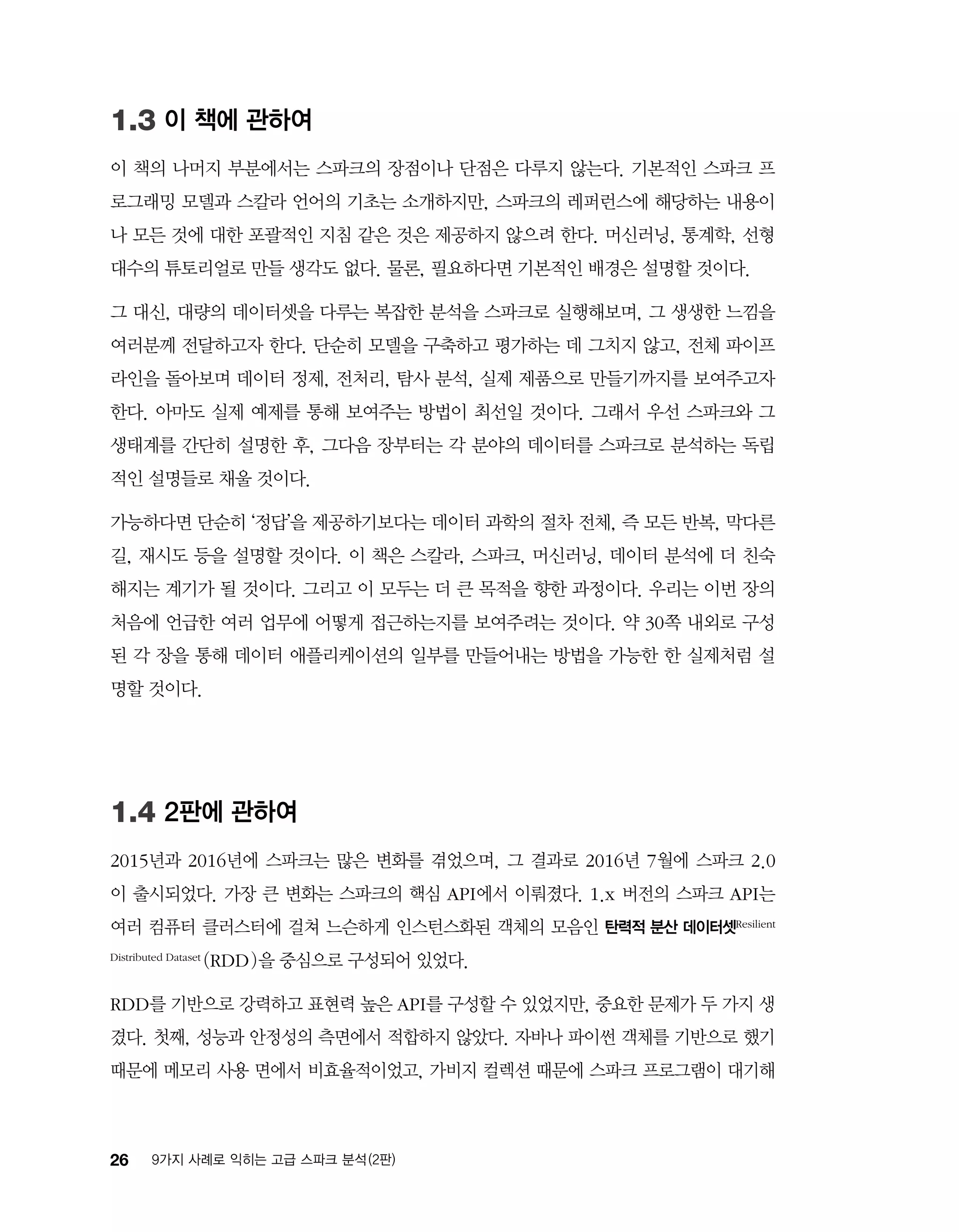

표 2-1 레코드 링크의 어려움

이름 주소 도시 주 전화번호

조시의 커피숍 선셋 대로 1234 서 할리우드 CA (213)-555-1212

조시 커피 선셋 대로 1234, 서 할리우드 CA 555-1212

커피숍 체인 #1234 선셋 가 1400, 2 할리우드 CA 206-555-1212

커피숍 체인 지역 사무소 선셋 가 1400, 2호실 할리우드 캘리포니아 206-555-1212

이 표에서 위의 두 줄은 각각 ‘서 할리우드’와 ‘할리우드’라는 도시에 있는 서로 다른 작은 커피

숍처럼 보인다. 하지만 이는 입력상의 실수로, 사실은 같은 커피숍을 가리킨다. 그다음의 두 줄

은 주소가 같지만 2개의 서로 다른 사업장을 가리키고 있는데, 하나는 실제 커피숍이며 다른

하나는 지역의 체인점 사무소다. 둘 다 시애틀에 있는 본사의 대표 전화번호가 기록되어 있다.

이 예제는 레코드 링크가 얼마나 어려운지를 보여준다. 각각의 묶음이 서로 유사하게 보이더라

도 중복이 있는지를 결정하기 위해 사용하는 기준은 묶음마다 다르다. 사람은 직관으로 쉽게

구분할 수 있겠지만 컴퓨터가 그 구분법을 학습하기에는 어려운 형태다.](https://image.slidesharecdn.com/9-180305025948/75/9-2-33-2048.jpg)

![753장 음악 추천과 Audioscrobbler 데이터셋

상호작용하는 데이터를 설명하는 데 사용하는 잠재요인에 해당한다.

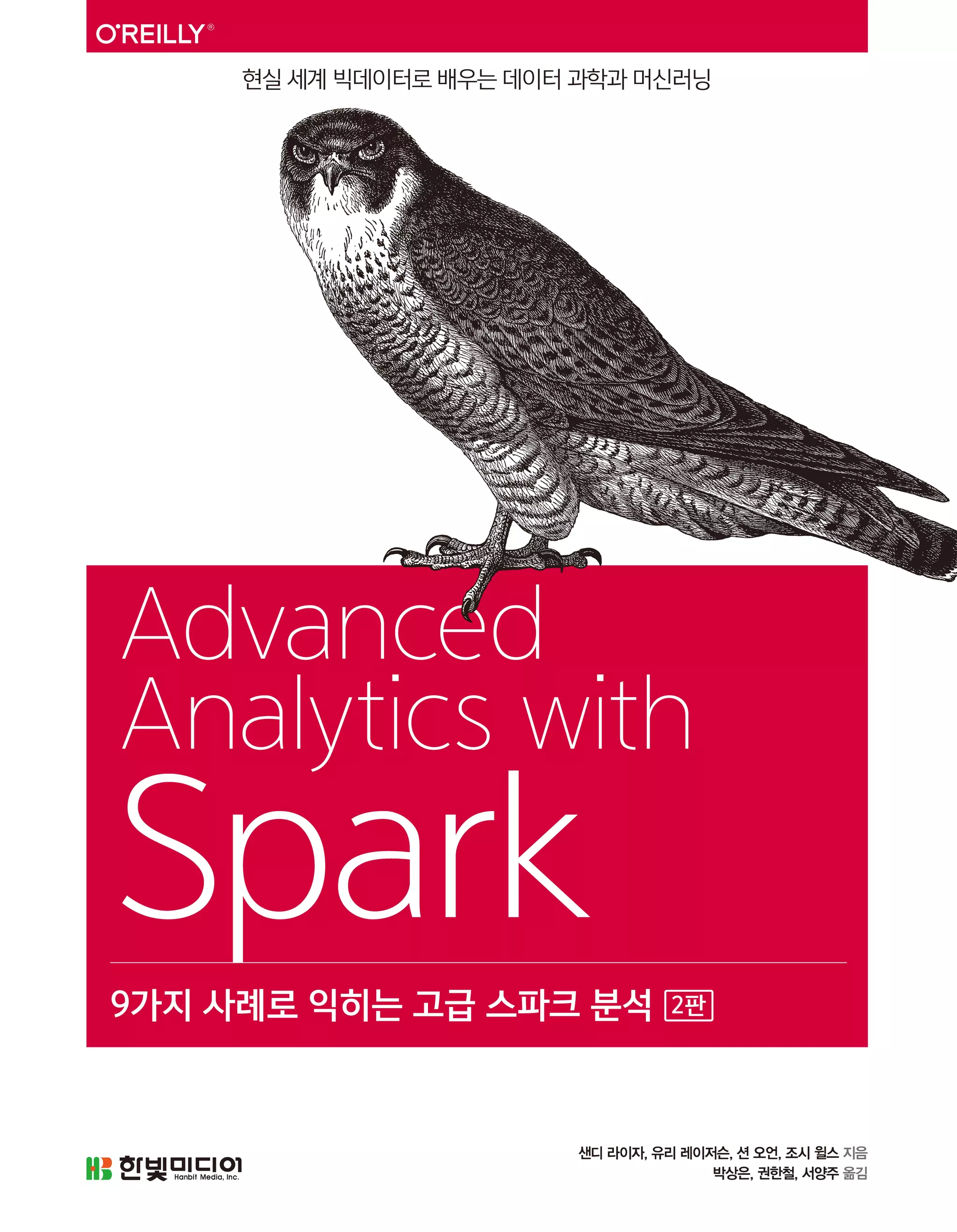

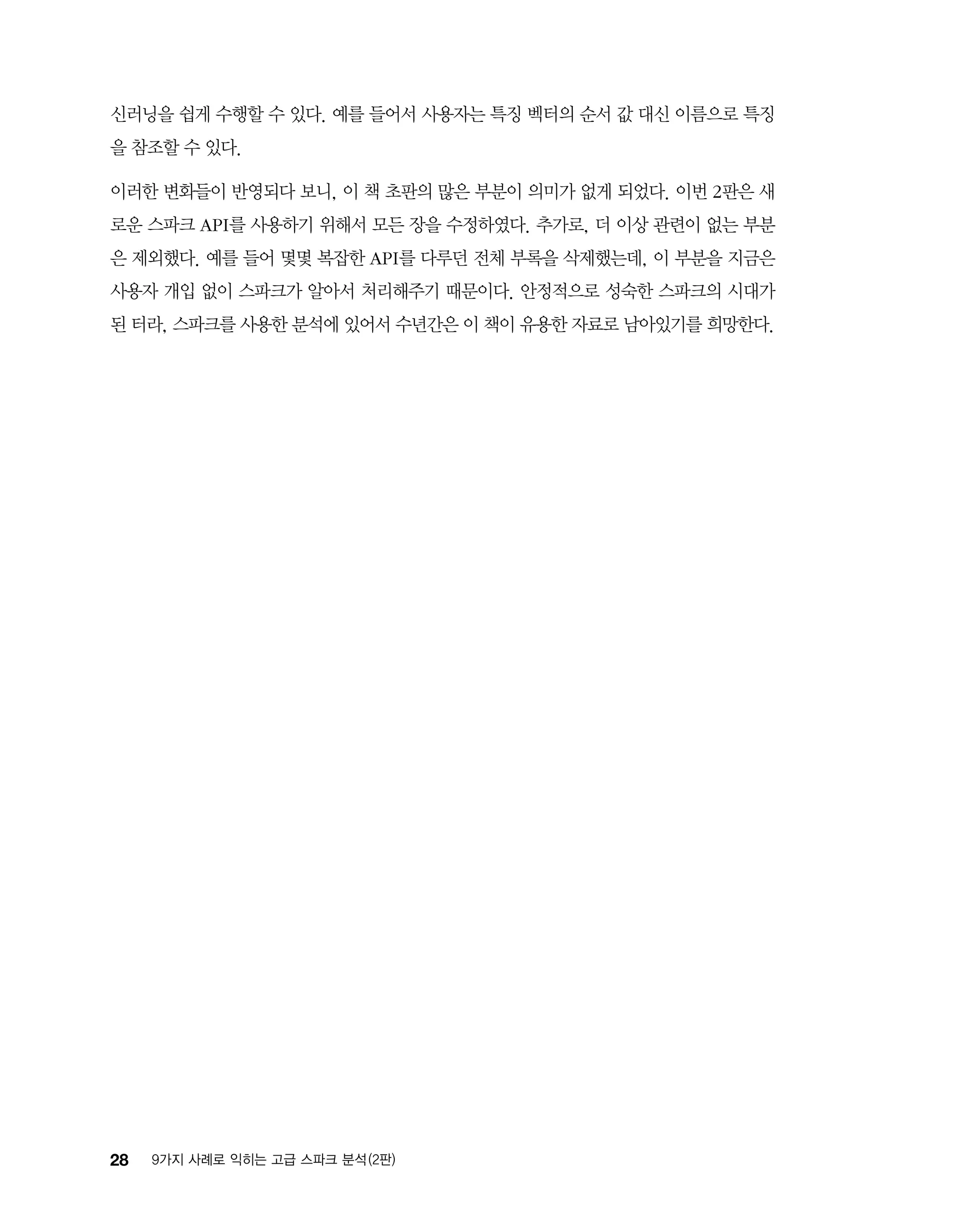

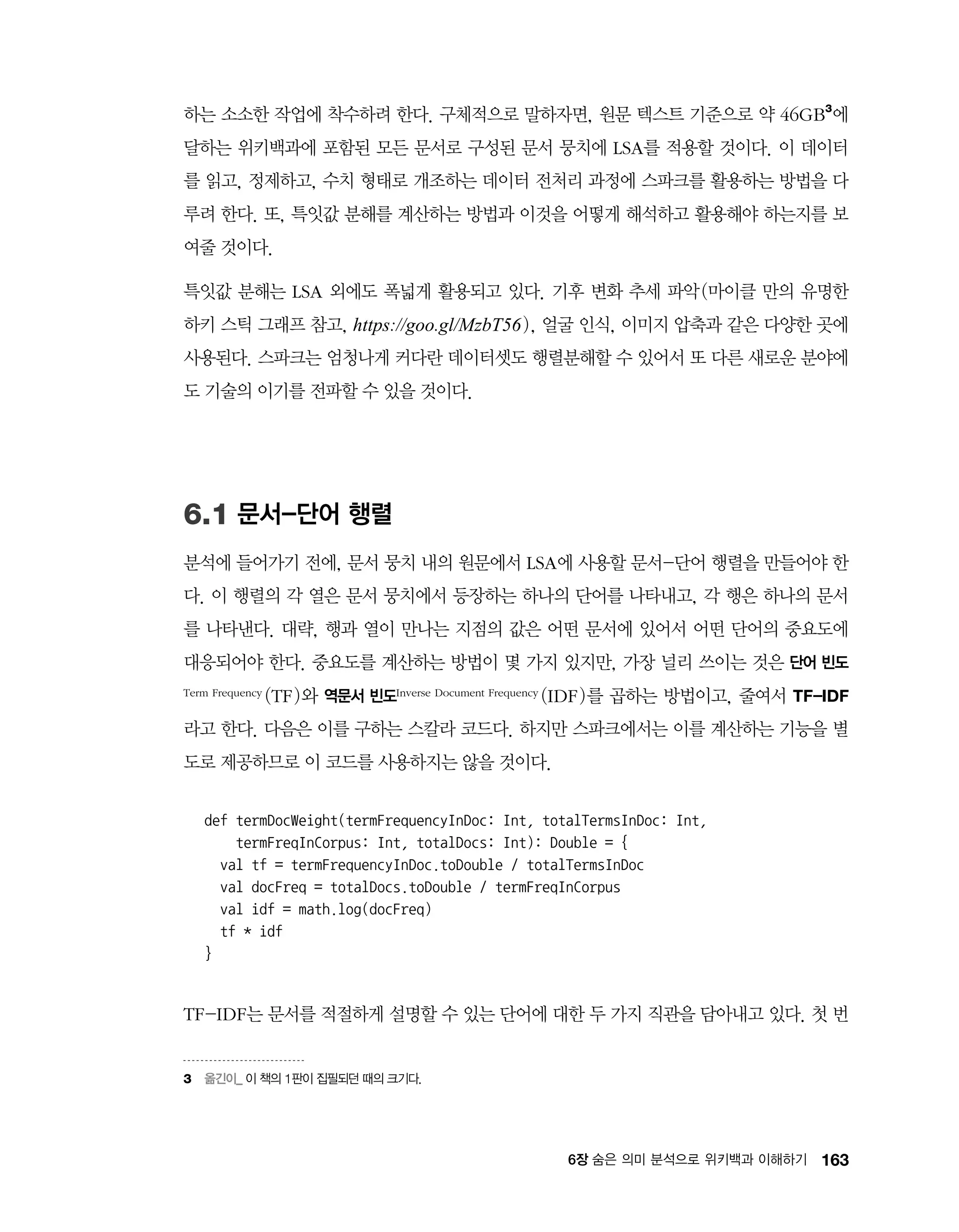

[그림 3-1]에서 볼 수 있듯, k가 작기 때문에 이 분해는 근사치일 수밖에 없다.

그림 3-1 행렬 분해

원래의 행렬 A는 매우 희소한 데 비해 행렬 곱 XYT

는 밀도가 매우 높아서 이 알고리즘을 행렬

채우기Matrix Completion 알고리즘이라고 부를 때도 있다. 설사 값이 0인 원소가 있다 할지라도 매

우 드물게 나타나므로, 이 모델은 A의 근삿값일 뿐이다. 원래의 행렬 A에서 결측된(즉, 값이 0

인) 많은 원소에 대한 값조차도 생성한다는(채워준다는) 점에서 행렬 분해는 하나의 모델이라

할 수 있다.

다행히도 선형대수학이 직관과 아주 잘 들어맞는다. 이 두 행렬은 각 사용자와 각 아티스트를

하나씩의 행으로 담고 있다. 이 행들은 매우 작은 수(k개)의 값만을 가진다. 그리고 각 값은 모

델에서 잠재특징Latent Feature에 대응한다. 그래서 행들은 사용자와 아티스트가, 아마도 취향이나

장르에 대응하리라 추측되는 이들 잠재 특징과 얼마나 밀접하게 관련되는지를 표시하게 된다.

그리고 간단히 사용자-특징 행렬과 특징-아티스트 행렬을 곱하는 것으로 사용자-아티스트

상호작용 밀집 행렬 전체의 근사치를 얻을 수 있다. 이 행렬 곱은 아이템을 아이템 속성들에 대

응시킨 뒤 사용자 속성들을 가중치로 준 것으로 생각할 수 있다.

안타까운 점은 A를 완벽하게 표현하기에는 X와 Y가 충분히 크지 않아(선형대수학에서는 계수

Rank가 너무 작다고 기술한다. https://goo.gl/49ymAa) 일반적으로 정확하게 A = XYT

를 만족

하는 해를 구할 수 없다는 것이다. 하지만 알고 보면 나쁘지 않다. A는 발생할 수 있는 모든 상](https://image.slidesharecdn.com/9-180305025948/75/9-2-39-2048.jpg)

![1054장 의사 결정 나무로 산림 식생 분포 예측하기

알고리즘의 유연함을 살펴볼 것이다.

의사 결정 나무 기반의 알고리즘은 직관적으로 이해할 수 있고 추론할 수 있다는 게 장점이다.

실제로 누구나 의사 결정 나무에 내재된 방식과 똑같은 추론을 일상에서 사용하리라 생각한다.

예를 들어 나는 모닝커피에 우유를 섞어 마시는데, 우유를 붓기 전에 ‘우유가 상했는지’를 예측

해보고 싶다. 확신이 없다면 유통기한이 지났는지를 확인한다. 유통기한이 지나지 않았다면 상

하지 않은 것으로 예측한다. 유통기한이 지났더라도 사흘이 넘지 않았다면 상하지 않은 것으로

예측하고, 사흘이 넘었다면 냄새를 맡아봐서 그 냄새가 이상하면 상한 것, 그렇지 않다면 상하

지 않은 것으로 예측한다.

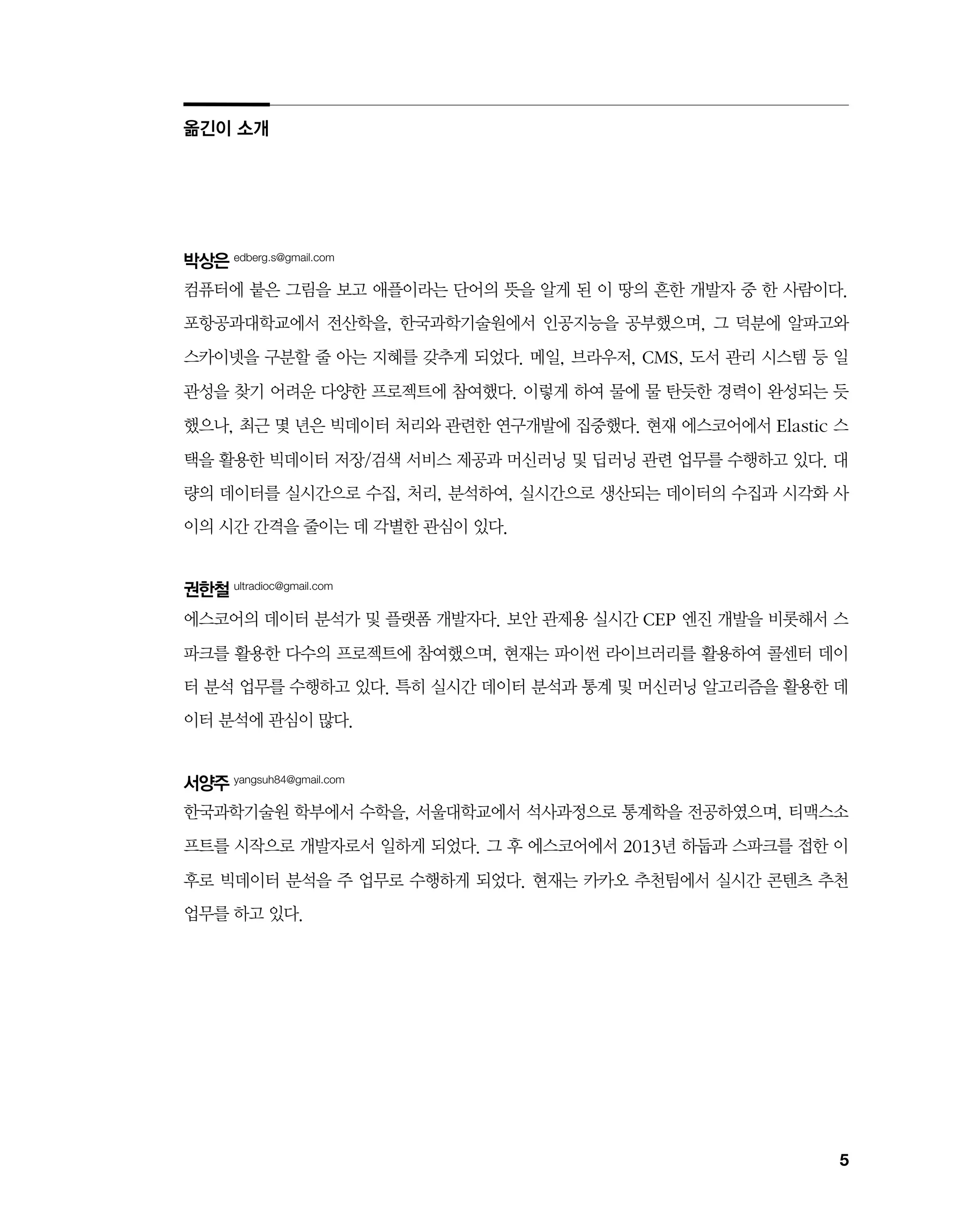

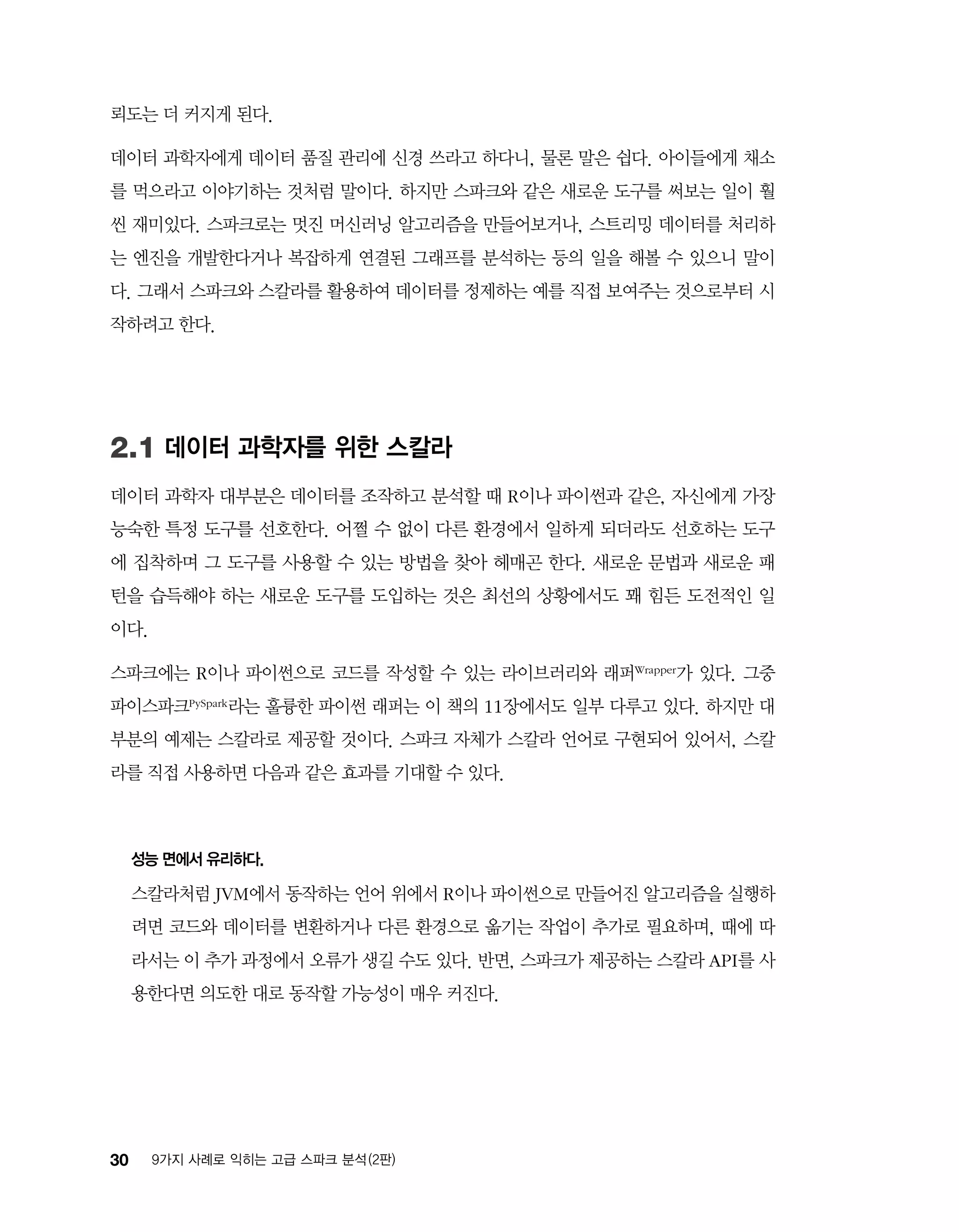

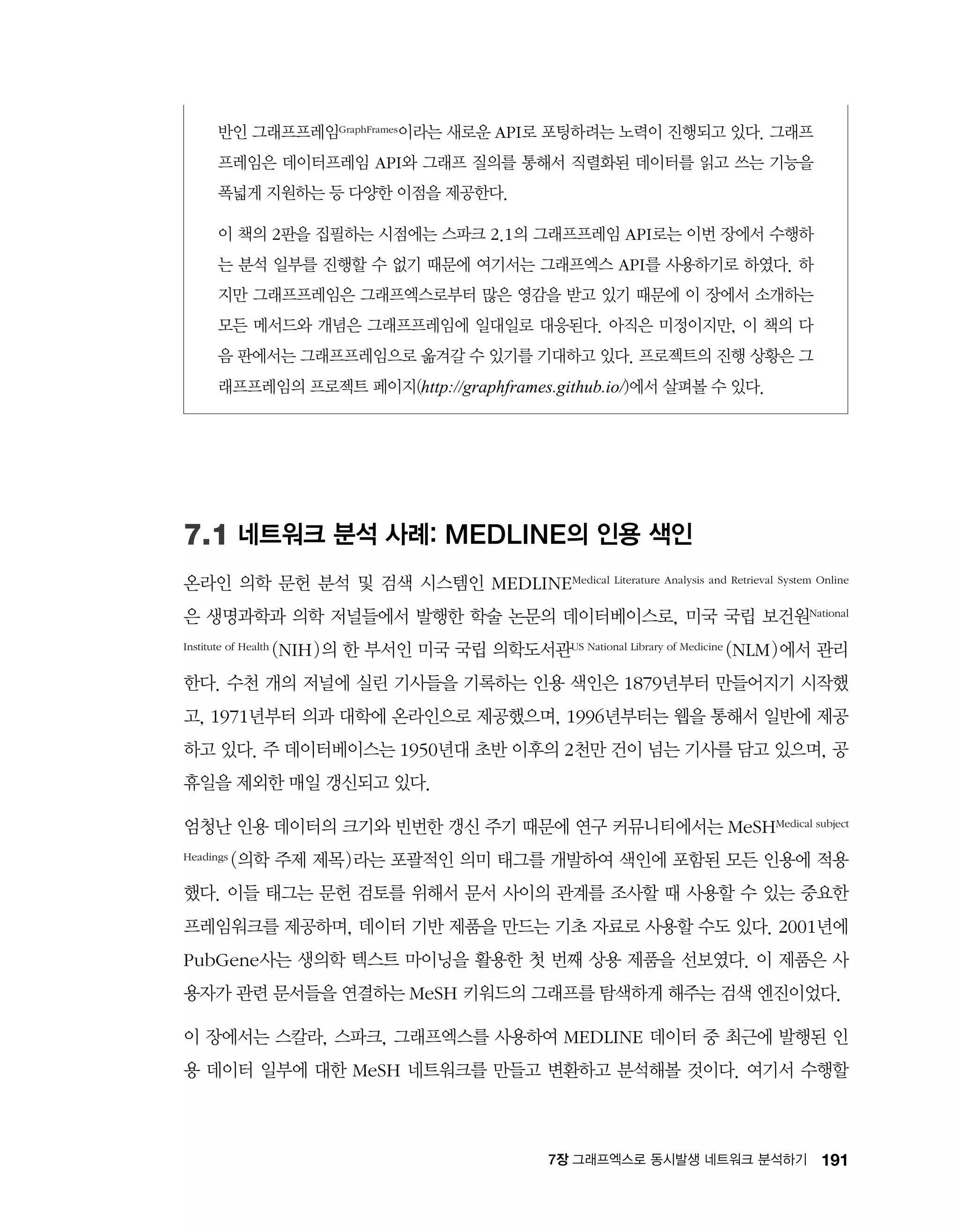

예측으로 이어지는 일련의 예/아니오 선택이 의사 결정 나무에 내재된 추론 방식이다. 각각의

결정으로 두 결과 중 하나로 넘어가는데, [그림 4-1]에서 볼 수 있듯, 최종 결과일 수도 있고

또 다른 결정의 순간일 수도 있다. 이런 의미에서 이 프로세스는 각각의 결정을 내부 노드로,

최종 해답을 말단 노드로 가지는 트리 구조로 간주할 수 있다.

그림 4-1 의사 결정 나무 : 우유가 상했나?

이런 규칙은 어린 시절 수년에 걸쳐 직관적으로 습득해 적용해온 것으로, 상한 우유와 상하지

않은 우유를 구분하는 간단하면서도 쓸만한 규칙이자, 의사 결정 나무의 성격을 보여주는 좋은](https://image.slidesharecdn.com/9-180305025948/75/9-2-45-2048.jpg)

![106 9가지 사례로 익히는 고급 스파크 분석 (2판)

예다.

이것은 단순화한 의사 결정 나무로, 정밀하게 만들어지지는 않았다. 더 자세히 알아보기 위해

다른 예를 생각해보자. 로봇이 이색 애완동물 가게에서 일하고 있다. 로봇은 가게 문을 열기 전

에 어떤 동물이 아이에게 적절한지를 배우고 싶어 한다. 가게 주인은 서둘러 애완동물 아홉 마

리 각각이 아이에게 적절한지를 기록한 목록인 [표 4-1]을 작성한다. 이제 로봇은 애완동물을

조사하면서 [표 4-1]의 정보와 조합한다.

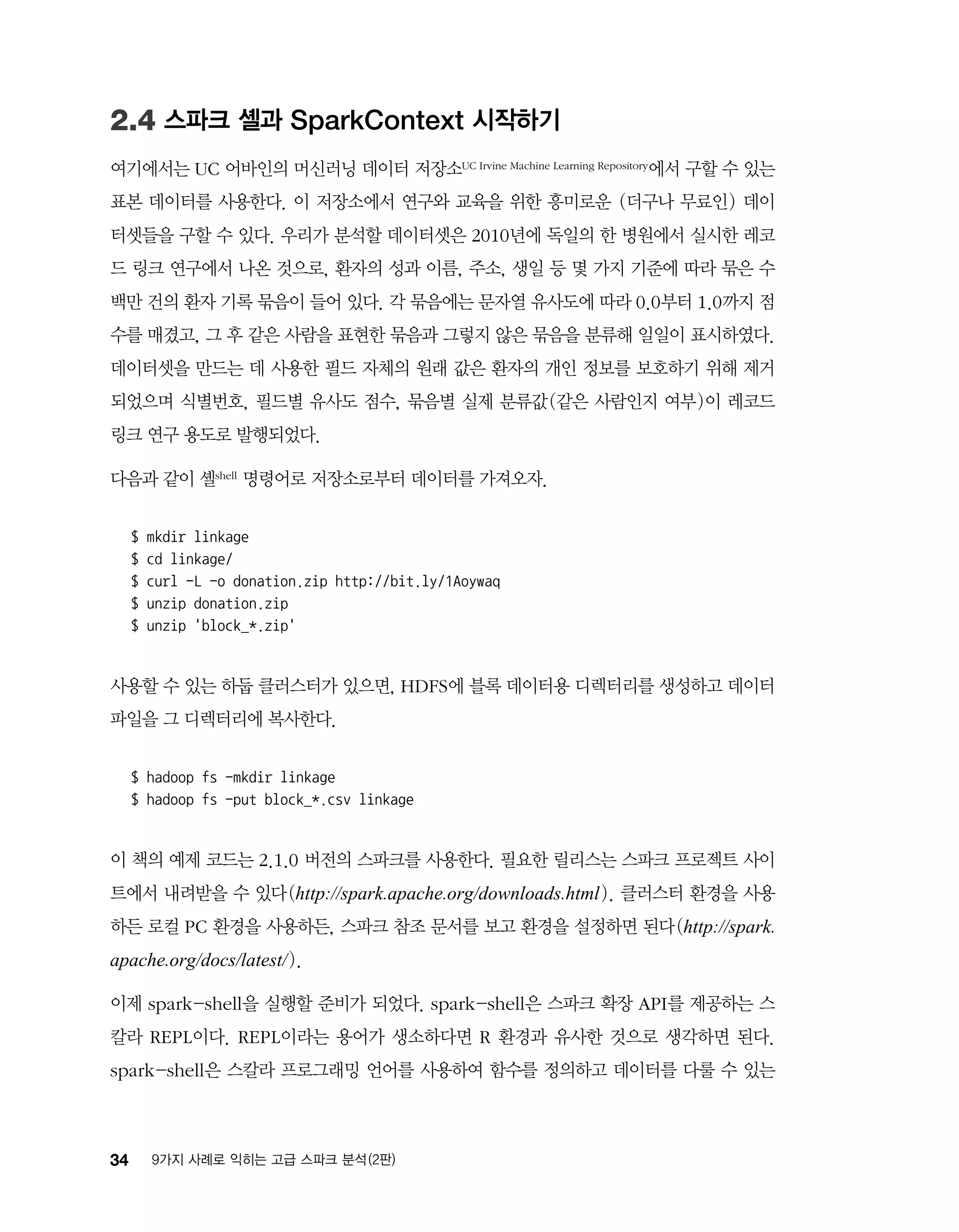

표 4-1 이색 애완동물 상점 ‘특징 벡터’

이름 무게(Kg) 다리의 수 색 아이에게 적절한가?

초코 20.5 4 갈색 적절

콩이 3.1 0 녹색 부적절

호야 0.2 0 구릿빛 적절

치즈 1390.8 4 회색 부적절

나비 12.1 4 회색 적절

다롱이 150.9 2 구릿빛 부적절

은띵이 0.1 100 갈색 부적절

꾸꾸 1.0 2 회색 부적절

루비 10.0 4 갈색 적절

이름은 특징에 포함되지 않는다. ‘루비’라는 이름은 고양이한테도, 독거미한테도 붙일 수 있으

니 이름만으로 무엇인가를 예측할 수 있으리라 생각할만한 근거가 없기 때문이다. 그렇다면 수

치형 특징 두 개(무게와 다리의 수)와 범주형 특징 하나(색)가 남는다.

그리고 이 특징들로 예측할 범주인 “아이에게 적절한가?”가 있다. 처음에는 [그림 4-2]처럼 무

게를 유일한 판단 기준으로 삼는 간단한 의사 결정 나무를 이 데이터셋에 적합시켜보자.](https://image.slidesharecdn.com/9-180305025948/75/9-2-46-2048.jpg)

![166 9가지 사례로 익히는 고급 스파크 분석 (2판)

6.3 파싱하여 데이터 준비하기

덤프 파일의 앞부분은 다음과 같은 모양이다.

page

titleAnarchism/title

ns0/ns

id12/id

revision

id584215651/id

parentid584213644/parentid

timestamp2013-12-02T15:14:01Z/timestamp

contributor

usernameAnomieBOT/username

id7611264/id

/contributor

commentRescuing orphaned refs (quot;autogenerated1quot; from rev

584155010; quot;bbcquot; from rev 584155010)/comment

text xml:space=preserve{{Redirect|Anarchist|the fictional character|

Anarchist (comics)}}

{{Redirect|Anarchists}}

{{pp-move-indef}}

{{Anarchism sidebar}}

'''Anarchism''' is a [[political philosophy]] that advocates [[stateless society|

stateless societies]] often defined as [[self-governance|self-governed]]

voluntary institutions,lt;refgt;quot;ANARCHISM, a social philosophy that

rejects authoritarian government and maintains that voluntary institutions are

best suited to express man's natural social tendencies.quot; George Woodcock.

quot;Anarchismquot; at The Encyclopedia of Philosophylt;/refgt;lt;refgt;

quot;In a society developed on these lines, the voluntary associations which

already now begin to cover all the fields of human activity would take a still

greater extension so as to substitute

...

스파크 셸을 시작해보자. 이 장에서는 작업을 좀 더 쉽게 만들어주는 몇몇 라이브러리를 활용

할 것이다. 의존하는 라이브러리들을 모두 포함한 JAR 파일을 빌드해주는 메이븐 프로젝트를

깃허브 저장소에 올려두었다.

$ cd ch06-lsa/

$ mvn package](https://image.slidesharecdn.com/9-180305025948/75/9-2-58-2048.jpg)

![31311장 파이스파크와 썬더로 신경 영상 데이터 분석하기

numpy/scipy/matplotlib

고속 배열 연산, 전문가용 함수, 매트랩에서 아이디어를 가져온 플로팅 라이브러리를 포

함한 일반적인 매트랩의 기능을 재현한다.

pandas

R의 data.frame과 비슷한 기능을 제공한다. 보통은 성능도 더 뛰어나다.

scikit-learn/statsmodels

분류, 회귀, 군집화, 행렬 분해와 같은 머신러닝과 통계 모델을 고품질로 구현하여 제공한

다.

nltk

자연어 처리에 널리 사용되는 라이브러리다.

awesome-python 깃허브 저장소(https://github.com/vinta/awesome-python)에서 다른

많은 라이브러리의 목록을 찾을 수 있다.

스파크처럼 파이스파크를 시작해보자.

export PYSPARK_DRIVER_PYTHON=ipython # 파이스파크는 IPython 셸을 사용할 수 있다.

export PYSPARK_PYTHON=path/to/desired/python # 작업자 노드를 위한 설정이다.

pyspark --master ... --num-executors ... ➊

➊ pyspark도 spark-shell과 spark-submit에서와 같이 동일한 스파크 인수를 받는다.

spark-submit을 사용하면 우리 스크립트 중 확장자가 .py인 파일을 찾아 서브밋Submit해줄 것

이다. 작업자 노드와 드라이버(예, IPython)에서 사용할 파이썬 버전을 명시할 수 있으며 버

전이 일치해야 한다. 파이썬 셸을 시작하면 클러스터와 상호작용하는 (sc로 선언된) 파이썬

SparkContext 객체를 생성한다. SparkContext를 사용할 수 있게 되면 파이스파크 API는 스

파크 API와 매우 유사하게 동작한다. 예를 들어 다음은 CSV 데이터를 읽어 들이는 모습이다.

raw_data = sc.textFile('path/to/csv/data') # RDD[string]

# 필터링하고, 쉼표를 기준으로 나누고, 실수(float)를 파싱하여 RDD[list[float]]를 얻는다.

data = (raw_data](https://image.slidesharecdn.com/9-180305025948/75/9-2-85-2048.jpg)

![314 9가지 사례로 익히는 고급 스파크 분석 (2판)

.filter(lambda x: x.startswith(#))

.map(lambda x: map(float, x.split(','))))

data.take(5)

스칼라 RDD API를 사용할 때와 비슷하게 텍스트 파일을 읽어 #으로 시작하는 줄을 제거한

후, CSV 데이터를 float 값 목록으로 파싱한다. 인수로 전달된 (예를 들어 filter나 map에 전

달된) 파이썬 함수들은 매우 유연하다. 파이썬 객체를 인수로 받아 파이썬 객체를 반환해야 한

다(filter의 반환값은 불리언으로 해석된다). 제약이 없는 것은 아니다. 먼저, 파이썬 함수 객

체는 클라우드피클Cloudpickle로 직렬화할 수 있어야 한다. 익명(람다) 함수도 마찬가지다. 그리고

클로저에서 참조하는 모든 모듈은 실행자 파이썬 프로세스가 실행되는 환경의 PYTHONPATH

환경변수에서 지정한 위치에 설치되어 있어야 한다. 참조 모듈을 사용하려면 그 모듈을 클러스

터 전체에 설치하고 모듈의 위치를 실행자 프로세스 구동 환경의 PYTHONPATH에 명시한다.

혹은 해당 모듈의 ZIP/EGG 파일을 스파크로 명시적으로 배포하면 PYTHONPATH에 추가

된다. 후자의 방식은 sc.addPyFile( )을 호출하여 수행할 수 있다.

파이스파크 RDD는 단지 파이썬 객체들의 RDD일 뿐이다. 파이썬 리스트처럼 이 RDD에는

혼합된 자료형의 객체도 저장할 수 있다(모든 객체가 PyObject의 인스턴스인 덕분이다).

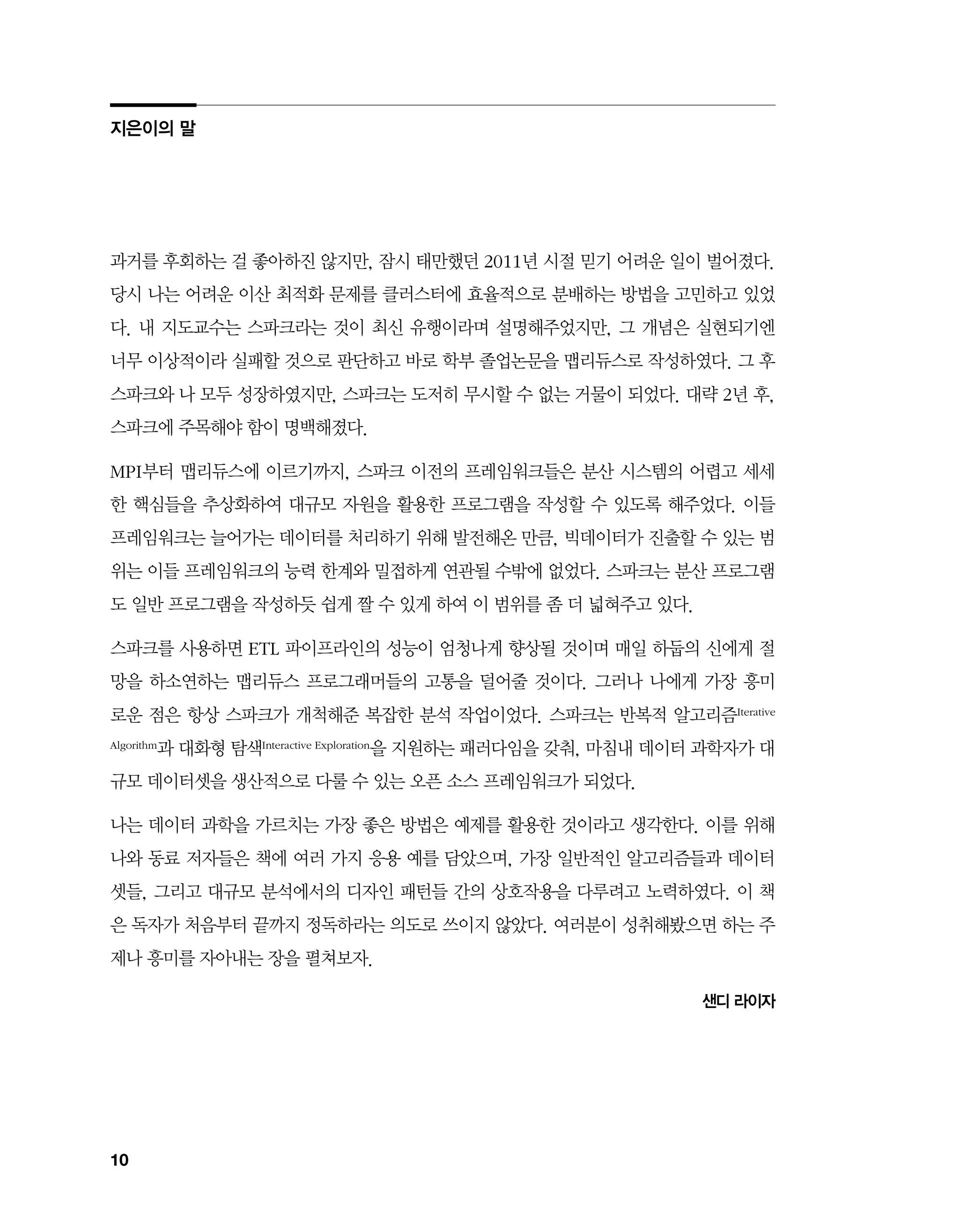

11.1.1 파이스파크 내부 구조

디버깅을 간소화하고 잠재적인 성능 저하의 원인을 알고 대처하려면 파이스파크의 구현 원리

를 어느 정도 이해해두는 것이 좋다. [그림 11-1]을 보자.

그림 11-1 파이스파크 내부 구조](https://image.slidesharecdn.com/9-180305025948/75/9-2-86-2048.jpg)

![316 9가지 사례로 익히는 고급 스파크 분석 (2판)

11.2 썬더 라이브러리 개요와 설치

썬더 라이브러리의 예제와 문서

썬더 패키지는 훌륭한 문서와 튜토리얼을 제공한다. 이어지는 예제는 썬더 문서의 데이터셋

과 튜토리얼을 참조했다.

썬더는 스파크에서 대용량의 공간과 시계열 데이터셋(즉, 커다란 다차원 행렬)을 처리하기 위

한 파이썬 도구 모음이다. 행렬 계산에는 넘파이NumPy 모듈을, 몇몇 통계 기법을 분산 처리하는

데에는 MLlib 라이브러리를 적극적으로 사용한다. 파이썬으로 만들어져서 매우 유연하고, 또

수많은 개발자가 이용할 수 있다. 다음 절에서는 썬더 API를 소개하고 썬더와 파이스파크로 감

싸진 MLlib의 K-평균 군집화 구현을 사용하여 몇몇 신경 활동을 추적해 패턴을 분류해볼 것

이다. 썬더를 설치하려면 pip install thunder-python을 호출하기만 하면 되지만, 모든 작

업자 노드에 설치해야 한다.

설치를 끝내고 SPARK_HOME 환경변수를 설정하면 다음과 같이 파이스파크 셸을 실행할 수

있다.

$ export PYSPARK_DRIVER_PYTHON=ipython # 일반적으로 추천하는 설정이다.

$ pyspark --master ... --num-executors ...

[...some logging output...]

Welcome to

____ __

/ __/__ ___ _____/ /__

_ / _ / _ `/ __/ '_/

/__ / .__/_,_/_/ /_/_ version 2.0.2

/_/

Using Python version 2.7.6 (default, Apr 9 2014 11:54:50)

SparkContext available as sc.

Running thunder version 0.5.0_dev

A thunder context is available as tsc

In [1]:](https://image.slidesharecdn.com/9-180305025948/75/9-2-88-2048.jpg)

![31711장 파이스파크와 썬더로 신경 영상 데이터 분석하기

11.3 썬더로 데이터 읽어 들이기

썬더는 특별히 신경 영상 데이터셋을 염두에 두고 설계되었다. 그래서 시간별로 여러 번 촬영

한 대량의 영상 데이터를 분석하는 데 특화되었다.

먼저, S35

안의 썬더 저장소(s3://thunder-sample-data/images/fish/)에서 제공하는 예

제 데이터셋 중 제브라피쉬 뇌 영상 몇 장을 읽어보자. 동작 방식을 설명하는 것이 목적이므로

이 예제는 엄청나게 다운샘플링된 데이터로 수행한다. 데이터를 추가하거나 더 큰 데이터셋을

사용하고자 한다면 썬더 문서를 참조하자. 제브라피쉬는 생물학 연구에서 널리 사용하는 모델

생물Model Organism이다. 크기가 작고 짧은 주기로 번식하여 척추동물 발생의 모델로 사용한다. 또

한, 재생이 특출나게 빠르다는 점도 흥미롭다. 제브라피쉬가 신경과학 연구에 훌륭한 모델인

이유는 몸이 투명하고 뇌가 작아서 개별 신경을 구분할 수 있고, 그 전체를 고해상도 영상으로

녹화할 수 있기 때문이다. 다음은 데이터를 읽어 들이는 코드다.

import thunder as td

data = td.images.fromtif('/user/ds/neuro/fish', engine=sc) ➊

print data

print type(data.values)

print data.values._rdd

...

Images

mode: spark ➋

dtype: uint8

shape: (20, 2, 76, 87)

class 'bolt.spark.array.BoltArraySpark' ➌

PythonRDD[2] at RDD at PythonRDD.scala:48 ➍

➊ SparkContext 객체를 전달하는 방법에 주목하자. 썬더는 동일한 API를 사용하여 로컬 모드 동작을 지원

한다.

➋ 스파크에서 지원하는 Images 객체를 볼 수 있다.

➌ BoltArray는 기저의 데이터 컨테이너를 추상화한 것으로, 이 프로젝트에서는 로컬 데이터 표현과 스파크

RDD 표현을 추상화한다.

➍ PythonRDD가 기저의 RDD 객체다.

5 옮긴이_ S3는 아마존의 클라우드 저장소 서비스다.](https://image.slidesharecdn.com/9-180305025948/75/9-2-89-2048.jpg)