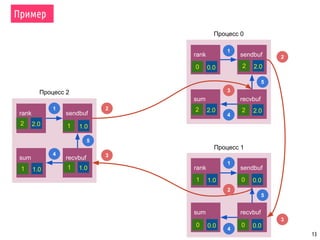

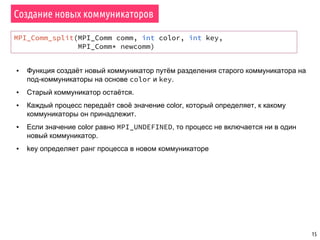

Документ представляет подробный анализ производных типов данных в MPI, включая их создание и использование для передачи сообщений. Он обсуждает различные типы данных, такие как структурные и векторные, а также процессы создания новых коммуникаторов и групп процессов. Включены примеры кода для иллюстрации процесса и определения размера и протяженности типов данных.

![4

Производные типы данных (derived datatypes)

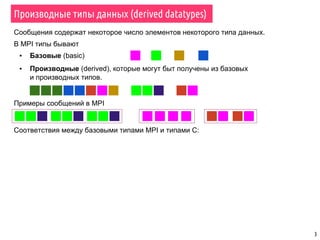

struct buff_s {

int ival[3];

double dval[5];

} buffer;

Компилятор

int double

MPI_Send(&buffer, 1, buff_datatype, ...)

&buffer = начальный

адрес данных

Указатель,

описывающий

смещение

array_of_types[0]=MPI_INT;

array_of_blocklengths[0]=3;

array_of_displacements[0]=0;

array_of_types[1]=MPI_DOUBLE;

array_of_blocklengths[1]=5;

array_of_displacements[1]=...;

MPI_Type_struct(2, array_of_blocklengths,

array_of_displacements, array_of_types,

&buff_datatype );

MPI_Type_commit(&buff_datatype);](https://image.slidesharecdn.com/pct-fall2015-lec4-151216125544/85/4-MPI-4-320.jpg)

![9

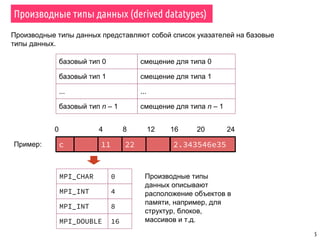

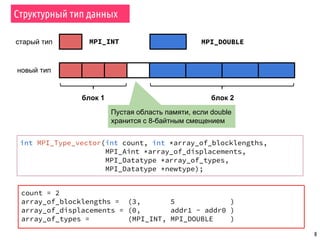

Структурный тип данн

блок 1

struct buff {

int ival[3];

double dval[5];

}

buf_datatype

Пустая область памяти, если double

хранится с 8-байтным смещением

блок 2

▪ Каждый массив хранится независимо.

▪ Каждый буфер – это пара массива из 3 переменных int и массива из 5 переменных

double

▪ Длина пустой области памяти между массивами может быть любая.](https://image.slidesharecdn.com/pct-fall2015-lec4-151216125544/85/4-MPI-9-320.jpg)

![10

Как расчитать смещение

int MPI_Get_address(void* location, MPI_Aint* address);

▪ array_of_disp[i] = address(block_i) – address(block_0)

Как получить адрес в формате MPI:](https://image.slidesharecdn.com/pct-fall2015-lec4-151216125544/85/4-MPI-10-320.jpg)

![20

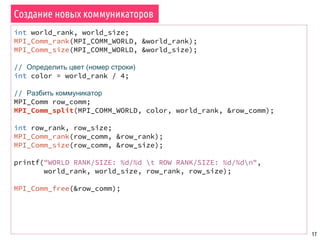

Создание новых коммуникаторов

int world_rank, world_size;

MPI_Comm_rank(MPI_COMM_WORLD, &world_rank);

MPI_Comm_size(MPI_COMM_WORLD, &world_size);

MPI_Group world_group;

MPI_Comm_group(MPI_COMM_WORLD, &world_group);

int n = 7;

const int ranks[7] = {1, 2, 3, 5, 7, 11, 13};

// Создать группу из из world_group и включить в неё 7 процессов

MPI_Group prime_group;

MPI_Group_incl(world_group, 7, ranks, &prime_group);

// Создать новый коммуникатор

MPI_Comm prime_comm;

MPI_Comm_create_group(MPI_COMM_WORLD, prime_group, 0, &prime_comm);

int prime_rank = -1, prime_size = -1;

if (MPI_COMM_NULL != prime_comm) {

MPI_Comm_rank(prime_comm, &prime_rank);

MPI_Comm_size(prime_comm, &prime_size);

}

printf("WORLD RANK/SIZE: %d/%d t PRIME RANK/SIZE: %d/%dn",

world_rank, world_size, prime_rank, prime_size);

MPI_Group_free(&world_group);

MPI_Group_free(&prime_group);

MPI_Comm_free(&prime_comm);](https://image.slidesharecdn.com/pct-fall2015-lec4-151216125544/85/4-MPI-20-320.jpg)