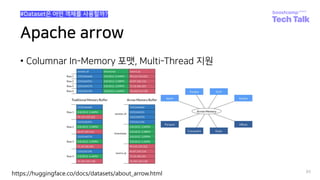

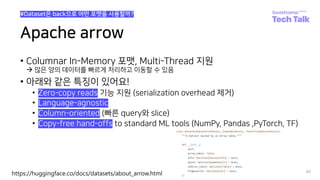

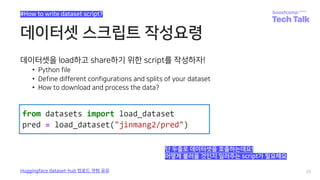

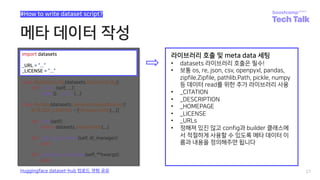

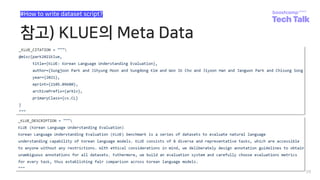

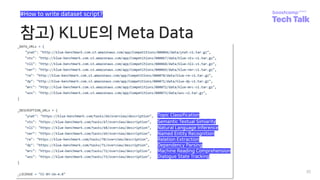

The document discusses how to collaborate using huggingface datasets. It introduces huggingface datasets and explains why data collaboration is needed for ML/DL projects. It then covers uploading data to the huggingface hub, including creating a repository, and the three methods of uploading - uploading the script only, uploading the dataset only, or uploading both. The document also provides guidance on writing dataset scripts, including defining configurations, metadata, and the required classes.

![데이터셋 스크립트 작성요령

26

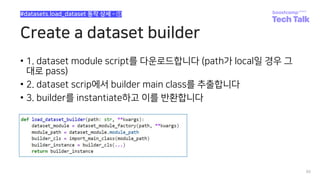

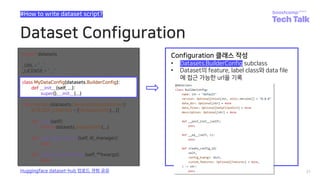

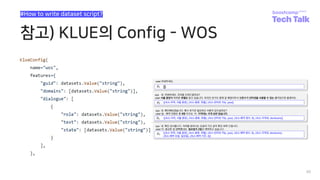

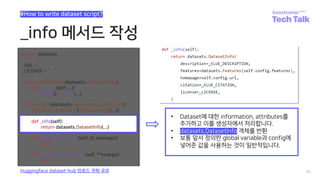

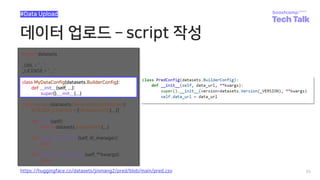

#How to write dataset script?

Huggingface dataset-hub 업로드 경험 공유

import datasets

_URL = “...”

_LICENSE = “...”

class MyDataConfig(datasets.BuilderConfig):

def __init__(self, ...):

super().__init__(...)

class MyData(datasets.GeneratorBasedBuilder):

BUILDER_CONFIGS = [MyDataConfig(...)]

def _info(self):

return datasets.DatasetInfo(...)

def _split_generators(self, dl_manager):

pass

def _generate_examples(self, **kwargs):

pass](https://image.slidesharecdn.com/boostcampaitechtechtalkjinmyunghoon-211210113319/85/Tech-Talk-_datasets-26-320.jpg)

![GeneratorBasedBuilder Class

41

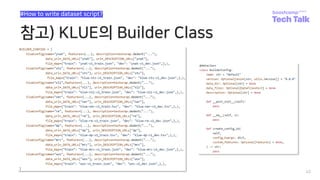

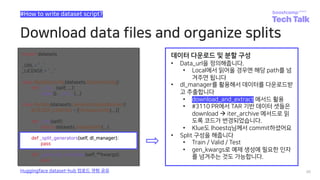

#How to write dataset script?

Huggingface dataset-hub 업로드 경험 공유

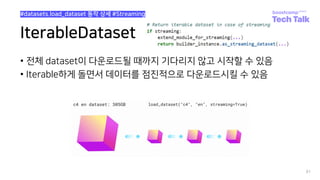

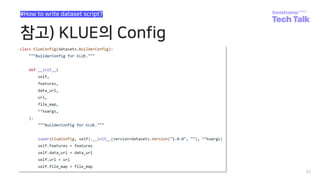

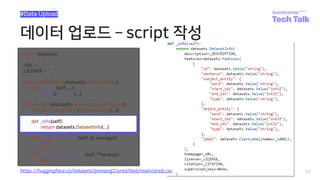

class MyData(datasets.GeneratorBasedBuilder):

BUILDER_CONFIGS = [MyDataConfig(...)]

Builder 클래스 작성

• datasets.GeneratorBasedBuilder subclass

• BUILDER_CONFIGS는 list 형태로 여러 가지

data에 대한 config을 설정할 수 있다.

• 각 config에 대한 객체를 생성

• Config은 name 인자를 필수적으로 받습니다

• 만약 config의 수가 1개 이상일 경우,

• name을 필수 적으로 인자로 받아야 에러가 발

생하지 않습니다.

• e.g., klue의 경우 8가지의 task가 있습니다.

• load_dataset(“klue”)로 호출할 경우,

• 어떤 data를 가져올 것인지 지정되지 않아 에러

를 띄우게 됩니다.](https://image.slidesharecdn.com/boostcampaitechtechtalkjinmyunghoon-211210113319/85/Tech-Talk-_datasets-41-320.jpg)

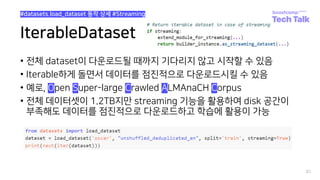

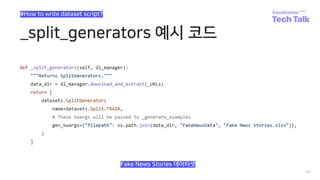

![데이터 업로드 add/commit/push

53

#Data Upload

$ git add train.csv

$ git add dev.csv

$ git branch M main

$ git commit -m “upload data”

[main 49a2427] upload data

2 files changed, 6 insertions(+)

create mode 100644 dev.csv

create mode 100644 train.csv

$ git push origin main

Counting objects: 4, done.% (2/2), 374 KB | 0 B/s

Delta compression using up to 8 threads.

Compressing objects: 100% (4/4), done.

Writing objects: 100% (4/4), 532 bytes | 532.00 KiB/s, done.

Total 4 (delta 0), reused 0 (delta 0)

To https://huggingface.co/datasets/jinmang2/pred

01a4cee..49a2427 main -> main

• 이제 git을 사용하듯 repo에 데이터를 업로드해봅시다!](https://image.slidesharecdn.com/boostcampaitechtechtalkjinmyunghoon-211210113319/85/Tech-Talk-_datasets-53-320.jpg)

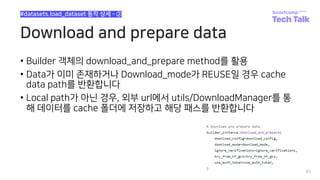

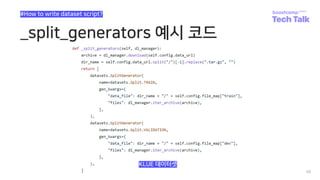

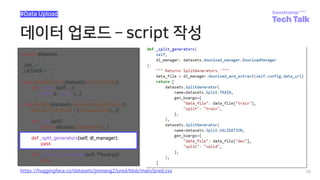

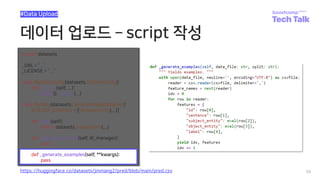

![데이터 업로드 script 작성

56

#Data Upload

class MyData(datasets.GeneratorBasedBuilder):

BUILDER_CONFIGS = [MyDataConfig(...)]

https://huggingface.co/datasets/jinmang2/pred/blob/main/pred.csv](https://image.slidesharecdn.com/boostcampaitechtechtalkjinmyunghoon-211210113319/85/Tech-Talk-_datasets-56-320.jpg)

![Adding tests and metadata

• Dataset에 test data와 checksum metadata를 추가

• 테스트 및 검증하고 생성된 데이터 셋을 인증할 수 있게!

60

#Additional

https://huggingface.co/docs/datasets/share_dataset.html#sharing-your-dataset

$ root@<your_id>:~/pred# cd ..

$ root@<your_id>:~# dataset-cli test pred --save_infos --all_configs

Testing builder 'pred' (1/1)

Downloading and preparing dataset pred/pred to

/opt/ml/.cache/huggingface/datasets/pred/pred/0.0.0/3511603182c8362e0369afd244ecaf540e9a1700304bdfda3ecbd3ba7f748c7e...

100%|██████████████████████████████████████████████| 2/2 [00:00<00:00, 8405.42it/s]

100%|██████████████████████████████████████████████| 2/2 [00:00<00:00, 1619.11it/s]

Dataset pred downloaded and prepared to

/opt/ml/.cache/huggingface/datasets/pred/pred/0.0.0/3511603182c8362e0369afd244ecaf540e9a1700304bdfda3ecbd3ba7f748c7e.

Subsequent calls will reuse this data.

100%|██████████████████████████████████████████████| 2/2 [00:00<00:00, 580.17it/s]

Dataset Infos file saved at dataset_infos.json

Test successful.](https://image.slidesharecdn.com/boostcampaitechtechtalkjinmyunghoon-211210113319/85/Tech-Talk-_datasets-60-320.jpg)

![Adding tests and metadata

• Dataset에 test data와 checksum metadata를 추가

• 테스트 및 검증하고 생성된 데이터 셋을 인증할 수 있게!

61

#Additional

https://huggingface.co/docs/datasets/share_dataset.html#sharing-your-dataset

$ root@<your_id>:~# dataset-cli dummy_data pred --auto_generate

100%|██████████████████████████████████████████████| 2/2 [00:01<00:00, 1.21it/s]

100%|██████████████████████████████████████████████| 2/2 [00:00<00:00, 1302.78it/s]

Dummy data generation done and dummy data test succeeded for config 'pred''.

Automatic dummy data generation succeeded for all configs of 'pred’

$ root@<your_id>:~# cp ./datasets/pred/dummy .](https://image.slidesharecdn.com/boostcampaitechtechtalkjinmyunghoon-211210113319/85/Tech-Talk-_datasets-61-320.jpg)

![Push to hub

63

#push_to_hub

$ root@<your_id>:~/pred# git add *

$ root@<your_id>:~/pred# git status

On branch main

Your branch is up to date with 'origin/main'.

Changes to be committed:

(use "git reset HEAD <file>..." to unstage)

modified: .gitattributes

new file: dataset_infos.json

new file: pred.py

new file: dummy/pred/0.0.0/dummy_data.zip

new file: dummy/pred/0.0.0/dummy_data.zip.lock

$ root@<your_id>:~/pred# git commit m “upload datasets script and meta data”

[main adac29c] upload datasets script and meta data](https://image.slidesharecdn.com/boostcampaitechtechtalkjinmyunghoon-211210113319/85/Tech-Talk-_datasets-63-320.jpg)

![Push to hub

64

#push_to_hub

$ root@<your_id>:~/pred# git push origin main

Counting objects: 6, done.% (1/1), 2.0 KB | 0 B/s

Delta compression using up to 8 threads.

Compressing objects: 100% (6/6), done.

Writing objects: 100% (6/6), 2.53 KiB | 2.53 MiB/s, done.

Total 6 (delta 1), reused 0 (delta 0)

To https://huggingface.co/datasets/jinmang2/pred

49a2427..adac29c main -> main

$ root@<your_id>:~/pred# git tag v0.0.0

$ root@<your_id>:~/pred# git push --tags

Total 0 (delta 0), reused 0 (delta 0)

To https://huggingface.co/datasets/jinmang2/pred

* [new tag] v0.0.0 -> v0.0.0](https://image.slidesharecdn.com/boostcampaitechtechtalkjinmyunghoon-211210113319/85/Tech-Talk-_datasets-64-320.jpg)