Report

Share

Download to read offline

Recommended

More Related Content

What's hot

What's hot (20)

【DL輪読会】Data-Efficient Reinforcement Learning with Self-Predictive Representat...

【DL輪読会】Data-Efficient Reinforcement Learning with Self-Predictive Representat...

Dimensionality reduction with t-SNE(Rtsne) and UMAP(uwot) using R packages.

Dimensionality reduction with t-SNE(Rtsne) and UMAP(uwot) using R packages.

[DL輪読会]Model soups: averaging weights of multiple fine-tuned models improves ...![[DL輪読会]Model soups: averaging weights of multiple fine-tuned models improves ...](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

![[DL輪読会]Model soups: averaging weights of multiple fine-tuned models improves ...](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

[DL輪読会]Model soups: averaging weights of multiple fine-tuned models improves ...

More from Arata Honda

More from Arata Honda (10)

正則化項について

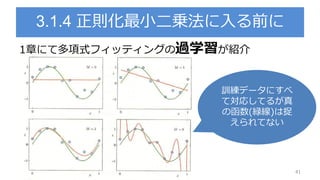

- 3. 3.1.4 正則化最小二乗法 正則化について議論 二乗誤差 に正則化項 を加える 43 誤差関数

- 7. Lasso : Least absolute shrinkage and selection operator lassoは, スパース(疎)な解が得られるという話がある スパースで何がうれしいのか? 毎回この図でてくるけど何なん? 47 lassoridge

- 8. そろそろ理解したいぜ (M=2の時の図らしい) 青線 : 正則化されていない誤差関数の等高線 赤線で囲まれた領域 : 正則化項の制約条件を満たす領域 48 lassoridge 青と赤が満たすのが誤差最小化条件 ridge : lasso : 条件が減る = 次元が減る →特徴量も減る(変数選択) →モデル推定と変数選択を一括