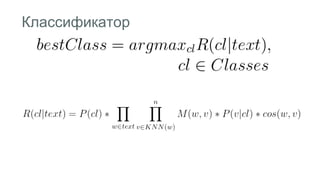

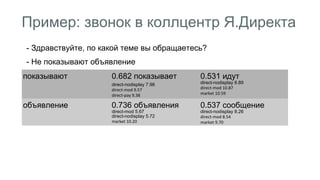

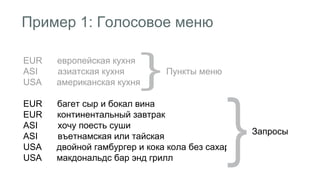

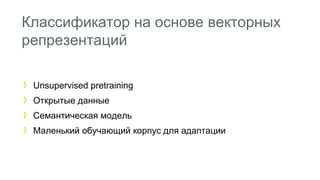

Документ описывает методы классификации коротких текстов, используя векторные репрезентации слов, в контексте голосовых систем и колл-центров. Рассматриваются традиционные статистические подходы, их преимущества и недостатки, а также представлен классификатор, основанный на векторных представлениях и метриках доверия. Приводятся примеры применения в различных сферах, включая колл-центры и диалоговые системы.

![Векторная репрезентация

Входной вектор

А Б Х В Г

[ 1 1 1 1 1] - [100К]

Результат

=> Проекция [200]

Х = [0.080543, 0.075750, ... -0.109624, 0.038613]](https://image.slidesharecdn.com/3-140915101736-phpapp01/85/slide-20-320.jpg)