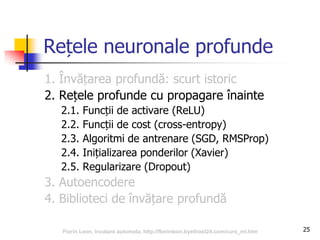

Documentul oferă o prezentare detaliată a învățării automate, concentrându-se pe rețele neuronale profunde și istoria dezvoltării acestora. Se discută despre tehnicile de învățare profundă, care pot prelucra date brute pentru a extrage reprezentări utile, și despre aplicațiile lor în diverse domenii precum recunoașterea imaginilor și înțelegerea limbajului natural. În plus, sunt explicate concepte cheie precum arhitecturile rețelurilor neuronale, tehnici de antrenare, și evoluția metodelor de învățare profundă până în prezent.