Учебное пособие охватывает вычислительные методы, используемые для решения инженерных и научно-технических задач, включая линейную алгебру, нелинейные уравнения, численное интегрирование и дифференцирование. Книга предназначена для студентов и аспирантов технических вузов, а также инженеров и научных работников, содержащая примеры, иллюстрации и обсуждения методов, алгоритмов и их реализации на компьютере. Второе издание включает исправления и новые темы, основанные на опыте преподавания и актуальных методах вычислений.

![Глава 1. Математическое моделирование и решение прикладных задач

собой прикладных программ и системных средств, включающих сред

ства, предоставляемые пользователю для управления ходом вычисли

тельного эксперимента, обработки и представления его результатов.

Такой комплекс программ иногда называют пробле.мно-ориентирован

ным пакетом прикладных програм,~1.

§ 1.4. Допоnнитеnьные замечани1

1. Математическое моделирование является основой современной

методологии решения прикладных задач, и его роль объективно возрас

тает в связи с необходимостью решения все более сложных приклад

ных проблем.

2. Эффективность применения компьютера в той или иной области

науки и техники тем выше, чем совершеннее ее математические

модели. В то же время использование компьютера для исследования

каких-либо процессов часто служит серьезным стимулом для создания

новых математических моделей и детального изучения лих процессов

другими методами.

3. Само по себе применение компьютера не позволяет решить

прикладную задачу, а лишь дает в руки исследователя мощный инст

румент познания. Использование компьютера не только не освобож

дает от необходимости глубоко осмыслить решаемую проблему, но и

заставляет уделять постановке задачи гораздо больше внимания.

4. Вычислительный эксперимент не противоречит натурному экс

перименту и классическому математическому анализу прикладной

задачи, а, напротив, находится с ними в органическом единстве.

5. Для успешного применения метода математического моделирова

ния с использованием компьютера необходимо гармоническое владе

ние всеми его составляющими. В настоящем пособии основное внима

ние уделено вычислительным методам и алгоритмам, анализу свойств

вычислительных задач, интерпретации получаемых результатов.

6. Дополнительную информацию о методологии современного м~rrема

тическоrо моделирования и концепции вычислительного эксперимента

можно получить из следующих источников: [58, 71, 79, 96, 99, 11 *].

7. В настоящее время большое количество высококачественных про

грамм и пакетов программ распространяется бесплатно. Например,

через lnternet по адресу http://www.netlib.org доступно программное

обеспечение, предназначенное для решения широкого спектра приклад

ных задач. Кроме того, по адресу http://www.acm.org/pubs/cago можно

найти 866 тщательно разработанных программ, реализующих эффек

тивные вычислительные алгоритмы.

24](https://image.slidesharecdn.com/33379-160302054853/85/33379-25-320.jpg)

![Глава 2. Введение в элементарную теорию nоrрешностей

Пр им ер 2.5. С какой относительной точностью следует найти

число а*, чтобы верными оказались шесть его значащих цифр?

Из утверждения 2° следует, что достаточно найти а• с относитель

ной точностью 6::::: 10-6• .&

Заметим, что границы абсолютной и относительной погрешностей

принято записывать с одной или двумя значащими цифрами. Большая

точность в записи этих величин, как правило, не имеет смысла, так как

обычно они являются довольно грубыми оценками истинных значений

погрешностей, и кроме того, для практического использования часто

бывает достаточно знать только их порядок.

Пр им ер 2.6. Информация о погрешности вида о(а*) ::::: 0.288754 • 1o-s

практически равноценна информации о(а*) ::::: 3. 10-6' причем послед

няя вызывает больше доверия. Скорее всего, вполне удовлетворитель

ной в данном случае является и запись о(а*) - 10-6. .&

Неравенство (2.3) эквивалентно двойному неравенству

а• - Л(а*) $а$ а• + Л(а*)

и поэтому тот факт, что число а• является приближенным значением

числа а с верхней границей абсолютной погрешности Л(а*) [с абсо

лютной точностью i; = Л(а*) ], принято записывать в виде

а= а* ± Л(а*).

Как правило, числа а• и Л(а*) указывают с одинаковым числом

цифр после десятичной точки.

Пр им ер 2.7. Пусть для числа а известны приближенное значение

а•= 1.648 и граница абсолютной погрешности Л(а*) = 0.002832. Тогда

можно записать а= 1.648 ± 0.003. Записи вида а= 1.648 ± 0.002832 или

а = 1.648 ± 0.1 являются неестественными. .&

Из неравенства (2.4) следует, что значение а заключено примерно

между а*(! - 8(а*)) и a*(I + 8(а*)). Поэтому тот факт, что число а•

является приближенным значением числа а с границей относительной

погрешности 8(а*) (с относительной точностью i; = 8(а*) ), принято

записывать в виде а= а• (1 ± 8(а*) ).

Пр им ер 2.8. Оценим точность часто используемого в простейших

расчетах приближения тт* = 3 14 к числу тt. Поскольку тt = 3.14159"" то

7t - тт* = 0.00159... Следовательно, можно принять Л(тт*) = 0.0016

и 8(тт*)::::: 0.0016/3 14::::: 0.00051=0.051 %. Итак, тt = 3.14(1±О051 %). .&

30](https://image.slidesharecdn.com/33379-160302054853/85/33379-31-320.jpg)

![Глава 2. Введение в элементарную теорию погрешностей

Разделив обе части полученного неравенства на 1аЬ1. выведем

оценку (2.12).

Для вывода второй оценки предварительно заметим, что

1ь·1=1ь + (Ь. - b)I ~ 1ь1 -Л(Ь.) = lbl(l - о(Ь•)).

Тогда

о(а·1ь·)= lа!ь-а·1ь·1 = lаь·-ьа·1 =

la!bl laь*I

= 1а(Ь* - Ь) + Ь(а - a*)I < 1аlЛ(Ь°) + /ЬIЛ(а*) = S(b*) + S{a*) 8

1аь*I - 1abl(1 -о(ь*)) 1- s(ь*) .

Следствие. Если 8(а*) « 1 и Б(Ь•) « 1, то для оценки границ

относительных погрешностей можно использовать следующие при

ближенные равенства:

8(а* ь•) ~ 8(а•)+ 8(Ь*), 8(а* !Ь*) ~ 8(а*)+ 8(Ь*). (2.14)

Именно равенства (2.14) чаще всего и используют для практической

оценки погрешности.

Итак, выполнение арифметических операций над приближенными

числами, как правило, сопровождается потерей точности. Единствен

ная операция, при которой потеря не происходит, - это сложение

чисел одного знака. Наибольшая потеря точности может произойти при

вычитании близких чисел одного знака.

§ 2.4. Погрешность функции

1. Погрешность функции многих переменных. Пусть f(x) =

= f(x 1, х2, •.. , хт) - дифференцируемая в области G функция т перемен

ных, вычисление которой производится при приближенно заданных зна

чениях аргументов х~, х;, "., х:. Такая ситуация возникает, например

всякий раз, когда на компьютере производится расчет по формуле. Важно

знать, каково значение неустранимой погрешности, вызванной тем, что

вместо значения у = f(x) в действительности вычисляется значение

у•= f(x•), где х• = (х~, х;, "., х: ).

Введем обозначения: пусть [х, х*] - отрезок1, соединяющий точки

х их*, и r;. = дf/дхj.

J

1 Отрезком, соединяющим точки х их' в m-мерном пространстве, называется множе

ство точек видаах + ( - а)х', О :5 а :5 .

34](https://image.slidesharecdn.com/33379-160302054853/85/33379-35-320.jpg)

![§ 2.4. Погрешность функции

Предложение 2.5. Для абсолютной погрешности значения

у• = f(x*) справедлива следующая оценка:

т

Л(у0 ) ~ L . max • 11;}х)1 Л(х;).

j=I х Е [х,х ]

(2.15)

До к аз ат ель ст в о. Оценка (2.15) вытекает из формулы конечных

приращений Лагранжа1:

т

f(x)-f(x0

) = L1; (х)(хгхj), хе [х,х0 ]. •

j=I j

Следствие. Если х• ""х, то в силу оценки (2.15) можно положить

- т -

Л(у0

)"" L 11;.(х0 ) 1Л(х/)'

j=I 1

(2.16)

- т

Л(у0 )"" L ll;}x) 1Л(х/). (2.17)

j=I

Равенство (2.16) удобно для практических оценок, а равенством

(2.17) мы воспользуемся в дальнейшем для теоретических построений.

Из (2.16), (2.17) вытекают приближенные равенства для оценки гра

ниц относительных погрешностей:

- т -

о(у*)"" 2: vjo<x/),

j=I

lxjl IJ;.(x*)/

v• = J

j lt(x0

)I '

- т -

о(у*)"" 2: vjo<xj).

j=I

(2.18)

(2.19)

Пр им ер 2.12. Пусть корни квадратного уравнения х2 + Ьх + с = О

вычисляются при значениях коэффициентов Ь "" 103, с "" 1. Каково влия

ние погрешностей задания коэффициентов на точность вычисляемых

значений?

Воспользуемся явными формулами для корней:

х1 = f(b, с)= (-Ь- ./d)l2, х2 =g(b, с)= (-Ь + ./d)!2,

где d = Ь2 - 4с.

1 Жозеф Луи Лагранж (1736--1813) - французский математик, механик и астроном.

Одии из создателей математического анализа, вариационного исчисления, классической

аналитической механики.

35](https://image.slidesharecdn.com/33379-160302054853/85/33379-36-320.jpg)

![Глава 2. Введение в элементарную теорию погрешностей

ются в виде (2.26) с нулевой мантиссой и показателем р =Ртах + l,

т.е. в виде

±оо =±(О.ООО ... О)· 2

Ртах+ 1

Символы ±сх:> ведут себя в соответствии со следующими естествен-

х

ными правилами: +сх:>+оо = +сх:>, (-l)x(+cx:>) = --<X.J, - =О для всякого

±00

+оо

числа х с плавающей точкой, =-- =±сх:> для всякого положительного

х

числах с плавающей точкой, +сх:> ЕВ х = +сх:> и т.д.

Символ NaN генерируется в случае, если результат выполняемой

операции не определен. Например 5= NaN, Д = NaN, Ох(+сх:>) = NaN,

00

+сх:> + (--СХ>) = NaN, ;;;; = NaN, NaN ЕВ х = NaN, NaN е NaN = NaN и т.д.

NaN числа представляются в виде (2.26) с ненулевой мантиссой и с

показателем р =Ртах + l.

Таким образом, IEEE арифметика замкнута относительно арифмети

ческих операций. Каждая выполняемая на компьютере операция имеет

результатом либо число с плавающей точкой, либо один из символов

+сх:>, --<X.J, NaN. Информация о возникновении символов ±сх:> или NaN

доводится до сведения пользователя выставлением индикатора особого

случая (exception flag), но работа программы при этом не прерывается.

Это позволяет разрабатывать более надежные программы. Любые два

NaN числа считаются различными. Поэтому простейший способ убе

диться в том, что х =NaN состоит в проверке свойства х *х.

Замечание. Казалось бы, результат выполнения операции о0 в

IEEE арифметике должен получить значение NaN, но в дей

ствительности принято соглашение, что о0 = l. Это соглашение

очень полезно при работе с многочленами.

§ 2.6. Допоnнитеnьные замечания

1. Более подробно приближенные числа и погрешности арифмети

ческих операций над ними изложены в известном учебном пособии

[35]. Здесь же приведены правила подсчета оставляемых значащих

цифр, которые рекомендуется применять при массовых «ручных»

вычислениях без точного учета погрешностей.

46](https://image.slidesharecdn.com/33379-160302054853/85/33379-47-320.jpg)

![§ 2.6. Дополнительные замечания

2. Дополнительную информацию об особенностях арифметических

операций над числами с плавающей точкой можно найти, например

в (23, 54, l02, 106].

3. В последнее время в практике вычислений в качестве меры

погрешности приближенного числа а• часто используют величину

1а -1а*11, объединяющую в себе черты абсолютной и относительной

1 + а

погрешностей. Она близка к Л(а*) при 1а1 « l и практически совпа

дает с 15(а*) при 1а1 » 1.

4. Информацию о IEEE стандарте можно найти в [54, 122, 5*, 15*,

20•, 24*].

5. Для уменьшения погрешностей округления иногда используется

рациональная арифметика. В ней каждое рациональное число пред

ставляется парой целых чисел (с увеличенным по сравнению со стан

дартным числом разрядов) - числителем и знаменателем. Арифмети

ческие операции над такими числами производятся как над обычными

рациональными дробями.

Рациональная арифметика реализована во многих пакетах символь

ных вычислений, например в пакетах Mathematica и MACSYMA.

6. К настоящему времени разработан интервальный анализ, даю

щий возможность заставить компьютер следить за совершаемыми

ошибками округления, чтобы затем получить гарантированные оценки

их накопления.

47](https://image.slidesharecdn.com/33379-160302054853/85/33379-48-320.jpg)

![§ 3.1. Корректность вычислительной задачи

Пр и мер 3.3. Задача о вычислении ранга матрицы в общем случае

неустойчива. В самом деле, для матрицы А = [ ~ ~] ранг равен 1,

поскольку det А = О и существует ненулевой элемент а11 = 1. Однако сколь

угодно малое возмущение коэффициента а22 на величину Е * О приводит

к матрице Аt = [~ ~] , для которой detA t = Е *О и, следовательно, ранг

равен 2. А

Пр им ер 3.4. Покажем, что задача вычисления определенного

ь

интеграла/= ffi.x) dx устойчива.

а

Пусть /*(х) - приближенно заданная интегрируемая функция и

ь

/* = ff*(x) dx. Определим абсолютную погрешность функции/* с

а

помощью равенства Л(/*} = sup lf(x)-/*(x}I, в котором знак sup

хе [а,Ь]

можно заменить на max, если f и /* непрерывны. Так как

ь

Л(/*)= IJ-J*I = lf(f(x)-/*(x))dxl ~(Ь-а)Л(/*}, (3.3)

а

то для любого Е >О неравенство Л(/*) < Е будет выполнено, если потре

бовать выполнение условия Л(/*) < S = El(b - а). .&

Пример 3.5. Покажем, что задача вычисления производной

и(х) = f'(x) приближенно заданной функции является неустойчивой.

Пусть/*(х)- приближенно заданная на отрезке [а, Ь] непрерывно

дифференцируемая функция и и*(х) = (/*)'(х). Определим абсолютные

погрешности с помощью равенств

Л(/*) = maxl /(x}-/*(x)I,

[а,Ь]

Л(и*) = maxl и(х)- u*(x)I.

[a,h]

Возьмем, например/*(х) = /(х) + аsш(х/а2 ), где О< а« .Тогда

и*(х) = и(х) + а- 1 cos(x /а2) и Л(и*) = а- 1 , в то время как Л(/*) = а.

Таким образом, сколь угодно малой погрешности задания функции f

может отвечать сколь угодно большая погрешность производной f'. .&

51](https://image.slidesharecdn.com/33379-160302054853/85/33379-52-320.jpg)

![Глава 3. Вычислительные задачи, методы и алгоритмы. Основные понятия

ные задачи некорректны. Не вызывает, например, сомнения практиче

ская важность решения некорректных задач дифференцирования и

суммирования ряда (см. примеры 3.5., 3.6). К некорректным задачам

относятся также обратные задачи геофизики, астрофизики, спектрогра

фии, многие задачи распознавания образов, задачи синтеза и ряд дру

гих прикладных задач.

К настоящему времени разработана теория решения многих классов

некорректных задач. Важная роль в создании методов решения таких

задач принадлежит российским математикам, в первую очередь

А.Н. Тихонову 1 • Эти методы (методы регуляризации) довольно сложны

и выходят за рамки данной книги. Мы ограничимся изложением в

§ 16.7 того, как метод регуляризации может быть применен в случае

некорректной задачи вычисления решения интегрального уравнения

Фредгольма первого ряда. Для первого знакомства с методами регуля

ризации можно рекомендовать учебные пособия (37, 97].

§ 3.2. Обусловленность вычислительной задачи

1. Определения. Пусть вычислительная задача корректна (ее

решение существует, единственно и устойчиво по входным данным).

Теоретически наличие у задачи устойчивости означает, что ее реше

ние может быть найдено со сколь угодно малой погрешностью, если

только гарантировать, что погрешности входных данных достаточно

малы. Однако на практике погрешности входных данных не могут быть

сделаны сколь угодно малыми, точность их ограничена. Даже то что

исходные данные нужно будет ввести в компьютер, означает, что их

относительная точность будет заведомо ограничена величиной порядка

Ем (см. § 2.5). В реальности, конечно, уровень ошибок в исходной

информации будет существенно выше. Как же повлияют малые, но

конечные погрешности входных данных на решение, как сильно спо

собны они исказить желаемый результат? Для ответа на этот вопрос

введем новые понятия.

Под обусловленностью вычислительной задачи понимают чувстви

тельность ее решения к малым погрешностям входных данных. Задачу

называют хорошо обусловленной, если малым погрешностям входных

данных отвечают малые погрешности решения, и плохо обусловленной,

если возможны сильные изменения решения.

Часто оказывается возможным ввести количественную меру степени

обусловленности вычислительной задачи - число обусловленности.

Эту величину можно интерпретировать как коэффициент возможного

1 Андрей Николаевич Тихонов (1906-1993) - российский математик, один из созда

телей теории решения некорректных задач.

54](https://image.slidesharecdn.com/33379-160302054853/85/33379-55-320.jpg)

![Глава З. Вычислительные задачи, методы и алгоритмы. Основные понятия

мере 2.11 имеем v"" J1+x*l!J1 - x•I ""7 · 105, то потеря пяти верных

значащих цифр здесь не представляется удивительной.

2. Примеры плохо обусловленных задач. Первым рассмотрим

классический приМJ:р, принадлежащий Дж. Уилкинсону 1 [102].

Пр им ер 3.8. Пусть требуется найти корни многочлена

P(x)=(x- l)(x-2) ... (х-20)=х20_21Ох19+ ...

по заданным значениям его коэффициентов. Из теории известно, что

эта задача устойчива. Возьмем коэффициент а= -210 при х 19 и изме

ним его значение на а• = -21 О + 2-23• Как повлияет эта, казалось бы,

незначительная погрешность на значения корней? Заметим, что х 1 = 1,

х2 = 2, .. " х20 =20 - точные значения корней.

Вычисленные с высокой точностью корни возмущенного много

члена таковы:

х; "" 1.00000, х; "" 2.00000, х; "" 3.00000, х; "" 4.00000,

х; ""5.00000, х~ ""6.00001, х; ""6.99970, х; ""8.00727,

х; "" 8.91725, х;0, 11 "" 10.0953 ± 0.643501 i, х;2, 13 "" 11.7936 ± l.65233i,

х;4, 15 ""13.9924±2.51883i, х;6, 17 ""16.7307±2.81262i,

х;8, 19 "" 19.5024 ± 1.94033i, х;0 ""20.8469.

Как нетрудно видеть, корни х1 , ••• , х6 оказались практически нечувстви

тельны к погрешностям в коэффициенте а. В то же время некоторые

корни превратились в комплексные и имеют относительные погрешно

сти ОТ 6 ДО 18 %, несмотря на ТО, ЧТО О(а•) "" 6 • 1О-8 %.

В данном случае нетрудно провести анализ чувствительности кор

ней. Пусть F(x, а) = х20 + ах 19 + .... Будем рассматривать корни xk как

функции параметра а, т.е. xk = xk(a). Равенство F(xk(a), а)= О, выпол

ненное в окрестности точки а = -21 О, задает xk как неявную функцию

от а. Пользуясь второй из формул (2.22) для границы относительной

погрешности и применяя формулу (2.23) для производной неявной

функции, имеем

1 Джеймс Х. Уилкинсон (1918-1986) - американский математик, внесший значи

тельный вклад в современное пони'llание вычислительных методов. О деятельности

Джеймса Х. Уилкинсона см. (54].

56](https://image.slidesharecdn.com/33379-160302054853/85/33379-57-320.jpg)

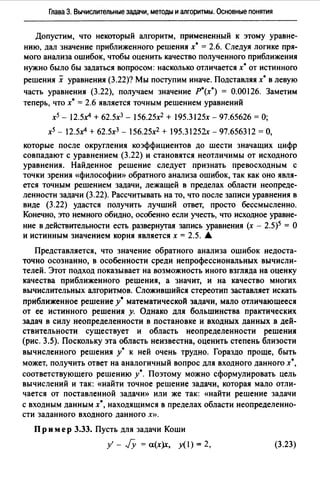

![§ 3.2. Обусловленность вычислительной задачи

у

О 1t/2 1t З1t/2 21t 51t/2 З1t х

Рис. 3.3

который можно сделать, довольно прост: при использовании функции

у = sinx желательно проводить вычисления так, чтобы аргумент нахо

дился в диапазоне 1х1 < 2, поскольку здесь v0 ~ 1. А

ь

4. Обусловленность задачи вычисления интеграла/= fЛх) dx.

а

Как следует из оценки (3.3), в этом случае абсолютное число обуслов

ленности имеет вид vл = Ь - а. Если же перейти к рассмотрению отно-

сительных погрешностей и положить fJ(f*) = sup l/*(x)-f(x)l!if(x)I

(а, Ь]

для тех, х, где /(х) *О, то используя неравенство

ь h

Л(/*) ~ ЛJ*(x)-f(x)I dx ~ JIЛx)I dx •fJ(j),

а а

получаем оценку

(3.9)

ь ь

в которой v0 = flf(x) 1dx /1 JЛх) dx 1.

а а

Если подынтегральная функция знакопостоянна, то v0 = 1 и задача

хорошо обусловлена. Если же функция f на отрезке [а, Ь] принимает

значения разных знаков, то v0 > 1. Для некоторых сильно колеблю-

щихся (осциллирующих) около нуля функций может оказаться, что

v0 » 1 и тогда задача вычисления интеграла является плохо обуслов-

ленной.

59](https://image.slidesharecdn.com/33379-160302054853/85/33379-60-320.jpg)

![§ 3.3. Вычислительные методы

сумму, то из определения определенного интеграла следует, что Jh - 1

при h - О, т.е. метод прямоугольников сходится. .А.

Пример 3.16. Учитывая определение производной функции

f(x +h)-f(x)

f'(x) = lrm h , для ее приближенного вычисления можно

h - о

/(т + h)-f(x)

использовать формулу/' (х) "' h . Погрешность аппроксима-

ции этой формулы численного дифференцирования стремится к нулю

при h - О. .А.

Одним из распространенных методов аппроксимации является дис

кретизация - приближенная замена исходной задачи конечномерной

задачей, т.е. задачей, входные данные и искомое решение которой

могут быть однозначно заданы конечным набором чисел. Для задач,

которые не являются конечномерными, этот шаг необходим для после

дующей реализации на компьютере, так как вычислительная машина в

состоянии оперировать лишь с конечным количеством чисел. В приве

денных выше примерах 3.15 и 3.16 была использована дискретизация.

Хотя точное вычисление интеграла и предполагает использование бес

конечного множества значений f(x) (для всех х Е [а, Ь]), его прибли

женное значение можно вычислить, использовав конечное число п зна

чений в точках а + (i -l/2)h. Аналогично, задача вычисления

производной, точное решение которой предполагает выполнение опе

рации предельного перехода при h - О (а следовательно, использова

ние бесконечного множества значений функции/), сводится к прибли

женному вычислению производной по двум значениям функции.

При решении нелинейных задач широко используют различные

методы линеаризации, состоящие в приближенной замене исходной

задачи более простыми линейными задачами.

Пр им ер 3.17. Пусть требуется приближенно вычислить значение х =

= Га для а > О на компьютере, способном выполнять простейшие ариф

метические операции. Заметим, что по определению х = Ja является

положительным корнем нелинейного уравнения х 2 - а= О. Пусть x<0J-

некоторое известное приближение к Ja Заменим параболу у= х2 - а пря

мой у= (x<OJ )2- а + 2х<О>(х - х<О>), являющейся касательной, проведенной

к ней в точке с абсциссой х = x<OJ (рис. 3.4). Точка пересечения этой каса

тельной с осью Ох дает лучшее, чем x<0J, приближение и находится из

63](https://image.slidesharecdn.com/33379-160302054853/85/33379-64-320.jpg)

![§ 3.4. Корректность вычислительных алгоритмов

методов, как принято считать, возник в 1949 г., когда Дж. фон Нейман 1

и С. Улам2 использовали случайные числа для моделирования с помо

щью компьютеров поведения нейтронов в ядерном реакторе. Эти

методы могут оказаться незаменимыми при моделировании больших

систем, но подробное их изложение предполагает существенное

использование аппарата теории вероятностей и математической стати

стики и выходит за рамки данной книги.

§ 3.4. Корректность вычиспитепьных апгоритмов

1. Вычислительный алrоритм. Вычислительный метод, доведен

ный до степени детализации, позволяющий реализовать его на компью

тере, принимает форму вычислительного алгоритма.

Определим вычислительный ш~горитм как точное предписание дей

ствий над входными данными, задающее вычислительный процесс,

направленный на преобразование произвольных входных данных х (из

множества допустимых для· данного алгоритма входных данных Х)

в полностью определяемый этими входными данными результат.

Реальный вычислительный алгоритм складывается из двух частей:

абстрактного вычислительного ш~горитма, формулируемого в обще

принятых математических терминах, и программы, записанной на одном

из алгоритмических языков и предназначенной для реализации алго

ритма на компьютере. Как правило, в руководствах по методам вычисле

ний излагаются именно абстрактные алгоритмы, но их обсуждение про

водится так, чтобы выявить особенности алгоритмов, которые оказывают

существенное влияние на качество программной реализации.

2. Определение корректности алrоритма. К вычислительным

алгоритмам, предназначенным для широкого использования, предъяв

ляется ряд весьма жестких требований. Первое из них - корректность

алгоритма. Будем называть вычислительный алгоритм корректным,

если выполнены три условия:

1) он позволяет после выполнения конечного числа элементарных

для вычислительной машины операций преобразовать любое входное

данное х Е Х в результат у;

1 Джон фон Нейман (1903-1957) - американский математик, физик, инженер-изо

бретатель. Оказал значительное влияние на развитие современной lатематики. Один из

создателей первых компьютеров. Историческую справку о фон Неймане см. в (54].

2 Станислав Улам (1909-1984)-американский математик. Краткий очерк о ero дея

тельности можно найти в (54].

69](https://image.slidesharecdn.com/33379-160302054853/85/33379-70-320.jpg)

![§ 3.4. Корректность вычислительных алгоритмов

4. Вычислительная устойчивость. Из-за наличия погрешностей

округления при вводе входных данных в компьютер и при выполнении

арифметических операций неизбежно появление вычислительной

погрешности. На разных компьютерах она различна из-за различий в раз

рядности и способах округления, но для фиксированного алгоритма в

основном значение погрешности определяется машинной точностью Ем.

Назовем алгоритм вычислительно устойчивым, если вычислитель

ная погрешность результата стремится к нулю при Ем --+ О. Обычно

вычислительный алгоритм называют устойчивым, если он устойчив по

входным данным и вычислительно устойчив, и - неустойчивым, если

хотя бы одно из этих условий не выполнено.

Пр им ер 3.26.1 Пусть требуется составить таблицу значений инте-

1

гралов In = Jxn е 1 -х dx для п = 1, 2, ".на 6-разрядном десятичном ком

о

пьютере.

Интегрируя по частям, имеем

1 1 1

/п= Jxnd(-e 1 -x)=-xnel-xj~+ Je1-.td(x")=-l+ Jnx11 - 1 e1-xdx.

о о о

Следовательно, справедлива формула

Кроме того,

1

10 = J е 1 -х dx=e-1"'/~=1.71828.

о

(3.17)

Воспользуемся формулой (3.17) для последовательного вычисления

приближенных значений интегралов /п:

11"'/~=11~ -1 = 0.71828;

13 "' 1; = 31; - 1 = о.30968;

15 "'1; = 51;-1 = 0.19360;

17"'!;=11;-1 =0.13120;

19"' 1; = 91;- 1 = -0.55360;

12 "' 1; = 21~ - 1 = 0.43656;

14 "' 1; = 41; - 1 = 0.23872;

16 "'1;=61;-1 =О.16160;

fg "' 1; = 81;- 1 = 0.04960;

/ 10 "' 1~0 = 101;- 1 = -6.5360.

1 Идея примера заимствована нз [5, 106].

71](https://image.slidesharecdn.com/33379-160302054853/85/33379-72-320.jpg)

![§ 3.5. Чувствительность вычислительных алгоритмов к ошибкам округления

жется наименьшей, если суммировать числа в порядке возрастания их

значений, начиная с наименьшего.

Иногда неудачно выбранный порядок операций либо приводит к

полной потере точности, либо вообще не дает возможности получить

результат из-за переполнения.

Пр им ер 3.29. Пусть на компьютере типа IBM РС требуется вычис

лить произведение v = а0 х а1 х а2 х ... х а49 х а50, где а;"' 1025 - i. Если

производить вычисления в естественном порядке, то уже а0 х а1 "' 1044

даст значение, равное +оо. Вычисление произведения в обратном порядке

сразу же приводит к исчезновению порядка, так как а50 х а49 "' 10-49 < Х0 .

В данном случае вполне приемлем следующий порядок операций: v =

= а0 х а50 х а 1 х а49 х ... х а24 х а26 х а25, исключающий возможность

переполнения или антипереполнения. ~

2. Катастрофическая потеря точности. Иногда короткая последо

вательность вычислений приводит от исходных данных, известных

с высокой точностью, к результату, содержащему недопустимо мало

верных цифр или вообще не имеющему ни одной верной цифры.

В этом случае, как было отмечено в§ 3.2, принято говорить о катастро

фической потере точности.

Пр и мер 3.301• Известно, что функция ех может быть представлена

в виде сходящегося степенного ряда:

оо xk х2 хз

еХ=""' -=l+x+-+-+

~ k' 2' 31k=O • . •

+~+

п'.

(3.20)

Возможность вычисления значения экспоненты прямым суммиро

ванием ряда (3.20) кажется привлекательной. Пусть для вычислений

используется 6-разрядный десятичный компьютер. Возьмем х = -8.1

и будем вычислять значения частичных сумм до тех пор, пока добавле

ние очередного слагаемого еще меняет значение суммы:

е-8.1"' 1.00000 е 8.10000 Е9 32.8050 е 88.5737 Е9 179.362 е 290.566 Е9 ...

••• Е!) 16.4111 87.81941 Е!) ••• =0.000649915.

В сумму вошло 36 слагаемых и значение очередного (37-го) слагае

мого оказалось уже не в состоянии изменить результат. Можно ли счи

тать результат удовлетворительным? Сравнение с истинным значением

е-8.1 "' 0.000303539 показывает, что найденное значение не содержит ни

одной верной цифры.

'Идея примера заимствована нз [106].

75](https://image.slidesharecdn.com/33379-160302054853/85/33379-76-320.jpg)

![Глава З. Вычислительные задачи, методы и алгоритмы. Основные понятия

(для х < О) приводит к резкому ухудшению обусловленности вычисле

ний. Для х =-8.1, как в примере 3.30, имеем v15 =е 1 6 2 ~ 107• Поэтому

неудивительна полная потеря точности при вычислениях на 6-разряд

ном десятичном компьютере.

Рассмотрим теперь обусловленность алгоритма прямого вычисления

по формуле (3.21 ). При малых х вычисленные приближения с~ ~ cos х

и с;~ cos 2х содержат погрешности порядка Ем. Поэтому Л(у*} - 2Ем.

Учитывая, что у ~ 1.5х2 , находим оценку границы относительной

погрешности б (у*} - х-1 Ем. Число обусловленности v - х-1 быстро

растет с уменьшением 1х1. Уже при 1х1 .$ F,. эта оценка дает

б(у*) >> 1, т.е. говорит о катострофической потере точности.

Если алгоритм, предназначенный для решения хорошо обусловленной

задачи, оказался плохо обусловленным, то его следует признать неудов

летворительным и попытаться построить более качественный алгоритм.

В примерах 3.30 и 3.31 это удалось сделать сравнительно легко.

Однако для плохо обусловленных задач дело обстоит иначе. Ключ

к пониманию дает следующее высказывание [81]: «Если задача плохо

обусловлена, то никакие усилия, потраченные на организацию изо

щренных вычислений, не могут дать правильных ответов, исключая

случайности». Здесь требуется серьезное переосмысление постановки

вычислительной задачи.

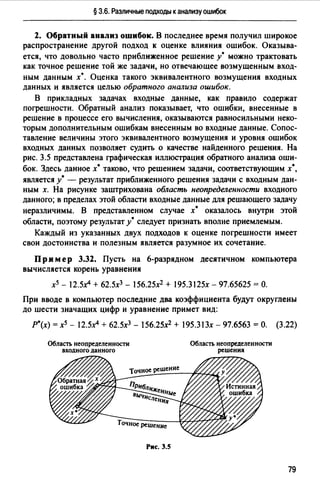

§ 3.6. Различные подходы к анализу оwибок

1. Прямой анализ ошибок. Общий эффект влияния ошибок обычно

учитывают следующим образом. Изучают воздействие ошибок выходных

данных, метода и округлений на получаемый результат у• и пытаются

оценить некоторую меру близости у• к истинному решению у. Такой

метод исследования называют прямым анализом ошибок. В большинстве

случаев в данной книге мы будем следовать этому традиционному пути.

Во многих (но далеко не во всех) случаях оценки погрешности удается

получить; однако довольно часто они оказываются сильно завышенными

и приводят к неоправданному пессимизму в оценке качества приближен

ного решения. Реальное значение погрешности у - у• часто значительно

меньше, чем ее оценка, рассчитанная на самый неблагоприятный случай

и выведенная с помощью прямого анализа. Особенно трудным является

прямой анализ вычислительной погрешности.

78](https://image.slidesharecdn.com/33379-160302054853/85/33379-79-320.jpg)

![Глава 3. Вычислительные задачи, методы и алгоритмы. Основные понятия

3. Противоречивость требований. Можно продолжить перечисле

ние требований к вычислительным алгоритмам, добавив, например

требования универсальности и гибкости. Однако нетрудно понять, что

сформулированные требования противоречивы. Большинство из них

вступает в противоречие с экономичностью, выраженной через затраты

машинного времени. В разных ситуациях на первый план может высту

пать то или иное требование и, удовлетворяя в большей степени одним

требованиям, программа с неизбежностью в меньшей степени удовле

творяет другим. Это частично объясняет наличие большого числа про

грамм, предназначенных для решения одной и той же задачи.

Естественно, что хорошая программа, которую можно предъявить

для широкого использования, не может быть простой. Следует при

знать, что составление таких программ - это работа, требующая высо

кой квалификации и специальных знаний. Ее выполняют специалисты

по созданию математического обеспечения компьютеров. Рядовой

пользователь должен по возможности стремиться максимально исполь

зовать стандартные программы, а не создавать новые.

§ 3.8. Допопнитепьные замечаниw

Учебные пособия [97, 37] можно рассматривать как введение в тео

рию методов решения некорректных задач. Их удачно дополняют сле

дующие книги [7, 72, 98]. Отметим, что [98] содержит не только теорию

и алгоритмы, но и тексты соответствующих программ.

2 Весьма содержательное изложение проблемы обусловленности

вычислительных задач и обратного анализа ошибок содержится в (81).

Здесь же подробно обсуждаются проблема создания высококачествен

ного математического обеспечения и требования, предъявляемые к

вычислительным алгоритмам.

86](https://image.slidesharecdn.com/33379-160302054853/85/33379-87-320.jpg)

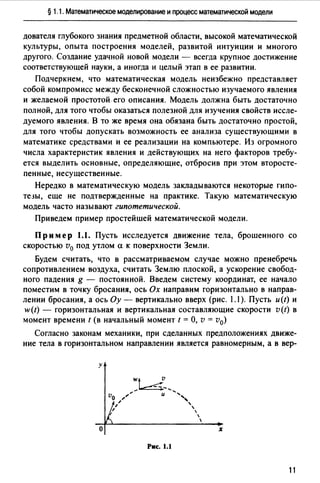

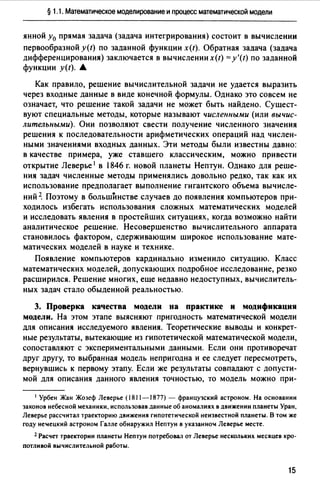

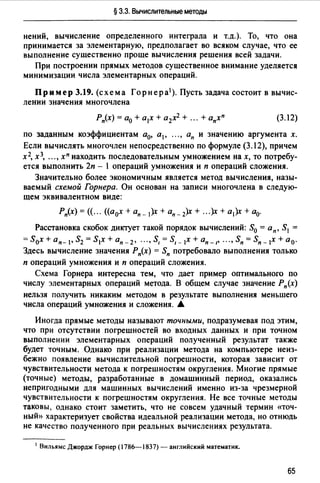

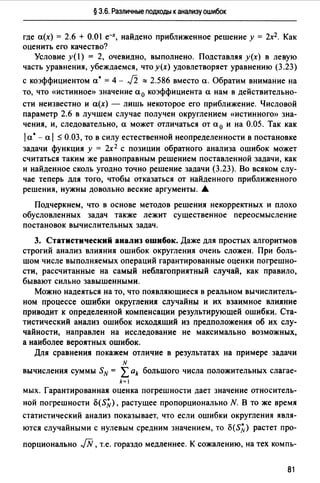

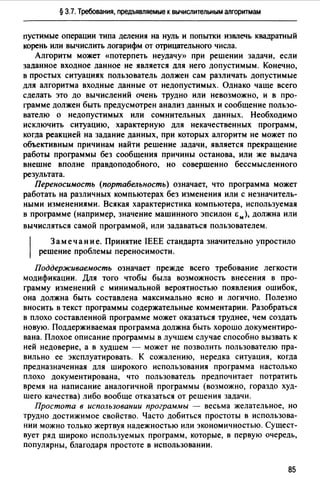

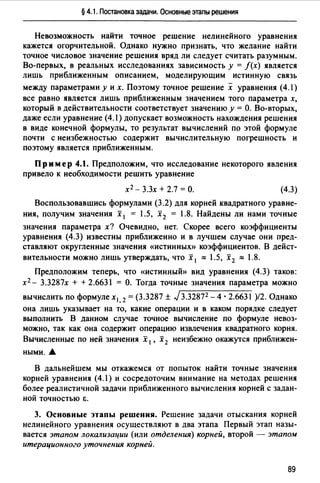

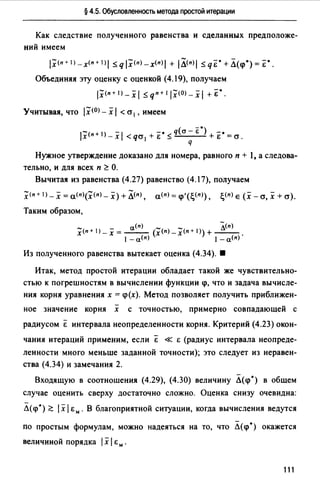

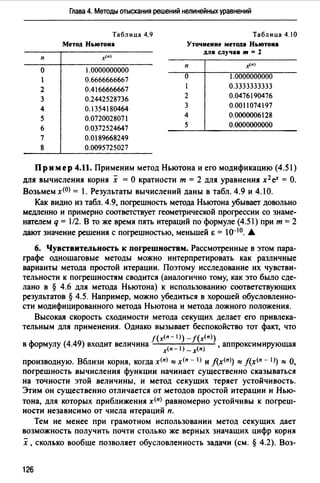

![Глава 4. Методы отыскания решений нелинейных уравнений

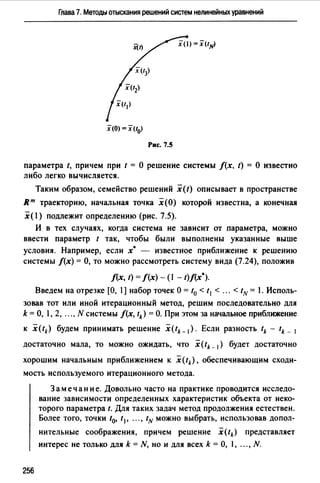

у

х

Рис. 4.1

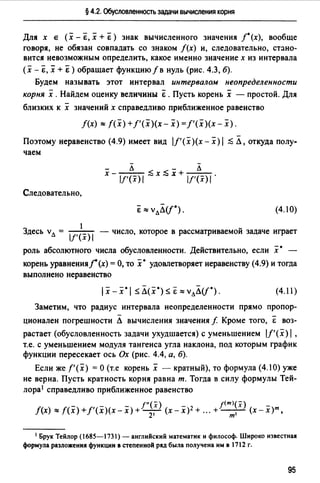

углом. Функция f(x), график который изображен на рис. 4.1, имеет

четыре корня. Корни х 1 и х3 - простые, х2 и х4 - кратные.

Задача отыскания простых корней является существенно более

простой (и чаще встречающейся), чем задача отыскания кратных кор

ней В действительности большинство методов решения уравнения

(4.1) ориентировано именно на вычисление простых корней.

2. Уточнение постановки задачи. В конкретной задаче часто инте

рес представляют не все корни уравнения, а лишь некотор1;.1е из них.

Тогда постановку задачи уточняют, указывая на то, какие из корней

подлежат определению (положительные корни, корни из заданного

интервала, максимальный из корней и т.д.).

В подавляющем большинстве случаев представить решение уравне

ния (4.) в виде конечной формулы оказывается невозможным. Даже

для простейшего алгебраического уравнения п-й степени

(4.2)

явные формулы, выражающие его корни через коэффициенты с помо

щью конечного числа арифметических операций и операций извлече

ния корней степени не выше п, найдены 1 лишь при п = 2, 3, 4. Однако

уже для уравнений пятой и более высоких степеней таких формул не

существует. Этот замечательный факт, известный как теорема Абеля,

был установлен в 30-е годы XIX в. Н. Абелем 2 и Э. Галуа 3.

1 Алгебраические уравнения третьей и четвертой степеней не поддавались усилиям

математиков около 2000 лет. Эту задачу решили итальянские математики эпохи Ренес

санса Сципион дель Ферро (1456-1526), Никколо Тарталья (1500--1557), Джироламо

Кардано (1501-1576), Людовико Феррари (1522-1565).

2 Нильс Хенрик Абель (1802-1829) - норвежский математик. Теорема, о которой

идет речь, была доказана им в возрасте около 22 лет.

3 Эварист Га ~уа (1811-1832) - французский математик, один из создателей теории

групп. Убит на дуэли в возрасте 21 года. Краткий очерк о его жизни см. в [54].

88](https://image.slidesharecdn.com/33379-160302054853/85/33379-89-320.jpg)

![Глава 4. Методы отыскания решений нелинейных уравнений

Локализация корней. Отрезок [а, Ь], содержащий только один

корень х уравнения (4.1 ), называют отрезко.u локализации корня х.

Цель этапа локализации считают достигнутой, если для каждого из

подлежащих определению корней удалось указать отрезок локализации

(его длину стараются по возможности сделать минимальной).

Прежде чем переходить непосредственно к отысканию отрезков

локализации, имеет смысл провести предварительное исследование

задачи для выяснения того, существуют ли вообще корни уравнения

(4.1 ), сколько их и как они расположены на числовой оси.

Способы локализации корней многообразны, и указать универсаль

ный метод не представляется возможным. Иногда отрезок локализации

известен либо он определяется из физических соображений. В простых

ситуациях хороший результат может давать графический метод (см. при

мер 4.2). Широко применяют построение таблиц значений функций f

вида У;= f(x; ), i = 1, 2, ..., п. При этом способе локализации о наличии на

отрезке [х; _1, х;] корня судят по перемене знака функции на концах

отрезка (см. пример 4.3). Основанием для применения указанного спо

соба служит следующая хорошо известная теорема математического ана

лиза.

Теорема 4.1. Пусть функция/непрерывна на отрезке [а, Ь] и при

нимает на его концах значения разных знаков, т.е. f(a) · f(b) < О. Тогда

отрезок [а, Ь] содер:ж:ит по крайней мере один корень уравнения f(x) =О. •

К сожалению, корень четной кратности не удается локализовать на

основании перемены знака с помощью даже очень подробной таблицы.

Дело в том, что в малой окрестности такого корня (например, корня х 2

на рис. 4.1) функция f имеет постоянный знак.

Важно подчеркнуть, что далеко не всегда для успешного отыскания

корня х уравнения (4.1) необходимо полное решение задачи локализа

ции. Часто вместо отрезка локализации достаточно найти хорошее

начальное приближение х<О) к корню х .

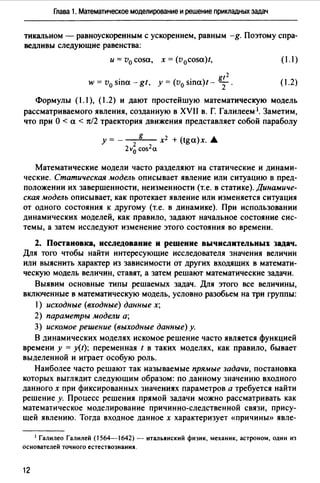

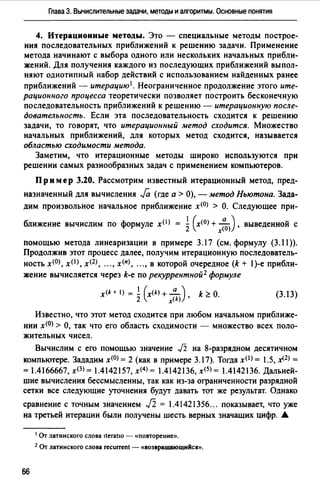

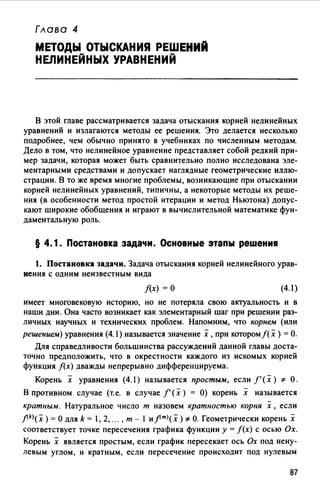

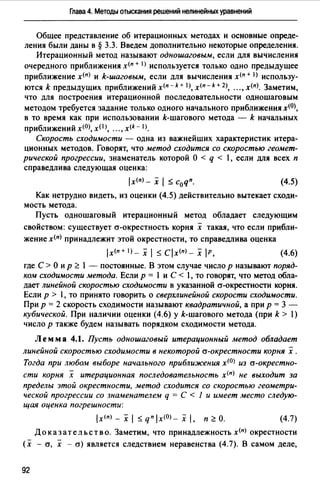

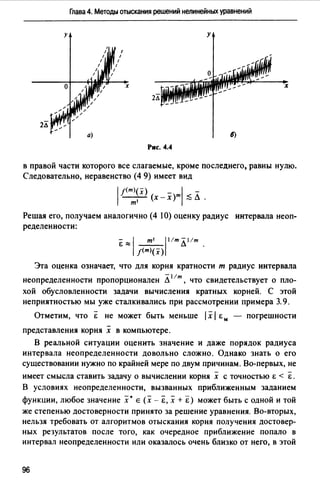

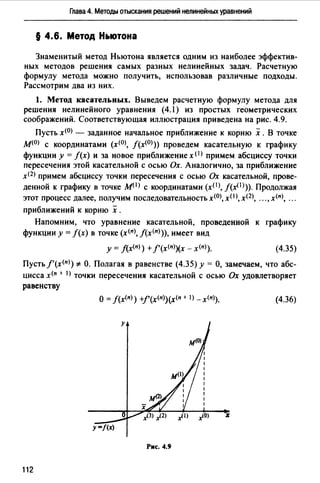

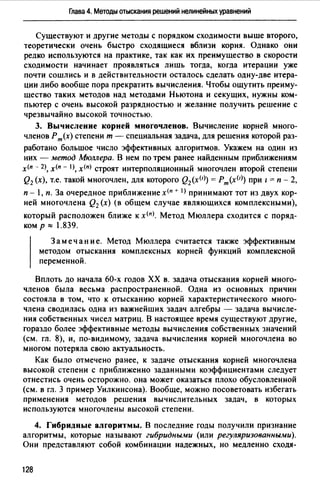

Пр им ер 4.2. Локализуем корни уравнения

4(1-х 2 )-ех=о. (4.4)

Для этого преобразуем уравнение к виду 1 - х2 = 0.25 ех и построим

графики функций у = 1 - х2 и у = 0.25 еХ (рис. 4.2). Абсциссы точек

пересечения этих графиков являются корнями данного уравнения. Из

рис. 4.2 видно, что уравнение имее'f два корня х 1 и х2 , расположенные

на отрезках [-1, О] и [О, 1]. Убедимся, что функция f(x) = 4(1 - х2)- ех

90](https://image.slidesharecdn.com/33379-160302054853/85/33379-91-320.jpg)

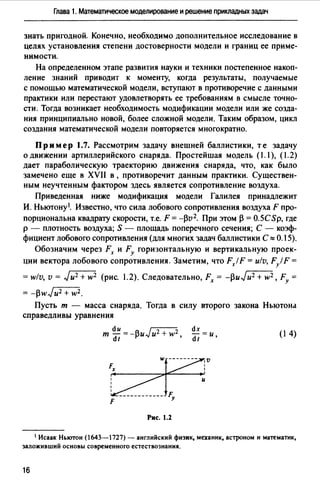

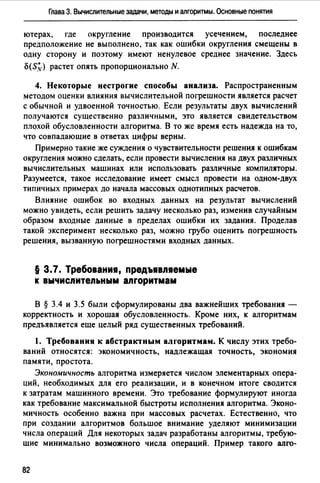

![§ 4.1. Постановка задачи. Основные этапы решения

у

х

Рис. 4.2

принимает на концах указанных отрезков значения разных знаков. Дей

ствительно, /(-1) = -е-1 <О, /(О)= 3 >О, /(1) =-е <О.

Следовательно, в силу теоремы 4.1 на каждом из отрезков [-1, О]

и [О, 1] находится по крайней мере один корень. •

Пр им ер 4.3. Локализуем корни уравнения

хз - l.lx2- 2.2х + 1.8 =О.

Для этого составим таблицу значений функции f(x) = хз - l. Jx2 -

- 2.2х + 1.8 на отрезке [-2, 2] с шагом 0.4 (табл. 4.1 ).

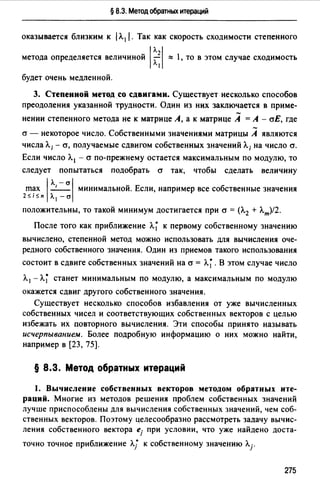

Таблица 4.1

х -2.0 -1.6 -1.2 -{),8 -{).4 О.О

f(x) -6.200 -1.592 1.128 2.344 2.440 1.800

Продолжение табл. 4. 1

х 0.4 0.8 1.2 1.6 2.0

f(x) 0.808 -0.152 -0.696 -0.440 1.000

Из таблицы видно, что функция f меняет знак на концах отрезков

[-1.6, -1.2], [0.4, 0.8], [1.6, 2.0]. Теорема 4.1 дает основание утверждать,

что каждый из этих отрезков содержит по крайней мере один корень.

Учитывая, что в силу основной теоремы алгебры многочлен третьей

степени не может иметь более трех корней, заключаем, что полученные

три отрезка содержат ровно по одному корню. Таким образом, корни

локализованы. •

Итерационное уточнение корней. На этом этапе для вычис

ления каждого из корней с точностью Е > О используют тот или иной

итерационный метод, позволяющий построить последовательность

х<0>, хО>, "., х<11>, ".приближений к корню х.

91](https://image.slidesharecdn.com/33379-160302054853/85/33379-92-320.jpg)

![§ 4.3. Метод бисекции

ситуации вычисления следует прекратить и считать, что получен мак

симум действительно возможного.

Для большинства итерационных методов определить этот момент

можно, поскольку начиная с него поведение приближений х<п) стано

вится крайне нерегулярным. Если вдали от интервала неопределенно

сти величина

lx(n) _x(n-1)1

q(n) = -'------'-

1х<п-1) - х<п - 2) 1

(4.12)

обычно бывает меньше единицы ( /х<п) - х<п - I) 1 < 1х<п - 1>- х<п - 2) 1), то

появление при некотором п значения q<11J > 1 свидетельствует, скорее

всего, о начале «разболтки» - хаотического поведения итерационной

последовательности. В этой ситуации вычисления имеет смысл пре

рвать, чтобы выяснить причину явления и принять правильное реше

ние. Лучшим из полученных приближений к решению следует считать,

конечно, х<п - 1J. Использование для контроля вычислений величины

(4.12) называют часто правилом Гарвика.

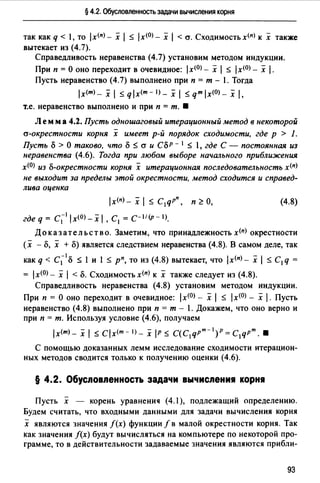

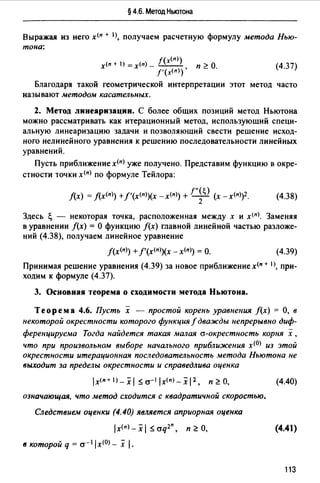

§ 4.3. Метод бисекции

1. Описание метода. Пусть требуется с заданной точностью Е > О

найти корень х уравнения (4.1). Отрезок локализации (а, Ь] (т.е. отре

зок, содержащий только один корень х) будем считать заданным.

Предположим, что функция/непрерывна на отрезке (а, Ь] и на его кон

цах принимает значения разных знаков, т.е.

f(a)f(b) <О. (4.13)

На рис. 4.5 изображен случай, когда /(а)< О и /(Ь) >О.

Для дальнейшего будет удобно обозначить отрезок [а, Ь] через

[а<0>, ь<0>]. Примем за приближенное значение корня середину отрезка -

Рис. 4.5

97](https://image.slidesharecdn.com/33379-160302054853/85/33379-98-320.jpg)

![Глава 4. Методы отыскания решений нелинейных уравнений

точку x<OJ = (a<OJ + ь<О>)/2. Так как положение корня х на отрезке

[a<OJ, ь<0>] неизвестно, то можно лишь утверждать, что погрешность

этого приближения не превышает половины длины отрезка (рис. 4.5):

lx(O) - х 1 ~ (Ь(О) _ а<О>)/2.

Уменьшить погрешность приближения можно, уточнив отрезок

локализации, т.е. заменив начальный отрезок [а<0>, ь<0>] отрезком

[аО>, ь<I)] меньшей длины. Согласно методу бисекции (половинного

деления) в качестве [aOJ, ь< 1 >] берут тот из отрезков [а<О>, х<О>] и [х<О>,

ь<0>], на концах которого выполняется условие /(a(l>)f(b<1>) ~ О. Этот

отрезок содержит искомый корень. Действительно, если fla(l>)flb(I)) <О,

то наличие корня следует из теоремы 4.1; если же f(a(l>)f(bO>) =О, то

корнем является один из концов отрезка. Середина полученного

отрезка x(I) = (a(I) + ЬО>)/2 дает теперь приближение к корню, оценка

погрешности которого составляет

lx<1>- х 1 ~ (b(l)_a(l>)/2 = (Ь - а)/22 •

За очередное уточнение отрезка локализации [ащ, ь<2>] снова берут

тот из отрезков [a(I>, x(I>], [х< 1 >, ь(I>], на концах которого выполняется

условие f(a<2>)f(b<2>) ~ О.

Опишем очередную (п + 1)-ю итерацию метода. Пусть отрезок

[а<п>, ь<п>] уже найден и вычислены значения х<п>, f(а<п>), f(Ь<п>). Тогда

производят следующие действия:

1°. Вычисляют f(x(n) ).

2°. Если f(a<n>)f(x<n>) ~ О, то в качестве отрезка локализации

[а<п+ 1), ь<п+ 1)] принимают отрезок [а<п>, х<п>]. в противном случае

f(x(n))f(b(n>) <о и за [а<п + 1>, ь<п +I)] принимают отрезок [х<п>, ь<п>].

3°. Вычисляют х<п + 1>= (а<п +I) + ь<п + 1))/2.

Неограниченное продолжение итерационного процесса дает после

довательность отрезков [а(О), Ь(О)], (a(I), b(I)], "., [а<п>, Ь(п)], .",содержа

щих искомый корень. Каждый из них (за исключением начального)

получен делением пополам предыдущего отрезка.

2. Скорость сходимости. Середина п-го отрезка - точка х<п> =

= (а<п> + ь<п>)/2 дает приближение к корню х, имеющее оценку погреш

ности

(4.14)

Из этой оценки видно, что метод бисекции сходится со скоростью

геометрической прогрессии, знаменатель которой q = 1/2. По сравне

нию с другими методами метод бисекции сходится довольно медленно.

98](https://image.slidesharecdn.com/33379-160302054853/85/33379-99-320.jpg)

![§4.3. Метод бисекции

Однако он очень прост и весьма непритязателен; для его применения

достаточно, чтобы выполнялось неравенство (4.13), функция f была

непрерывна и верно определялся ее знак. В тех ситуациях, где не нужна

сверхвысокая скорость сходимости (а это часто имеет место при про

стых прикладных расчетах), этот метод весьма привлекателен.

Заметим, что число итераций, которое требуется при применении

метода бисекции для достижения разумной точности Е, не может быть

очень большим. Например, для уменьшения первоначального отрезка

локализации в 106 раз нужно 19 итераций.

3 а меч ан и е. Интересно, что при выполнении условия (4.13)

метод бисекции сходится даже, если на отрезке [а, Ь] находится не

один, а несколько корней уравнения f(x) = О. В результате приме

нения метода будет найден один из этих корней.

3. Критерий окончания. Итерации следует вести до тех пор,

пока не будет выполнено неравенство ь<п> - а<п> < 2Е. При его выпол

нении в силу оценки (4.14) можно принять х<п> за приближение к

корню с точностью Е.

Пр им ер 4.4. Найдем методом бисекции с точностью Е = 10-2 поло

жительный корень уравнения 4( 1 - х2) - ех = О.

В примере 4.2 этот корень был локализован на отрезке [О, 1], причем

/(0) > О, f( 1) < 0. Положим а(О) = 0, Ь(О) = 1, х(О) = (а(О) + Ь(О))/2 = 0.5.

1-я итерация. Вычисляемf(х<0>):::: 1.3512. Так какf(а(О))j(х<0>) >О,

то за очередной отрезок локализации принимаем [а(!>, b(I)] = [0.5, 1].

Вычисляем x(IJ = (а< 1 1 + b(I >)/2 = 0.75.

2-я итерация. Вычисляемf(хО>) ::::-0.3670. Так какf(аО>)J(хО>) <

<О, то [а<2), Ь(2)] = [0.5, О. 75] и х<2) = (а<21 + Ь(21)/2 = 0.625.

Результаты следующих итераций (с четырьмя цифрами после деся

тичной точки) приведены в табл. 4.2.

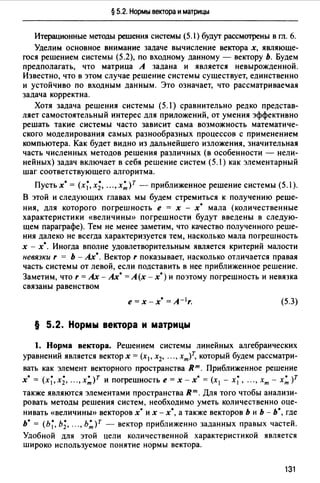

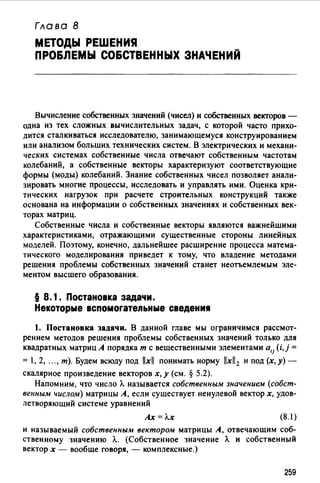

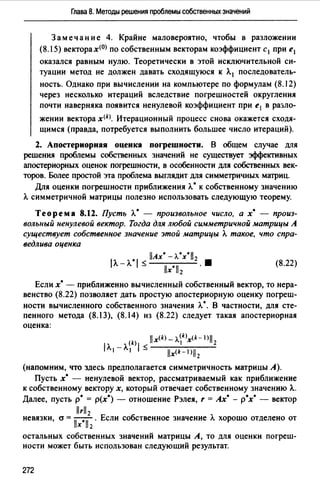

Таблица 4.2

Номер ите- Знак

a(n) Ь(•) _x{n) л:х<•)> Ь(п) _ a(n)

рации k f(d")) f(b("))

о 0.0000 1.0000 + - 0.5000 1.3513 1.0000

1 0.5000 1.0000 + - 0.7500 -0.3670 0.5000

2 0.5000 0.7500 + - 0.6250 0.5693 0.2500

3 о 6250 0.7500 + - 0.6875 0.1206 0.1250

4 0.6875 0.7500 + - 0.7187 -0.1182 0.0625

5 0.6875 0.7187 + - 0.7031 0.0222 0.0312

6 0.7031 0.7187 + - 0.7109 - 0.0156

99](https://image.slidesharecdn.com/33379-160302054853/85/33379-100-320.jpg)

![Глава 4. Методы отыскания решений нелинейных уравнений

При п = 6 имеем Ь(б) -а<б)"' 0.0156 < 2 • 10-2. Следовательно, задан

ная точность достигнута и можно принять х :::ох<6>. Окончательно полу

чим х = 0.71 ±О.О . .А

4. Влияние вычислительной погрешности. При использовании

метода бисекции принципиально важным является правильное опреде

ление знака функции f В случае, когда х<п> попадает в интервал неоп

ределенности корня (см. § 4.2), знак вычисленного значения] (x<n>) не

обязан быть верным, и последующие итерации не имеют смысла.

Однако этот метод следует признать очень надежным; он гарантирует

точность приближения, примерно равную радиусу интервала неопреде-

ленности &. Как было отмечено в § 4.3, большего требовать нельзя.

§ 4.4. Метод простой итерации

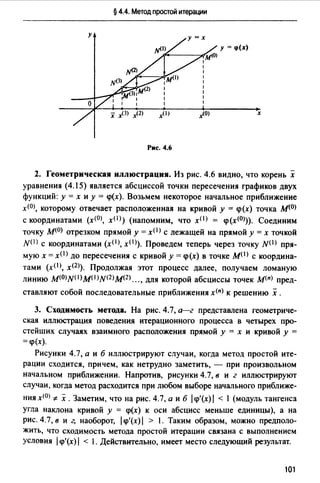

1. Описание метода. Чтобы применить метод простой итерации

для решения нелинейного уравнения (4.1 ), необходимо преобразовать

это уравнение к следующему виду:

х = <р(х). (4.15)

Это преобразование (приведение уравнения к виду, удобному для итера

ций) можно выполнить различными способами; некоторые из них будут

указаны ниже. Функцию <р далее будем называть итерационной функ

цией.

Выберем каким-либо образом приближенное значение корня х<0>

и подставим его в правую часть уравнения (4.15). Получим значение

х< 1 > = <р(х<0>). Подставляя теперь х< 1 > в правую часть уравнения (4.15),

имеем х<2> = <р(х< 1 >). Продолжая этот процесс неограниченно, получаем

последовательность приближений к корню, вычисляемых по формуле

х<п + 1) = <p(x<n>), п ~ О. (4.16)

Очевидно, что метод простой итерации - одношаговый (см. § 4.1).

Если существует предел построенной последовательности х =

lim х<п), то, переходя к пределу в равенстве (4.16) и предполагая

функцию <р непрерывной, получаем равенство

х=<р(х).

Это значит, что х - корень уравнения (4.15).

100

(4.17)](https://image.slidesharecdn.com/33379-160302054853/85/33379-101-320.jpg)

![Глава 4. Методы отыскания решений нелинейных уравнений

Если это условие выполнено, то найденное значение х<п> является при

ближением к х с точностью Е.

Пр им ер 4.5. Используем метод простой итерации для вы числе

ния положительного корнях уравнения4(1 -х 2)-ех =О с точностью

Е = 10-4• Результат примера 4.4 дает для корня отрезок локализации

[а, Ь] = (0.70, 0.72).

Преобразуем уравнение к виду (4.15), где q>(x) = J1- ех/ 4. Заме

тим, чтоq>'(х) = -ex/(8JI -ex/4),q>"(x) =-ex(1-ex/8)/(8J1 -ех/4)3 .

Так как q>" < О на [а, Ь], то производная q>' монотонно убывает и q =

= maxlq>'(x)I =q>'(b)"" 0.37. Следовательно, условие сходимости (4.18)

[а,Ь]

выполнено. Возьмем х<0> = О.7 и будем вести итерации до выполнения

критерия (4.23). В табл. 4.3 соответствующие приближения приведены

с десятью знаками мантиссы.

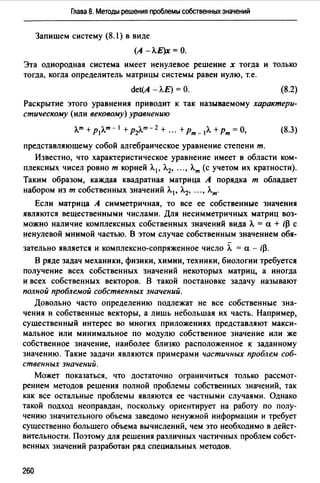

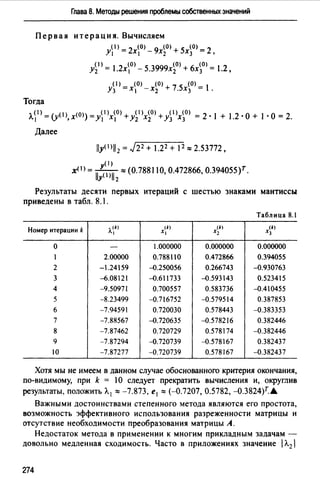

п

о

2

3

4

5

х<п)

0.7000000000

0.7046714292

о.7029968319

0.7035984939

о. 7033824994

0.7034600632

Таблица 4.3

3. 10-з

1·10-3

4· J0--4

2· 10--4

5 • 10-5

Критерий окончания выполняется при п = 5. После округления зна

чения х<5> до четырех значащих цифр получим х = О.7035 ± О.ООО1. .&

104

Замечание. Часто в практике вычислений вместо критерия

(4.23) используется привлекательный своей простотой критерий

lx(n)_x(n-) 1 <Е. (4.24)

В случае О < q ~ 1/2 использование критерия (4.24) оправдано.

Действительно, здесь (1 - q)/q ~ 1 и поэтому выполнение неравен

ства (4.24) влечет за собой выполнение неравенства (4.23).

В то же время при 1/2 < q < 1 использование критерия (4.24)

может привести к преждевременному прекращению итераций.

Дело в том, что когда значение величины q близко к единице, ите

рационный процесс сходится медленно и расстояние между двумя

последовательными приближениями х<п) и х<п - I) не характеризует

расстояние от х<пl до решения х (рис. 4.8).](https://image.slidesharecdn.com/33379-160302054853/85/33379-105-320.jpg)

![Глава 4. Методы отыскания решений нелинейных уравнений

где ~(п) - промежуточная между х<п - I) и х<п - 2> точка, имеем

x<n) _x(n-1) - _

(i(n) = <р'(~(п)):::;<р'(х).

х<п-1>-х<п-2)

Таким образом, в равенстве (4.22) можно положить а<п> "" (i<п> и

поэтому при определенных условиях можно использовать следующий

практический критерий окончания итерационного процесса:

lх<п>-х<п-1)1~11 ::a<n)IE.

а(п)

S. Дополнительные сведения о характере сходимости. Когда про

изводная <р' знакопостоянна на отрезке локализации, итерационная

последовательность обладает некоторыми полезными дополнитель-

ными свойствами. Заметим, что при <р'(х) * О в достаточно малой

окрестности корня знак производной <р'(х) действительно постоянен.

Теорем а 4.4. Пусть [а, Ь] - отрезок локализации корня уравнения

(4.15). Предположим, что на этом отрезке функция <р непрерывно

дифференцируема, а ее производная <р'(х) знакопостоянна и удовлетво

ряет неравенству (4.18) при О< q < 1. Пусть х<0> Е [а, Ь] - произволь

ное начальное приближение и при <р' < О выполнено дополнительное

условие х< 1 > = <р(х<0>) Е [а, Ь] (первое приближение не выходит за пре

делы отрезка локализации).

Тогда итерационная последовательность не выходит за пределы

отрезка [а, Ь], метод простой итерации сходится и верны оценки погреш

ности (4.19), (4.21). Краме того, справедливы следующие свойства:

1°. Если <р' >О на [а, Ь], тох<п) сходится к х, монотонно возрастая

при а ~ х<О) < х ,и монотонно убывая при х < х<О) ~ Ь.

2°. Если <р' <О на [а, Ь], то сходимостьх<п) к х носит колебатель

ный характер, т.е. при всех п ~ О значения х<п) и х<п + 1) расположены

по разны1: стороны от х, причем последовательности приближений

с четными и нечетными номерами сходятся к х монотонно. В этом

случае верна апостериорная оценка погрешности

lx(n)_ х 1 ~ lx<nJ_x(n- l)I, п ~ 1 (4.25)

и справедлив критерий (4.24) окончания итерационного процесса.

Мы не будем приводить здесь полное доказательство теоремы. Оно

основано на использовании равенства (4.20), установленного при доказа

тельстве теоремы 4.2. Докажем только справедливость свойств 1° и 2°.

106](https://image.slidesharecdn.com/33379-160302054853/85/33379-107-320.jpg)

![§ 4.4. Метод простой итерации

Доказательство. Если О < q>' ::; q, то знаки величин х<п> - х

и х<п - I) - х совпадают, в то время как lx(n)_ х 1::; q /х<п- I) _ х 1. Сле

довательно, последовательность монотонно приближается к х с той

стороны, где лежит х<0>. Если же -q < q>' <О, то из равенства (4.20) сле

дует, что знаки величин х<п> - х и х<п - 1>- х различны. Это подтвер

ждает колебательный характер сходимости. •

Замечание. Монотонный и колебательный характер сходимо

сти итерационной последовательности, указанные в теореме 4.4,

иллюстрируют соответственно рис. 4.7, а и 6.

6. Приведение уравнения к виду, удобному для итераций. Клю

чевой момент в применении метода простой итерации - эквивалент

ное преобразование уравнения (4.1) к виду (4.15). Конечно, такое пре

образование имеет смысл только тогда, когда оказывается

выполненным условие (4.18) с О< q < 1. Укажем один из простых спо

собов такого преобразования.

Предположим, что производная f' на отрезке [а, Ь] непрерывна

и положительна. Тогда существуют положительные постоянные т и М

такие, что О< т::; f(x)::; М, хе [а, Ь]. Приведем уравнение (4.1) к виду

х = х - af(x), (4.26)

где а > О. Здесь итерационная функция q> имеет вид q>(x) = х - af(x).

Как выбрать а, чтобы выполнялось условие (4.18), причем q было бы

по ВОЗМОЖНОСТИ минимальным?

Заметим, что 1 - аМ ::; q>'(x) = 1 - af' (х) ::; 1 - ат и поэтому

lч>'(x)I::; q(a) = max{ l 1-aMI, l I -aml }. Для того чтобы было выпол

нено неравенство q(a) < 1, достаточно взять любое а е (0,2/М). Кон

кретный выбор параметра а зависит от наличия информации о числах т

и М. Если известны обе эти величины, то лучшим является выбор а =

=а 0 = 2/(М+ т). В этом случае q(a0 )=(M-m)/(M+ т). Если же известно

только М, то можно положить а= а 1 = IM. В этом случае q (а1 )= 1- т!М.

Кроме того, при а= а 1 производная q>'(x) неотрицательна, и в силу тео

ремы 4.3 сходимость является монотонной.

1

3 а меч ан и е. Случай, когда производная f' отрицательна, сво

дится к рассмотренному выше умножением уравнения f(x) = О на -l.

Пример 4.7. Для решения задачи, поставленной в примере 4.5,

можно воспользоваться преобразованием уравнения (4.4) к виду

(4.26). Будем считать известным, что х е [О. 70, О. 72]. Так как на

отрезке локализации выполнено условие (4(1 - х2)- еХ)' =-8х - еХ <О,

107](https://image.slidesharecdn.com/33379-160302054853/85/33379-108-320.jpg)

![Глава 4. Методы отыскания решений нелинейных уравнений

то перепишем уравнение в видеfj(х) =О, гдеfj(х) = е'" - 4(1 - х2). Тогда

fj (х) = е'" + 8х и для х е [О. 70, О. 72) верны оценки О < т = fj (О. 70) s

s fi (х) $ fj (0.72) = М. Выберем в уравнении (4.26) а= 2/(т + М), возь

мемх<0> = 0.7 и будем вести итерации по формулех<п + 1) =x(n) - а[е·«п> -

- 4(1 - (х<11>) 2 )]. Выбранному а соответствует q =(М- т)!(М+ т)""

"" О.О 13 и поэтому сходимость должна быть более быстрой, чем в при

мере 4.6. Действительно, уже первая итерация дает хО> = О.7034025118,

и так как _q_ lx<1>- х<0> 1 "" 5 • 10-5, то итерации следует прекратить

1-q

и считать х = 0.7034 ±О.ООО. А.

§ 4.5. Обусповnенность метода простой итерации

В § 4.4 метод простой итерации был рассмотрен при идеальном

предположении о возможности точного вычисления значений функции

<р(х). В действительности же вычисления на компьютере дают прибли

женные значения <р•(х). Поэтому вместо последовательности x<n>, удов

летворяющей равенству х<11 + l) =<р(х(11>), получается последовательность

:Х<11>, для которой

(4.27)

Известно, что метод простой итерации и многие другие итерацион

ные методы устойчивы к ошибке, допущенной на одной из итерации.

Такая ошибка эквивалентна некоторому ухудшению очередного при

ближения; если она не вывела приближение за пределы области сходи

мости, то итерационная последовательность по-прежнему будет схо-

диться к решению х ,а внесенная погрешность - затухать. Поэтому о

таких итерационных методах говорят, что они обладают свойством

самоисправляемости.

Однако погрешности допускаются не на одной, а на всех итерациях

и совокупное их влияние несколько иное.

1. Обусловленность задачи. Прежде чем сформулировать резуль

тат о поведении метода простой итерации при наличии погрешности в

вычислении функции <р, отметим, что преобразование уравнения f(x) = О

к виду х = <р(х) изменяет обусловленность задачи. Запишем это уравне-

- -ние в виде f(x) =О, где f(x) = х - <р(х), и воспользуемся результатами

§4.2. Заметим, что ЛJ')=Л(<р'), поскольку в действительности при-

108](https://image.slidesharecdn.com/33379-160302054853/85/33379-109-320.jpg)

![Глава 4. Методы отыскания решений нелинейных уравнений

Пр им ер 4.9. Используя метод Ньютона, укажем итерационный

процесс вычисления PJa, где а > О, р - натуральное число.

По определению, х = PJa - это неотрицательная величина, удовле

творяющая равенству хР = а. Таким образом, задача сводится к вычис

лению положительного корня уравнения f(x) = О, где /(х) = хР - а.

Итерационная формула метода Ньютона примет вид

(х<">)Р - а - 1

х<" + 1) =х<п) - =Р__ х(п) + а (4.44)

р(х<">)Р - 1 р p(x<n>)p-1

При р = 2 эта формула уже была получена в примере 3.17. А

5. Связь с методом простой итерации. Метод Ньютона можно рас

сматривать как один из вариантов метода простой итерации, связанный

со специальным преобразованием уравнения f(x) =О к виду

х = q>н(х), (4.45)

где q>н(х) = х - f(x)/f'(x).

Действительно, итерационная формула метода простой итерации

.x(n+ 1) = q>н(х<")) совпадает с (4.37).

Если исходить из этого с учетом оценки (4.19), можно сделать вывод

о том, что метод Ньютона сходится только линейно. Однако заметим,

f"(x)

что q>Л, (х) =f(x) ---2 • Так как f(x) = О, то q>Л,(х) = О и величина

(f'(x))

а<п + I) = 1q>'(~<11))1. определяющая в силу равенства (4.20) коэффициент

сжатия погрешности, стремится к нулю при п ---+ оо. Скорость сходимо

сти возрастает по мере приближения к корню, отсюда и ее сверхлиней

ный характер.

В качестве аналога теоремы 4.4 для метода Ньютона приведем сле

дующий результат.

Теорема 4.8. Пусть [а, Ь] - отрезок локализации простого корня

х уравнения (4.1). Предположим, что на этам отрезке функция f два

жды непрерывно дифференцируема, а ее производные/'(х) иf''(х) знако

постоянны. Пусть х<О) е [а, Ь] - произвольное начальное приближение,

и в случае f(x<0))f'(x<0)) < О выполнено дополнительное условие x<I) е [а,

Ь] (первое приближение не выходит за пределы отрезка локализации).

Тогда начиная с п = l итерационная последовательность метода

Ньютона х<11) сходится к х монотонно с той стороны отрезка [а, Ь],

где f(x)f"(x) > О. •

116](https://image.slidesharecdn.com/33379-160302054853/85/33379-117-320.jpg)

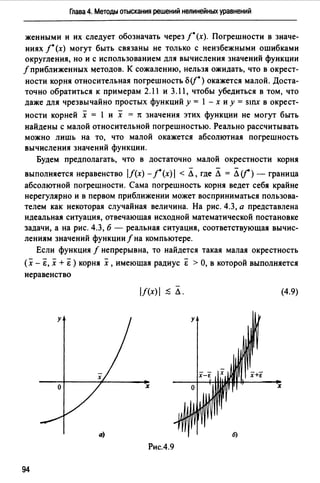

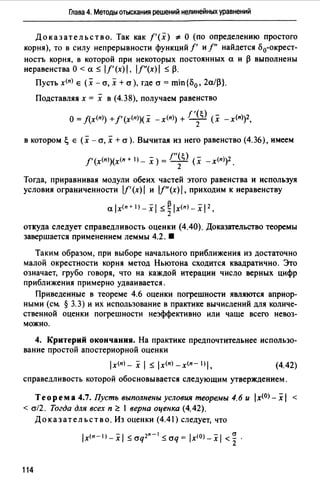

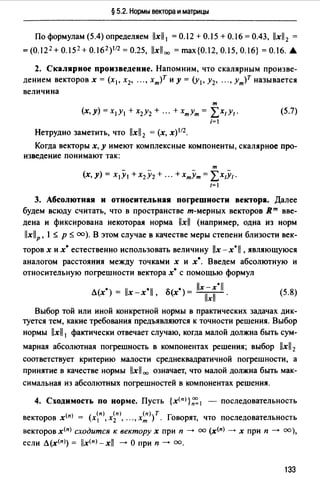

![§ 4.7. Модификации метода Ньютона

т.е. исходное нелинейное уравнение заменяется приближенно более

простым линейным уравнением.

l. Упрощенный метод Ньютона. Если производная f'(x) непре

рывна, то ее значение вблизи простого корня х почти постоянно.

Поэтому можно попытаться вычислить/' лишь однажды в точке х<0>, а

затем заменить в формуле (4.37) значение f' (х<п>) постоянной f'(x<0>). В

результате получим расчетную формулу упрощенного метода Ньютона:

х<п + 1) = х<п> - f(х<п>) ' п ~о. (4.46)

f'(x(O))

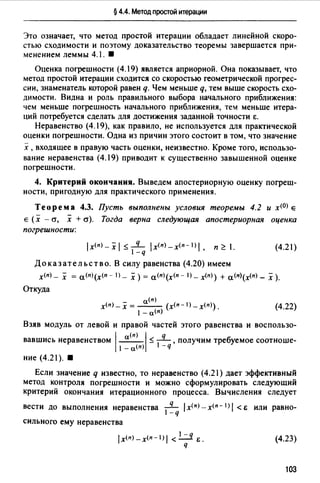

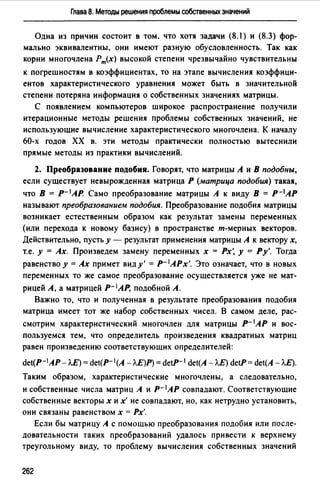

Геометрическая иллюстрация метода приведена на рис. 4.11. В точке

(x<OJ, f(x<O>)) к графику функции у = f(x) проводится касательная /0 и за

приближение xm принимается абсцисса точки пересечения этой каса

тельной с осью Ох (как в методе Ньютона). Каждое следующее прибли

жениех<п + 1>получается здесь как абсцисса точки пересечения с осью Ох

прямой, проходящей через точку М(п> с координатами (х<п>, f(х<п> )) и

параллельной касательной /0 •

Упрощение вычислений по сравнению с методом Ньютона достига

ется здесь ценой резкого падения скорости сходимости. Сходимость

этого метода является уже не квадратичной, а линейной.

Метод (4.46) можно рассматривать как метод простой итерации

с итерационной функцией <р(х) =х - f(x<~> . Так как <р'(х) = 1 - f'(<x]>),

J'(x ) f'(x

то для знаменателя q соответствующей геометрической прогрессии

имеем q "' l 1 - ;~~~~)1 · Следовательно, скорость сходимости тем выше,

чем ближе начальное приближение х<0> к решению х .

у

о х

Рие. 4.11

119](https://image.slidesharecdn.com/33379-160302054853/85/33379-120-320.jpg)

![Глава 4. Методы отыскания решений нелинейных уравнений

у у

о х х о х х

Рис. 4.16

Для того чтобы сохранить квадратичную скорость сходимости,

метод Ньютона нужно модифицировать следующим образом:

f(x<n))

х<п+l)=х<п>-т--- п~О.

f'(х<п))'

(4.51)

Можно показать (это достигается раскрытием неопределенностей

с помощью формулы Тейлора), что при таком выборе итерационной

функции q>(x) = х - т f((x)) получим q>'(x) =О, и сходимость снова ока

/' х

жется квадратичной.

На рис. 4.16, а, б проиллюстрировано поведение последовательных

приближений стандартного метода Ньютона и его модификации (4.51)

для случая отыскания корня кратности т = 2.

Для метода (4.51) значение х<п + I) получается следующим образом.

В точке м<п) с координатами (х<п>, j(х<п>)) к графику функции прово

дится касательная. Пересечение ее с осью Ох дает вспомогательную

точку :Х<п+ I). Для получения точки х<п + I) нужно воспользоваться

равенством х<п + 1J - х<п) = т( х (п + 1) - x<n>).

Пр им ер 4.10. Применим методы, рассмотренные в данной главе,

для вычисления положительного корня уравнения 4(1 - х2) - еХ = О, счи

тая известным, что х Е [О, 1] (см. пример 4.2).

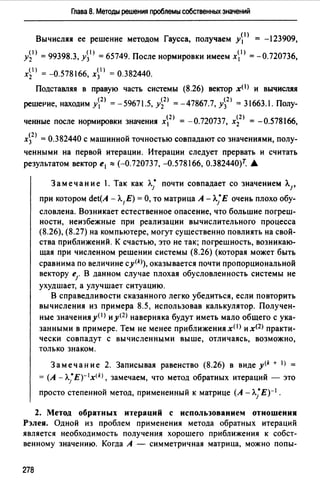

Результаты вычислений приведены в табл. 4.5-4.8. В них для каж

дого приближения дается число верных знаков и требуемое число вычис

лений значений функции /(х) = 4(1 - х2 ) - еХ (для упрощенного метода

124](https://image.slidesharecdn.com/33379-160302054853/85/33379-125-320.jpg)

![§ 4.8. Дополнительные замечания

можная (но не обязательная) потеря точности составляет одну-две вер

ные цифры. Необходимо лишь прервать итерационный процесс в тот

момент, когда приближения окажутся в опасной близости к интервалу

неопределенности. Один из способов заметить этот момент состоит

в использовании правила Гарвика (см. § 4.2).

Отметим, что при попадании очередного приближения в малую

окрестность решения теряет устойчивость и метод Стеффенсена.

§ 4.8. Допопнитепьные замечани1

1. Метод обратной квадратичной интерполяции. Пусть приближе

ния х<п - 2), х<п - 1>, х<п) уже найдены, а соответствующие значения функ

ции f различны (последнее предположение заведомо будет выполнено,

если функция/строго монотонна). Тогда строят такой квадратичный мно

гочлен Р2(у) от переменной у, что х<1) = P 2(f(x(r))) для i = п - 2, п - 1, п.

За очередное приближение к решению принимается х<п + I) =Р2(0).

Этот трехшаrовый метод обладает локальной сходимостью с поряд

ком р "" 1.839; для начала ero работы требуется задание трех хороших

начальных приближений.

2. Методы с порядком сходимости выше второrо. Приведем при

меры одношаrовых методов, обладающих кубической сходимостью.

Таковым является итерационный метод1

Здесь

_ /(х)

и(х)- f'(x)'

v (х) =f(x)f"(x).

[f '(х)]2

Другим примером метода, обладающего кубической скоростью схо

димости, является метод Галлея2

1 Этод метод часто называют итерационным методом Эйлера.

2 Эдмунд Галлей (1656-1742) - анrлнйскнй астроном, предсказавший периодиче

ское (с периодом 75 лет) появление кометы, впоследствии названной ero именем.

127](https://image.slidesharecdn.com/33379-160302054853/85/33379-128-320.jpg)

![§ 4.8. Дополнительные замечания

щихся методов типа бисекции с недостаточно надежными, но быстро

сходящимися методами типа секущих или Ньютона. Результирующие

алгоритмы обладают высокой надежностью и гарантированной сходимо

стью. В тех же случаях, когда в окрестности простого корня функция/

гладкая, сходимость становится сверхлинейной.

Алгоритм ZEROIN, изложенный в [106], является примером эффек

тивного гибридного алгоритма. на каждом шаге которого принимается

решение о том, какой из трех методов: бисекции, секущих или обрат

ной квадратичной интерполяции - следует использовать для вычисле

ния очередного приближения.

5. Л2-процесс Эйткена. Пусть {х<п>},~0 - последовательность

приближений к корню х ,полученная линейно сходящимся итерацион

ным методом (например, методом простой итерации). Использовав три

последние найденные приближения х<п - 1), х<п>, х<п + 1>, можно получить

более точное приближение к решению

_ (х<п + 1) _ х<п))2

х<п + 1) =х<п + J) _ -~----~-

t'(n + 1) _ 2х<п) + х<п - 1) ·

Этот способ ускорения сходимости используется на завершающем

этапе итераций и называется Л2-процессом Эйткена.

6. Критерии окончания. Проблема выбора правильного критерия

окончания итерационного процесса часто оказывается достаточно

сложной. Следует также иметь в виду, что наряду с обсуждавшимся в

предыдущих параграфах условием /х<п>-х<п- I) 1 < Е 1 нередко исполь-

зуется следующее условие: /J(х<п>)/ < Е2.

129](https://image.slidesharecdn.com/33379-160302054853/85/33379-130-320.jpg)

![§ 5.2. Нормы вектора и матрицы

где Л}АТА) - собственные числа 1 матрицы АТА;

т

IJAlloo = max L la;;I. (5.13)

1 $ {$ т ]= 1 .

Нормы llAll 1 и llAll 00 вычисляются просто (см. ниже пример 5.2).

Для получения значения первой из них нужно найти сумму модулей эле

ментов каждого из столбцов матрицы А, а затем выбрать максимальную

из этих сумм. Для получения значения llAll00 нужно аналогичным

образом поступить со строками матрицы А.

Как правило, вычислить значение нормы llAll2 бывает трудно, так

как для этого следует искать собственные числа Л1. Для оценки вели

чины llAll2 можно, например, использовать неравенство

(5.14)

Здесь llAllE= J,,~I laul 2- величина, называемая евклидовой нормой

матрицы А. Часто эту же величину называют нормой Фробениуса 2 и

обозначают llA 11F.

Норма (5.9) имеет простую геометрическую интерпретацию. Для того

чтобы ее привести, заметим, что операцию умножения матрицы А на век

тор х можно рассматривать как преобразование, которое переводит вектор

х в новый вектор у = Ах. Если значение llxll интерпретируется как длина

векторах, то величина llAxll / llxll есть коэффициент растяжения векторах

под действием матрицы А. Таким образом, величина

llAxiJ

kmax = llA11 = ~:~ bl (5.15)

представляет собой максимальный коэффициент растяжения векторов

под действием матрицы А. Полезно отметить, что для невырожденной

матрицы А минимальный коэффициент растяжения kmin отвечает норме

обратной матрицы и вычисляется по формуле

k - 11л-111-1 - . llAxll

mln - - ~~~ Тхf · (5.16)

Заметим, что в случае llA 11 < 1 происходит сжатие векторов под дей

ствием матрицы А.

1 Напомним, что число Л. называется собственным числом матрицы А, если существует

вектор х ~ О такой, что Ах= J..x. Каждая матрица порядка т имеет ровно т собственных

чисел (вообще говоря, комплексных) с учетом их кратности.

~ Фробениус Фердинанд Георг (1849-1917) - не'lецкий математик.

135](https://image.slidesharecdn.com/33379-160302054853/85/33379-136-320.jpg)

![Глава 5. Прямые методы решения систем линейных алгебраических уравнений

Пр и мер 5.2. Для матрицы

r

O.I -0.4 О ]

А= 0.2 О -0.3

о 0.1 0.3

найдем llA11 1 , llA 11 оо и оценим llA112 •

В соответствии с формулами (5.11), (5.13) и неравенством (5.14) имеем

llAll 1 = max{O.I + 0.2 +О; 0.4 +О+ 0.1; О+ 0.3 + 0.3} = 0.6;

llAll00 = max{O.I + 0.4 +О; 0.2 +О+ 0.3; О+ 0.1+0.3} = 0.5;

§ 5.3. Типы используемых матриц

Эффективность вычислений в линейной алгебре существенно зави

сит от умения использовать специальную структуру и свойства исполь

зуемых в расчетах матриц. Напомним некоторые важные типы матриц.

Квадратная матрица А называется диагональной, если ее элементы

удовлетворяют условию а11 = О для i "# j (все отличные от нуля элементы

расположены на главной диагонали):

а11 о о о

о а22 о о

А= о о а33 ." о

.................

О О О ... атт

Диагональную матрицу, у которой все элементы а11 главной диаго

нали равны единице, называют единичной и обозначают буквой Е:

1 о о ". о

о 1 о ... о

Е= о о 1 ." о

. . . . . . . . . . . .

о о о ". 1

136](https://image.slidesharecdn.com/33379-160302054853/85/33379-137-320.jpg)

![§ 5.3.Типы используемых матриц

Пр им ер 5.3. Вычислим норму единичной матрицы Е.

llExll llxll

По определению, llEll = ~~~ ТхiГ =~~~ llxll = l . Следовательно,

llEll = 1. .А

Важную роль в численном анализе играют треугольные матрицы.

Квадратная матрица А называется нижней треугольной, если все ее

элементы, расположенные выше главной диагонали, равны нулю

(о11 = О для i < }). Если же равны нулю все элементы матрицы, распо-

ложенные ниже главной диагонали (o1j = О для i > }), то она называ

ется верхней треугольной.

Нижняя и верхняя треугольная матрицы имеют соответственно сле

дующий вид:

0 11 о о о 0 11 0 12 °13 0 1т

0 21 0 22 о о о 0 22 О23 02т

й31 О32 й33 о о о О33 03т

.. .. .. .......... . .................

0тt 0т2 °т3 •.. 0тт о о о ... 0тт

Треугольные матрицы обладают рядом замечательных свойств. Напри

мер, для таких матриц определитель легко вычисляется по формуле

(5.17)

Квадратная матрица А называется симметричной, если она совпа

дает со своей транспонированной матрицей Ат (или, что то же, oij = 011

для всех i,j).

Будем называть симметричную матрицу А положительно опреде

ленной и писать А > О, если для всех векторов х ;tO квадратичная форма

т

(Ах, Х) = L Ol]XIXJ

i,]=I

принимает положительные значения.

Обозначим через Л.mtn и Л.mах минимальное и максимальное собст

венные значения матрицы А. Известно, что для симметричной матрицы

Л.miпllxll; ~ (Ах,х) ~ Л.maxllxll;

и матрица А положительно определена тогда и только тогда, когда все

ее собственные значения положительны.

137](https://image.slidesharecdn.com/33379-160302054853/85/33379-138-320.jpg)

![Глава 5. Прямые методы решения систем линейных алгебраических уравнений

Доказательство. Заметим, что (а.А)-1 = а-1А- 1 . Поэтому

сопd(а.А) = llaAll · ll(aA)-111 = 1ai · l!All I aJ-1l!A-111 = сопd(А). 8

Замечание. Пользуясь приведенной в § 5.2 геометрической

интерпретацией норм матриц А и А- 1 (см. формулы (5.15) и (5.16)),

число обусловленности можно интерпретировать как отношение

максимального коэффициента растяжения векторов под действием

матрицы А к минимальному коэффициенту. сопd(А) = kmax/kmin·

Величина сопd(А) зависит, вообще говоря, от выбора нормы векто

ров в пространстве Rm. Фактически это есть зависимость максимального

коэффициента роста погрешности от способа измерения величины вход

ных данных и решения. В частности, выбору нормы llxllp (1 $ р $ оо)

отвечает сопdР(А) = l!A-1llP · llAllP.

Пр им ер 5.4. Вычислим сопd 00 (А) для матрицы

A=[l.03 0.991]·

0.991 0.943

Сначала найдем обратную матрицу

А-1 "'[-87.4 91.8 ] .

91.8 -95.4

(5.25)

Тогда сопd 00 (А) = llAll 00 • llA-111 00 "'2.о21·187.2 "'378. Если вход

ные данные для системы уравнений с матрицей (5.25) содержат относи

тельную погрешность порядка 0.1-1 %, то систему можно расценить

как плохо обусловленную. •

Пр им ер 5.5. Рассмотрим систему уравнений

1.03х 1 +0.99lx2 = 2.51,

(5.26)

О.991х 1 + О.943х2 = 2 41

с матрицей (5.25). Ее решением является х 1 "' 1 981, х2 "' 0.4735. Правая

часть системы известна в лучшем случае с точностью до 0.005, если

считать, что числа 2.51 и 2.41 получены округлением «истинных)) зна

чений при вводе в память трехзначного десятичного компьютера. Как

влияет погрешность во входных данных такого уровня на погрешность

решения? Возмутим каждую из компонент вектора правой части Ь =

= (2 51, 2.4J)T на 0.005, взяв ь• = (2.505, 2.415)r. Решением системы,

142](https://image.slidesharecdn.com/33379-160302054853/85/33379-143-320.jpg)

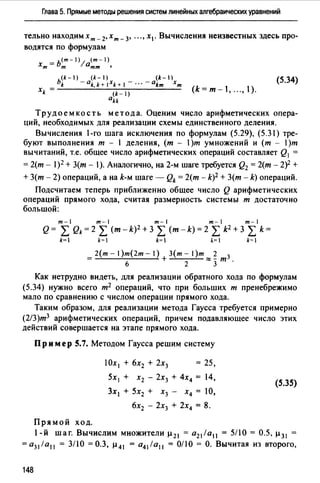

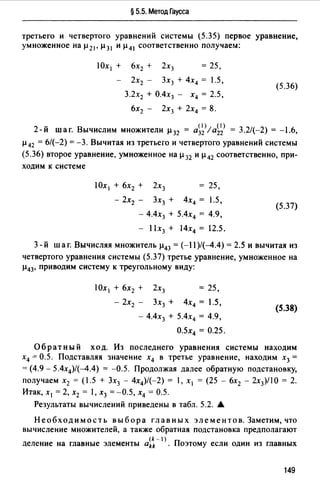

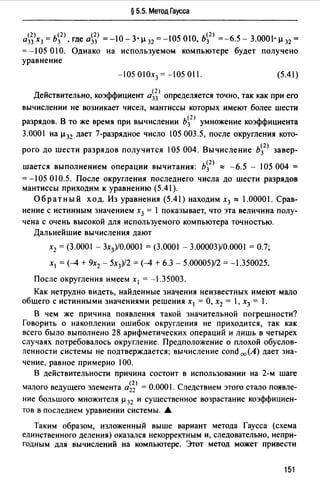

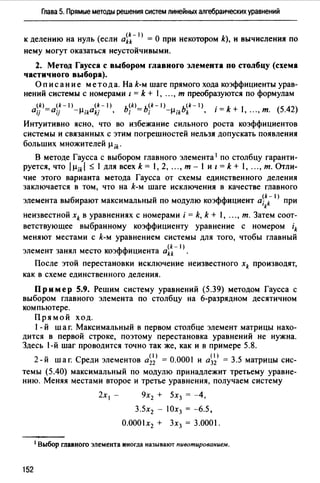

![§ 5.5. Метод Гаусса

и вычтем последовательно из третьего, четвертого, "., т-го уравнений

системы (5.30) второе уравнение, умноженное соответственно на

µ 32 , µ 42 , "., µm2 В результате получим систему

а11Х1 + а12Х2 + а13Х3 + ". + almxm = Ь1,

+а0 1х = ь< 1 >2т т 2 •

(2) <2> = ь<2>

а33 Х3 + ··· + а3тХт 3 • (5.32)

Здесь a~j> и ь~2 > (i,j = 3, 4, "., т) вычисляются по формулам

<2> (1) <I> ь~2) = ь~1> - . ь<1>

aij =а;/ - µ;2а2] , , µ,2 2 ·

Аналогично проводятся остальные шаги. Опишем очередной k-й шаг.

k-й шаг. В предположении, что главный (ведущий) элемент k-го

шага ai~- I) отличен от нуля, вычислим множители k-го шага

{k-1) {k-1)

µik=a;k lakk (i=k+,".,т)

и вычтем последовательно из (k + 1)-го, ..., т-го уравнений полученной

на предыдущем шаге системы k-e уравнение, умноженное соответст

венно на µk + 1, k• µk + 2, k• "., µmk·

Гlосле (т - 1)-ro шага исключения получим систему уравнений

а11Х1+а12Х2+ а13Х3+".+а1тХт = h1,

(2)

а33 Х3 + (5.33)

(т-1) - ь<т-1)

0тт Хт - т '

матрица А (т - 1) которой является верхней треугольной. На этом вычис

ления прямого хода заканчиваются.

Об ратный ход. Из последнего уравнения системы (5.33) находим

х т. Подставляя найденное значение х т в предпоследнее уравнение,

получаем х т _ 1• Осуществляя обратную подстановку, далее nоследова-

147](https://image.slidesharecdn.com/33379-160302054853/85/33379-148-320.jpg)

![§ 5.9. Метод прогонки

По формулам (5.68) последовательно находим:

/11 = Ji;'i = J6.25 = 2.5, /21 = а21 //11 = -1/2.5 = -0.4;

/31 = а31 //11 = 0.512.5 = 0.2, /22 = Ja22 -1;1= J5-0.16 = 2.2;

132 = (а32 - /31121 )//22 = (2.12 - 0.2(-0.4))/2.2 = !;

133=Ja33 -/;1 -/;2 =JЗ.6-0.22 -1 2 =1.6.

Следовательно, матрица L такова:

L = -0.4 2.2 О ·l2.5 о о ]

0.2 1 1.6

Система Ly = Ь имеет вид

2.5у, = 7.5,

-О.4у1 + 2.2у2 = -8.68,

О.2у1 + у2 + 1.6у3 = -0.24.

Решая ее, получаем у1 = 3, у2 = -3.4, у3 = 1.6.

Далее из системы Lтх =у, которая имеет вид

2.5х 1 - О.4х2 + О.2х3 = 3,

2.2Х2 + Х3 = -3.4,

1.6Х3 = 1.6,

находим решение х 1 = 0.8, х2 = -2, х3 = 1. А

§ 5.9. Метод прогонки

Рассмотрим метод прогонки 1 - простой и эффективный алгоритм

решения систем линейных алгебраических уравнений с трехдиагональ

ными матрицами

Ь1Х1 + С1Х2

a-r1 + br2 + c-r3

й;Х; - 1 + Ь;Х; + С;Х; + 1 =d,,

ат - 1Хт - 2 + Ьт - 1Хт - 1 + Ст - Хт = dm - !•

йmХт - 1 + ЬтХт = dm.

(5.69)

1 Метод прогонки был предложен в начале 50-х годов независимо несколькими авто

рами, в том числе российскими учеными И.М. Гельфандом, О.В. Локуцневскнм, В.С. Вла

димировым, АС. Кронродом.

171](https://image.slidesharecdn.com/33379-160302054853/85/33379-172-320.jpg)

![§ 5.9. Метод прогонки

Здесь

У1 о о ." о о 1 -а1 о ". о о

а2 У2 о ".о о о -а2 ". о о

L= о а3 Уз ." о о U=

о о о 1 -am-1

о о о ".ат Ут о о о о

Так как для определения L и U нет необходимости вычислять коэф

фициенты Р,, то общее число операций на получение разложения (5.78)

составляет примерно Зт.

Подобно тому как это описано в § 5.7, разложение (5.78) можно

использовать для решения систем с многими правыми частями. Если

нужно решить р систем с матрицей А, то общее число операций соста

вит примерно Зт + 5тр.

К сожалению, при обращении матрицы А теряется ее трехдиаго

нальная структура. Обратная матрица является заполненной, однако

для ее вычисления с помощью разложения (5.78) требуется примерно

лишь 2.5 т2 арифметических операций.

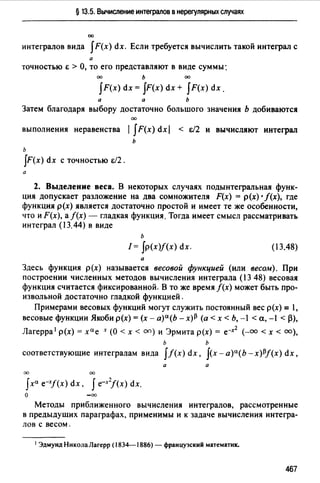

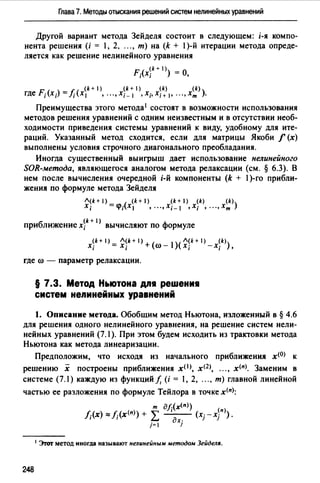

Так как det А = det L · det U, а det U = l, то определитель трехдиаго