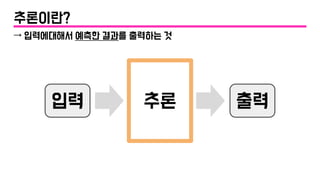

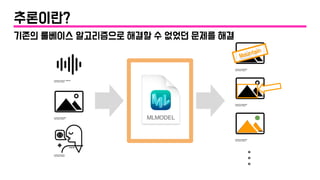

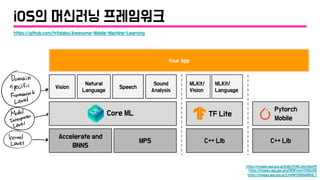

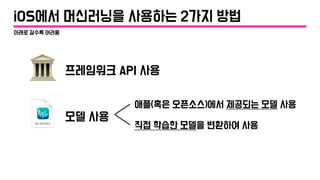

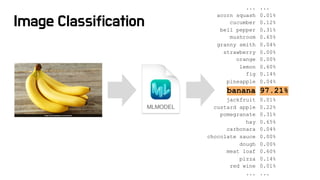

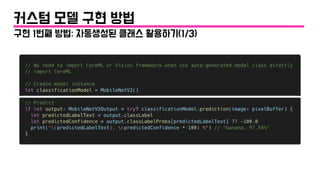

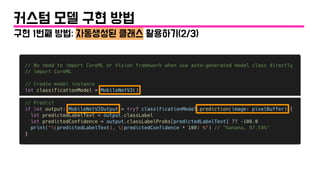

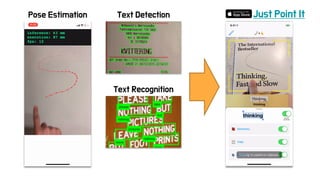

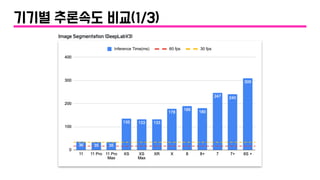

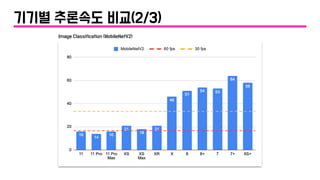

iOS에서 머신러닝으로 해결할 수 있는 문제들을 다양한 예시와 함께 소개합니다. 기존에 룰베이스 알고리즘으로는 해결하기 힘들었던 어려운 문제들을 머신러닝이 어떻게 해결할 수 있는지 설명하고, 간단한 코드 예제와 함께 Core ML 사용법을 알려드립니다. 또한 서비스에 사용하는 모델의 경우 어떤 추가적인 고려를 해야하는지도 간략히 소개하고 있습니다.

본 발표에 공유된 대부분의 데모는 https://github.com/motlabs/awesome-ml-demos-with-ios 저장소에 올라가있어, 코드 레벨까지 궁금한 분들께서는 이 저장소를 확인해주세요.

발표영상: https://www.youtube.com/watch?v=zKPB8rnS-EM

![[Let's Swift 2019] iOS 앱에서 머신러닝이 해결 할 수 있는 문제들](https://image.slidesharecdn.com/ios-ml-demos4-191113114831/85/Let-s-Swift-2019-iOS-60-320.jpg)