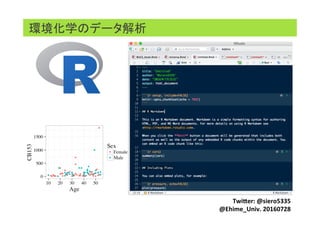

環境化学データ解析入門: 愛媛大講演資料 160728

- 24. 集計: summary() 関数 summary() 関数: () の中にデータセットの名前を入れて使う データセット名$要素名で各要素にアクセス可能 素早くTable用のデータを作ることができる

- 32. 手法 正規性 等分散性 関数 Package Student’s t 要 要 t.test(group1, group2, var.equal=T) 不要 Welch’s t 要 不要 t.test(group1, group2, var.equal=F) 不要 Mann-Whitney 不要 要 wilcox.test(group1, group2) 不要 Brunner-Munzel 不要 不要 brunner.munzel.test(x,y) library(lawstat) 検定: Welch’s t 検定, Brunner-Munzel 検定 ほくそ笑む:マイナーだけど最強の統計的検定 Brunner-Munzel 検定: h$p://d.hatena.ne.jp/hoxo_m/20150217/p1 Brunner-Munzel検定: h$p://oku.edu.mie-u.ac.jp/~okumura/stat/brunner-munzel.html 正規性のある場合の検定だとStudent’s t 検定, ない時だとMann- Whitneyがしょっちゅう使われるが、等分散性が必要なことはあまり 知られてない。 Welch’s t 検定, Brunner-Munzel検定はあまり有名ではないが強力 な手法。使ってみてもいいかも? 理論の詳細は上記ブログに詳細。

- 40. 機械学習 (Machine Learning) データ解析における研究課題の一つで、人間が自然に 行っている学習能力と同様の機能をコンピュータで実現 しようとする技術・手法

- 44. 主成分分析(Principle component analysis, PCA) 次元を縮小・データを可視化するための手法

- 45. 主成分分析(Principle component analysis, PCA) 次元を縮小・データを可視化するための手法

- 46. 主成分分析(Principle component analysis, PCA) 次元を縮小・データを可視化するための手法 形・色・重さ・模様・材質など様々な情報(次元)をもつ

- 47. 主成分分析(Principle component analysis, PCA) 次元を縮小・データを可視化するための手法 形・色・重さ・模様・材質など様々な情報(次元)をもつ 影を見れば他の要素が消えて形だけの情報が残る

- 48. 主成分分析(Principle component analysis, PCA) 次元を縮小・データを可視化するための手法

- 49. 主成分分析(Principle component analysis, PCA) 次元を縮小・データを可視化するための手法 影しか見えないので何の影なのかは自分で考えないといけない

- 50. 主成分分析(Principle component analysis, PCA) 主成分分析の際には各変数の標準化が重要になる 標準化しない場合だと数値が大きく分散の絶対値が大きい因子の 寄与が大きくなってしまう

- 51. 主成分分析(Principle component analysis, PCA) 標準化なし 標準化あり summaryの結果

- 52. 主成分分析(Principle component analysis, PCA) 標準化なし 標準化あり 上記黄色部分が各種成分の寄与率を表す 標準化あり、なしで結果が大きく変わっている summaryの結果

- 53. 主成分分析(Principle component analysis, PCA) 標準化なし 標準化あり 上記黄色部分が各種成分の寄与率を表す 標準化あり、なしで結果が大きく変わっている →図でも確認する summaryの結果

- 54. 主成分分析(Principle component analysis, PCA) (98.2%) (1.04%) (47.2%) (15.7%) 標準化の有無でPlotの様子だけではなく、 寄与する因子のパターンも大きく異る なしではPCB総濃度や濃度の高いPCB異性体しか目立たないが ありでは第2主成分に身長, 体重, BMIが寄与していることが分かる

- 55. その他機械学習: caret package 重回帰分析 (MLR) 部分最小二乗法 (PLS) →次元縮約により潜在変数を作成 Elastic net (Enet) →正則化により不要なパラメータを削減 Support vector regression (SVR) →非線形に対応: カーネル法(高次元に射影) Gradient boosting Decision Tree (GBDT) →非線形に対応: 多重更新重み付け決定木 線形回帰と その応用

- 56. 重回帰分析 (MLR) 部分最小二乗法 (PLS) →次元縮約により潜在変数を作成 Elastic net (Enet) →正則化により不要なパラメータを削減 Support vector regression (SVR) →非線形に対応: カーネル法(高次元に射影) Gradient boosting Decision Tree (GBDT) →非線形に対応: 多重更新重み付け決定木 目的変数を予測するのが目的 統計モデリングとの違いは? 線形回帰と その応用 その他機械学習: caret package

- 57. 重回帰分析 (MLR) 部分最小二乗法 (PLS) →次元縮約により潜在変数を作成 Elastic net (Enet) →正則化により不要なパラメータを削減 Support vector regression (SVR) →非線形に対応: カーネル法(高次元に射影) Gradient boosting Decision Tree (GBDT) →非線形に対応: 多重更新重み付け決定木 従属変数の寄与よりも 予測の良さを良しとすることが多い 線形回帰と その応用 その他機械学習: caret package

- 58. 重回帰分析 (MLR) 部分最小二乗法 (PLS) →次元縮約により潜在変数を作成 Elastic net (Enet) →正則化により不要なパラメータを削減 Support vector regression (SVR) →非線形に対応: カーネル法(高次元に射影) Gradient boosting Decision Tree (GBDT) →非線形に対応: 多重更新重み付け決定木 GCのリテンションタイム予測, 結合能・活性の予測等 線形回帰と その応用 その他機械学習: caret package

- 60. 機械学習: caret package データサイエンティスト養成読本R活用編 P45参照 データ全体を訓練データと検証データに分割して検証 することで、未知データに対応可能か確認 なんか難しいしめんどくさそう → 実際闇は深い データ 訓練データ 検証データ モデル構築 モデル検証 予測モデル Cross validationで 訓練モデルの最適化

- 61. 機械学習: caret package データサイエンティスト養成読本R活用編 P45参照 データ 訓練データ 検証データ モデル構築 モデル検証 予測モデル Cross validationで 訓練モデルの最適化 データ全体を訓練データと検証データに分割して検証 することで、未知データに対応可能か確認 caret packageで多少改善?

- 75. Rの疑問に関する質問サイト

- 76. おすすめ本(読んだもの)

- 80. Enjoy!