Embed presentation

Download as PDF, PPTX

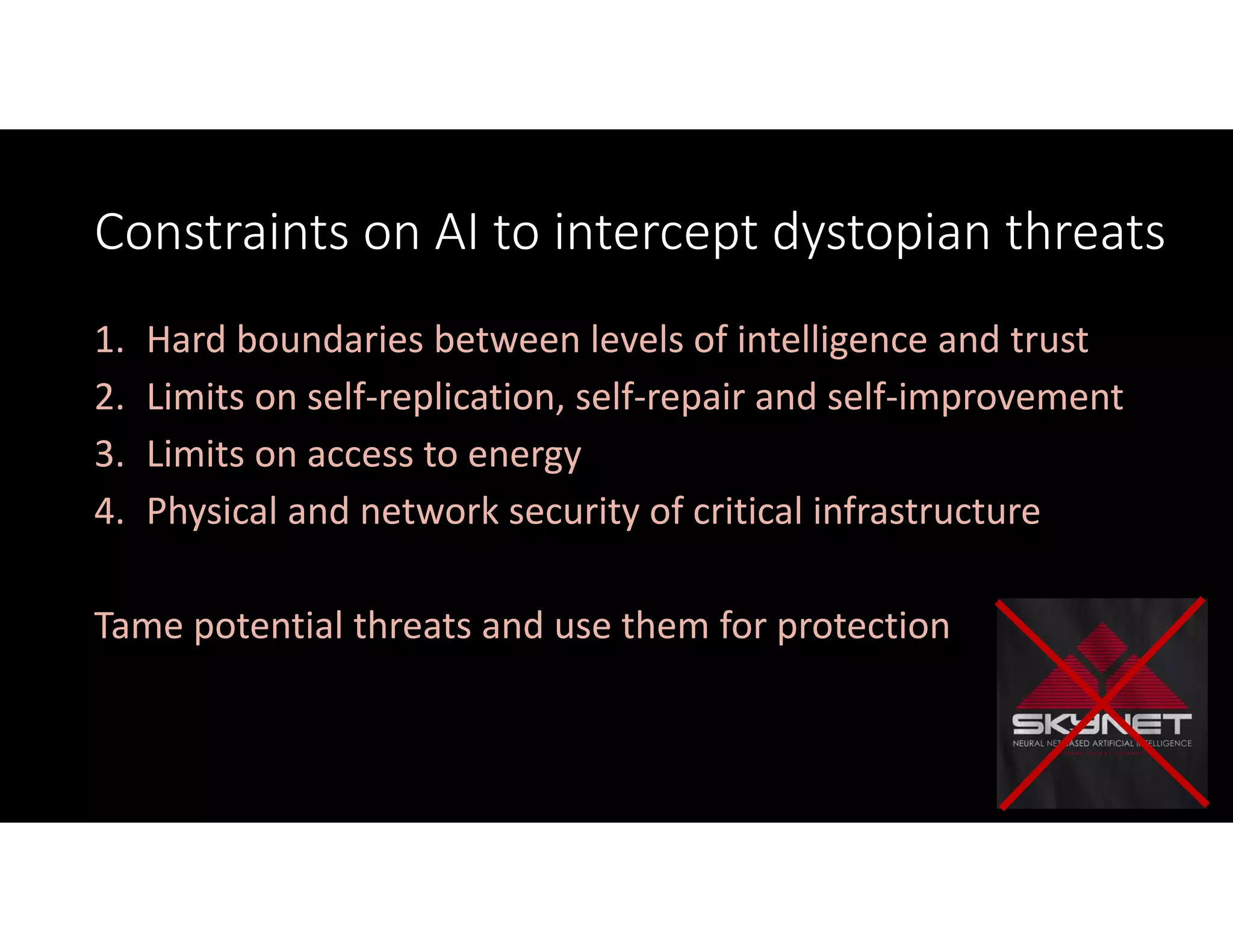

The document discusses the potential dystopian threats posed by AI from a hardware perspective, emphasizing the need for stringent controls on self-replication, self-repair, and energy access for AI systems. It argues for establishing hard boundaries between different levels of intelligence and trust to manage risks effectively. The author suggests that by taming potential threats, AI can be harnessed for protection rather than danger.