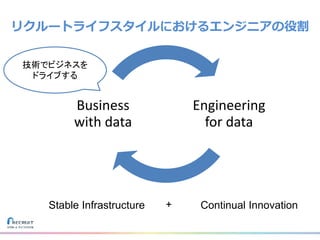

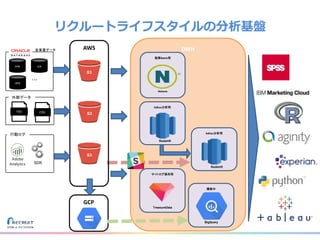

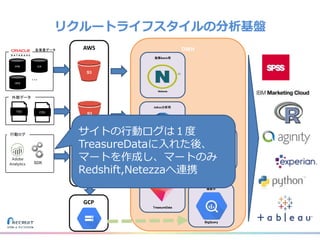

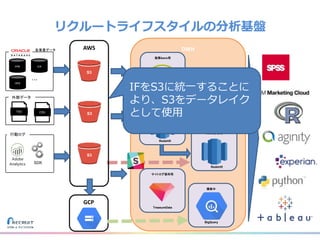

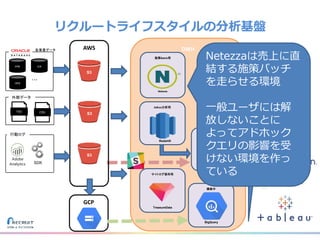

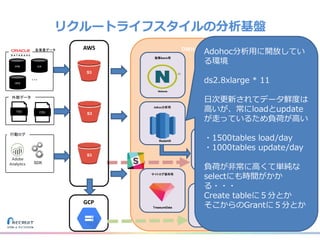

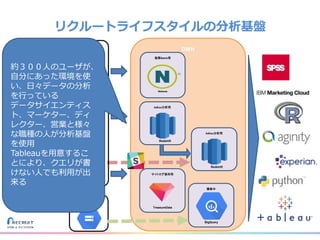

リクルートライフスタイルではじゃらん、ホットペッパーグルメ、ホットペッパービューティーなど約30のサービスを展開しています。

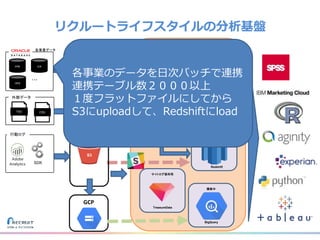

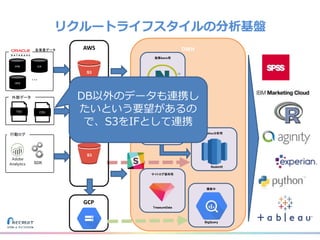

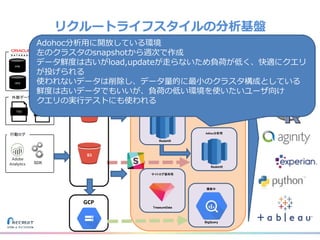

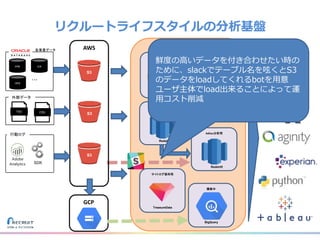

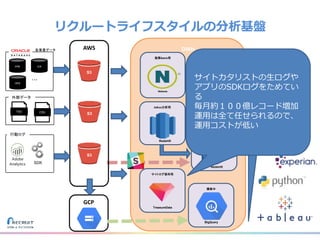

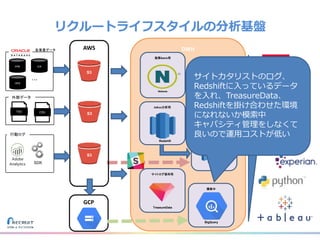

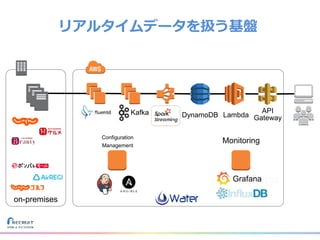

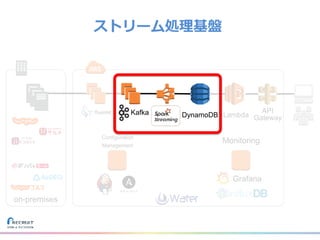

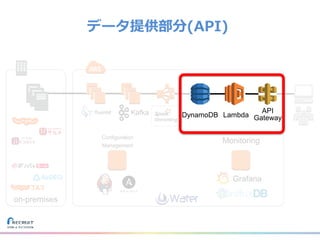

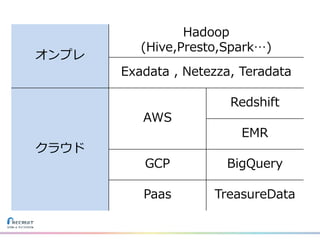

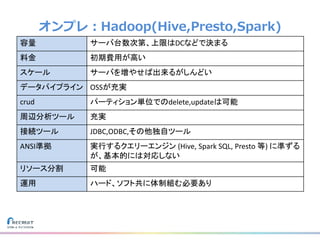

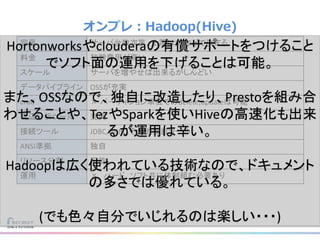

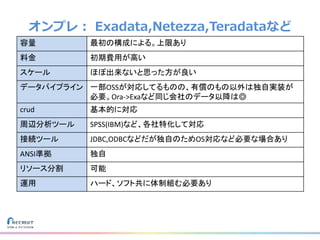

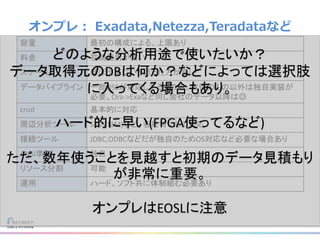

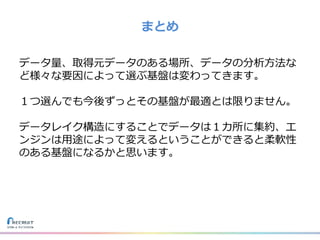

それらのデータを全社共通で使えるように、オンプレ、クラウドのハイブリッドでビックデータ基盤を構築しています。

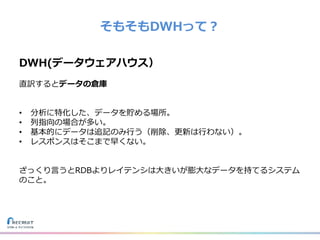

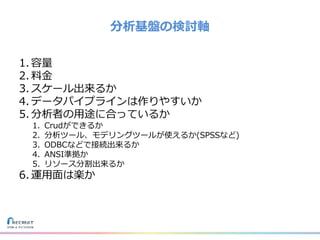

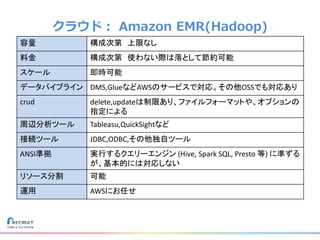

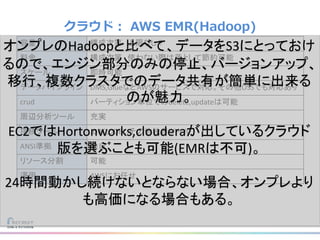

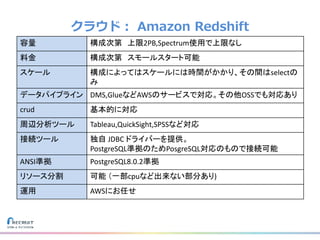

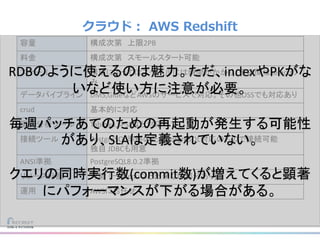

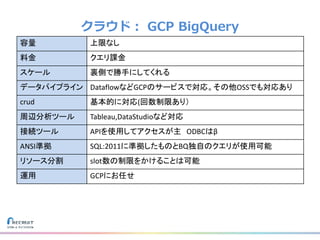

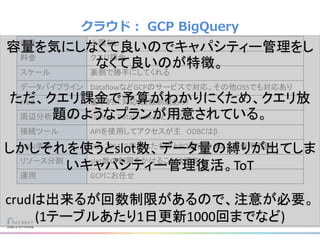

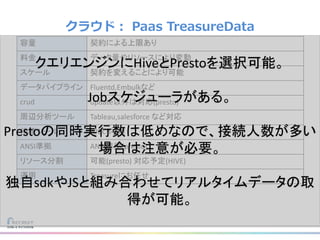

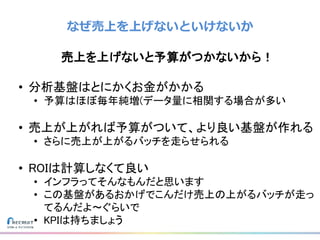

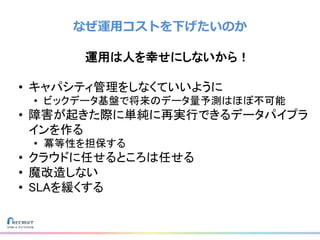

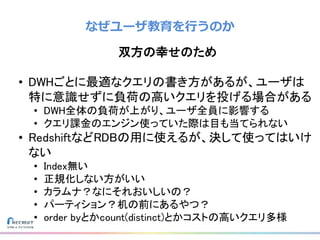

メール配信に使われるバッチやアドホック分析、レポーティングなど様々な用途で使われる中、どうバッチに影響を出さない基盤を作るのか、なぜクラウドだけではなく、オンプレなど複数のDBを使っているのか、なぜその基盤を選んだのか、データ基盤の比較とともに紹介します。

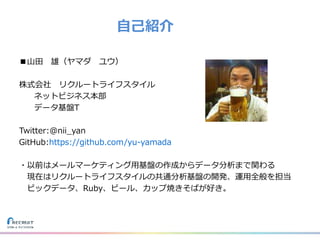

山田 雄(株式会社リクルートライフスタイル)