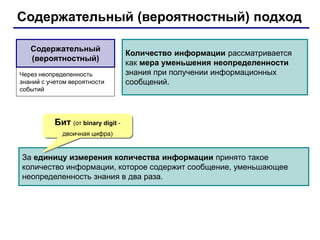

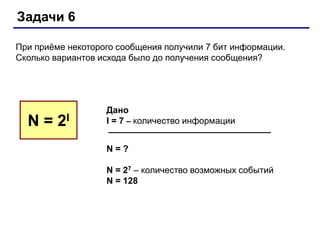

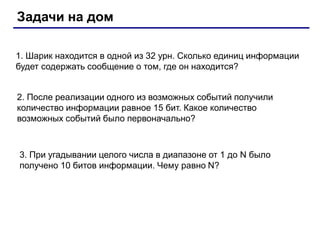

Документ описывает основы двоичного кодирования информации и единицы измерения количества информации, такие как бит и байт, а также производные единицы, включая килобайт и мегабайт. Излагается подходы к измерению информации, основанные на уменьшении неопределенности и количестве символов, с примерами задач по вычислению информации. Рассматриваются различные виды информации, такие как текстовая, графическая и звуковая, и приведены формулы для вычисления объема информации в этих типах.