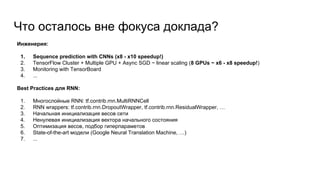

Доклад посвящен предсказанию последовательностей с использованием TensorFlow и глубокого обучения, включая RNN и LSTM. Он охватывает основные принципы моделирования, трудности инженерной жизни и лучшие практики для работы с TensorFlow. В заключение подводятся итоги оптимизации процесса обучения, что позволяет ускорить его в три раза.