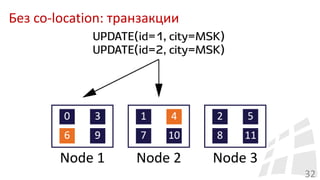

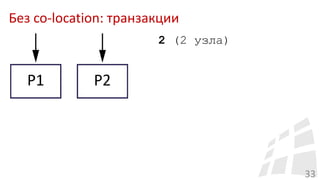

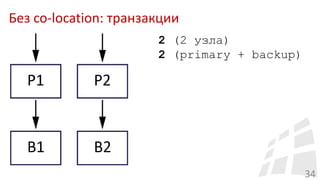

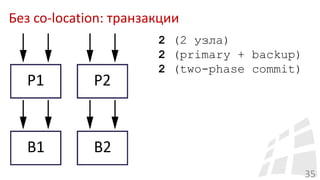

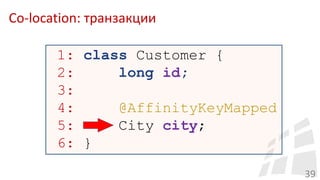

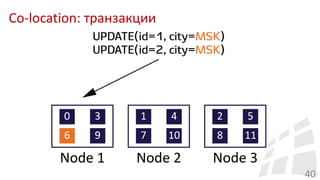

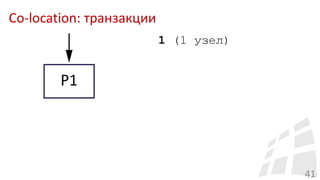

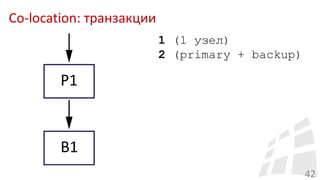

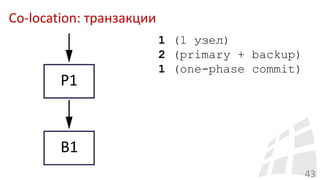

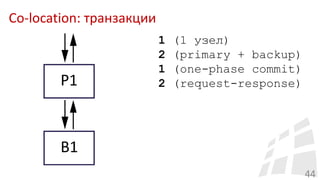

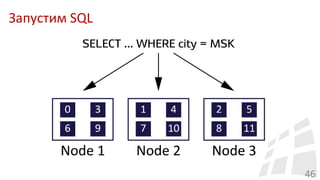

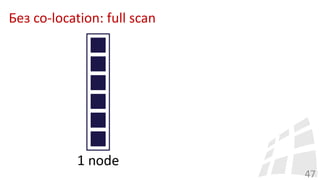

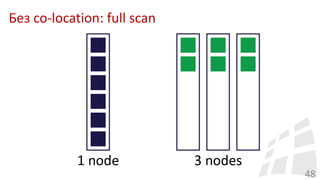

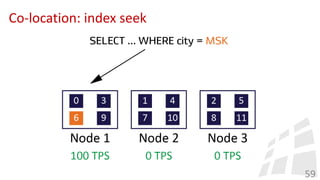

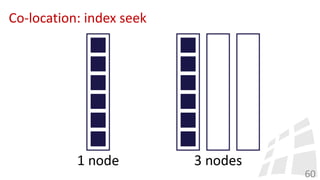

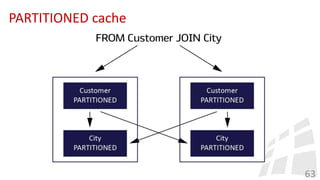

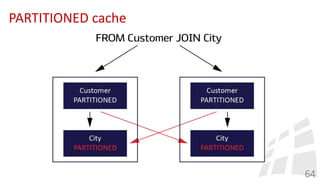

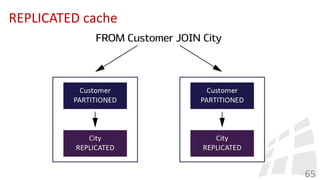

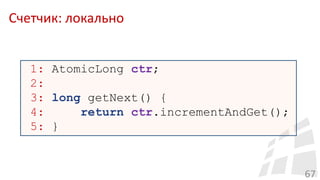

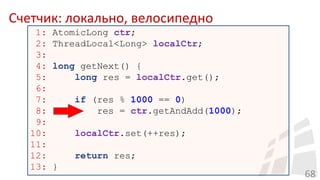

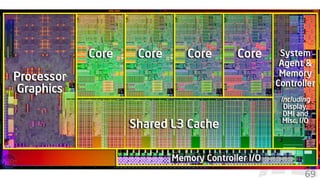

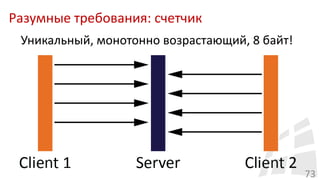

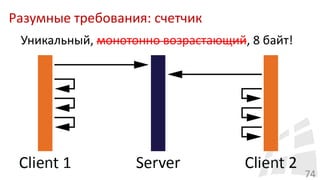

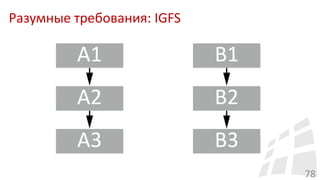

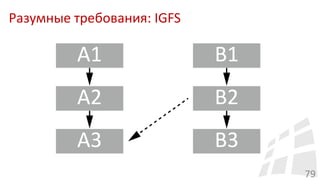

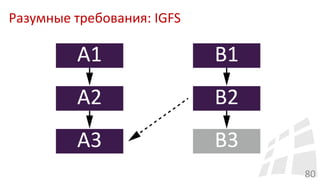

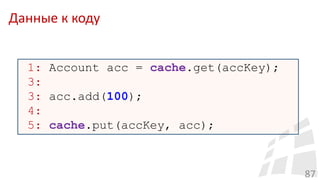

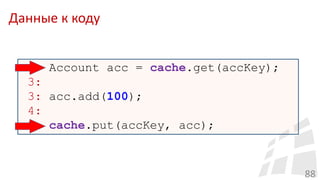

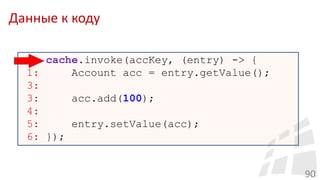

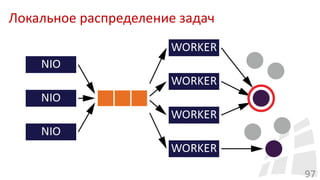

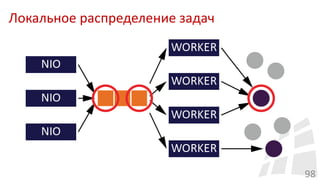

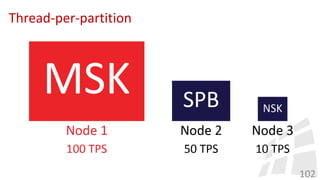

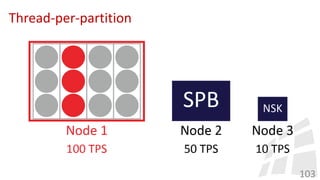

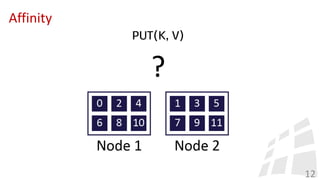

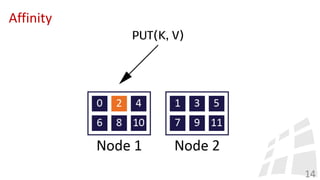

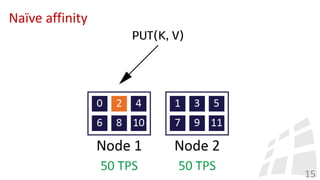

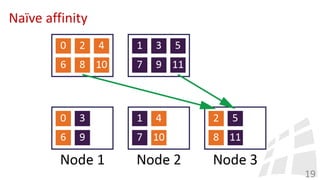

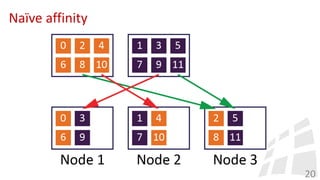

Документ обсуждает технологии шардирования и co-location в распределенных in-memory системах, включая алгоритмы и синхронизацию в кластере. Он подчеркивает важность оптимизации архитектуры и распределения задач для достижения баланса между эффективностью и стабильностью. Кроме того, охватываются аспекты многопоточности и работа с данными, возникающие в контексте разработки и применения данных технологий.

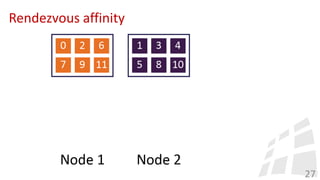

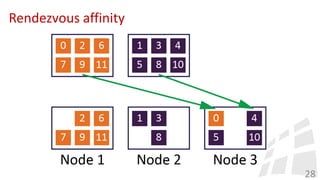

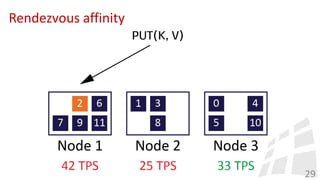

![Rendezvous affinity

22

• Consistent hashing [1]

• Rendezvous hashing (HRW) [2]

[1] https://en.wikipedia.org/wiki/Consistent_hashing

[2] https://en.wikipedia.org/wiki/Rendezvous_hashing](https://image.slidesharecdn.com/jpoint2017ozerov-170407114537/85/in-memory-22-320.jpg)