Recommended

PDF

Analysis of Learning from Positive and Unlabeled Data

PDF

強化学習勉強会・論文紹介(第30回)Ensemble Contextual Bandits for Personalized Recommendation

PDF

normalized online learning

PDF

logistic regression in rare events data

PDF

Contexual bandit @TokyoWebMining

PPTX

PPTX

組合せ最適化を体系的に知ってPythonで実行してみよう PyCon 2015

PDF

PDF

Large-Scale Bandit Problems and KWIK Learning

PPTX

Pydata_リクルートにおけるbanditアルゴリズム_実装前までのプロセス

PPTX

PDF

Asymptotically optimal policies in multiarmed bandit problems

PDF

PPTX

Pycon reject banditアルゴリズムを用いた自動abテスト

PPTX

Multi-agent Inverse reinforcement learning: 相互作用する行動主体の報酬推定

PPTX

PDF

PPTX

MLP輪読会 バンディット問題の理論とアルゴリズム 第3章

PPTX

PDF

Ml professional bandit_chapter1

PPTX

PDF

L 05 bandit with causality-公開版

PDF

PDF

PDF

[読会]Causal transfer random forest combining logged data and randomized expe...

PDF

[読会]P qk means-_ billion-scale clustering for product-quantized codes

PDF

[読会]Long tail learning via logit adjustment

PDF

[読会]A critical review of lasso and its derivatives for variable selection und...

PDF

[読会]Themis decentralized and trustless ad platform with reporting integrity

PDF

[読会]Logistic regression models for aggregated data

More Related Content

PDF

Analysis of Learning from Positive and Unlabeled Data

PDF

強化学習勉強会・論文紹介(第30回)Ensemble Contextual Bandits for Personalized Recommendation

PDF

normalized online learning

PDF

logistic regression in rare events data

PDF

Contexual bandit @TokyoWebMining

PPTX

PPTX

組合せ最適化を体系的に知ってPythonで実行してみよう PyCon 2015

PDF

Similar to finite time analysis of the multiarmed bandit problem

PDF

Large-Scale Bandit Problems and KWIK Learning

PPTX

Pydata_リクルートにおけるbanditアルゴリズム_実装前までのプロセス

PPTX

PDF

Asymptotically optimal policies in multiarmed bandit problems

PDF

PPTX

Pycon reject banditアルゴリズムを用いた自動abテスト

PPTX

Multi-agent Inverse reinforcement learning: 相互作用する行動主体の報酬推定

PPTX

PDF

PPTX

MLP輪読会 バンディット問題の理論とアルゴリズム 第3章

PPTX

PDF

Ml professional bandit_chapter1

PPTX

PDF

L 05 bandit with causality-公開版

PDF

PDF

More from shima o

PDF

[読会]Causal transfer random forest combining logged data and randomized expe...

PDF

[読会]P qk means-_ billion-scale clustering for product-quantized codes

PDF

[読会]Long tail learning via logit adjustment

PDF

[読会]A critical review of lasso and its derivatives for variable selection und...

PDF

[読会]Themis decentralized and trustless ad platform with reporting integrity

PDF

[読会]Logistic regression models for aggregated data

PDF

Introduction of introduction_to_group_theory

PDF

Squeeze and-excitation networks

PDF

Dynamic filters in graph convolutional network

PDF

Nmp for quantum_chemistry

PDF

Dl study g_learning_to_remember_rare_events

PDF

PDF

PDF

Joint optimization of bid and budget allocation in sponsored search

PDF

Towards a robust modeling of temporal interest change patterns for behavioral...

PDF

Real time bidding algorithms for performance-based display ad allocation

PDF

Fingind the right consumer - optimizing for conversion in display advertising...

PDF

Real time bid optimization with smooth budget delivery in online advertising

PDF

Estimating conversion rate in display advertising from past performance data

PDF

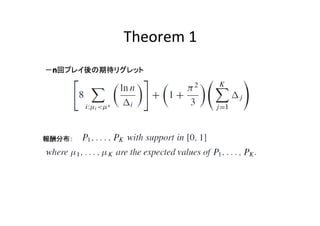

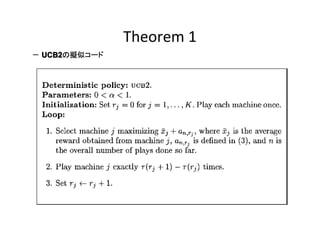

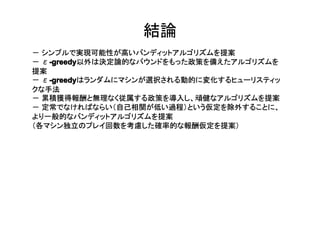

finite time analysis of the multiarmed bandit problem 1. Finite-time Analysis of the

Multiarmed Bandit

Problem

PETER AUER,University of Technology Graz

NICOL`O CESA-BIANCHI, University of Milan

PAUL FISCHER, Universitat Dortmund

ICML 2002)

(ICML 2002

@shima_x

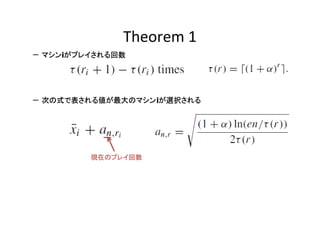

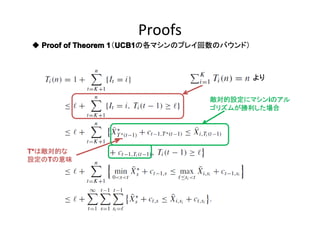

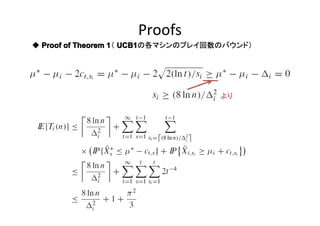

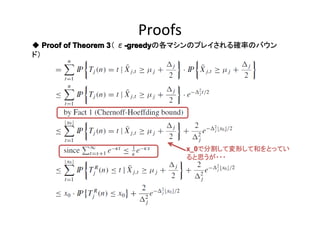

2. 3. 4. 5. 6. 7. 8. 9. 10. 11. 12. 13. 14. 15. 16. 17. 18. 19. Proofs

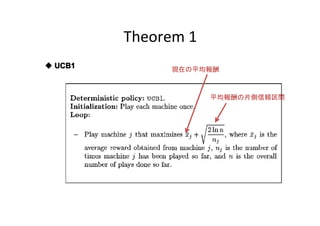

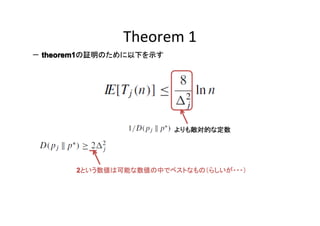

◆ Proof of Theorem 1 UCB1

1(UCB1

UCB1の各マシンのプレイ回数のバウンド)

より

i

敵対的設定にマシンiのアル

ゴリズムが勝利した場合

T*は敵対的な

T

設定のTの意味

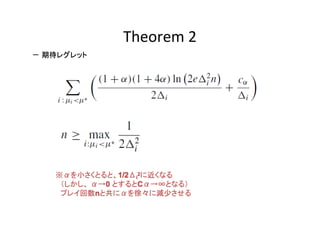

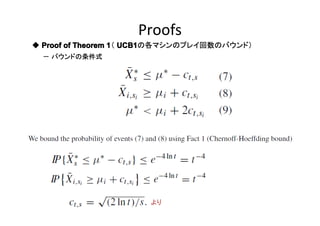

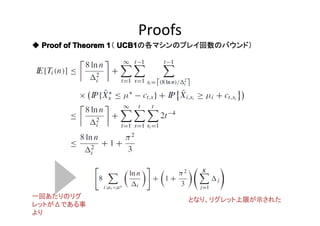

20. 21. 22. Proofs

◆ Proof of Theorem 1 UCB1

1( UCB1の各マシンのプレイ回数のバウンド)

一回あたりのリグ

レットがΔである事

より

となり、リグレット上限が示された

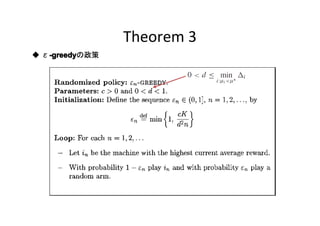

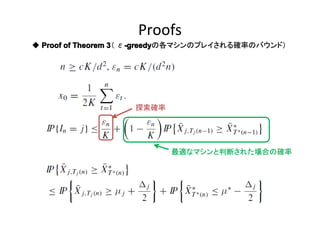

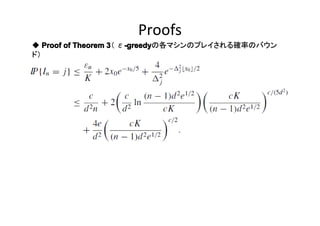

23. Proofs

◆ Proof of Theorem 3 ε-greedy

3( -greedy

-greedyの各マシンのプレイされる確率のバウンド)

探索確率

最適なマシンと判断された場合の確率

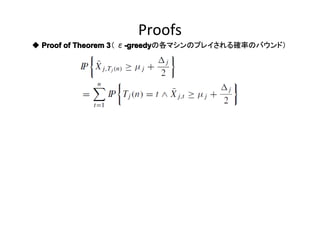

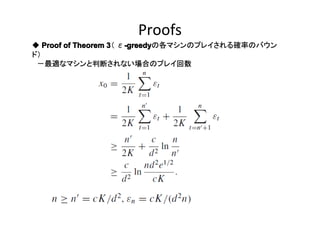

24. 25. Proofs

◆ Proof of Theorem 3 ε-greedy

3( -greedy

-greedyの各マシンのプレイされる確率のバウン

ド)

x_0

x_0で分割して変形して和をとってい

ると思うが・・・

26. Proofs

◆ Proof of Theorem 3 ε-greedy

3( -greedy

-greedyの各マシンのプレイされる確率のバウン

ド)

-最適なマシンと判断されない場合のプレイ回数

27. 28. 29.