「CVPR 2020 網羅的サーベイ」により作成された Machine Learning Architectures and Formulations エリアのメタサーベイ資料です。

CVPR 2020 網羅的サーベイ: http://xpaperchallenge.org/cv/survey/cvpr2020_summaries/listall/

cvpaper.challengeはコンピュータビジョン分野の今を映し、トレンドを創り出す挑戦です。論文サマリ作成・アイディア考案・議論・実装・論文投稿に取り組み、凡ゆる知識を共有します。2020の目標は「トップ会議に30+本投稿」することです。

http://xpaperchallenge.org/cv/

![投稿の多かった研究機関

12

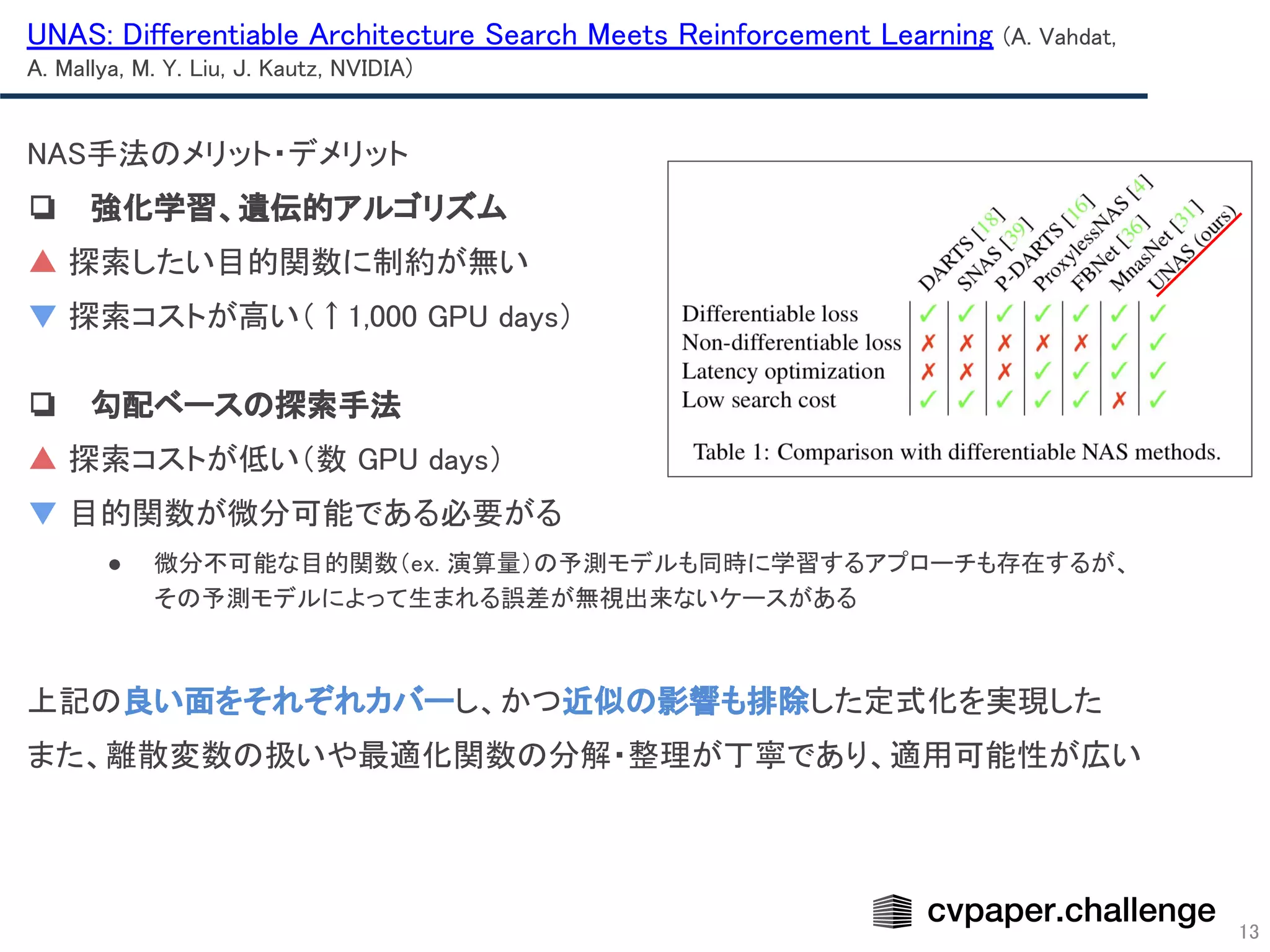

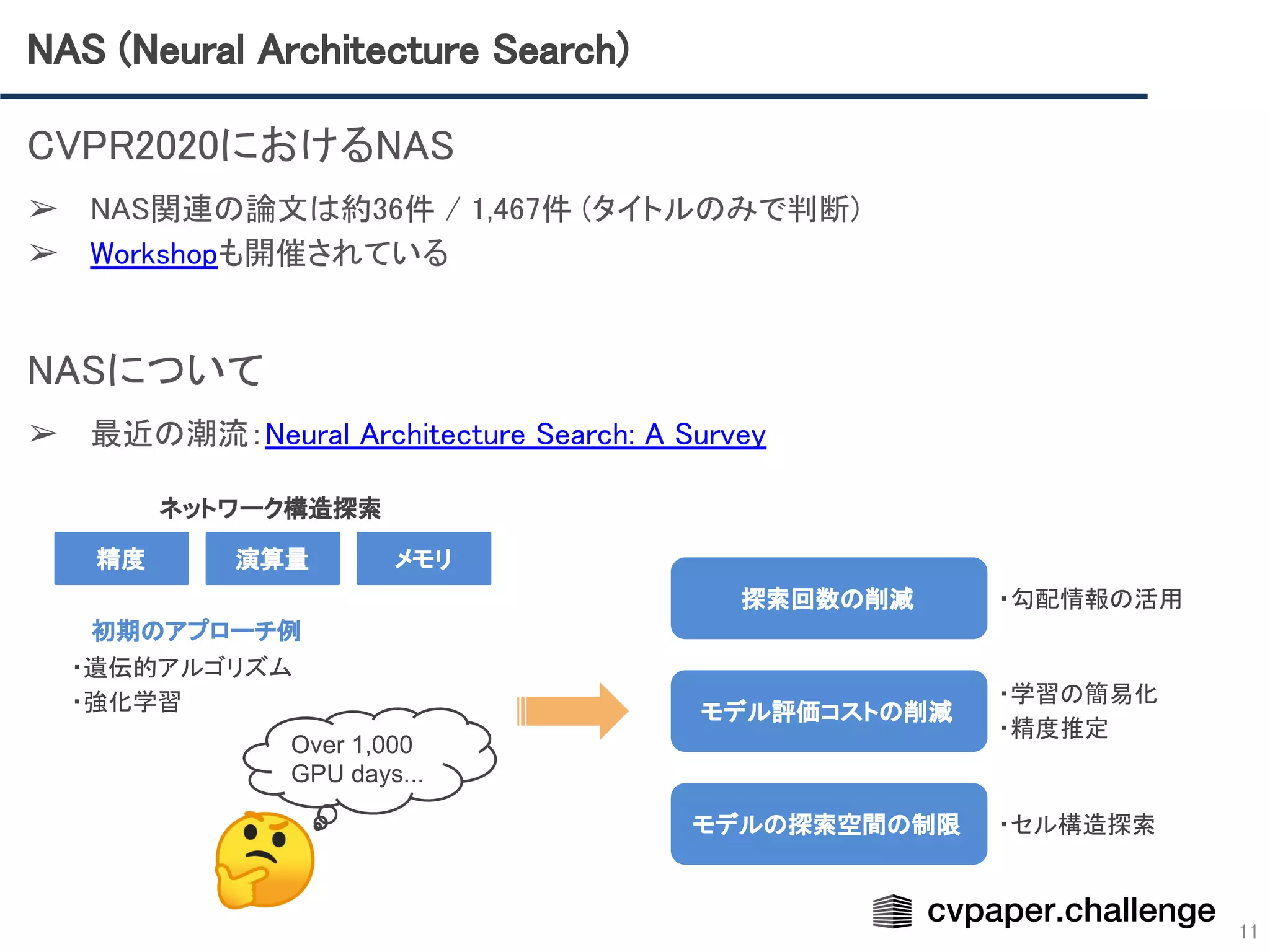

CVPR2020 NAS関連の論文36件の手動集計の結果

1位 [5件] SenseTime

2位 [3件] Huawei, 北京大学

(内2件はHuaweiと北京大学が両方共著に入っている)

3位 [2件] NVIDIA, Google, 清華大学など多数

➢ 2位にランクインしたHuaweiについて

Huaweiの中でも特に Huawei Noah’s Ark Lab

というAI研究開発機関から投稿されている。

直近でAutoMLツールをリリースしており、

AutoMLやNASの研究にも力を入れていると

思われる。

VEGA: AutoML Toolchain by Noah’s Ark Lab](https://image.slidesharecdn.com/machinelearningarchitecturesandformulations-200724003848/75/CVPR-2020-Machine-Learning-Architectures-and-Formulations-12-2048.jpg)