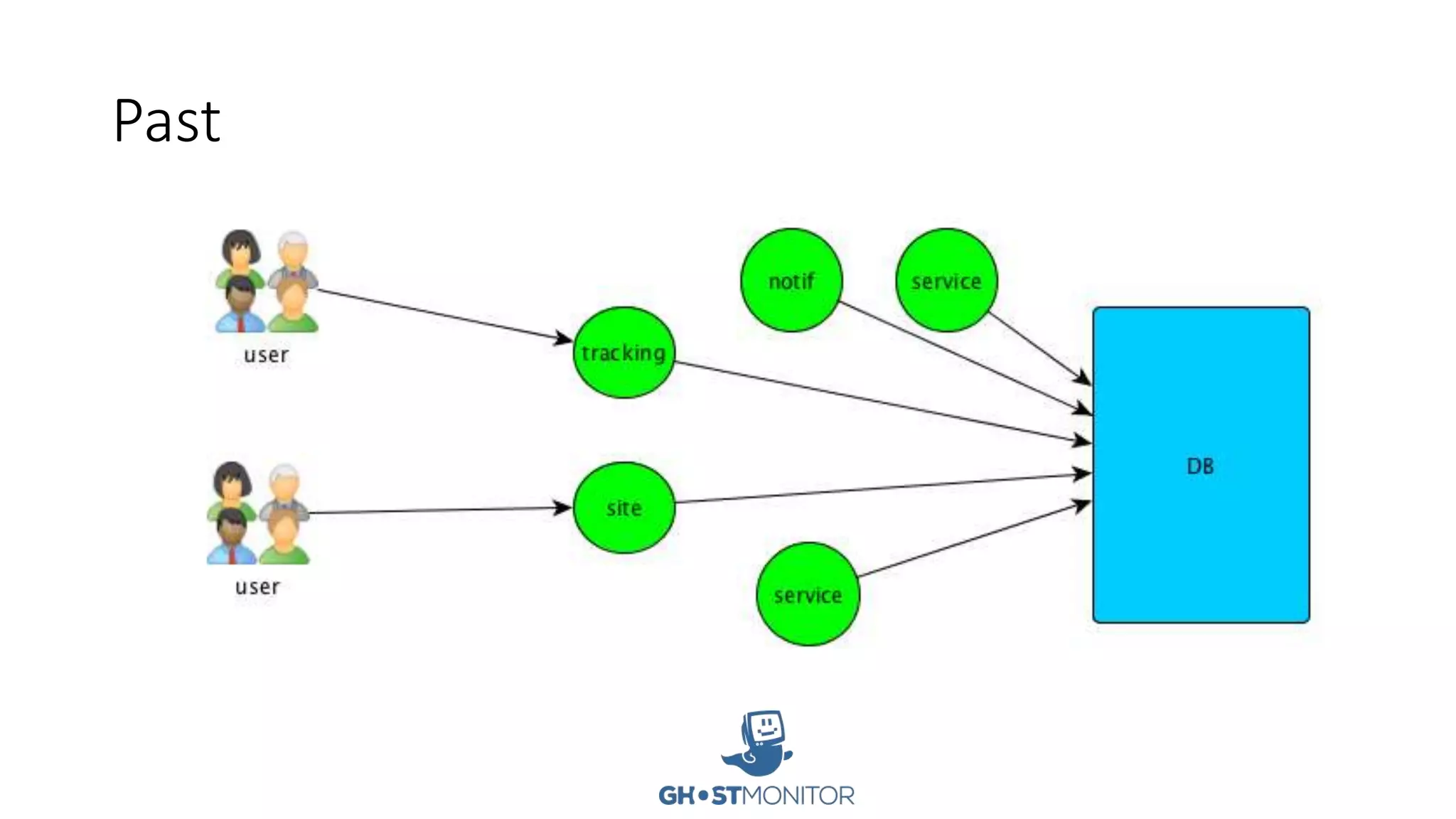

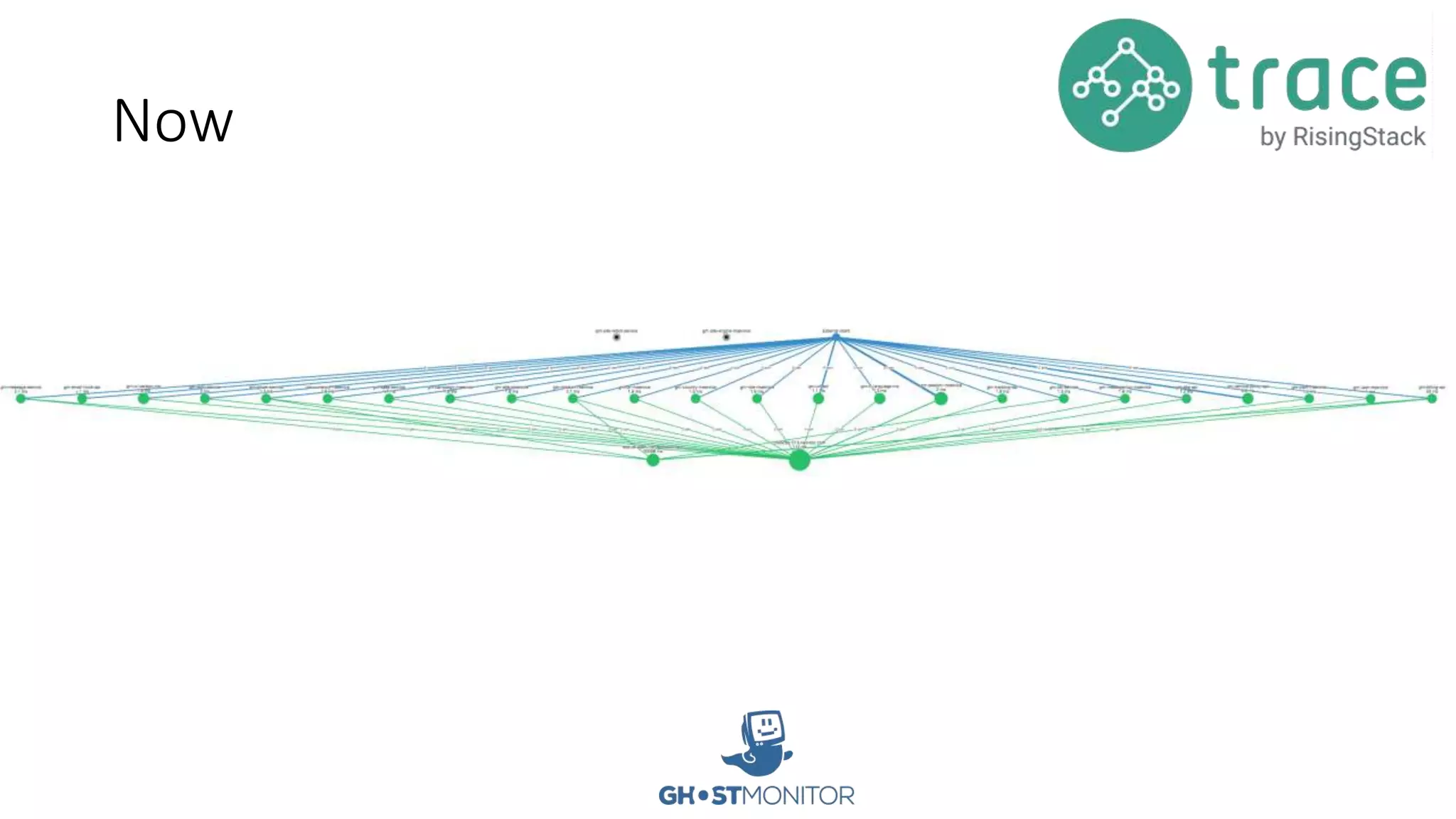

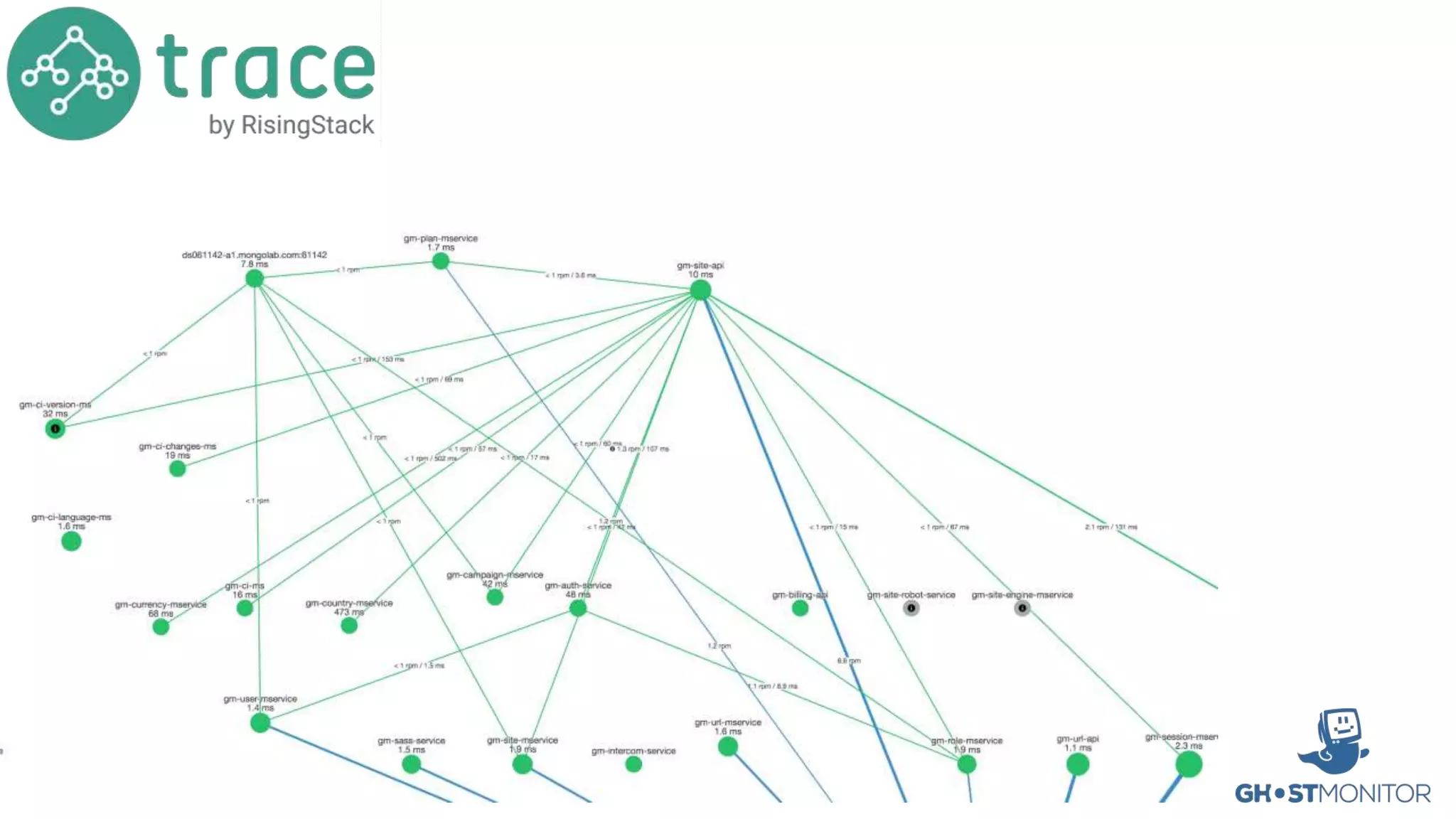

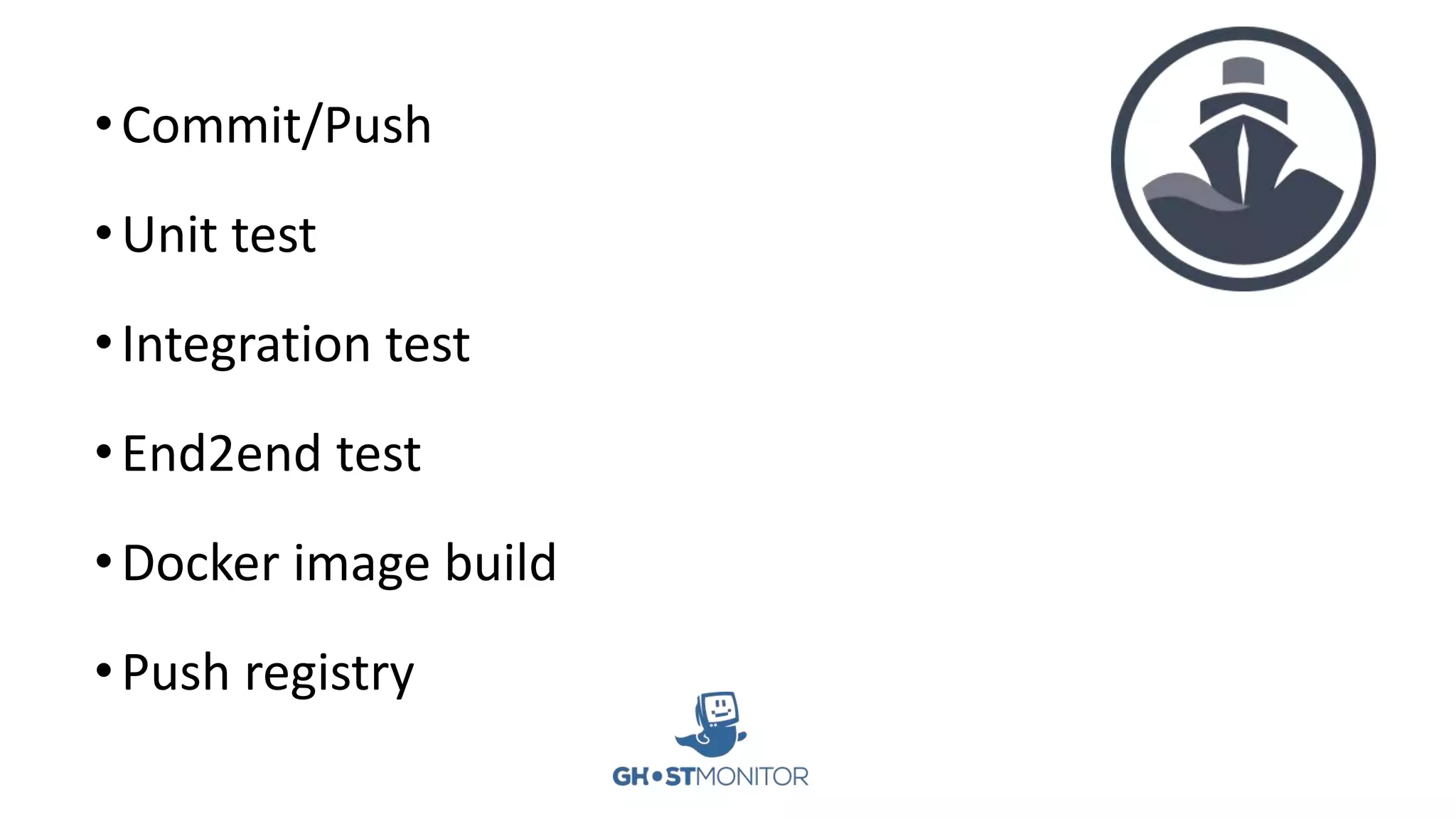

- The company uses microservices architecture with 50+ services running across 300+ containers orchestrated by Kubernetes. They have fully automated continuous integration and deployment.

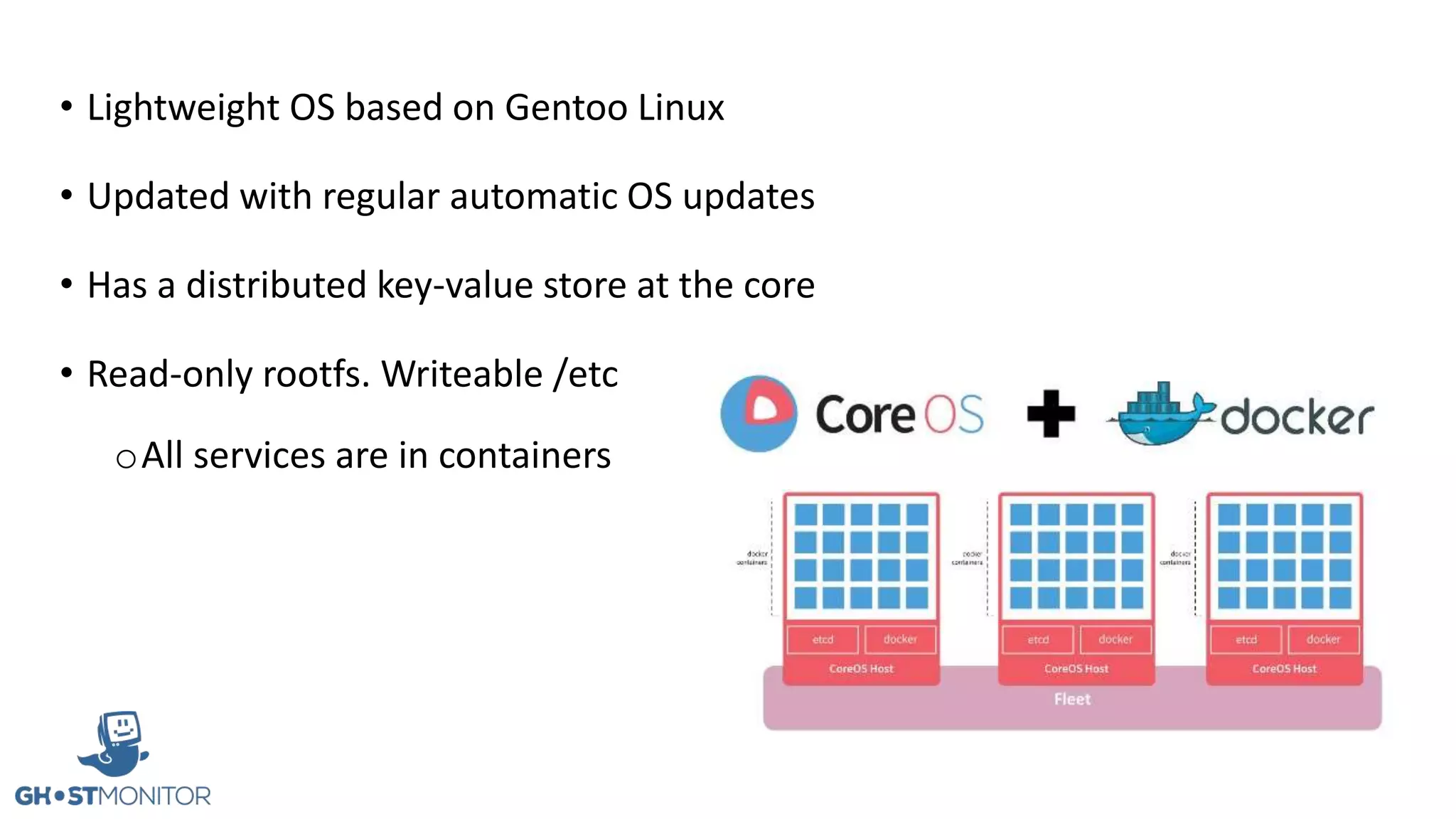

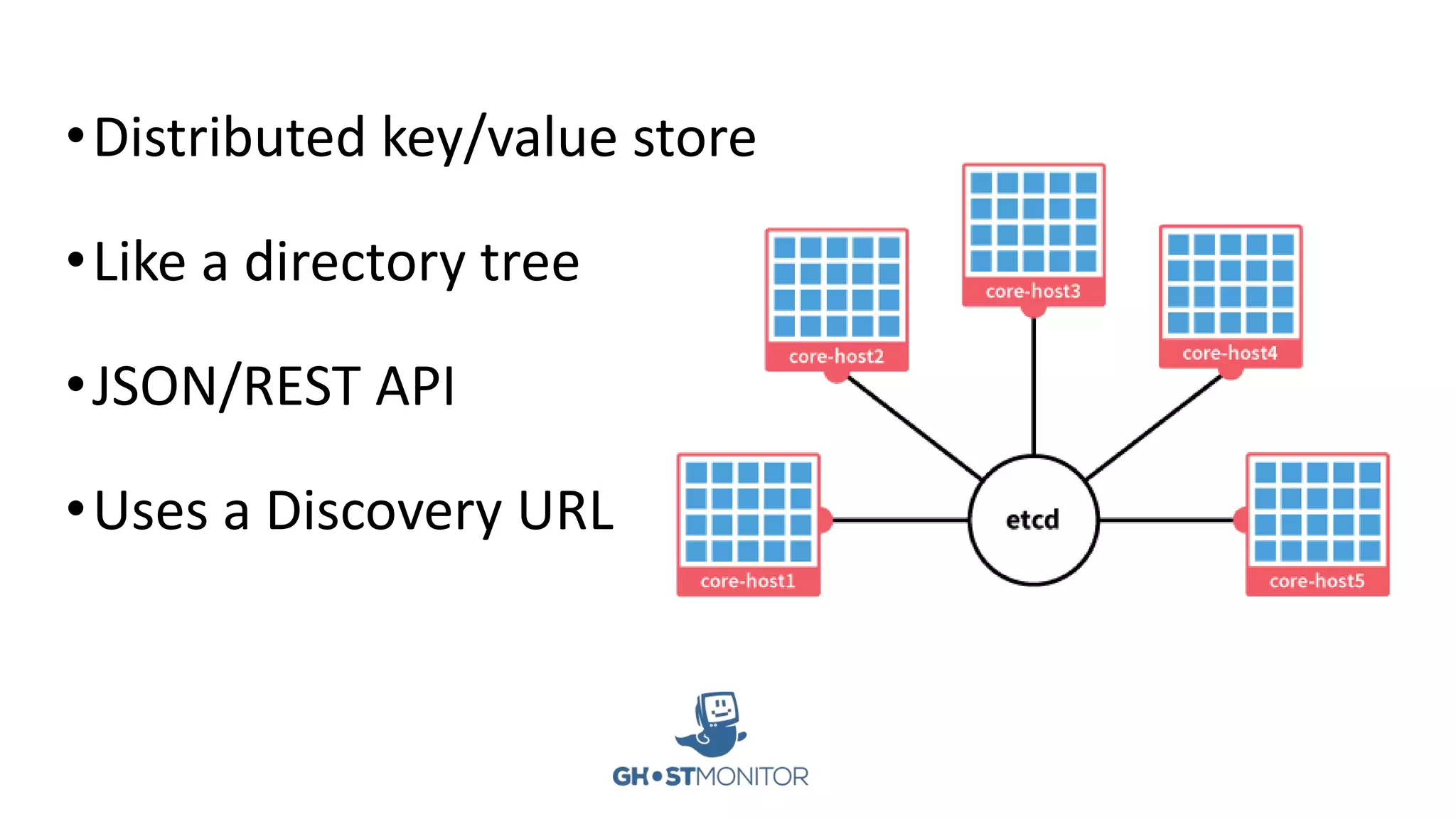

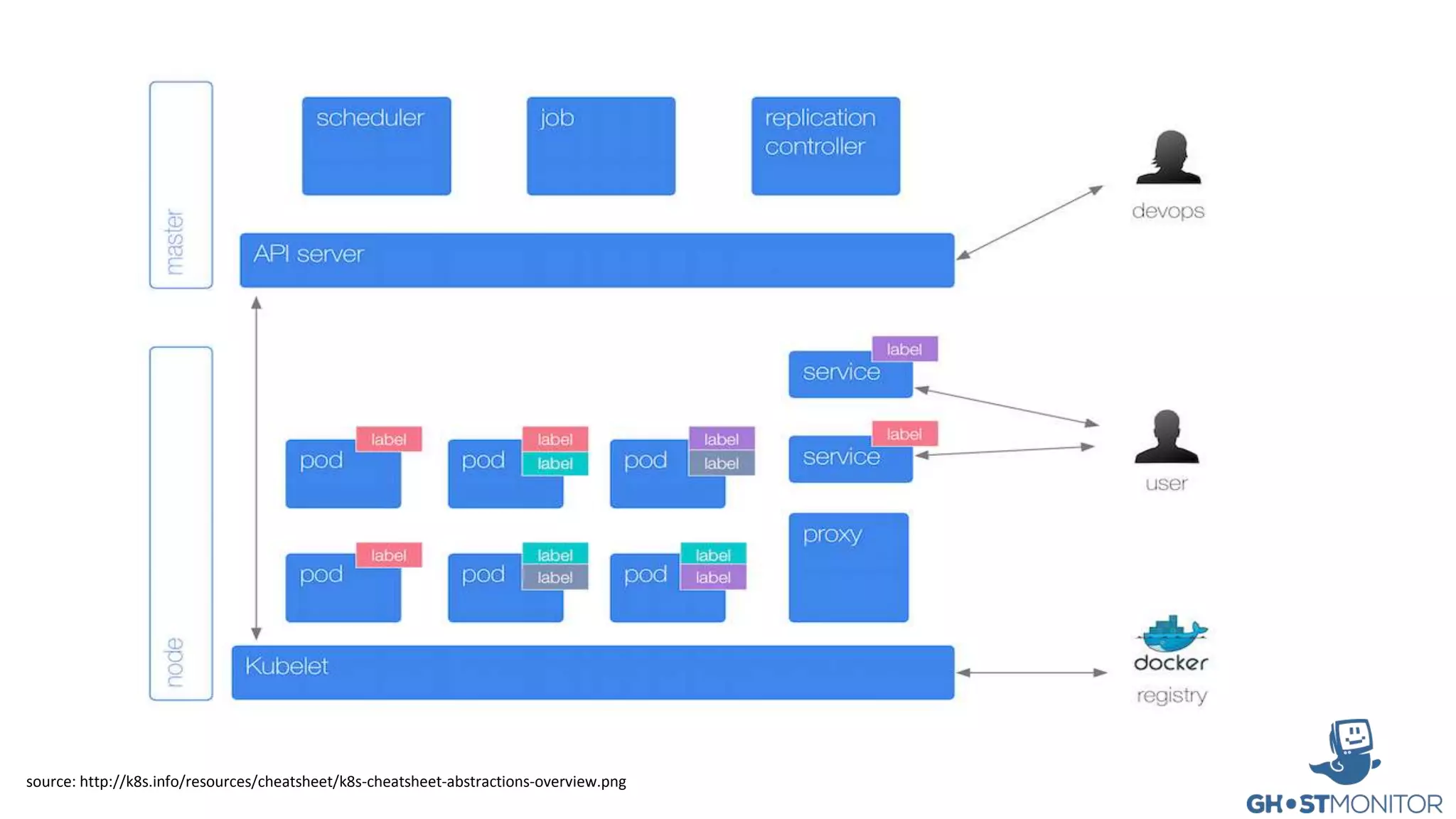

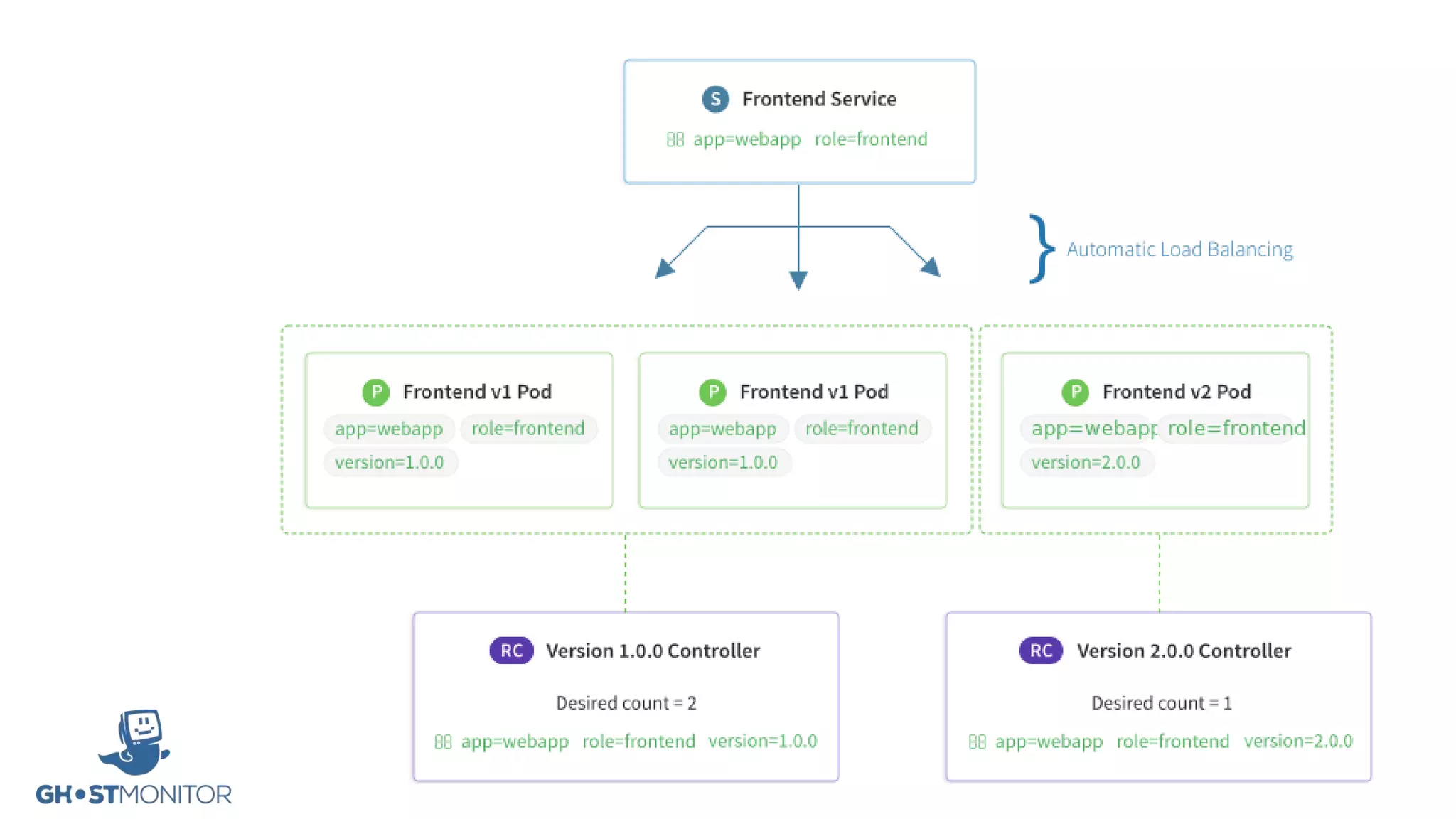

- CoreOS is used as the lightweight OS which updates automatically and stores services in read-only containers. Kubernetes provides service discovery, auto-scaling, deployment, rollback and resource management for containers.

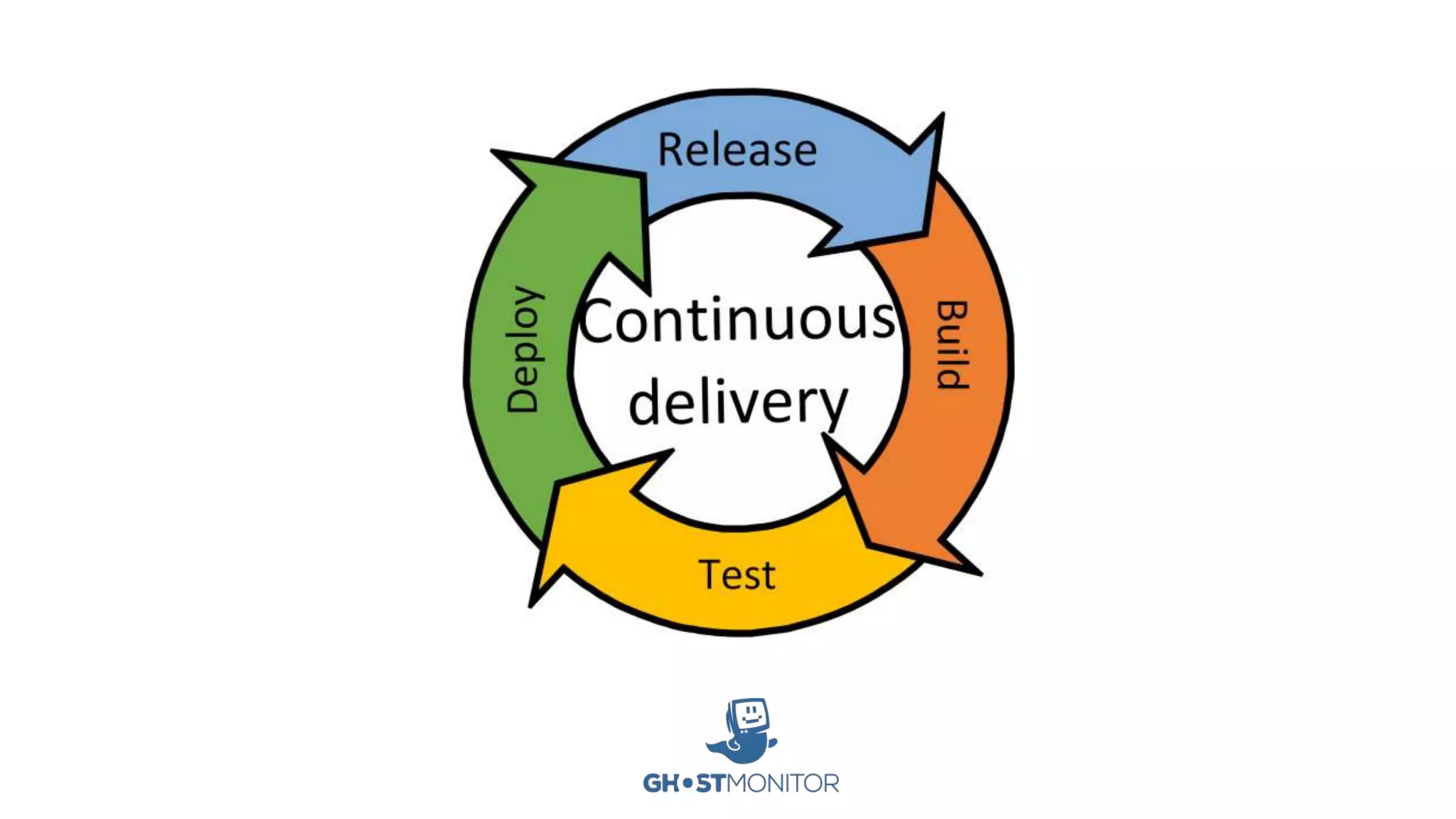

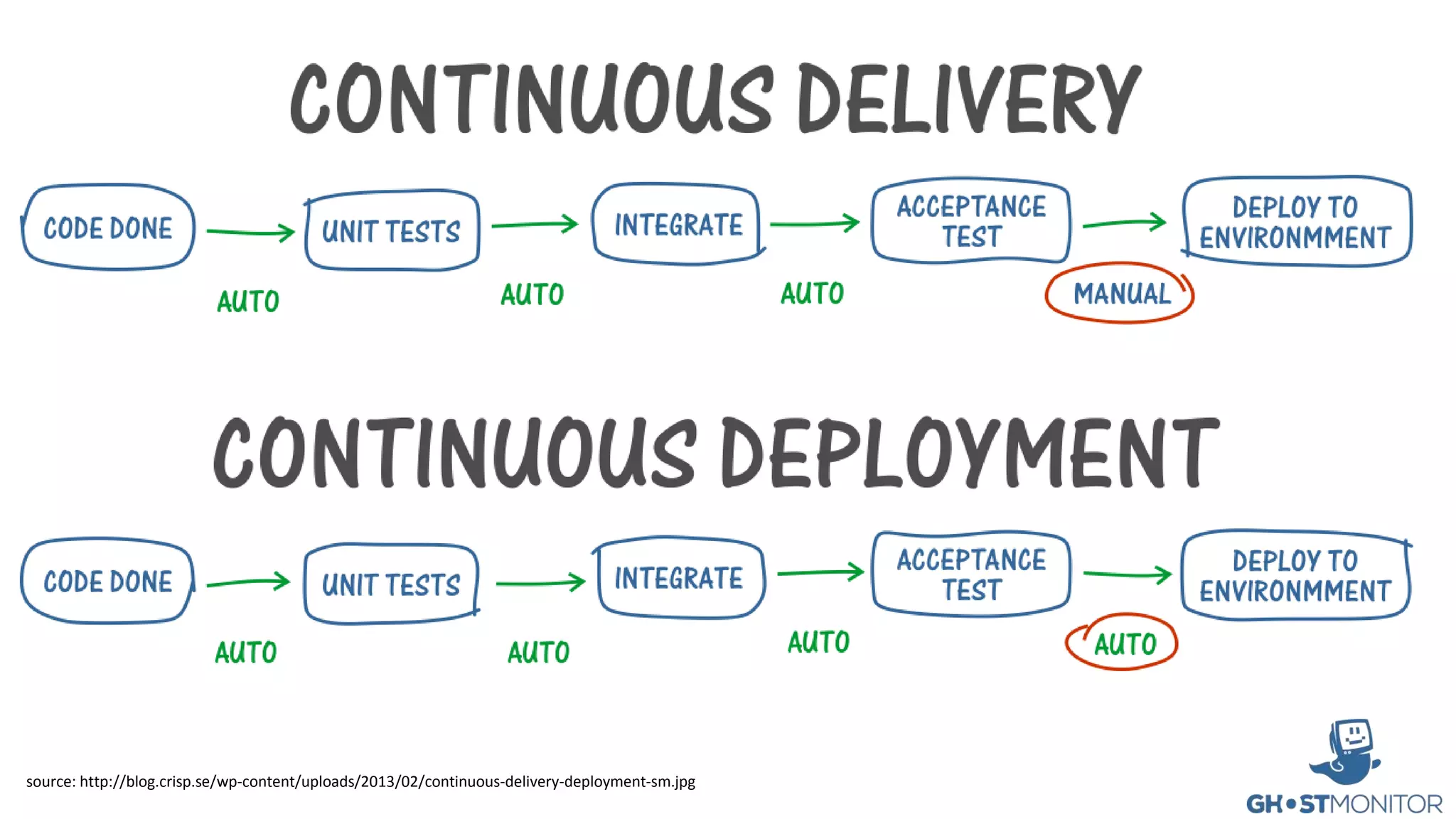

- The software development process follows a continuous delivery model where code changes are deployed through a pipeline to ensure the software can be reliably released at any time.