Sprint16

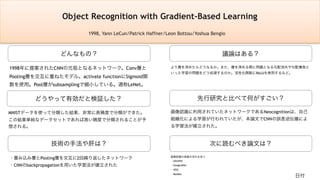

- 1. どんなもの? 先行研究と比べて何がすごい? 技術の手法や肝は? 議論はある? どうやって有効だと検証した? 次に読むべき論文は? 画像認識の発展の流れを追う ・AlexNet ・GoogLeNet ・VGG ・ResNet より層を深めたらどうなるか。また、層を深める際に問題となる勾配消失や勾配爆発と いった学習の問題をどう処理するのか。活性化関数にReLUを使用するなど。 MNISTデータを使って分類した結果、非常に高精度で分類ができた。 この結果単純なデータセットであれば高い精度で分類されることが予 想される。 ・畳み込み層とPooling層を交互に2回繰り返したネットワーク ・CNNのbackpropagationを用いた学習法が確立された 画像認識に利用されていたネットワークであるNeocognitionは、自己 組織化による学習が行われていたが、本論文でCNNの誤差逆伝播によ る学習法が確立された。 1998年に提案されたCNNの元祖となるネットワーク。Conv層と Pooling層を交互に重ねたモデル。activate functionにSigmoid関 数を使用。Pool層がsubsamplingで縮小している。通称LeNet。 Object Recognition with Gradient-Based Learning 1998, Yann LeCun/Patrick Haffner/Leon Bottou/Yoshua Bengio 日付

- 3. どんなもの? 先行研究と比べて何がすごい? 技術の手法や肝は? 議論はある? どうやって有効だと検証した? 次に読むべき論文は? 画像認識の発展の流れを追う ・AlexNet ・GoogLeNet ・VGG ・ResNet ・純粋に深いCNNを教師あり学習するだけで大幅に精度が向上する。 ・中間層を除くと精度が2%悪化するため、層が深いことは本質的に精度に影響を与えて いる。 ImageNe LSVRC-2010コンテストにおいて、CNNモデル(5つの畳み込み層と3 つの全結合層)を利用して120万の高解像度画像を1000クラスに分類した。結 果、2位(エラー率: 26.2%)以下を大きく引き離す結果(エラー率: 15.3%)と なった。 主に4つの斬新な手法を用いている。 1. 活性化関数にReLUを使い収束速度を従来に比べ数倍大きくした点 2. マルチGPUで学習した点 3. 正則化方法としてDropOutを利用した点 4. 重複プーリングを利用した点 ・これだけ大規模なデータセットに対してニューラルネットワークが成果を出したこと。 ・活性化関数にReLUを使い収束速度を従来に比べ数倍大きくした。従来はtanhやsigmoidを使うこと が一般的だった。 ・当時としては比較的新しい手法であったDropOutが利用されたこと。(現在でもよく使われる正則 化手法) この論文以前にもCNN networkは存在したが、大規模なデータセットでのCNN アプリケーションとしては最初の成功例とされる。現在の流れから見るとシン プルなアーキテクチャで、全8層のニューラルネットワーク。AlexNet自体を使 うことは少ないが後続のDNNに影響を及ぼした。 ImageNet Classification with Deep Convolutional Neural Networks 2012, Alex Krizhevsky, Ilya Sutskever, Geoffrey E. Hinton 日付

- 7. アーキテクチャの詳細 Layer Filter size Stride Output size input (227, 227, 3) conv (11, 11) (4, 4) (55, 55, 96) maxpool (3, 3) (2, 2) (27, 27, 96) conv (5, 5) (1, 1) (13, 13, 256) maxpool (3, 3) (2, 2) (13, 13, 256) conv (3, 3) (1, 1) (13, 13, 384) conv (3, 3) (1, 1) (13, 13, 384) conv (3, 3) (1, 1) (13, 13, 256) maxpool (3, 3) (2, 2) (6, 6, 256) fc(DropOut:0.5) 4096 fc(DropOut:0.5) 4096 fc(output) 1000

- 8. 学習・評価について 最適化手法 SGD 重みの初期化 w ~ N(0, 0.01) biasの初期化 conv層+fc隠れ層: 1で初期化 それ以外: 0で初期化 学習率 全層で0.1? 後々の調整で0.01 評価 top-1 error rate top-5 error rate top-1 error rate 1 - accuracy? top-5 error rate 正解ラベルが、そのモデルが最も可能 性が高いとするラベル5つの中に含まれ ない率のこと。

- 9. どんなもの? 先行研究と比べて何がすごい? 技術の手法や肝は? 議論はある? どうやって有効だと検証した? 次に読むべき論文は? VGG19 ILSVRC detection taskで、評価指標値mAPが43.9%で優勝した。 従来のような入力層から出力層まで直線的な構造ではなく、Inception構造と呼ばれる横 への広がりを持つアーキテクチャである。横方向への広がりとは、複数のサイズの異な るフィルターの畳み込み層を結合するという構造となっている。また、膨大なパラメー タを処理するために畳み込み計算を行う前に1×1の畳み込みを行い、パラメータ数を削 減している。 従来のアーキテクチャはConv層を縦方向につなげていた。このことは畳み込み層が深く なるにつれてサイズが小さくなることから層が深くならなかった。その一方、本論文で は複数の畳み込み層を並列に適用し、その結果を結合することで層を深くすることを可 能にした。 また、GAP(Global Average Pooling)を導入している点も画期的である。これは入力され た特徴マップと同じサイズのAvePoolingを行う。つまり出力が1×1×チャネル数のテンソ ルになるため、CNNの最後の畳み込み層の出力チャネル数を最終的な出力の次元数(ク ラス数)としGAPを適用することで全結合層を利用せずに済む。このことはパラメータ 数の削減を意味し、過学習を防ぐ。 ILSVRC-2014で優勝したアーキテクチャ。大きな特徴としては、 Inceptionモジュールを取り入れた点で、これにより層をより深くする ことができるようになった。全体で22層のアーキテクチャである。 Going deeper with convolutions 2014, Christian Szegedy/Wei Liu/Yangqing Jia et al. 日付

- 11. どんなもの? 先行研究と比べて何がすごい? 技術の手法や肝は? 議論はある? どうやって有効だと検証した? 次に読むべき論文は? ・ResNet(2015) 初期化手法としてGlorotの初期化(randomに初期化)を使用しているが、この初期化で 行われるスケーリングは活性化関数の線型性を前提としており、ReLU関数を活性化関数 として使用している場合は適切ではないのではないか、という点が議論としてあげられ る。 ILSVRC-2012 データセットを使ってモデルの性能を検証した。評価指 標として用いられたのはAlexNet(2012)と同様top-1 errorとtop-5 error である。 ・フィルターサイズを3×3にしている点 ・MaxPoolingの後のConv層のチャネル数を2倍にしている点 ・重みの初期化はrandom initialization ・バッチサイズ: 256, momentum: 0.9, dropuout ratio: 0.5, learning rate: 0.01~ それまでのCNNモデルとの違いは層の深さやフィルターサイズが主であるが、それらの 要因から画像の認識精度が上がった点(ただ闇雲に層を深くすればいいわけでは勿論な い)。AlexNetのアーキテクチャと根本は同じで、かつたった2つのモデルを組み合わせ ただけ(D, E)でILSVRC-2012, 2013のSOTAを上回った点。 画像認識処理において、Image Netなどの大規模なデータセットに対して畳み 込みネットワークが結果を出した。この論文の主なる論点とAlexNetとの主な 違いは、層を深くした(重み付き層最大19層)ことである。また3×3という小 さなフィルターサイズで畳み込みを行なうことで性能が上がった。 日付 Very Deep Convolutional Networks for Large-Scale Image Recognition 2015, Karen Simonyan/Andrew Zisserman

- 12. VGG16のアーキテクチャ

- 14. どんなもの? 先行研究と比べて何がすごい? 技術の手法や肝は? 議論はある? どうやって有効だと検証した? CIFAR-10を使ってさらに深い層を試しているが(1202層)、制度としては依然として良いがResNet-110 という110層のモデルよりも下がってしまっている。この理由としては、層を深くしすぎることはや はり勾配消失等の問題があるのかもしれない。また、過学習をしている問題もあり、これは不必要に パラメータ数が多いため、強い正則化をかけることで改善されるかもしれない。 また、ResNetは学習に時間がかかる(層を深くしているため)。100層を超えると学習に数週間かか るため、改善が必要。例えば層を深くするのではなく畳み込む際のフィルタの数を増やすなどの工夫 が考えらるる。 最も特徴的なのは層を深くすることに耐えうるようにResidential Learing Frameworkを 使用していることである。また、VGG16との違いとしては、MaxPooling層がないこと、 全結合層に隠れ層がないこと、DropOutがないことが挙げられる。 従来のモデルでは深くても16~30層ほどであった。その主な理由としてあげられるのは 層を深くすることによって勾配消失や勾配爆発を引き起こしやすくなることであった。 しかし本論文ではDeep Residual Learning Frameworkによりこの問題を解決することが でき、従来モデルよりもはるかに深い層でも精度を得ることができる。 初期化手法をHeの初期化にしたことで、活性化関数をReLUにできる点。 深いニューラルネットワークの学習は困難とされてきたが、本論文で はResidential Learning Frameworkを使用することで、100層を超える ネットワークの学習を可能にし、結果としてImageNetテストセットで 3.57%のエラー率を達成した。(これはILSVRC-2015でSOTA。) Deep Residual Learning for Image Recognition 2015, Kaiming He/Xiangyu Zhang/Shaoqing Ren/Jian Sun 日付

- 15. Residual Learning Frameworkの考え方 入力 Conv Batch norm ReLU Conv Batch norm ReLU 出力 入力値をx、従来のCNNにおける☆部での値をH(x) ResNetではshortcut connectionでx、deep pathで F(x) = H(x) - xを出力し、☆でこれらを加算する。 重みの更新もdeep pathでF(x)を出力するように学習 される。 残差(residue)を出力するネットワークだから ResNet(Deep Residual Network)と呼ばれる。 X F(X) D E E P P A T H Shortcut connection あくまでも目的は勾配が消失しないようにすること!

- 16. 各アーキテクチャの比較

- 17. アーキテクチャの詳細