More Related Content

PPT

PPTX

PPTX

PPTX

PDF

cassandra 100 node cluster �admin operation DOC

PDF

PDF

[db tech showcase Tokyo 2016] D27: Next Generation Apache Cassandra by ヤフー株式会... What's hot

PPT

PDF

Cassandraとh baseの比較して入門するno sql PDF

PDF

PDF

PDF

PDF

PPT

PDF

PDF

PDF

PDF

PDF

ライブドア様xKLab合同勉強会 システムモニタリングツール「Ganglia」の紹介 PDF

PPT

PDF

Guide to Cassandra for Production Deployments PDF

PPTX

PDF

PDF

Quick Introduction to GlusterFS Viewers also liked

PDF

C22 スプリットブレインになっても一貫性を保証するインメモリデータグリッド製品 by Taichi Umeda PDF

なぜApache HBaseを選ぶのか? #cwt2013 PDF

CaSSanDra: An SSD Boosted Key-Value Store PPTX

PDF

5分でわかる Apache HBase 最新版 #hcj2014 PPTX

Similar to Consistency level

PDF

MapR アーキテクチャ概要 - MapR CTO Meetup 2013/11/12 PDF

Amazon ElastiCache - AWSマイスターシリーズ PDF

PDF

Red Hat OpenShift Container Storage ODP

PDF

フルオープンソースでここまで出来る。OpenStackの構築と運用 PDF

20120117 13 meister-elasti_cache-public PPTX

MongoDB on EC2 #mongodbcasual More from Kazutaka Tomita

PPTX

PPTX

Apache cassandraと apache sparkで作るデータ解析プラットフォーム PPTX

Apache sparkとapache cassandraで行うテキスト解析 PPTX

PDF

PPTX

PPTX

What is row level isolation on cassandra PDF

PPTX

PPTX

Consistency level

- 1.

- 2.

- 3.

- 4.

- 5.

- 6.

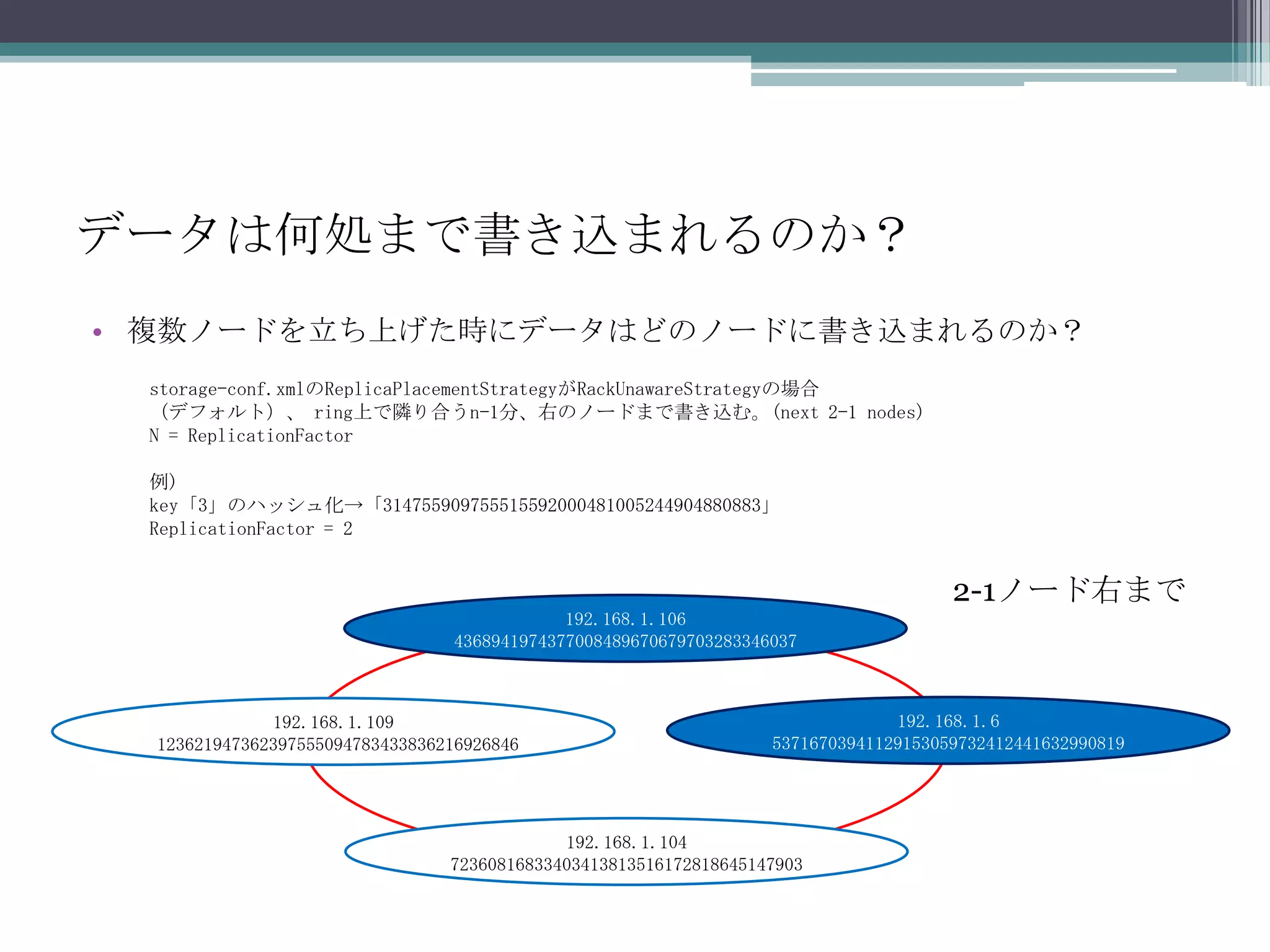

thriftAPIで見てみるthriftAPIのdescribe_ringを使用してリング情報を取得する。例)KS「TimeStampSimpleTrees」のringを取得ReplicationFactor=2結果を成形[TokenRange(end_token='123621947362397555094783433836216926846',start_token='72360816833403413813516172818645147903', endpoints=['192.168.1.109', '192.168.1.106']),TokenRange(end_token='72360816833403413813516172818645147903',start_token='53716703941129153059732412441632990819', endpoints=['192.168.1.104', '192.168.1.109']),TokenRange(end_token='4368941974377008489670679703283346037',start_token='123621947362397555094783433836216926846', endpoints=['192.168.1.106', '192.168.1.6']),TokenRange(end_token='53716703941129153059732412441632990819',start_token='4368941974377008489670679703283346037', endpoints=['192.168.1.6', '192.168.1.104'])]「3」のhash値「314755909755515592000481005244904880883」は「 192.168.1.109」, 「192.168.1.6」に格納される。 - 7.

- 8.

- 9.

- 10.

![データは何処にあるのか?(Partition)複数ノードを立ち上げた時に実際データは何処にあるのかstorage-conf.xmlのPartitionerがorg.apache.cassandra.dht.RandomPartitionerの場合(デフォルト)、キーをMD5でHash値化した値を整数とみなし、0から2^127の間の各ノードが持つレンジに割り当てる。例)KS「TimeStampSimpleTrees」、CF「SimpleTrees」、key「3」、Column「id」データの場合TimeStampSimpleTrees.SimpleTrees['3']['id']keyをmd5でハッシュ化->「314755909755515592000481005244904880883」Nodetoolよりpompadour@zaku2-F-1:~$ nodetool --host 192.168.1.104 ringAddress Status Load Range Ring 123621947362397555094783433836216926846 192.168.1.106 Up 21.53 MB 4368941974377008489670679703283346037 |<--|192.168.1.6 Up 11.01 MB 53716703941129153059732412441632990819 | |192.168.1.104 Up 4.37 MB 72360816833403413813516172818645147903 | |192.168.1.109 Up 10.95 MB 123621947362397555094783433836216926846 |-->|192.168.1.109のキー「123621947362397555094783433836216926846」より大きいよってプライマリレプリカは「192.168.1.106」](https://image.slidesharecdn.com/consistencylevel-100520122947-phpapp02/75/Consistency-level-4-2048.jpg)

![thriftAPIで見てみるthriftAPIのdescribe_ringを使用してリング情報を取得する。例)KS「TimeStampSimpleTrees」のringを取得ReplicationFactor=2結果を成形[TokenRange(end_token='123621947362397555094783433836216926846',start_token='72360816833403413813516172818645147903', endpoints=['192.168.1.109', '192.168.1.106']),TokenRange(end_token='72360816833403413813516172818645147903',start_token='53716703941129153059732412441632990819', endpoints=['192.168.1.104', '192.168.1.109']),TokenRange(end_token='4368941974377008489670679703283346037',start_token='123621947362397555094783433836216926846', endpoints=['192.168.1.106', '192.168.1.6']),TokenRange(end_token='53716703941129153059732412441632990819',start_token='4368941974377008489670679703283346037', endpoints=['192.168.1.6', '192.168.1.104'])]「3」のhash値「314755909755515592000481005244904880883」は「 192.168.1.109」, 「192.168.1.6」に格納される。](https://image.slidesharecdn.com/consistencylevel-100520122947-phpapp02/75/Consistency-level-6-2048.jpg)