Recommended

PDF

PDF

PDF

PDF

PDF

[AWS Summit 2012] クラウドデザインパターン#4 CDP VPC移行編

PDF

PDF

PDF

PPTX

PDF

PDF

Curriculum Vitae Jan.15 Mohamed Abou Bakr

PPTX

PDF

PPTX

شركه بورتو البحر الميت للتنمية السياحية Powe point

DOCX

J431 Strategic Communications Campaign Plan

PDF

ODP

PPTX

Verbos y cuantificadores, rodriguez avila

PPTX

PDF

PPTX

PPTX

Public Safety Hiring Tutorial

PPT

PDF

PPTX

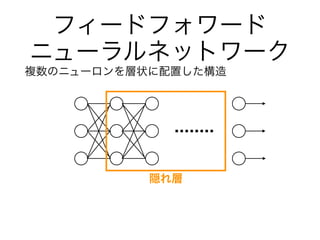

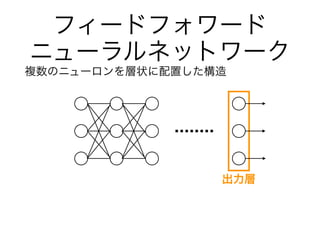

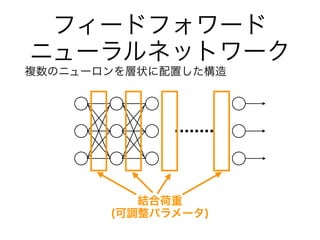

Neural Network + Tensorflow 入門講座

PDF

PDF

東京都市大学 データ解析入門 10 ニューラルネットワークと深層学習 1

PDF

PDF

PDF

Scikit-learn and TensorFlow Chap-14 RNN (v1.1)

More Related Content

PDF

PDF

PDF

PDF

PDF

[AWS Summit 2012] クラウドデザインパターン#4 CDP VPC移行編

PDF

PDF

PDF

Viewers also liked

PPTX

PDF

PDF

Curriculum Vitae Jan.15 Mohamed Abou Bakr

PPTX

PDF

PPTX

شركه بورتو البحر الميت للتنمية السياحية Powe point

DOCX

J431 Strategic Communications Campaign Plan

PDF

ODP

PPTX

Verbos y cuantificadores, rodriguez avila

PPTX

PDF

PPTX

PPTX

Public Safety Hiring Tutorial

PPT

Similar to ニューラルネットワーク勉強会2

PDF

PPTX

Neural Network + Tensorflow 入門講座

PDF

PDF

東京都市大学 データ解析入門 10 ニューラルネットワークと深層学習 1

PDF

PDF

PDF

Scikit-learn and TensorFlow Chap-14 RNN (v1.1)

PDF

PDF

PPTX

PPTX

Deep learning chapter4 ,5

PPTX

Machine Learning Fundamentals IEEE

PPTX

PPTX

【macOSにも対応】AI入門「第3回:数学が苦手でも作って使えるKerasディープラーニング」

PPTX

PPTX

論文紹介:「End-to-end Sequence Labeling via Bi-directional LSTM-CNNs-CRF」

PDF

A yet another brief introduction to neural networks

PDF

PDF

PDF

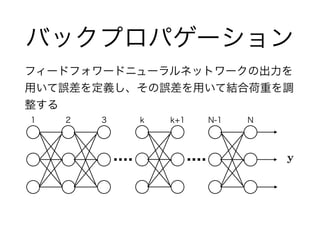

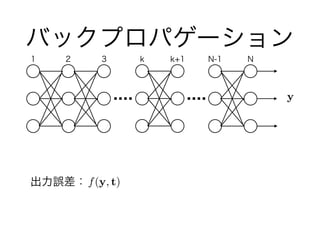

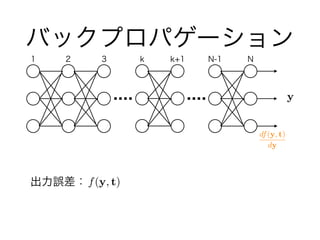

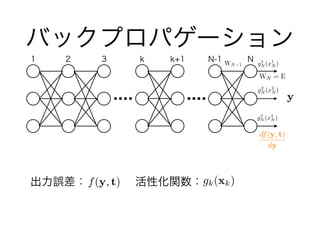

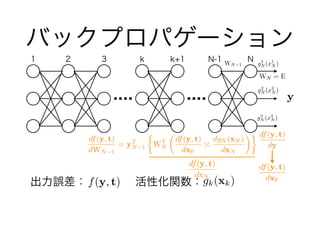

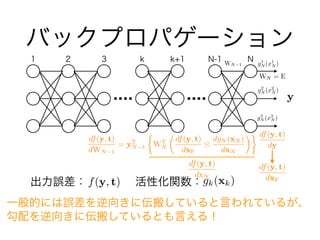

ニューラルネットワーク勉強会2 1. 2. 3. 4. 5. 6. 7. 8. 9. 10. 11. 12. 13. 出力誤差: 活性化関数:

バックプロパゲーション

f(y, t)

y

1 2 3 k k+1 N-1 N

df(y, t)

dy

g1

N (x1

N )

g2

N (x2

N )

g3

N (x3

N )

WN 1

WN = E

df(y, t)

dxN

df(y, t)

dWN 1

= yT

N 1

⇢

WT

N

✓

df(y, t)

dxF

⌦

dgN (xN )

dxN

◆

df(y, t)

dxFgk(xk)

14. gk(xk)出力誤差: 活性化関数:

バックプロパゲーション

f(y, t)

y

1 2 3 k k+1 N-1 N

df(y, t)

dy

g1

N (x1

N )

g2

N (x2

N )

g3

N (x3

N )

WN 1

WN = E

df(y, t)

dxN

df(y, t)

dWN 1

= yT

N 1

⇢

WT

N

✓

df(y, t)

dxF

⌦

dgN (xN )

dxN

◆

df(y, t)

dxF

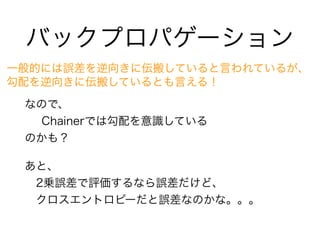

一般的には誤差を逆向きに伝搬していると言われているが、

勾配を逆向きに伝搬しているとも言える!

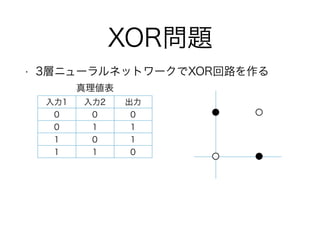

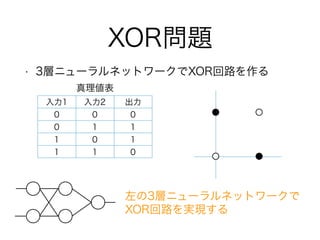

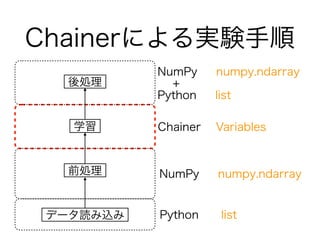

15. 16. 17. 18. 19. 20. 21. 22. 23. 24. 25. 26. 27. 28. 29. 30. 31. 32. 33. 34. 35. 36. トレーニングデータ

入力データはリストで管理

Numpyを使うのでデータは行列をイメージ

train = [[0, 0], [0, 1], [1, 0], [1,1]]

label = [[0], [1], [1], [0]]

37. 38. 39. 40. 41.

![トレーニングデータ

入力データはリストで管理

Numpyを使うのでデータは行列をイメージ

train = [[0, 0], [0, 1], [1, 0], [1,1]]

label = [[0], [1], [1], [0]]](https://image.slidesharecdn.com/nn2-151021043427-lva1-app6891/85/2-36-320.jpg)

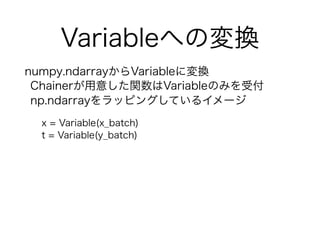

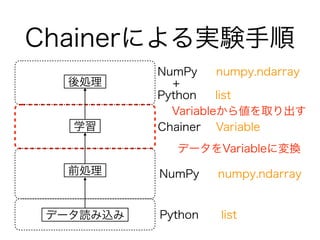

![numpy.ndarrayへの変換

Chainerを使うためにnumpy.ndarrayに変換

ここでは、ランダムにデータを選ぶバッチ学習

Chainerではnp.float32を基本的に利用

#実装例

x = np.array(train, dtype=np.float32)

y = np.array(label, dtype=np.float32)

indexes = np.random.permutation(len(train))

for i in range(0, len(train), batchsize):

x_batch = np.asarray(x[indexes[i:i+batchsize]])

y_batch = np.asarray(y[indexes[i:i+batchsize]])](https://image.slidesharecdn.com/nn2-151021043427-lva1-app6891/85/2-37-320.jpg)