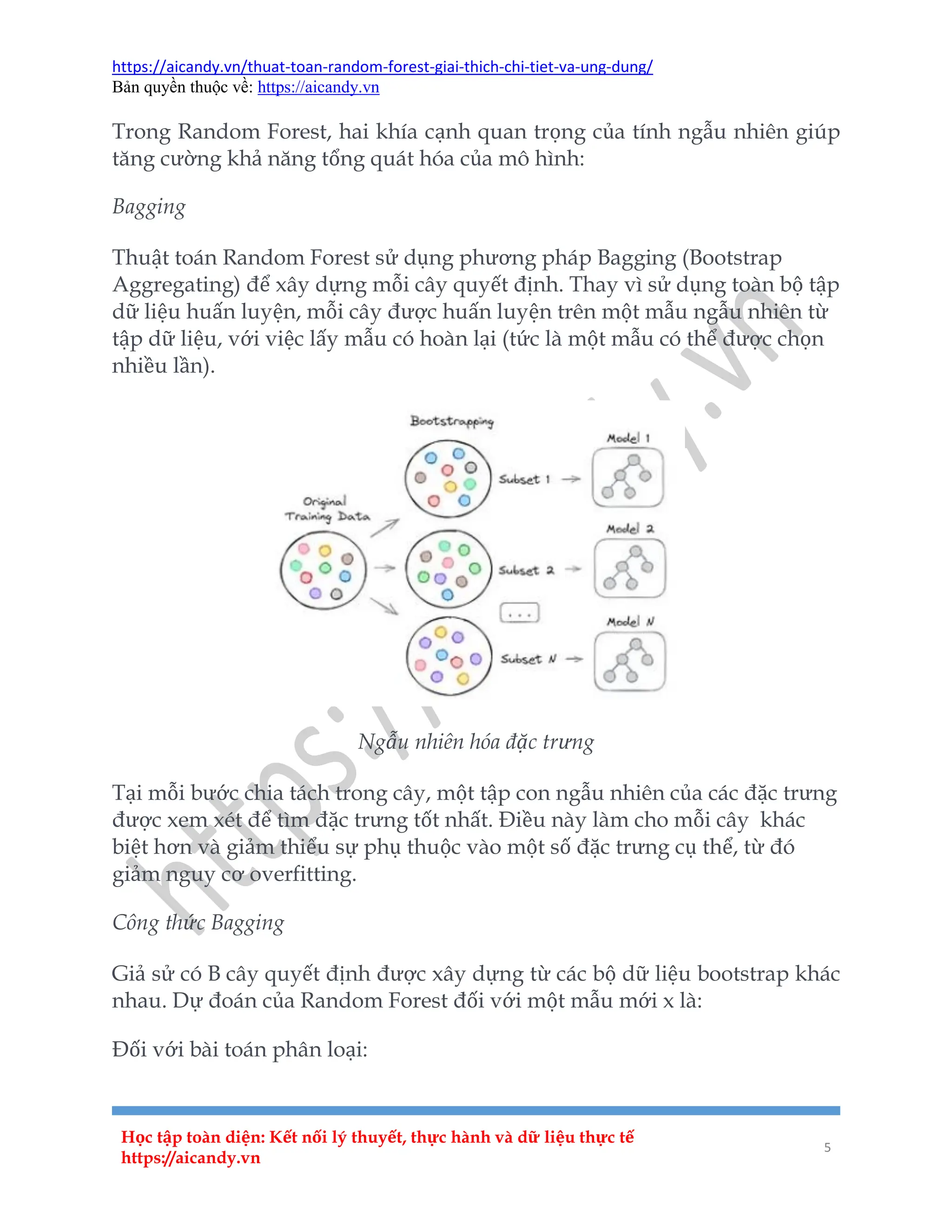

Thuật toán random forest là một phương pháp học máy giám sát, nổi bật với khả năng phân loại và hồi quy thông qua việc kết hợp nhiều cây quyết định để tạo ra một mô hình mạnh mẽ hơn. Thuật toán này sử dụng phương pháp bagging và ngẫu nhiên hóa trong việc xây dựng các cây, giúp giảm thiểu overfitting và cải thiện độ chính xác. Các ứng dụng của random forest rất đa dạng, bao gồm phát hiện gian lận, chuẩn đoán y tế, dự đoán thị trường chứng khoán, phân tích hình ảnh và dự báo thời tiết.