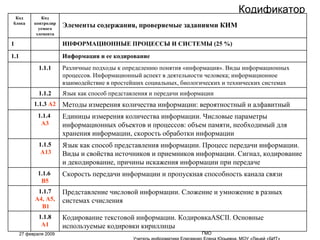

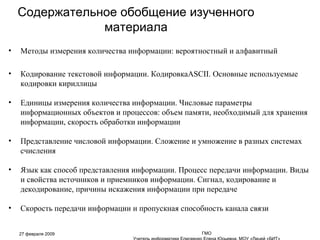

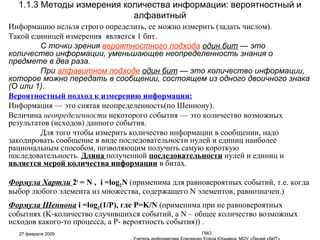

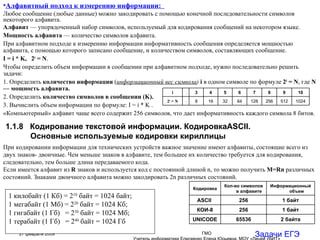

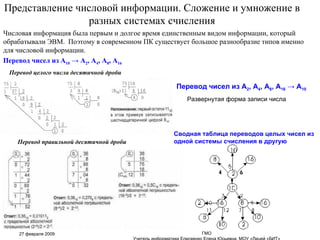

Документ обсуждает кодирование информации, включая различные кодировки (ASCII, кириллица) и методы измерения информации, такие как вероятностный и алфавитный подходы. Описываются параметры информационных объектов, включая объем памяти и скорость обработки данных, а также шифрование и декодирование сигналов. Также рассматриваются способы представления чисел и их перевод между системами счисления.