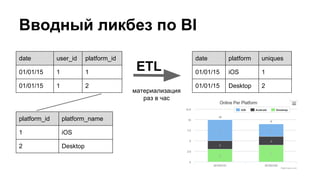

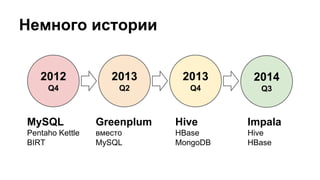

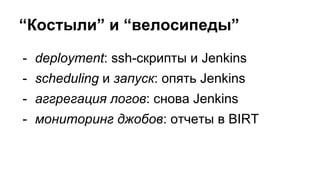

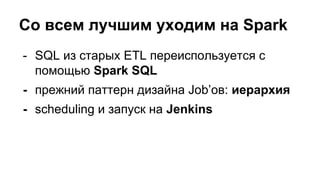

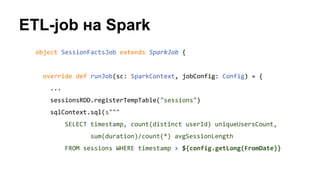

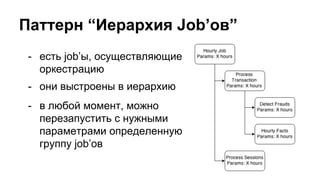

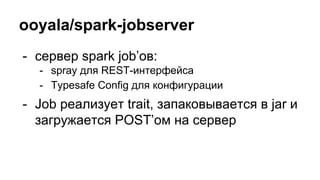

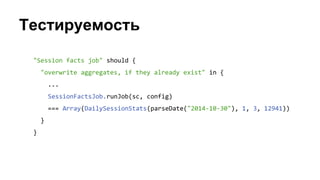

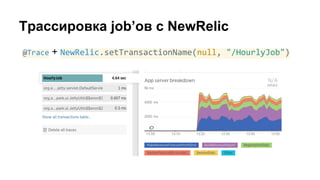

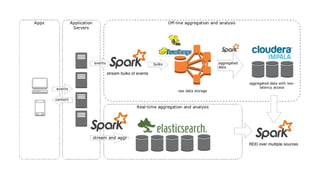

Документ представляет собой обсуждение использования ETL-процессов с Apache Spark для BI-платформ, включая примеры работы с игровыми данными и архитектуру систем. Основное внимание уделяется проблемам, связанным с устаревшими методологиями и недостатками существующих решений, таким как deployment и мониторинг. В документе также обсуждаются перспективы применения технологий, таких как Spark Streaming и интеграция с Elasticsearch.