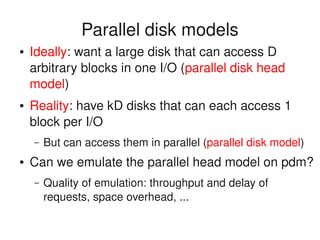

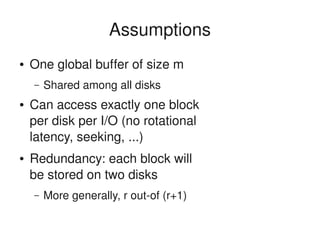

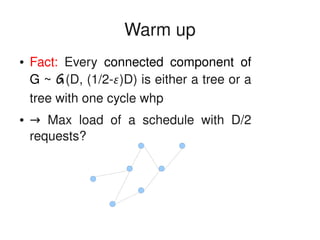

This document discusses parallel disk models and techniques for emulating a parallel disk head model on multiple disks that can each access one block per I/O. It presents several algorithms for writing and reading blocks in parallel across disks with low maximum load, including:

1) Queued writing that stores each block on two disks and achieves an expected write time of 1+exp(-D) for (1-ε)D blocks.

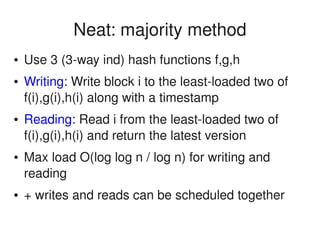

2) A majority method that stores each block on three disks and can schedule writes and reads together with maximum load O(log log n / log n).

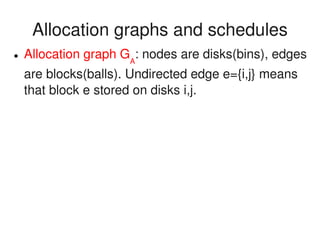

3) Techniques for orienting allocation graphs to achieve maximum loads of 1, 2, and O(log log

![Outline

● Outline

● Parallel disk models

● Emulations

● Open problems

● Bibliography

– [Sanders et al, soda00, spaa00, soda02] and

related work on balanced allocations [Czumaj,

Berenbrink,]](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-2-320.jpg)

![Emulation: queued writing

● Assume pairwiseindependent hash functions

f,g:[n]>[n]. Consider D queues Q1

...QD

● Each block i will be stored at f(i),g(i)

● Write((1)D blocks): append blocks to queues,

keep writing from queues until ∑i

|Qi

| < O(D/)](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-7-320.jpg)

![Emulation: queued writing

● Assume pairwiseindependent hash functions

f,g:[n]>[n]. Consider D queues Q1

...QD

● Each block i will be stored at f(i),g(i)

● Write((1)D blocks): append blocks to queues,

keep writing from queues until ∑i

|Qi

| < O(D/)

● Theorem [Sanders]:

– E[time to write (1)D blocks] < 1+exp(D)](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-8-320.jpg)

![Aside: allocation processes

● Eg [Azar, Broder, Karlin, Upfal STOC94],

[Mitzenmacher 96], [Czumaj, Berenbrink, ..]

● m bins, n balls; ball i can go to 2 bins f(i),g(i)

chosen independently and uar

● Balls arrive online, thrown into leastloaded of

f(i),g(i)

● Interested in maxj

load(j)](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-9-320.jpg)

![Allocation graphs and schedules

● Allocation graph GA

: nodes are disks(bins), edges

are blocks(balls). Undirected edge e={i,j} means

that block e stored on disks i,j.

● Schedule: given a set of requested edges S, GS

is

an orientation of GA

[S].](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-11-320.jpg)

![Allocation graphs and schedules

● Allocation graph GA

: nodes are disks(bins), edges

are blocks(balls). Undirected edge e={i,j} means

that block e stored on disks i,j.

● Schedule: given a set of requested edges S, GS

is

an orientation of GA

[S].

● Load(disk j) = indegree(j) in GS

● #I/O steps = load(schedule) = maxj

indegree(j)

→ maintain online an orientation of low indegree

– If blocks stored at several disks, GA

is a hypergraph](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-12-320.jpg)

![Max load 1.2*N/D

● Lemma[Pittel,Spencer,Wormald]: G ~ G(D,1.67D)

has no 3core whp](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-18-320.jpg)

![Max load 1.2*N/D

● Lemma[Pittel,Spencer,Wormald]: G ~ G(D,1.67D)

has no 3core whp

● Strategy: Repeatedly pick the node with largest

remaining degree, orient edges toward it and

remove it

● max load 2 for each 1.67D requests](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-19-320.jpg)

![Max load 1.2*N/D

● Lemma[Pittel,Spencer,Wormald]: G ~ G(D,1.67D)

has no 3core whp

● Strategy: Repeatedly pick the node with largest

remaining degree, orient edges toward it and

remove it

● max load 2 for each 1.67D requests

● BUT: all these must buffer requests before

scheduling them](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-20-320.jpg)

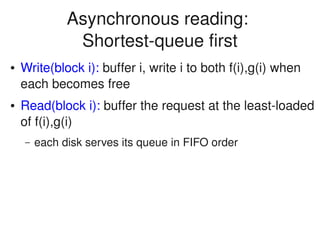

![Asynchronous reading:

Shortestqueue first

● Write(block i): buffer i, write i to both f(i),g(i) when

each becomes free

● Read(block i): buffer the request at the leastloaded

of f(i),g(i)

– each disk serves its queue in FIFO order

● Requests are scheduled online

● Conjecture[Sanders]: Delay O(log 1/) is achievable

for average arrival rate (1)D

– If 2 copies of each block allowed (Theta(1/) for 1 copy)](https://image.slidesharecdn.com/camnet-july2008-151005164148-lva1-app6891/85/Parallel-disk-head-emulation-22-320.jpg)