Embed presentation

Download to read offline

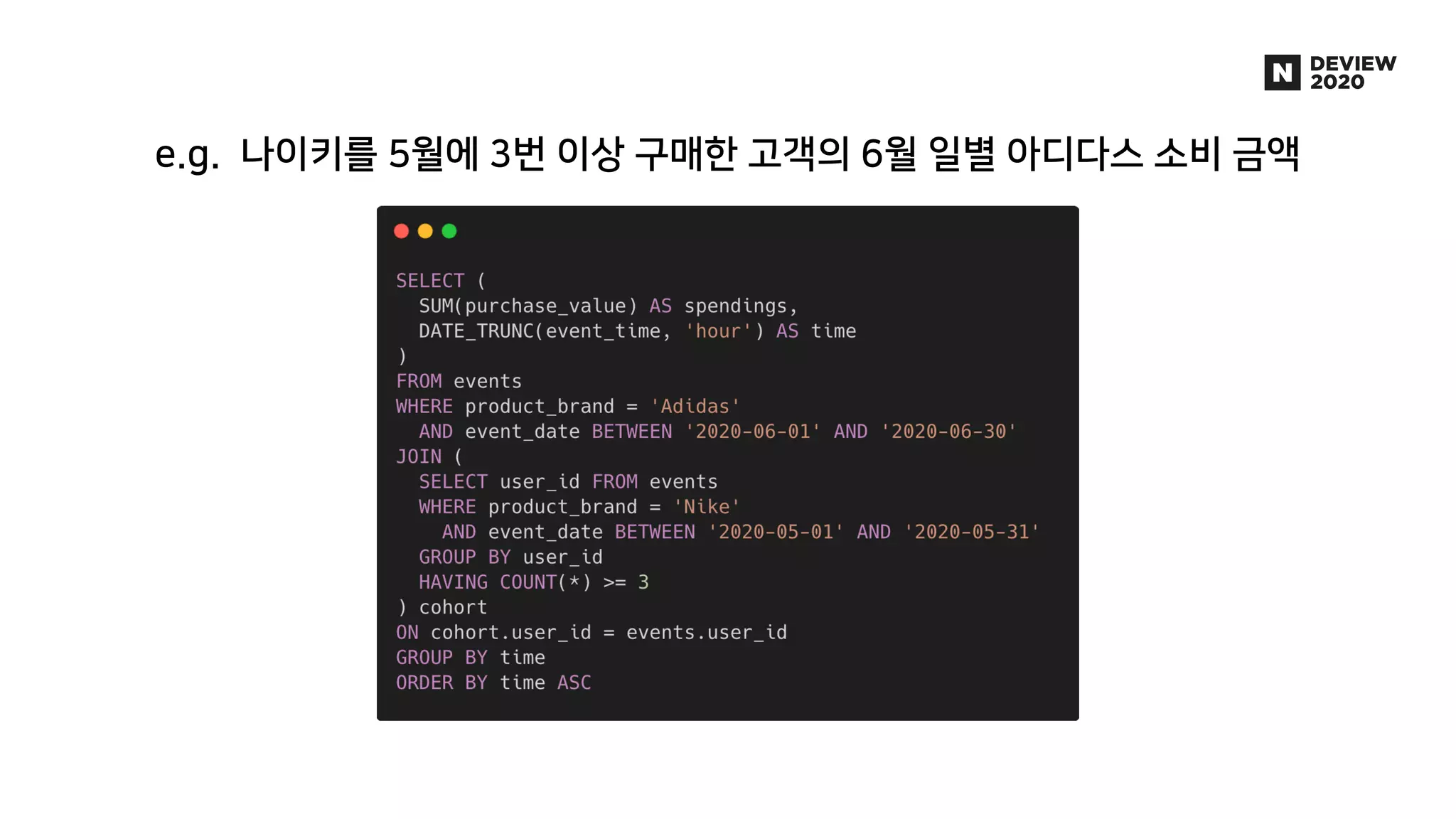

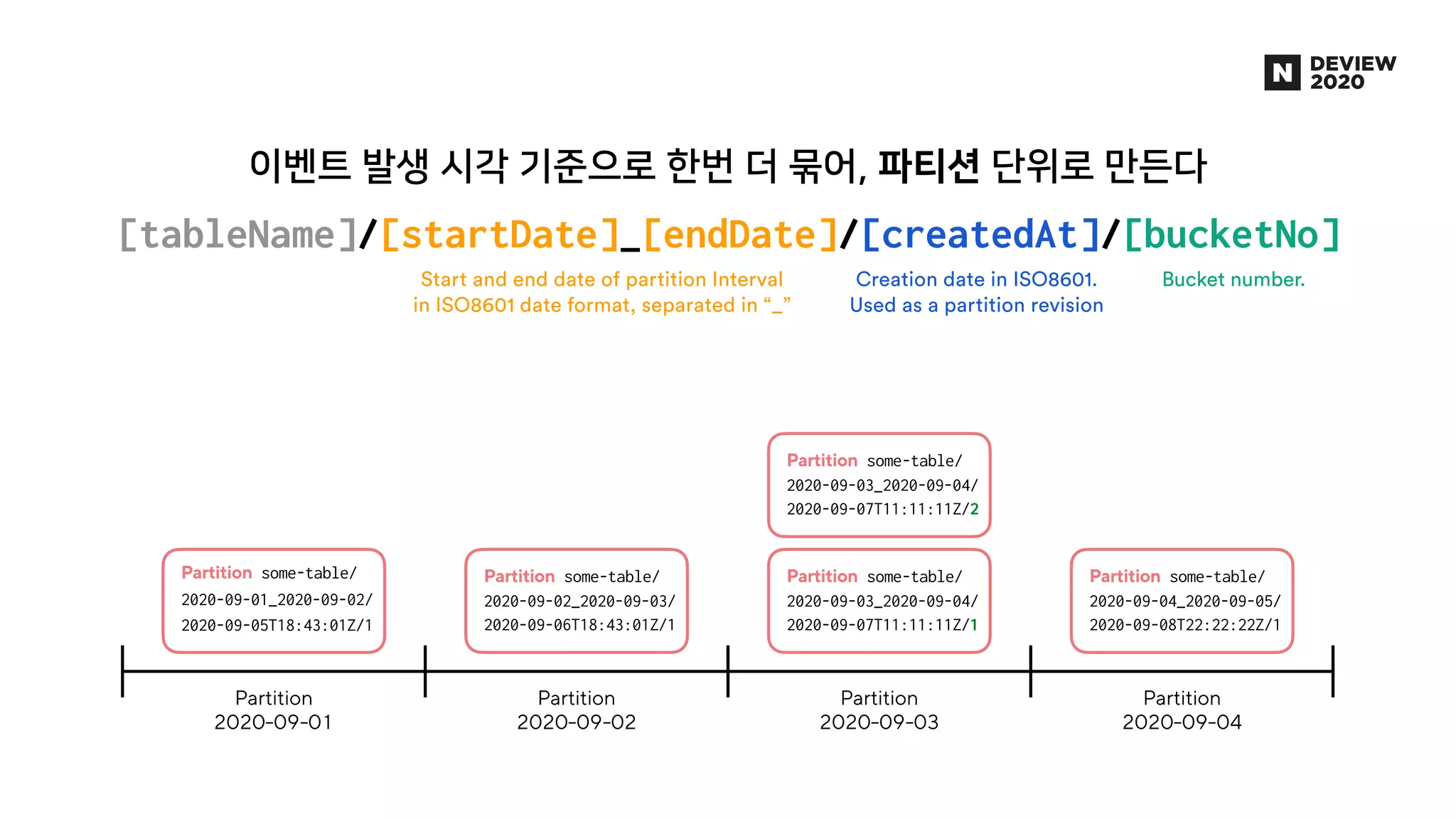

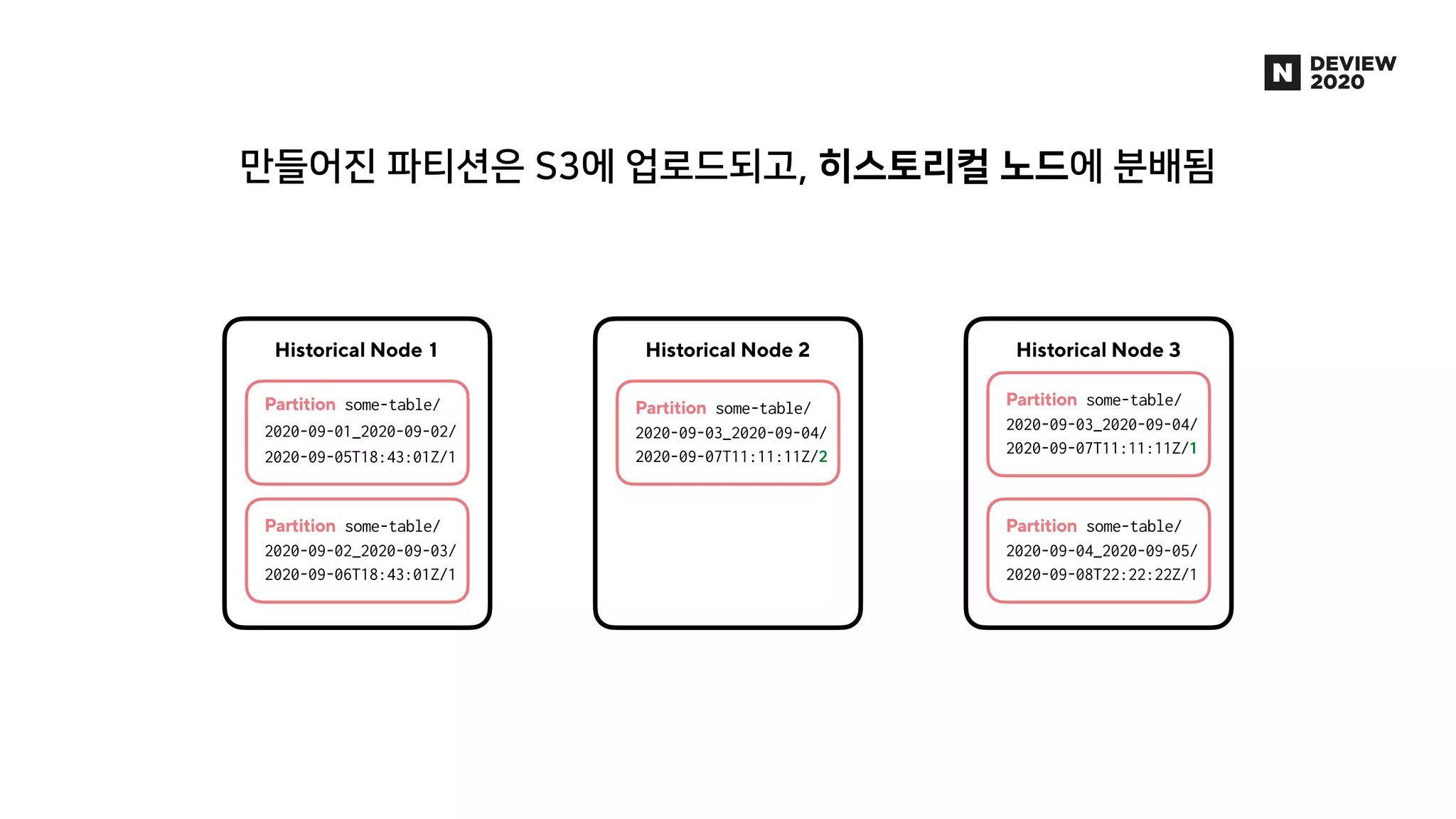

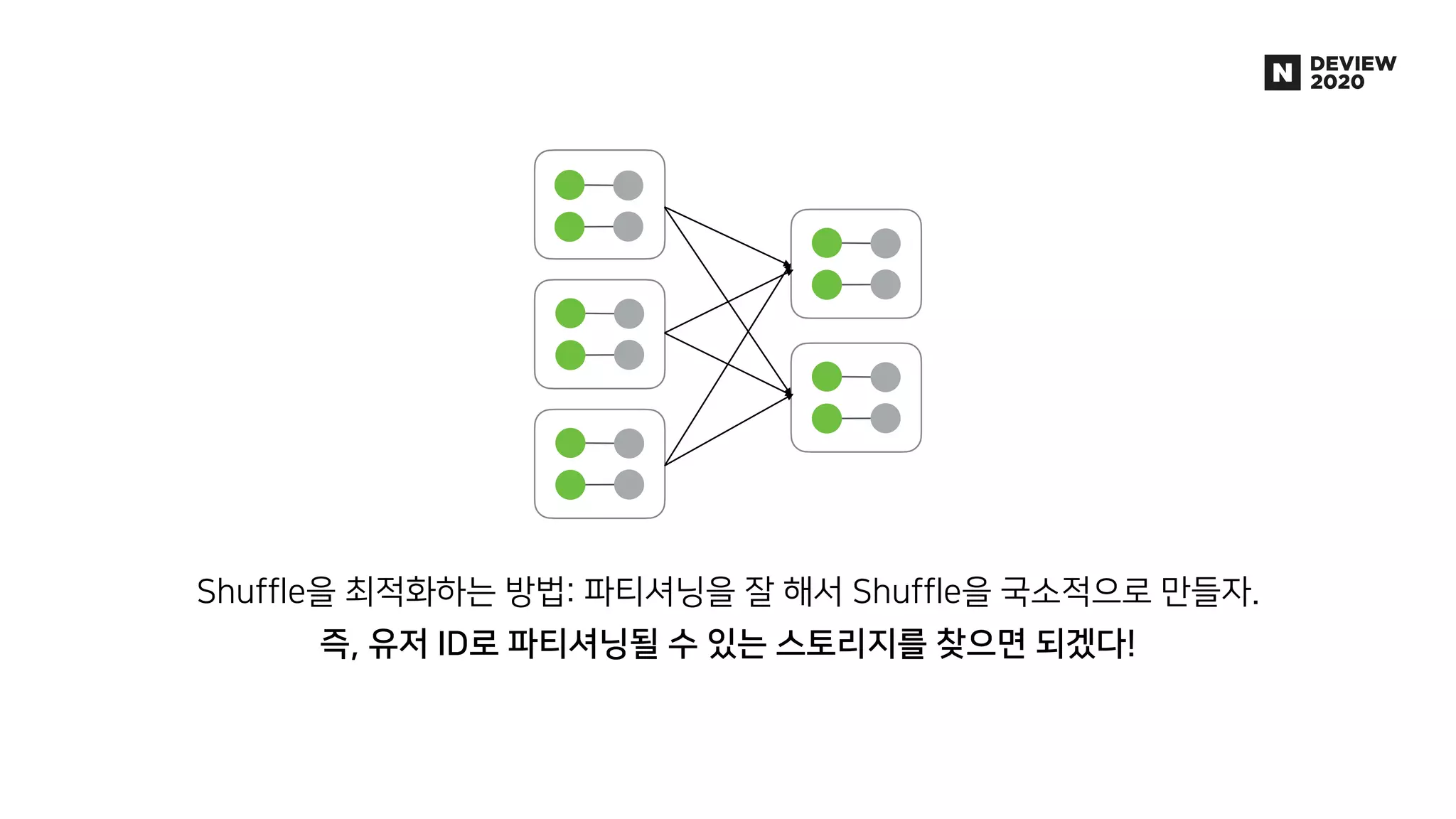

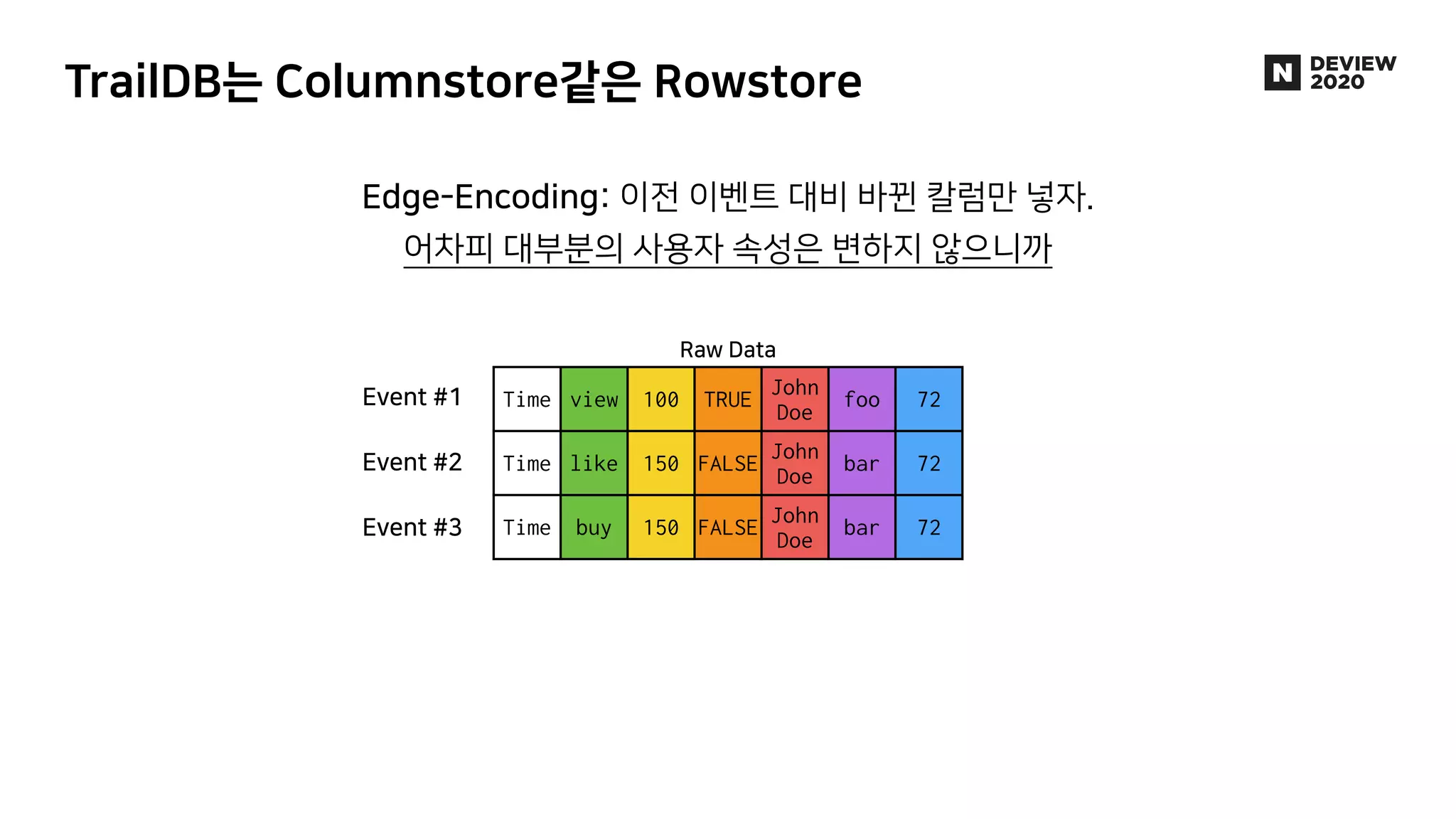

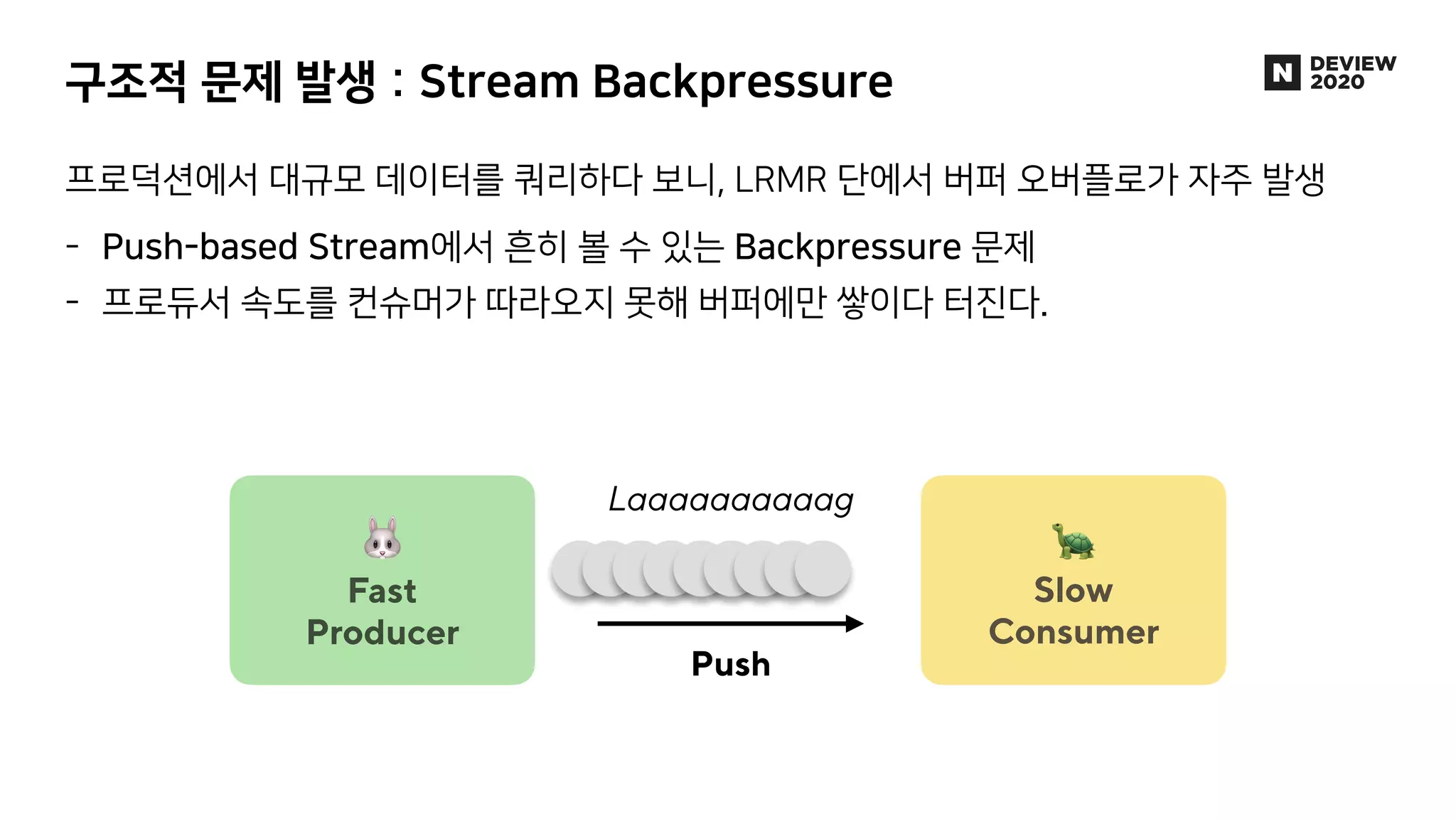

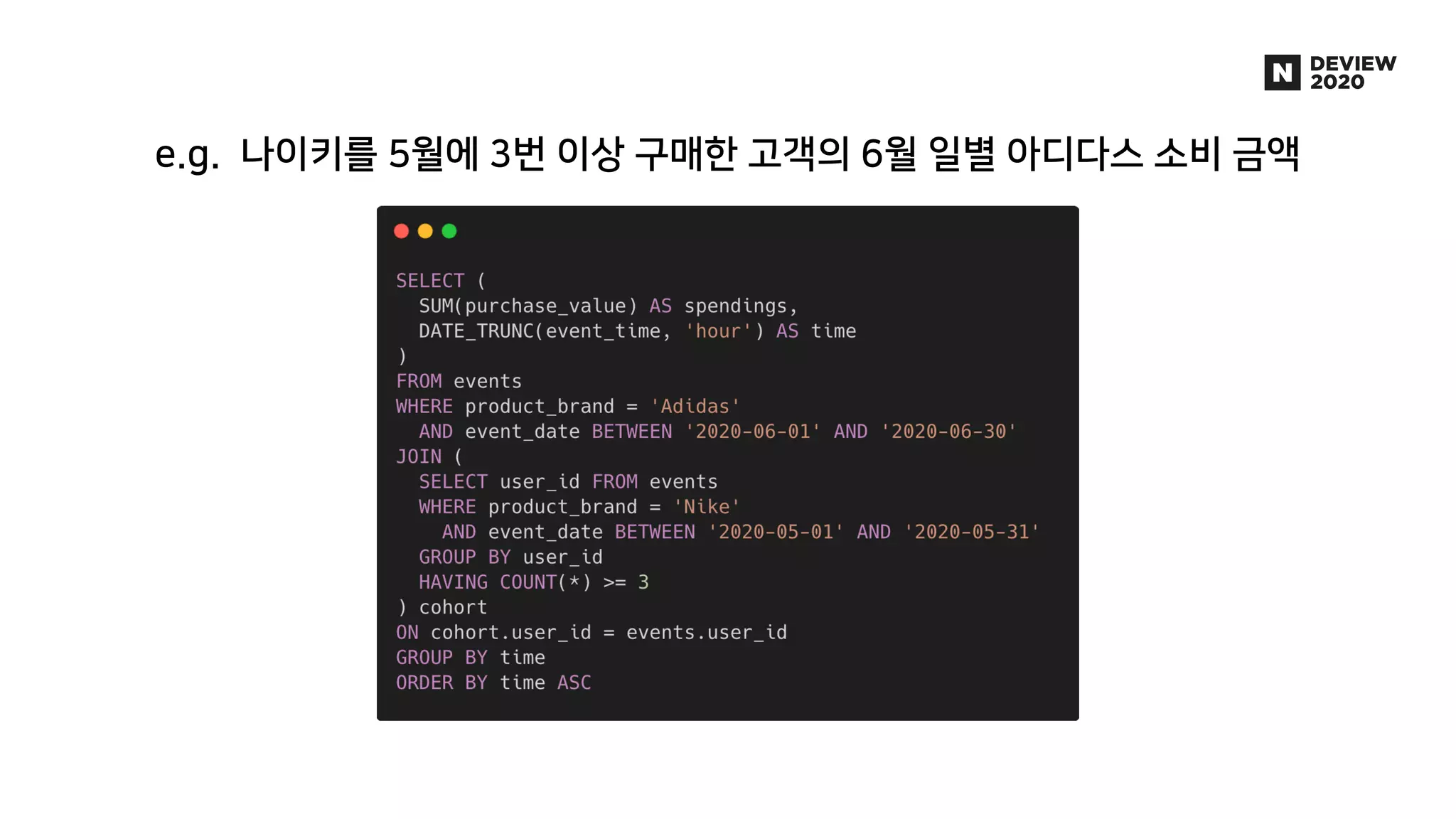

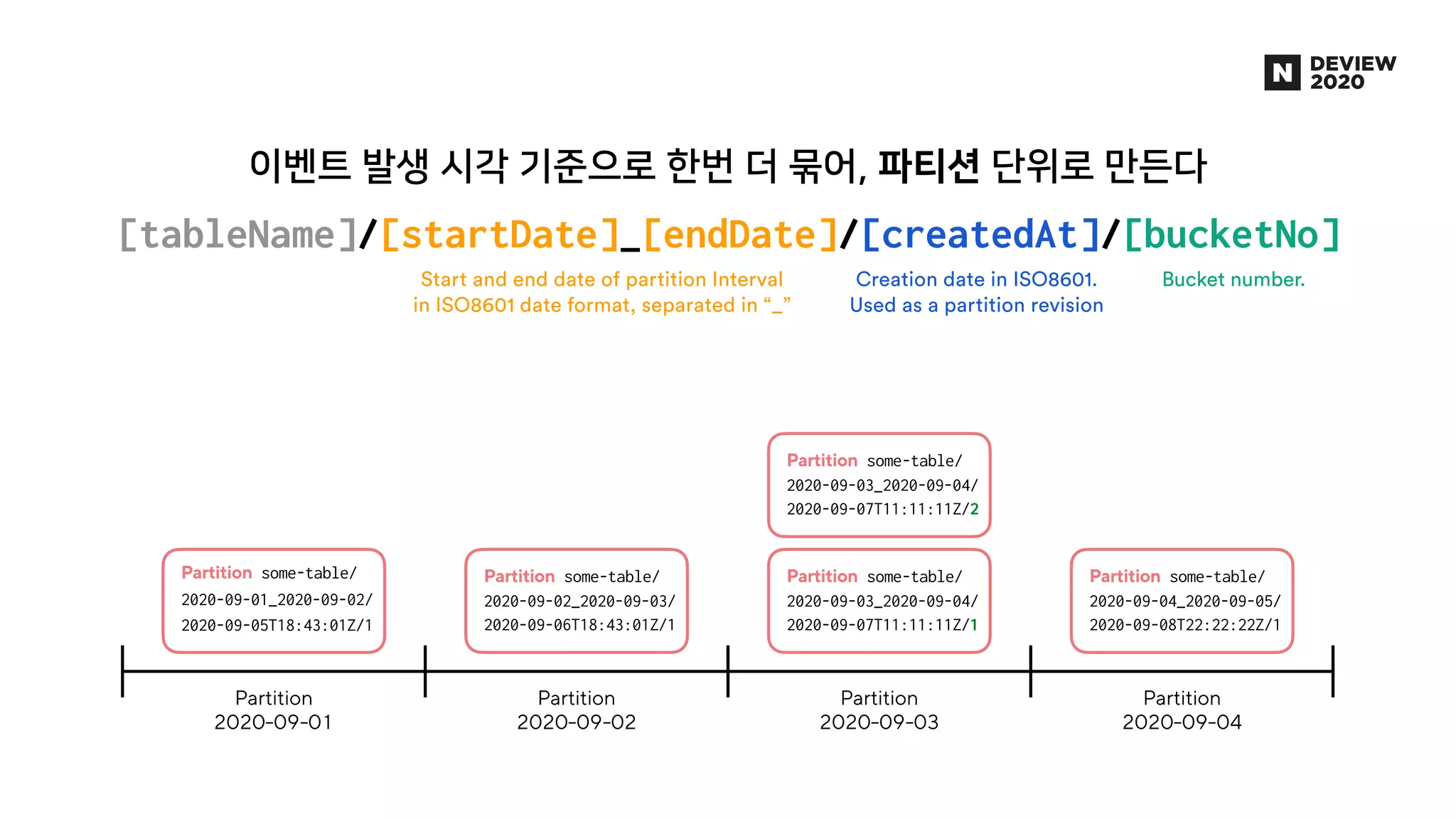

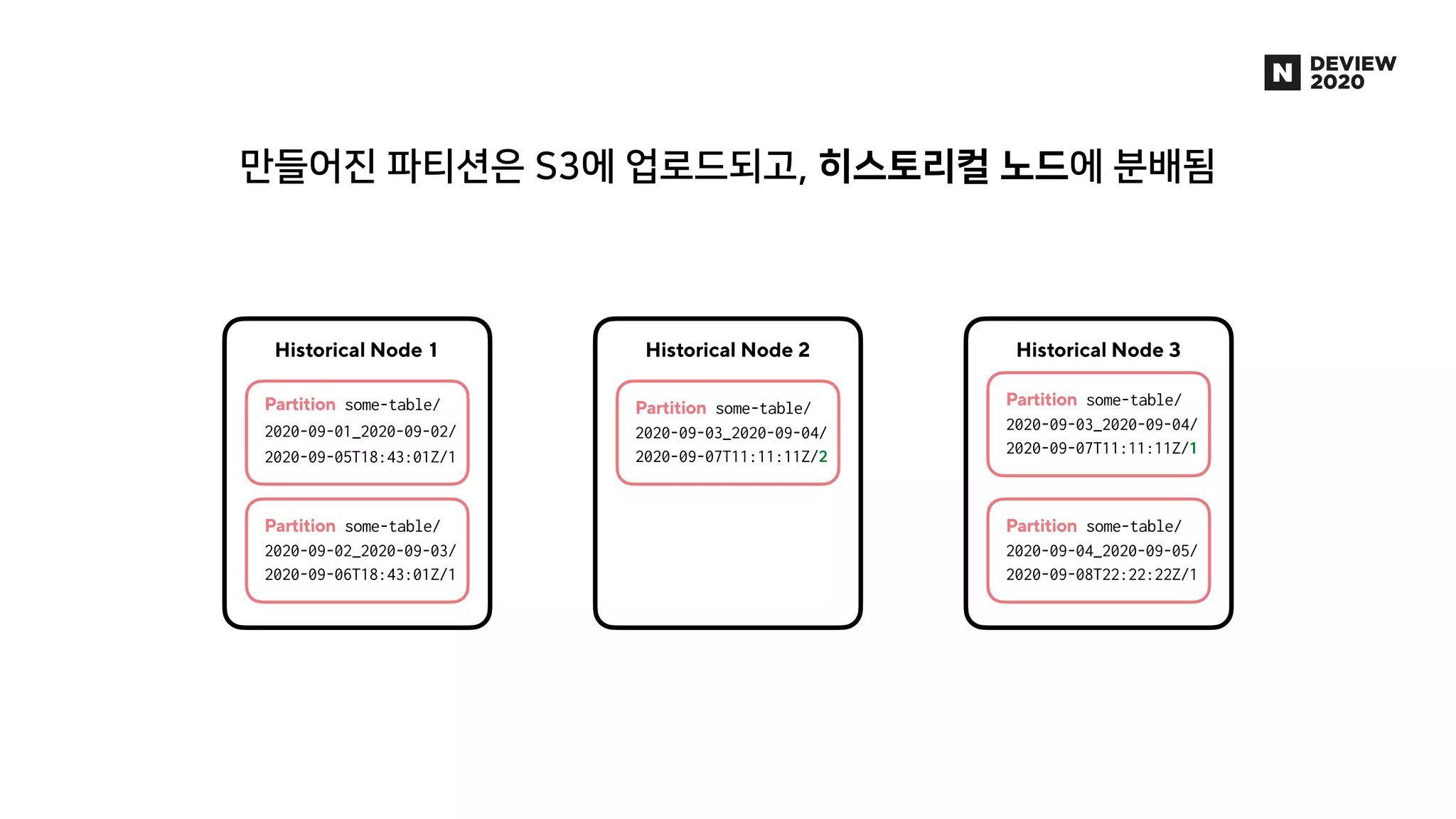

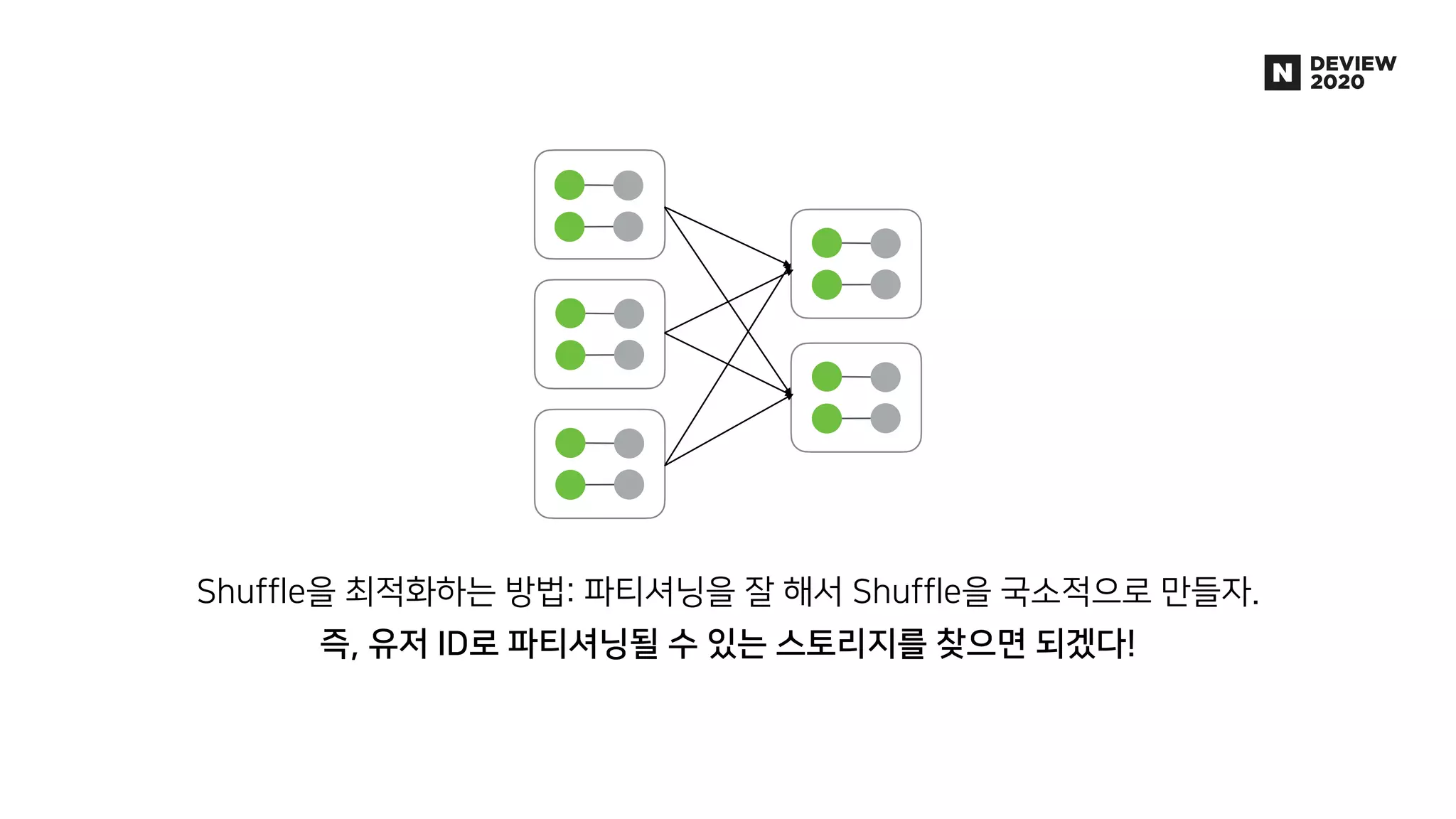

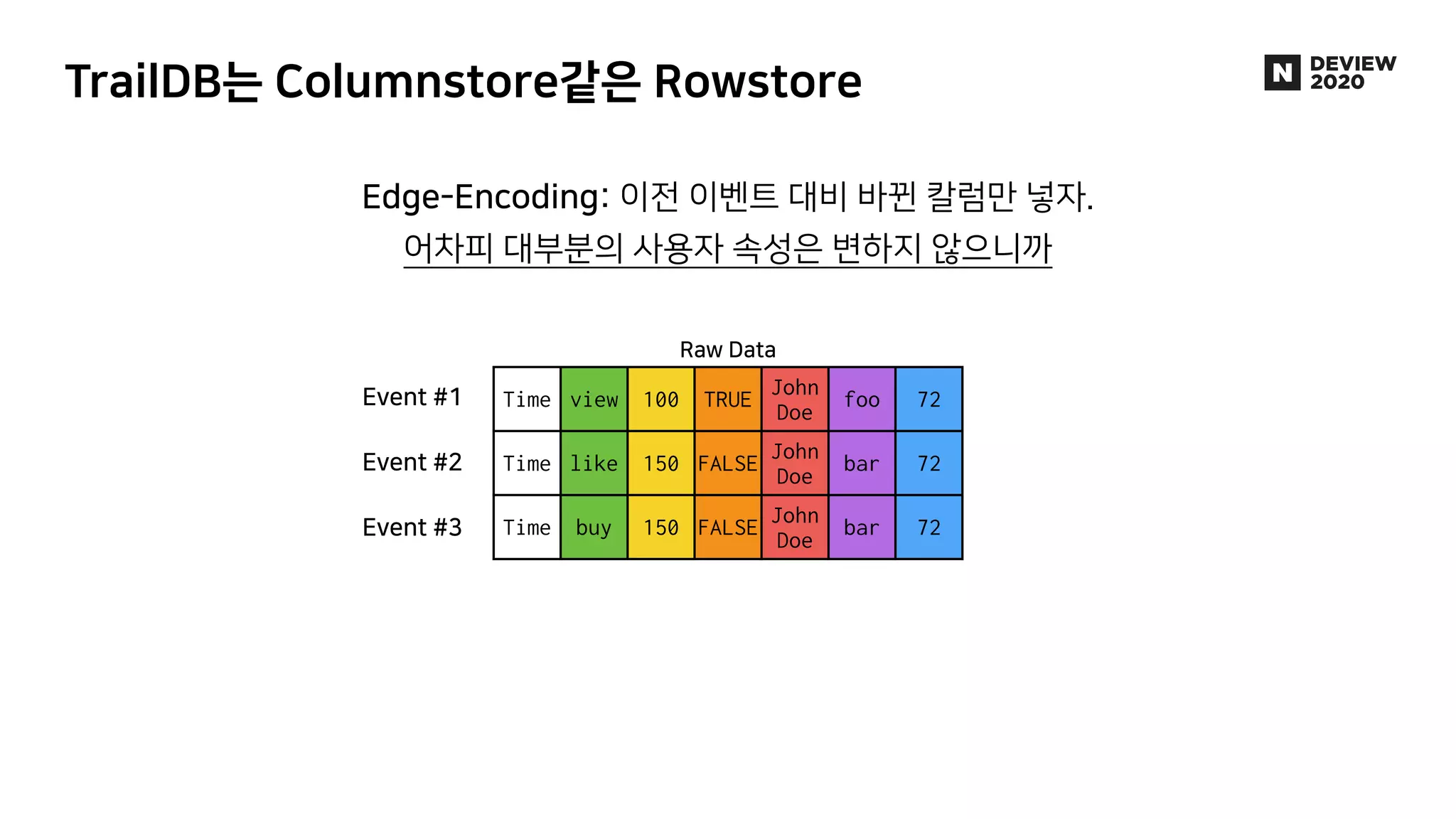

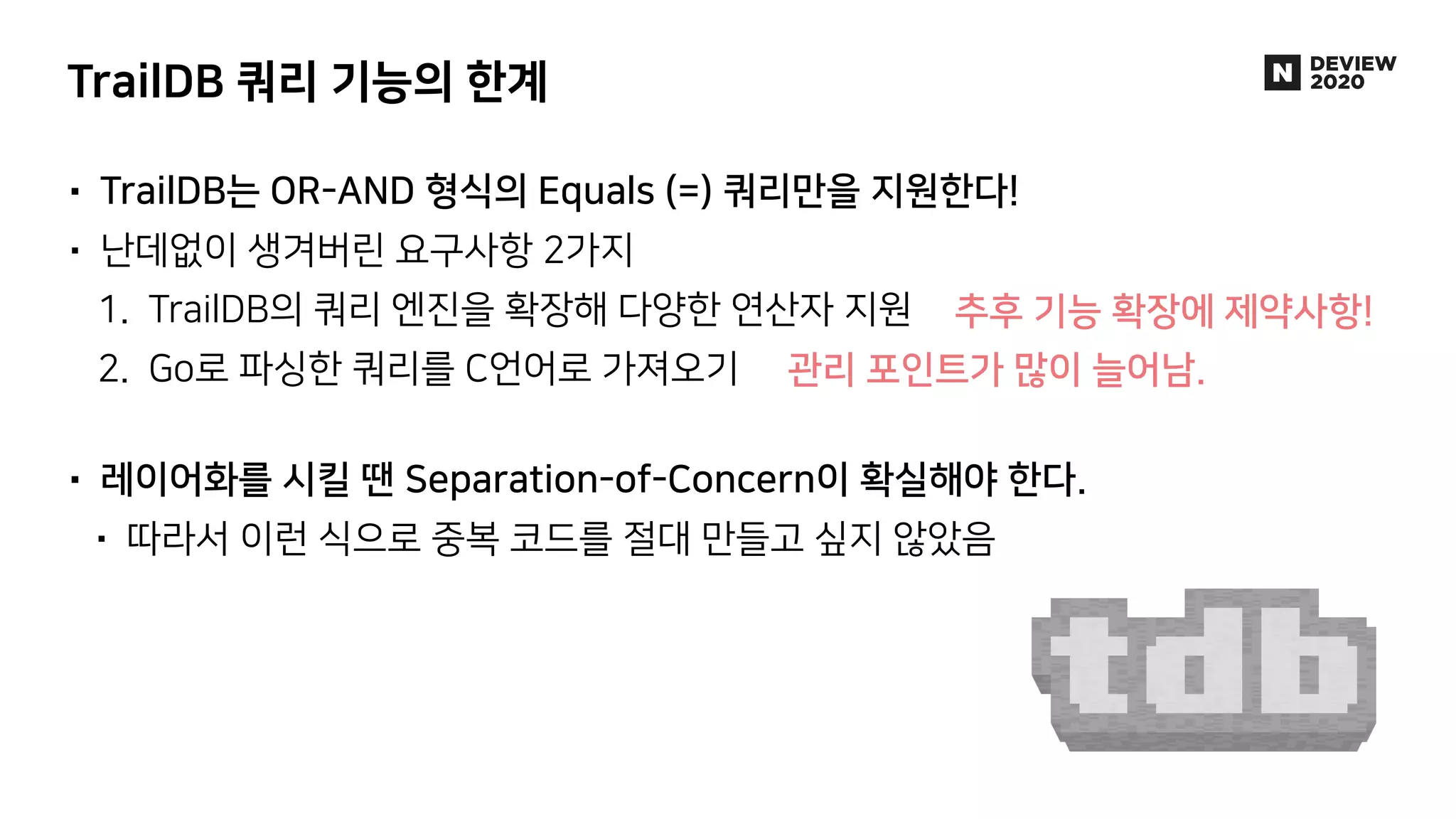

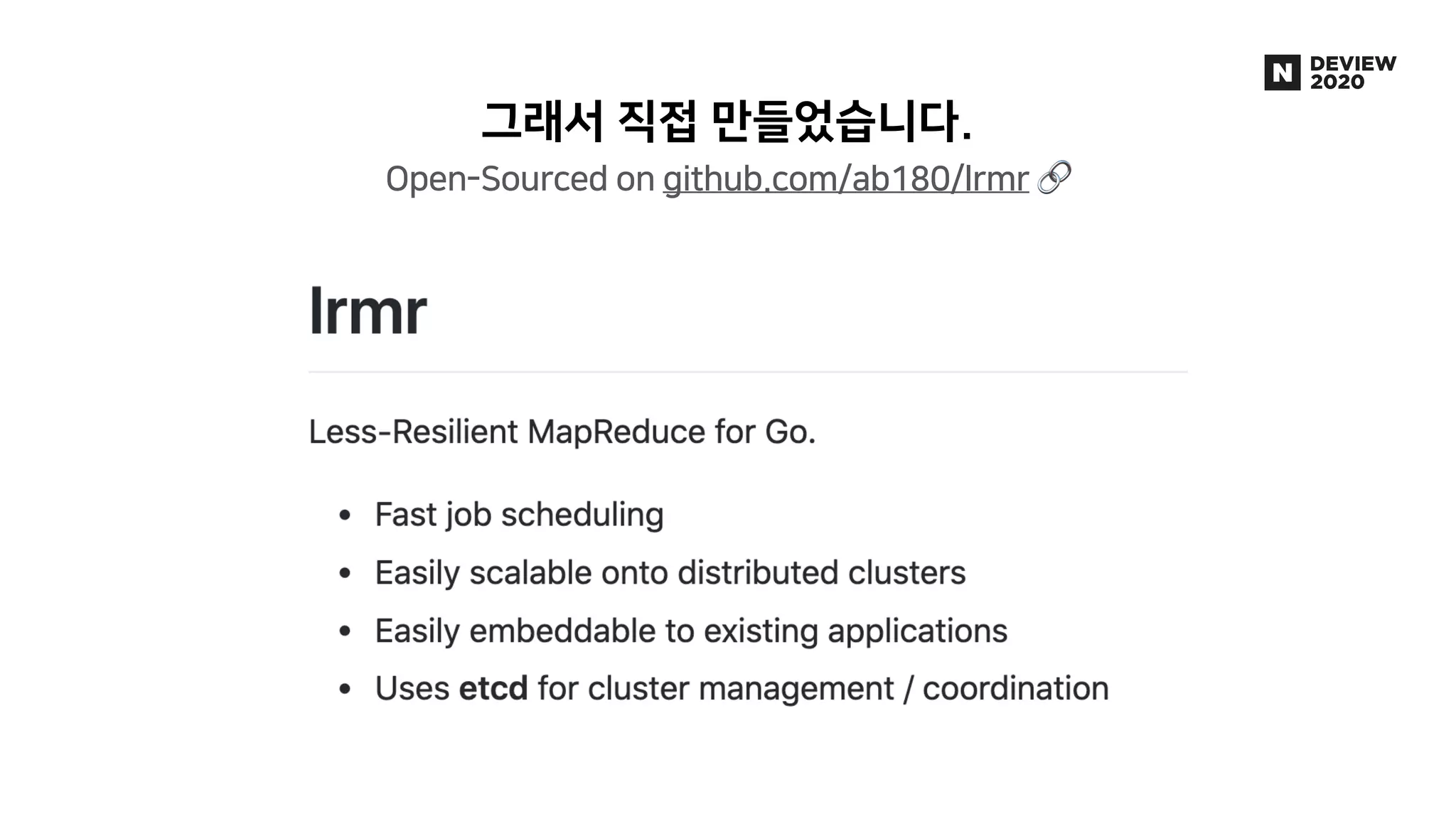

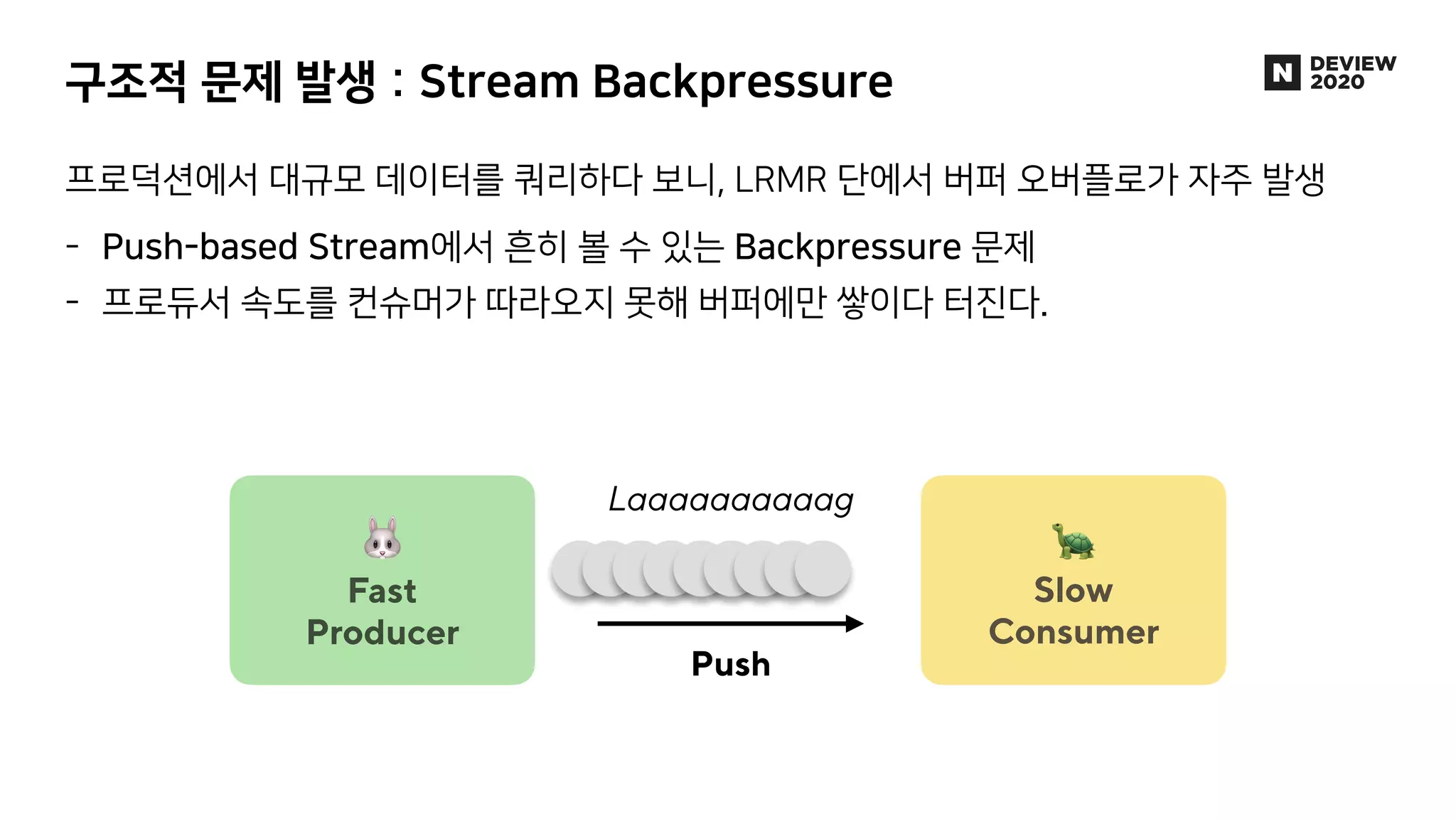

에어브릿지는 웹, 앱을 넘나드는 사용자의 유입과 행동을 파악하여 광고 성과를 측정, 분석하는 제품입니다. 월 2000만 유저로부터 들어오는 100억 건 이상의 데이터 속에서 유저 행동을 실시간으로 분석한 애널리틱스를 제공하기 위해, AB180에서는 Luft라는 행동 분석에 특화된 OLAP DB를 자체적으로 개발해 코호트 분석 기능 및 각종 애널리틱스 제공에 활용하고 있습니다. * 발표 영상: https://tv.naver.com/v/16969997 * 블로그 글: https://abit.ly/luft * 채용 페이지: https://abit.ly/recruit-database-engineer