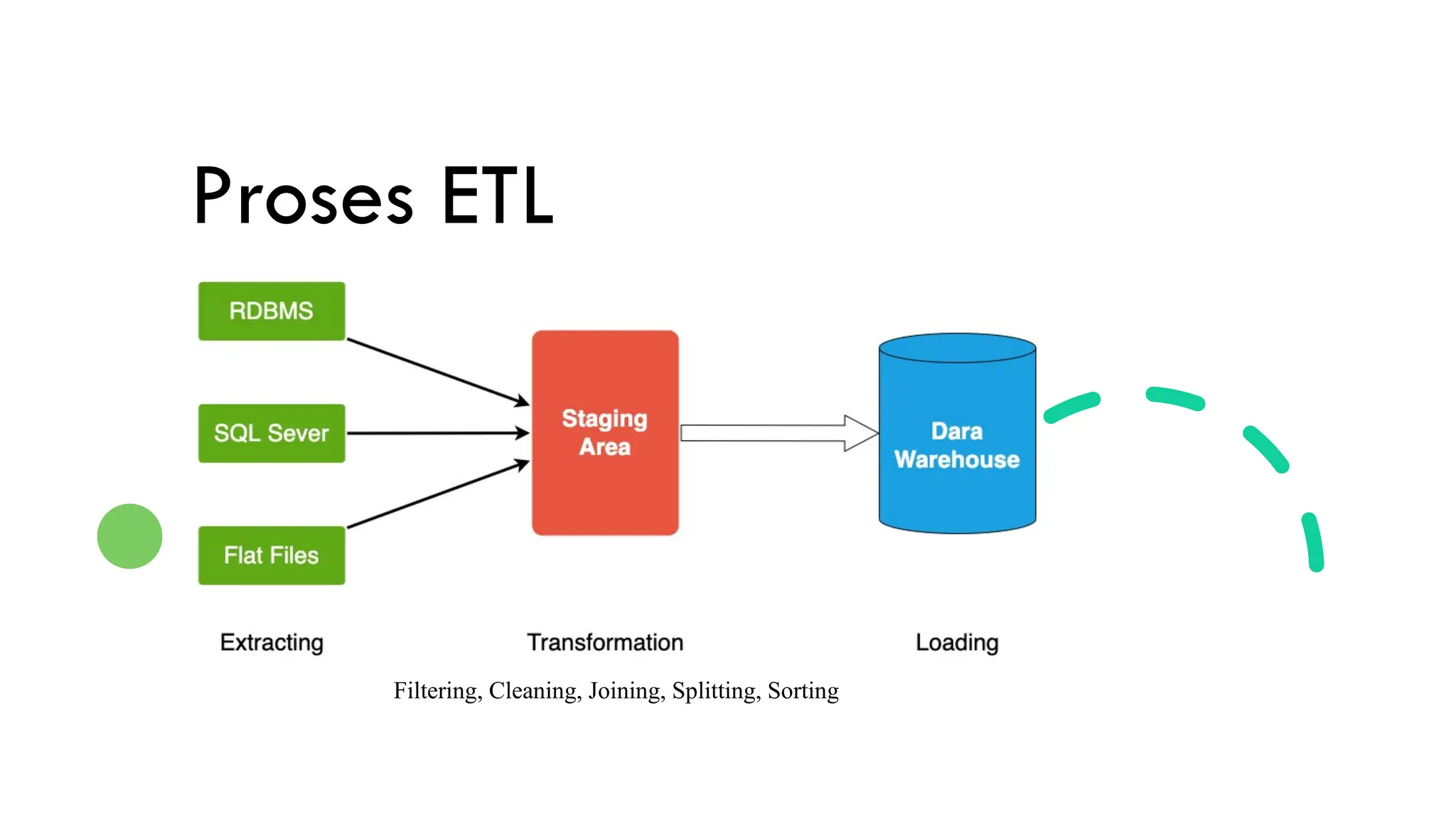

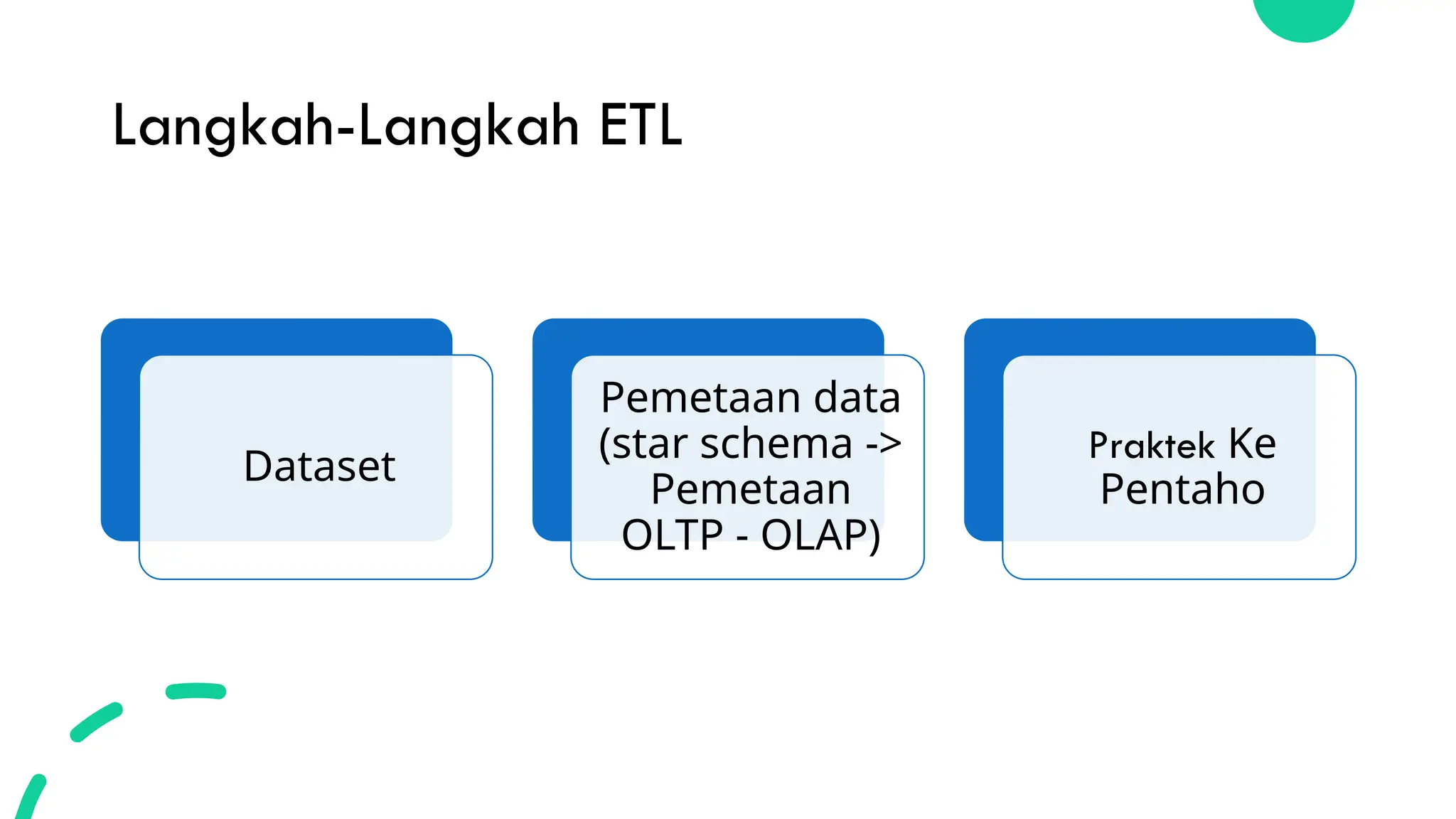

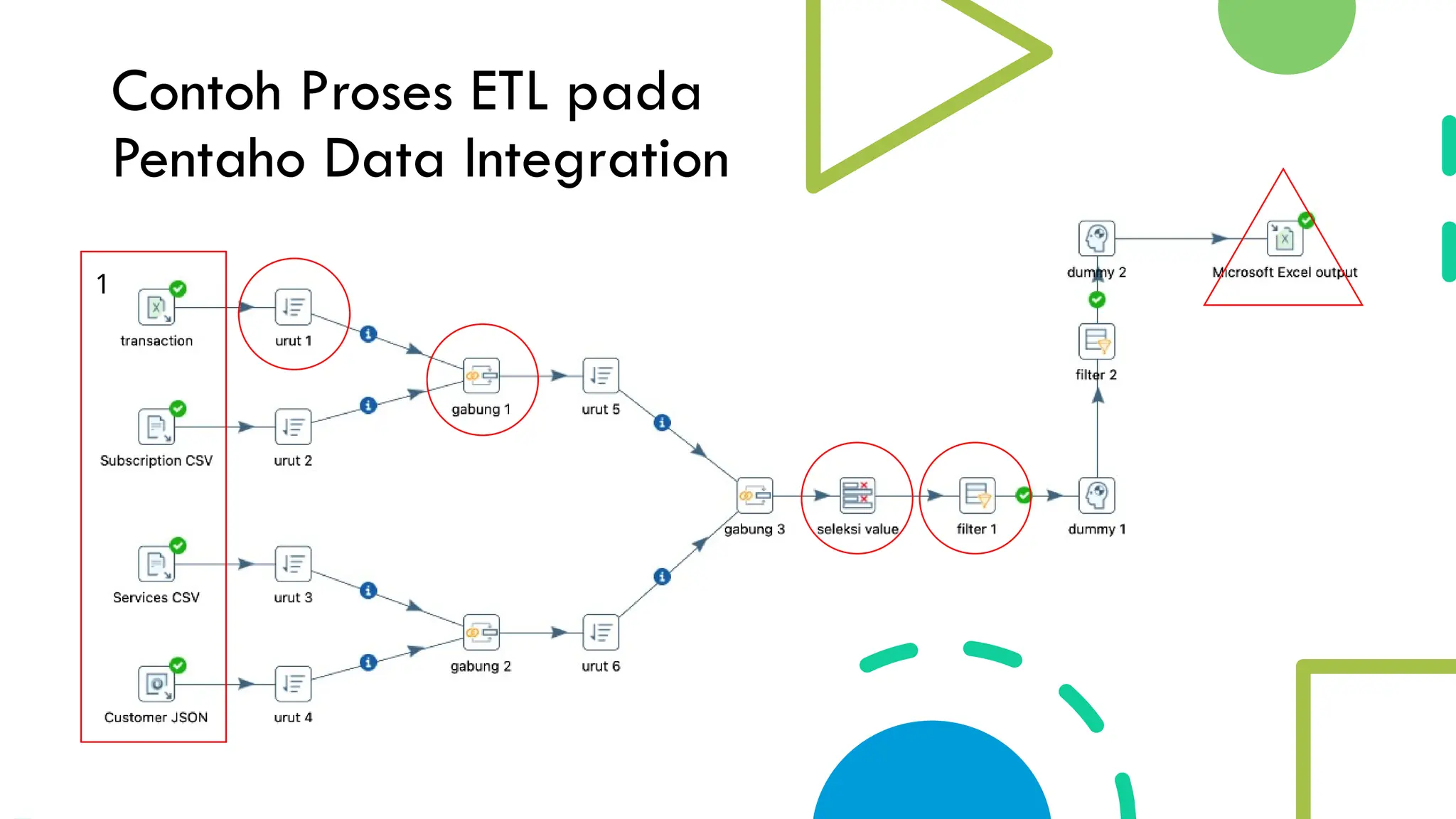

Dokumen ini membahas perbedaan antara ETL (Extract, Transform, Load) dan ELT (Extract, Load, Transform) dalam pengolahan data, terutama dalam konteks big data. ETL penting untuk mengumpulkan dan mengolah data secara efisien, sementara ELT membalikkan urutan operasi tersebut. Contoh praktik ETL menggunakan Pentaho Data Integration juga disertakan.