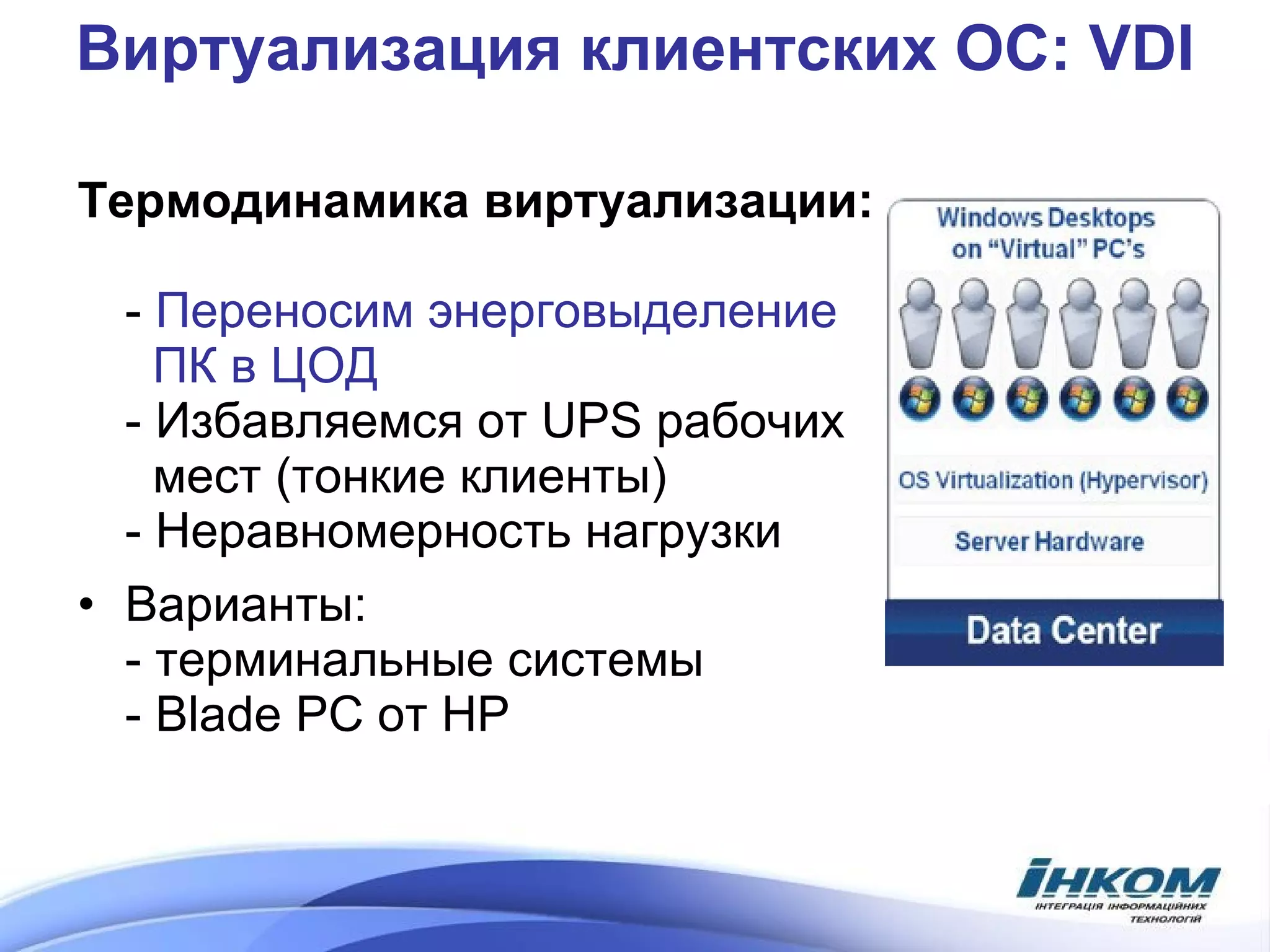

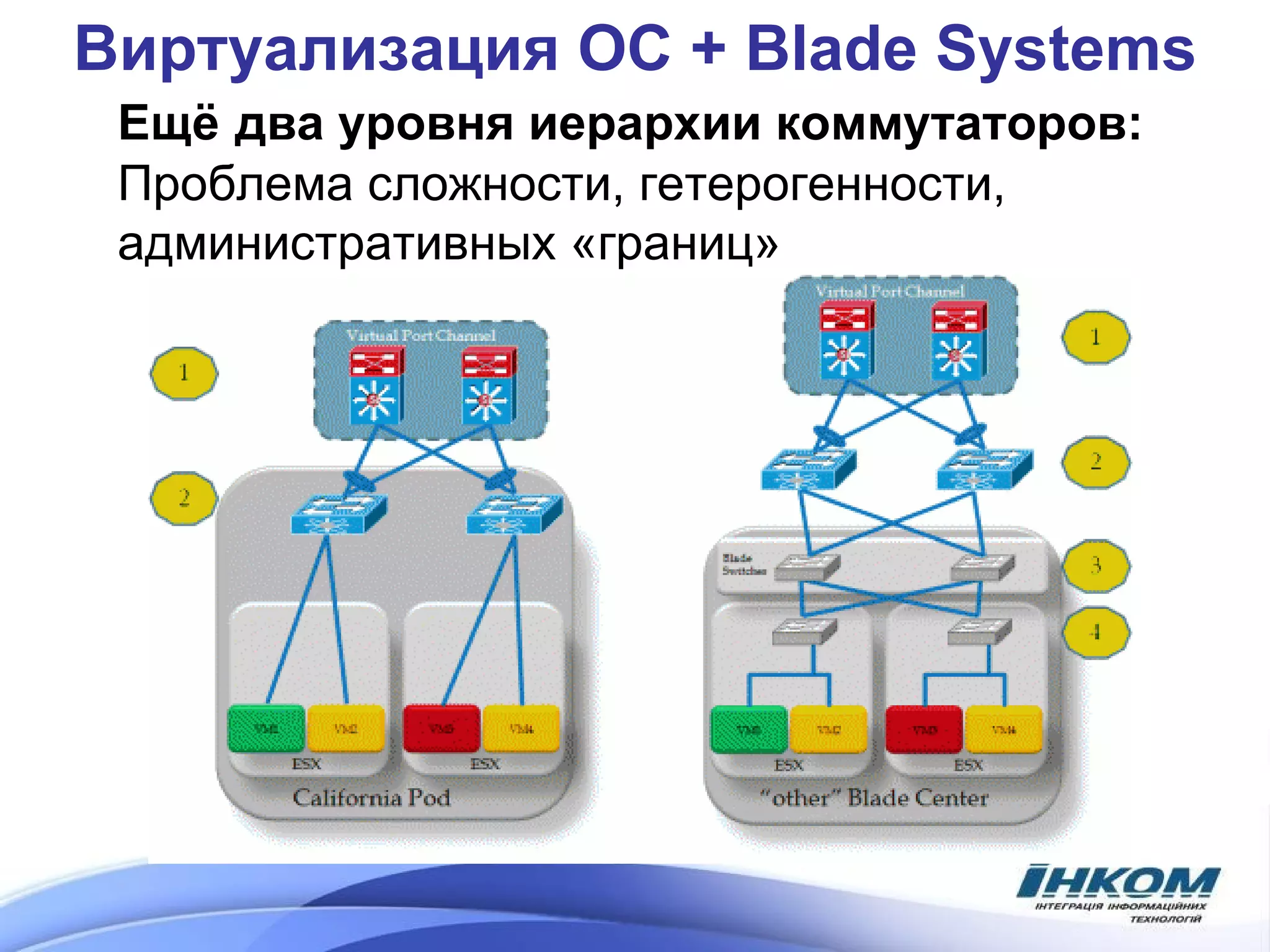

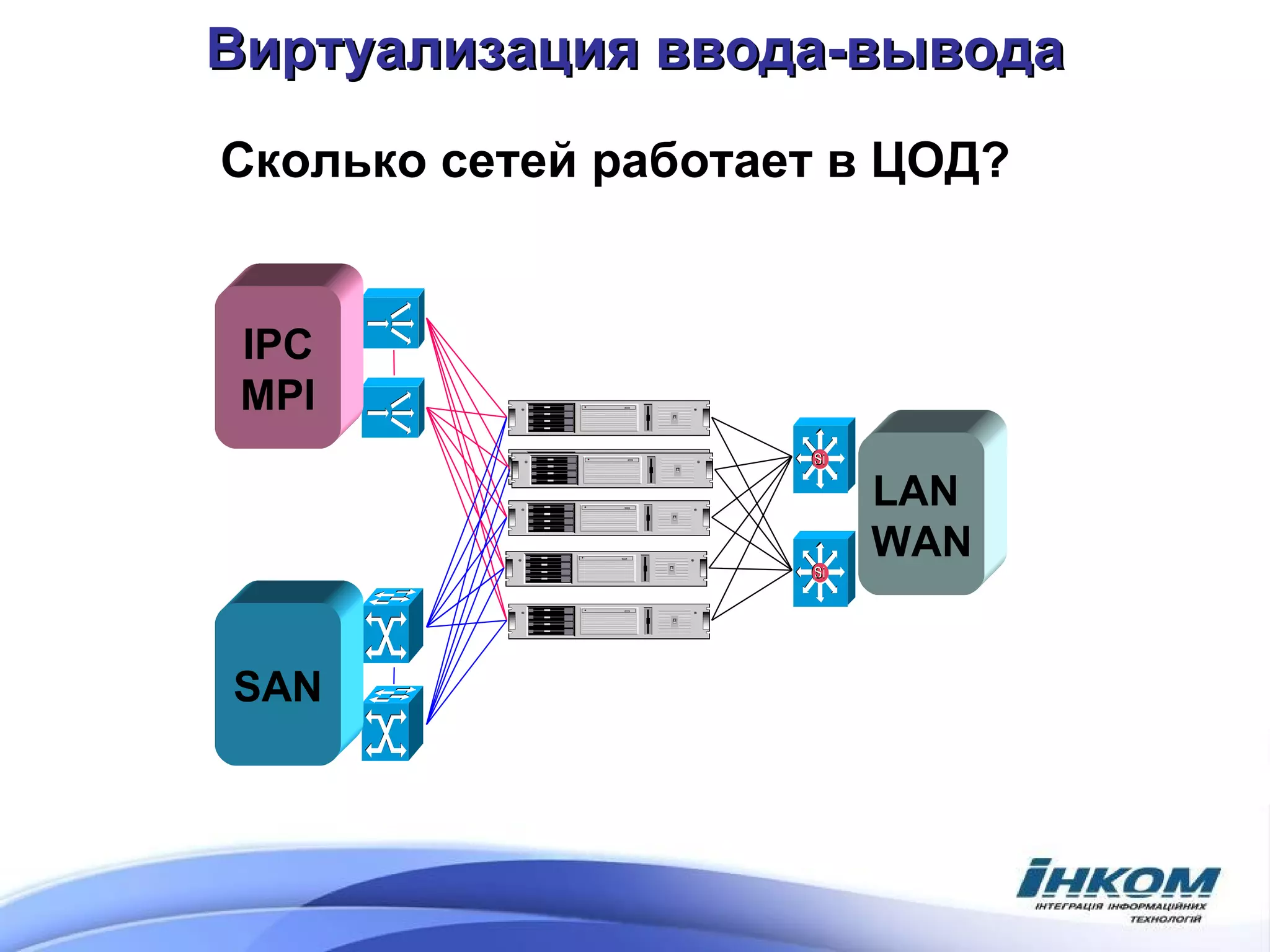

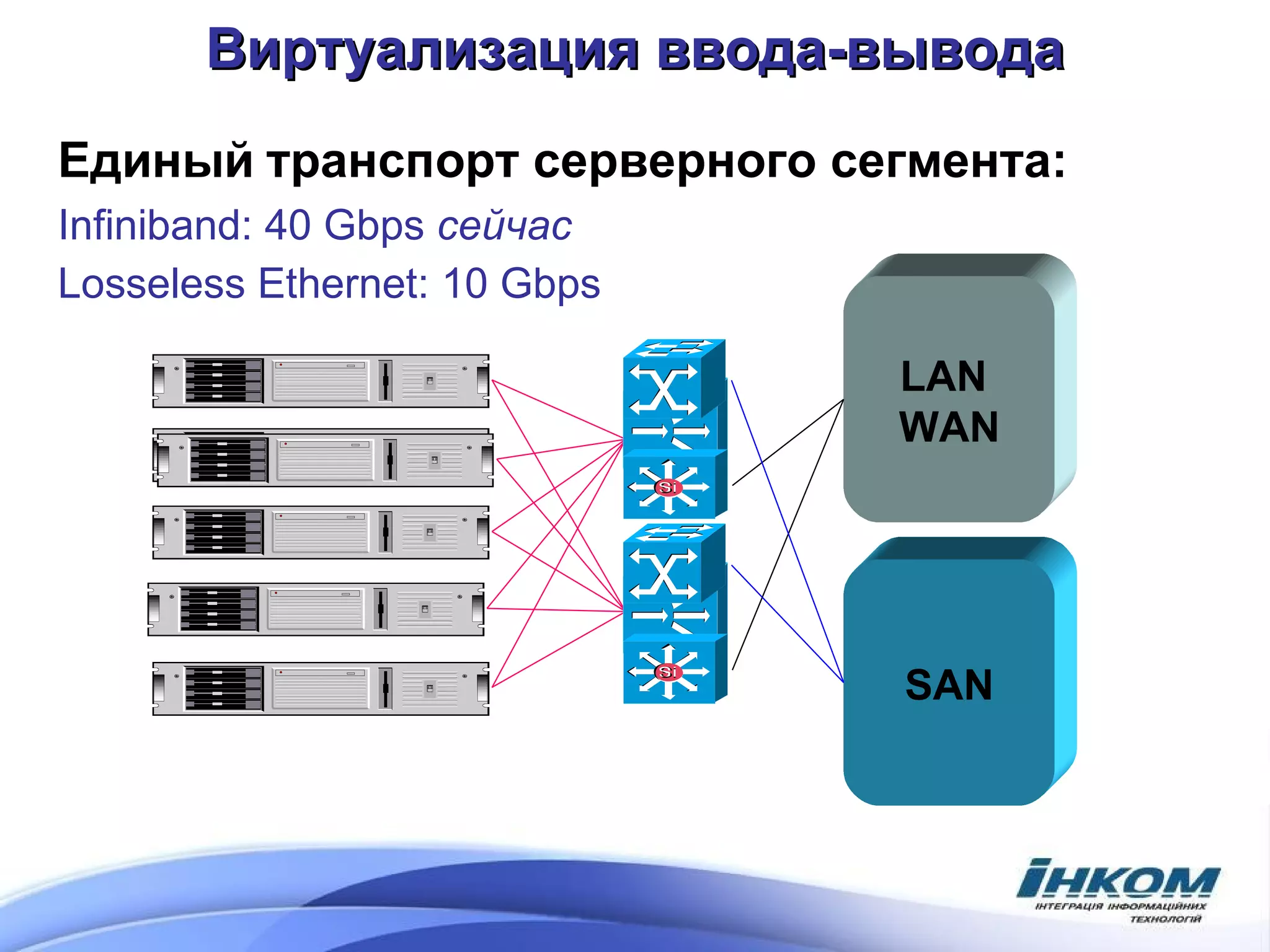

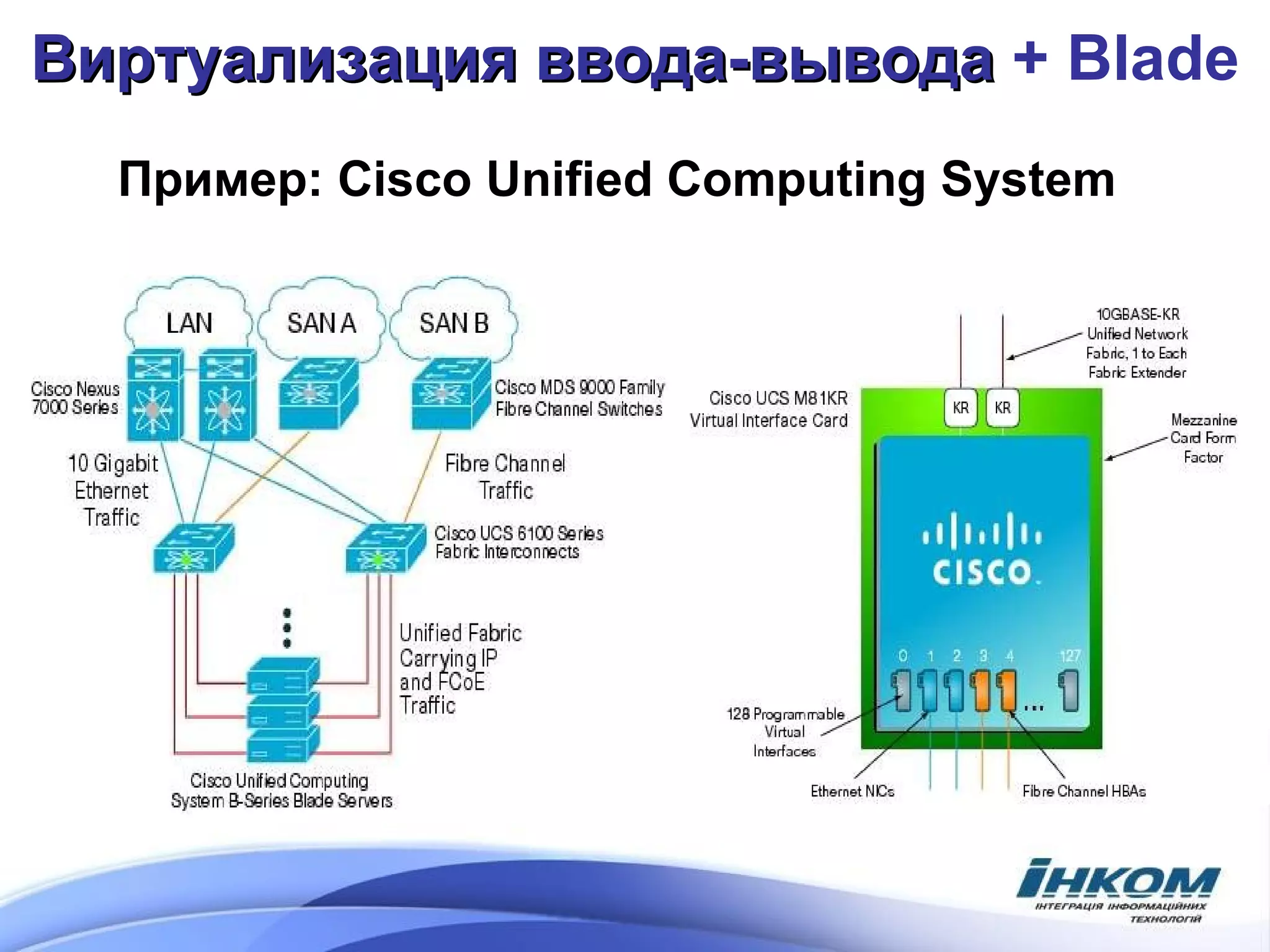

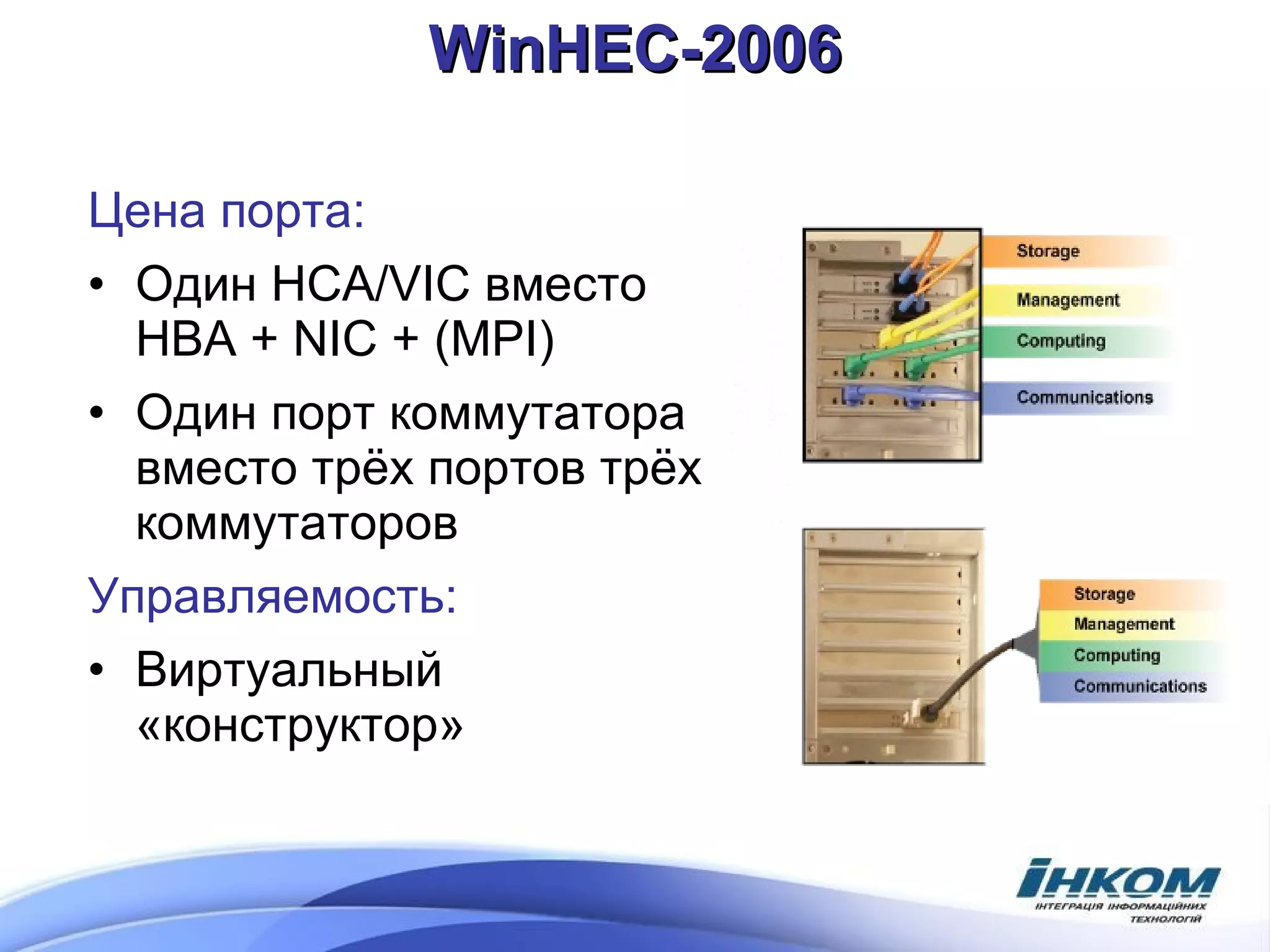

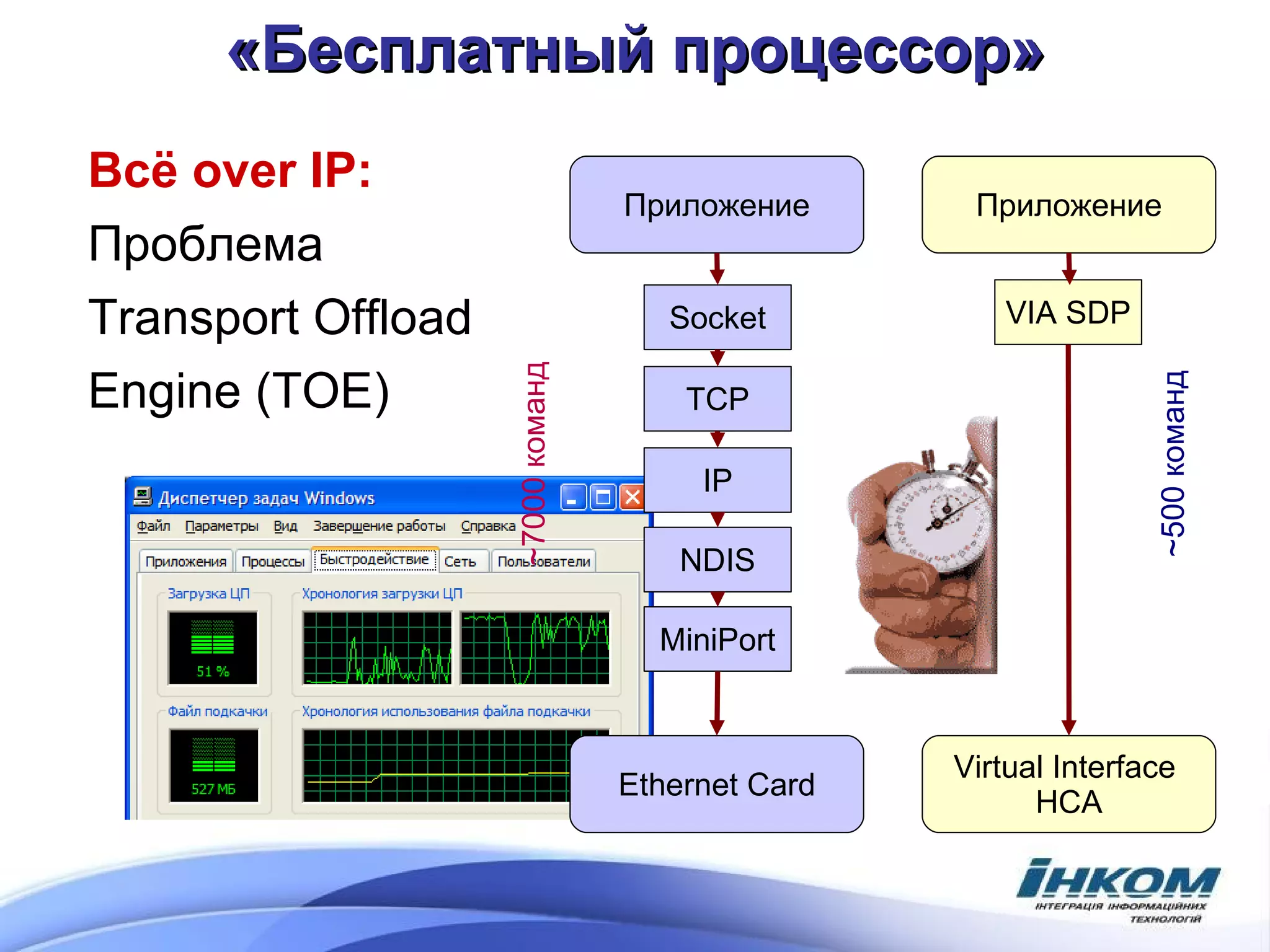

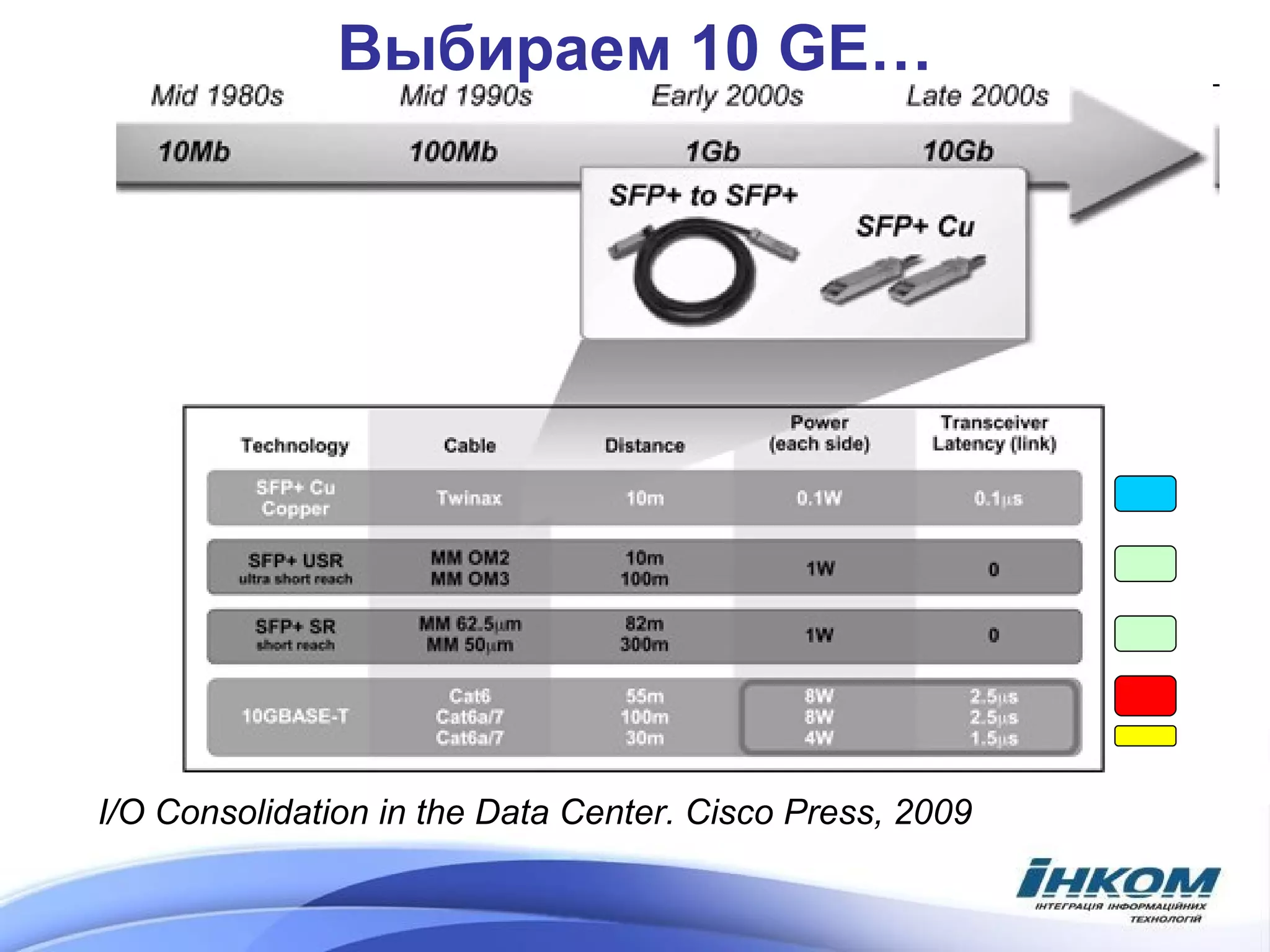

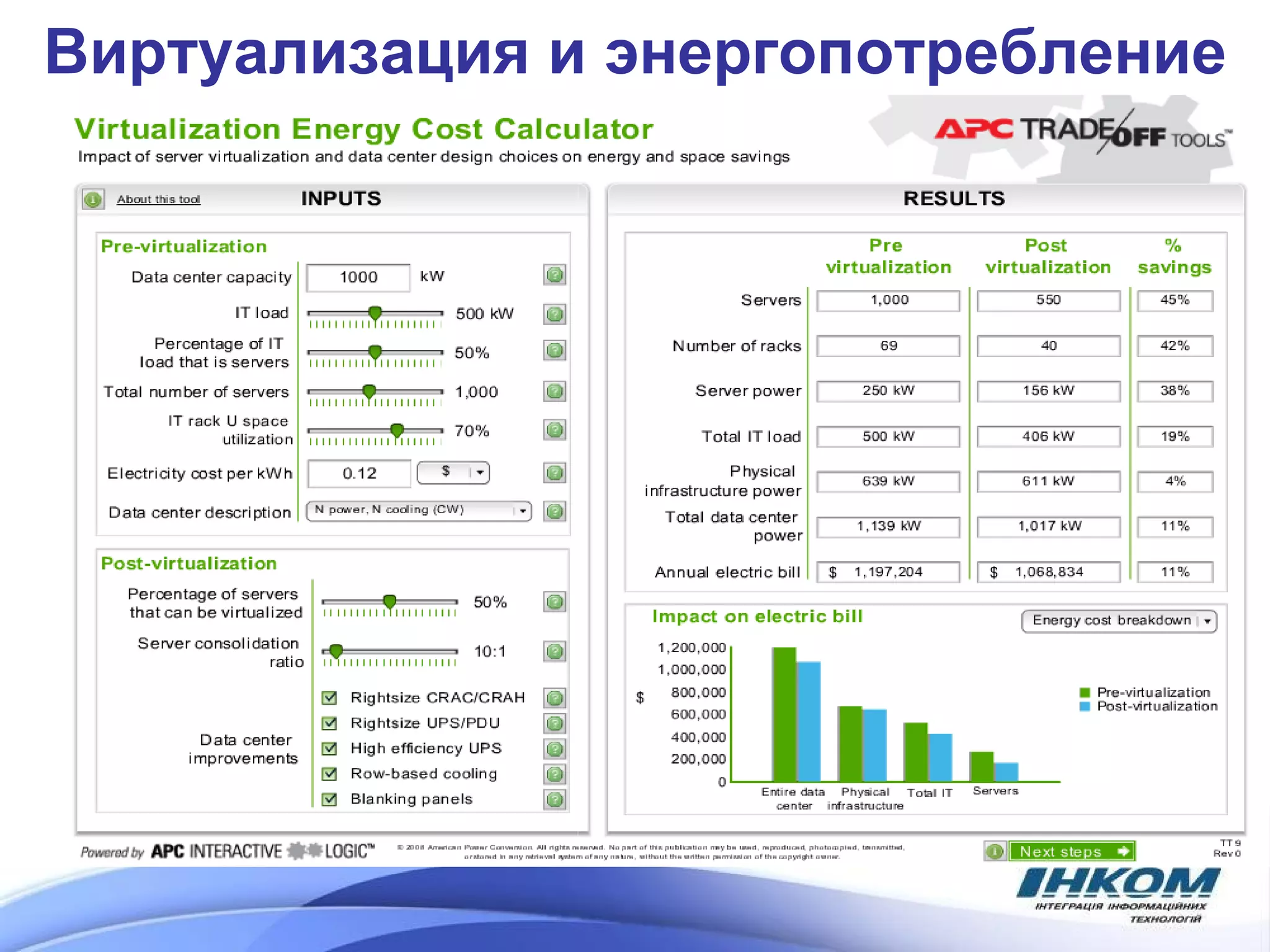

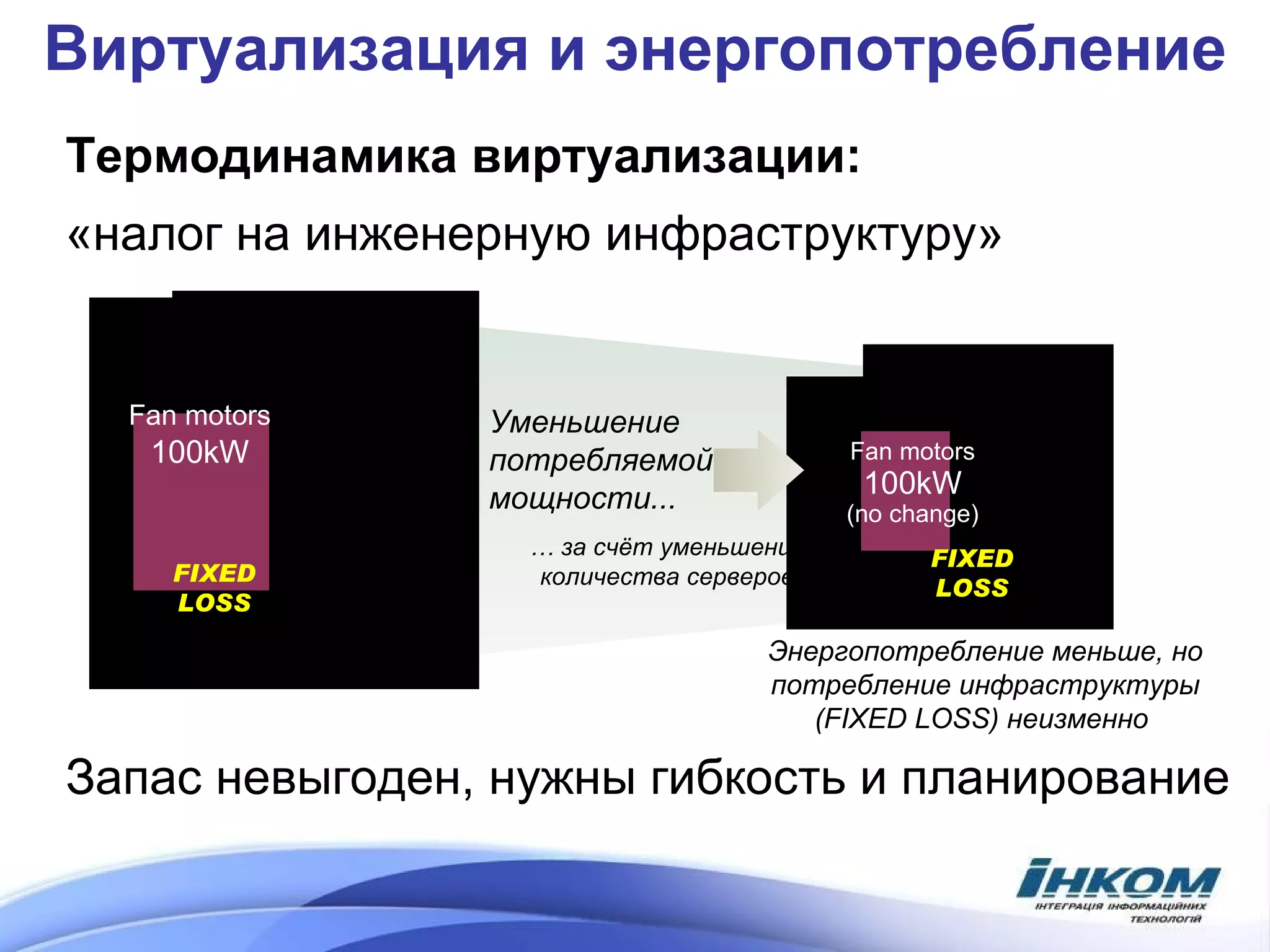

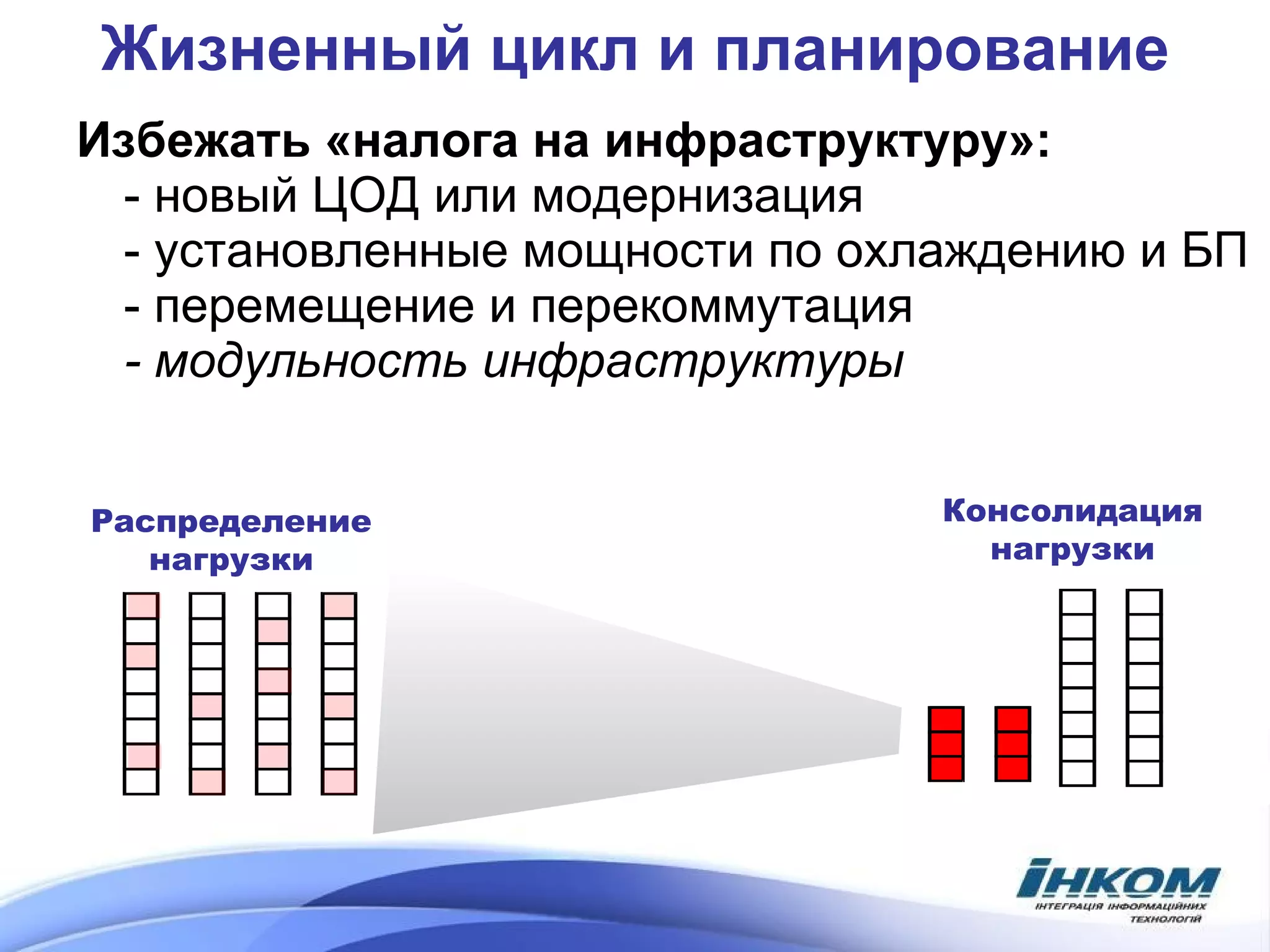

Документ обсуждает архитектуру центров обработки данных (ЦОД) с акцентом на виртуализацию операционных систем и управление энергопотреблением. Рассматриваются проблемы параллелизма, термодинамика виртуализации и влияние на ввод-вывод, а также предлагают решения для повышения плотности систем и эффективности управления. В документе также представлены примеры реализации систем высокой плотности и их инфраструктуры.