دوره مقدماتی یادگیری ژرف

مقدمات یادگیری ماشین و یادگیری نظارت شده

آشنایی با نوع داده تصویر در پایتون

پیده سازی طبقه بندی ساده در پایتون

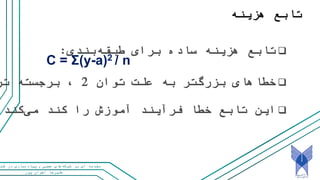

در این جلسه با مفاهیم پایه شبکه های عصبی و یادگیری عمیق آشنا شدیم. نوع خاصی از داده که داده تصویری است معرفی شد. و سپس به معرفی و بررسی انواع توابع فعال سازی ( activation function) معرفی مدل های پرسپترون چندلایه (MLP یا multi-layer Perceptron) انواع توابع هزینه در شبکه های عصبی (Cost Functions یا Loss Function) یادگیری و آموزش شبکه های عصبی پرداخته شد.

همچنین به بررسی tensorflow playground پرداخته و مباحثی مانند تعداد لایه و نورون و نوع activation function و تاثیر آن بر روی آموزش مورد بحث قرار گرفت. در ادامه آموزش کتابخانه Keras در پایتون و پیاده سازی یک شبکه عصبی ساده بیان شد. مشکل over-fitting و راهکار Dropout به عنوان یکی از راه حل های regularization بیان شد.

![پور اخوان علیرضا

و عصبی هایشبکه بر ای مقدمهکت در سازیپیاده

Representing class data: one-hot encoding

labels = ["shoe", "dress", "shoe", "t-shirt",

"shoe", "t-shirt", "shoe", "dress"]](https://image.slidesharecdn.com/p1-181114190723/85/slide-30-320.jpg)