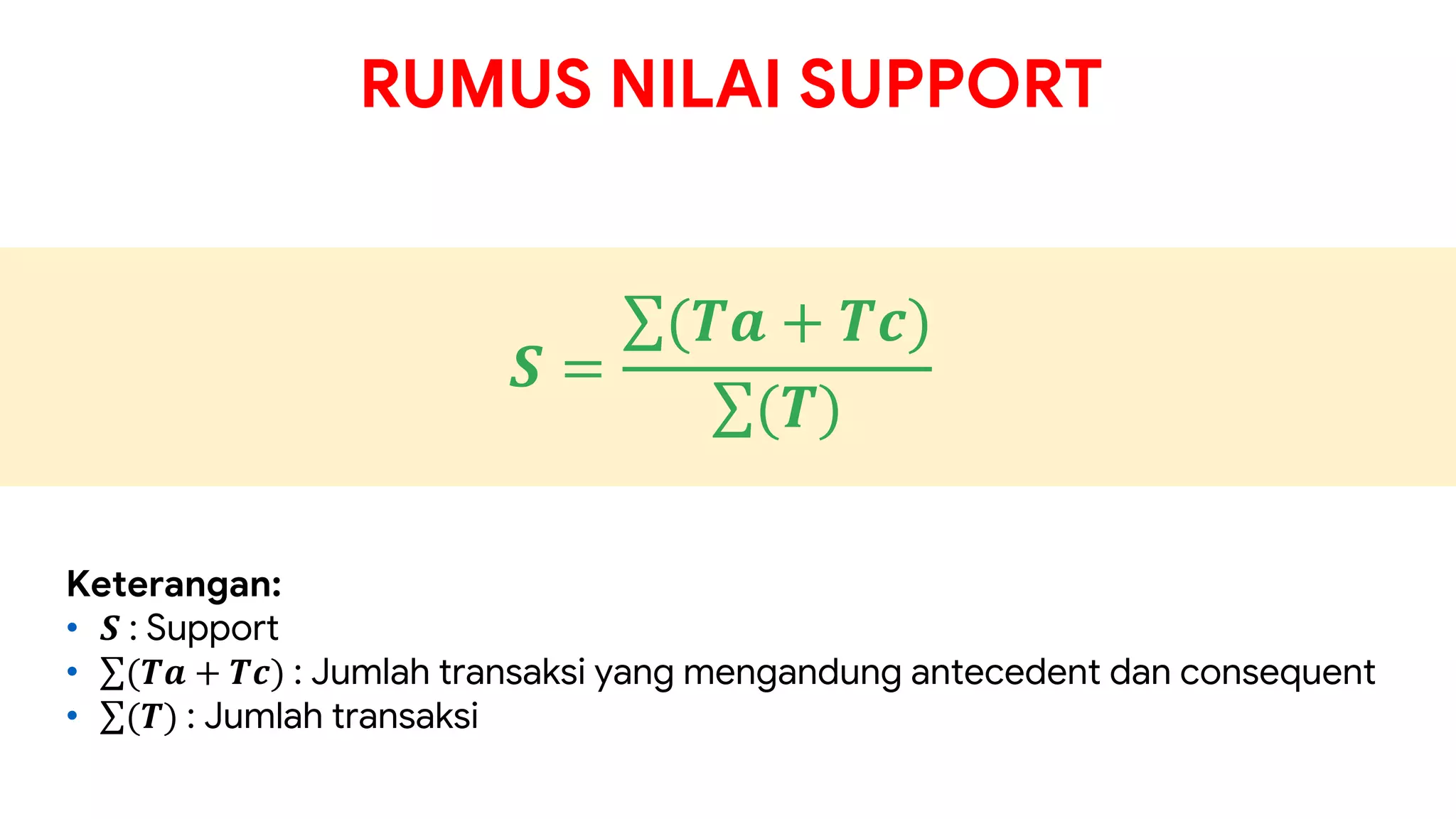

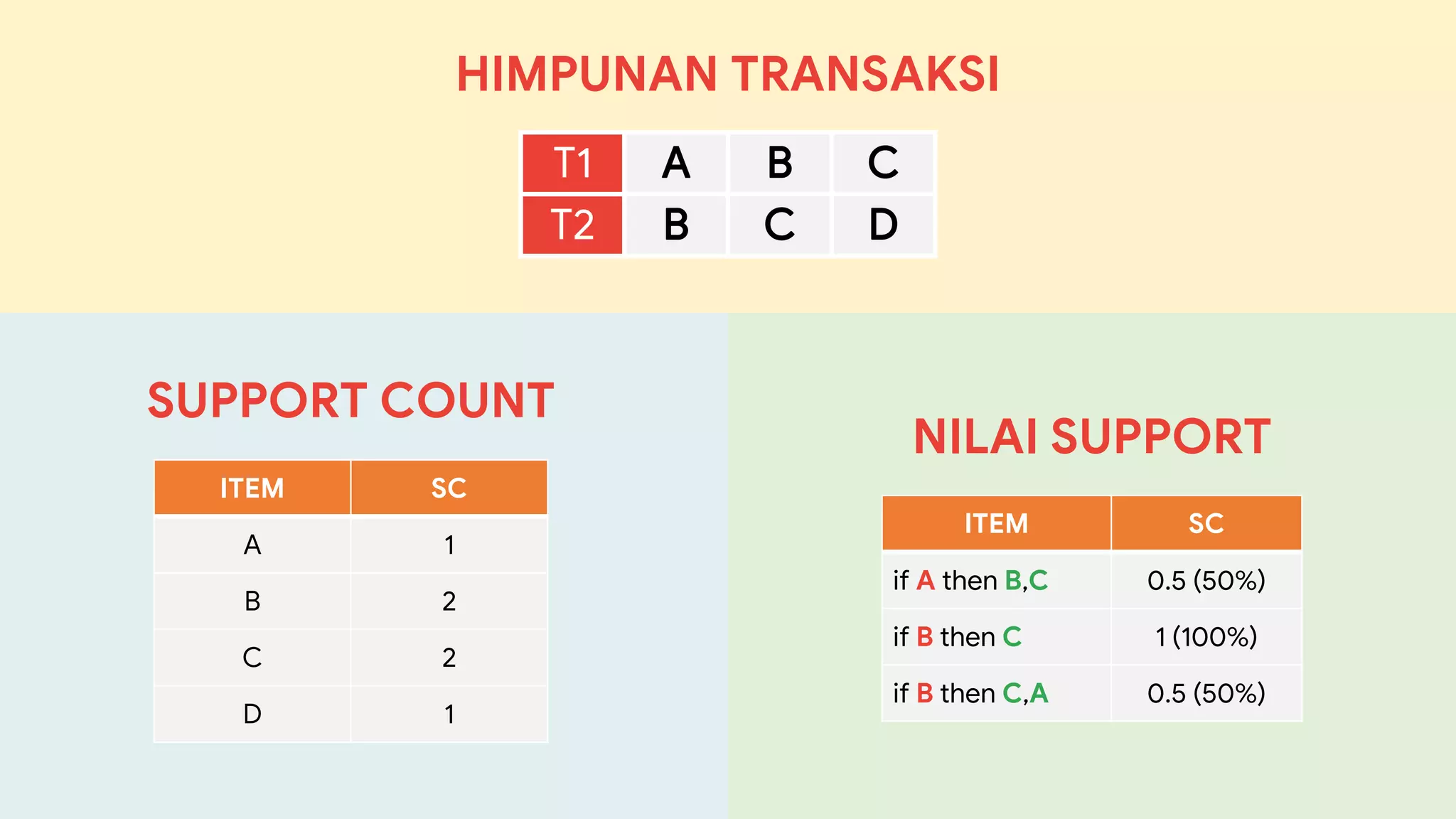

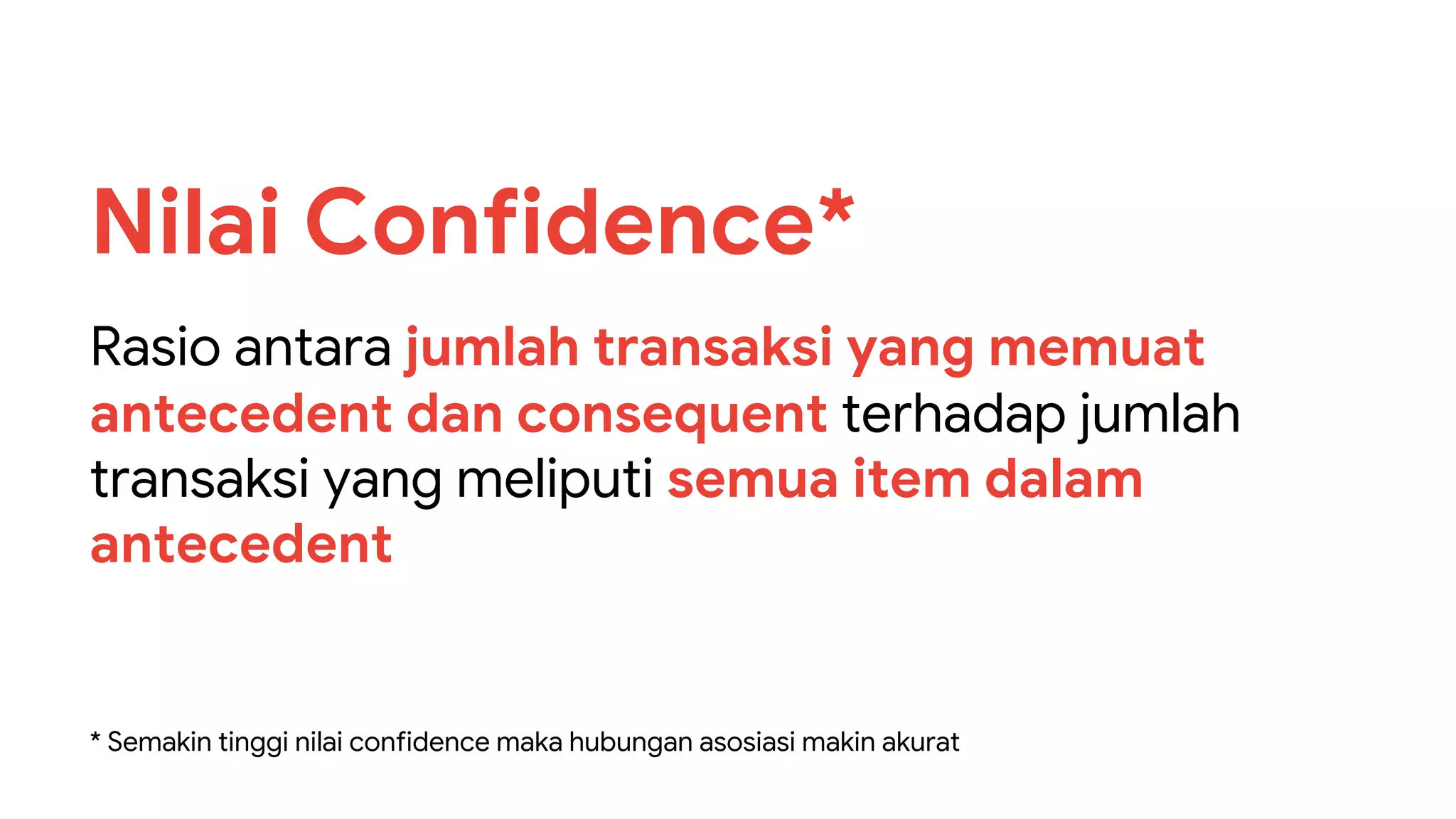

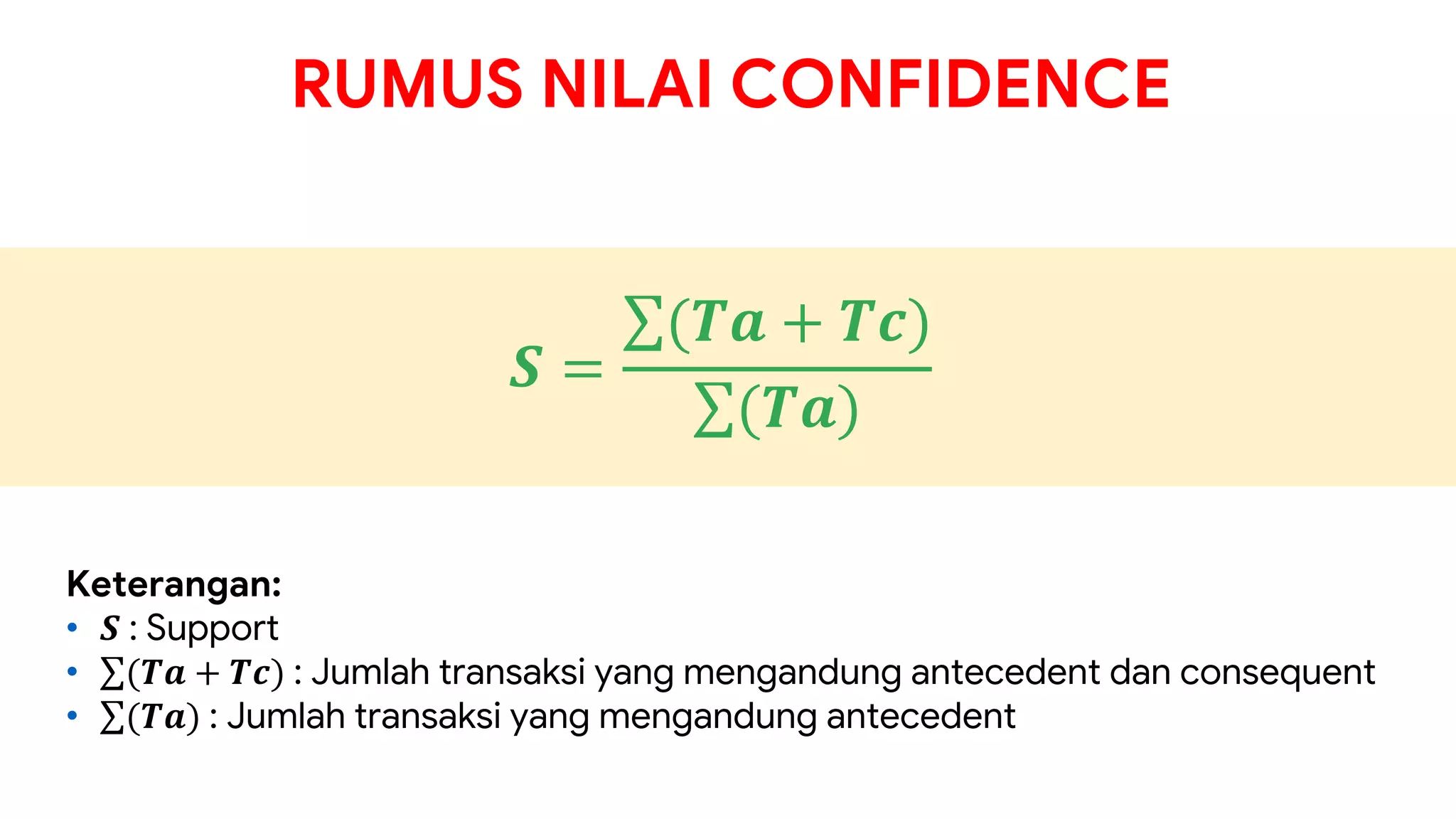

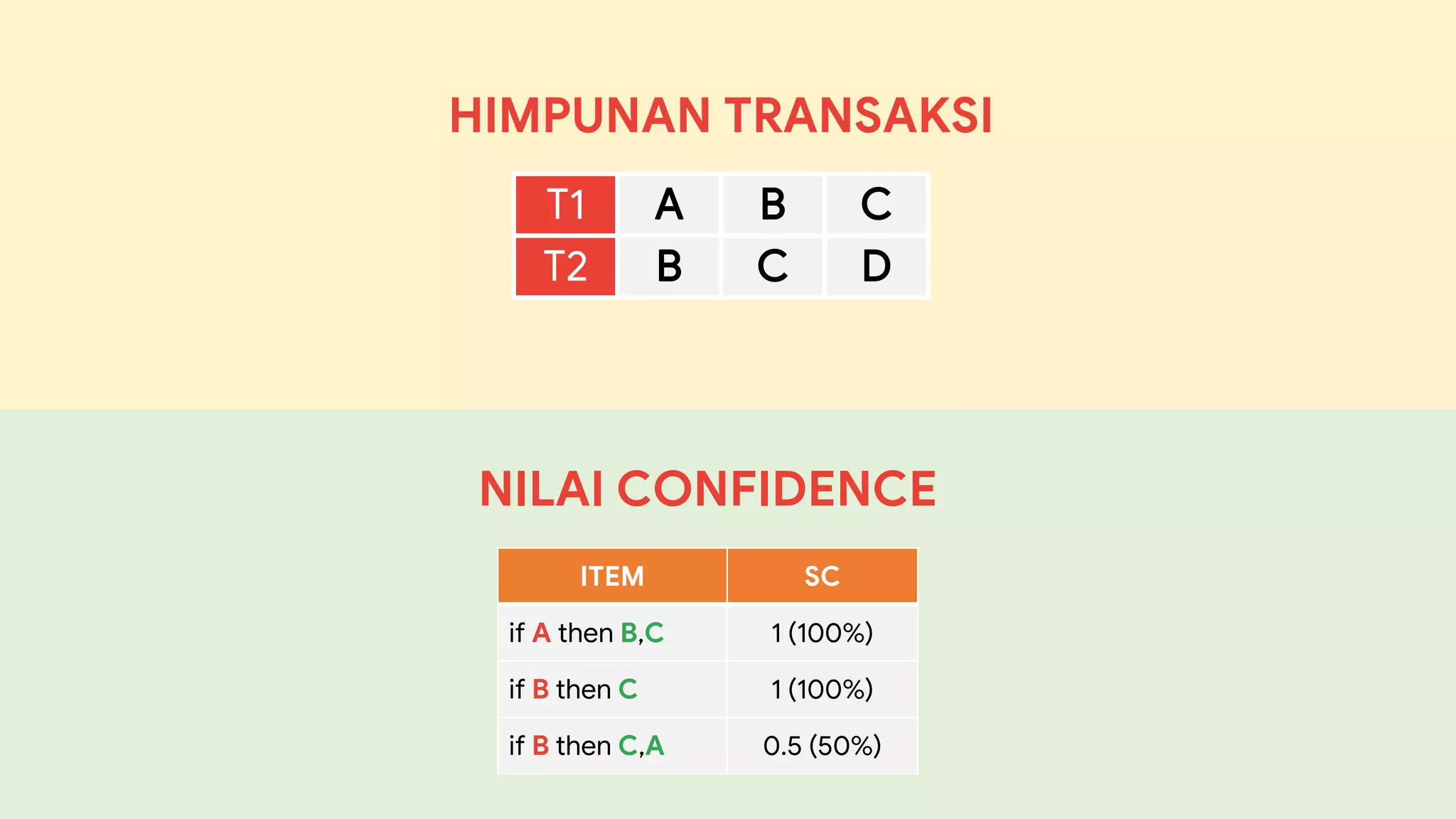

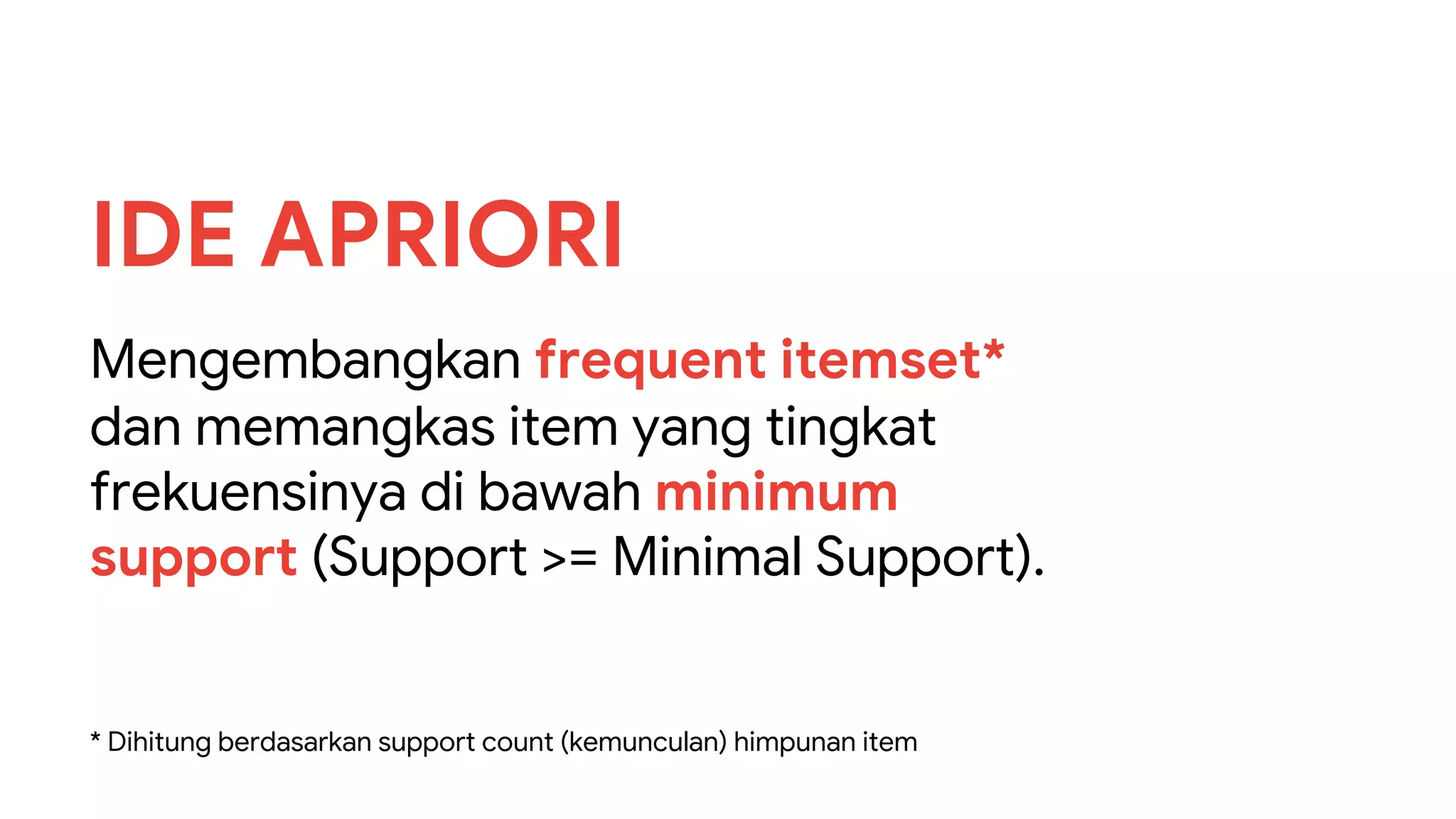

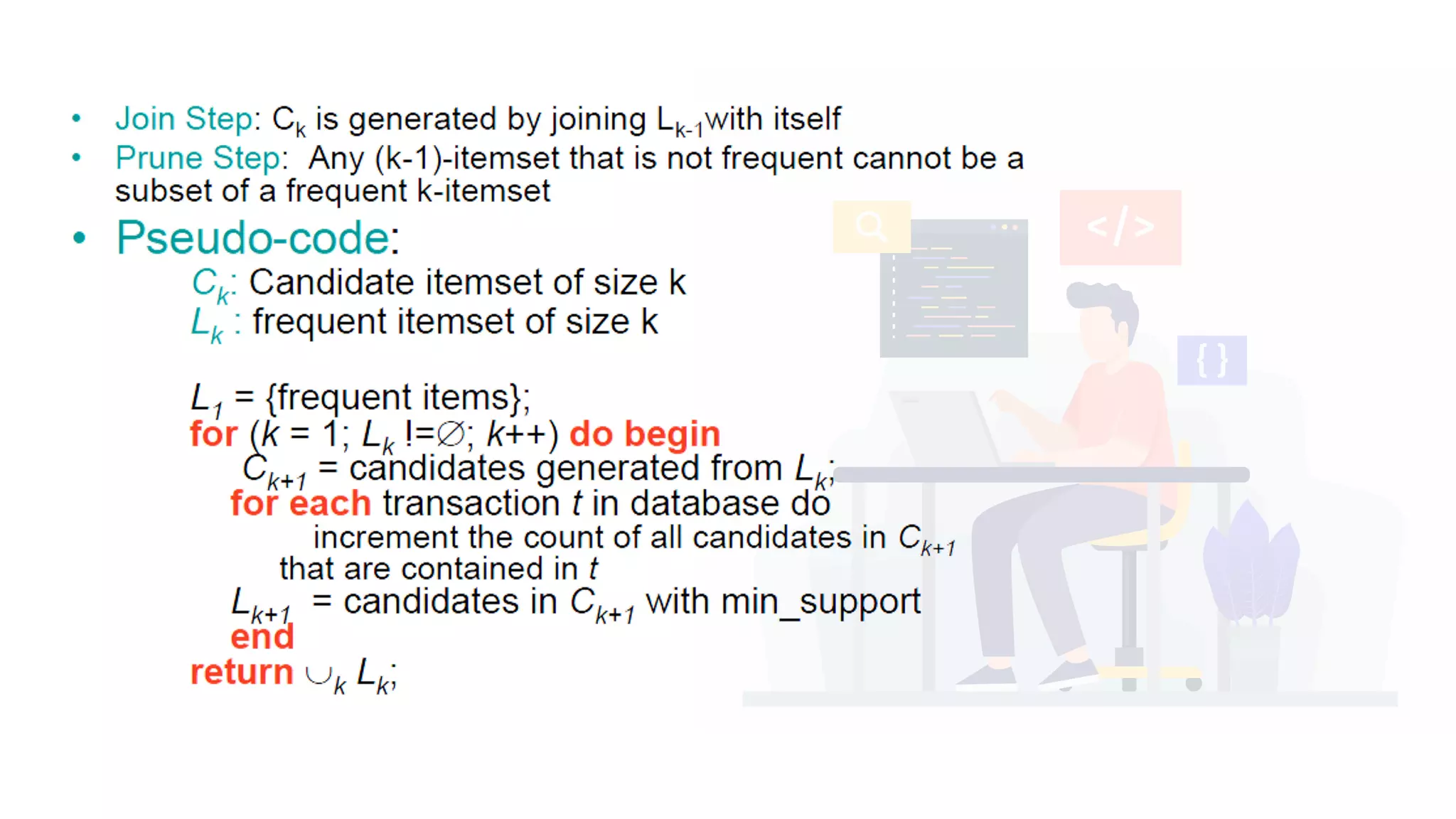

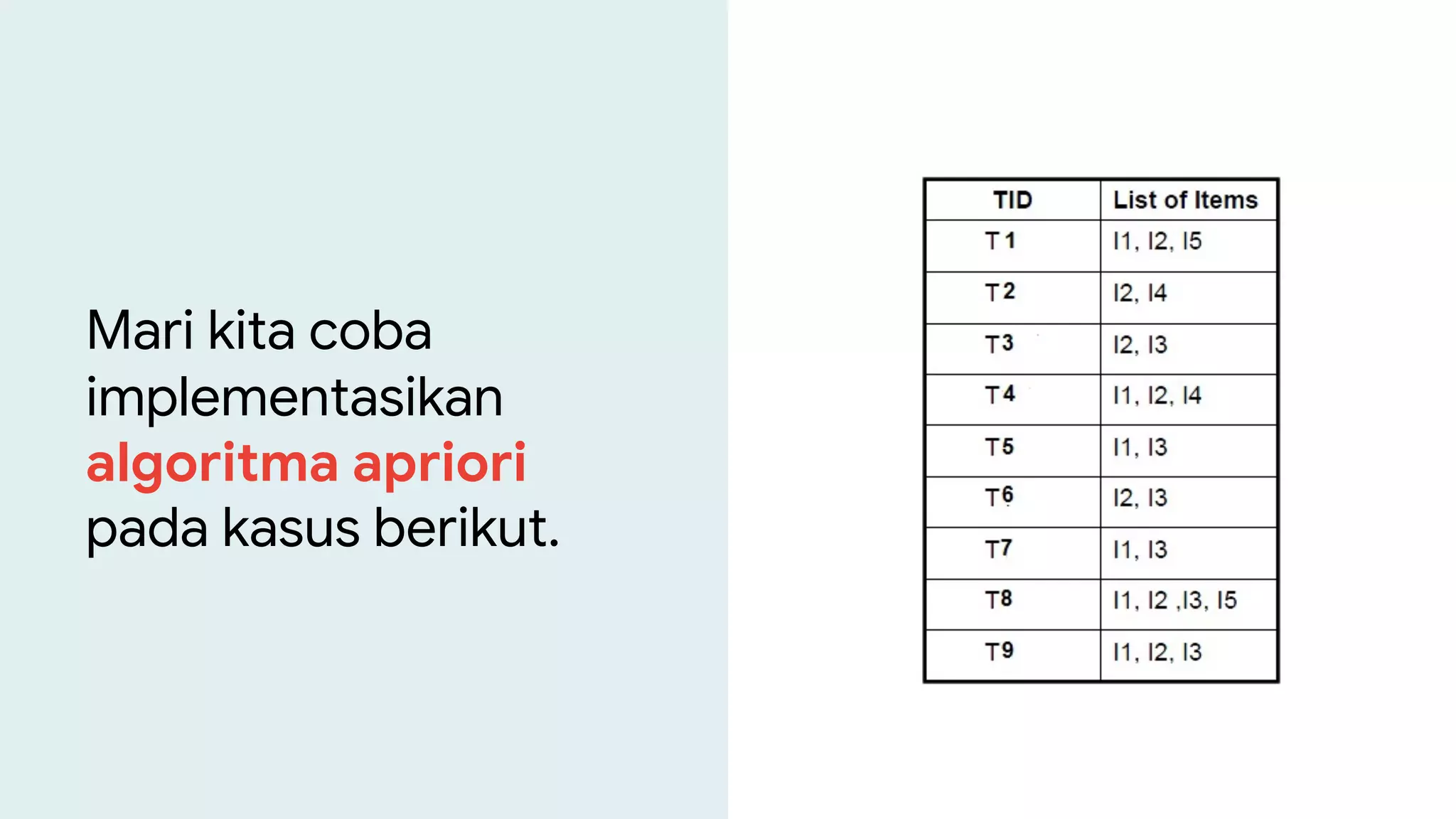

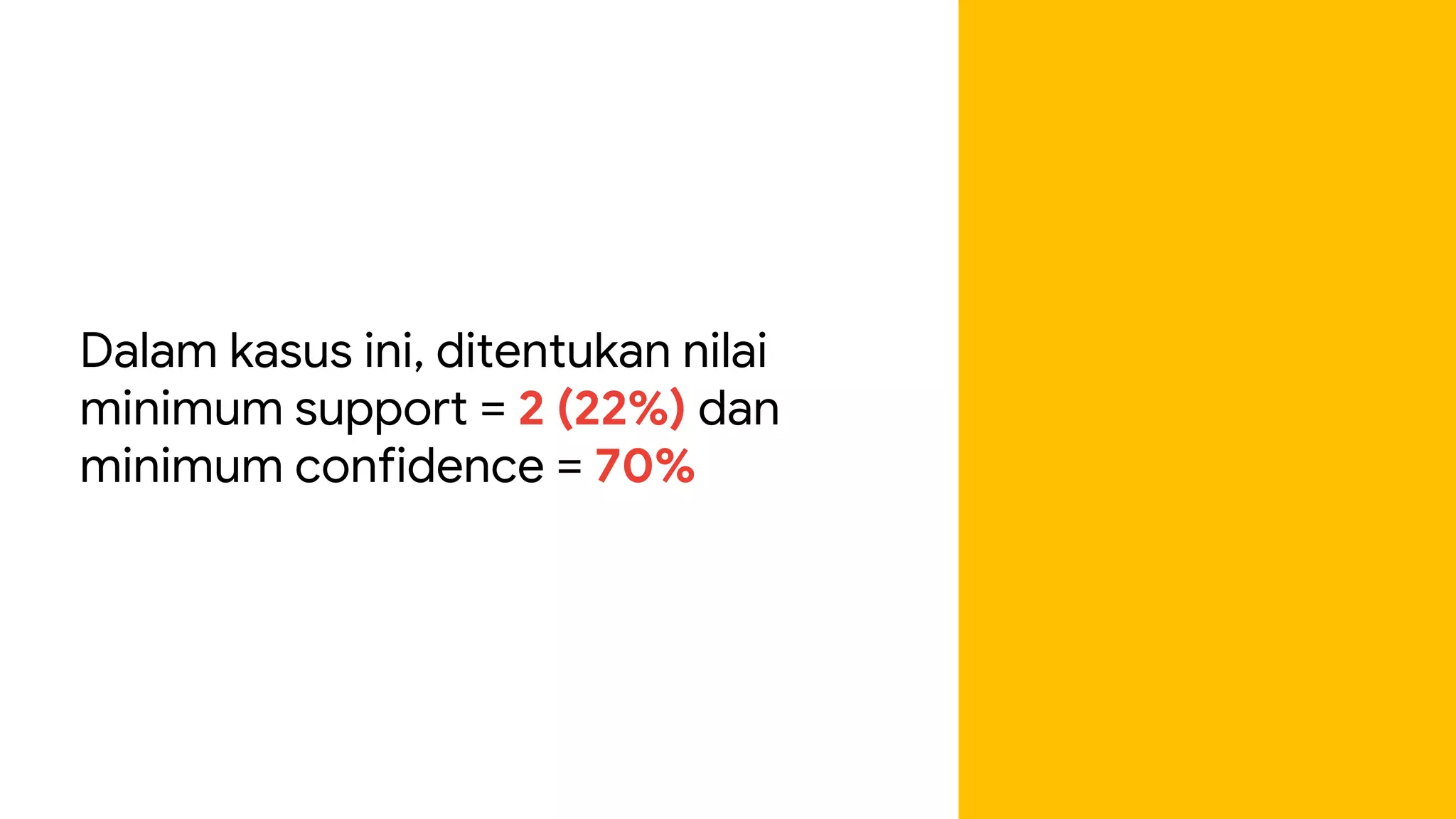

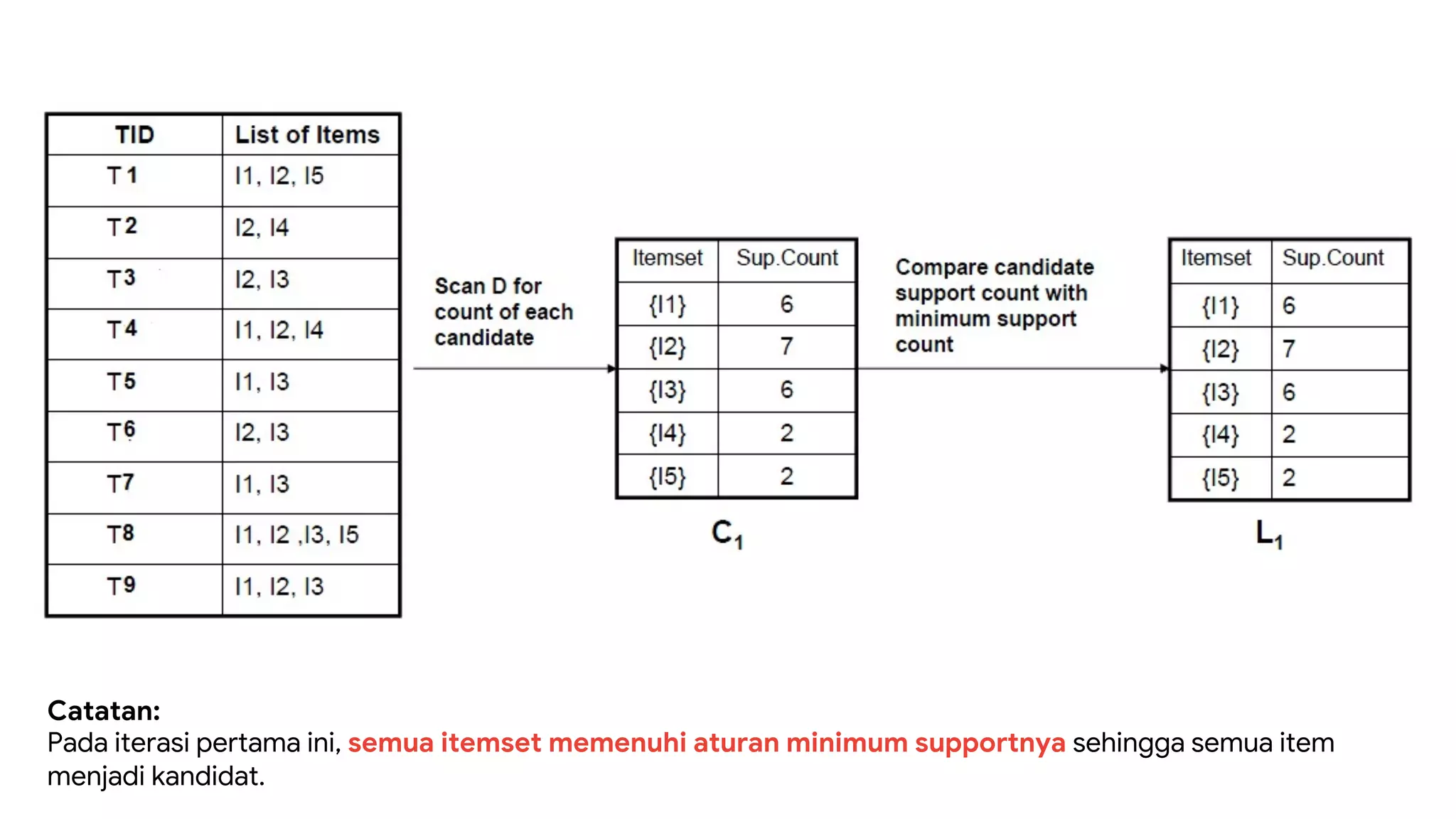

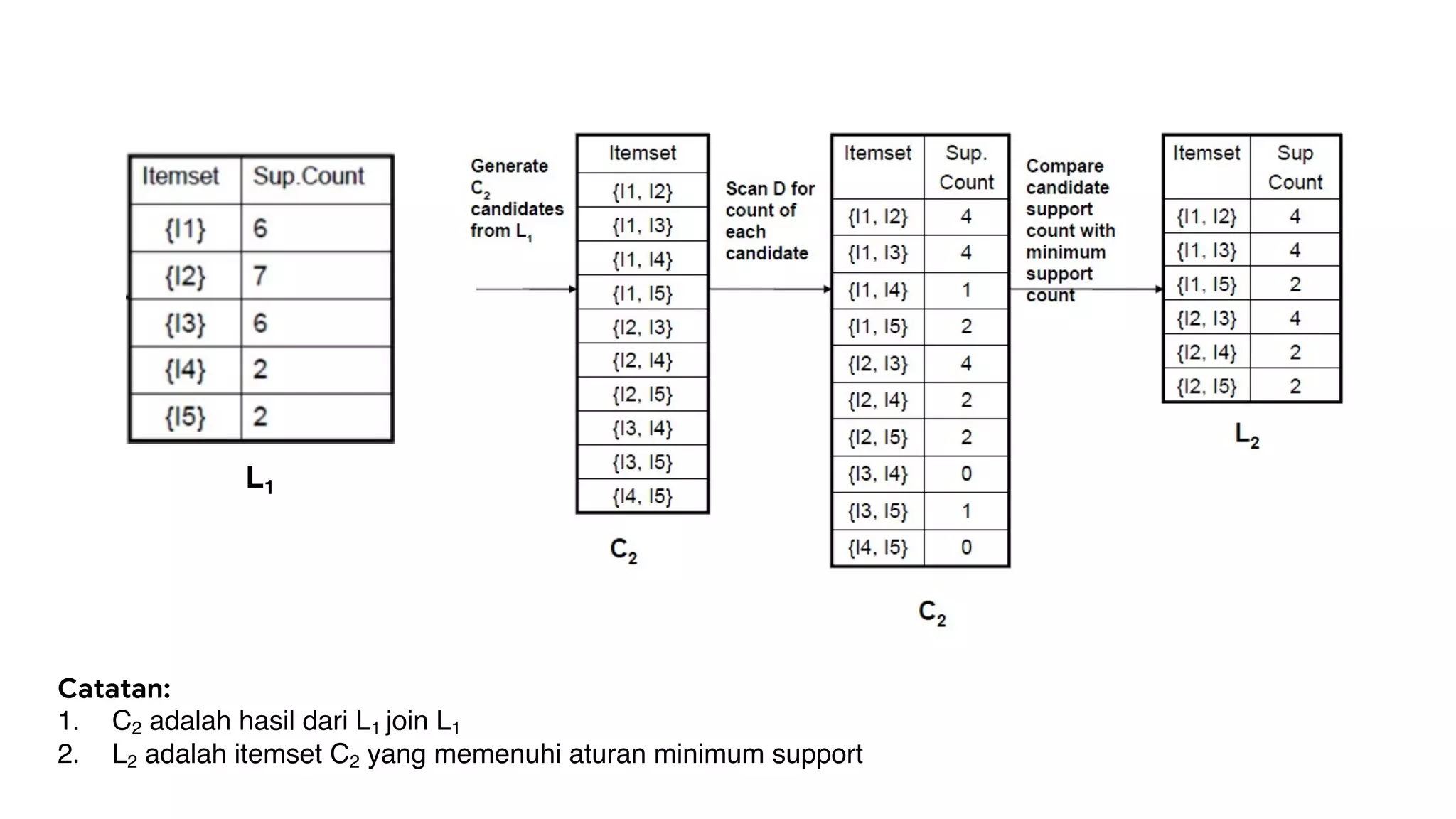

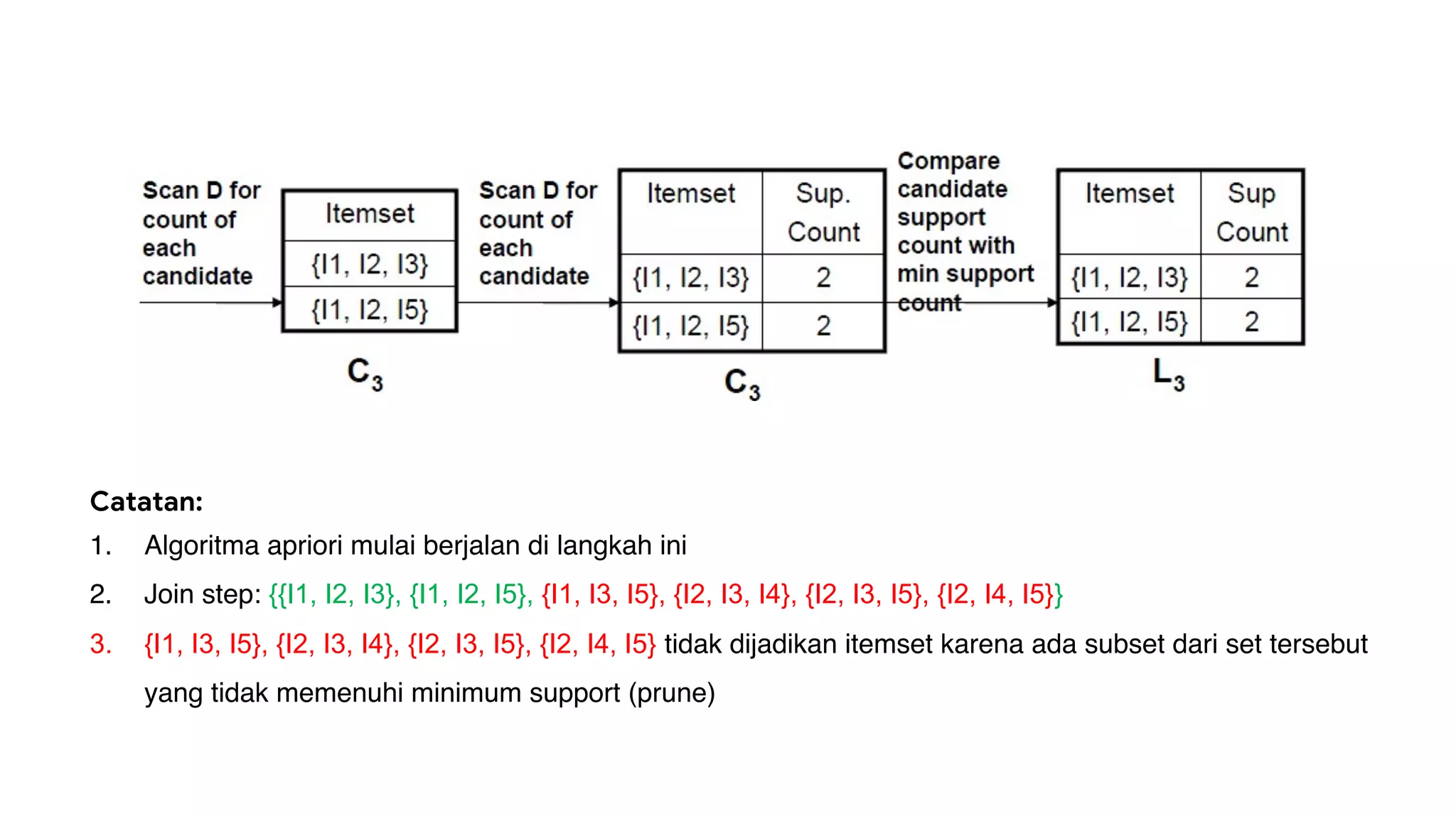

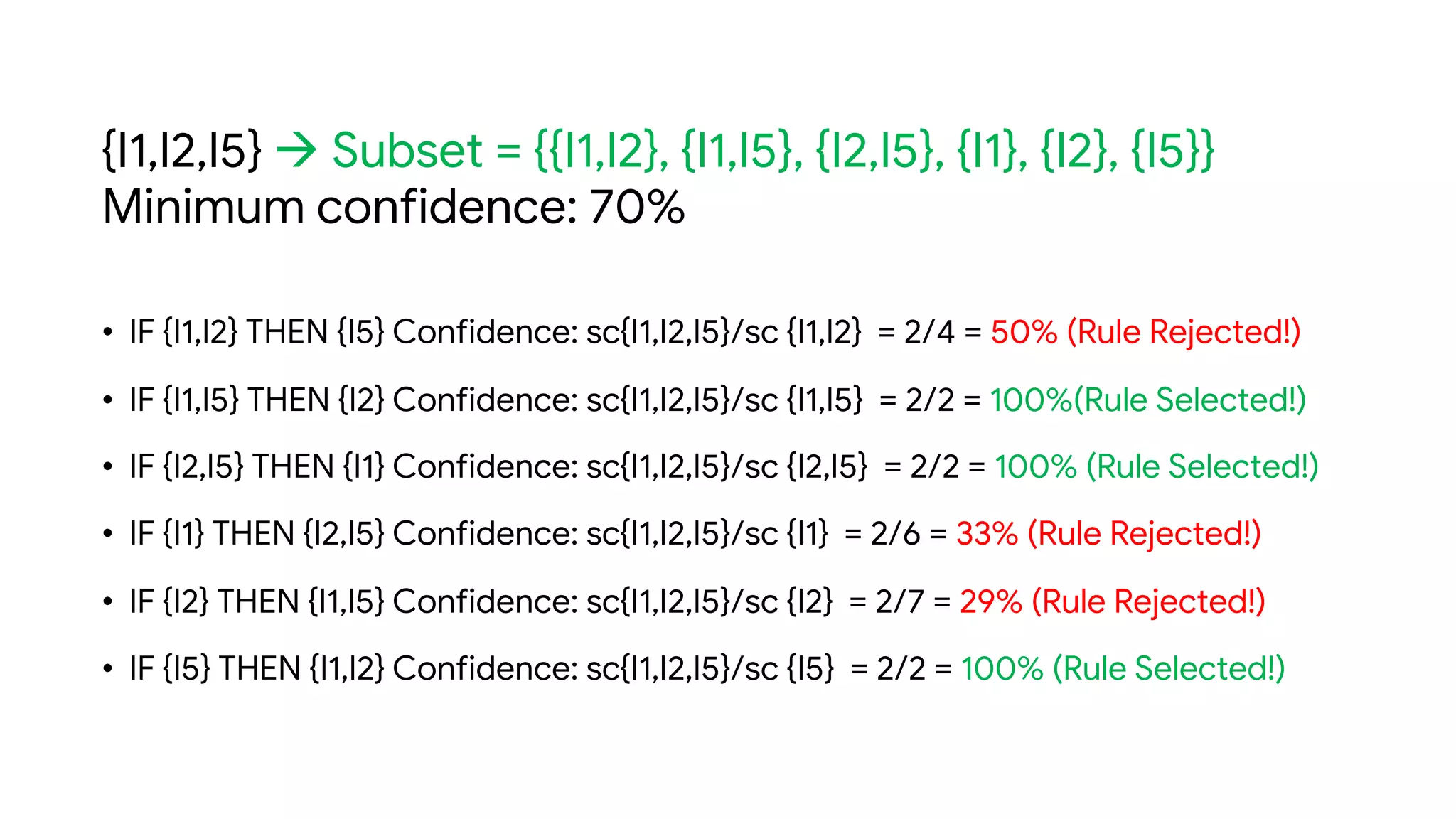

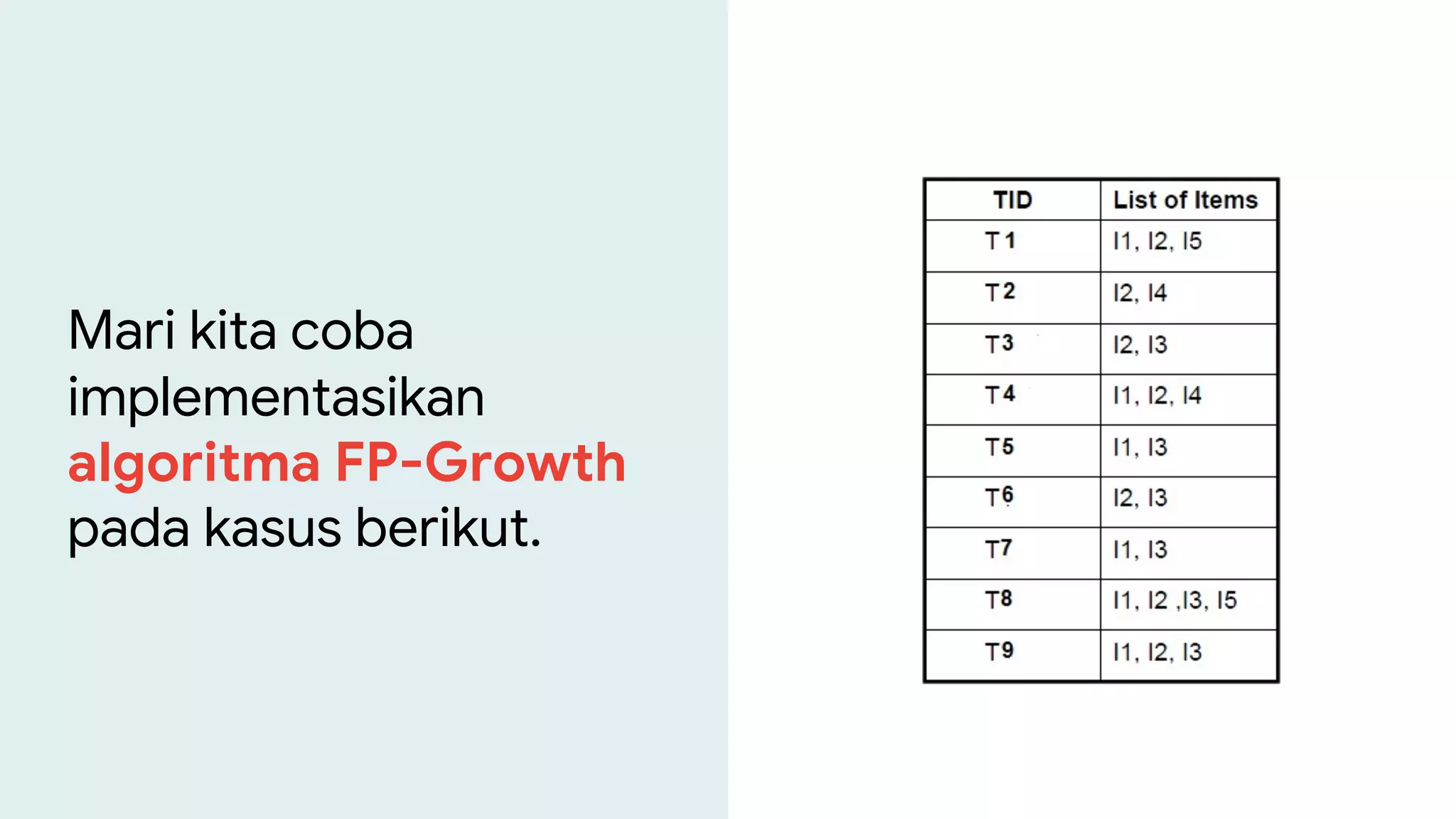

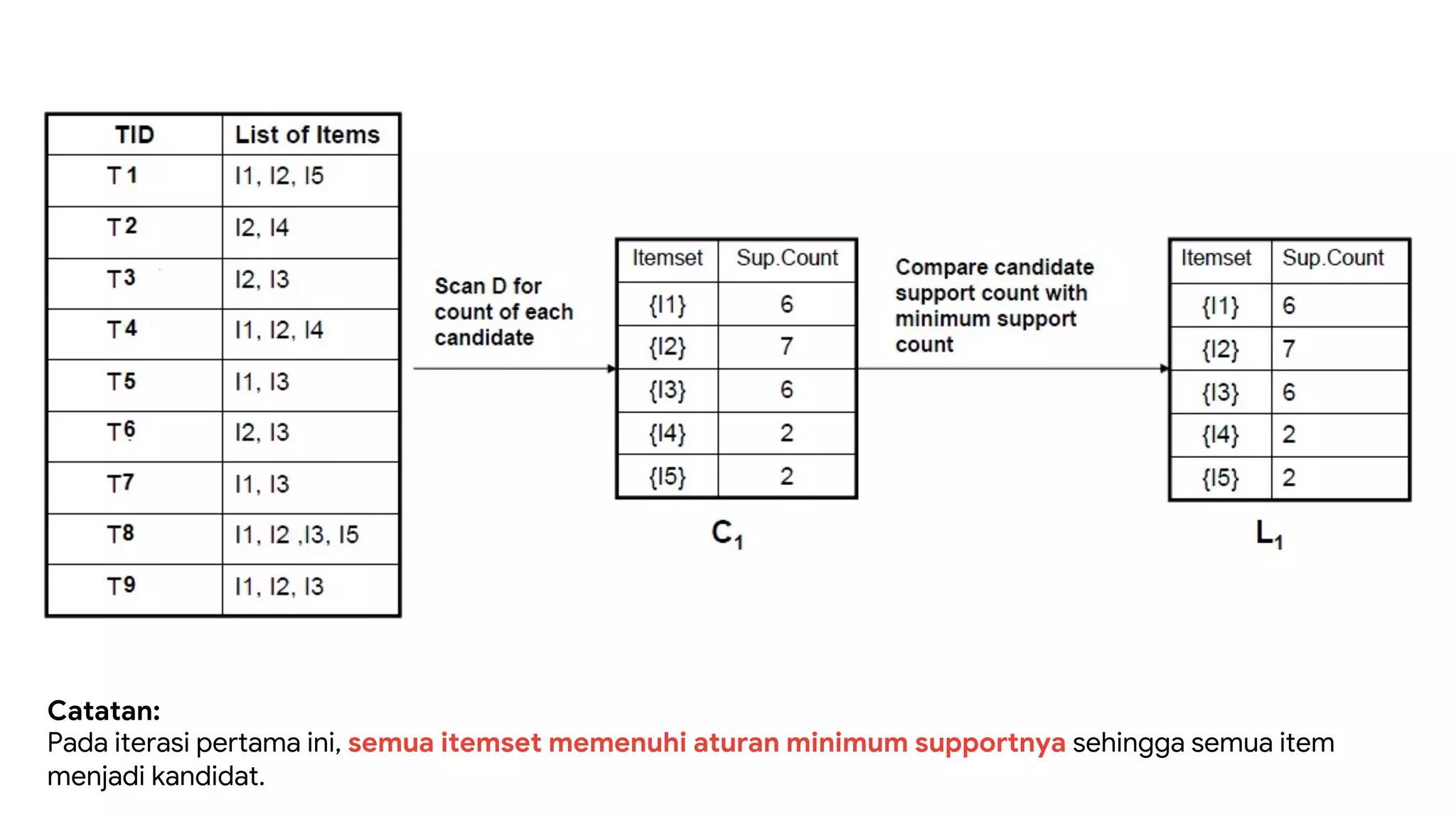

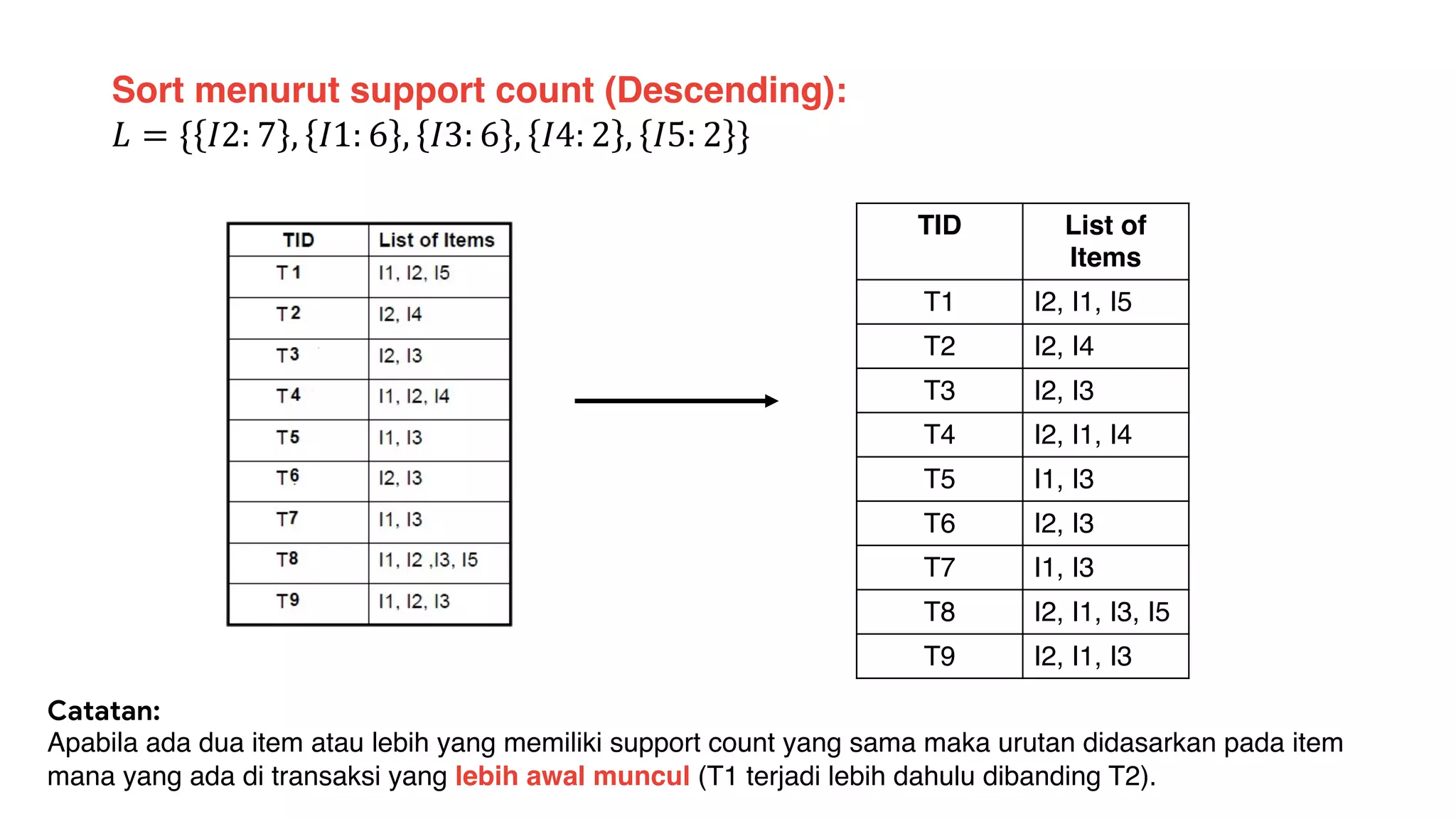

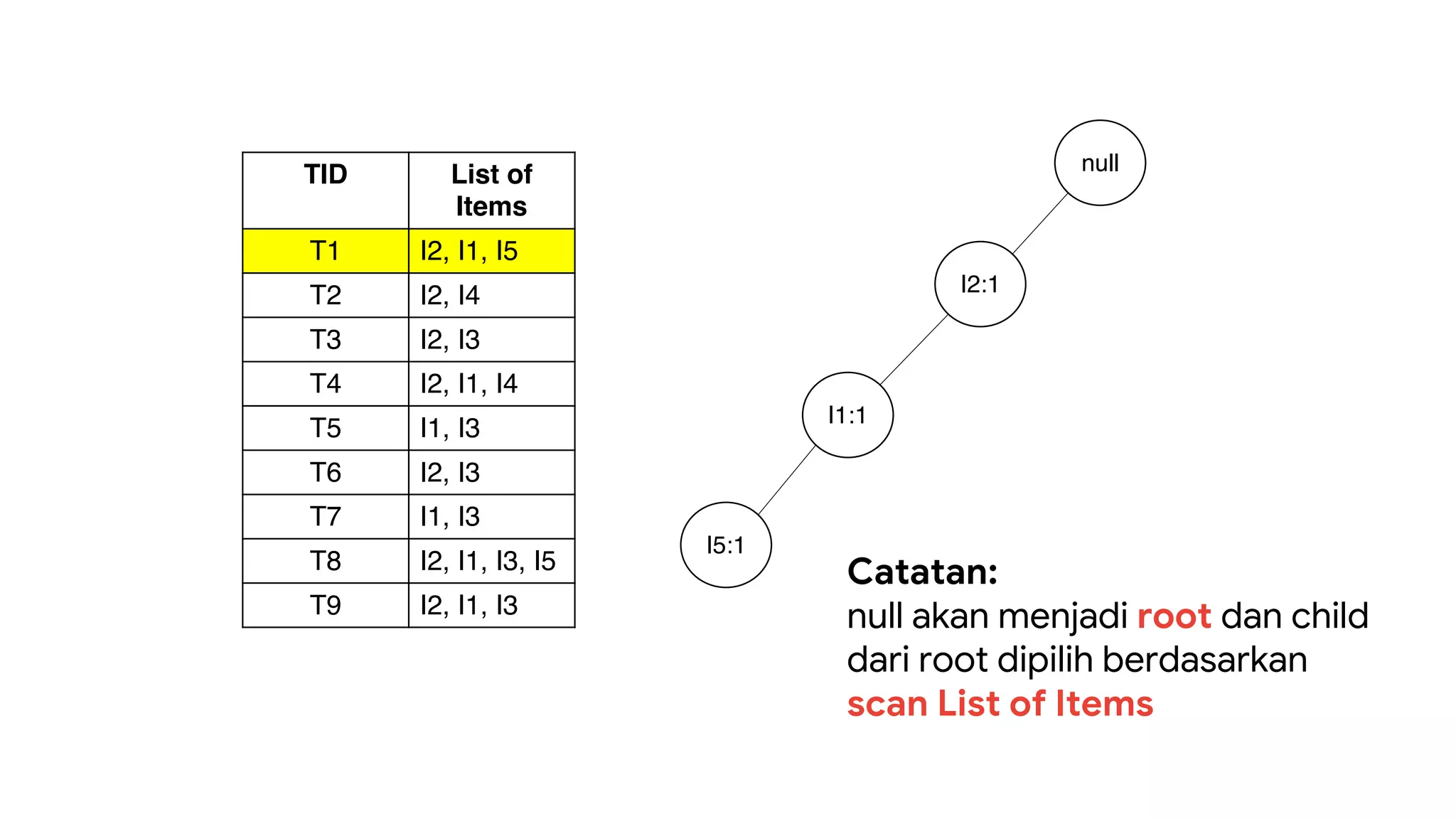

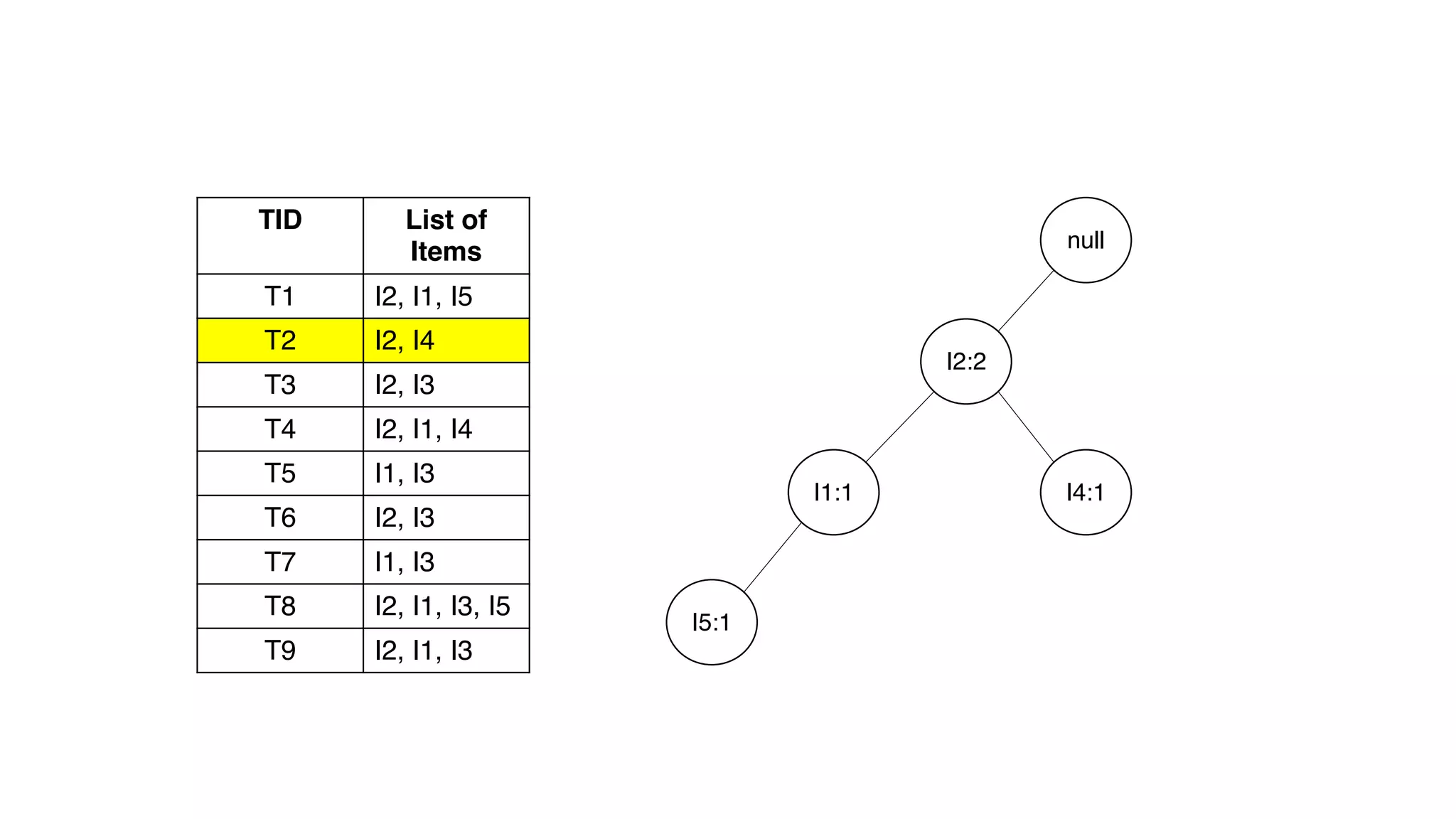

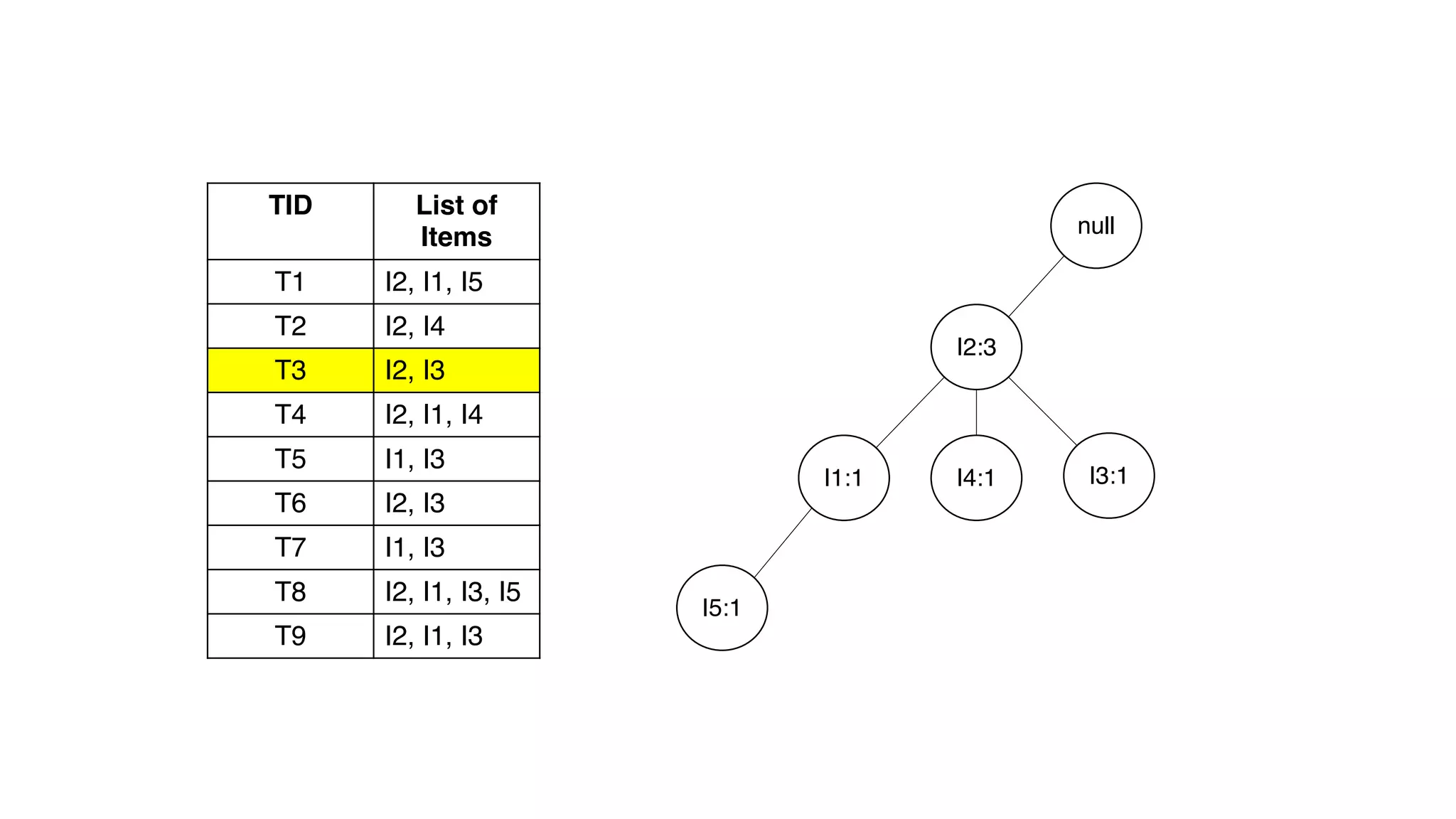

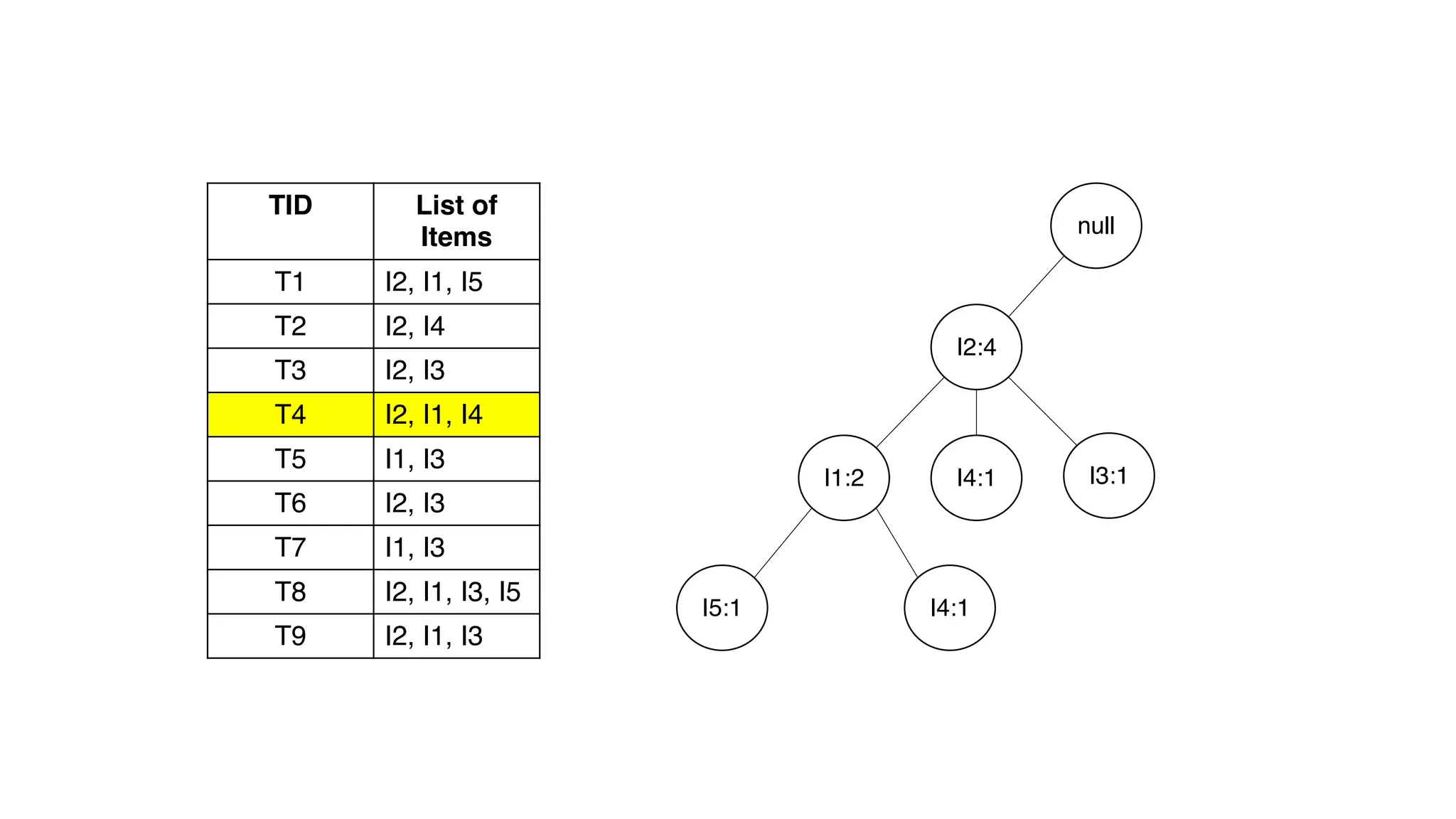

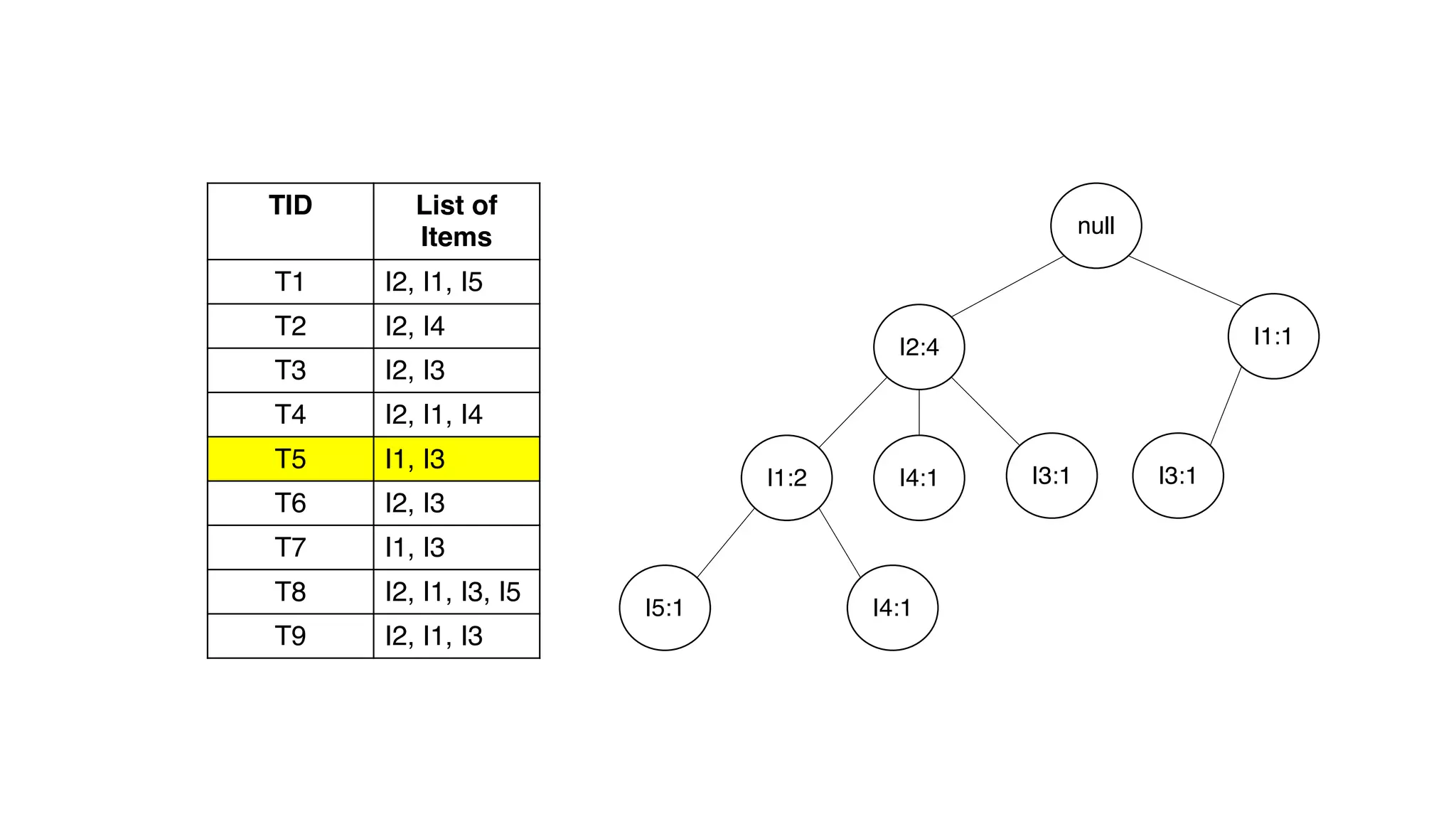

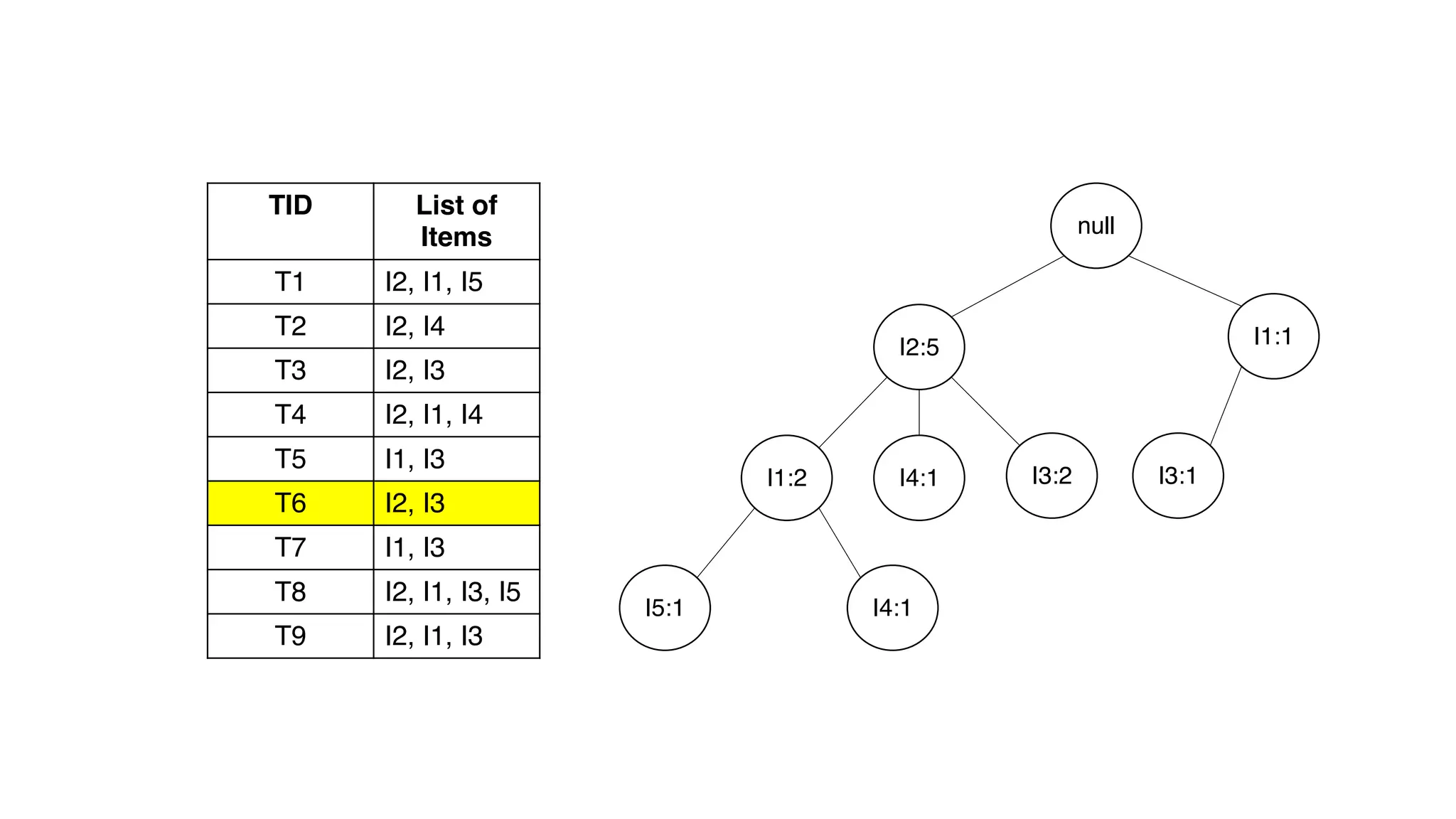

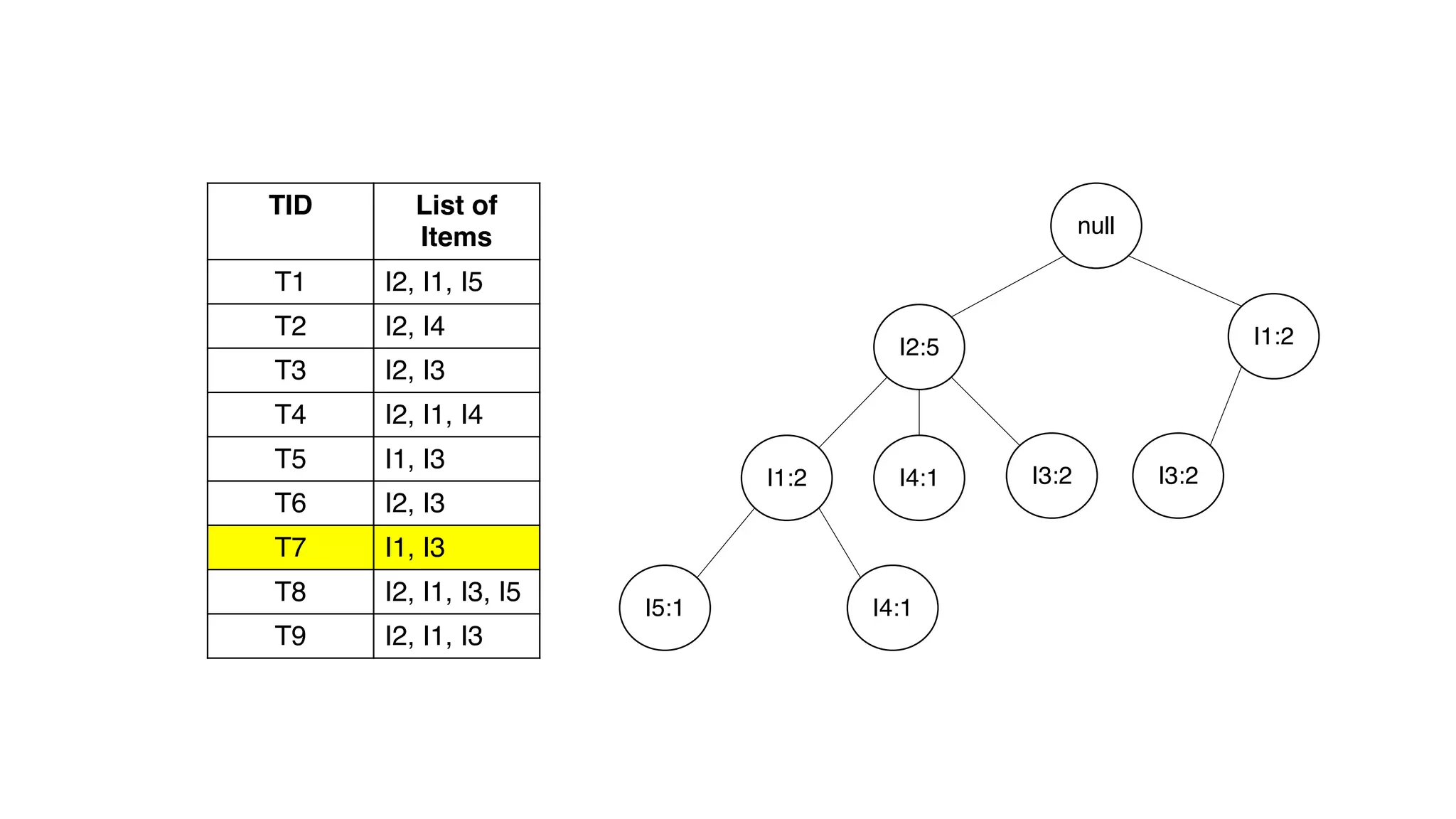

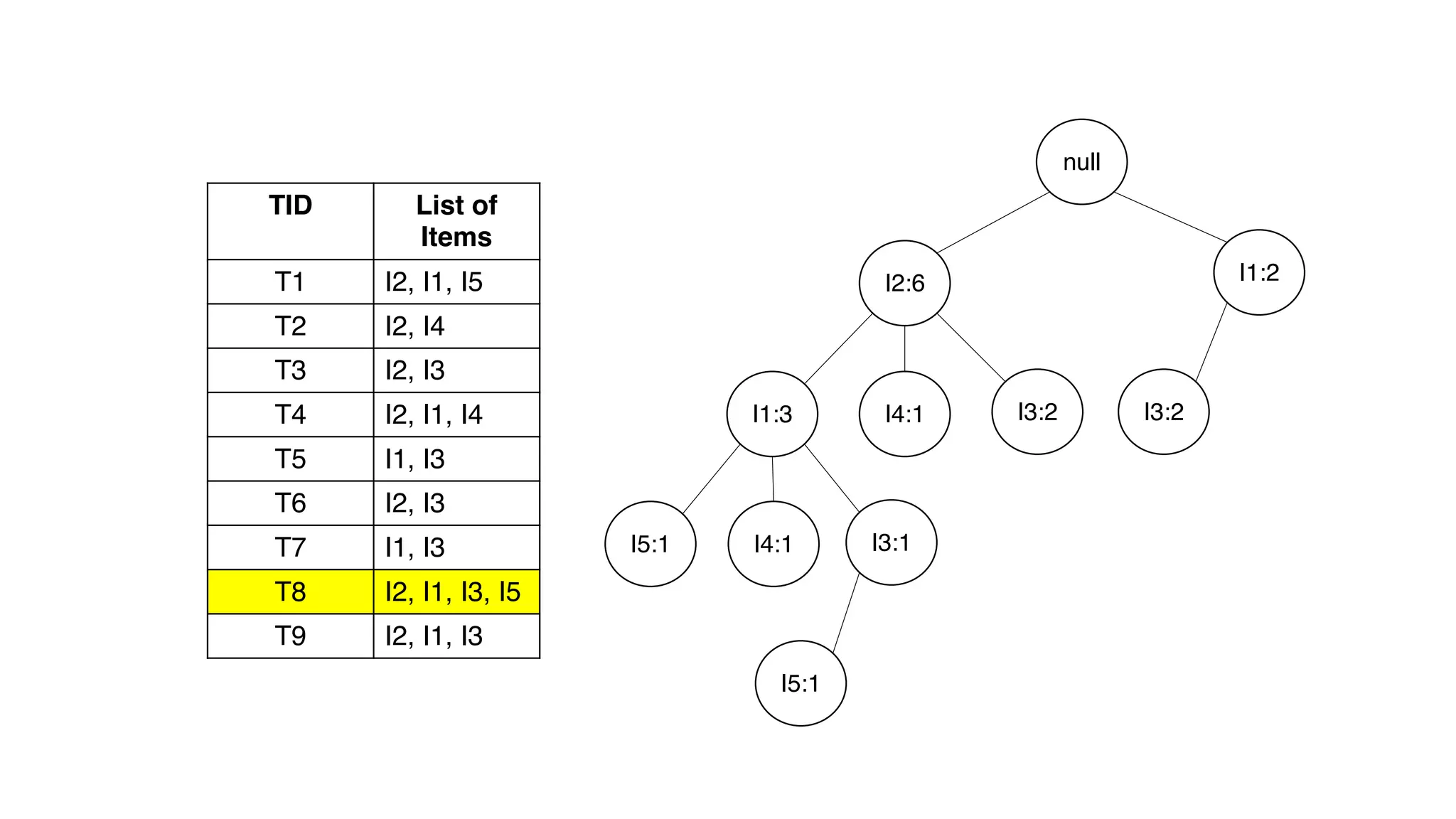

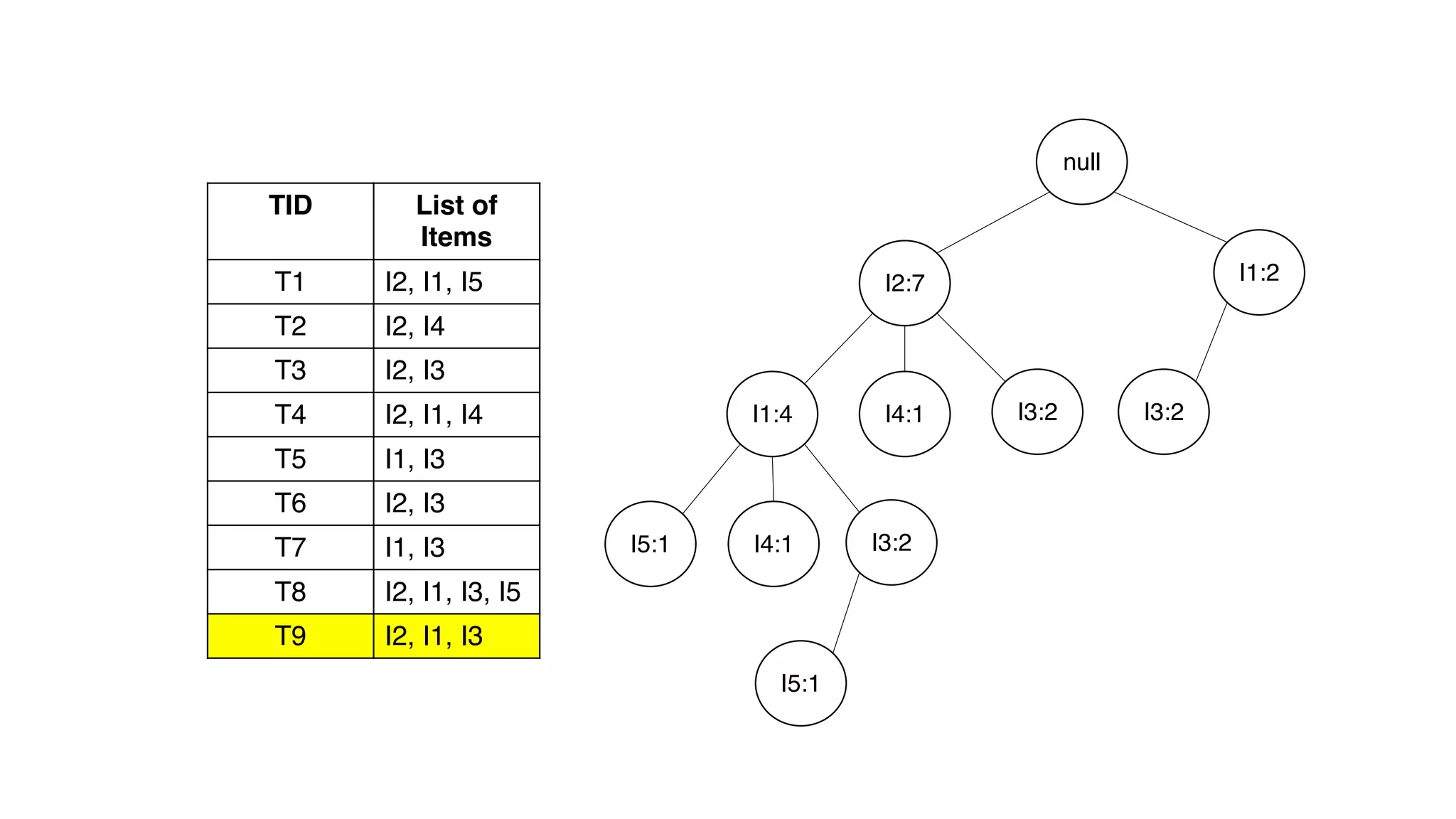

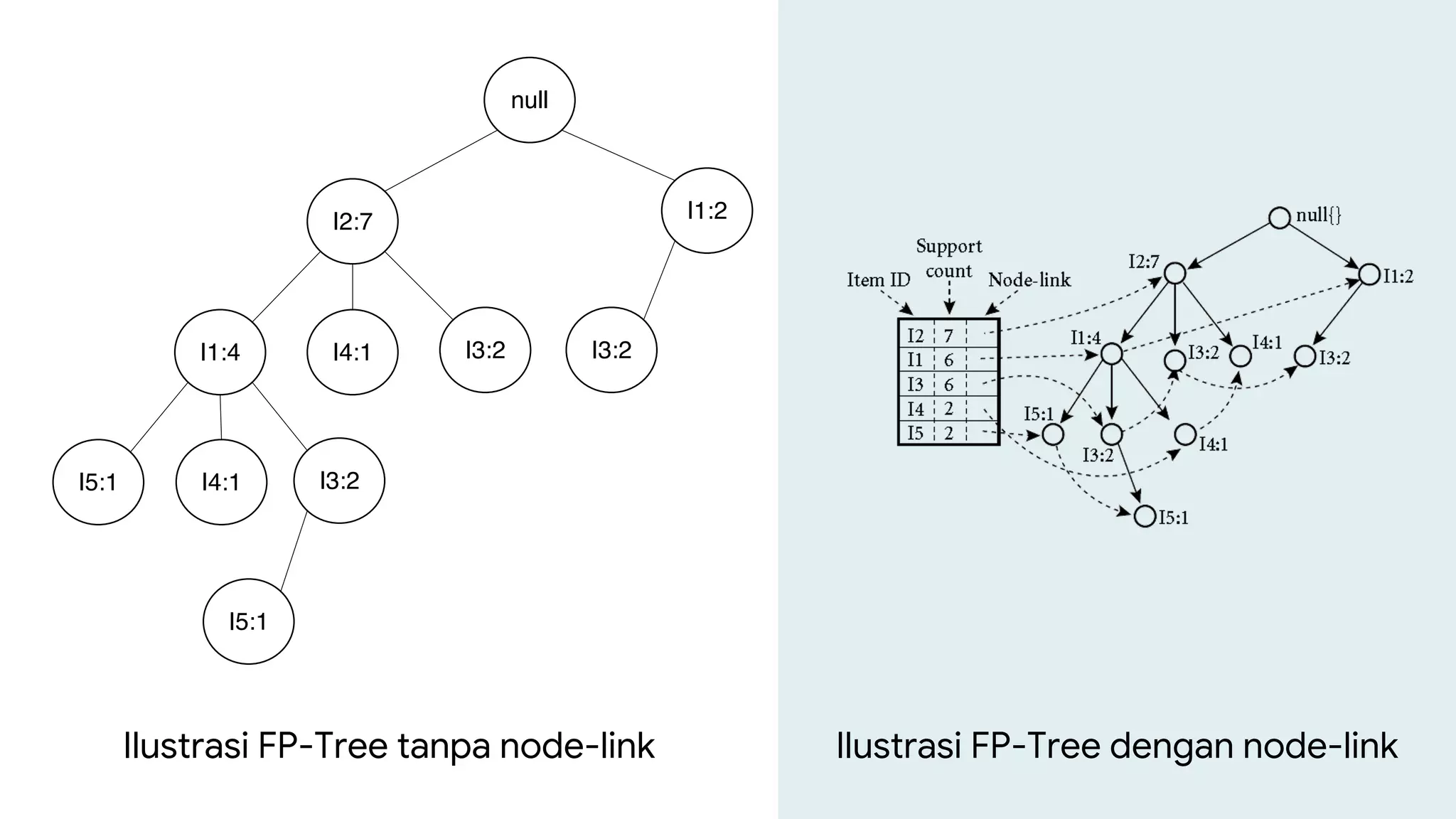

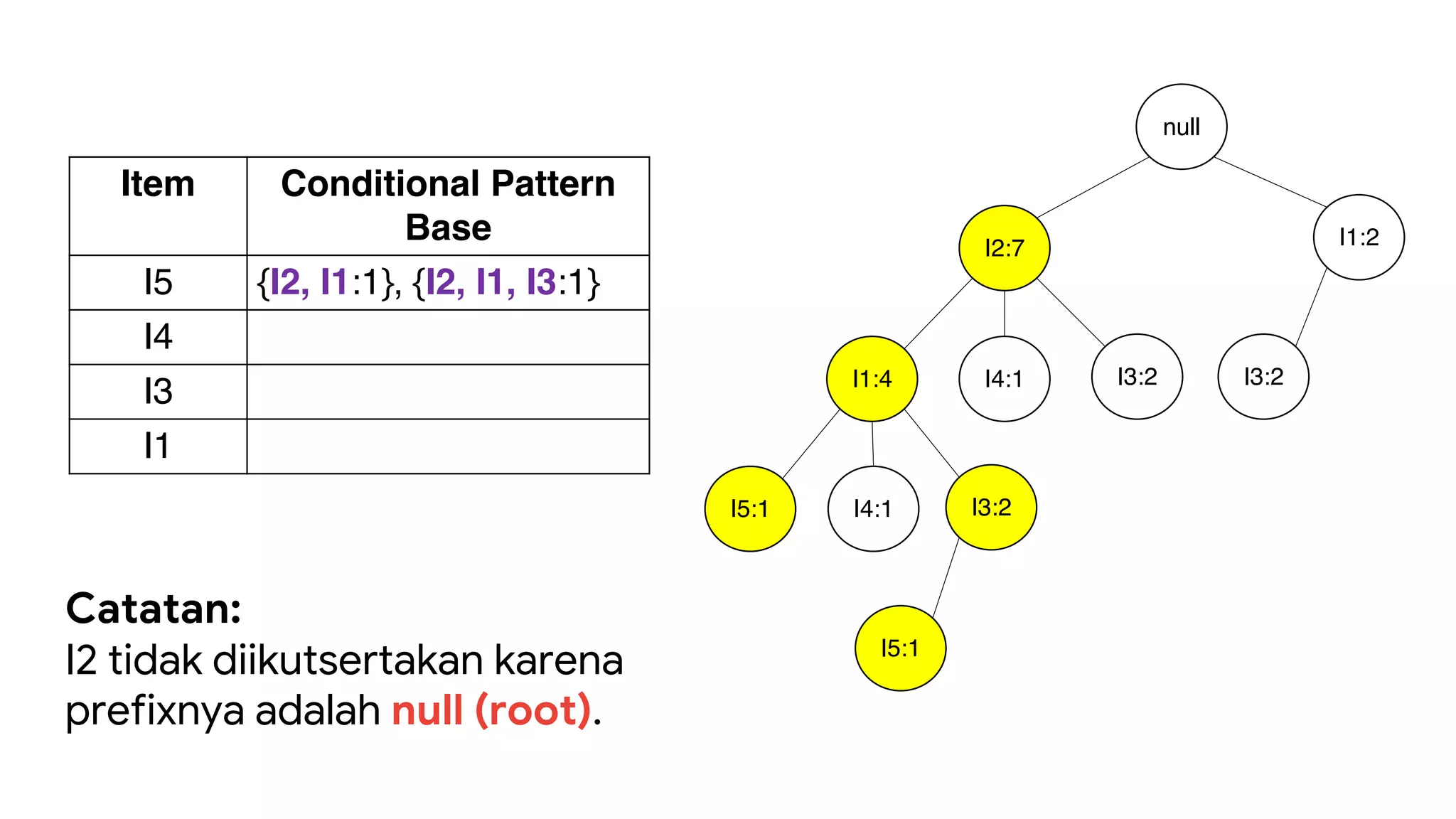

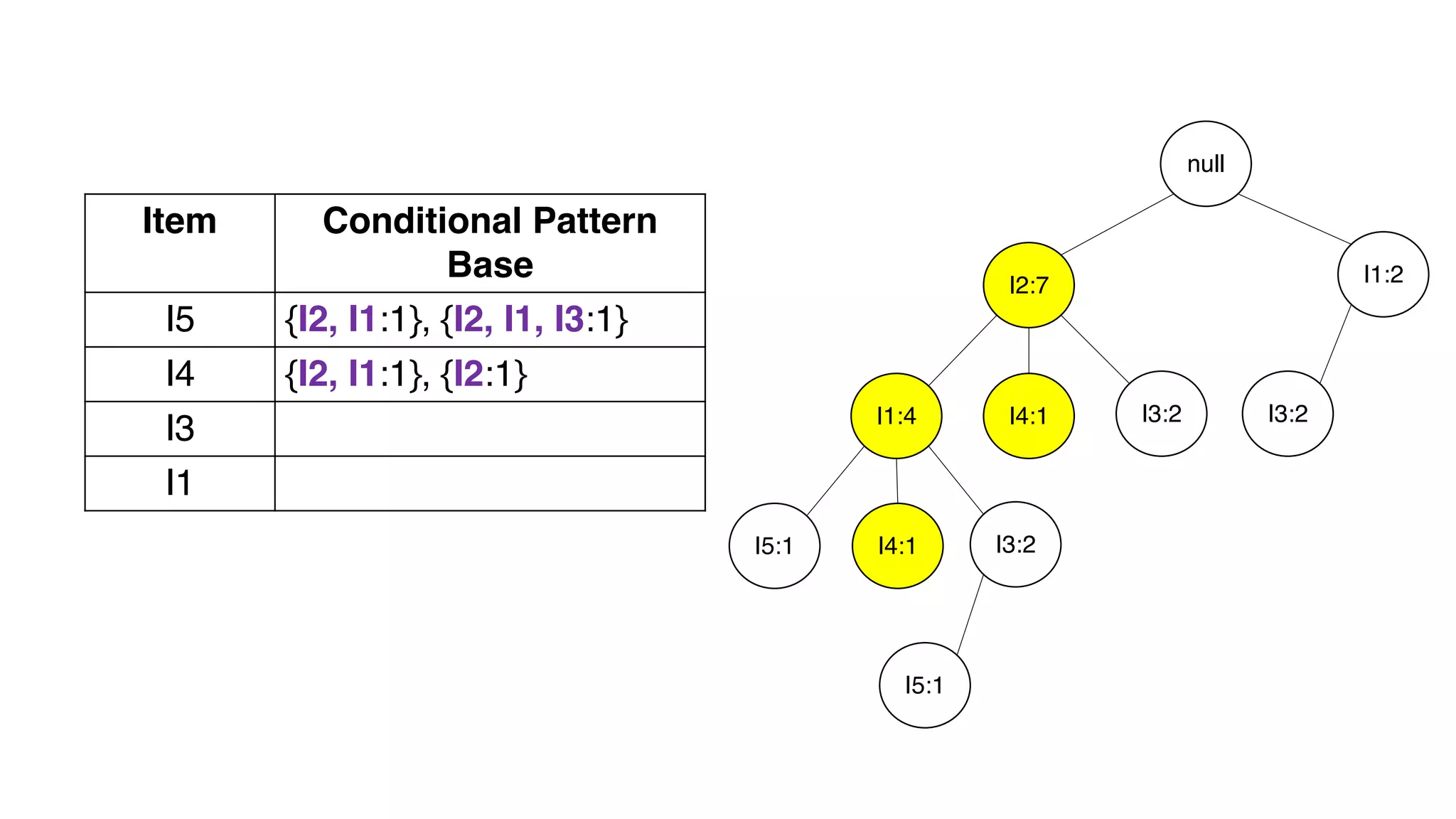

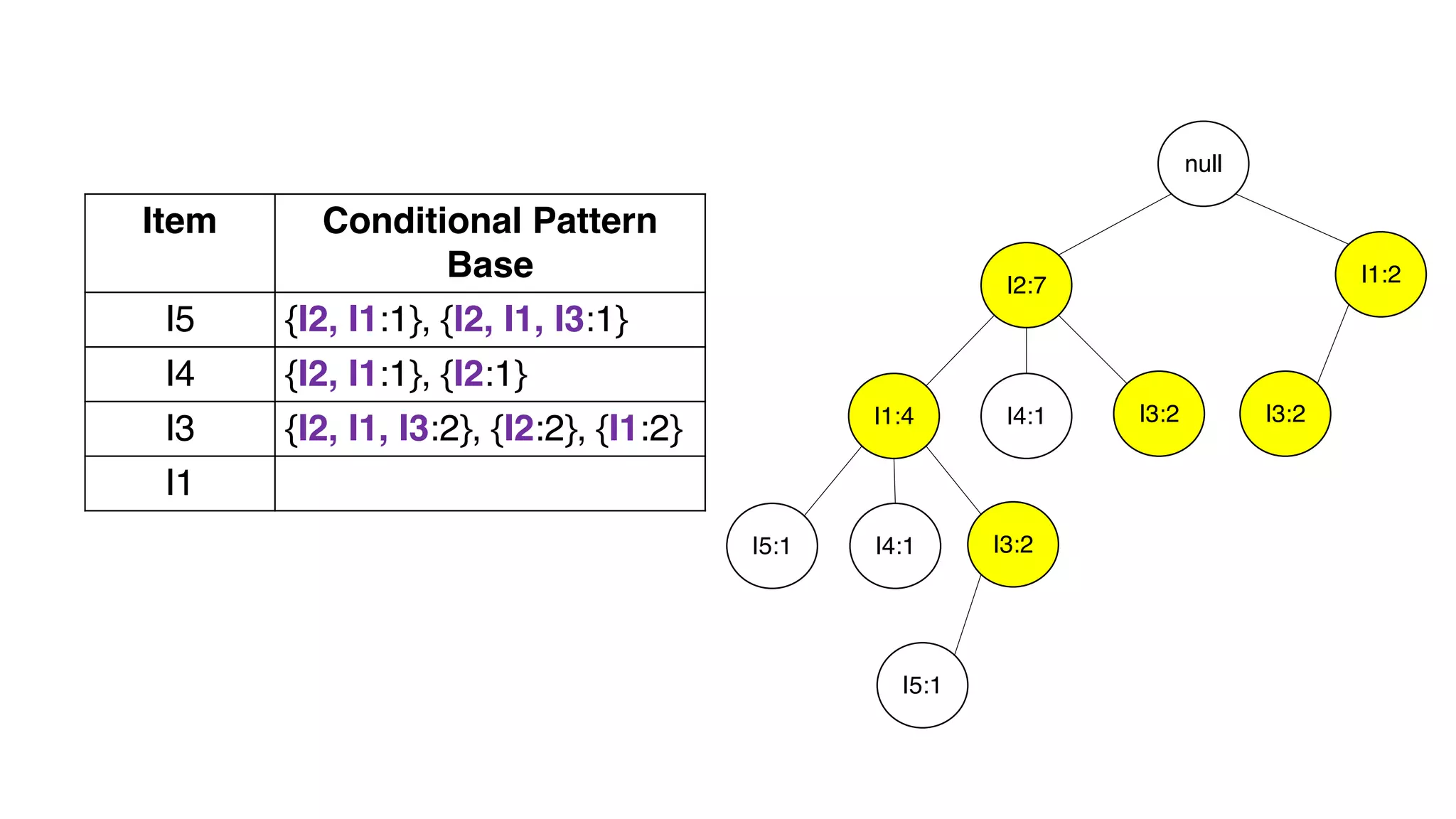

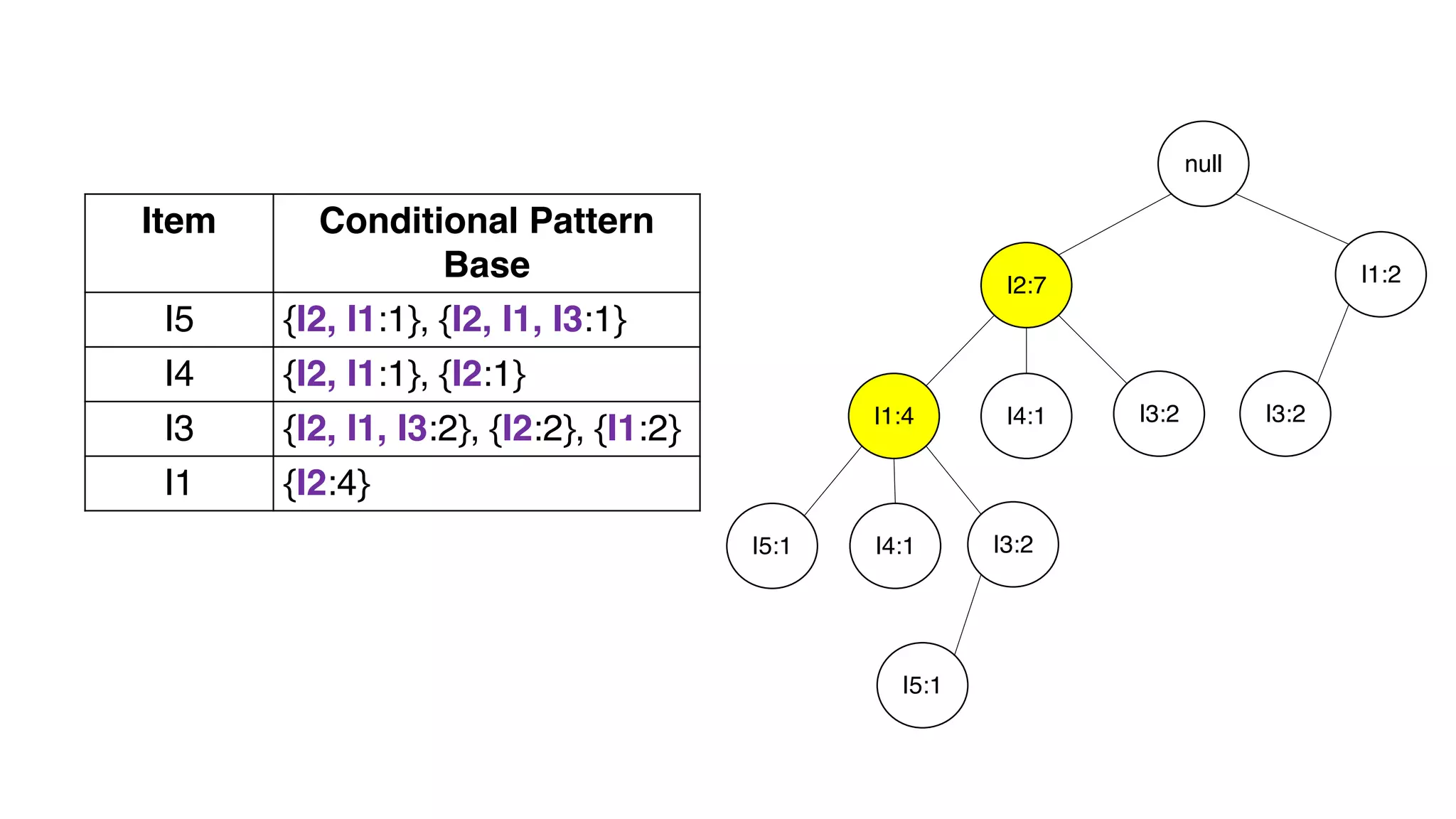

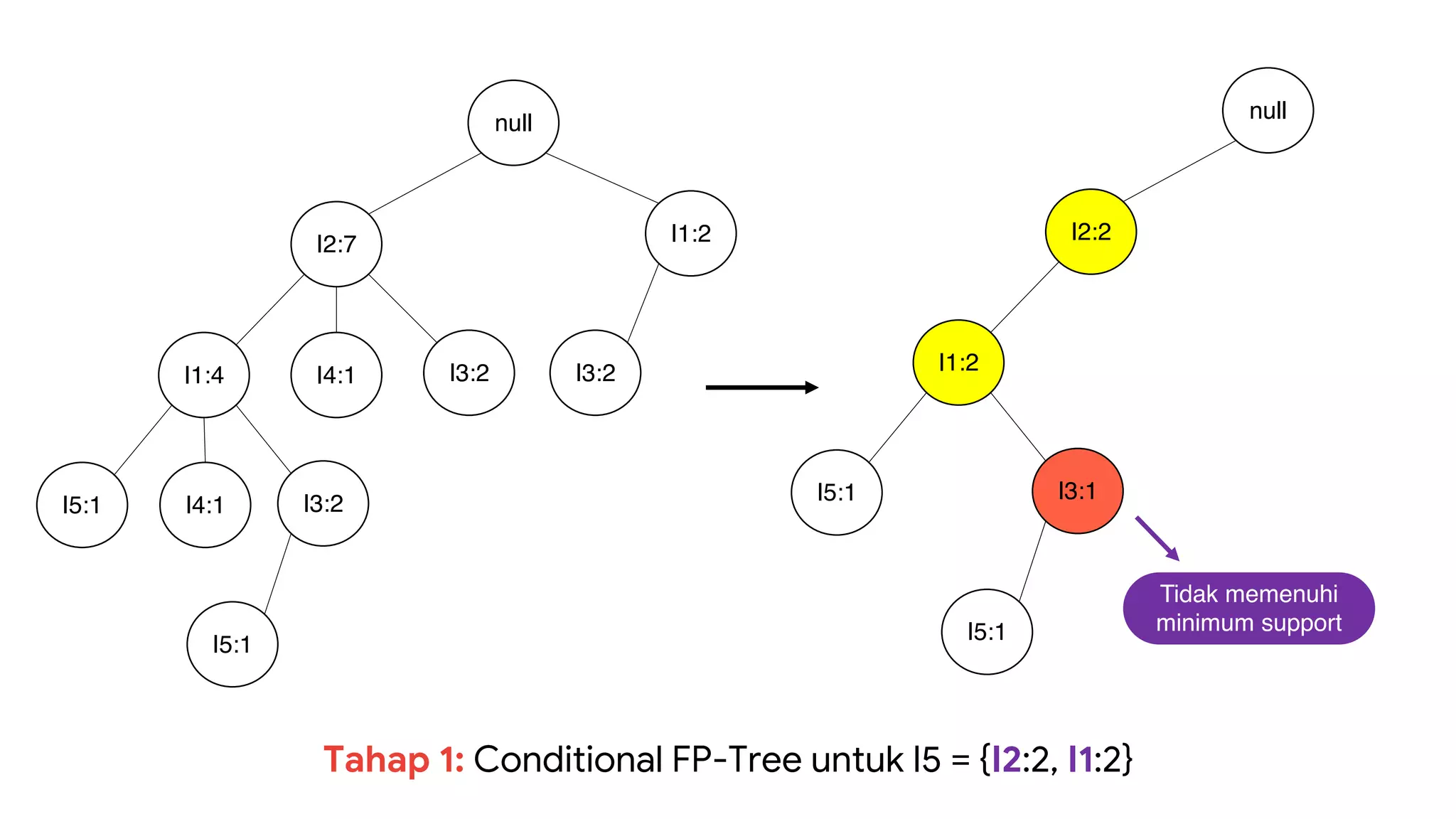

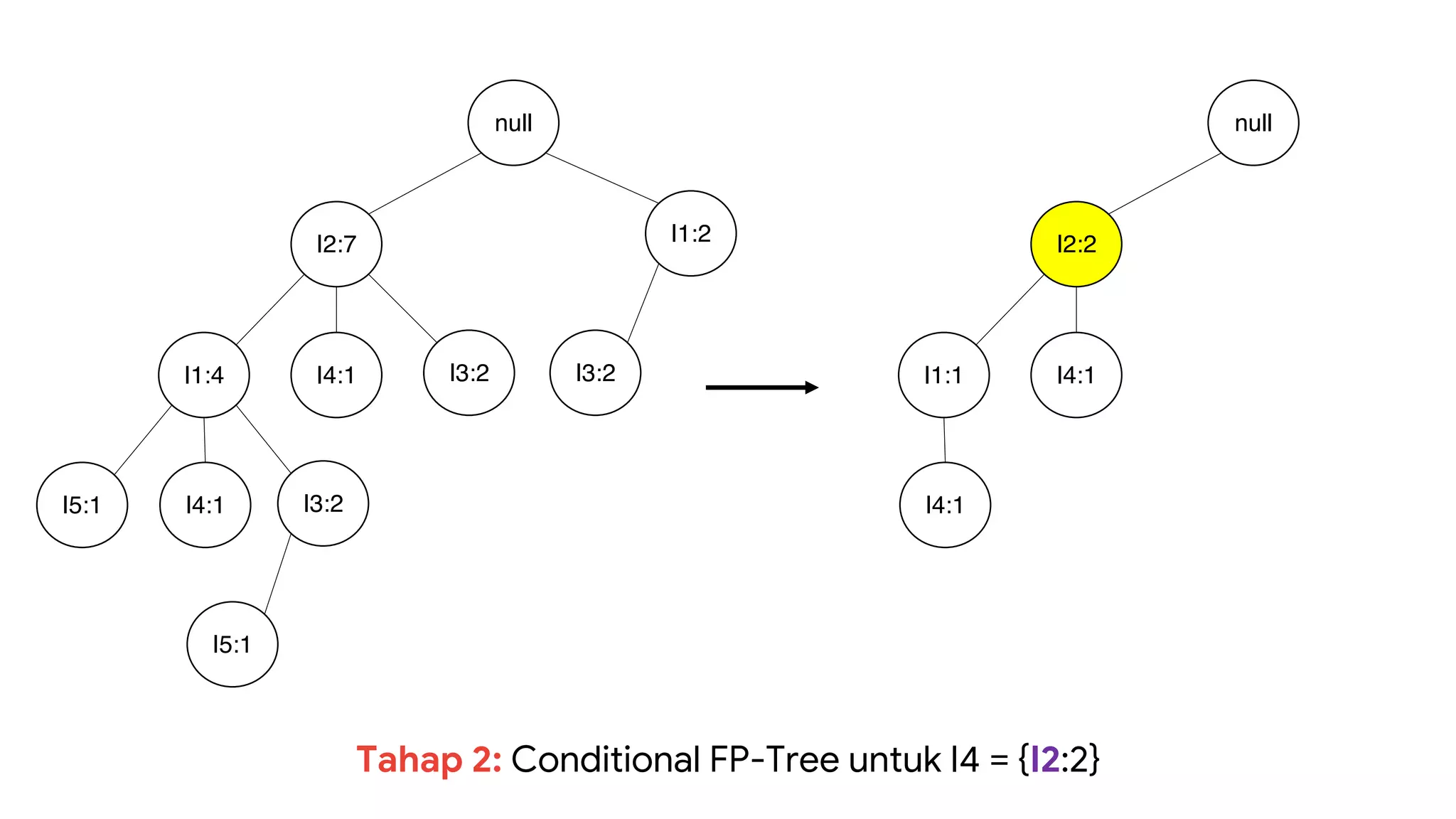

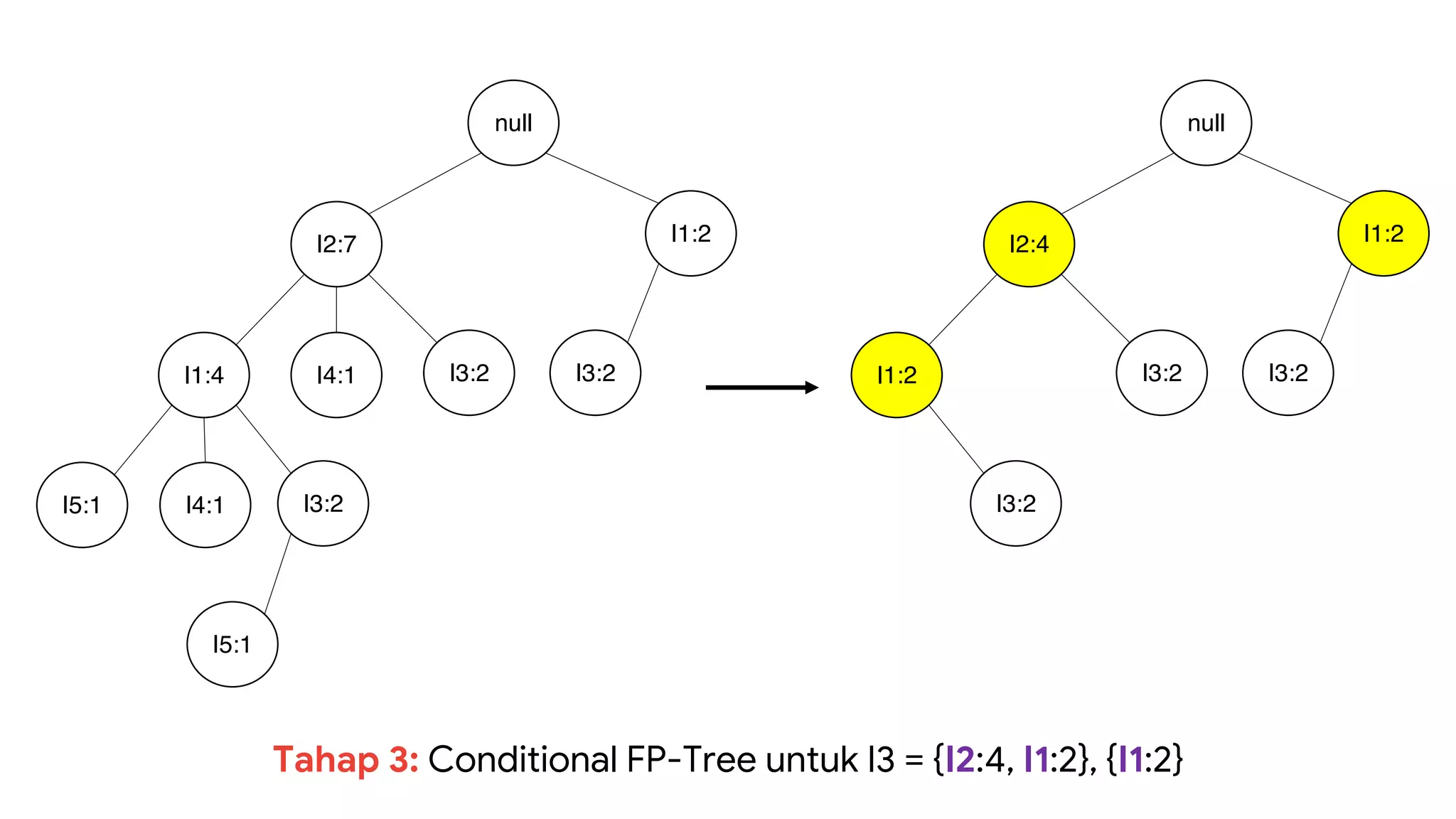

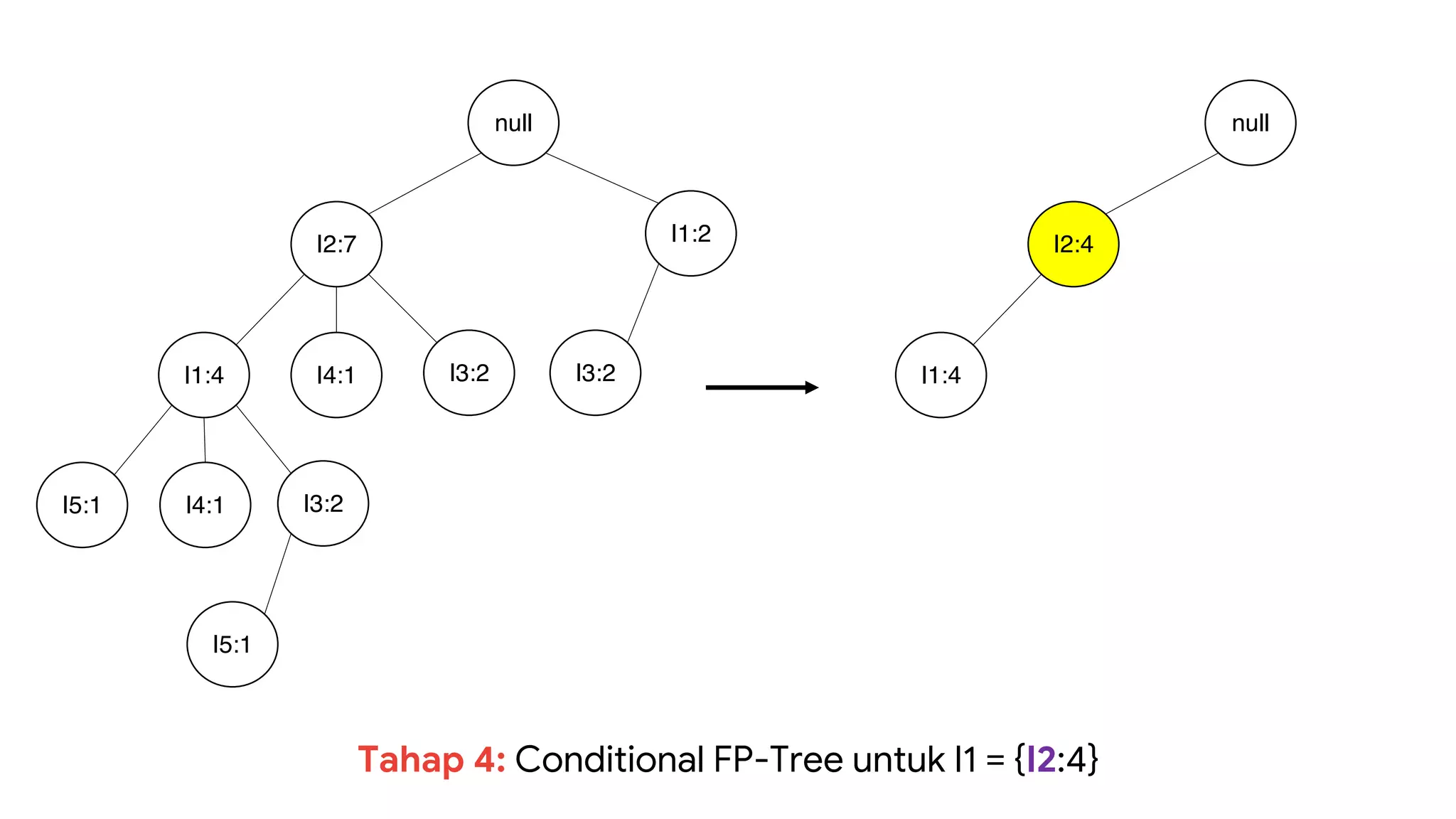

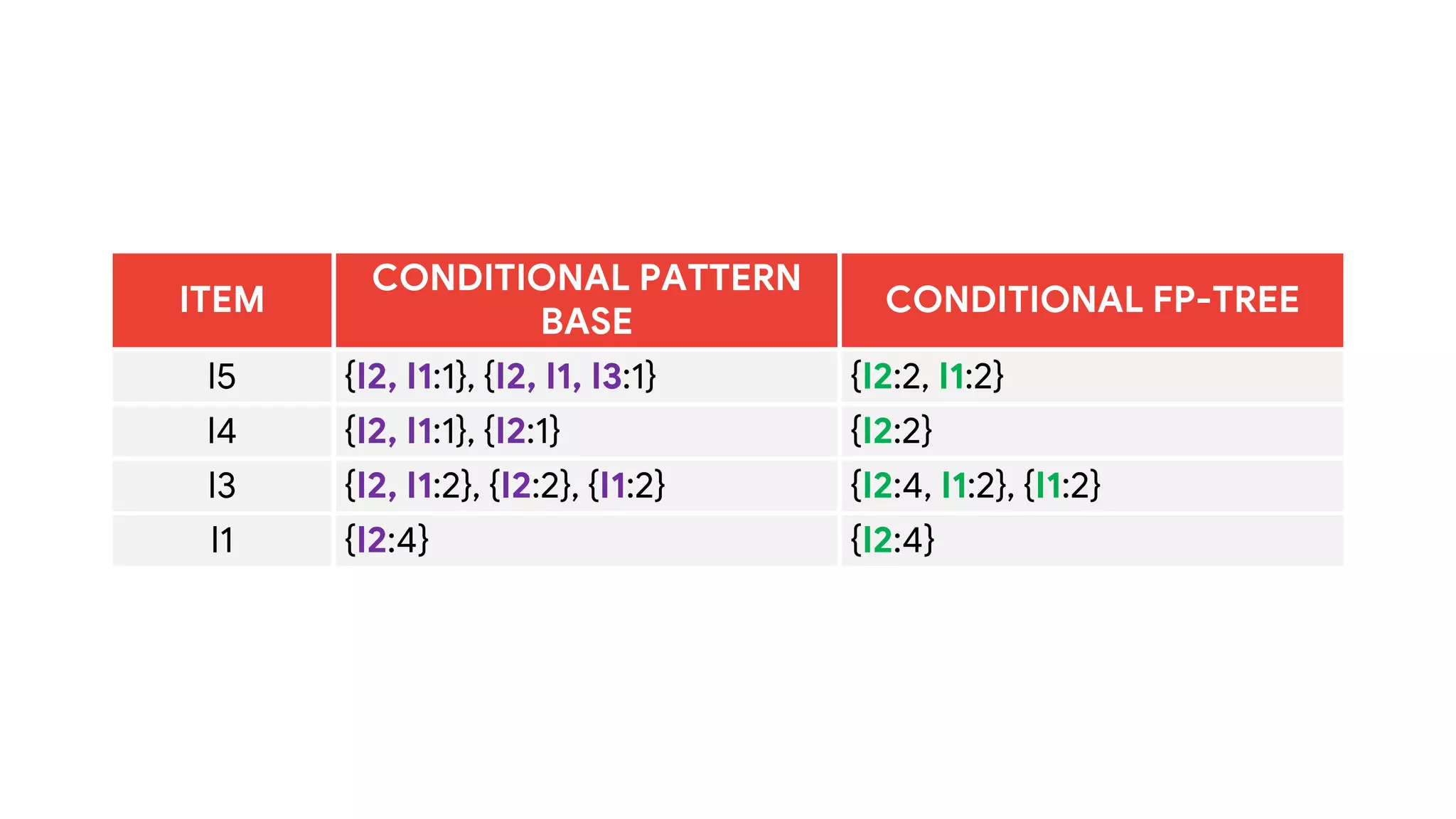

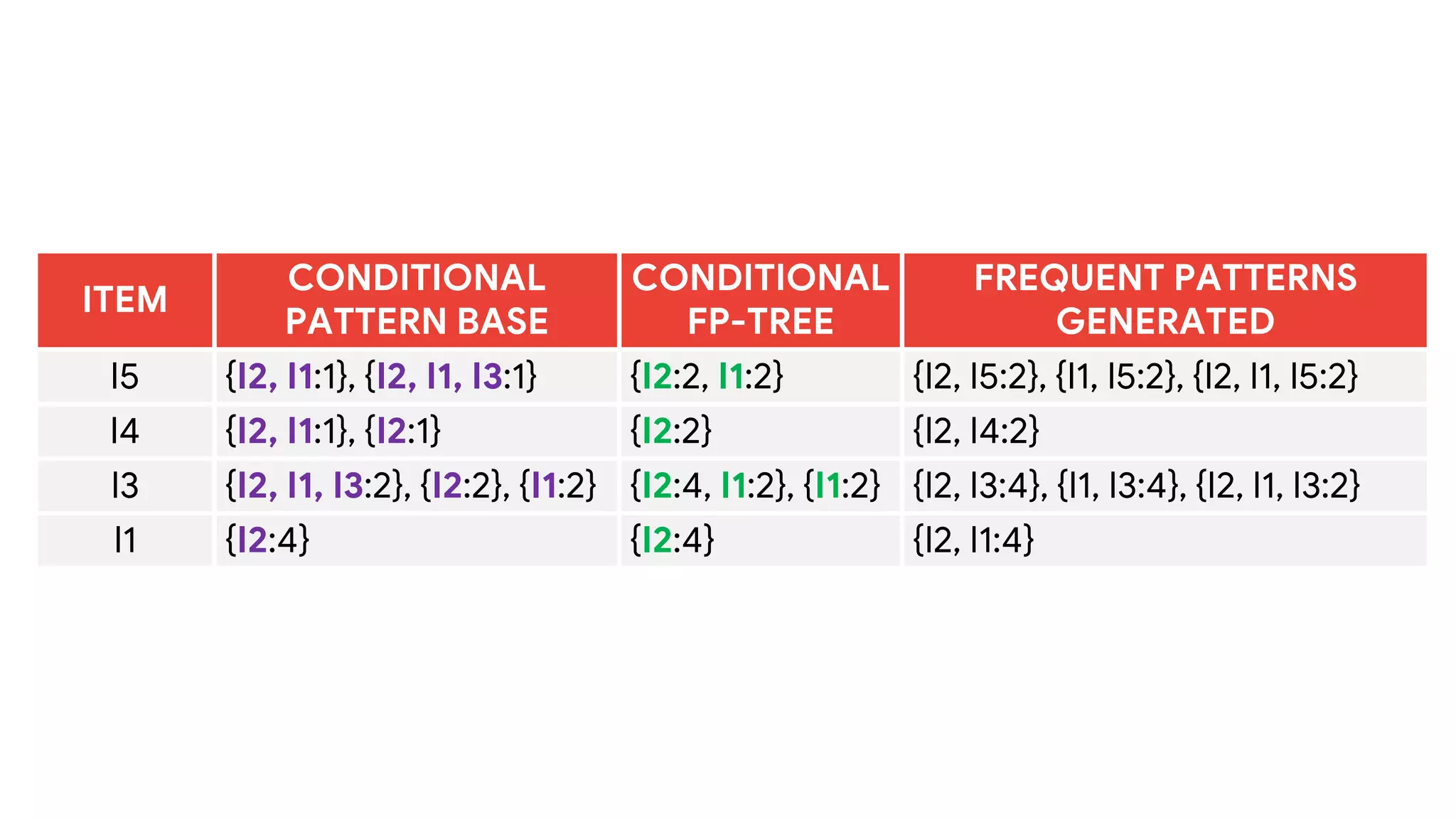

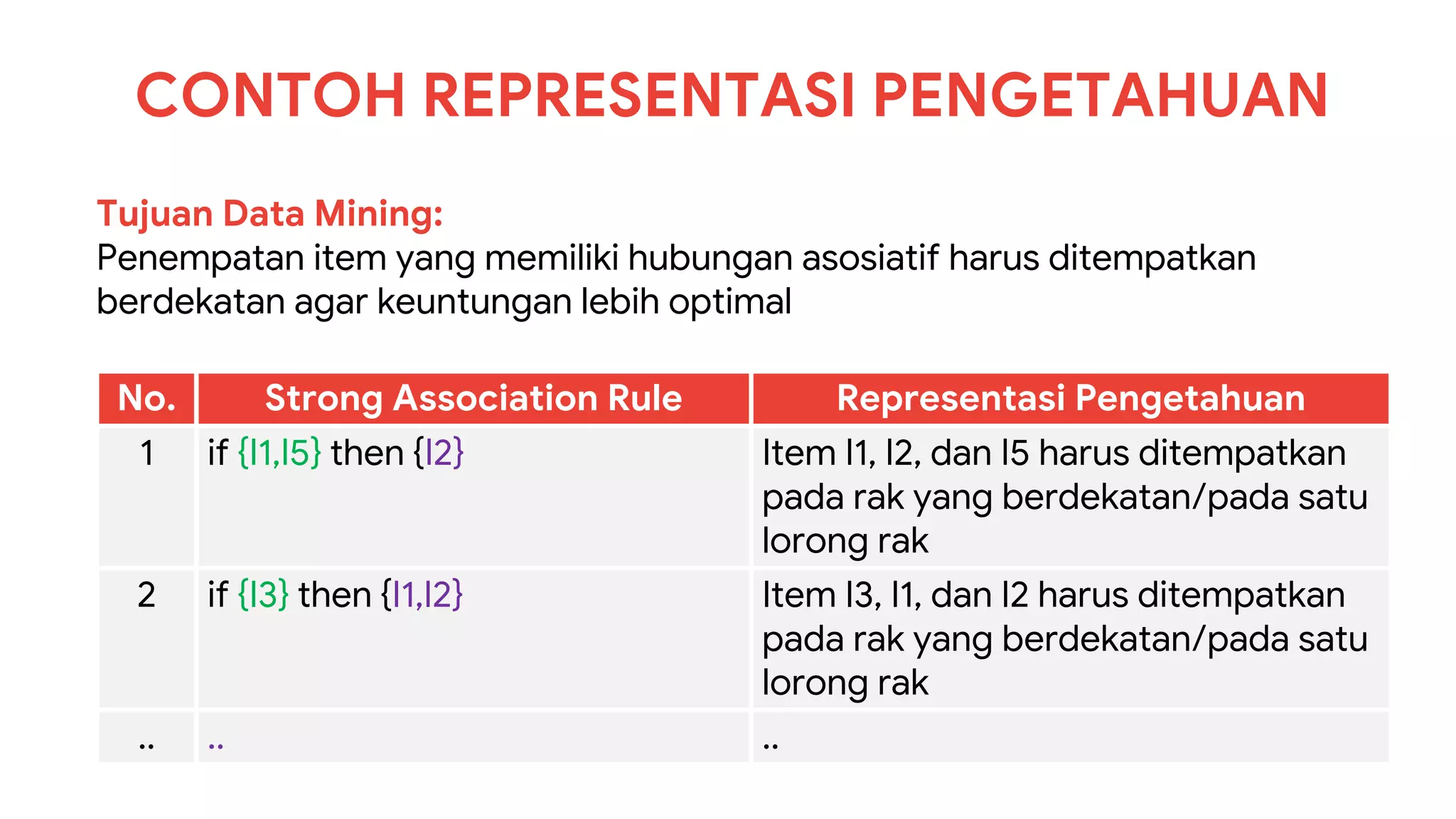

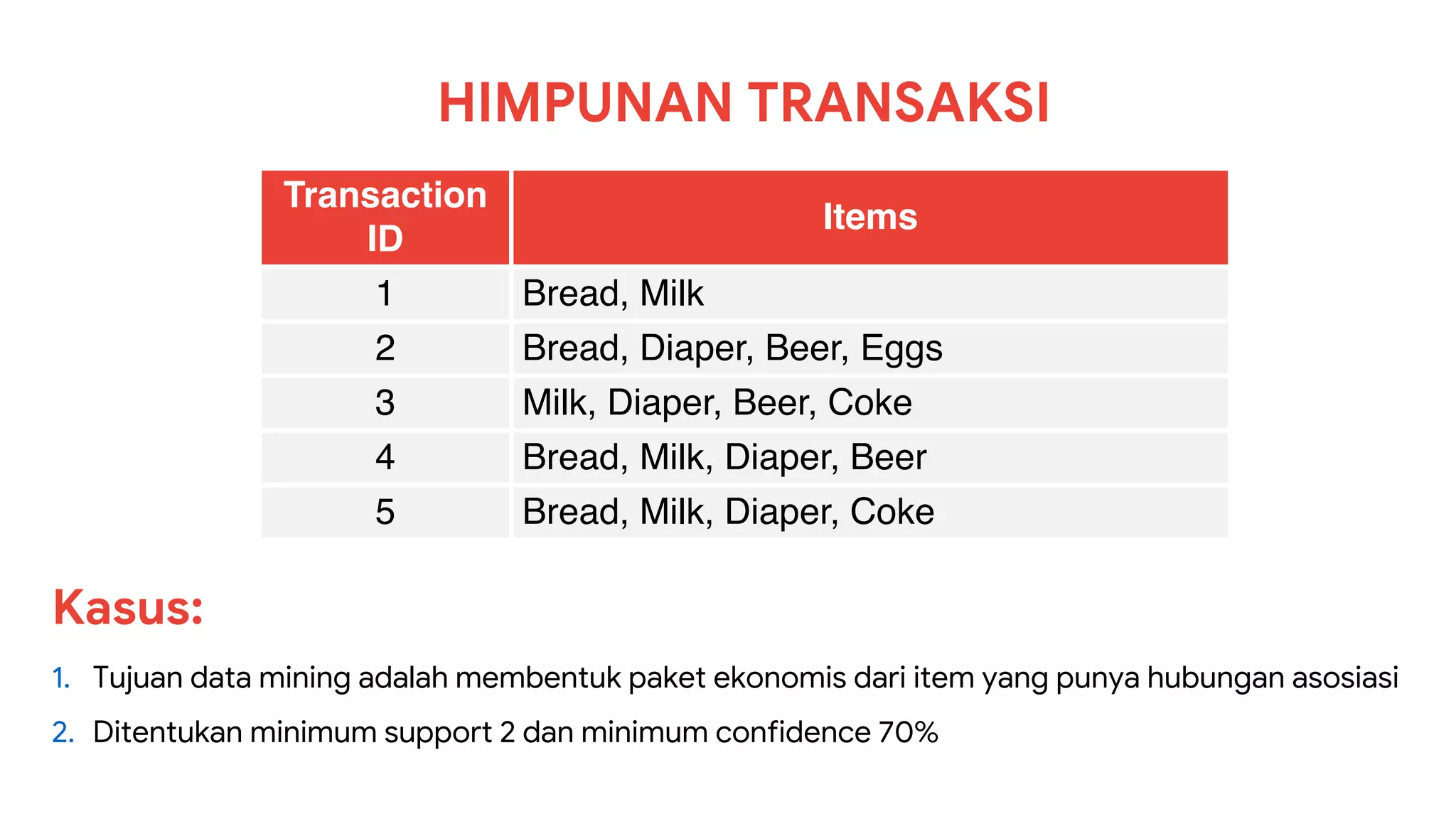

Dokumen ini menjelaskan metode data mining association rule, termasuk penggunaan nilai support dan confidence untuk mengekstraksi hubungan antar item. Algoritma yang dibahas adalah Apriori dan FP-Growth, dengan implementasi langkah-langkah untuk mengidentifikasi strong association rules. Penjelasan meliputi pembuatan frequent itemsets dan penerapan conditional pattern base untuk membentuk pola yang signifikan.